國家人機混合增強智能重點實驗室項目:利用生成世界模型優(yōu)化多智能體系統(tǒng)決策

生成模型在單智能體場景中的應用已經取得了顯著進展。例如,UniSim通過預測圖像中的動作來推斷未來的情景,展示了從廣泛數(shù)據(jù)中學習的模擬器可以推廣到現(xiàn)實世界,并彌合仿真與現(xiàn)實的差距。而Genie則允許用戶在生成的環(huán)境中逐幀行動,為訓練未來的通用智能體鋪平了道路。但是這些模型主要集中于單智能體場景,對于需要多個智能體協(xié)同工作的任務,它們的適用性相對有限。

在多智能體強化學習(MARL)任務中,世界模型的研究尚處于起步階段。盡管一些研究在模擬單智能體行為方面取得了進展,但在涉及多個智能體的復雜場景中,現(xiàn)有方法仍然面臨諸多挑戰(zhàn)。例如,MARL任務通常涉及多個實體的屬性,如位置和角色,僅用文本描述狀態(tài)是困難的。此外,MARL環(huán)境的動態(tài)和獎勵模型比單智能體設置更加復雜,現(xiàn)有的方法假設獎勵是已知的或可以通過幀信息輕松推導,但這種假設在MARL中并不成立。

針對這些局限性,最新研究提出了通過生成世界模型來增強多智能體決策問題答案的策略。來自國家人機混合增強智能重點實驗室和國家視覺信息與應用工程研究中心的研究團隊探索了一種新的范式,將語言引導的模擬器整合到多智能體強化學習流程中,以提供更為切實的解決方案。模擬器作為一個世界模型,分別學習動態(tài)和獎勵,利用這些模型生成的試錯體驗來訓練聯(lián)合策略,從而提升多智能體決策問題的解決質量。

這項研究由西安交通大學的研究團隊完成,團隊成員包括Zeyang Liu、Xinrui Yang、Shiguang Sun、Long Qian、Lipeng Wan、Xingyu Chen和通訊作者Xuguang Lan。研究團隊隸屬于國家人機混合增強智能重點實驗室和國家視覺信息與應用工程研究中心,專注于多智能體系統(tǒng)和生成模型的研究,致力于通過創(chuàng)新的方法解決現(xiàn)實世界中的復雜問題。他們的研究工作在2024年神經信息處理系統(tǒng)會議(NeurIPS 2024)上展示,充分體現(xiàn)了他們在人工智能和機器人領域的領先地位和創(chuàng)新能力。

研究動機

多智能體任務中存在許多挑戰(zhàn)和需求。多智能體系統(tǒng)需要協(xié)調多個智能體的行為,以實現(xiàn)共同的目標,這需要復雜的決策和規(guī)劃過程。現(xiàn)有生成模型在處理多智能體任務時往往缺乏對動態(tài)環(huán)境的準確模擬,導致生成的解決方案不夠精確和可靠。

通過語言引導的模擬器在增強決策問題答案中的潛力顯而易見。將語言模型與世界模型相結合,能夠更好地理解任務描述,并通過模擬不同的決策過程來生成更準確的答案。這不僅可以提高多智能體系統(tǒng)的效率和性能,還可以為實際應用提供更為切實可行的解決方案。本研究通過提出一種新的范式,將語言引導的模擬器整合到多智能體強化學習流程中,旨在解決多智能體任務中的復雜決策問題,提升生成模型的適用性和有效性。

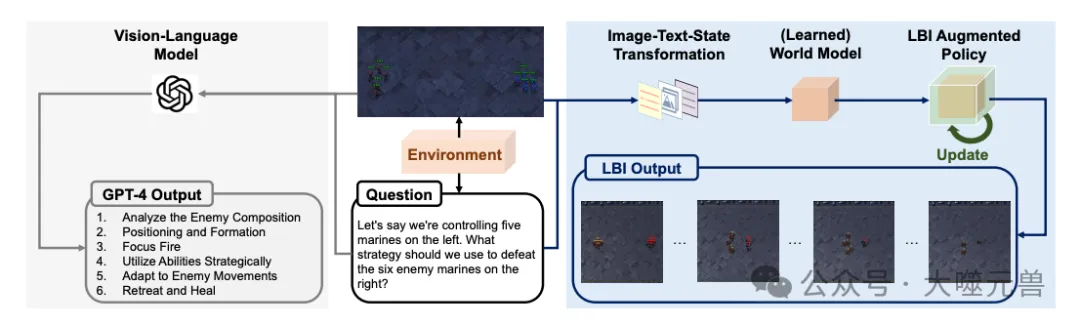

圖1:對于當前的視覺語言模型來說,需要很好地理解環(huán)境動態(tài)和目標的復雜決策問題仍然具有挑戰(zhàn)性,例如,GPT-4得出的答案是粗略和誤導性的。相反,互動前學習(LBI)通過模擬給定問題中的任務來實現(xiàn)有根據(jù)的推理。LBI利用模擬器訓練MARL策略,并通過在模擬器上運行聚合策略來生成答案。

方法論

互動模擬器的構建

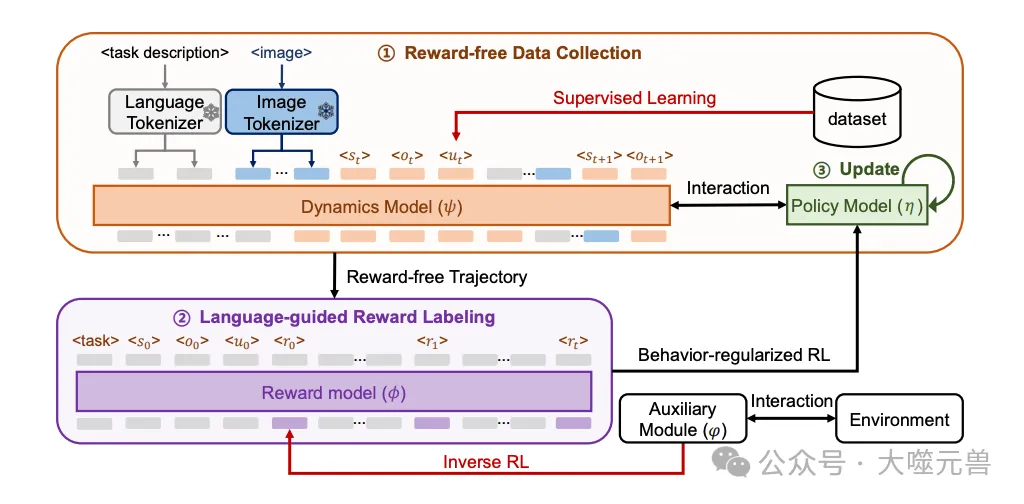

在多智能體決策問題中,互動模擬器的構建是至關重要的一步。研究團隊提出的互動模擬器由三個核心組件構成:圖像分詞器、動態(tài)模型和獎勵模型。通過這些組件的相互合作,模擬器能夠生成試錯經驗,并且提升多智能體決策問題的答案質量。

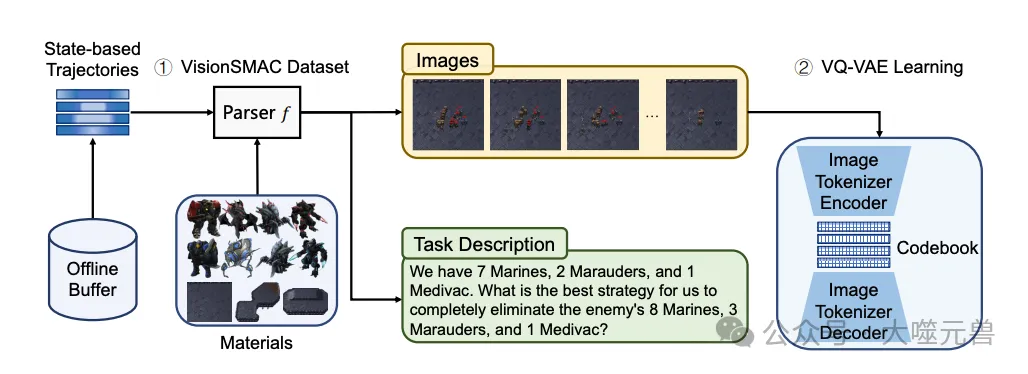

圖像分詞器的作用是將原始視頻幀轉換為離散標記,從而降低數(shù)據(jù)維度并提高圖像生成的質量。具體來說,作者采用了矢量量化變分自編碼器(VQ-VAE),這是一種先進的圖像編碼方法。VQ-VAE通過對每一幀圖像進行編碼,生成離散表示。這種表示不僅保留了原始圖像的重要信息,還顯著減少了數(shù)據(jù)量,從而為后續(xù)的動態(tài)模型和獎勵模型提供了高效的輸入數(shù)據(jù)。

圖2:數(shù)據(jù)集構建和VQ-VAE訓練。

動態(tài)模型是互動模擬器的核心組件之一,它通過自回歸建模,根據(jù)過去的幀和狀態(tài)標記來預測下一幀和狀態(tài)。研究團隊采用了因果變換器作為動態(tài)模型的架構,并在任務描述的指導下進行建模。具體來說,動態(tài)模型接收一系列的圖像和狀態(tài)標記,并在每一個時間步進行預測。為了提高預測的準確性和穩(wěn)定性,動態(tài)模型還采用了動態(tài)殘差項,將狀態(tài)預測目標從St+1?為?ΔSt+1=St+1?St,以進一步提高生成的準確性。通過這種方式,動態(tài)模型能夠生成一致的長視距軌跡,確保多智能體決策過程中各個步驟的連貫性。

獎勵模型通過軌跡推斷狀態(tài)-動作對的獎勵,是互動模擬器中另一個關鍵組件。作者采用了類似于逆強化學習的訓練管道,通過最大化專家演示軌跡的似然性來訓練獎勵模型。具體來說,獎勵模型接收完整的軌跡作為輸入,并在確定性動態(tài)下進行信用分配。為了避免獎勵高估,研究團隊引入了獎勵約束和行為正則化,通過這些措施進行樣本內學習,從而提高獎勵預測的準確性。獎勵模型的這一設計使得互動模擬器能夠在復雜的多智能體決策環(huán)境中生成合理的獎勵,并幫助智能體快速學習到最優(yōu)策略。

為了構建有效的互動模擬器,首先需要一個全面的數(shù)據(jù)集。研究團隊提出的新SMAC多智能體強化學習數(shù)據(jù)集,通過解析器自動生成給定狀態(tài)和任務描述的真實圖像。SMAC(StarCraft Multi-Agent Challenge)環(huán)境以其豐富的環(huán)境和高控制復雜性著稱,是訓練和測試多智能體系統(tǒng)的理想平臺。為了生成訓練數(shù)據(jù),研究者們運行多智能體探索方法,如EMC(Efficient Multi-agent Communication)和IIE(Interactive Imitation Learning),在多個訓練地圖上收集了大量的交互軌跡。每條軌跡都包含狀態(tài)、觀察、聯(lián)合動作和完成信號。這些數(shù)據(jù)通過解析器轉換為相應的圖像和任務描述,為模擬器的訓練提供了基礎。

任務描述的解析與生成是訓練互動模擬器的重要步驟之一。研究團隊設計了一種解析器,將每個軌跡轉換為自然語言任務描述。這些任務描述包含環(huán)境動態(tài)、代理和敵人的數(shù)量和類型,以及終止狀態(tài)下敵人的剩余生命值等信息。通過這種方式,任務描述不僅提供了當前狀態(tài)的信息,還為模擬器的動態(tài)模型提供了額外的上下文,使其能夠更準確地預測未來的狀態(tài)。

圖3:互動前學習概述。

動態(tài)模型是模擬器的核心組件之一,其作用是根據(jù)過去的幀和狀態(tài)標記,預測下一幀和狀態(tài)。為了實現(xiàn)這一目標,研究團隊采用了因果變換器作為動態(tài)模型的架構。具體來說,動態(tài)模型通過自回歸建模,根據(jù)任務描述和過去的幀和狀態(tài)標記,生成未來的狀態(tài)和圖像。

獎勵模型通過推斷狀態(tài)-動作對的獎勵,幫助智能體在模擬環(huán)境中學習到最優(yōu)策略。研究團隊借鑒了逆強化學習的訓練管道,通過最大化專家演示軌跡的似然性來訓練獎勵模型。具體來說,獎勵模型接收完整的軌跡作為輸入,并根據(jù)軌跡中的動態(tài)信息進行獎勵分配。為了避免獎勵高估,研究者們引入了獎勵約束和行為正則化,通過這些措施進行樣本內學習,從而提高獎勵預測的準確性和魯棒性。

實驗與結果

性能比較

在性能比較中,研究團隊評估了LBI(Learning before Interaction)在無獎勵的離線學習、離線多智能體強化學習(MARL)和在線多智能體強化學習中的表現(xiàn)。

在無獎勵的離線學習方面,LBI顯著優(yōu)于多種基準方法,包括行為克隆(BC)和對抗模仿學習(MA-AIRL)。行為克隆方法通過模仿整個數(shù)據(jù)集的行為來學習策略,而MA-AIRL使用對抗學習進行策略模仿。盡管這些方法在一些任務上有一定的表現(xiàn),但它們往往無法在復雜的多智能體決策場景中實現(xiàn)高成功率。相較之下,LBI通過生成試錯經驗,改進了決策過程,從而在各種難度的地圖上表現(xiàn)出色。

離線MARL方面LBI同樣表現(xiàn)出色,超越了現(xiàn)有的多種方法,如BCQ-MA和CQL-MA。這些離線方法利用真實獎勵進行訓練,但在代理數(shù)量增加時,其性能往往會顯著下降。研究團隊提出的LBI通過動態(tài)模型和獎勵模型的協(xié)同工作,生成了更為合理的試錯軌跡,并優(yōu)化了策略學習,從而在復雜的環(huán)境中取得了更高的成功率和表現(xiàn)。

在線MARL方面,LBI也展示了其優(yōu)越性。研究團隊將LBI與現(xiàn)有的在線方法如CW-QMIX、QPLEX等進行了比較。結果表明,LBI在樣本效率方面顯著提升,這得益于其預訓練的世界模型在生成響應時減少了等待時間。這一結果表明,預訓練的世界模型不僅能夠提高離線學習的性能,還能在在線學習過程中提供顯著的優(yōu)勢。

在未見任務中的泛化能力

為了評估LBI(Learning before Interaction)在未見任務中的泛化能力,研究團隊測試了LBI在十個未見測試地圖上的表現(xiàn)。結果顯示,LBI在這些新的環(huán)境中依然表現(xiàn)出色,成功地將已學知識轉移到新任務上,且無需額外的微調。這種零樣本泛化能力是生成模型在實際應用中非常關鍵的特性,證明了LBI在多智能體決策問題中的廣泛適用性。

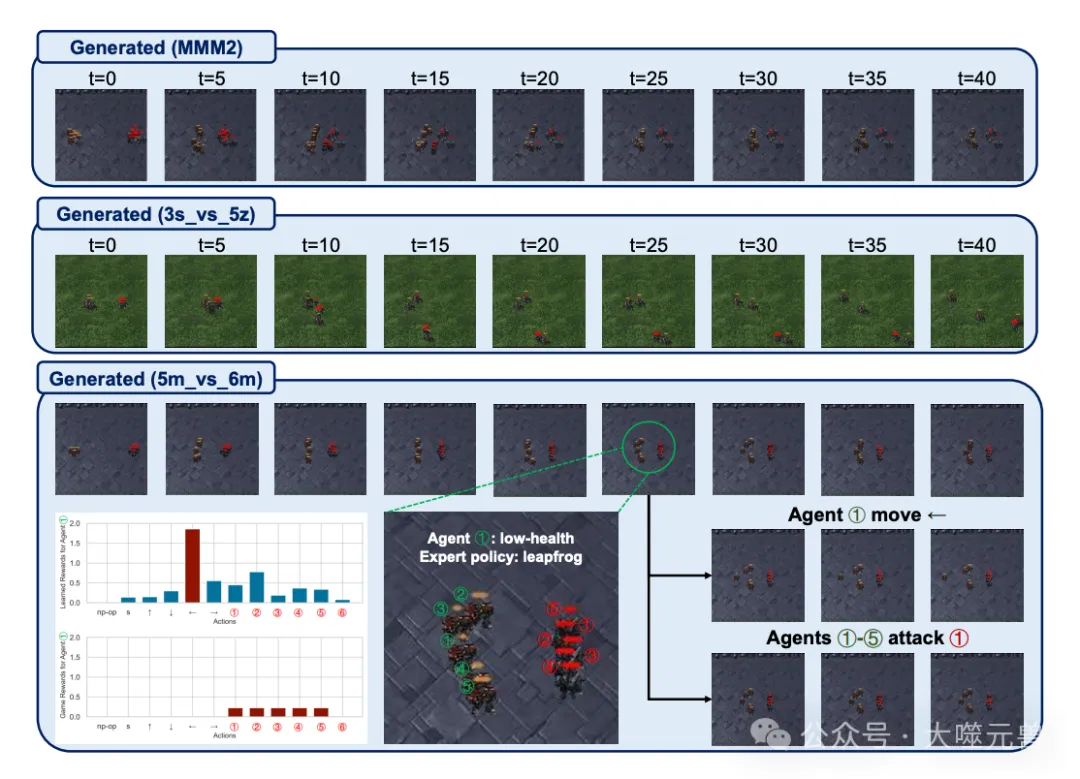

圖4:動態(tài)和獎勵模型預測的可視化,其中“np-op”和“s”分別表示不操作和停止。

動態(tài)模型不僅能夠生成長視距的圖像軌跡,還能在關鍵狀態(tài)下進行動作可控生成。具體來說,動態(tài)模型在生成的過程中沒有出現(xiàn)明顯的累積誤差,這表明LBI具備生成一致性和長視距軌跡的能力。在5m_vs_6m的例子中,研究人員展示了在某個可能動作后的連續(xù)幀,證明了LBI可以進行動作可控的生成,幫助智能體更好地理解和執(zhí)行策略。

消融研究

研究團隊通過消融研究深入分析了互動模擬器中各組件的貢獻,包括動態(tài)模型和獎勵模型的具體作用及其在不同任務中的表現(xiàn)。

動態(tài)模型在生成長視距軌跡和預測未來狀態(tài)方面起著關鍵作用。通過消融研究,研究團隊發(fā)現(xiàn),使用動態(tài)殘差項對減少后續(xù)狀態(tài)的預測誤差至關重要。這在各種訓練和未見任務中,動態(tài)殘差項顯著提升了模型的整體表現(xiàn)。盡管圖像參考的效果不如預期,但作為另一種模式,圖像在某些情況下比語言或狀態(tài)信息更具表現(xiàn)力,未來的研究可能會進一步探索其潛力。

對于獎勵模型,獎勵約束和行為正則化在訓練任務中發(fā)揮了重要作用,顯著改善了整體性能。具體來說,獎勵約束通過控制獎勵值,避免了在樣本外狀態(tài)-動作對上出現(xiàn)獎勵過高的情況,而行為正則化則通過在策略學習中加入保守性,進一步提高了獎勵預測的準確性。在未見任務中,研究發(fā)現(xiàn),獎勵的保守性比策略更為重要。當存在樣本外狀態(tài)-動作對時,保守的獎勵預測能夠更好地幫助智能體進行決策學習。相比之下,LBI(Learning before Interaction)在缺乏獎勵約束和行為正則化的情況下表現(xiàn)較差,這進一步證明了這些組件在優(yōu)化模型性能中的關鍵作用。

相關工作

世界模型

世界模型的研究在多智能體強化學習中扮演著至關重要的角色。這些模型通過預測環(huán)境動態(tài)和獎勵,幫助智能體更有效地學習和決策。

模型預測控制(MPC)是一種通過模型模擬來生成高獎勵動作序列的方法。在MPC的應用中,像MBMF、PETS和PlaNet等模型通過集成MPC來采樣高獎勵的動作序列。這些方法依賴于世界模型對環(huán)境動態(tài)的精確模擬,從而在多步預測中生成最優(yōu)的決策序列。AlphaGo和MuZero等知名算法通過學習轉換模型并應用蒙特卡羅樹搜索(MCTS),實現(xiàn)了在人類競爭游戲中的突破。這些方法展示了世界模型在生成高質量決策中的潛力。

微分規(guī)劃與策略學習方法利用模型的內部結構來促進策略學習。GPS(Guided Policy Search)和GDP(Gradient-based Policy Search)等模型通過微分規(guī)劃獲得最優(yōu)策略的解析形式。這些方法通過對世界模型和策略進行重新參數(shù)化,并通過反向傳播計算策略梯度估計,從而提高了策略的學習效率。SVG(Stochastic Value Gradients)和MAAC(Multi-Agent Actor-Critic)等模型在緊湊的潛在空間中學習世界模型和策略,進一步提升了策略學習的效果。

Dyna-style 方法通過生成更多的經驗來訓練策略,從而擴展了數(shù)據(jù)集的覆蓋范圍。MVE(Model-based Value Expansion)和STEVE(Stochastic Ensemble Value Expansion)等方法通過多步時間差預測進行更好的價值估計。SLBO(Safe Model-Based Optimization)、MBPO(Model-Based Policy Optimization)和BMPO(Behavioral Model-Based Policy Optimization)等方法則通過理論分析證明,策略性能會在一定模型偏差和回滾長度下單調改進。為了進一步增加回滾長度并避免累積誤差,M2AC(Model-based Actor-Critic)和COPlanner(Conservative Planner)計算每一步的回滾不確定性,并在總獎勵中加入懲罰項。這些方法展示了世界模型在生成更多經驗并訓練策略中的有效性。

模仿學習

模仿學習通過模仿專家的行為來訓練智能體,是一種廣泛應用于多智能體系統(tǒng)的有效方法。在這些方法中,最大熵逆強化學習(MaxEnt IRL)、條件擴散模型和序列建模方法都具有重要意義。

最大熵逆強化學習(MaxEnt IRL)通過最小化代理和專家分布之間的差異來學習穩(wěn)定的獎勵函數(shù)。這種方法不僅能捕捉專家行為的多樣性,還能提供更好的泛化能力。通過最大化軌跡的熵,MaxEnt IRL能夠有效地處理復雜的決策問題,并在多個領域表現(xiàn)出色。例如,在自然語言目標和動態(tài)學習中,MaxEnt IRL展示了其強大的適應能力和廣泛的應用前景。

條件擴散模型是模仿學習中的另一種重要方法。通過將狀態(tài)和噪聲向量作為輸入,條件擴散模型可以生成預測動作,并模仿人類專家或游戲數(shù)據(jù)中的多模態(tài)行為。這種方法在建模隨機行為和處理復雜環(huán)境方面表現(xiàn)優(yōu)異。與傳統(tǒng)的模仿學習方法相比,條件擴散模型能夠更好地適應各種不同的情景,并提供更高的靈活性。

序列建模方法通過將軌跡生成問題看作序列建模問題,實現(xiàn)了對狀態(tài)、動作和獎勵的高效生成。決策變壓器(MADT)是序列建模方法中的代表,它通過自回歸方式生成狀態(tài)、動作和獎勵。與傳統(tǒng)的模仿學習方法相比,決策變壓器能夠更好地捕捉決策過程中的依賴關系,并提供更為準確的決策結果。這種方法在多智能體決策任務中表現(xiàn)出色,展示了其在序列建模中的潛力。

結論與展望

研究團隊提出的“交互前學習” (Learning before Interaction, LBI) 方法,結合了生成模型和多智能體強化學習,展示了在多智能體決策問題中的創(chuàng)新性和有效性。LBI通過引入語言引導的互動模擬器,解決了傳統(tǒng)生成模型在處理復雜多智能體決策問題時的不足。具體來說,LBI包括圖像分詞器、動態(tài)模型和獎勵模型三個核心組件,這些組件協(xié)同工作,生成高質量的試錯經驗,改進了決策質量。實驗結果表明,LBI不僅在各種基準測試中表現(xiàn)出色,還展示了強大的零樣本泛化能力,能夠在未見任務中保持卓越表現(xiàn)。這些研究成果證明了LBI在處理復雜多智能體決策問題上的潛力和實際應用價值。

LBI的提出為多智能體系統(tǒng)的研究提供了新的思路和方向。未來的研究可以進一步優(yōu)化和擴展LBI的應用場景。例如,在其他高復雜度和高動態(tài)性的環(huán)境中,LBI有望通過適應不同的任務描述和獎勵函數(shù),展現(xiàn)出更廣泛的適用性。此外,LBI的框架可以與其他先進的人工智能技術相結合,如自然語言處理和計算機視覺,進一步提高多智能體系統(tǒng)的智能化水平。

另一個重要的研究方向是提高LBI的效率和可擴展性。盡管研究團隊已經展示了LBI在樣本效率上的顯著提升,未來的研究可以探索更高效的模型訓練和推理方法,以進一步減少計算成本和時間。同時通過引入更多的實際數(shù)據(jù)和場景,LBI可以在真實世界的應用中得到驗證和改進,推動多智能體決策系統(tǒng)在工業(yè)、醫(yī)療和社會治理等領域的發(fā)展。

LBI的創(chuàng)新性和有效性為多智能體決策問題提供了切實可行的解決方案,其廣泛的應用潛力和未來的研究方向也為人工智能領域帶來了新的機遇和挑戰(zhàn)。科技的進步總是如此令人興奮和期待。(END)

參考資料:https://arxiv.org/abs/2410.02664