中國國家自然科學基金資助項目:多智能體系統中的動態故障容錯技術 精華

智能體故障對多智能體強化學習(MARL)算法的性能構成了顯著威脅,主要帶來兩大挑戰。智能體常常難以從由意外故障引發的混亂狀態空間中提取關鍵信息。其次回放緩沖區中記錄的故障前后轉變不均衡,導致訓練樣本失衡問題。為了解決這些問題,來自清華大學自動化系和QiYuan Lab(啟源實驗室)的聯合團隊通過結合優化的模型架構和定制的訓練數據采樣策略來增強MARL的故障容錯能力。具體而言,研究團隊在actor和critic網絡中引入了注意力機制,自動檢測故障并動態調節對故障智能體的關注。此外還引入了優先級機制,選擇當前訓練需求中最關鍵的樣本。為了進一步支持這一領域的研究,他們設計并開源了一個高度解耦的容錯MARL代碼平臺,以提高相關問題研究的效率。實驗結果表明,該方法在處理各種類型的故障、任意智能體故障和隨機時間故障方面表現出色。他們的技術論文《Towards Fault Tolerance in Multi-Agent Reinforcement Learning》12 月 2 日發表于arXiv 平臺。

多智能體系統基于MARL算法的性能優于傳統控制方法,但對意外故障仍然高度脆弱。為提高此類系統的故障容錯能力,他們引入了一種注意力機制,使神經網絡能夠動態調整對故障相關信息的關注度。通過優先級采樣策略,從收集到的經驗中選擇最符合當前訓練需求的關鍵樣本。跨多種故障類型的實驗結果表明,該方法顯著改善了故障容錯能力,驗證了其魯棒性。研究結果表明,該方法有潛力應用于真實世界場景,如多機器人系統和自動駕駛車隊。

研究團隊提出一種新穎的故障容錯方法,以提高多智能體強化學習(MARL)系統在智能體故障情況下的穩定性和可靠性。他們提出了一種結合優化模型架構和定制訓練數據采樣策略的方法,通過引入注意力機制和優先級經驗回放(PER),自動檢測故障并動態調整對故障相關信息的關注。該方法不僅能夠有效應對不同類型和時刻的智能體故障,還能在通信維護和任務分配中表現出卓越的性能。此外,研究團隊還開發并開源了一個新平臺(開源地址https://github.com/xbgit/FaultTolerance AACFT),支持研究人員進行多智能體系統容錯能力的深入研究和實驗。

研究團隊成員包括清華大學自動化系的Yuchen Shi和Yi Zhang,QiYuan Lab(啟源實驗室)的Huaxin Pei和Liang Feng,以及清華大學北京信息科學與技術國家研究中心(BNRist)的Danya Yao。研究團隊的工作得到了中國國家自然科學基金(項目編號:62133002)的資助,他們具有強大的學術背景和豐富的研究經驗。團隊在多智能體系統、強化學習和容錯計算等領域具有深厚的技術積累,通過結合多學科的研究成果,提出了創新的故障容錯方法,并設計了一個高效的實驗平臺,推動了該領域的進一步發展。

方法概述

在這篇論文中,研究團隊提出了一種新穎的方法,通過結合優化模型架構與定制訓練數據采樣策略,旨在提升多智能體強化學習(MARL)系統的容錯能力。這種方法的核心在于引入注意力機制和優先級經驗回放(PER),使得系統能夠自動識別智能體故障并動態調整對故障信息的關注度,從而更高效地利用訓練數據,提高系統的整體性能。

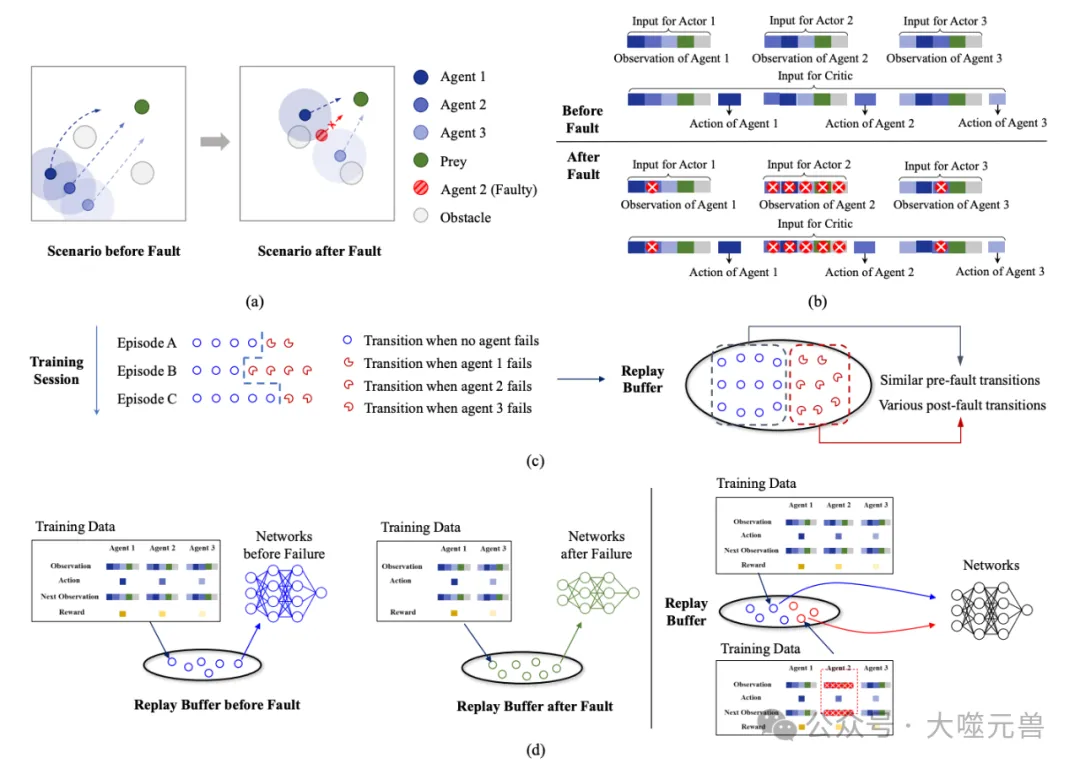

圖1:(a)代理故障前后捕食者-獵物系統的圖示,其中不同深淺的藍色圓圈代表捕食者,綠色圓圈代表獵物。每個代理周圍的大透明圓圈代表其通信范圍。在最初用作通信橋的代理2發生故障后,代理1和3失去了通信。(b) 故障前后演員和評論家的輸入說明。當代理2發生故障時,其相關信息會變得異常并標記為紅色,從而導致參與者和評論家網絡的原始輸入中斷。(c) 處理故障的兩種自然想法的說明。左側部分說明了在代理故障前后手動區分訓練數據和網絡的想法,右側部分說明了神經網絡自動識別輸入中無效信息的想法。藍色圓圈代表類似的故障前過渡,不同的不完整圓圈代表各種故障后過渡,反映了樣本的不平衡。

優化模型架構與定制訓練數據采樣策略相結合的方法

在多智能體系統中,每個智能體在執行任務時,不僅需要處理自身的狀態信息,還需要考慮其他智能體以及環境和任務的狀態。這種復雜性增加了系統的訓練難度,特別是在出現智能體故障的情況下。為了應對這一挑戰,研究團隊提出了一種優化的模型架構,通過精心設計的輸入配置和結合注意力機制,使系統能夠自動識別并處理故障智能體的信息。

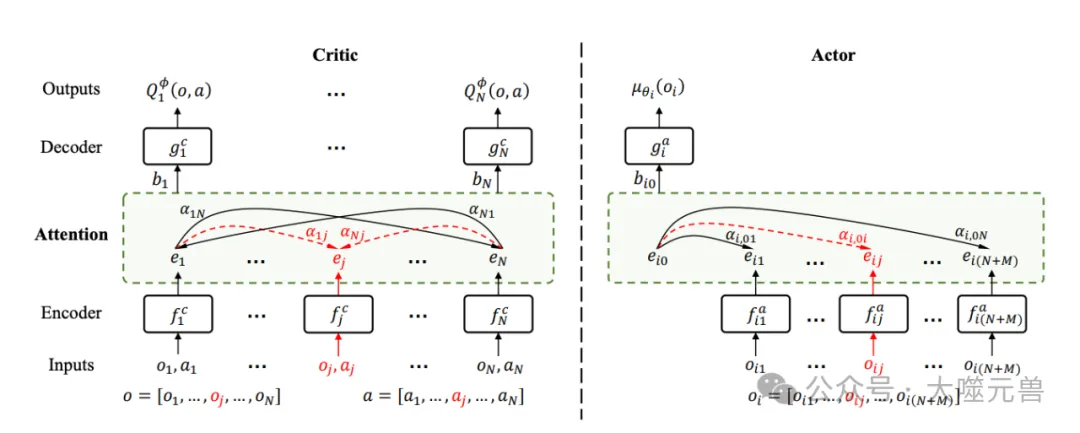

圖2:方法的主要組成部分的說明。

此外,定制訓練數據采樣策略也在研究團隊中扮演了重要角色。通過優先級經驗回放(PER),系統能夠優先選擇那些對當前訓練最關鍵的樣本,從而解決訓練數據樣本不平衡的問題。這種再加權的方法使得系統在處理智能體故障時,能夠更有效地進行學習和調整,提高訓練效率和系統性能。

注意力機制在actor和critic網絡中的應用

注意力機制是近年來在深度學習領域廣泛應用的一種技術,因其優越的性能和可解釋性,得到了廣泛關注。在研究團隊中,研究團隊將注意力機制引入到actor和critic網絡中,用于自動檢測并處理智能體故障信息。

在actor網絡中,注意力機制被用來動態調整對故障智能體的關注度。例如,當某個智能體發生故障時,系統能夠通過調整注意力權重,減少對該故障智能體信息的依賴,轉而關注其他有效信息,從而繼續高效地執行任務。同樣,在critic網絡中,注意力機制可以幫助系統識別并過濾掉故障智能體的無效信息,確保網絡訓練的準確性和有效性。

通過這種方式,注意力機制在actor和critic網絡中的應用,使得系統能夠靈活應對智能體故障,提高整體容錯能力和任務執行效率。

優先級經驗回放(PER)的引入與作用

優先級經驗回放(PER)是研究團隊提出的另一個關鍵策略。傳統的經驗回放方法通常隨機選擇訓練樣本,而這種方法在處理樣本不平衡問題時顯得力不從心。為了提高訓練效率,研究團隊設計了一種再加權的方法,通過引入優先級機制,優先選擇那些對當前訓練最關鍵的樣本。

具體來說,系統根據每個樣本的重要性(如訓練損失)來確定其優先級,并按照這個優先級進行樣本選擇。這種方式不僅解決了訓練數據樣本不平衡的問題,還提高了系統在處理智能體故障時的學習效率和模型性能。

詳細方法

為了提高多智能體強化學習(MARL)系統的容錯能力,研究團隊提出了一種結合注意力機制和優先級經驗回放(PER)的方法。通過在actor和critic網絡中引入注意力機制,系統能夠自動識別故障智能體并動態調整對故障信息的關注度。同時,優先級經驗回放通過再加權策略解決了樣本不平衡的問題,提高了訓練效率。

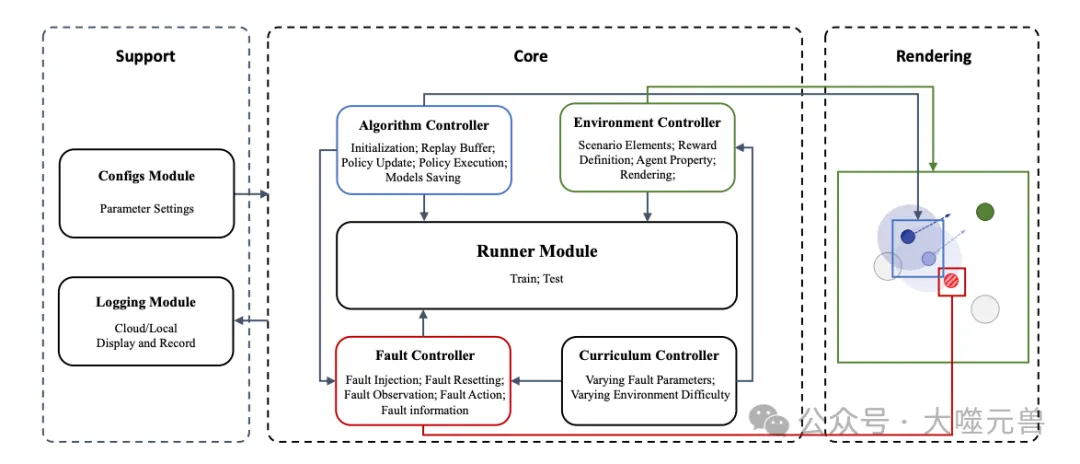

圖3:FTMAL的總體框架。

Actor和Critic的注意力機制

在多智能體系統中,actor和critic是兩個核心組件。Actor負責根據觀察到的狀態選擇行動,而critic負責評估這些行動的價值。在面對智能體故障時,傳統方法通常無法有效區分故障信息與有效信息,從而影響系統性能。為此,研究團隊引入了注意力機制,使得actor和critic能夠動態調整對不同信息源的關注度,自動過濾掉故障智能體的無效信息。

多智能體合作任務中智能體的觀察狀態

在多智能體合作任務中,每個智能體的觀察狀態不僅包括自身的信息,還包括其他智能體、環境和任務的狀態。一個智能體的觀察狀態可以分為以下幾部分:

1.智能體自身的狀態(位置、速度等)

2.其他智能體的狀態及其通信狀態

3.環境的狀態(如障礙物的位置)

4.任務的狀態(如目標位置和速度)

這種復雜的觀察狀態要求系統能夠靈活處理不同來源的信息,特別是在出現故障時,能夠迅速識別并調整對不同信息的關注度。

注意力模塊在actor和critic網絡中的設計與實現

在actor網絡中,注意力模塊用于動態調整對故障智能體的關注度。具體來說,actor網絡接收智能體的觀察狀態,將其轉換為嵌入表示,然后通過注意力機制計算出每個信息源的重要性權重,最后基于加權后的嵌入表示生成行動。

在critic網絡中,注意力模塊幫助系統識別并過濾故障智能體的無效信息。Critic網絡接收所有智能體的觀察狀態和行動,將其轉換為嵌入表示,通過注意力機制計算出每個信息源的重要性權重,最后基于加權后的嵌入表示生成Q值。

通過這種設計,注意力機制使得actor和critic網絡能夠靈活應對智能體故障,提高系統的容錯能力和任務執行效率。

優先級經驗回放(PER)

為了進一步提高訓練效率,研究團隊引入了優先級經驗回放(PER)策略。傳統的經驗回放方法通常隨機選擇訓練樣本,這在樣本不平衡的情況下可能導致訓練效率低下。而PER通過為每個樣本分配優先級,根據優先級進行樣本選擇,從而解決了樣本不平衡的問題。

再加權方法及其在處理樣本不平衡問題中的應用

具體來說,PER策略會根據樣本的重要性(如訓練損失)為其分配優先級。重要性越高的樣本,其被選中的概率越大。在訓練過程中,系統會優先選擇那些對當前模型訓練最關鍵的樣本,從而提高訓練效率。

通過這種再加權方法,PER策略能夠確保系統在處理智能體故障時,優先學習那些最具挑戰性的轉變,提高了模型的魯棒性和性能。

實驗結果與分析

在這部分,他們深入探討了AACFT方法的性能和有效性,通過一系列對比實驗、情節可視化、注意力分布分析以及對故障時間的適應性測試,驗證了該方法的優越性。

對比實驗

首先,通過對比實驗,他們評估了AACFT方法與三種基線方法(M3DDPG、MADDPG、MADDPG+MC)的性能。結果顯示,AACFT在處理多智能體故障方面表現優異,尤其是在任務完成率、通信維護和任務分配方面,顯著優于其他方法。

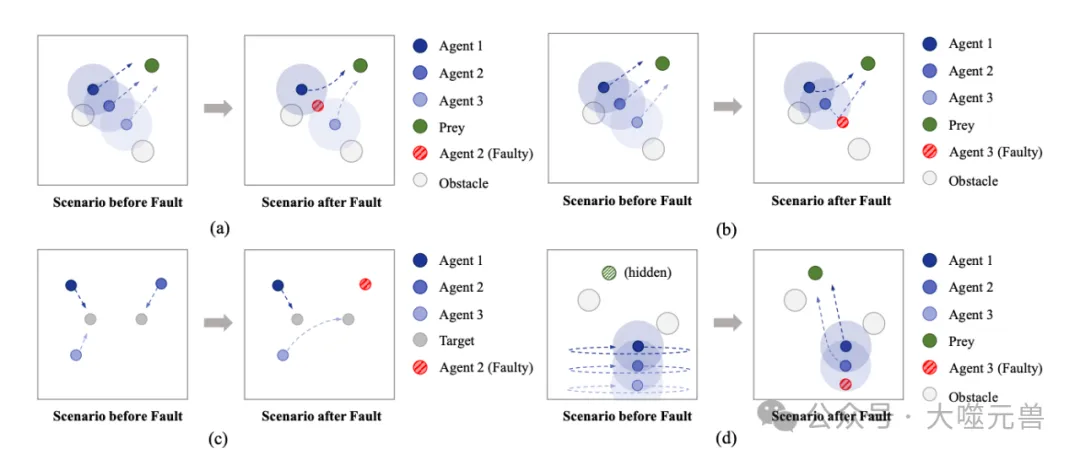

圖4:故障前后場景示意圖。(a) 代理2失敗時的放棄場景和恢復場景。(b) 代理3失敗時的恢復方案。(c) 導航場景。(d)巡邏場景。

具體來說,在無故障的基本捕食者-獵物場景中,所有方法的表現相近。然而在引入故障后,AACFT方法顯現出明顯的優勢。在放棄場景和恢復場景中,AACFT方法的任務完成率顯著高于其他基線方法。這表明AACFT方法能夠更有效地識別并處理智能體故障,維持系統的正常運作。

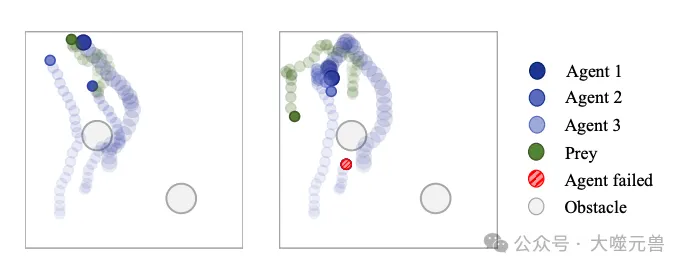

圖5:在不考慮訓練過程中的故障的情況下測試基本MADDPG。(左)無故障。(右)代理2失敗。

情節可視化

為了更直觀地展示AACFT方法在處理智能體故障時的行為,他們對恢復場景中的智能體行為進行了可視化展示。通過這些可視化圖,他們可以清晰地看到,在智能體2和智能體3發生故障時,系統是如何調整并繼續執行任務的。

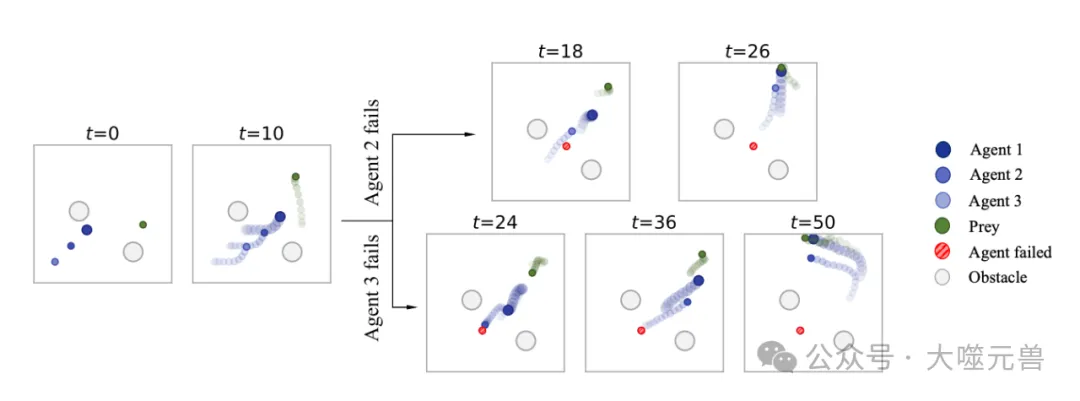

圖 6:恢復場景中的一個事件的說明,其中代理2和代理3分別失敗。在圖中,一系列透明度逐漸降低的圓圈表示代理從上一個時間步長到當前時間步長的運動軌跡。

例如,當智能體2故障時,智能體1和智能體3能夠迅速重新分配任務,保持追蹤獵物的動作。當智能體3故障時,智能體2首先執行恢復任務,完成后繼續與智能體1共同追蹤獵物。這些可視化結果驗證了AACFT方法在智能體故障情況下的魯棒性和靈活性。

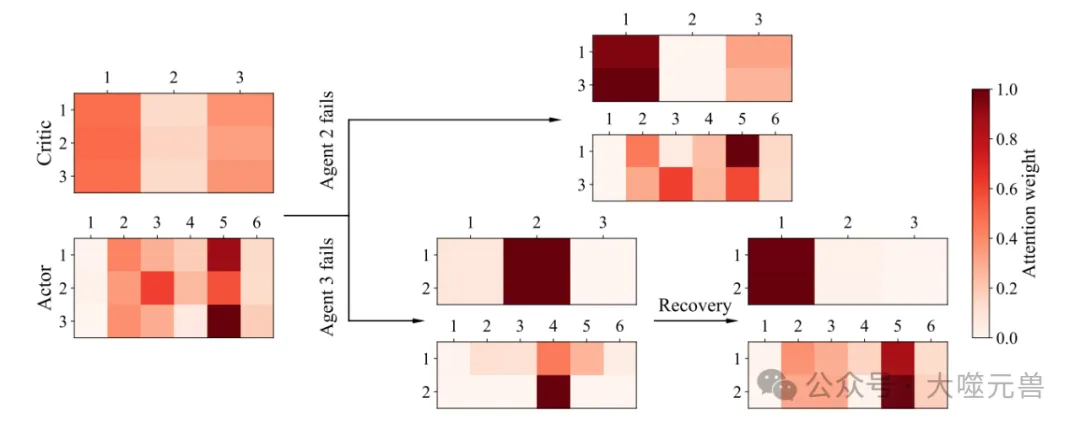

注意力分布分析

注意力機制在處理智能體故障中發揮了關鍵作用。通過注意力分布分析,他們觀察到,在正常運行時,critic中的注意力分布相對均衡,而actor對獵物的注意力較高。當智能體發生故障時,系統能夠動態調整注意力權重,減少對故障智能體的關注,轉而關注其他有效信息。

這種調整不僅保證了系統在故障情況下的正常運行,還提高了任務執行的效率。注意力分布的變化驗證了注意力機制在提高系統容錯能力方面的重要性。

加權優先經驗回放的作用

為了進一步提高訓練效率,AACFT方法引入了加權優先經驗回放(PER)。實驗結果顯示,使用PER的AACFT方法在訓練效率和模型性能方面顯著優于未使用PER的方法。

通過PER策略,系統能夠優先選擇那些對當前訓練最關鍵的樣本,從而有效解決樣本不平衡問題,提高了訓練效率和模型性能。特別是在巡邏場景中,使用PER的AACFT方法在處理復雜任務時表現更加出色。

圖7:恢復場景中故障前后評論家和演員的注意力分配。3×3或2×3矩陣是評論家的注意力矩陣,3×6或2×6矩陣是演員的注意力矩陣。評論家中的每一行表示一個代理對其他代理的注意力分配,而行動者中的每行表示代理對其觀察中不同信息的注意力分配。故障發生后,相應的代理行將被刪除。

對故障時間的適應性

最后,他們評估了AACFT模型在不同故障時間點的表現。結果顯示,AACFT方法在不同故障時間點都表現出較高的任務完成率,并且隨著故障時間的推遲,任務完成率有所提高。這與容錯系統的預期一致,進一步驗證了AACFT方法在不同故障條件下的適應性和魯棒性。

研究團隊通過一系列實驗和分析,驗證了AACFT方法在多智能體系統故障容錯能力方面的優越性能。通過引入注意力機制和優先級經驗回放,系統能夠更高效地識別和處理故障信息,保持系統的穩定性和任務執行的高效性。

平臺開發與開源

論文除了提出新的算法方法外,研究團隊還開發并開源了一個用于研究多智能體強化學習(MARL)故障容錯能力的新平臺(開源地址:https://github.com/xbgit/FaultTolerance AACFT)。該平臺不僅集成了最新的算法,還提供了豐富的工具和接口,使研究人員能夠更高效地進行實驗和驗證。

新平臺的設計與功能

新平臺的設計核心圍繞著簡化多智能體系統中故障容錯算法的研究與開發。平臺由多個模塊組成,包括運行模塊、算法控制器、環境控制器、故障控制器和課程控制器等。每個模塊負責不同的功能,確保系統的高效運行和易用性。例如,運行模塊負責處理多智能體與環境的交互,收集回放緩沖區中的轉變數據;算法控制器負責初始化、更新和執行智能體策略,并處理與故障相關的任務。

平臺還提供了一個配置模塊和一個日志模塊。配置模塊為算法、環境、故障以及訓練或測試設置提供相關參數,支持分離的配置文件,便于進行對比實驗。日志模塊則記錄算法、環境和故障控制器的數據,支持WandB集成和本地打印、保存訓練日志的選項。

故障控制器的集中管理

為了更高效地管理和處理智能體故障,平臺設計了一個專用的故障控制器。故障控制器集中管理故障的注入、故障智能體觀察和行為的修改、故障的重置以及故障相關數據的收集等功能。這一設計確保了故障修改不干擾主代碼模塊,提高了訓練和測試的效率。

通過將故障管理集中在一個專用的控制器中,平臺不僅簡化了故障處理的流程,還提高了系統的靈活性和可擴展性。研究人員可以在實驗過程中輕松注入和管理各種類型的故障,觀察系統在不同故障條件下的表現,從而深入研究多智能體系統的容錯能力。

用戶自定義故障類型和參數的支持

平臺的另一個重要特點是支持用戶自定義故障類型和參數。研究人員可以根據實驗需求,靈活地設置故障的時間、目標和概率。故障類型包括限制故障智能體的動作或向其觀察中添加噪聲等。通過這種方式,研究人員能夠在不同的實驗場景中,注入相同或多種類型的故障,從而研究不同算法在處理各種故障條件下的性能。

這種高度的可定制性使得平臺在應對復雜實驗需求時,展現出極大的靈活性和適用性。無論是對算法進行優化,還是驗證新方法的有效性,研究人員都能夠通過這一平臺,獲得更為準確和全面的實驗數據。

總結與展望

研究團隊通過引入注意力機制和優先級經驗回放(PER)策略,提出了一種新穎的多智能體強化學習(MARL)方法,旨在提升系統的故障容錯能力。通過一系列實驗驗證,該方法在處理各種類型和時刻的智能體故障方面表現優異,顯著提高了系統在任務完成率、通信維護和任務分配等方面的性能。

實驗結果顯示,AACFT方法在應對智能體故障時表現出色。通過與三種基線方法(M3DDPG、MADDPG、MADDPG+MC)的對比,AACFT方法在多個實驗場景中都顯示出明顯的優勢。具體而言,無論是在任務完成率還是在系統的穩定性和魯棒性方面,AACFT方法都優于其他基線方法。這些實驗結果不僅驗證了注意力機制在提升系統容錯能力中的重要作用,也證明了優先級經驗回放在解決訓練數據樣本不平衡問題中的有效性。

通過對智能體行為的可視化分析,研究團隊進一步展示了AACFT方法在處理智能體故障時的具體操作過程。結果表明,注意力機制能夠有效引導actor和critic網絡動態調整對故障信息的關注度,確保系統在故障情況下依然能夠高效運行。

盡管AACFT方法在實驗中表現出色,仍有一些領域值得進一步探索和改進。首先,研究團隊計劃在平臺中設計更多類型的故障,以檢驗方法在更廣泛的故障條件下的適應性和泛化能力。通過引入不同類型的故障,可以進一步驗證AACFT方法的魯棒性,并探索其在更復雜環境中的表現。

其次,研究團隊還計劃優化和擴展現有平臺,增加更多的功能模塊和工具,以支持更復雜的實驗設置和數據分析。例如,可以引入更多的環境和任務類型,以及更精細的故障模擬和監測工具,從而提供更全面的實驗數據支持。

此外,研究團隊將繼續探索其他先進的深度學習技術和算法,以進一步提升系統的性能和效率。例如可以考慮結合強化學習中的其他前沿技術,如對抗訓練、自適應學習率等,以提升系統的訓練效果和性能表現。

總之,研究團隊為多智能體系統的故障容錯能力研究提供了新的思路和方法。通過結合注意力機制和優先級經驗回放策略,AACFT方法顯著提升了系統在智能體故障情況下的表現。他們期待研究團隊繼續優化和擴展現有方法和平臺,探索更多可能的應用場景,為多智能體系統在實際中的應用提供更堅實的技術基礎。(END)

參考資料:

1.https://arxiv.org/abs/2412.00534

2. https://github.com/xbgit/FaultTolerance AACFT