基于模塊化思想,阿里達摩院提出多模態(tài)基礎模型mPLUG-2

對于多模態(tài)基礎模型,我們希望其不僅可以處理特定的多模態(tài)相關任務,還希望其處理單模態(tài)任務時也具有優(yōu)異的性能。阿?達摩院團隊發(fā)現(xiàn)現(xiàn)有的模型往往不能很好的平衡模態(tài)協(xié)作和模態(tài)糾纏的問題,這限制了模型在各種單模態(tài)和跨模態(tài)下游任務的性能。

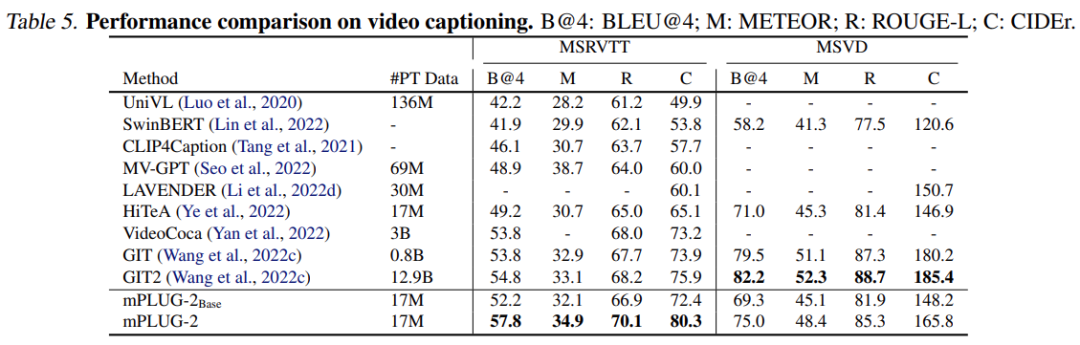

基于此,達摩院的研究者提出了 mPLUG-2,其通過模塊化的?絡結構設計來平衡多模態(tài)之間的協(xié)作和糾纏問題,mPLUG-2 在 30 + 多 / 單模態(tài)任務,取得同等數(shù)據(jù)量和模型規(guī)模 SOTA 或者 Comparable 效果,在 VideoQA 和 VideoCaption 上超越 Flamingo、VideoCoca、GITv2 等超?模型取得絕對SOTA。此外,mPLUG-Owl 是阿?巴巴達摩院 mPLUG 系列的最新工作,延續(xù)了 mPLUG 系列的模塊化訓練思想,把 LLM 升級為?個多模態(tài)?模型。mPLUG-2 的研究論文已被 ICML 2023 接收。

- 論?地址:https://arxiv.org/pdf/2302.00402.pdf

- mPLUG-2 地址:https://github.com/X-PLUG/mPLUG-2

- mPLUG-Owl 地址:https://github.com/X-PLUG/mPLUG-Owl

研究背景

?規(guī)模預訓練基礎模型是??智能領域的新興范式,涉及語?、視覺和多模態(tài)等多個領域。隨著 Transformer 體系結構的?泛成功,近年來已經出現(xiàn)了語?、視覺和多模態(tài)預訓練的?融合趨勢。

該趨勢下的?條主要線路是采?統(tǒng)?的序列?成框架來統(tǒng)?任務和模態(tài),如 T5、OFA 和 Flamingo 等。另?條主要線路則是將所有任務都視為實例區(qū)分 (instance discrimination),并采用純編碼器架構,如 BERT、Florence 和 BEIT-3 模型。

以上主流基礎模型提出為多模態(tài)數(shù)據(jù)建模共享的單?網絡 (single network),以此來利用模態(tài)協(xié)作的信息,如 Flamingo。然而,由于不同模態(tài)涉及到的任務的巨?差異,這種策略將?臨模態(tài)糾纏的問題,多個模態(tài)可能會相互干擾,特別是當存在多種模態(tài)和任務時。單模塊基礎模型難以平衡模態(tài)協(xié)作的收益和模態(tài)糾纏對多個跨模態(tài)下游任務的影響。

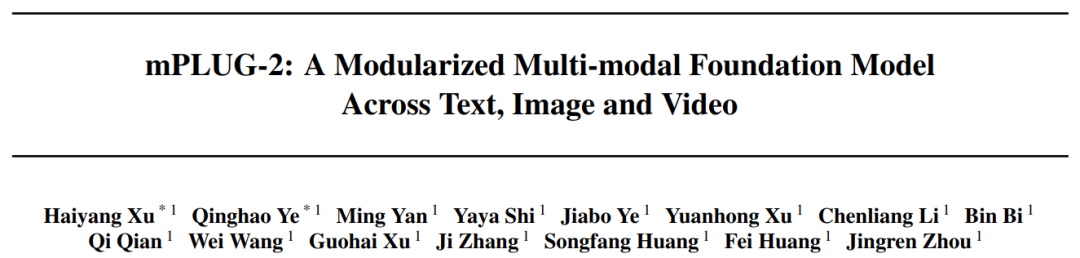

為了緩解這個挑戰(zhàn),在這項?作中,阿?達摩院團隊引?了?種新的多模態(tài)基礎模型的統(tǒng)?范式,如下圖 1 所示。它采?基于模塊的?絡設計來考慮到模態(tài)協(xié)作和模態(tài)糾纏之間的平衡。mPLUG-2 的研究者設計了特定的共享功能模塊 (functional modules),以?勵模態(tài)協(xié)作,同時保留特定于模態(tài)的模塊 (modality-specific modules) 以解決模態(tài)糾纏的問題。

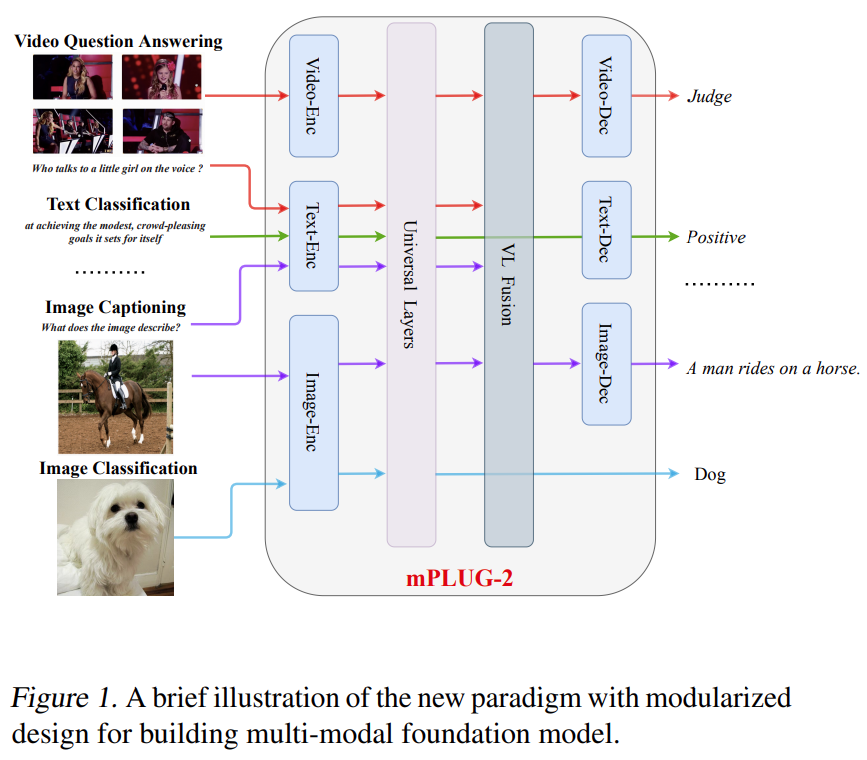

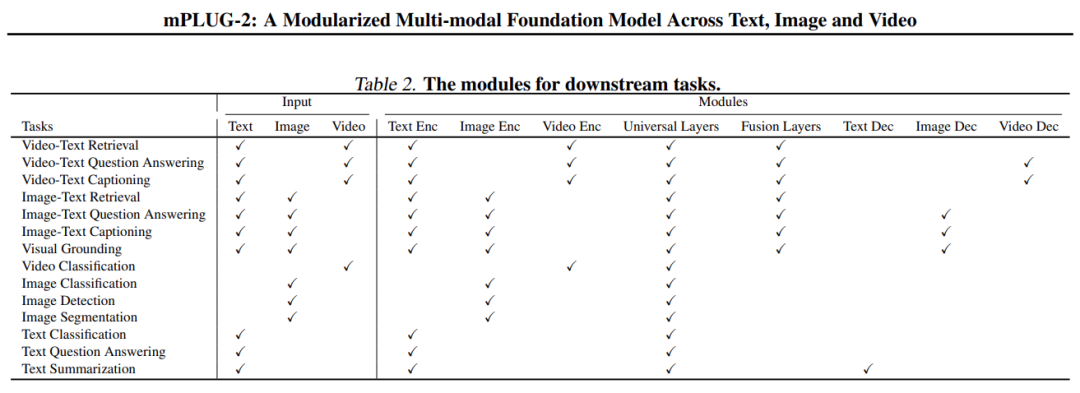

基于模塊化的設計,不同的模塊可以靈活地選取和組合,以適應?量的單模態(tài)和多模態(tài)的理解和?成任務。支持的下游任務的詳細信息在表 1 中給出,可以看到 mPLUG-2 可以處理多種跨?本、圖像和視頻的不同類型的下游任務。下表 2 中也提供了不同的下游任務所需要的模塊組合。

方法概覽

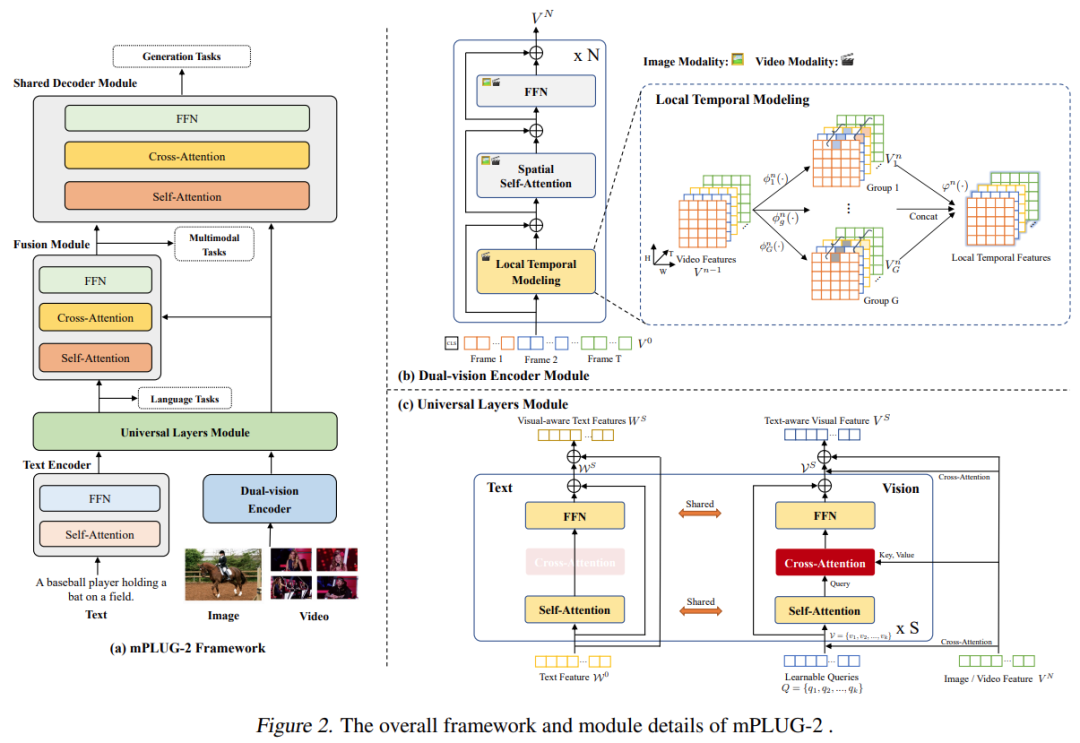

模型框圖如上圖 2 所示:(1) mPLUG-2 設計了?個統(tǒng)?的雙 (dual) 視覺編碼器模塊,其中視頻與圖像輸?共享的標準 Transformer 模塊,?于建模空間信息。局部時域建模模塊?于視頻相關任務的時域關系建模。(2) mPLUG-2 設計了?個新穎的通?層模塊 ( universal layers module),?于作為不同模態(tài)之間的樞紐,其通過共享?注意?模塊將視覺和語?模態(tài)投影到共同的以語?為導向的語義空間中。(3) mPLUG-2 使?額外的交叉注意?模塊將通?視覺表示 (universal vision representation) 與原始細粒度視覺表示融合。詳細的模塊設計如圖 2 所示。最后,mPLUG-2 的不同模塊通過任務和模態(tài)指令 (task and modality instructions) 在單模態(tài)和跨模態(tài)任務上進?聯(lián)合預訓練。在推理過程中,mPLUG-2 可以使?模塊化 Transformer 架構為各種單模態(tài)和交叉模態(tài)任務選擇不同的模塊。

mPLUG-2 的卓越性能

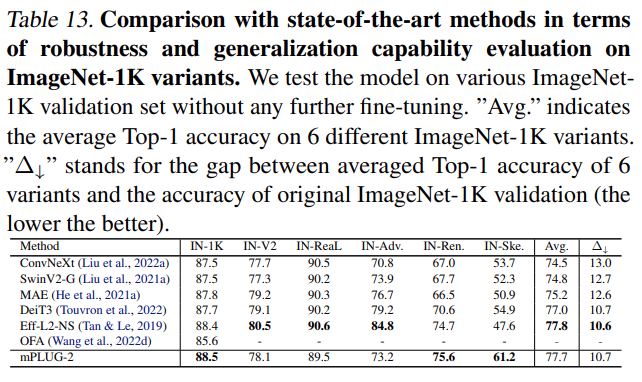

mPLUG-2 在 30 多個有挑戰(zhàn)性的單模態(tài)和跨模態(tài)理解和?成基準測試中評估了 mPLUG-2 的性能,它在相似的模型大小和數(shù)據(jù)規(guī)模下取得了最先進或有競爭力的結果。

這里展示幾個有代表性的實驗結果:

多模態(tài)任務

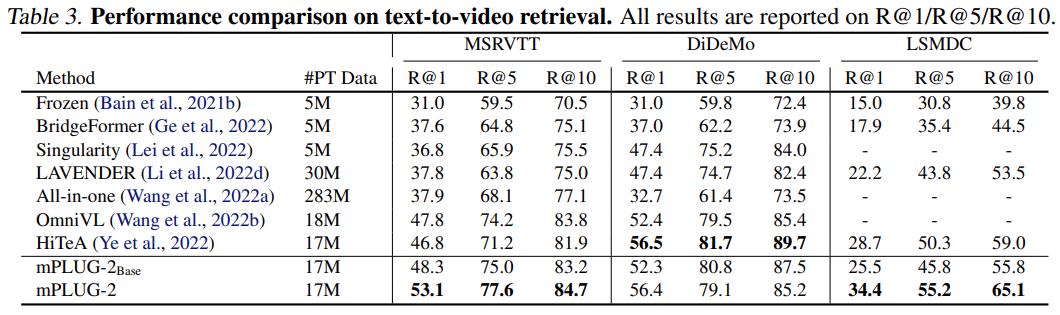

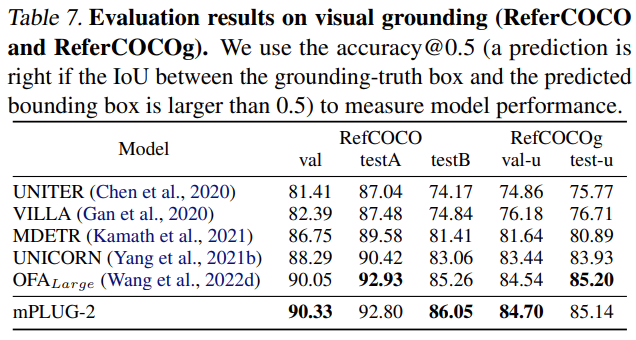

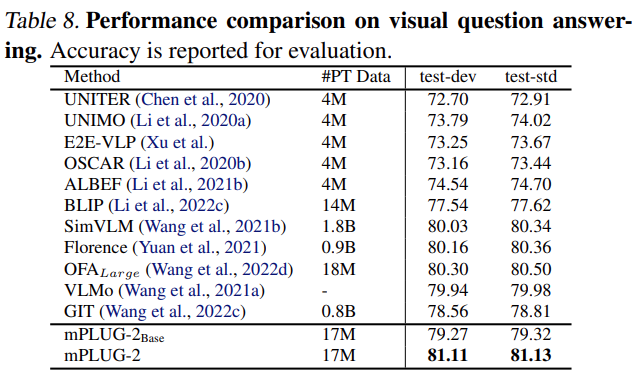

研究者在多模態(tài)理解型和生成型的相關任務上評測 mPLUG-2 的性能,包括: multimodal retrieval、question answering、visual grounding 和 captioning 等,實驗結果表明其可以得到 SOTA 的性能。

純語言任務

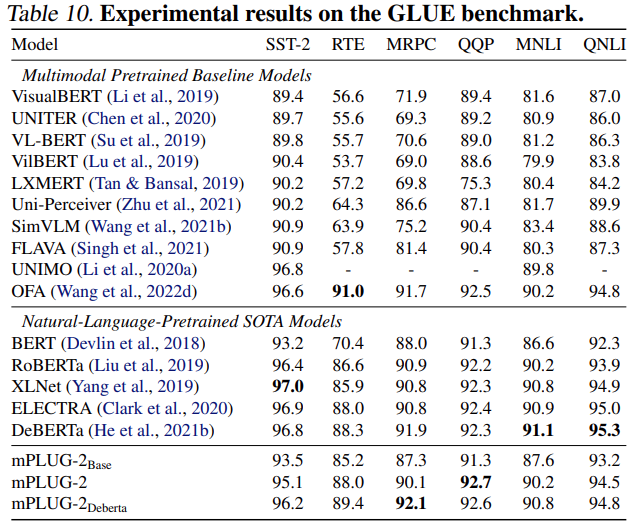

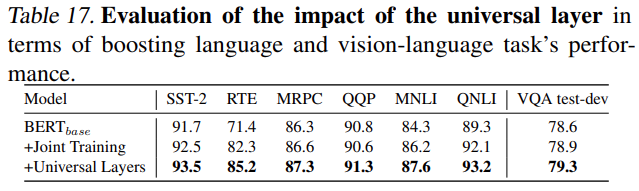

研究者發(fā)現(xiàn),相比于專?語?預訓練模型和其他多模態(tài)預訓練模型,mPLUG-2 在 GLUE benchmark 上可以取得可?的性能。實驗結果證明了使? universal layer 做模態(tài)協(xié)作的有效性。

純視覺任務

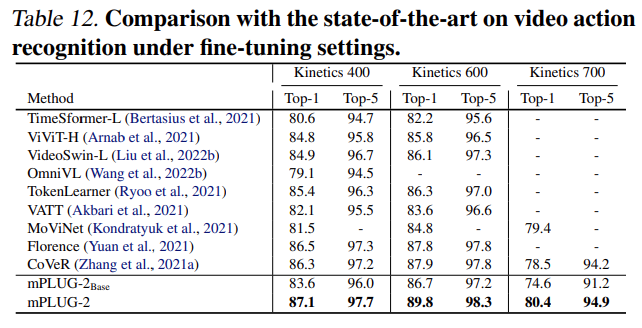

研究者發(fā)現(xiàn),mPLUG-2 在純視覺任務上,如行為識別,圖像分類任務,可以取得具有競爭力的性能。

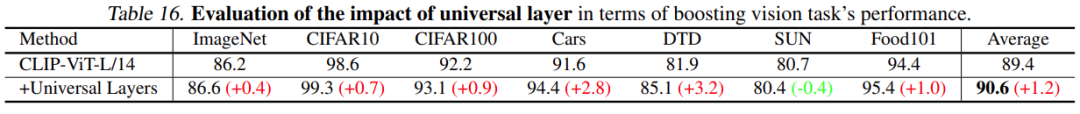

消融:用于模態(tài)協(xié)作的通用層 (universal layer) 的作用有多大?

研究者在 baseline 的基礎上,添加他們設計的通?層 universal layer。可以發(fā)現(xiàn),通過鼓勵模態(tài)協(xié)作,在單模態(tài)或者跨模態(tài)任務上,都會有明顯的性能提升,證明了通?層 universal layer 的有效性。

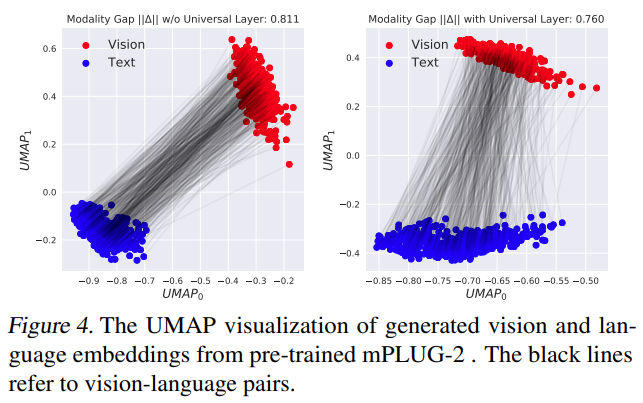

另外,研究者還發(fā)現(xiàn),?勵模態(tài)協(xié)作的通?層 universal layer 可以得到更小的 modality gap。

更多技術和實驗細節(jié)請參閱原論?。