達摩院發布大模型測試基準:GPT-4勉強及格,其他模型悉數落敗

隨著大模型的發展,尤其是近來各種開源大模型的發布,如何對各種模型進行充分并且準確的評估變得越來越重要。其中一個越來越受到認可的方向就是利用人類考題來檢驗模型,從而可以測試模型的知識及推理能力。例如對于英文模型,MMLU 已經被廣泛用來評估模型在多個學科上的表現。類似的,最近中文社區也涌現了例如 C-Eval 以及 GAOKAO 這種利用中文試題來測試模型,特別是中文模型的表現。

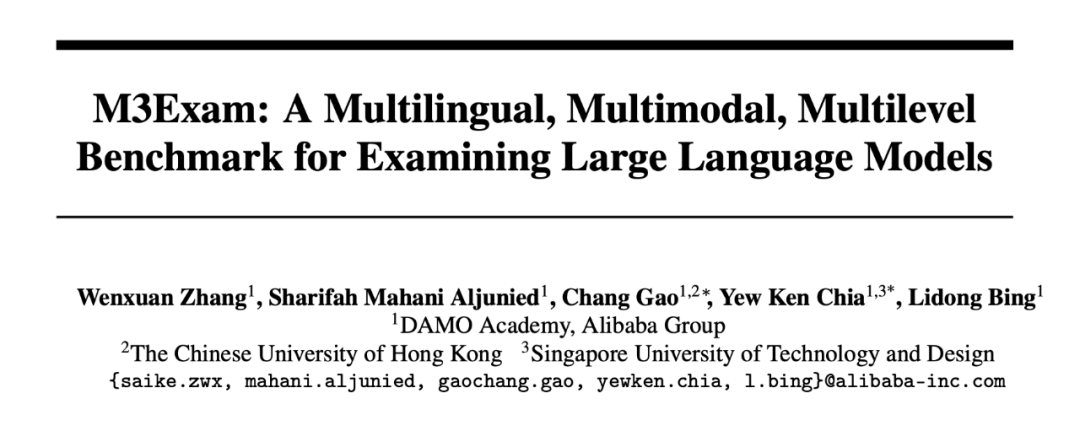

這樣的測試基準對于促進模型的發展起著至關重要的作用,然而對于多語言 / 多模態大模型,相應的評測依然是一片空白。由此,阿里巴巴達摩院多語言 NLP 團隊發布了首個多語言多模態測試基準 M3Exam 以推動此類評測的發展,論文和數據代碼已公開:

圖片

圖片

- 論文:https://arxiv.org/pdf/2306.05179.pdf

- 數據 & 代碼:https://github.com/DAMO-NLP-SG/M3Exam

背景

傳統的 NLP 任務已經越來越難充分測試大語言模型的真正效果,在這樣的背景下,利用人類考題來檢驗模型已經逐漸成為了測試大模型的一個常見做法。例如 MMLU 數據集涵蓋了多個學科,被廣泛用來測試各種模型,GPT-4 也將其作為一個重要的測試基準。類似地,最近一個月我們也看到了中文上的類似嘗試例如 C-Eval 和 GAOKAO,將各類 / 高考的中文試題匯總起來用以測試中文大模型。

然而目前的測試基準都僅有英文或者加上中文問題,盡管許多模型涌現 / 宣稱有多語言的效果,模型的多語言能力無法得到充分測試。此外,多模態類問題,也即涉及圖片的考題也往往在構建過程中被忽略。這導致了多語言 / 多模態大模型的效果無法被準確衡量。為了彌補這一空白,我們構建了 M3Exam - 一個利用人類考題構建的多語言、多模態、多級別的測試基準,共涵蓋 12317 道題目。

圖片

圖片

正如名字所示,M3Exam 有三個特征:

- Multilingual 多語言:我們綜合考慮語言特點、資源高低、文化背景等多個因素,挑選了 9 個國家對應的語言,涵蓋英文、中文、意大利語、葡萄牙語、越南語、南非荷蘭語、斯瓦希里語、泰語、爪哇語,所有問題均來自于對應國家的官方試題。

- Multimodal 多模態:我們同時考慮純文字以及帶圖片的題目,并且認真處理了所有圖片從而方便模型進行處理。

- Multilevel 多階段:我們考慮三個重要的教育階段:小升初、初升高、高中畢業,并且從對應階段的官方考試取得題目,使得可以比較不同階段對應的不同智力要求下,模型的表現差異。

多語言測試

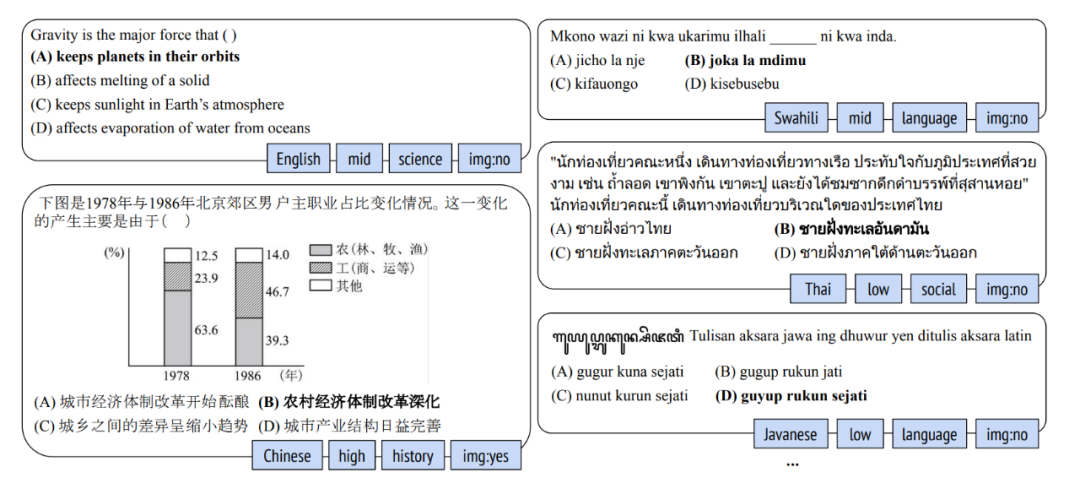

我們選取了多種開源、閉源模型來測試它們的多語言能力,結果如圖所示:

圖片

圖片

可以看到雖然許多模型的英文效果不錯(比如 Claude 和 ChatGPT 都可以達到 75% 左右),但平均而言效果均不佳。GPT-4 是唯一一個可以超過 60% 準確率的模型,而 ChatGPT 也只能達到 57% 的準確率。從語言的角度看,在低資源或者非拉丁字符語言比如泰語、爪哇語上,即使是 GPT-4 也只能達到 50+% 的準確率。這顯示目前大部分模型的能力仍然是集中體現在英文上,多語言能力仍然有待提高。

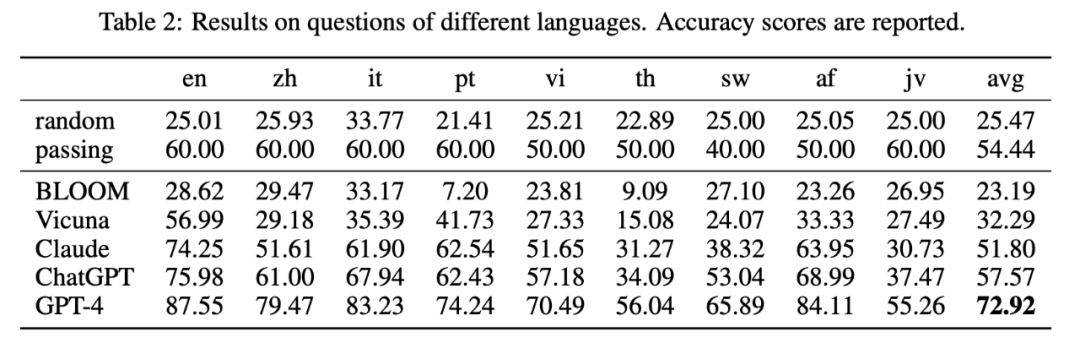

我們同樣可以看到,來自于各個國家本土的問題更加充分地測試出了模型的多語言能力。例如 GPT-4 的 report 里將 MMLU 翻譯成了多個語言,在不同語言的翻譯試題上取得了較好的結果。但是如果用真實場景下的問題,這迫使模型必須學習到每個語言,甚至是其背后對應的文化背景知識,才能解答。例如上圖中給的例子,斯瓦希里語涉及到一個諺語的填空;泰語則涉及到泰國本地常見的自然景觀特點:

圖片

圖片

可以看到,即使是根據準確的翻譯(上圖的英文翻譯由泰語母語者提供),但沒有對應的語言、文化常識也無法作答,體現出對模型多語言能力的充分測試。

多模態測試

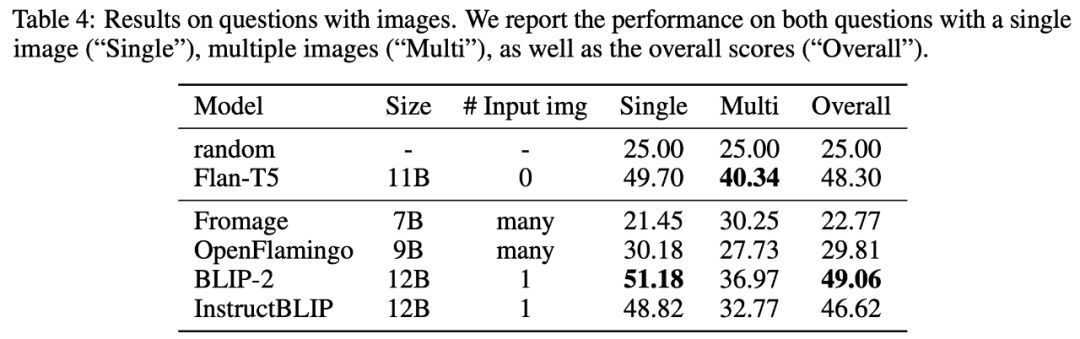

我們也選取了多個多模態大模型并對其進行測試,包括 Fromage, OpenFlamingo, BLIP-2, InstructBLIP,結果如下圖所示:

圖片

圖片

可以看到,大部分模型表現都很糟糕,甚至沒有模型可以超過 50% 的準確率。即使跟相近參數量的 Flan-T5 模型相比(Flan-T5 并沒有拿圖片當作輸入),多模態模型基本沒有體現出優勢。

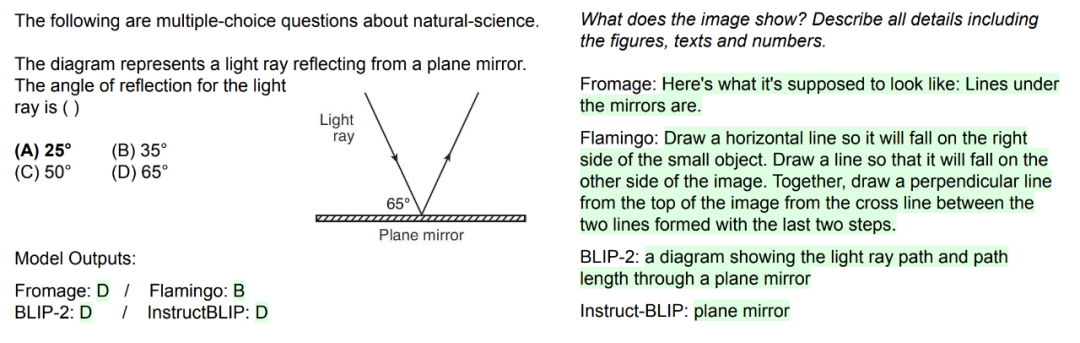

進一步檢查我們發現,可能是因為現有的多模態測試數據都比較簡單,例如 VQA 中往往只是對圖片的某一方面進行簡單提問。而人類考題往往涉及到對圖片更復雜的理解,例如數理類考試中需要注意到圖片的數字細節。下圖給了一個具體問題以及各個模型的輸出:

圖片

圖片

可以看到所有模型均回答錯誤。為了進一步檢驗模型對圖片理解的程度,我們額外構造了一個 prompt 讓模型對圖片的各種細節進行描述(上圖右邊),可以看到所有模型都無法準確描述出圖片里標注的角度 65 度,所以自然無法解答出圖中的反射角是多少度。

多層級測試

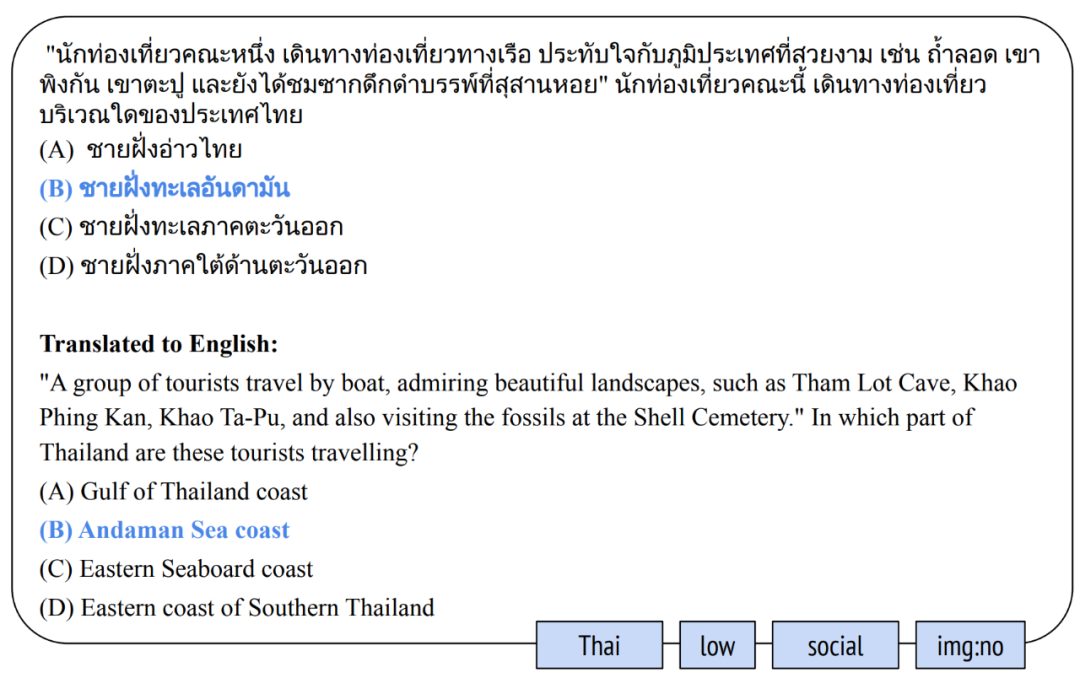

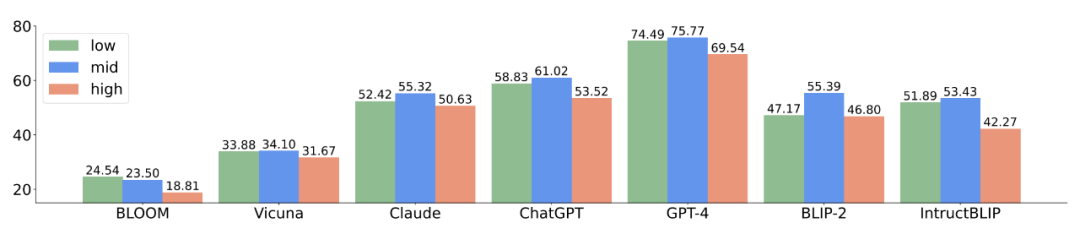

在數據構造過程中,我們選取了三個重要的考試階段,即小升初、初升高、高中升大學。值得注意的是我們發現即使各個國家的教育體系各有差異,但基本都有相應的教育階段。不同的教育階段往往對應著在不同國家,大家對相應年齡段人群所期待的智力水平。這樣的劃分給我們提供了用不同教育階段的問題來觀察模型效果的角度。結果匯總如下圖所示:

圖片

圖片

可以看到出人意料的是,從較低的教育階段到更高階段,模型效果并沒有呈現顯著下降。奇怪的是基本所有模型都在中等階段的問題上表現最好。然而對于人類來說,例如在中國,如果能在高考中得到 70% 左右的正確率,解決小學考題應該是輕而易舉的事情,然而對模型來說似乎并不如此。

這個觀察給我們帶來的啟發是,不斷用更困難的數據去測試模型不一定能最大限度衡量出模型的差異。如果想要可靠地在實際生活中使用模型,例如用于 AI 教育,研究為什么模型會在基礎問題上犯錯可能更有價值。

結語

這篇文章介紹了我們新創建的測試基準 M3Exam,目標是可以為多語言 / 多模態大模型的評價提供一個可靠的基準。從目前的測試結果我們可以看出,雖然不少模型在高資源語言例如英文甚至中文上已經可以取得還不錯的效果,但在多語言情況下絕大部分模型的效果都差強人意。多模態模型的效果則更難令人滿意,顯示目前的多模態模型還只能對圖片的簡單特征進行捕捉,而無法捕捉更精確的細節。我們期待 M3Exam 未來可以幫助相關模型的開發迭代,從而將大模型的便利帶給所有語言的使用者以及更豐富的使用場景。