開源即爆火!英偉達(dá)重磅推出OmniVinci全模態(tài)大模型

全模態(tài)智能,英偉達(dá)的下一步

你是否想過,未來的 AI 將會是什么樣子?

是只會打字的 Chat Bot,只會看圖的 VLM,還是只能分辨聲音的 ALM?

都不是! 真正的智能,應(yīng)該像我們?nèi)祟愐粯樱軌蛲瑫r看、聽、說、寫,既能看懂世界的五彩斑斕,也能聽懂萬物的聲音。

在不久前結(jié)束的英偉達(dá)華盛頓 GTC 大會上,老黃再三強(qiáng)調(diào) “研究人員需要開源。開發(fā)者依賴開源。全球的公司,包括我們都離不開開源模型。開源非常,非常,重要。” 在老黃的號召下,全模態(tài)理解模型迎來重量級新玩家 —— 英偉達(dá)(NVIDIA)開源了 OmniVinci, 一款能理解多模態(tài)世界的全模態(tài)大語言模型(Omni-Modal LLM)。該模型實(shí)現(xiàn)了視覺、音頻、語言在同一潛空間(latent space)中的統(tǒng)一理解, 讓 AI 不僅能識別圖像、聽懂語音,還能推理、對話、生成內(nèi)容。這個 9B 的視覺 - 語音理解全模態(tài)模型剛上線就爆火,一周時間 Huggingface 模型權(quán)重目前已經(jīng)有超過 10000 次下載量!

- 論文標(biāo)題:OmniVinci: Enhancing Architecture and Data for Omni-Modal Understanding LLM

- 項(xiàng)目地址:https://github.com/NVlabs/OmniVinci

- 論文地址:https://arxiv.org/abs/2510.15870

- 開源模型:https://huggingface.co/nvidia/omnivinci

秀翻全場!多模態(tài)理解性能全面超越

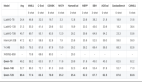

和相近尺寸的全模態(tài)模型競品相比,OmniVinci 在多項(xiàng)常用多模態(tài)基準(zhǔn)測試榜單中取得了顯著優(yōu)勢,包括視頻 - 音頻跨模態(tài)理解任務(wù)(DailyOmni +19.05),音頻理解 (MMAR + 1.7),和視頻理解 (Video-MME +3.9),展現(xiàn)出卓越的全模態(tài)理解能力。更重要的是,OmniVinci 少用了近 6 倍的數(shù)據(jù)量實(shí)現(xiàn)了超越,展現(xiàn)了其架構(gòu)和數(shù)據(jù)引擎的卓越效率。

三大架構(gòu)創(chuàng)新:讓視覺與聽覺在同一空間共鳴

OmniVinci 不僅具備炸裂的榜單性能,其論文中通過大量科學(xué)實(shí)驗(yàn)探索最優(yōu)全模態(tài)模型架構(gòu)的方法,而不是粗暴堆疊訓(xùn)練數(shù)據(jù),這種做法顯然更值得借鑒。想象一下,AI 看視頻時,畫面(視覺)和聲音(音頻)是兩條獨(dú)立的信息流。如果模型架構(gòu)對此處理不好,AI 就會 “精神分裂”。而 OmniVinci 的目標(biāo)就是讓它們完美同步,通過三項(xiàng)核心創(chuàng)新設(shè)計(jì)來實(shí)現(xiàn):

OmniAlignNet:跨模態(tài)語義對齊網(wǎng)絡(luò)

這就像一個 “超級翻譯器”,讓模型在同一空間中 “看得見聲音,聽得懂畫面”。它創(chuàng)建了一個共享空間,通過對比學(xué)習(xí) ,讓視覺信號和音頻信號能在這里用同一種 “語言” 無障礙交流,實(shí)現(xiàn)跨模態(tài)深度對齊 。

Temporal Embedding Grouping (TEG):時間嵌入分組機(jī)制

將視覺幀與音頻信號按時間戳重組,使模型能跨模態(tài)感知事件的相對先后關(guān)系。AI 終于能搞清楚,是 “先開槍再有槍聲”,還是 “先有閃電再有雷聲”。它通過按時間戳分組,讓 AI 理解事件的先后順序 。

Constrained Rotary Time Embedding (CRTE):受約束旋轉(zhuǎn)時間嵌入

通過時間旋轉(zhuǎn)編碼,模型獲得絕對時間感知能力。AI 不僅知道 “先” 和 “后”,還知道這件事發(fā)生在視頻的第 5 秒,還是第 50 秒。

有了這三板斧,OmniVinci 才真正擁有了準(zhǔn)確感知視覺,音頻和時間流逝的能力。

數(shù)據(jù)引擎:24M 多模態(tài)對話的背后

模型強(qiáng)度離不開數(shù)據(jù)支撐。OmniVinci 團(tuán)隊(duì)構(gòu)建了一個龐大的全模態(tài)數(shù)據(jù)引擎(Omni-Modal Data Engine),共涵蓋 2400 萬條多模態(tài)對話樣本,覆蓋圖像、視頻、音頻、語音四大領(lǐng)域。數(shù)據(jù)分布中,圖像占 36%、音頻與語音共占 38%、視頻 11%、全模態(tài)數(shù)據(jù) 15%。其中包括兩種創(chuàng)新的全模態(tài)學(xué)習(xí)方式:

- 隱式全模態(tài)學(xué)習(xí)(Implicit Learning)

直接利用現(xiàn)有視頻自帶音頻的問答數(shù)據(jù),讓模型在 “看視頻” 的同時 “聽聲音”。

- 顯式全模態(tài)學(xué)習(xí)(Explicit Learning)

通過 AI 單獨(dú)生成視覺和音頻模態(tài)專屬的描述,再由 LLM 進(jìn)行交叉修正與融合,解決了單模態(tài)模型常見的 “幻覺”(如只看畫面誤判語義)。

實(shí)驗(yàn):打造全模態(tài)模型的關(guān)鍵洞察

[關(guān)鍵洞察 1] 單一模態(tài)打標(biāo) = 不靠譜!告別 “模態(tài)幻覺”

團(tuán)隊(duì)發(fā)現(xiàn),很多 AI 模型都有 “模態(tài)幻覺”: 只看圖(視覺):AI 看到一個深海機(jī)器人,可能會 “腦補(bǔ)” 說這是人類高科技的勝利 。只聽聲(音頻):AI 聽到旁白說 “地球最深處”,可能會 “瞎猜” 說這是關(guān)于地心的紀(jì)錄片 。因此一個集成了兩種模態(tài)的聯(lián)合字幕方法對于全面理解至關(guān)重要。

[關(guān)鍵洞察 2] 1 + 1 > 2!當(dāng)聽覺 “點(diǎn)亮” 視覺

加上音頻,模型真的變強(qiáng)了嗎?答案是肯定的! 團(tuán)隊(duì)發(fā)現(xiàn),聲音為視覺提供了全新的信息維度,音視頻聯(lián)合學(xué)習(xí)能顯著提高視頻的理解能力 。只用視覺 (Visual Alone) 視覺 + 音頻 (隱式學(xué)習(xí) IL) 視覺 + 音頻 + 全模態(tài)數(shù)據(jù)引擎 (顯式學(xué)習(xí) EL) 結(jié)果顯示 (見下表),每增加一步,性能都在飆升!特別是加入了數(shù)據(jù)引擎的 “顯式學(xué)習(xí)” 后,模型性能在多個基準(zhǔn)上都實(shí)現(xiàn)了巨大飛躍。

[關(guān)鍵洞察 3] 王牌對王牌:當(dāng) OmniVinci 遇上 “強(qiáng)化學(xué)習(xí)”

基礎(chǔ)模型已經(jīng)這么強(qiáng)了,還能再進(jìn)化嗎? 能!通過強(qiáng)化學(xué)習(xí) (RL)!

音頻,讓強(qiáng)化學(xué)習(xí) “如虎添翼”! 團(tuán)隊(duì)在使用 GRPO 強(qiáng)化學(xué)習(xí)框架時發(fā)現(xiàn)了一個 “隱藏 Buff”: 只給 AI 看視頻(視覺)去訓(xùn)練,遠(yuǎn)不如 “邊看邊聽”(視聽結(jié)合)的效果好! 如圖所示,加入音頻后,模型的收斂速度更快。

強(qiáng)強(qiáng)對決,OmniVinci 更勝一籌! 在這個多模態(tài) RL 框架下,OmniVinci 和 Qwen2.5-Omni 都能獲益 。但是,OmniVinci 憑借更強(qiáng)的基礎(chǔ)性能和指令跟隨能力,在 15 步內(nèi)就超越了 Qwen2.5-Omni 的準(zhǔn)確率,并且格式獎勵收斂速度快了 2.7 倍 ! 最終,經(jīng)過 RL 訓(xùn)練的 OmniVinci+RL,在所有全模態(tài)基準(zhǔn)上再次實(shí)現(xiàn)全面提升!

不止是 SOTA,是全能 Agent

跑分只是基礎(chǔ),真正的全模態(tài) AI,必須能在真實(shí)世界 “大顯身手”。

OmniVinci 做到了。研究團(tuán)隊(duì)用它測試了 N 個真實(shí)場景,效果非常好 :

場景一:聯(lián)合視聽感知

你給它一段播客視頻,它不僅能看懂主持人和嘉賓的外形,更能 “聽懂” 他們討論的復(fù)雜話題。

場景二:語音轉(zhuǎn)錄 + 翻譯

你對它說話,它能瞬間轉(zhuǎn)錄成文字。

場景三:全語音交互

你用語音問:“這個演講者的公司使命是啥?”

它立刻用語音答:“他的公司使命是在火星上建立一個自我維持的文明。”

場景四:指揮機(jī)器人,直接 “張嘴說”!

OmniVinci 能直接聽懂你的語音指令(比如 “進(jìn)入臥室,在床腳站住” ),然后規(guī)劃下一步行動。這才是真正實(shí)用的人機(jī)交互!

場景五:AI 看懂 “專家會診”!

醫(yī)生一邊滾動查看 CT 影像,一邊用嘴說出診斷(“這里我們看到一些肺大皰和相關(guān)的纖維化改變...” ) 。OmniVinci 能同時 “看” CT 影像的動態(tài)變化 ,并 “聽” 懂醫(yī)生的專業(yè)解說 ,準(zhǔn)確回答 “肺部紋理隨時間如何變化?” 這類高難度問題,在醫(yī)療 AI 上大展身手 !

場景六:AI “全能解說” 體育比賽!

看網(wǎng)球比賽,AI 不再是 “睜眼瞎”。OmniVinci 能同步理解激烈的視覺動作(誰在發(fā)球、誰贏了這一分)和解說員的評論。在預(yù)測得分結(jié)果和回合長度上,它完勝 Qwen2.5-Omni。更重要的是,量化后在消費(fèi)級顯卡 GeForce RTX 4090 上它延遲極低,完全可以用于電視直播!

這不就是賈維斯嗎?

寫在最后

OmniVinci 的出現(xiàn),可能不僅僅是一個新 SOTA 9B 全模態(tài)模型的誕生,它更代表了一種全新的 AI 范式。

未來,AI 不再是割裂的 “視覺模型” 或 “音頻模型”,而是統(tǒng)一的 “全模態(tài)感知系統(tǒng)”。

更低的訓(xùn)練成本,意味著更快的迭代和更廣泛的應(yīng)用。從能聽懂指令的機(jī)器人,到能理解醫(yī)生口述和 CT 影像的醫(yī)療 AI,再到監(jiān)控異常聲音和畫面的智能工廠,一個更智能的未來,正在加速到來。

英偉達(dá)這次,又交出了一份驚艷的答卷。

對于 OmniVinci,你怎么看?你最期待它被用在什么地方?歡迎在評論區(qū)留下你的 “神預(yù)言”!