美團開源全模態,比肩頂級閉源模型,開源新SOTA

美團LongCat團隊發布了5600億參數開源全模態模型LongCat-Flash-Omni。

LongCat-Flash-Omni能實現毫秒級的實時音頻-視覺交互。不僅能理解復雜的模態組合,還能像人一樣進行低延遲的實時對話。這在AI通往具備全模態感知與交互能力的路上,又劃上了一筆。

一個模型聽懂看懂還能聊

LongCat-Flash-Omni的核心是一個端到端的全模態架構。

它可以像一個統一的大腦,接收文本、音頻、圖像、視頻或是這些信息的任意組合作為輸入,然后直接生成包含語義和情感的語音。

這個大腦由幾個關鍵部分協同工作:一個敏銳的視覺編碼器、一套完整的音頻處理工具、一個強大的語言模型主干,以及一套為實時交互量身定制的流式處理機制。

模型的眼睛是LongCat-ViT(視覺變換器),一個經過精心設計的視覺編碼器。

它解決了傳統視覺模型的一個痛點:固定分辨率。

傳統模型在處理圖片前,通常需要粗暴地將圖片縮放或裁剪成一個固定尺寸,這無疑會損失信息。LongCat-ViT則原生支持各種分辨率和寬高比的輸入,無論是高清大圖還是手機豎屏視頻,都能最大程度地保留原始信息。

這個視覺編碼器在傳統Vision Transformer(視覺變換器)結構之上,集成了一系列增強設計,比如能同時處理圖像和視頻的統一分塊模塊、更精準捕捉空間位置的二維旋轉位置嵌入(2D-RoPE)、以及提升穩定性和效率的SwiGLU激活函數和RMSNorm層。

為了在實時交互中快速處理視頻流,模型的視覺編碼器采用了相對輕量級的配置,參數量為6.37億。

LongCat-ViT的訓練過程也頗具巧思,它采用漸進式方案。模型先從固定低分辨率(如224x224)的圖像學起,這是課程學習的思路,讓模型先掌握基礎視覺概念。然后,再逐步過渡到處理原生分辨率的圖像和視頻。這種由易到難的學習方式,不僅節約了大量的計算資源,也讓模型收斂得更快更穩定。

模型的聽覺和說話能力,經歷了一次重要的進化。

在訓練的早期階段,模型使用一個音頻標記器(Tokenizer),將連續的音頻波形轉換成離散的編碼,就像把語音翻譯成一種特殊的文字。

這種做法的好處是,模型可以像處理文本一樣,用統一的下一token預測方式來學習和生成語音,訓練效率很高。這個標記器是LongCat-Audio-Codec,它以16.67赫茲的頻率將音頻離散化為四個碼本,一個碼本負責語義,另外三個負責音色、音調等聲學細節。

團隊很快發現,這種離散化處理會損失聲音中微妙的細節,比如語氣中的猶豫、環境中的微弱背景音。

為了讓模型聽得更真切,從訓練的第五階段開始,引入了一個音頻編碼器。這個編碼器不再將音頻文字化,而是將其轉換為連續的音頻特征(即向量表示),直接輸入給LLM主干。

有趣的是,在生成語音時,模型仍然輸出離散的音頻token。

這保證了生成過程與LLM固有的預測范式一致。隨后,一個高效的音頻解碼器將這些token實時轉換回流暢的語音波形。這個解碼器同樣來自LongCat-Audio-Codec,支持流式解碼,延遲極低,僅需超前三幀數據即可工作。

這個音頻編碼器本身也是為低延遲而生的流式架構。

它將音頻切分成每80毫秒一幀的片段,并通過一種名為FSMN(前饋序列記憶網絡)的高效結構來處理。為了在延遲和性能間找到最佳平衡,只有最后幾層處理單元會稍微偷看一點未來的信息,而前面的層則嚴格按時間順序處理,保證了極快的響應速度。

模型思考和決策的核心,是建立在LongCat-Flash之上的一個5600億參數的MoE(混合專家)語言模型。根據任務內容,它會智能地選擇激活一小部分最相關的專家(約270億參數)。

這種選擇性思考的機制,使得LongCat-Flash-Omni在擁有巨大知識儲備的同時,計算效率極高,為實時交互提供了可能。

要實現流暢的實時音視頻對話,模型必須能同步處理來自攝像頭和麥克風的連續數據流。

LongCat-Flash-Omni為此設計了一套精妙的視頻策略和流式交互機制。

視頻處理本身就是一個難題,時長、分辨率、幀率千差萬別。模型采用動態幀采樣策略,默認每秒采樣2幀(2 FPS),但會根據視頻長短動態調整。短視頻會以更高幀率采樣,確保信息密度;超長視頻則會均勻采樣,避免內存爆炸。

為了讓模型理解視頻的時間順序,每個視頻幀前面都會被加上一個文本時間戳。這樣,輸入給LLM的序列就形成一個時空交錯的序列。

在實時交互中,模型采用了一種稀疏-密集采樣策略,堪稱點睛之筆。

當用戶正在說話或進行操作時,模型會以2 FPS的密集采樣率,專注地看和聽,盡可能捕捉所有信息。

當輪到模型回應時,它會切換到0.5 FPS的稀疏采樣率,用余光關注著視頻流,既保留了對環境的感知,又大大降低了計算開銷,為自身的思考和生成騰出資源。

音頻和視頻的特征被切分成以1秒為單位的同步數據塊,像拉鏈一樣交錯輸入LLM。這種時間同步、分塊交錯的機制,確保了模型能盡早接收到用戶的視聽信息,從而將響應延遲降到最低。

模型學會了十八般武藝

訓練一個能處理所有模態的模型,最大的挑戰在于不同模態數據的性格迥異。

文本是高度濃縮的符號,語義密度極高。語音雖然也是序列信號,但信息密度遠低于文本,還夾雜著情感、口音等副語言信息。視覺信息則是空間性的,視頻更是在空間之上增加了時間維度,復雜度指數級增長。

面對這種異質性,直接將所有數據一鍋燉效果很差。LongCat-Flash-Omni的訓練借鑒了人類的學習過程,采用了一種課程啟發的漸進式策略,分階段、由易到難地學習。

LongCat-Flash-Omni的訓練被劃分為五個核心階段。

模型首先在一個高質量、多樣化的純文本語料庫(約16萬億token)上進行訓練。這為模型打下了堅實的語言基礎,使其成為一個知識淵博、邏輯清晰的文化人。

在語言能力穩固后,引入結構上最接近文本的語音數據。模型學習將聲音信號與語言模型的語義空間對齊,理解語音中的語義和副語言信息。此時,語音被處理成離散的token。

模型開始學習看圖。大規模的圖像-文本對和圖文交錯數據被引入,模型開始建立視覺表征與語言概念之間的連接,學會看圖說話、理解圖中的復雜關系。

引入最復雜的視頻數據。模型開始學習理解時空動態,進行事件推理。同時,更高質量、更多樣化的圖像數據也被加入,進一步強化模型的視覺理解深度。

模型的記憶力從8000token擴展到128000token。通過專門的長上下文多模態數據進行訓練,模型學會了處理長視頻、長文檔,并能在漫長的對話中保持上下文一致性。

這是為了解決階段1中離散語音token帶來的信息損失問題。模型在這一階段學習直接處理連續的音頻特征,這使其能夠捕捉到更細微的聲學細節,顯著提升了下游語音任務的保真度和性能。

這個由簡到繁、層層遞進的訓練策略,確保了模型在學習新模態能力的同時,不會遺忘或削弱已有的單模態能力,最終成長為一個真正的全能選手。

龐然大物也能身輕如燕

一個強大的模型,從訓練完成到能被用戶流暢使用,還需要高效的工程技術作為支撐。

預訓練之后,模型會經歷監督微調(SFT)和強化學習(RL)兩個階段。

SFT階段,模型通過學習海量高質量的指令數據,學會更好地理解和遵循人類的意圖。這些數據覆蓋了多模態理解、推理、交互對話和專業領域知識。

特別是為了實時交互,團隊專門策劃了模擬真實場景的語音-視覺問答、實時視頻分析等多模態交互數據。

強化學習階段則更進一步,通過引入人類偏好數據,訓練一個獎勵模型,然后利用這個獎勵模型來指導語言模型生成更符合人類喜好、更有用、更安全的回答。

訓練一個5600億參數的全模態模型,對計算基礎設施是巨大的考驗。

最大的挑戰在于模型和數據的異質性。

LLM、視覺編碼器、音頻編碼器各有各的計算和內存需求。

為了解決這個問題,團隊提出了模態解耦并行(MDP)策略。

這個策略的核心思想是因材施教,允許不同模odal組件采用最適合自己的并行策略。比如,LLM部分采用張量并行和流水線并行,而視覺和音頻編碼器則采用數據并行。

為了協調這些以不同方式運行的組件,團隊設計了一個名為ModalityBridge的通信框架,負責在它們之間高效地同步梯度和傳輸數據。這種解耦設計,使得多模態訓練的吞吐量能夠維持在純文本訓練的90%以上,效率極高。

此外,團隊還進行了一系列性能和內存優化。通過梯度檢查點技術,用計算換內存;通過混合精度訓練,減少內存占用;通過使用FlashAttention等內存高效的算子,降低計算過程中的內存峰值。這些策略共同保證了龐大的模型能夠在現有的硬件資源上穩定高效地進行訓練。

為了實現低延遲的實時交互,推理框架的設計至關重要。

團隊設計了一個解耦的推理框架,將視覺處理、音頻處理、LLM推理和音頻合成等模塊拆分為獨立的服務。這種設計允許它們并行工作,極大地降低了端到端的延遲。

更核心的是一個異步流式管道。

輸入的音頻和視頻流被切分成小塊,并被異步地送入各自的編碼器。編碼后的特征再異步地送入LLM進行處理。LLM生成的文本和音頻token也是流式地輸出。

正是這套精心設計的推理系統,讓激活270億參數的LongCat-Flash-Omni,也能實現250毫秒的驚人響應速度。

全能選手的成績單令人矚目

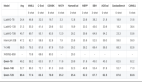

LongCat-Flash-Omni在視覺、音頻、文本以及跨模態的多個權威基準測試中,都展現了強大的性能。

在圖像理解方面,模型在VQAv2、TextVQA、DocVQA等多個基準上都取得了頂尖成績,尤其是在需要細粒度理解的文檔問答(DocVQA)上表現突出。

在視頻理解方面,模型在需要時空推理的TempCompass和MuirBench上表現出色,證明了其強大的動態場景理解能力。

在音頻理解方面,無論是在語音識別基準LibriSpeech上,還是在更具挑戰性的多語言語音識別基準FLEURS上,模型都超越了現有的主流模型。

在音頻指令跟隨任務,如音頻問答和音頻描述上,模型同樣表現優異。

作為模型的基礎,其文本能力也保持在頂尖水平。

在綜合性的跨模態理解基準OmniBench上,模型展現了強大的多模態信息整合與推理能力。

LongCat-Flash-Omni通過統一的框架,將強大的離線理解能力和低延遲的實時交互能力無縫結合,并開源了模型和其背后的技術思路,為通往更自然、更高效人機交互的未來,鋪下了一塊堅實的基石。