NeurIPS 2025|VFMTok: Visual Foundation Models驅(qū)動(dòng)的Tokenizer時(shí)代來(lái)臨

視覺 Tokenizer 的困境與破局

近年來(lái),自回歸(Autoregressive, AR)模型在語(yǔ)言生成領(lǐng)域的成功激發(fā)了其在圖像生成領(lǐng)域的應(yīng)用,涌現(xiàn)出 DALL-E、Parti、VAR 和 LlamaGen 等代表性工作。這類技術(shù)高度依賴于 VQGAN 等視覺 Tokenizer,它負(fù)責(zé)將高維、冗余的像素空間映射到一個(gè)低維、緊湊的離散潛在空間,是決定生成模型上限的基石。

然而,以 VQGAN 為代表的傳統(tǒng) Tokenizer 通常需要從零開始訓(xùn)練,其訓(xùn)練目標(biāo)由像素級(jí)重建損失函數(shù)主導(dǎo),導(dǎo)致其產(chǎn)生的潛在空間:

- 富含低層細(xì)節(jié)特征卻缺乏高層語(yǔ)義信息:能很好地還原圖像細(xì)節(jié),但潛在編碼本身缺乏高層語(yǔ)義信息。

- 較高的潛在空間冗余: VAGAN 基于圖像塊 (patch) 逐一進(jìn)行量化,而圖像中的物體通常是不規(guī)則的區(qū)域,基于圖像塊的量化降低了 tokens 的編碼效率。

- 無(wú)視結(jié)構(gòu)特性的表征:潛在空間的組織較為混亂,使得生成模型不僅需要更長(zhǎng)的訓(xùn)練時(shí)間來(lái)學(xué)習(xí)其潛在空間分布,而且往往得借助 CFG(Classifier-Free Guidance, CFG)等技巧來(lái)實(shí)現(xiàn)高保真度的圖像生成,增加了模型推理時(shí)間。

與此同時(shí),預(yù)訓(xùn)練的視覺基礎(chǔ)模型(Visual Foundation Models, VFMs),如 CLIP、DINOv2、SigLIP2 等,在提取豐富語(yǔ)義且可泛化視覺特征方面表現(xiàn)出了強(qiáng)大的能力。這些模型通過自監(jiān)督或語(yǔ)言監(jiān)督的方式進(jìn)行訓(xùn)練,它們能夠有效抽象出圖像中的高層語(yǔ)義信息,因此這些預(yù)訓(xùn)練的視覺基礎(chǔ)模型大多應(yīng)用于圖像內(nèi)容理解任務(wù)當(dāng)中。直接將其應(yīng)用于圖像重建和生成任務(wù)上卻鮮有人探索。

基于此,香港大學(xué) CVMI Lab 和階躍星辰 AIGC 團(tuán)隊(duì)提出一個(gè)大膽假設(shè):原本為視覺理解任務(wù)設(shè)計(jì)的預(yù)訓(xùn)練視覺基礎(chǔ)模型,其潛在特征是否也能直接作為圖像重建與生成的魯棒結(jié)構(gòu)化表征?

為了驗(yàn)證這一猜想,我們探索了一個(gè)基礎(chǔ)視覺模型新的應(yīng)用新方向:用凍結(jié)的預(yù)訓(xùn)練視覺基礎(chǔ)模型構(gòu)造離散的視覺 Tokenizer,將其應(yīng)用于圖像重建和自回歸圖像生成任務(wù)上。

我們發(fā)現(xiàn),相比于傳統(tǒng)的視覺 Tokenizer 模型,視覺基礎(chǔ)模型驅(qū)動(dòng)的圖像 Tokenizer 在這兩項(xiàng)任務(wù)上均表現(xiàn)出優(yōu)異的性能。

- 論文標(biāo)題: Vision Foundation Models as Effective Visual Tokenizers for Autoregressive Generation

- 論文地址: https://arxiv.org/pdf/2507.08441

- Huggingface: https://huggingface.co/papers/2507.08441

- Github: https://github.com/CVMI-Lab/VFMTok.git (Vanilla version)https://github.com/CVMI-Lab/VFMTok-RAR.git (Ultra version)

探索性發(fā)現(xiàn)

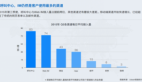

為了驗(yàn)證視覺基礎(chǔ)模型 (VFMs) 能否構(gòu)造高質(zhì)量的視覺 Tokenizer,我們首次嘗試使用不同的凍結(jié)的預(yù)訓(xùn)練基礎(chǔ)視覺模型 (VFMs) 提取圖像特征,將其送入 VQGAN 的編碼器中進(jìn)行端到端訓(xùn)練。訓(xùn)練階段只有量化器(quantilizer)和解碼器中的參數(shù)會(huì)進(jìn)行更新,隨后用它完成自回歸圖像生成任務(wù)。

實(shí)驗(yàn)表明:凍結(jié)的視覺基礎(chǔ)模型 (VFMs) 提取的圖像特征可以直接用于圖像重建,且訓(xùn)練好的視覺 Tokenizer 在自回歸圖像生成任務(wù)上的表現(xiàn)優(yōu)于傳統(tǒng)的視覺 Tokenizer 模型。

這一發(fā)現(xiàn)凸顯了預(yù)訓(xùn)練視覺基礎(chǔ)模型 (VFMs) 構(gòu)造高質(zhì)量視覺 Tokenizer 的巨大潛力。

核心思想

基于我們的探索性發(fā)現(xiàn):凍結(jié)的視覺基礎(chǔ)模型 (VFMs) 可以直接構(gòu)造高質(zhì)量的視覺 Tokenizer 并進(jìn)行端到端地訓(xùn)練,我們對(duì)構(gòu)造的視覺 Tokenizer 的結(jié)構(gòu)進(jìn)行進(jìn)一步的優(yōu)化 —— 利用視覺基礎(chǔ)模型 (VFMs) 提取圖像的多層特征 (Multi-level Features Extraction),這有助于同時(shí)捕獲圖像中的低層細(xì)節(jié)特征和高層語(yǔ)義信息。

同時(shí),我們注意到現(xiàn)有的量化機(jī)制 (quantization) 都是對(duì)圖像塊 (patch) 逐一量化,而圖像中物體一般都是形狀不規(guī)則的,因此我們?cè)O(shè)計(jì)了區(qū)域自適應(yīng)的量化 (Region-Adaptive Quantization) 方案。該方案可以進(jìn)一步降低潛在特征空間的冗余度,提高視覺 tokens 的利用效率。

此外,因?yàn)橐曈X基礎(chǔ)模型的參數(shù)是凍結(jié)的,因此在重建圖像內(nèi)容的同時(shí),我們也設(shè)計(jì)了語(yǔ)義特征重建的目標(biāo)函數(shù) (Semantic Reconstruction Objective),來(lái)提升視覺 Tokenizer 的語(yǔ)義保真度。我們將基于視覺基礎(chǔ)模型 (VFMs) 的 Tokenizer 稱之為 VFMTok。

VFMTok 架構(gòu)圖

關(guān)鍵技術(shù)細(xì)節(jié)

- 多層圖像特征提取 (Multi-level Features Extraction)

為了同時(shí)捕獲圖像低層細(xì)節(jié)特征和高層語(yǔ)義信息方便圖像重建,VFMTok 采用凍結(jié)的預(yù)訓(xùn)練的視覺基礎(chǔ)模型 (VFMs) 作為編碼器提取多層級(jí)語(yǔ)義特征。VFMTok 按照等間隔的方式從預(yù)訓(xùn)練基礎(chǔ)模型 (VFMs) 中提取多層特征 (multi-level features)。

- 區(qū)域自適應(yīng)量化 (Region-Adaptive Quantization)

為了實(shí)現(xiàn)區(qū)域自適應(yīng)量化 (Region-Adaptive Quantization) 機(jī)制,VFMTok 通過可學(xué)習(xí)「錨點(diǎn)查詢」(Anchor Queries)結(jié)合可變形注意力機(jī)制(Deformable Attention)自適應(yīng)地從多層級(jí)特征 (multi-level features) 中進(jìn)行區(qū)域自適應(yīng)的特征采樣 (Region-Adaptive Sampling)。

這種方式能聚焦于采樣圖像中模式一致的區(qū)域。隨后,VFMToks 對(duì)可學(xué)習(xí)「錨點(diǎn)查詢」(Anchor Queries)進(jìn)行量化 (quantization)。這種方式可以有效提升 token 的利用效率 —— 用更少的 tokens(256)來(lái)表征一張圖像。

- 語(yǔ)義重建目標(biāo)(Semantic Reconstruction Objective)

因?yàn)橐曈X基礎(chǔ)模型在 Tokenizer 的訓(xùn)練階段參數(shù)是凍結(jié)的,因此 VFMTok 在重建圖像的同時(shí),也會(huì)重建凍結(jié)的基礎(chǔ)模型(VFM)最后一層的語(yǔ)義特征。

為了實(shí)現(xiàn)這一點(diǎn),VFMTok 解碼階段設(shè)計(jì)了一個(gè)共享的輕量級(jí) Vision Transformer(ViT)。這個(gè) ViT 接收區(qū)域自適應(yīng)量化后的 tokens,結(jié)合一個(gè)可學(xué)習(xí)的 mask token 以及一組可學(xué)習(xí)的位置編碼(Positional Embedding)作為輸入,分別產(chǎn)生用于圖像重建和語(yǔ)義重建的特征。共享 ViT 的設(shè)計(jì)既減少了參數(shù)量又保證了語(yǔ)義保真度。其雙重目標(biāo)函數(shù)是:

其中  是傳統(tǒng)的視覺 Tokenizer 使用的一系列常規(guī)損失函數(shù),

是傳統(tǒng)的視覺 Tokenizer 使用的一系列常規(guī)損失函數(shù), 是重建出的 VFM 特征與原始 VFM 特征之間的余弦相似度損失函數(shù)。

是重建出的 VFM 特征與原始 VFM 特征之間的余弦相似度損失函數(shù)。

訓(xùn)練完成后,VFMTok 可以被應(yīng)用于圖像自適應(yīng)回歸任務(wù)上,基于 next-token prediction 的方式生成高質(zhì)量的圖像內(nèi)容。

實(shí)驗(yàn)亮點(diǎn)與分析

1.卓越的重建生成質(zhì)量與效率

大量實(shí)驗(yàn)表明,基于視覺基礎(chǔ)模型 (VFMs) 構(gòu)造的視覺 Tokenizer——VFMTok,具備高質(zhì)量、高效率的圖像重建和自回歸圖像生成能力。

- 更好的圖像重建質(zhì)量:相較于傳統(tǒng)的視覺 Tokenizer,VFMTok 可以用更少的 token 數(shù)量(僅用 256 個(gè))實(shí)現(xiàn)更優(yōu)的重建質(zhì)量(0.89 rFID, 215.4 rIS)和更高的碼本利用率 (100%),超越了之前大部分傳統(tǒng)的離散 Tokenizers。

- 更快的生成訓(xùn)練收斂速度:相比于經(jīng)典的 VQGAN 這類 Tokenizer,VFMTok 能夠顯著提升自回歸模型訓(xùn)練階段的收斂速度 —— 訓(xùn)練收斂速度提升了 3 倍。

- 更好的生成性能:在 ImageNet 256x256 的 class-to-image 生成任務(wù)上,VFMTok-1.4B 模型在參數(shù)量更少、訓(xùn)練迭代次數(shù)更少的情況下,自回歸生成性能超越了同類 LlamaGen-3B。此外,在接入更好的自回歸圖像生成框架 RAR 后,實(shí)現(xiàn)了 SOTA 的圖像生成性能(gFID: 1.36)。

- CFG-free 優(yōu)越性:值得注意的是,VFMTok 在有無(wú) CFG 的情況下性能幾乎一致(gFID: 2.07 vs 2.04),而 LlamaGen 則會(huì)從 2.19 急劇惡化至 9.38。這證明了其潛在空間具有極強(qiáng)的語(yǔ)義一致性,無(wú)需 CFG 即可實(shí)現(xiàn)高保真度的 class-to-image 圖像生成,可以進(jìn)一步減少圖像生成時(shí)間。

- 更快的推理速度:由于 tokens 數(shù)量減半(256 vs. 576),自回歸模型的生成過程長(zhǎng)度減半,推理速度因此獲得了約 4 倍的提升。

2.消融實(shí)驗(yàn)的有力證明

僅使用凍結(jié)的 VFM 作為編碼器,線性探針準(zhǔn)確率(linear probing)就從 VQGAN 的 23.1% 提升至 56.4%。引入?yún)^(qū)域自適應(yīng)量化 (Region-Adaptive Quantization) 和語(yǔ)義特征重建 (Semantic Reconstruction Objective) 后,VFMTok 僅用 256 個(gè) Token 就能在重建質(zhì)量(rFID 0.89 vs 0.95) 上全面超越使用 576 個(gè) Token 的 VQGAN 基線 Tokenizer。

總結(jié)與展望

VFMTok 首次證明了凍結(jié)的視覺基礎(chǔ)模型 (VFMs) 提取的圖像特征能有效用于圖像重建與生成,同時(shí)可以提升 Tokenizer 語(yǔ)義表征能力,使自回歸 (AR) 圖像生成模型收斂更快,并能實(shí)現(xiàn) CFG-free 的高保真圖像合成。VFMTok 提出的區(qū)域自適應(yīng)量化機(jī)制,通過有效利用圖像區(qū)域的固有冗余實(shí)現(xiàn)緊湊編碼,在減少視覺 token 數(shù)量的同時(shí)提升性能,實(shí)現(xiàn)高效且高質(zhì)量的自回歸圖像生成。

大量實(shí)驗(yàn)驗(yàn)證了 VFMTok 在圖像重建和自回歸生成中的有效性,確立了預(yù)訓(xùn)練視覺基礎(chǔ)模型 (VFMs) 構(gòu)造高質(zhì)量、高效率 Tokenizer 的主導(dǎo)地位。

由此可見,利用 VFM 的先驗(yàn)知識(shí)是構(gòu)建高質(zhì)量潛在空間的必由之路,也是構(gòu)建下一代 Tokenizer 的關(guān)鍵,這比任何從零開始的正則化或約束都更根本、更有效。預(yù)訓(xùn)練視覺基礎(chǔ)模型的巨大潛力值得我們?cè)谖磥?lái)深入挖掘,最終可能探索出一個(gè)能夠有效兼容所有生成模型的、語(yǔ)義豐富、高質(zhì)高效的「統(tǒng)一 Tokenizer」。

VFMTok 論文與代碼均已公開,歡迎感興趣的同學(xué)閱讀、復(fù)現(xiàn)以及深入討論。

作者介紹

本文作者主要來(lái)自于香港大學(xué) CVMI Lab 和階躍星辰 AIGC 團(tuán)隊(duì)。階躍星辰 AIGC 團(tuán)隊(duì)主要致力于圖像生成底模、圖像編輯底模、世界模型以及 RL 后訓(xùn)練研究和落地。歡迎志同道合的同學(xué)交流和加入,一起為 AIGC 社區(qū)貢獻(xiàn)力量。