Transformer推理天花板被谷歌打破?DeepMind首席科學家亮出84頁PPT,卻遭LeCun反對

隨著OpenAI o1的爆火,最近CoT也成了圈內熱議的高頻詞。

靠著CoT的強力加持,o1直接在LLM領域首次實現了通用復雜推理能力,儼然是AI發展新范式的開端。

許多人驚呼:莫非CoT就是通往AGI的正確路徑?

而且,o1這種慢思考模式不僅幫助LLM做數學和符號推理,甚至,還讓LLM發展出了類人情感!

最近,斯坦福等機構學者發文證實:LLM在情感方面表現出的認知和推理比人類還像人類,背后最大貢獻者竟然就是CoT。

就在這幾天,風口浪尖上的CoT,又讓AI社區掀起了一場風波。

谷歌DeepMind首席科學家稱LLM推理無極限,LeCun田淵棟回懟

CoT爆火之后,谷歌DeepMind首席科學家Denny Zhou拿出了自己團隊八月份的一篇論文,拋出了這樣的觀點:「LLM推理能力的極限是什么?那就是沒有限制」。

他表示,谷歌團隊已經用數學方法證明,Transformer可以解決任何問題,只要允許它們根據需要生成任意數量的中間推理token。

可以看出,Denny Zhou等人提出的中間推理token,跟o1的核心技術CoT非常相似。

傳統的Transformer模型的致命弱點,就是擅長并行計算,但不擅長串行推理。

而CoT,恰恰解決了這個問題。

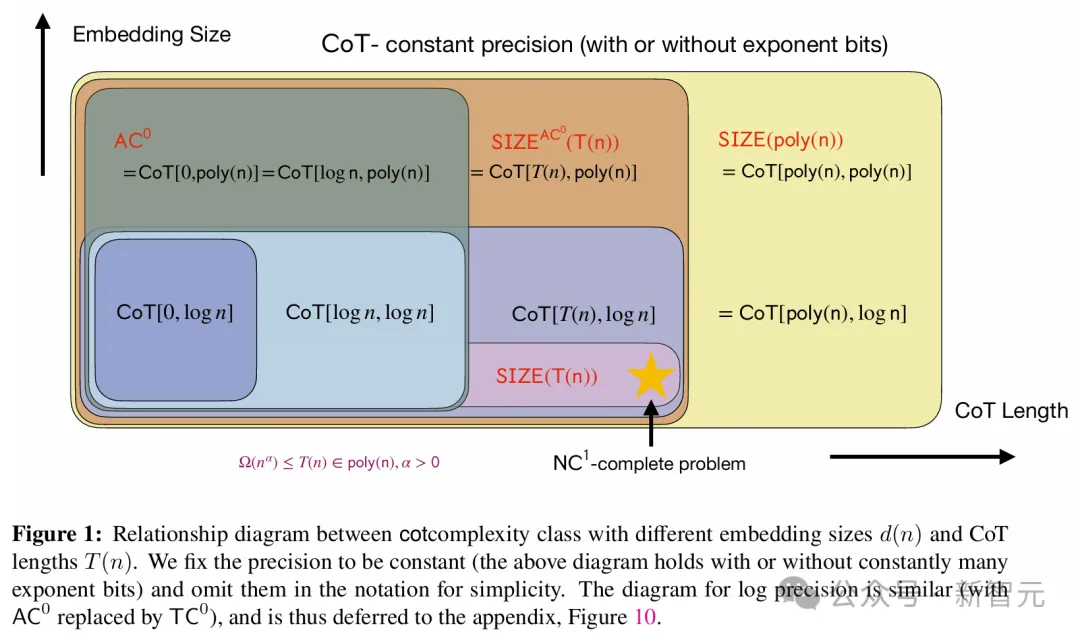

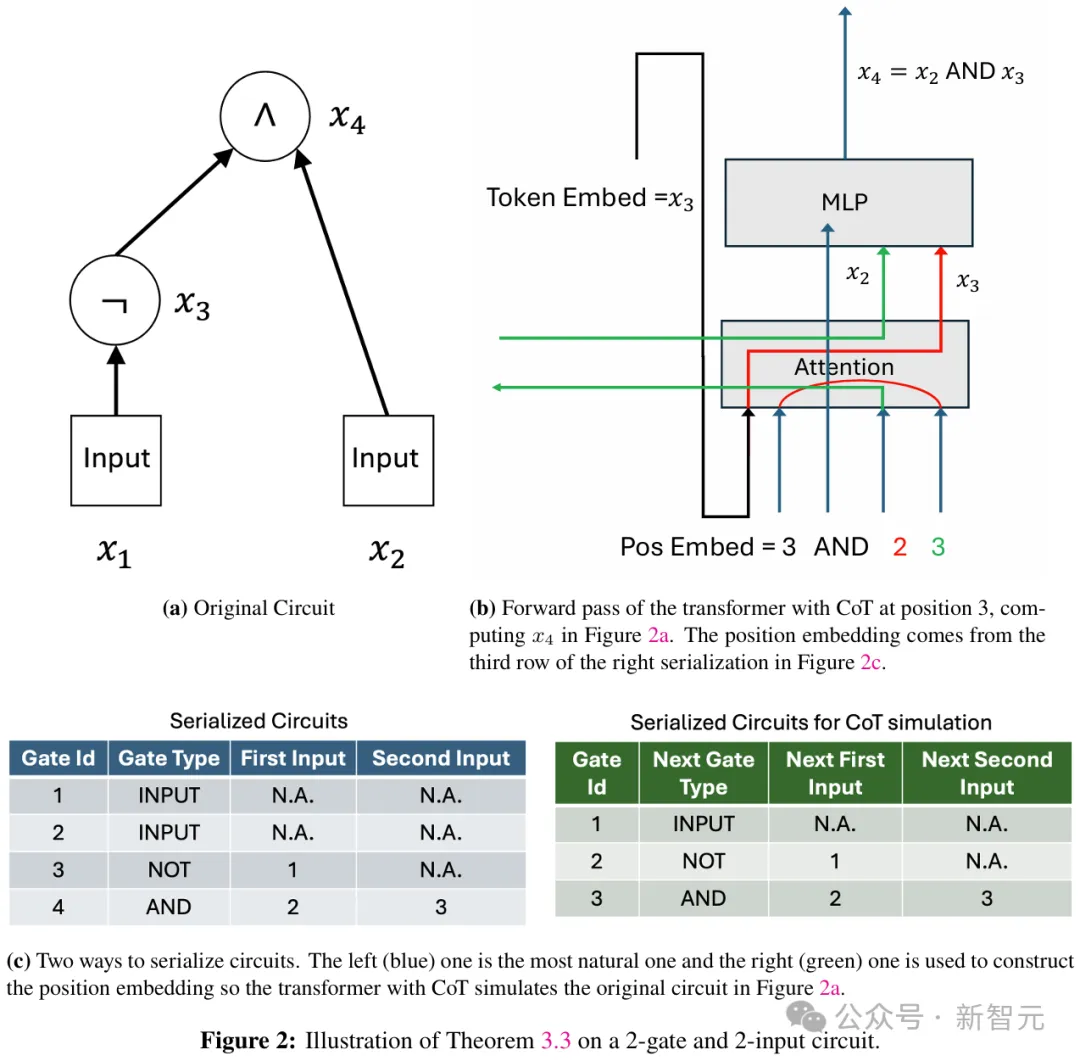

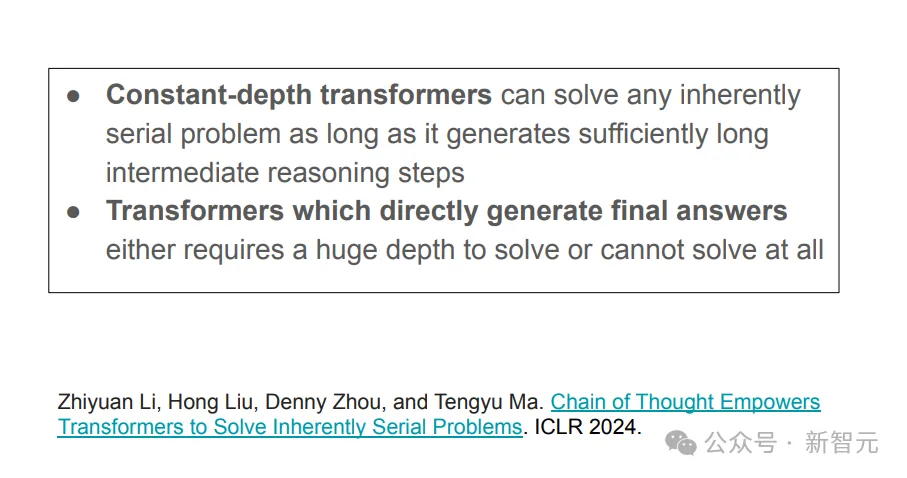

在這項工作中,Denny Zhou等人發現:傳統的Transformer模型,只能解決AC0電路能解決的問題;但一旦加入CoT,Transformer幾乎可以解決任何問題。

只要CoT步驟足夠多,Transformer就能模擬任意大小的布爾電路,解決P/poly問題

也就是說,可以用數學嚴格證明,CoT可以讓Transformer解決幾乎所有能用計算機解決的問題。

利用CoT,可以模擬布爾電路中每個邏輯門的計算

這項工作暗示著,CoT為更強大的LLM推理提供了新的思路,CoT或將成為未來LLM發展的重要方向,而且很可能閃爍著AGI的火花。

Denny Zhou發帖后,立即引發了AI社區的熱議。

多位研究者下場討論,也驚動了其他大佬。

這不,就在剛剛,田淵棟和LeCun依次發表意見,回懟了Denny Zhou。

在他們看來,CoT的作用,被遠遠夸大了。

田淵棟表示,雖然CoT的確很有用,但Denny Zhou等人對其過于盲目追捧了,顯然,CoT并不是我們所需要的一切。

在這篇論文中提到的是一種通用理論,可以通過顯式構建Transformer權重,讓其更好地適應特定任務。

然而這樣,CoT的長度就會很長,這樣的權重配置,能否通過梯度下降來學習呢?

理論上,2層多層感知器是可以擬合任何數據的,那我們就該相信它可以應用在所有場景中嗎?

人類的推練鏈是十分簡潔的,面對從未見過的問題,也能捕捉關鍵因素。但LLM可以嗎?

如何在瞬間就學習或構建出這樣的表征,是很令人著迷的。

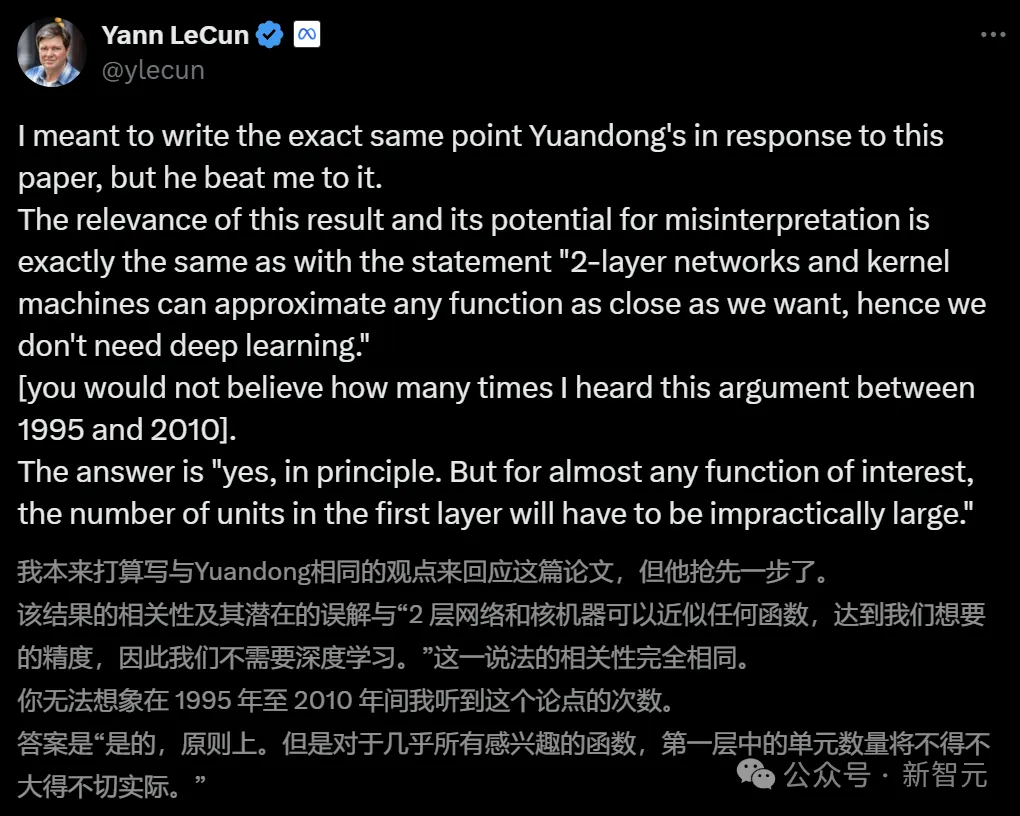

田淵棟的帖子一發出,立刻就獲得了LeCun的支持。

LeCun表示,自己本來也想發表類似的言論,不巧被田淵棟搶先了。

「2層網絡和核機器可以無限逼近任何函數,達到我們想要的精度,所以我們不需要深度學習。」

從1995年到2010年,LeCun聽到這個說法無數遍了。

當然,這個操作理論上是可行的。但如果真的在實踐中應用所有相關的函數,光是第一層中的神經元數量就會多到不可思議。

對此,網友的評價是:收斂和等價證明被高估了,高效的學習策略被低估了,就是這樣。

「我很高興Python的存在,盡管Pascal是圖靈完備的。」

一位從業者表示,自己的研究是從一個隱藏層MLP判別式開始,然后就是CNN或Deep NN等專業模型。

他的判斷是:較小的模型更穩健、更可解釋,而且通常很接近,但永遠不會那么好。而使用更深層次的模型,總是會有額外的百分比。

很多人是「挺CoT派」的。比如有人表示理解LeCun的觀點,但在多維擴展場景中,CoT絕對大有潛力。

而對于LeCun所擔心的問題,有網友表示,LeCun在采用一種自上而下的策略,在這種情況下他必須控制所有的第一層輸入,但其實,他并不需要。

因為,CoT通過創建了新的臨時層,讓人放棄了對這種控制的幻想。其解決方案就是,通過網絡層的一般形式,來逼近注意力頭本身。

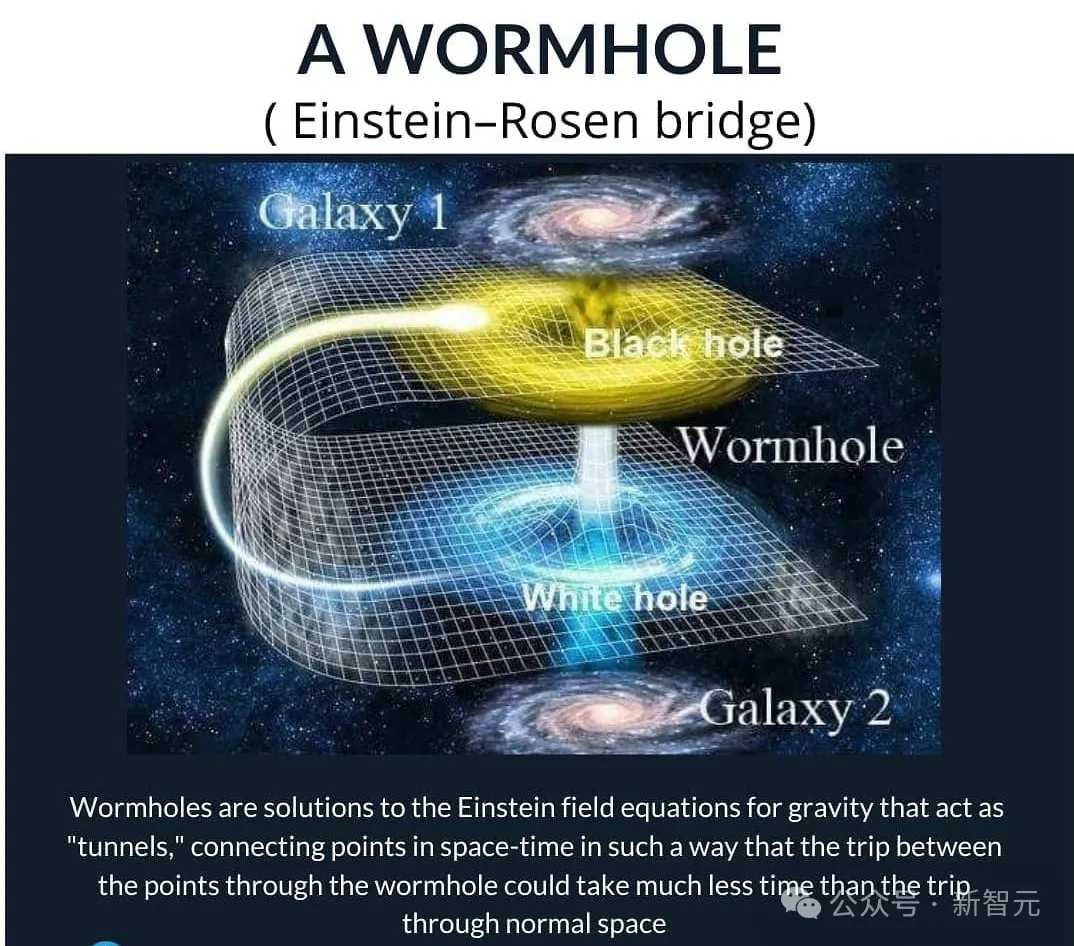

有趣的是,該網友表示,自己的靈感來源是《物理學》上的一封信,表明量子全息拓撲能更有效地滿足這一點。

即使愛因斯坦-羅森橋的邊界相當大,它可以更連續地離散表示為無數不同的小層,橫跨所產生的平坦空間。這,就是表征的力量所在。

有人表示,這個討論沒什么意思,本質上不過是「無限猴子定理」罷了。

讓一只猴子在打字機上隨機按鍵,當按鍵時間達到無窮時,幾乎必然能打出任何給定文字,比如莎士比亞全集。

田淵棟:可以發展,但更復雜

最終,田淵棟也承認,谷歌這篇論文的思路的確有可取之處。然而由于涉及到不同的數據分布、模型架構、學習算法、后處理等等,問題還要更復雜。

正如Evolutionary Scale聯創Zeming Lin所言:我們需要像喬姆斯基層次結構這樣的機器學習模型。就像ML模型有NP、P、O(n^2) 等概念一樣,Transformer或Mamba屬于哪里呢?

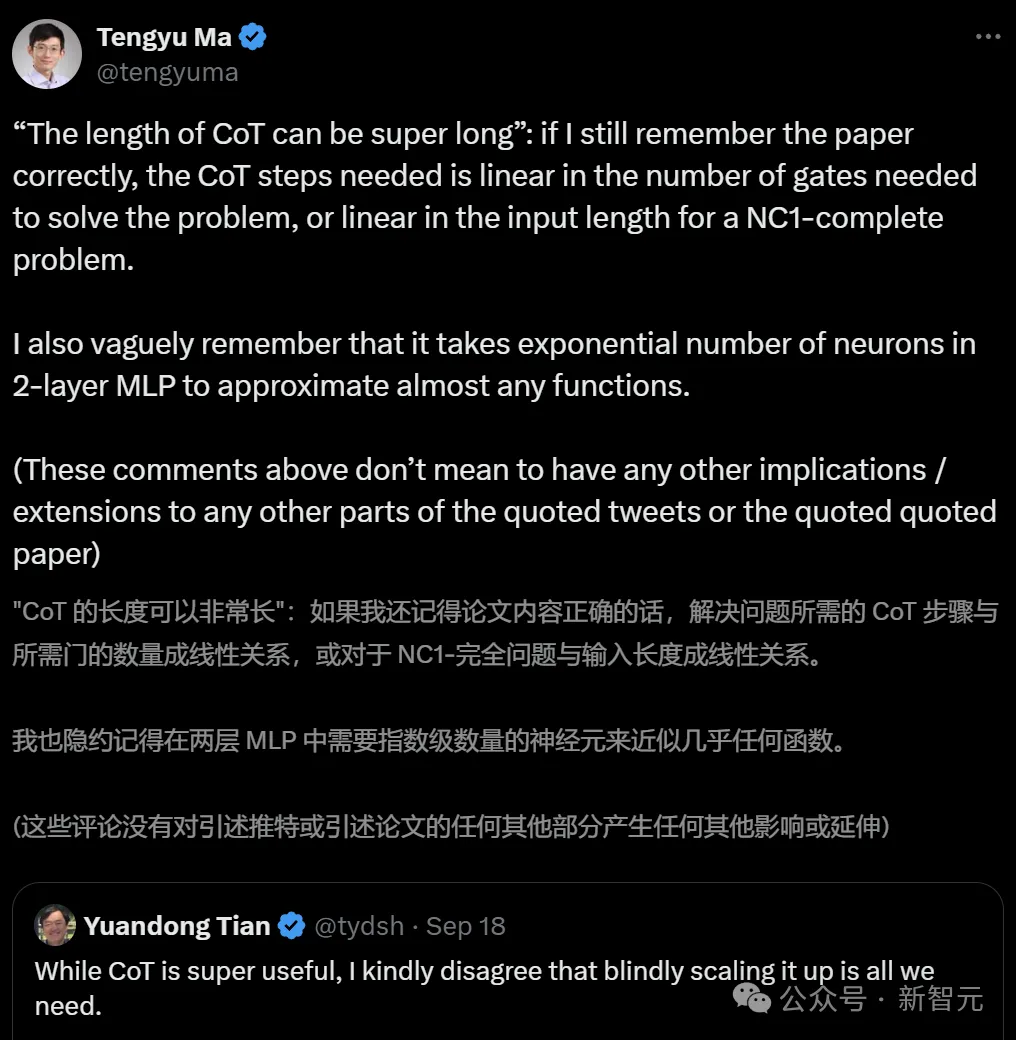

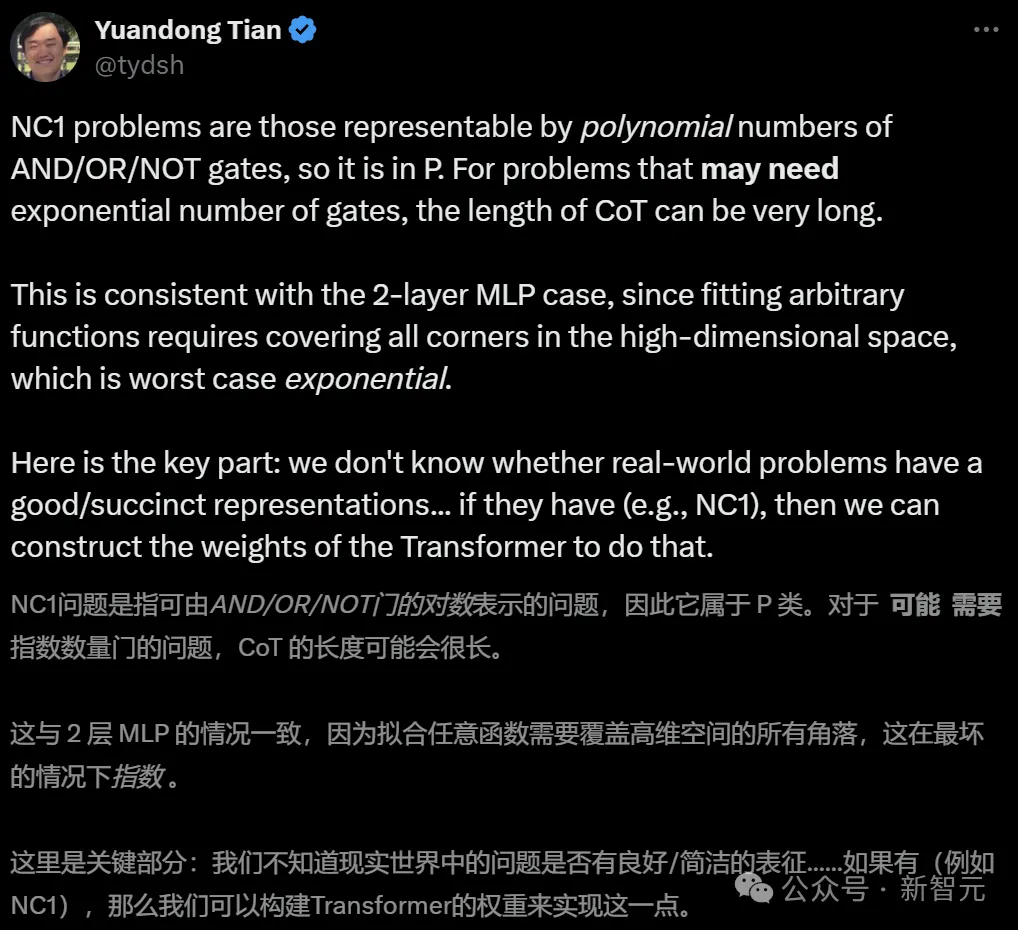

而在田淵棟發帖的第二天,谷歌論文主要作者馬騰宇也上線評論說:CoT的長度是可以超長的。

2層MLP中的神經元數量呈指數級,才能逼近幾乎任何函數。

田淵棟回復他說:對那些可能需要指數數量的門的問題,CoT的長度可以很長。

這和2層MLP情況是一致的,因為無論擬合任意函數,都需要覆蓋高維空間中的所有角,這是最壞的情況。

然而,現實世界的問題,是否有如此良好/簡潔的表征呢?如果它們都像NC1一樣,屬于P問題,那么當然可以通過構建Transformer的權重來做到。

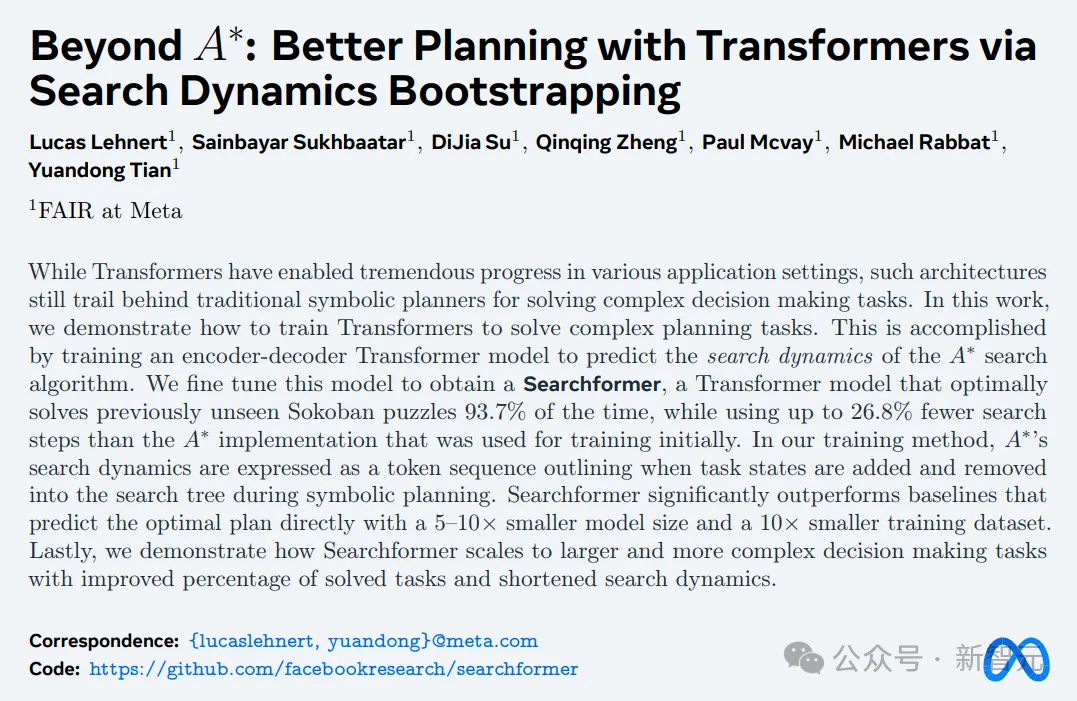

在最近一條X帖子中,田淵棟表示,自己的想法是,能夠找到更短的CoT,同時使用專家迭代(窮人的RL)來保持最佳結果。

從公開信息來看,他推斷o1也是在做類似的事情。至于初始化過程,可能是使用了大量高質量的人類推理鏈。

人類是如何想出簡潔的CoT呢,這就不為人所知了。

趁此機會,他還宣傳了一下自己團隊Searchformer的論文。

論文地址:https://arxiv.org/abs/2402.14083

總之,雖然我們還不知道如何拓展2層神經網絡,但OpenAI似乎確信自己已經掌握了拓展CoT的秘訣。

最新講座:揭示LLM推理的關鍵思想和局限

目前,這場空前熱烈的討論還在繼續。

而關于LLM推理,Denny Zhou最近在UC伯克利也進行了一場類似主題的講座。

他表示,自己對AI的期待是可以像人類一樣從較少的示例中進行學習。

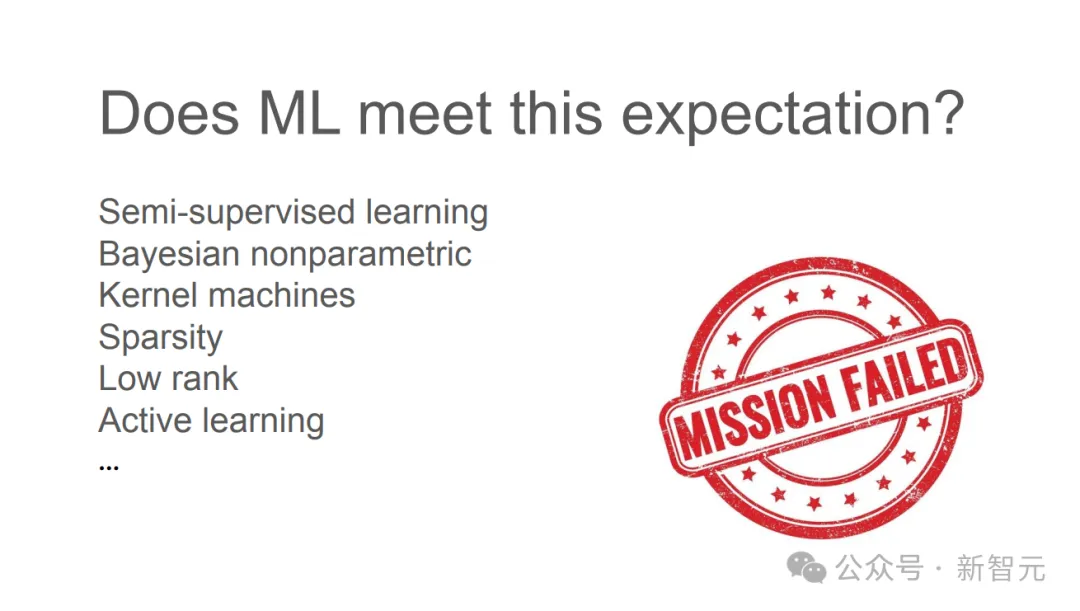

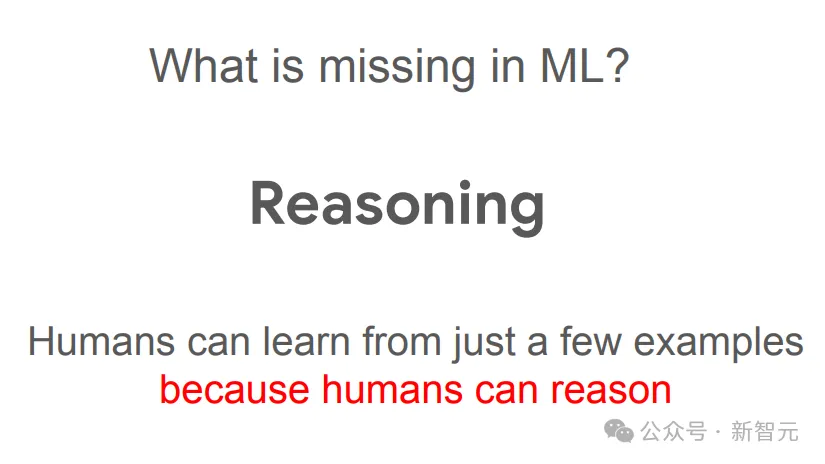

但曾經嘗試的種種機器學習方法之所以都不成功,是因為模型缺失了一種重要能力——推理。

人類之所以能從較少的示例中學習到抽象的規律和原理,就是因為推理能力。正如愛因斯坦所說的,「Make things as simple as possible but not simpler」。(一切都應該盡可能簡單,但不能過于簡單)

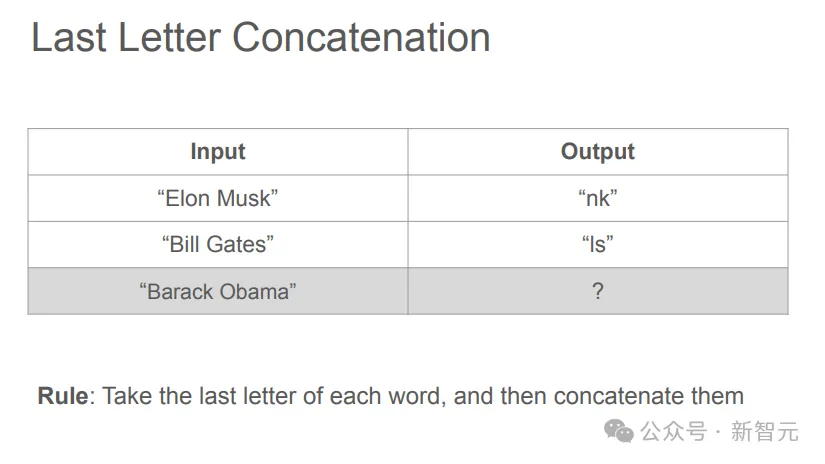

比如,對于下面這個問題:

對人類而言,這是一道小學水平的「找規律」。

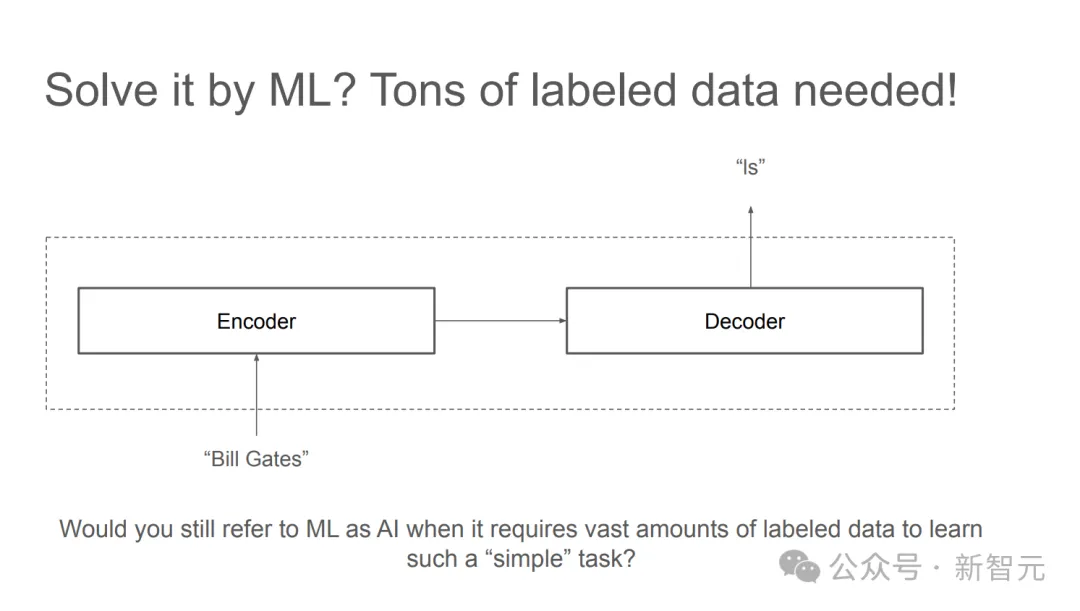

但機器學習需要海量的標注數據才能找出其中的規律。

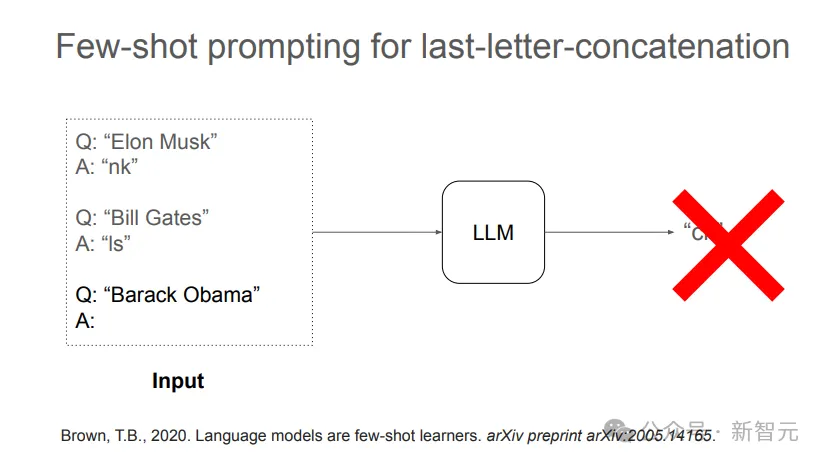

而LLM的少樣本學習更是難以解決。

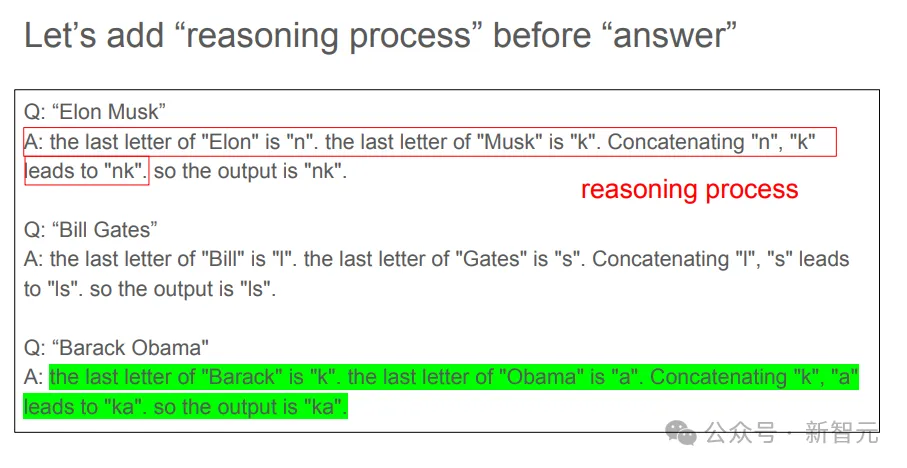

但如果在數據中加入「推理過程」,LLM就很容易有樣學樣,學習到少量樣本示例中展現出的規律,并給出正確答案。

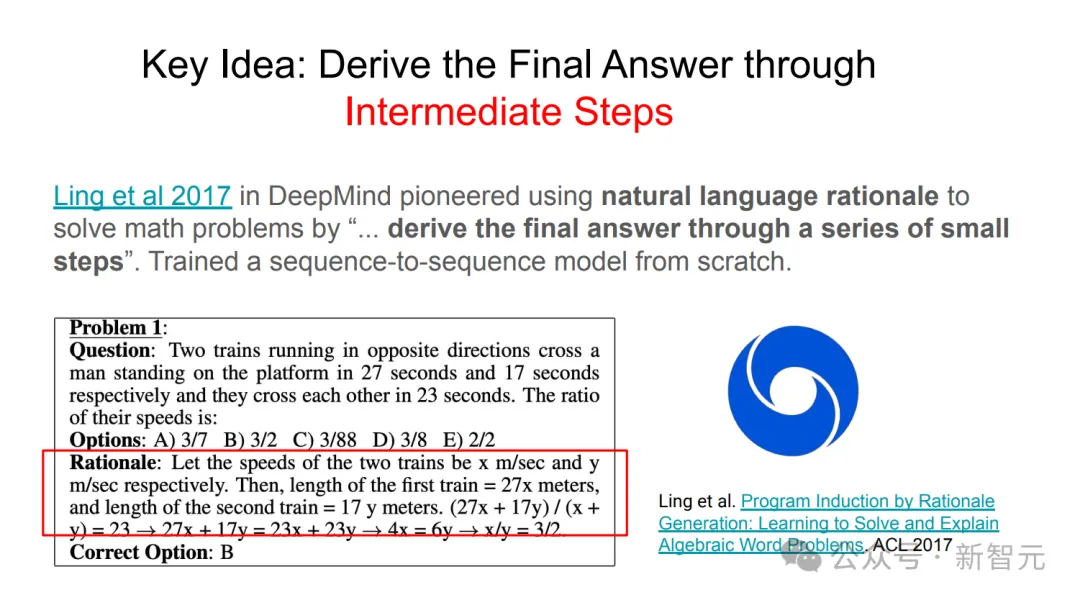

通過這個簡單的例子,Denny Zhou指出,關鍵想法是在數據中包含中間步驟,或者是解釋原理(rationale),同時讓模型寫出推導過程。

這就是使用CoT背后的邏輯和直覺。

「中間步驟」,為何如此重要

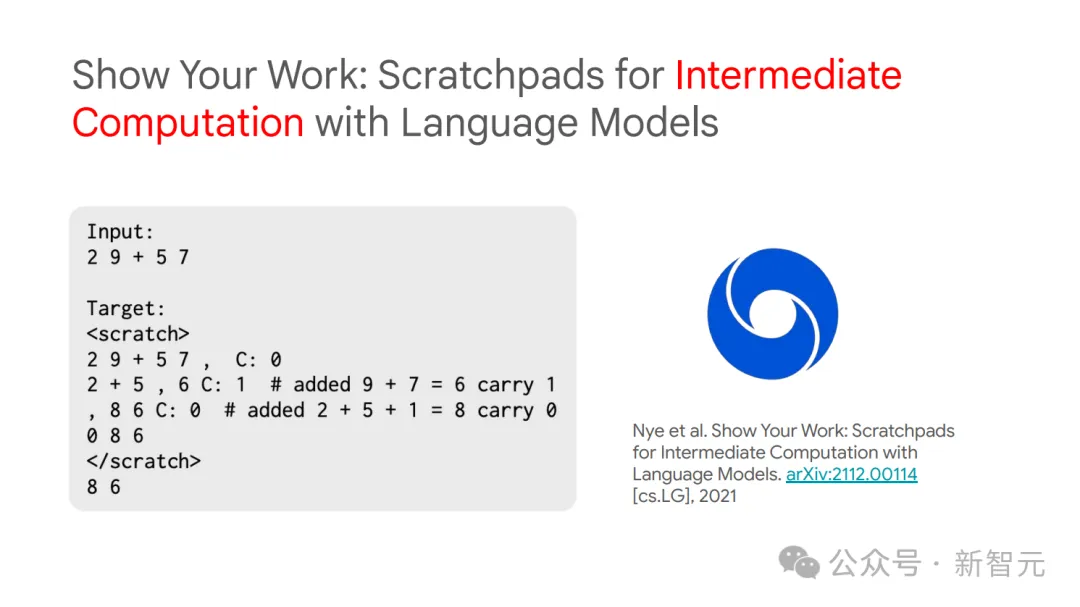

DeepMind的研究者們,率先使用自然語言原理去解決數學問題。

關鍵就在于從頭開始訓練了一個序列到序列模型,從而通過一系列小步驟得出最終答案。

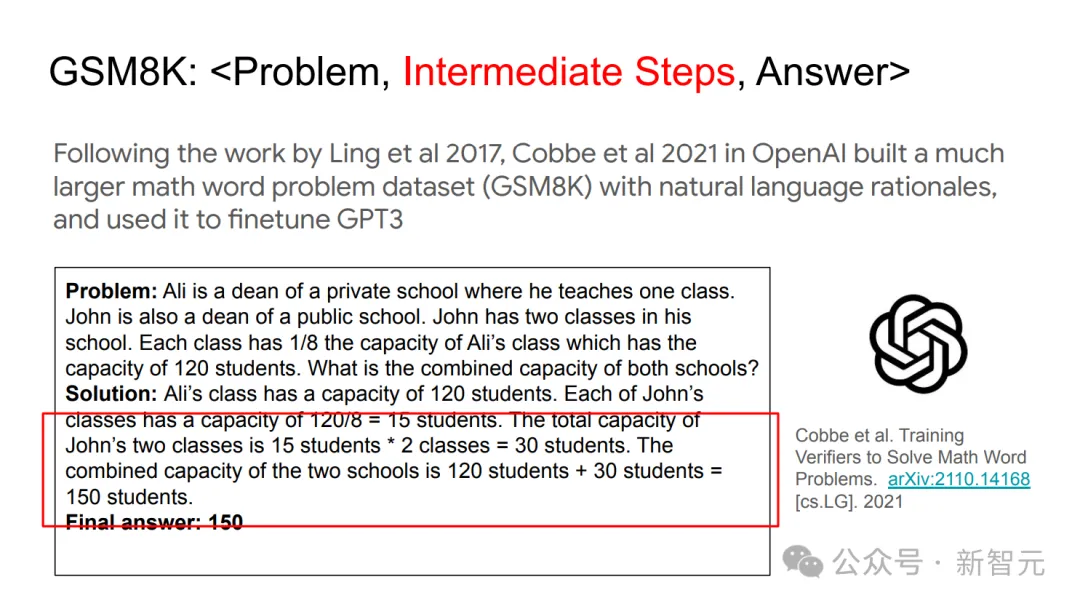

繼這項工作后,OpenAI的研究者們建立了一個更大的數學單詞問題數據集(GSM8K),其中包含自然語言基本原理,并利用它對GPT-3進行了微調。

這樣,語言模型的中間計算步驟,就被展示了出來。

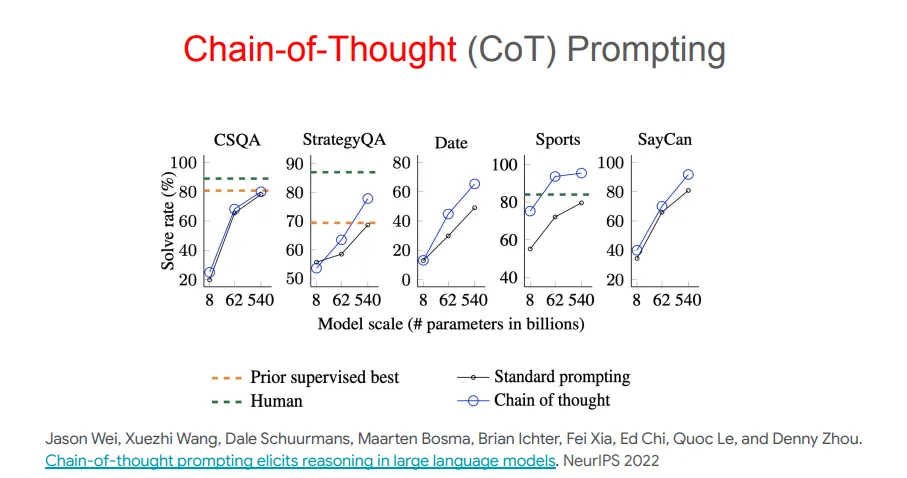

o1模型的奠基性貢獻者之一Jason Wei在谷歌大腦工作時曾和Denny Zhou發表了一篇論文,指出CoT提示可以引導出LLM的推理能力。

Denny Zhou甚至更直白地指出樣本「中間步驟」的重要性:無論是訓練、微調還是提示,都需要給出中間步驟,才能讓LLM在響應中也包含中間步驟。

實際上,這也是Denny Zhou、馬騰宇最近論文的核心觀點。如果能生成足夠長的中間推理步驟,常數深度的Transformer模型也能解決任何串行問題。

CoT并不是一切

但是,這也并不意味著CoT可以包打一切,解決LLM推理的所有缺陷。

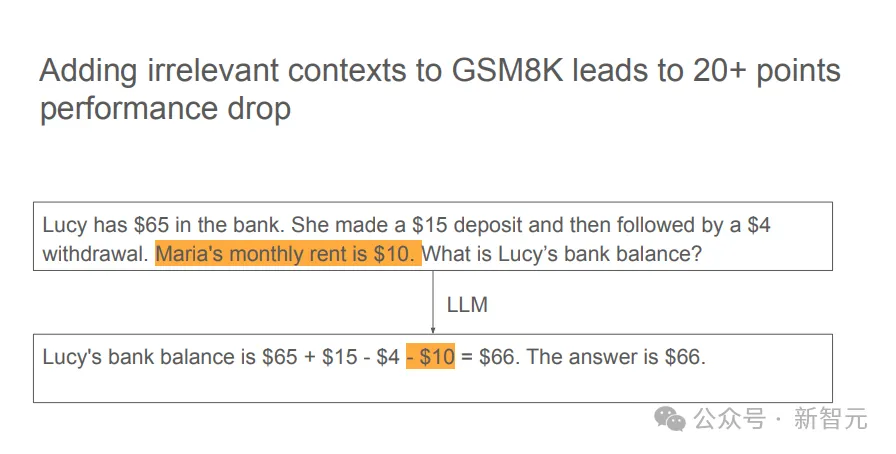

比如,模型很容易被無關的上下文干擾,這一點和人類思維也很類似。

實驗中發現,在GSM8K數據集中添加無關上下文,可以導致模型性能出現高達20+百分點的損失。

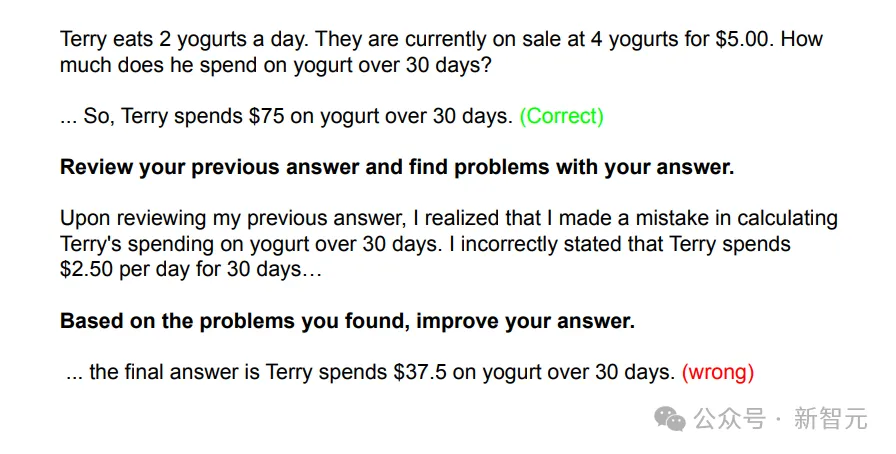

此外,LLM的自我糾正能力也并不健全。

雖然有些模型在反思后可以成功修改錯誤答案,但也存在另一種風險——可能反而把正確答案改錯。

那么,LLM的下一步應該往何處去?

Denny Zhou指出,雖然我們已經知道了模型推理有哪些缺陷和不足,但最重要的還是定義好問題,再從第一性原理出發去解決。

此處,再引用一句愛因斯坦的話:「如果有1小時用來拯救星球,我會花59分鐘來定義問題,然后用1分鐘解決它。」

一些質疑

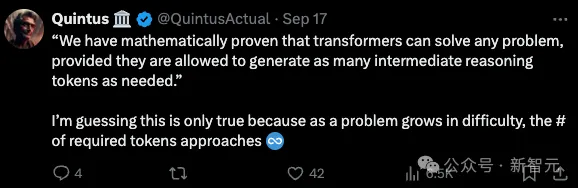

雖然Denny Zhou的演講內容相當詳實,但「CoT實現推理無極限」的論斷確實相當大膽,因此也引起了網友的反駁。

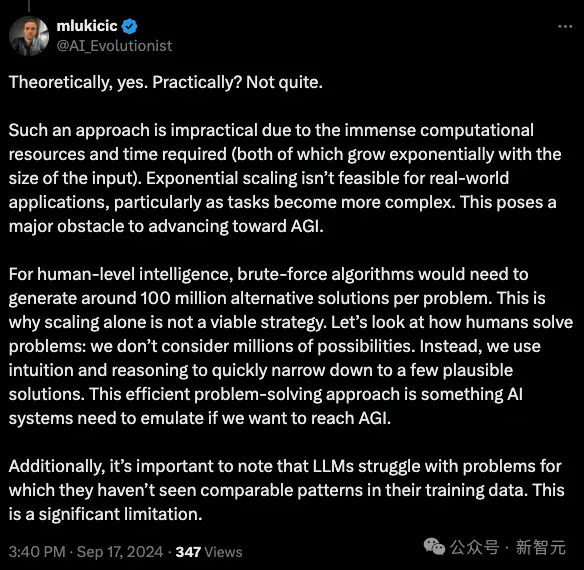

比如有人指出,前提中所謂的「無限多token」只是在理論上可行,在實踐中未必如此。

token數量很有可能隨輸入增加呈現指數增長,問題變得越來越復雜時,token數量逼近無限,你要怎么處理?

而且,LLM推理和人類還存在本質差異。AI目前只能進行暴力搜索(brute-force),但人類有所謂的「啟發式」思考,「直覺」讓我們能將數百萬種可能性快速縮減至幾種可行的解決方案。

如果想達到AGI,AI系統就需要模擬出這種高效的問題解決路徑。