2024年大語言模型(LLM)技術深度洞察:進展、問題、趨勢

本文轉載自旺知識,作者旺知識

對大型語言模型(LLMs)的興趣正在上升,特別是在2022年11月ChatGPT發布之后(見圖1)。近年來,LLMs已經轉變了各個行業,生成類似人類的文本并解決廣泛的應用。然而,它們的效果受到偏見、不準確和毒性問題的阻礙,這限制了它們更廣泛的采用并引發了道德擔憂。

圖1. 過去一年大型語言模型的谷歌搜索趨勢。來源:谷歌趨勢

圖1. 過去一年大型語言模型的谷歌搜索趨勢。來源:谷歌趨勢

本文通過深入探討有前景的方法,如自我訓練、事實檢查和稀疏專業知識,來解決這些問題并釋放這些模型的全部潛力,從而探索大型語言模型的未來。

1 - 大語言模型簡介

大型語言模型是一種旨在通過分析大量數據生成和理解類似人類文本的人工智能模型。這些基礎模型基于深度學習技術,通常涉及許多層和大量參數的神經網絡,使它們能夠捕捉到它們訓練的數據中的復雜模式。

大型語言模型的主要目標是理解自然語言的結構、語法、語義和上下文,以便它能夠生成連貫且上下文適當的響應或用相關信息完成給定的文本輸入。

這些模型在包括書籍、文章、網站和其他文本內容在內的多樣化文本數據源上進行訓練,這使它們能夠對廣泛的主題生成響應。

2 - 大語言模型當前發展進展和問題

大型語言模型的當前階段以其在理解和生成廣泛主題和應用的類似人類文本方面的令人印象深刻的能力為標志。這些模型使用先進的深度學習技術構建,并在大量數據上進行訓練,例如OpenAI的GPT-3和谷歌的BERT,已顯著影響自然語言處理領域。

當前的LLMs在各種任務上實現了最先進的性能,如:

- 情感分析

- 文本摘要

- 翻譯

- 問答

- 代碼生成

盡管取得了這些成就,語言模型仍然存在各種需要在未來模型中解決和修復的限制。

2.1 - 準確性

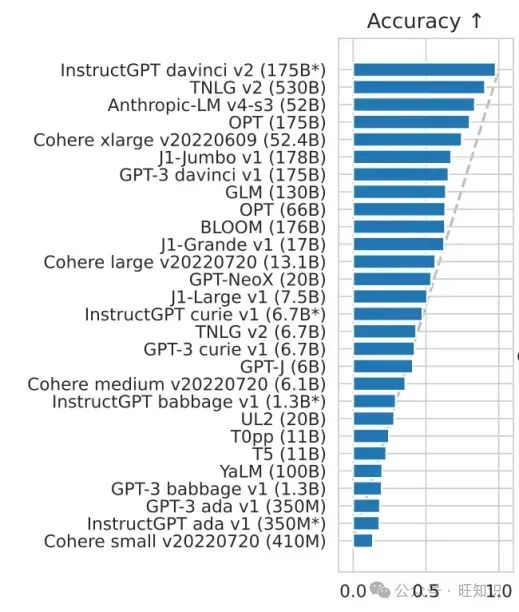

大型語言模型使用機器學習來推斷信息,這引發了關于潛在不準確性的擔憂。此外,預訓練的大型語言模型難以動態適應新信息,導致可能的錯誤響應,這需要在未來的發展中進一步審查和改進。圖3顯示了一些LLMs在準確性方面的比較。

圖片

圖片

圖3. 在5次HELM基準測試中各種語言模型的結果,用于準確性。來源:“BLOOM: A 176B-Parameter Open-Access Multilingual Language Model”

2.2 - 偏見

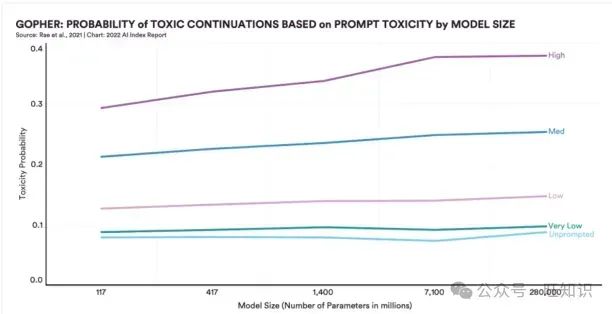

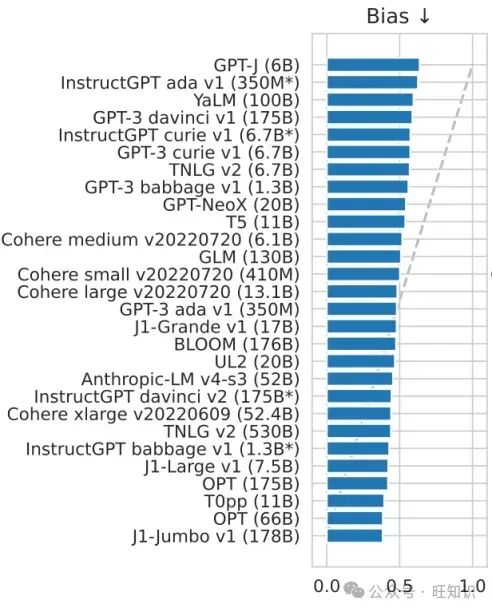

大型語言模型通過語音和文本促進類似人類的交流。然而,最近的發現表明,更先進和龐大的系統傾向于吸收其訓練數據中存在的社會偏見,導致在線社區中出現性別歧視、種族歧視或能力歧視的傾向(圖4)。

圖4. 大型語言模型的毒性指數。來源:斯坦福大學人工智能指數報告2022

圖4. 大型語言模型的毒性指數。來源:斯坦福大學人工智能指數報告2022

例如,最近的一個2800億參數模型與2018年的1.17億參數模型相比,毒性水平顯著增加了29%。隨著這些系統的不斷發展,成為AI研究和開發的更強大的工具,偏見風險的潛在增加也在增長。圖5比較了一些LLMs的偏見潛力。

圖片

圖片

圖5. 在5次HELM基準測試中各種語言模型的結果,用于偏見。來源:“BLOOM: A 176B-Parameter Open-Access Multilingual Language Model”

2.3 - 毒性

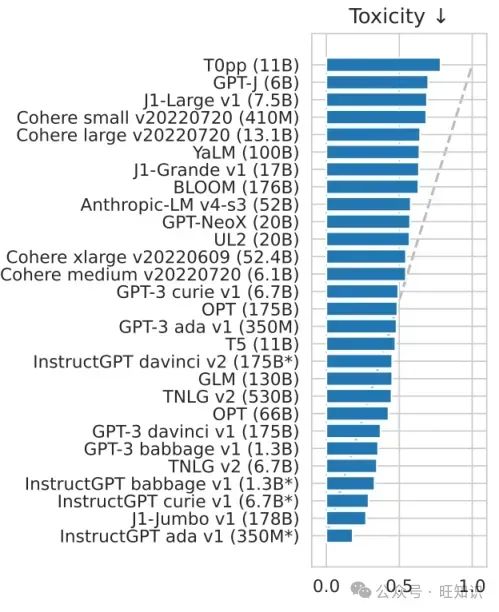

大型語言模型的毒性問題指的是這些模型在響應中無意中生成有害、冒犯性或不適當的內容的問題。這個問題的出現是因為這些模型是在包含偏見、冒犯性語言或有爭議觀點的大量文本數據上訓練的。

圖片

圖片

圖6. 在5次HELM基準測試中各種語言模型的結果,用于毒性.來源:“BLOOM: A 176B-Parameter Open-Access Multilingual Language Model”

解決未來大型語言模型中的毒性問題需要多方面的方法,包括研究、合作和持續改進。一些可能的策略來減輕未來模型中的毒性可以包括:

- 策劃和改進訓練數據

- 開發更好的微調技術

- 納入用戶反饋

- 內容審核策略

2.4 - 容量限制

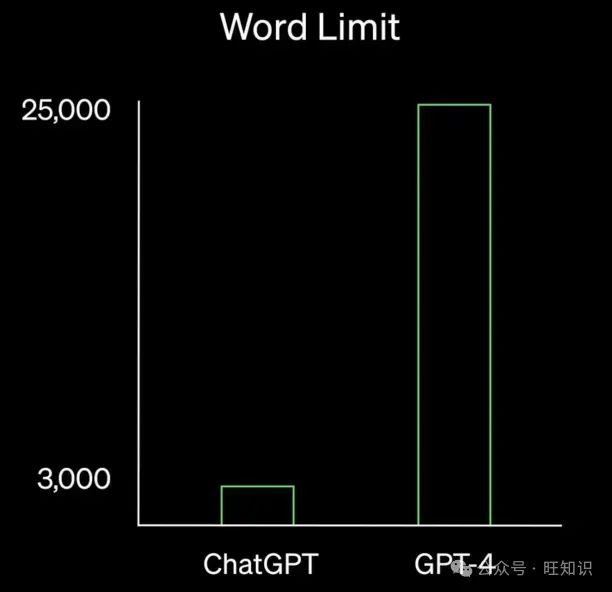

每個大型語言模型都有一個特定的內存容量,這限制了它作為輸入可以處理的令牌數量。例如,ChatGPT有一個2048令牌限制(大約1500個單詞),阻止它理解和為超過這個令牌閾值的輸入生成輸出。

GPT-4將容量擴展到25000字,遠遠超過了依賴GPT-3.5的ChatGPT模型(圖7)。

圖7. ChatGPT和GPT-4之間的字數限制比較.來源:OpenAI

圖7. ChatGPT和GPT-4之間的字數限制比較.來源:OpenAI

2.5 - 預訓練知識集

語言模型是在固定數據集上訓練的,這些數據集代表了某個時間點的知識快照。一旦訓練完成,模型的知識就被凍結,無法訪問最新的信息。這意味著在訓練數據收集后發生的任何信息或變化都不會反映在大型語言模型的響應中。

這導致了幾個問題,例如:

- 過時或錯誤的信息

- 無法處理最近的事件

- 在技術、金融或醫學等動態領域中的相關性較低

3 - 大語言模型的未來發展趨勢

不可能預見未來的語言模型將如何演變。然而,有關LLMs的有前景的研究,專注于我們上面解釋的共同問題。我們為未來的語言模型指出幾個重要的變化趨勢。

3.1 - 多模態LLM

具有整合多種類型輸入的能力,包括文本、照片和視頻,多模態LLM是人工智能的重大進步。這些模型非常適合各種應用,因為它們能夠理解和生成跨多種模態的材料。通過在各種數據集上進行大規模訓練,多模態LLM被構建來執行更復雜和細致的任務,例如回答關于圖像的問題或根據文本描述制作深入的視頻材料。

例子 –

- OpenAI的Sora – 在人工智能方面,OpenAI的Sora在文本到視頻生成方面取得了顯著進展。該模型使用各種視頻和圖像數據,如不同的時長、分辨率和寬高比,來訓練文本條件擴散模型。Sora通過處理視頻和圖像潛在代碼的空間時間補丁,并使用先進的變換器架構,生成高達一分鐘的高保真電影。

- Gemini – Google的Gemini多模態模型系列非常擅長理解和生成基于文本、音頻、視頻和圖像的材料。Gemini有Ultra、Pro和Nano版本,可以處理從內存受限的設備使用案例到復雜的推理活動的各種應用。評估結果顯示,Gemini Ultra模型在所有20個多模態基準測試中提高了最先進的水平,并在32個基準測試中的30個中達到了人類專家在MMLU測試基準上的表現,等等。

- LLaVA – LLaVA是一個先進的AI模型,它通過提高多模態學習能力,彌合了語言和視覺理解之間的差距。它非常適合需要對這兩種格式都有深刻理解的應用,因為它可以通過將視覺數據整合到語言模型中,分析和生成結合文本和圖像的內容。

3.2 - 開源LLM

作為開源軟件提供的LLM已經通過使全球社區能夠訪問復雜的模型及其背后的訓練過程,民主化了AI研究。此外,這種透明度確保了AI研究中的可復制性,除了促進合作和加速發現之外,還提供了對模型設計、訓練數據和代碼實現的透明訪問。

例子

- LLM360 – LLM360旨在通過促進模型創建的完全透明度來改變LLM領域。該項目公開了AMBER和CRYSTALCODER等模型的訓練數據、代碼和中間結果以及最終權重。LLM360通過使整個訓練過程開源,鼓勵可復制性和合作研究,為道德AI開發樹立了新的基準。

- LLaMA – 擁有從7B到65B參數的模型,LLaMA在開源LLM方面取得了重大進步。僅在公開可訪問的數據集上訓練的LLaMA-13B在一系列基準測試中的表現超過了更大的專有模型。該項目展示了對開放性和社區驅動的AI研究的承諾。

- OLMo – AI2的OLMo(Open Language Model)為7B規模的模型提供了訓練代碼、數據和模型權重的完全訪問。OLMo通過強調開放性和可復制性,鼓勵語言模型研究的進步,使研究人員和學者能夠共同創造。

- Llama-3 – Meta Llama,以其8B和70B參數模型針對各種應用進行了優化,在Llama-3中被引入。這些模型以其在推理和其他任務中的最新性能,在不同領域的開源AI開發中樹立了標準。

3.3 - 特定領域LLM

特定領域LLM旨在通過利用特定領域的數據和微調策略來更好地執行專業任務,例如編程和生物醫學。這些模型不僅提高了工作性能,還展示了AI如何被用來解決各種專業領域中的復雜問題。

例子

- BioGPT – BioGPT具有針對生物醫學領域的特殊架構,改進了生物醫學信息提取和文本合成等活動。在許多生物醫學自然語言處理任務中,它的表現優于以前的模型,證明了其理解和生成生物醫學文本的能力。

- StarCoder – StarCoder專注于理解編程語言和生成代碼。由于在大型代碼數據集上進行了深入訓練,它在軟件開發活動中非常熟練。它具有很強的理解復雜編程邏輯和創建代碼片段的能力。

- MathVista – MathVista解決了視覺理解和數學思維的交匯點。它在AI研究中處理數學和視覺數據方面顯示出改進,并為評估LLM在數學任務上的表現提供了標準。

3.4 - LLM智能體

大型語言模型驅動的LLM智能體是復雜的AI系統。它們利用強大的語言能力在內容開發和客戶服務等工作中脫穎而出。這些智能體處理自然語言查詢并執行各種領域的任務,如提出建議或制作藝術作品。當它們被集成到聊天機器人和虛擬助手等應用程序中時,LLM智能體簡化了交互。這展示了它們的多功能性以及它們如何改善各種行業的用戶體驗。

例子

- ChemCrow – ChemCrow將18個專業工具整合到一個平臺中,改變了計算化學。這個基于LLM的智能體能獨立合成驅蟲劑、有機催化劑和新的色團。它在化學合成、藥物發現和材料設計方面也表現出色。與標準LLM不同,ChemCrow使用外部知識源,提高了其在具有挑戰性的化學工作中的表現。

- ToolLLM – ToolLLM通過強調工具的可用性,改進了開源LLM。它使用ChatGPT進行API收集、指令生成和解決方案路線注釋,以及ToolBench,一個指令調整數據集。與ChatGPT等閉源模型相當,ToolLLaMA在執行復雜指令和推廣到未知數據源方面表現出色。

- OS-Copilot – 通過與操作系統交互,OS-Copilot擴展了LLM的能力,并創建了FRIDAY,這是一個能夠很好地執行各種工作的自治智能體。在GAIA基準測試中,FRIDAY的表現優于以前的方法,展示了在PowerPoint和Excel等任務中靈活使用的能力,需要的監督更少。OS-Copilot的框架擴展了AI在通用計算中的潛力,表明在自治智能體開發和更廣泛的AI研究中取得了實質性進展。

3.5 - 較小的LLM(包括量化LLM)

較小的LLM,如量化版本,適用于資源受限的設備部署,因為它們服務于需要較少精度或較少參數的應用。這些模型通過在有限的計算資源環境中提供更廣泛的可訪問性和應用大規模語言處理能力,促進了邊緣計算、移動設備和其他需要有效AI解決方案的場景中的部署。

例子

- BitNet – BitNet是首個作為BitNet b1.58引入研究的1位LLM。每個參數具有三元權重{-1, 0, 1},該模型在成本效率方面大大提高,同時在困惑度和任務性能方面與全精度模型相當。BitNet在能源消耗、吞吐量、延遲和內存利用率方面優于其他模型。它還提出了一種新的處理范式,并為訓練高性能、低成本LLM創建了一個新的縮放定律。

- Gemma 1B – 基于與Gemini系列相同的技術,現代輕量級開放變體稱為Gemma 1B。這些模型在語言解釋、推理和安全基準測試中表現出色,參數大小為20億和70億。Gemma在18個基于文本的任務中的11個上的表現優于同樣大小的開放模型。發布強調了AI使用中的安全性和責任性,包括預訓練和細化檢查。

- Lit-LLaMA – Lit-LLaMA基于nanoGPT,旨在提供一個純凈、完全開放和安全的LLaMA源代碼實現。該項目優先考慮社區驅動的開發和簡單性。因此,沒有樣板代碼,實現簡單。Lit-LLaMA支持參數高效的微調方法,如LLaMA-Adapter和LoRA,使得在消費設備上的有效使用成為可能。利用PyTorch Lightning和Lightning Fabric等庫,Lit-LLaMA專注于模型實現和訓練的關鍵方面,堅持單一文件方法,以生產最優質的LLaMA實現,完全開放源代碼,為快速進步和探索做好準備。

3.6 - 非Transformer架構LLM

被稱為非變換器LLM的語言模型經常引入如循環神經網絡(RNN)等組件,從而脫離了傳統的變換器架構。這些方法通過研究替代設計來解決變換器的一些主要缺點和問題,如昂貴的計算成本和對序列數據處理不當。非變換器LLM通過探索替代設計來提供獨特的方法來提高模型性能和效率,這擴大了高級語言處理工作的應用范圍,并增加了AI開發的工具數量。

例子

- Mamba – 由于Mamba解決了變換器架構的計算效率問題,特別是處理擴展序列時,它在基礎模型中提供了重大發展。與傳統模型不同,Mamba不受次二次時間架構的限制,這些架構在基于內容的推理方面存在困難。這些設計的例子包括線性注意力和循環模型。Mamba通過允許結構化狀態空間模型(SSM)參數根據輸入工作來增強離散模態處理。這一突破和硬件感知并行算法導致了一種簡化的神經網絡架構,摒棄了MLP塊和注意力。Mamba在包括語言、音樂和基因組學在內的多個模態中的表現超過了相同甚至更大尺寸的變換器,

3.7 - LLM自我事實檢查

旨在緩解大型語言模型的事實不可靠和靜態知識庫限制的一系列有前景的進展。這些新穎的技術對于準備LLMs進行廣泛的現實世界實施至關重要。這樣做需要兩種能力:

- 訪問外部資源的能力

- 為答案提供引用和參考資料的能力

在這個領域的重大初步研究包括谷歌的REALM和Facebook的RAG,兩者都在2020年推出。

2022年6月,OpenAI推出了一個名為WebGPT的經過微調的GPT模型版本,它利用微軟Bing瀏覽互聯網并生成更精確和全面的答案。WebGPT的運作類似于人類用戶:

- 向Bing提交搜索查詢

- 點擊鏈接

- 滾動網頁

- 使用像Ctrl+F這樣的功能來定位術語

當模型將互聯網上的相關信息納入其輸出時,它會包括引用,允許用戶驗證信息的來源。研究結果表明,所有WebGPT模型在準確響應的比例和提供真實和有信息量的答案的百分比方面都超過了每個GPT-3模型。

圖8. 比較GPT-3和WebGPT模型的TruthfulQA結果

來源:“WebGPT: Browser-assisted question-answering with human feedback”

DeepMind正在積極探索類似的研究途徑。幾個月前,他們推出了一個名為Sparrow的新模型。像ChatGPT一樣,Sparrow以對話為基礎運作,像WebGPT一樣,它可以搜索互聯網以獲取新信息并提供支持其主張的引用。

圖9. Sparrow提供最新答案和事實聲明的證據

來源:“Improving alignment of dialogue agents via targeted human judgements”

盡管現在下結論說準確性、事實檢查和靜態知識庫問題可以在未來的模型中被克服還為時過早,但當前的研究成果對未來是充滿希望的。這可能會減少使用提示工程來交叉檢查模型輸出的需求,因為模型已經交叉檢查了其結果。

3.8 - 合成訓練數據LLM

為了解決我們上面提到的一些限制,例如那些由訓練數據引起的限制,研究人員正在研究能夠生成自己的訓練數據集(即生成合成訓練數據集)的大型語言模型。

在最近的一項研究中,谷歌研究人員開發了一個大型語言模型,能夠創建問題、生成全面答案、篩選其響應以獲得最高質量的輸出,并使用策劃的答案對自己進行微調。令人印象深刻的是,這在多個語言任務中實現了新的最先進的性能。

例如,該模型的性能從74.2%提高到82.1%在GSM8K上,從78.2%提高到83.0%在DROP上,這是兩個廣泛用于評估LLM性能的基準。

最近的一項研究專注于增強一個關鍵的LLM技術,稱為“指令微調”,它構成了像ChatGPT這樣的產品的基礎。雖然ChatGPT和類似的指令微調模型依賴于人工制作的指令,但研究團隊開發了一個能夠生成自己的自然語言指令并隨后使用這些指令對自己進行微調的模型。

性能提升是顯著的,因為這種方法將基礎GPT-3模型的性能提高了33%,幾乎等同于OpenAI自己的指令調整模型(圖11)。

圖11. 由人類專家評估的GPT3模型及其指令調整變體的性能

來源:“Self-Instruct: Aligning Language Model with Self Generated Instructions”

有了這樣的未來模型,有可能減少模型輸出的偏見和毒性,并提高微調所需數據集的效率,這意味著模型學會自我優化。

3.9 - 稀疏專家LLM模型

盡管每個模型的參數、訓練數據、算法等導致性能差異,但所有今天公認的語言模型——如OpenAI的GPT-3、Nvidia/Microsoft的Megatron-Turing、谷歌的BERT——在最終設計上都共享一個基本特征。它們是:

- 自回歸

- 自監督

- 預訓練

- 使用密集激活的基于變換器的架構

密集語言模型意味著所有這些模型都使用它們所有的參數來創建對提示的響應。正如你可能猜到的,這不是很有效,也很麻煩。

稀疏專家模型的想法是,模型能夠激活只有一組相關的參數來回答給定的提示。目前開發的超過1萬億參數的LLMs被認為是稀疏模型。2 這些模型的一個例子是谷歌的GLam,擁有1.2萬億參數。

據《福布斯》報道,谷歌的GLaM比GPT-3大七倍,但訓練能耗少了三分之二。它只需要一半的計算資源進行推理,并在許多自然語言任務上超過了GPT-3的性能。

稀疏專家模型意味著以這種方式開發未來的語言模型更有效,能耗更低。

參考資料

Cem Dilmegani, The Future of Large Language Models in 2024.

Tanya Malhotra, The Next Big Trends in Large Language Model (LLM) Research.