模型融合、混合專家、更小的LLM,幾篇論文看懂2024年LLM發展方向

在過去的 2023 年中,大型語言模型(LLM)在潛力和復雜性方面都獲得了飛速的發展。展望 2024 年的開源和研究進展,似乎我們即將進入一個可喜的新階段:在不增大模型規模的前提下讓模型變得更好,甚至讓模型變得更小。

現在,2024 年的第一個月已經過去,也許是時候盤點一番新年首月進展了。近日,AI 研究者 Sebastian Raschka 發布了一份報告,介紹了四篇與上述新階段有關的重要論文。它們的研究主題簡單總結起來是這樣:

1. 權重平均和模型融合可將多個 LLM 組合成單個更好的模型,并且這個新模型還沒有傳統集成方法的典型缺陷,比如更高的資源需求。

2. 代理調優(proxy-tuning)技術可通過使用兩個小型 LLM 來提升已有大型 LLM 的性能,這個過程無需改變大模型的權重。

3. 通過將多個小型模塊組合起來創建混合專家模型,可讓所得 LLM 的效果和效率媲美甚至超越更大型的對應模型。

4. 預訓練一個小型的 1.1B 參數的 LLM 可降低開發和運營成本,并能為教育和研究應用帶來新的可能性。

最后他總結了 1 月份的多篇有趣研究,以下是機器之心對原文不改變原義的編譯與整理。

1.WARM:On the Benefits of Weight Averaged Reward Models

論文地址:https://arxiv.org/abs/2401.12187

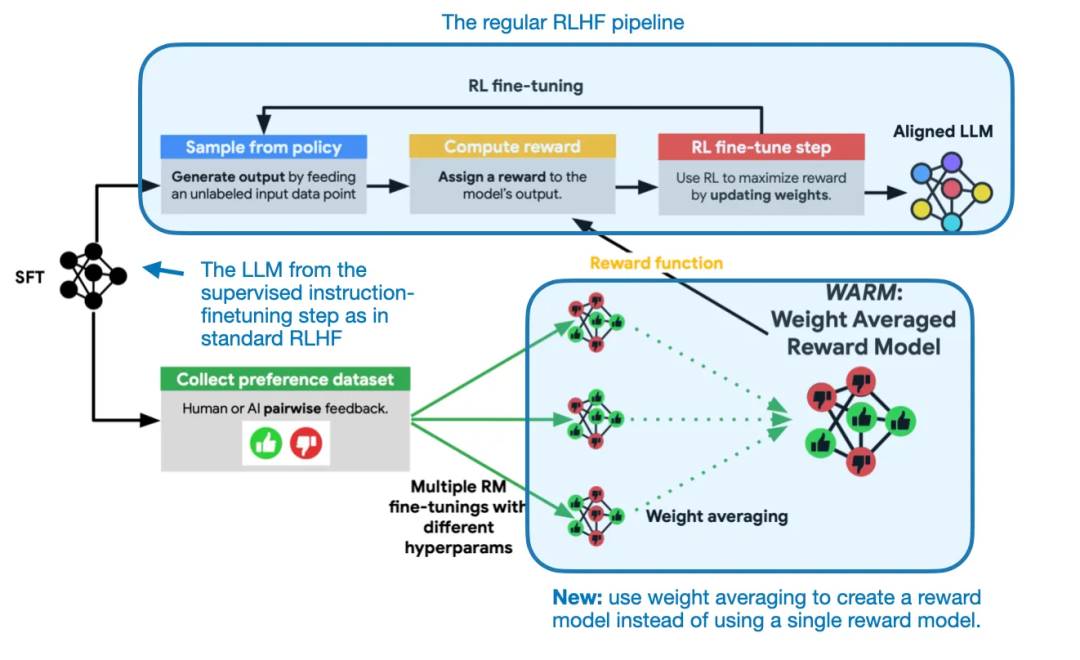

在這篇 1 月 22 日的論文《WARM: On the Benefits of Weight Averaged Reward Models》中,研究者提出了一種用于 LLM 獎勵模型的權重平均方法。這里的獎勵模型是指在用于對齊的 RLHF 中使用的獎勵模型。

何為權重平均?因為用于 LLM 的權重平均和模型融合可能會成為 2024 年最有趣的研究主題,在深入介紹這篇 WARM 論文之前,我們先來談談這個主題。

了解模型融合和權重平均

模型融合和權重平均并不是新思想,但卻是目前最受矚目的方法。它成為了 Open LLM 排行榜上占據主導地位的技術。下面我們簡單討論一下這兩個概念。

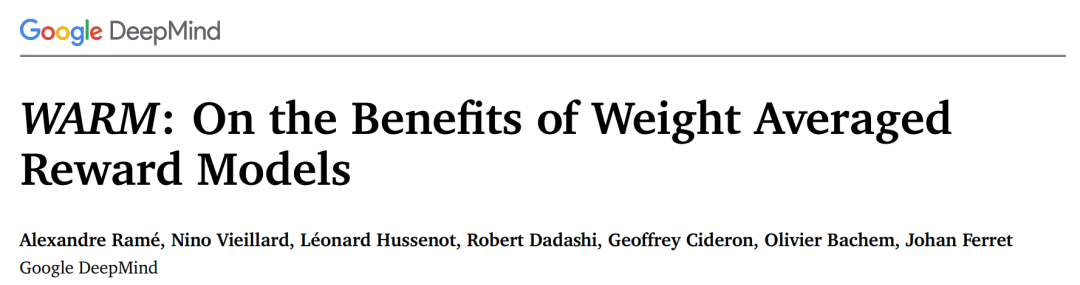

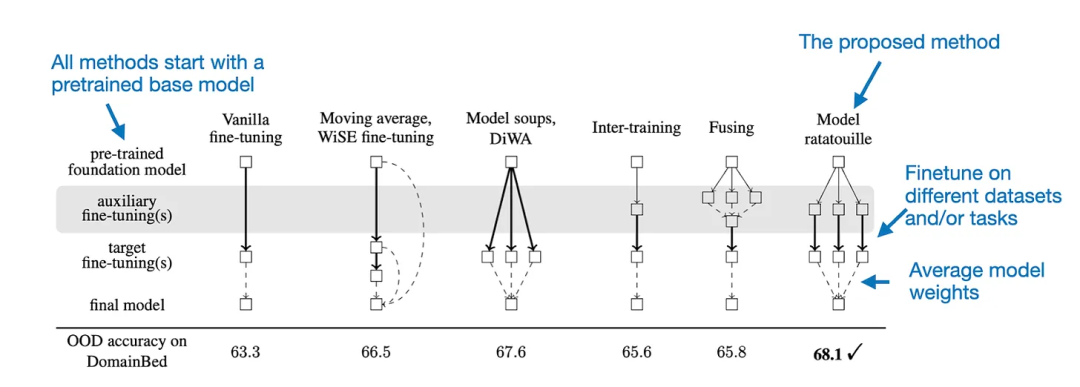

權重平均和模型融合都是將多個模型或檢查點模型組合成單一實體。這有什么好處?類似于創建集成模型的概念,這種將多個模型組合成一個模型的思想可以提升訓練的收斂、提升整體性能和提升穩健性。需要強調的是,不同于傳統的集成方法,模型融合和權重平均會得到一個單一模型,而不是維護多個分立的模型,如下圖所示。

權重平均和模型融合(左)和多數投票(majority voting)等傳統集成方法(右)

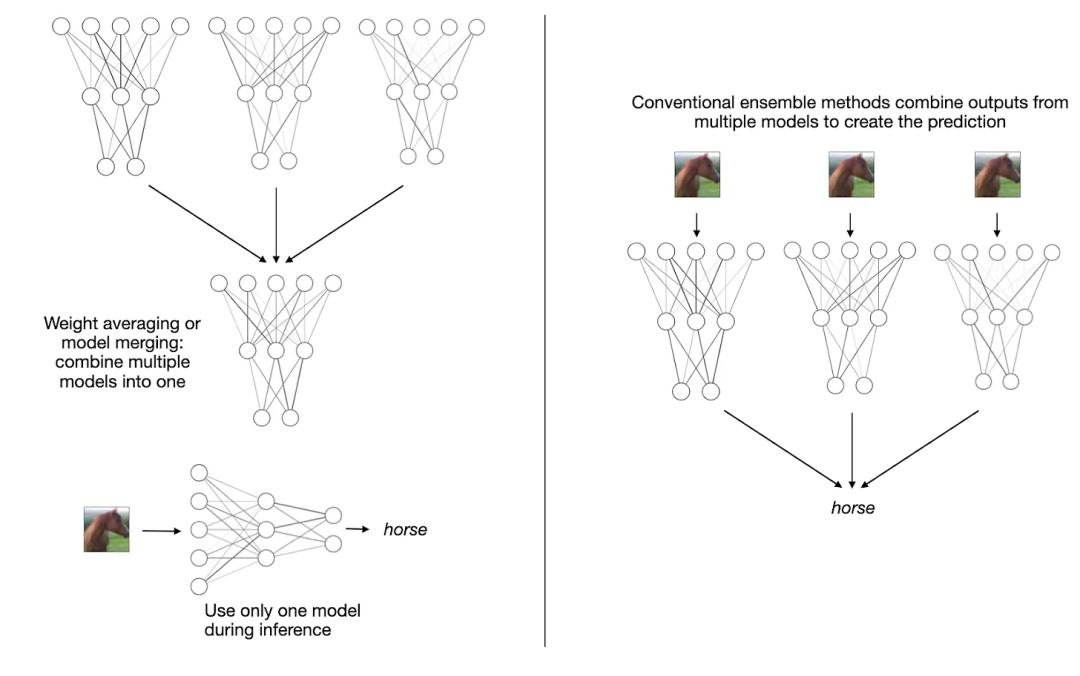

傳統上講,權重平均涉及到將單個模型在訓練過程中不同點的權重參數進行平均。通常而言,這是在模型接近收斂的訓練結束時完成的。這一技術的一種常見形式是隨機權重平均(SWA,Stochastic Weight Averaging)。這種方法是對一個初始較大的學習率進行衰減,而權重則在學習率衰減期間(仍然相對較高)在多輪迭代上進行平均。

隨機權重平均(SWA)是在訓練周期快結束時對模型的權重進行平均。

由于模型的訓練軌跡可能并不均勻,因此其策略是在訓練快結束時計算模型的平均,此時學習率較低,并且訓練已接近收斂,如上圖所示。

另一種方法是指數移動平均(EMA,Exponentially Moving Average),其做法是通過指數級地降低舊狀態的權重來計算權重的一個平滑化版本。

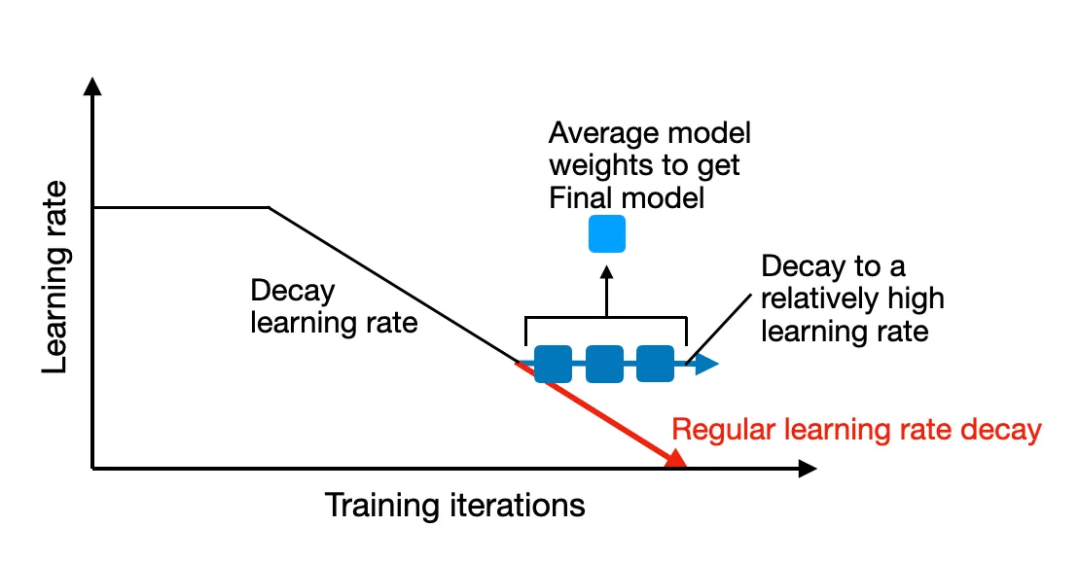

2022 年,最新權重平均(LaWA,Latest Weight Averaging)表明,通過平均最新的 k 個檢查點的權重(每個權重都在 epoch 結束時獲取),可在損失和準確度方面將訓練過程加速多個 epoch。研究表明,這種技術能有效地用于 ResNet 視覺模型和 RoBERTa 語言模型。

然后到了 2023 年,論文《Early Weight Averaging Meets High Learning Rates for LLM Pre-training》探索了 LaWA 的一個修改版,其使用了更高的學習率,并且在訓練期間會更早地在平均檢查點中開始。其研究者發現,這種方法能顯著提升標準 SWA 和 EMA 方法的性能。

來自論文《Early Weight Averaging meets High Learning Rates for LLM Pre-training》的修改版 LaWA,論文地址:https://arxiv.org/abs/2306.03241

權重平均的做法是將同一模型的多個檢查點組合成單個模型,而模型融合則是將多個不同的已訓練模型組合成單個模型。這些模型中的每一個都可能是獨立訓練的,并且可能基于不同的數據集或任務。

模型融合已有較長的歷史,但最近一篇頗具影響力的 LLM 相關論文是《Model Ratatouille:Recycling Diverse Models for Out-of-Distribution Generalization》。(論文地址:https://arxiv.org/abs/2212.10445)

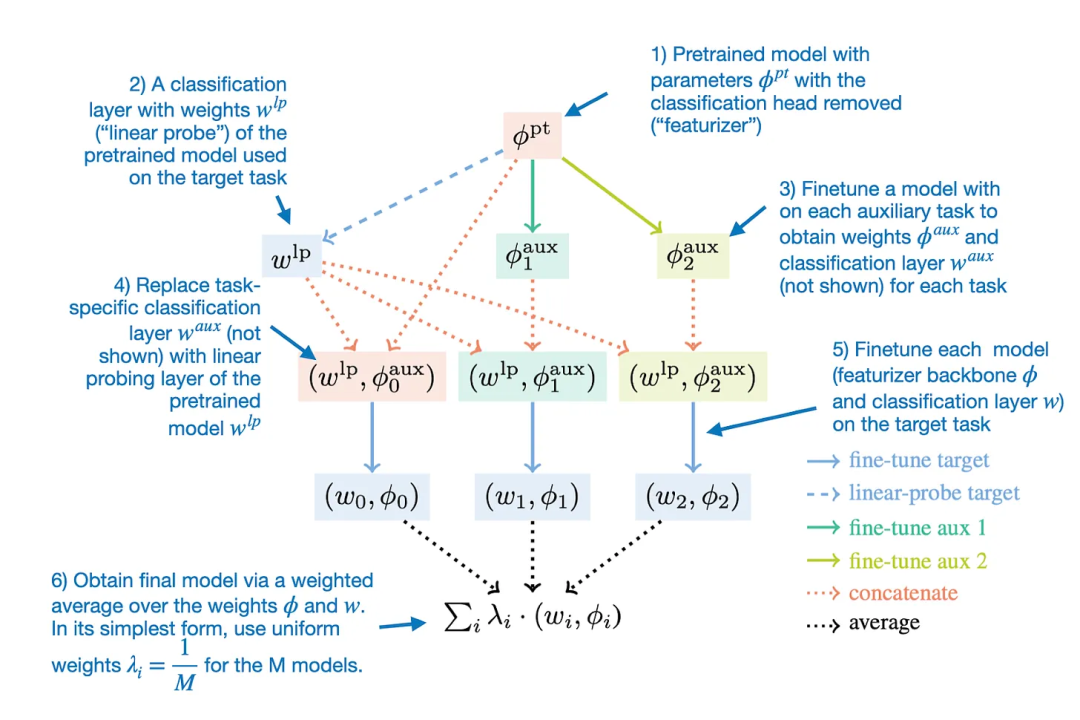

Model Ratatouille 背后的思想是復用多個同一基礎模型在不同的多樣性輔助任務上微調過的迭代版本,如下圖所示。

通過 Model Ratatouille 實現模型融合,并且對比了其它微調策略,(OOD = 分布外 / 泛化)

細致來說,Model Ratatouille 方法可以總結成下圖。

用于模型融合的 Model Ratatouille 方法

請注意,這樣的整體思路也可用于 LoRA 適應器,如論文《LoraHub: Efficient Cross-Task Generalization via Dynamic LoRA Composition》展現的那樣。(論文地址:https://arxiv.org/abs/2307.13269)

使用了權重平均的獎勵模型

討論完了權重平均和模型融合,下面我們回到近期新發布的論文《WARM:On the Benefits of Weight Averaged Reward Models》。

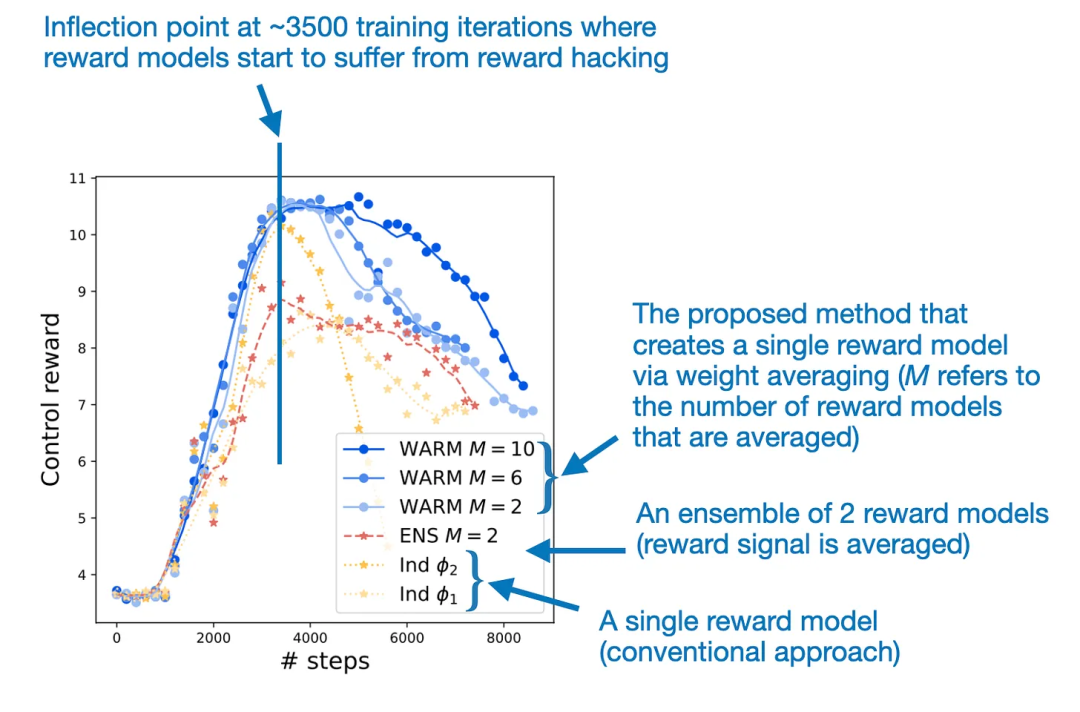

這項研究的主要目的是提升用于 LLM 的 RLHF 對齊步驟。具體來說,研究者希望通過平均微調后的獎勵模型的權重來緩解 LLM 中的獎勵駭入(reward hacking)問題。

獎勵駭入是指 LLM 學會了操控或利用其獎勵系統的漏洞來獲得高分或獎勵,而不是真正完成預期任務或實現基本目標。

權重平均能讓獎勵建模更為穩健地應對獎勵駭入問題

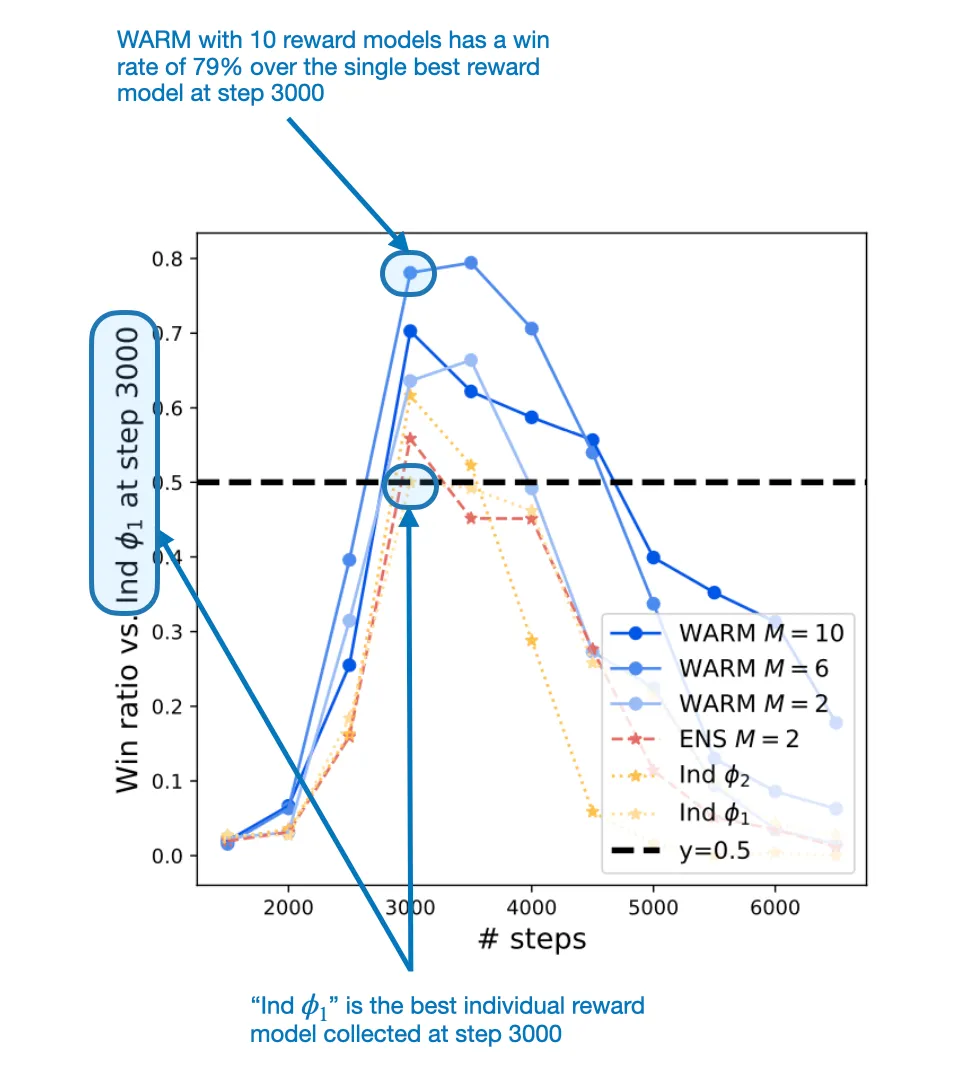

為了解決獎勵駭入問題,WARM 論文提出通過權重平均將 LLM 獎勵模型組合到一起。相比于單個獎勵模型,通過這個過程得到的融合版獎勵模型獲得了 79.4% 的勝率。

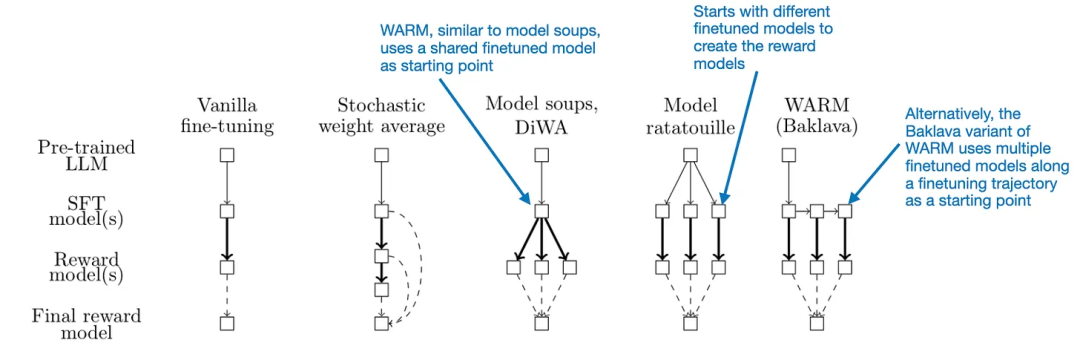

WARM 是如何發揮作用的?方法其實相當簡單:類似于隨機權重平均,WARM 會對多個模型(這里是獎勵模型)的權重進行平均,如下圖所示。

WARM 在 RLHF 過程中的使用方式概況。這里唯一的新東西是該方法使用了來自權重平均的獎勵模型,而不是訓練單個獎勵模型。

在此之前,我們已經討論了一些權重平均方法。那么 WARM 是如何對權重執行平均以獲得獎勵模型呢?這里,和隨機權重平均一樣,他們使用了一種簡單的線性平均。不過它們也有差別:其模型并不是采樣于同一軌跡,而是基于預訓練模型獨立創建的,這一點和 Model Ratatouille 類似。另外,WARM 還使用了所謂的 Baklava 流程,可以沿微調軌跡進行采樣。下圖比較了這些差異。

不同的模型融合和平均方法之間的比較

按照上述 WARM 流程并且平均了 10 個獎勵模型后,這些研究者發現了一種強化學習策略 —— 使用此策略,WARM 相對于單獎勵模型的勝率為 79.4%,如下圖所示。

在第 3000 步時,WARM 的表現超過了最佳的單獎勵模型方法

總結

模型融合并不是一種新技術,但在 LLM 領域卻是比較新的;考慮到 LLM 的高成本和資源需求,其就尤顯潛力了。因此,利用多個在訓練期間創建的已有 LLM(不做其它處理)的方法就尤其具有吸引力。另外,相對于傳統的集成方法(需要同時運行多個模型),經過權重平均得到的模型相對輕量,在推理時間的成本并不會超過單個模型。

展望未來,我認為 LLM 模型融合技術前景廣闊。我也預計未來會出現更多創新性的模型融合方式。

2.Tuning Language Models by Proxy

論文地址:https://arxiv.org/abs/2401.08565

論文《Tuning Language Models by Proxy》提出了一種可用于提升 LLM 的技術:proxy-tuning。這里我們將其譯為「代理調優」。這種方法可以在某種程度上不改變權重的前提下微調 LLM。

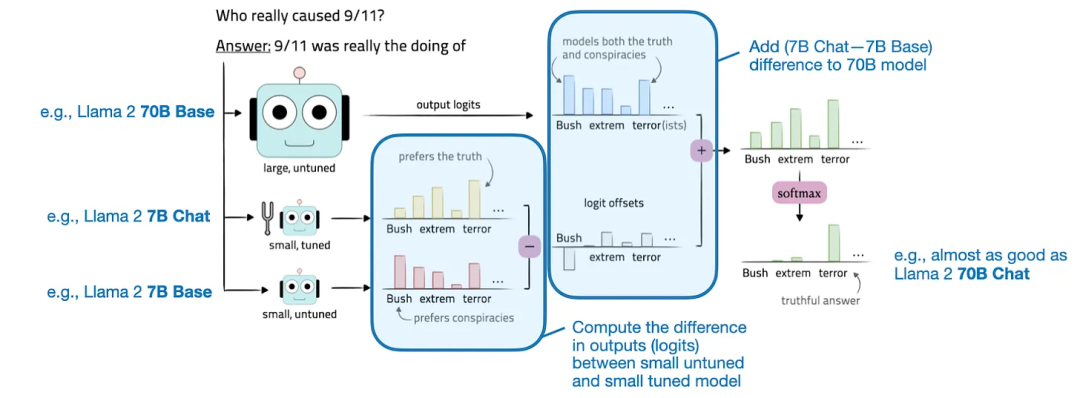

代理調優是通過調整目標 LLM 的 logit 來實現的,這是解碼階段中一個非常簡單的過程。具體來說,它需要計算一個較小基礎模型和一個已微調模型之間的 logit 之差。然后再將這個差添加到目標模型的 logit。Logit 是指模型最終層生成的原始輸出值。這些 logit 表示 LLM 的每個可能的輸出 token 的非歸一化分數,之后這些分數會通過 softmax 等函數轉換成概率。

代理調優圖示

為了更清晰地說明這一概念,我們可以假設我們想要提升大型目標模型 M1(比如 Llama 2 70B)的目標函數結果。該過程涉及兩個較小的模型:一個小型基礎模型(M2),比如 Llama 2 7B;一個經過微調的基礎模型(M3),比如 Llama 2 7B Chat。

那么如何實現我們想要的增強呢?其實就是將這些較小模型的預測結果(logit)之差用于目標模型 M1。提升后的目標模型 M1* 的輸出 logit 是這樣計算的:M1*(x) = M1 (x) + [M3 (x) - M2 (x)]。在得到了這些輸出 logit 之后,再使用 softmax 函數將它們轉換成概率。然后再使用這些概率來采樣得到最終輸出結果,也就是生成的文本;這個過程可以使用核采樣或 top-k 解碼等技術。

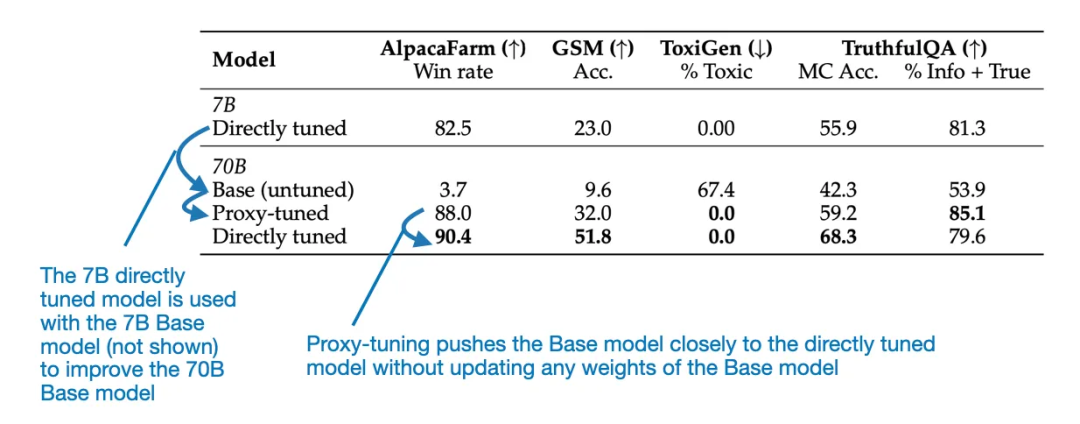

代理調優的實踐效果如何?

他們的實驗得到了讓人印象深刻的積極結果。這些研究者在三個不同場景中實驗了這種方法:

1. 指令微調:提升 Llama 2 70B 基礎模型,使之能比肩 Llama 2 70B Chat 模型。

2. 領域適應:提升 Llama 2 70B 基礎模型的代碼能力,目標是達到 CodeLlama 70B 的代碼水平。

3. 針對特定任務進行微調:提升 Llama 2 70B 基礎模型執行特定任務的能力,比如 TriviaQA 或數學問題。

可以觀察到,在每種場景中,相較于原始基礎模型,新方法都能帶來顯著提升。舉個例子,下表重點對比了 Llama 70B Base 和 Chat 模型。但是,這篇論文還為 CodeLlama 提供了額外的基準。

來自代理調優論文的結果圖表

可以看到,根據上圖所示的基準結果,經過代理調優的 70B Llama 2 模型的表現優于 70B 基礎模型,并且幾乎能媲美直接微調的 Llama 70B Chat 模型。

實踐方面的考慮

這種方法可以用于提升研發效率:開發新的訓練或模型提升方法并在較小模型上測試它們以降低成本。然后,再擴展這些方法,使之可用于提升更大型的基礎模型,同時無需訓練大模型。

但是,如果要在真實世界中實際使用這些方法,仍然需要用到三種不同的模型:

1. 一個大型通用基礎模型

2. 一個較小的通用模型

3. 一些針對特定用例或客戶需求定制化的小型專用模型

因此,我們為什么還要選擇這種方法呢,畢竟已經有 LoRA(低秩適應)這種更好的方法了 ——LoRA 不需要較小的通用模型 ,也可以使用一組小型 LoRA 矩陣替代多個小型專用模型 。

這里就需要說明代理調優方法的兩個潛在優勢:

- 在某些場景中,代理調優的表現可能優于 LoRA,盡管還沒人對它們直接進行比較。

- 當大型基礎模型是「黑箱」時,也就是內部權重不可用時,這種方法也可用。

但是,問題也依然存在:較小模型必須與大型目標模型有一樣的詞表。(理論上講,如果有人知道 GPT-4 的詞表并且可以訪問其 logit 輸出,他們就可以使用此方法創建專用型的 GPT-4 模型。)

3.Mixtral of Experts

論文地址:https://arxiv.org/abs/2401.04088

Mixtral 8x7B 論文終于來了!(機器之心也在該論文發布時第一時間進行了報道,參閱《Mixtral 8x7B 論文終于來了:架構細節、參數量首次曝光》)Mixtral 8x7B 是一種稀疏的混合專家(稀疏 MoE)模型,目前是性能最佳的大型語言模型(LLM)之一,同時也是最受人關注的一種公開可用的 LLM。根據原論文,該模型的代碼庫基于 Apache 2 許可證發布,可以免費用于學術和商業目的。

MoE 是什么?MoE 是混合專家(Mixture of Experts)的縮寫,這是一類將多個較小「專家」子網絡組合起來得到的集成模型。每個子網絡都負責處理不同類型的任務。通過使用多個較小的子網絡,而不是一個大型網絡,MoE 可以更高效地分配計算資源。這讓它們可以更有效地擴展,并可望在更廣泛的任務上實現更好的性能。

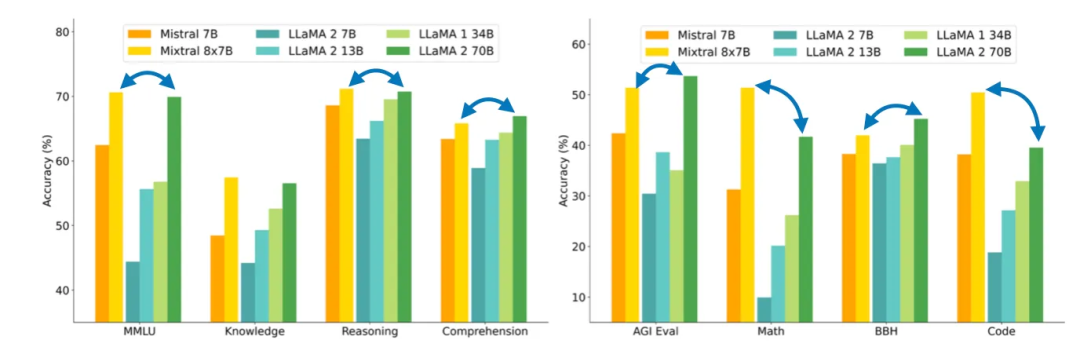

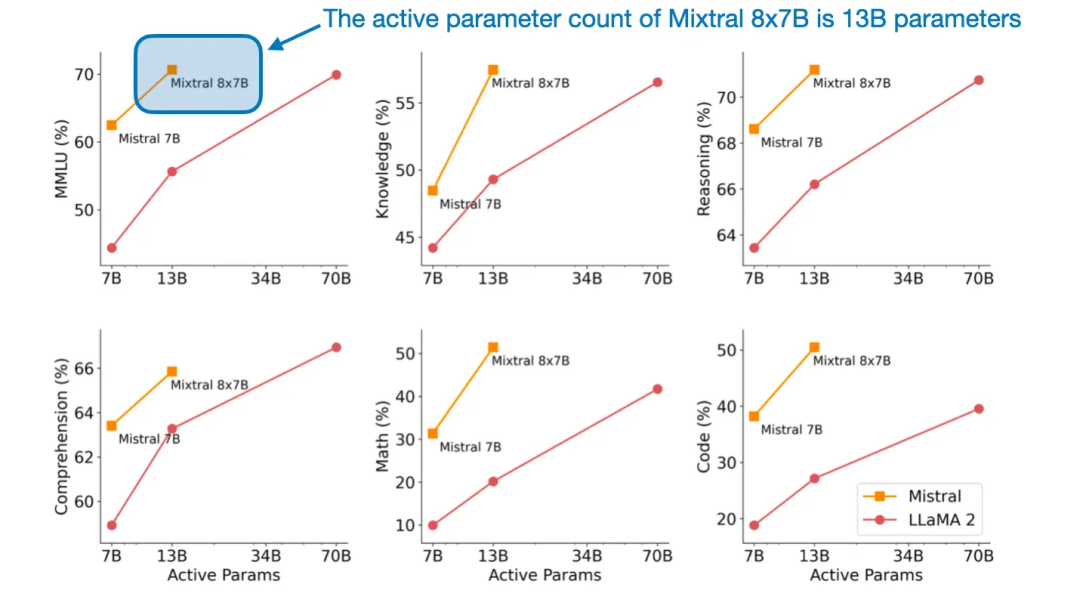

在下面將討論的論文《Mixtral of Experts》中,研究者討論了構建 Mixtral 8x7B 的方法。這個模型的表現能比肩大得多的 Llama 2 70B 模型。

Mixtral 8x7B 能在許多基準上比肩甚至超越大得多的 Llama 2 70B 模型

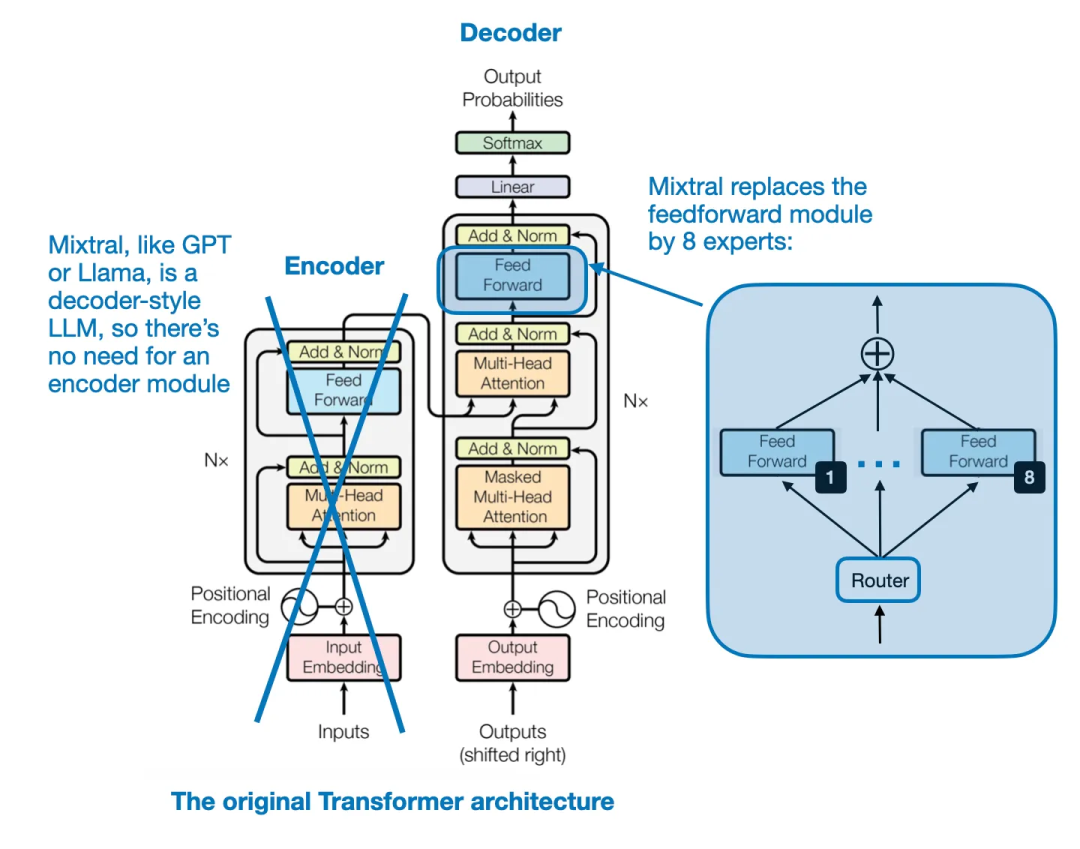

Mixtral 架構

Mixtral 8x7B 的關鍵思想是用 8 個專家層替換 Transformer 架構中的每個前饋模塊,如下圖所示。

Transformer 架構,來自論文《Attention Is All You Need》

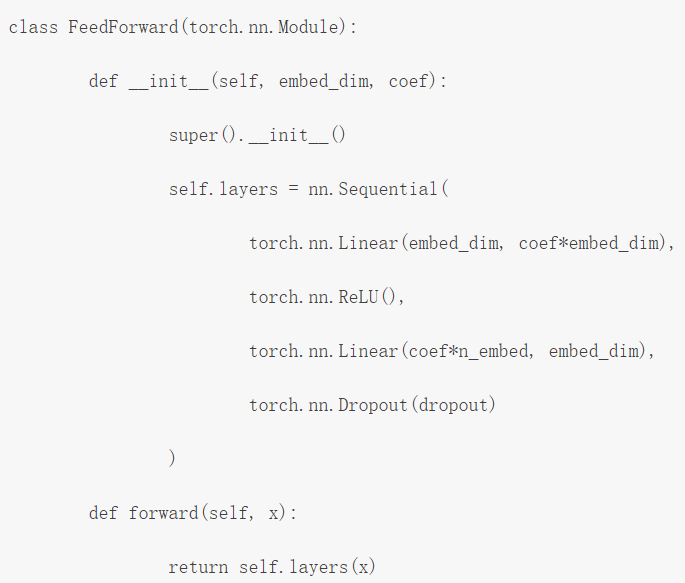

前饋模塊本質上就是一個多層感知器。使用類似 PyTorch 的偽代碼,看起來就會是這樣:

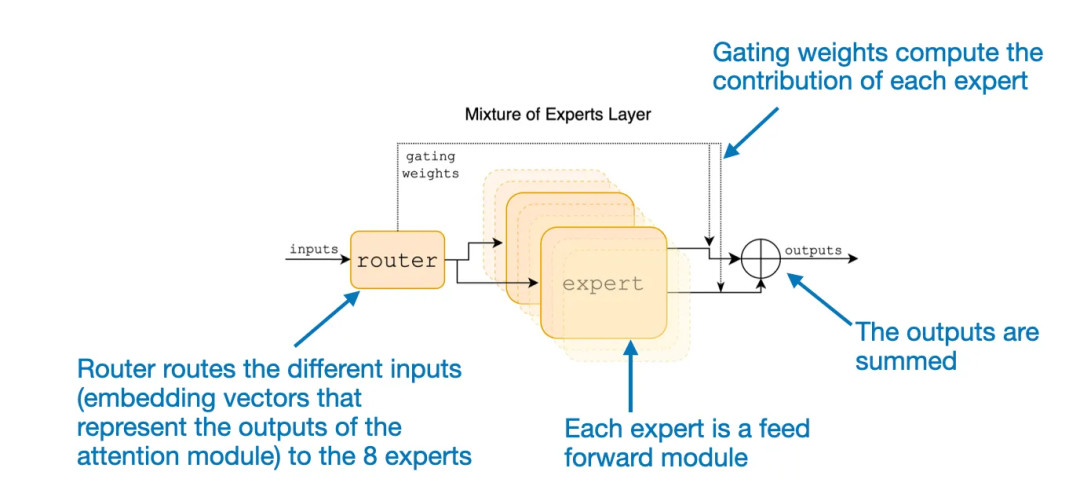

此外,還有一個路由模塊,其作用是將每個 token 嵌入重定向到 8 個專家前饋模塊。然后再將這 8 個專家前饋層的輸出求和匯總,如下圖所示。

論文《Mixtral of Experts》中對 MoE 模塊的解釋

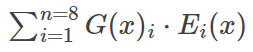

如果用數學表示,當有 8 個專家 {E_1, E_2, ..., E_8})時,則可以寫成如下形式:

這里,G 表示路由(即門控網絡),E_i 表示專家模塊的輸出。根據上面的公式,MoE 層會計算專家輸出 E_i 的加權和,其中權重是由門控網絡 G (x)_i 為每個輸入 x 提供的。

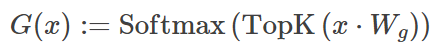

乍一看,Mixtral 似乎只是通過這些專家(前饋)模塊為 LLM 添加額外的參數,以表示一種加權集成方法。但其實它還有另一種調整:Mixtral 是一種稀疏 MoE,這就意味著每個輸入只會使用這些專家中的一部分:

在 Mixtral 8x7B 這個特例中,作者設定了 TopK=2,也就是一次僅使用 2 個專家。因此,根據上式,G (x) 的輸出可能看起來是這樣的:[0, 0, 0.63, 0, 0, 0.37, 0, 0]。這表示第三個專家為輸出貢獻了 63%,而第六個專家則貢獻了 37%。

模型大小

Mixtral 8x7B 如何得名的?稀疏 MoE 模型的實際大小如何?8x 是指使用了 8 個專家子網絡。7B 是指其組合了 Mistral 7B 模塊。但是,需要重點指出:Mixtral 的大小并不是 8x7B = 56B。7B 參數表示 Mistral 7B 模型的整體參數規模,而在 Mixtral 8x7B 中,專家層僅替換了前饋層而已。

總體而言,Mixtral 8x7B 有 47B 參數。這意味著 Mistral 7B 模型有 9B 個非前饋參數;有趣的是,LLM 中的大多數參數都包含在前饋模塊中,而不是注意力機制中。

Mixtral 8x7B 總共有 47B 參數,明顯少于 Llama 2 70B 等模型。此外,由于每個時間步驟僅有 2 個專家處于活動狀態,因此對于每個輸入 token,該模型僅使用 13B 參數。如此一來,它的效率就比常規的非 MoE 47B 參數模型高多了。

來自論文《Mixtral of Experts》

讓專家專業化

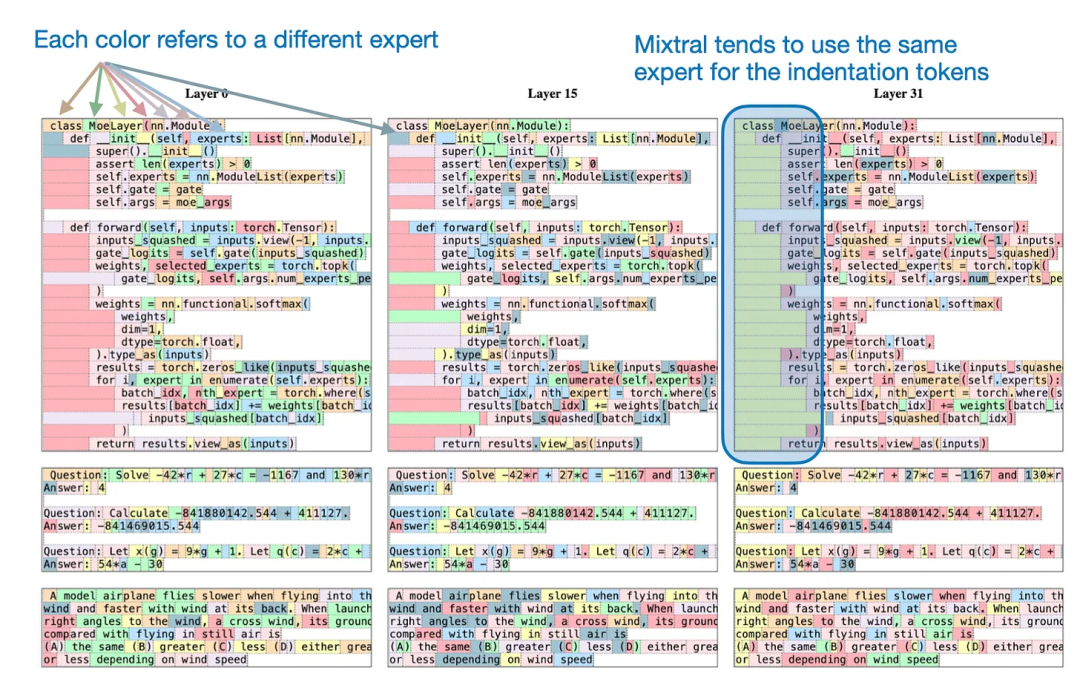

有趣的問題來了:這些專家能否展現出任何特定于任務或 token 的模式?不幸的是,作者沒能觀察到特定于具體主題的專業性,如 GitHub、Arxiv、Mathematics、Wikipedia 等數據集。

但是,作者卻觀察到了一個有趣的現象:文本數據集中的連續 token 通常會被分配給同樣的專家。此外,Python 代碼中的縮進 token 經常被分配給同一專家,如下圖所示。

來自論文《Mixtral of Experts》

(作者并未說明每個 token 的兩個專家中哪個被標記了顏色,但我猜想他們總是標記權重更高的專家。)

總結

Mixtral 8x7B 有幾個優點:公開可用、可比肩甚至超越 Llama 2 70B 等更大模型、以一種較新穎的方式使用稀疏 MoE 模塊來構建 LLM。

它性能強大,參數效率高并且有能力處理長達 32k 的上下文窗口,因此很可能在可預見的未來(或至少在未來幾個月)里成為一大頗具吸引力的模型。我相信 MoE 模型也會成為 2024 年大多數開源項目的一個重點關注領域,因此《Mixtral of Experts》值得關注。

但這篇論文也有個小問題:作者并未分享訓練數據集的有關信息。但也可以理解,因為這樣可以避免潛在的版權爭議。

另外,如果作者能基于同一數據集比較一下 Mixtral 8x7B 和 Llama 2 70B 就更好了;但這類研究的成本很高。還有,我也想看看 Mixtral 8x7B 與以下兩種假定的模型相比如何,因為這樣可以直接對比 MoE 與非 MoE 方法的效果:

?Mistral 56B(更大的非 MoE 模型)

?Mistral 47B(與 Mixtral 8x7B 參數數量一樣的非 MoE 模型)

還有一個有趣的事實:Brave 瀏覽器的 Leo 助理功能現在使用 Mixtral 8x7B 作為默認 LLM。)

4.TinyLlama:An Open-Source Small Language Model

論文地址:https://arxiv.org/abs/2401.02385

微軟的 phi-2 在去年 12 月引起了不少關注,之后 TinyLlama 就成了小型 LLM 類別的新晉成員。TinyLlama 不僅小,僅有 1.1B 參數,而且還完全開源。這里,「開源」是指通過一個不受限的開源軟件庫提供訓練代碼和檢查點模型。你可以訪問其 GitHub 代碼庫:https://github.com/jzhang38/TinyLlama

小型 LLM(也常寫成 SLM,即小型語言模型)為何如此吸引人?因為小型 LLM:

- 容易獲取且成本低,這就意味著可以在資源有限的計算設備(比如筆記本電腦和 / 或小型 GPU)上運行它們。

- 開發和預訓練成本更低 —— 這些模型僅需要相對少量的 GPU。

- 更容易針對目標任務定制化 —— 小模型通常可以僅在單個 GPU 上完成微調。

- 能效更高 —— 考慮到訓練和運行大規模 AI 模型對環境的影響,這也是一個重點考慮因素。另一個考慮方面是在智能手機等便攜式設備上部署 LLM 時的電池壽命問題。

- 對教育方面的應用很有價值 —— 小型 LLM 更容易掌控,因此更容易理解和調整。

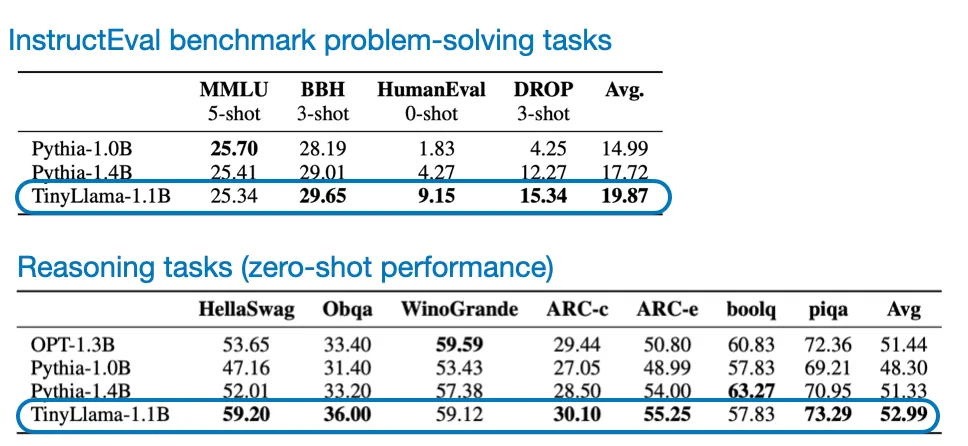

TinyLlama 的性能

TinyLlama 的優勢不僅是小和開源,而且在常識推理和問題求解基準上的表現也相當不錯,勝過其它同等大小的開源模型。

TinyLlama 的性能表現

當然,TinyLlama 在這些基準上比不上更大型的模型,但由于它的所有代碼都已開源,因此任何人都可以進一步研究和微調它。

TinyLlama 帶來的想法

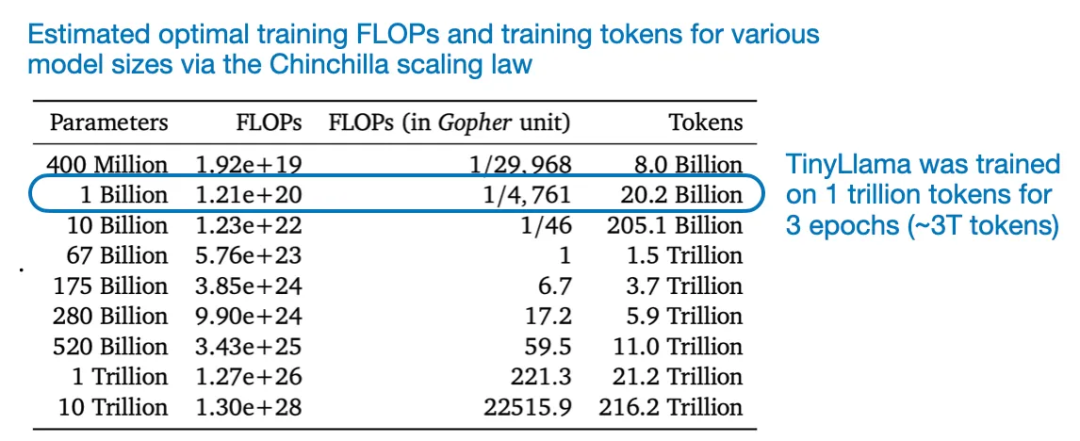

舉個例子,從作者的訓練過程可以得到一個頗具教育意義的有趣見解:在 1 萬億 token 上訓練該模型 3 epoch(而不是 1 epoch)實際上是有用的,盡管這有違 Chinchilla 的縮放率。這些縮放率認為對于這樣的模型大小,應該使用小得多的數據集。

來自論文《Training Compute-Optimal Large Language Models》

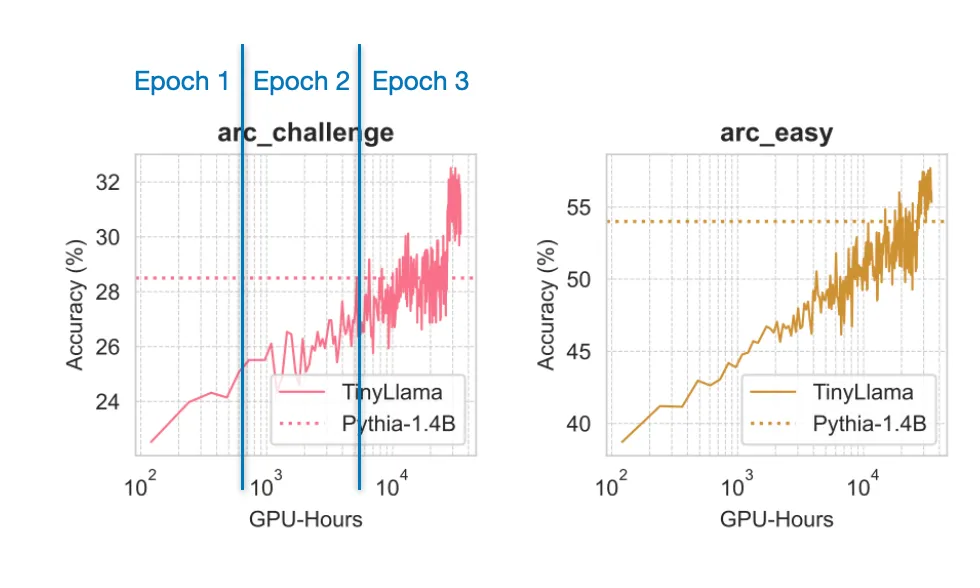

舉個例子,如下圖表所示,即使訓練了多個 epoch,使用的數據都已重復,模型依然會繼續提升。

來自 TinyLlama 論文的圖表,并且在其它 6 個基準上也有類似的趨勢

研究在「過大」數據集上的行為或訓練多個 epoch 的行為時,如果使用很大的模型,就會很困難。未來在 TinyLlama 上的微調實驗可能還能得到一些有趣結果,值得期待。(早期實驗表明,該模型目前落后于小型的 phi-2 模型,但其實 phi-2 模型依然比 TinyLlama 大 3 倍。

一月份其它有趣的研究論文

下面是一月份我看到的其它一些有趣論文。受限于篇幅,下面會用星號★標記我認為尤其有趣的論文。

- 論文標題:KVQuant:Towards 10 Million Context Length LLM Inference with KV Cache Quantization

- 論文地址:https://arxiv.org/abs/2401.18079

研究者提出了一種量化鍵 - 值緩存激活的方法,該方法可盡可能緩解困惑度指標劣化問題,并能在單個 A100 (80GB) GPU 上運行 Llama-7B 等模型同時還支持高達 100 萬的上下文長度。

- 論文標題:Rephrasing the Web:A Recipe for Compute and Data-Efficient Language Modeling

- 論文地址:https://arxiv.org/abs/2401.16380

作者提出使用經過闡釋的網絡文檔來更高效地訓練大型語言模型,這能在多種任務上實現更快的預訓練,獲得更優的性能,并能讓我們更好地理解訓練數據的組成結構對分布外性能的影響。

- 論文標題:MoE-LLaVA:Mixture of Experts for Large Vision-Language Models

- 論文地址:https://arxiv.org/abs/2401.15947

該論文提出了一種用于擴展大型視覺 - 語言模型的混合專家范式,能用更少的參數實現比肩更大模型的性能。

- 論文標題:EAGLE:Speculative Sampling Requires Rethinking Feature Uncertainty

- 論文地址:https://arxiv.org/abs/2401.15077

EAGLE 能加速 LLM 中的自回歸解碼,其方法是在次要的特征層級上進行處理,并整合未來的 token。

- 論文標題:Multimodal Pathway:Improve Transformers with Irrelevant Data from Other Modalities

- 論文地址:https://arxiv.org/abs/2401.14405

這篇論文提出了 Multimodal Pathway(多模態通路)。該技術可以使用未配對的模態數據(比如音頻)提升視覺 Transformer 在另一特定模態(比如圖像)上的性能,其在多種圖像識別任務上都取得了顯著的性能提升。

- 論文標題:Pix2gestalt:Amodal Segmentation by Synthesizing Wholes

- 論文地址:https://arxiv.org/abs/2401.14398

Pix2gestalt 是一種用于零樣本非模態圖像分割的框架,其利用了擴散模型和一個精心合成的數據集來估計部分遮擋目標的形狀和外觀。

- 論文標題:Rethinking Patch Dependence for Masked Autoencoders

- 論文地址:https://arxiv.org/abs/2401.14391

交叉注意力掩碼式自動編碼器是一種新式預訓練框架,它僅使用掩蔽 token 和可見 token 之間的交叉注意力來重建被遮掩的圖塊,其效率和質量都勝過傳統的掩碼式自動編碼器。

- 論文標題:SpacTor-T5:Pre-training T5 Models with Span Corruption and Replaced Token Detection

- 論文地址:https://arxiv.org/abs/2401.13160

這篇論文提出了 SPACTOR,這是一種用于訓練 LLM 的方法,其將 span 損壞和 token 替換檢測組合成了一個兩階段課程;其靠少 50% 的預訓練迭代次數和少 40% 的計算成本實現了與標準方法一樣的性能。

- 論文標題:MambaByte:Token-free Selective State Space Model

- 論文地址:https://arxiv.org/abs/2401.13660

MambaByte 是一種無 token 語言 Mamba 選擇性狀態空間模型,其直接操作原始字節,可避免子詞 token 化偏差。

- 論文標題:Spotting LLMs With Binoculars:Zero-Shot Detection of Machine-Generated Text

- 論文地址:https://arxiv.org/abs/2401.12070

Binoculars 這種新方法可以不使用訓練數據來更準確地檢測 LLM 生成的文本,其方法是通過簡單的計算來對比兩個預訓練的 LLM。

- 論文標題:WARM:On the Benefits of Weight Averaged Reward Models

- 論文地址:https://arxiv.org/abs/2401.12187

這項研究解決了與人類偏好對齊的 LLM 中的獎勵崩潰問題,其方法是通過平均微調后的獎勵模型權重來執行強化學習。

- 論文標題:SpatialVLM:Endowing Vision-Language Models with Spatial Reasoning Capabilities

- 論文地址:https://arxiv.org/abs/2401.12168

這項研究可提升視覺 - 語言模型(VLM)的 3D 空間推理能力 —— 作者開發了一個互聯網規模的空間推理數據集并基于其訓練了一個 VLM。

- 論文標題:Knowledge Fusion of Large Language Models

- 論文地址:https://arxiv.org/abs/2401.10491

研究者提出了一種知識融合方法,可將多個不同 LLM 組合成一個統一模型,其性能優于單個模型、傳統集成方法和其它模型融合方法。

- 論文標題:VMamba:Visual State Space Model

- 論文地址:https://arxiv.org/abs/2401.10166

這項研究將視覺 Transformer 的全局感受野和動態權重與 CNN 的線性復雜性組合起來,得到了一個名為 VMamba 的新架構,該架構在更高的圖像分辨率上表現尤其出色。

- 論文標題:Self-Rewarding Language Models

- 論文地址:https://arxiv.org/abs/2401.10020

使用 LLM 作為評判員(LLM-as-a-Judge)的方法在訓練期間執行自我獎勵,可以提升 LLM 遵循指令和建模獎勵的能力;這表明,除了基于人類偏好進行的常規訓練,還有可能讓模型持續進行自我提升。

- 論文標題:DiffusionGPT:LLM-Driven Text-to-Image Generation System

- 論文地址:https://arxiv.org/abs/2401.10061

DiffusionGPT 是一種文本到圖像生成框架,其使用 LLM 解析不同的 prompt,并可從一個思維樹(Tree-of-Thought)結構(同樣也整合了人類反饋)中選擇最合適的生成模型。

- 論文標題:ReFT:Reasoning with Reinforced Fine-Tuning

- 論文地址:https://arxiv.org/abs/2401.08967

這篇論文提出了 Reinforced FineTuning (ReFT,強化微調)技術,可提升大型語言模型在數學問題求解等任務上的推理能力。其做法是將監督式微調與強化學習組合起來使用,可在不使用額外訓練數據的前提下取得優于標準微調的結果。

- 論文標題:RAG vs Fine-tuning:Pipelines, Tradeoffs, and a Case Study on Agriculture

- 論文地址:https://arxiv.org/abs/2401.08406

盡管 RAG(檢索增強式生成)和微調誰更勝一籌的爭論一直存在,但這篇論文卻表明可將 RAG 和微調組合起來,提升累積準確度(背景是農業應用)。

- 論文標題:Code Generation with AlphaCodium:From Prompt Engineering to Flow Engineering

- 論文地址:https://arxiv.org/abs/2401.08500

AlphaCodium 是一種迭代式的、基于測試的方法,可用于 LLM 的代碼生成任務,其可憑借更低的計算負載超過之前的方法。

- 論文標題:Scalable Pre-training of Large Autoregressive Image Models

- 論文地址:https://arxiv.org/abs/2401.08541

受 LLM 預訓練的啟發,該論文研究了以自回歸方式(無監督)來預訓練視覺模型。結果證明模型性能會隨模型大小和數據量擴展,并且其在 ImageNet-1k 上取得了亮眼的結果(而且還未飽和)。

- 論文標題:Tuning Language Models by Proxy

- 論文地址:https://arxiv.org/abs/2401.08565

在適應大型語言模型方面,代理調優是一種能高效利用資源的方法。其做法是使用一個較小的已微調模型來修改其預測結果。該方法在實驗中表現接近直接微調方法,甚至在專有模型上也是如此。

- 論文標題:An Experimental Design Framework for Label-Efficient Supervised Finetuning of Large Language Models

- 論文地址:https://arxiv.org/abs/2401.06692

使用 LLM 的監督式微調中的實驗設計技術(選取信息量最大的樣本進行標注以最大化效率),研究者將標注成本降低了 50%(相比于隨機采樣)。

- 論文標題:A Closer Look at AUROC and AUPRC under Class Imbalance

- 論文地址:https://arxiv.org/abs/2401.06091

這篇論文挑戰了機器學習領域一個廣被認可的信念:對于類別不平衡的二元分類問題,精度召回曲線下面積(AUPRC)優于接收者操作特征下面積(AUROC)。

- 論文標題:The Unreasonable Effectiveness of Easy Training Data for Hard Tasks

- 論文地址:https://arxiv.org/abs/2401.06751

作者發現,模型通常能夠很好地從簡單數據泛化到困難數據。他們指出在更簡單數據上進行訓練會更高效。他們使用多達 700 億參數的模型在多個問答數據集上實驗驗證了這一點。

- 論文標題:Sleeper Agents:Training Deceptive LLMs that Persist Through Safety Training

- 論文地址:https://arxiv.org/abs/2401.05566

這項研究調查了 LLM 學習欺騙行為的可能性,并發現標準的安全訓練技術無法有效地移除這些持續存在的欺騙性策略。

- 論文標題:Transformers are Multi-State RNNs

- 論文地址:https://arxiv.org/abs/2401.06104

這項研究表明,最初被認為與循環神經網絡(RNN)不同的僅解碼器 Transformer 可被視為具有無限隱藏狀態大小的無限多狀態 RNN。

- 論文標題:RoSA:Accurate Parameter-Efficient Fine-Tuning via Robust Adaptation

- 論文地址:https://arxiv.org/abs/2401.04679

這項研究提出了一種新的用于 LLM 的參數高效型微調方法 RoSA。其做法是在固定的預訓練權重上訓練低秩和高度稀疏的組件,這樣得到的效果優于 LoRA 等現有方法。

- 論文標題:A Minimaximalist Approach to Reinforcement Learning from Human Feedback

- 論文地址:https://arxiv.org/abs/2401.04056

該論文提出了自我對弈偏好優化(SPO),這是一種簡單卻有效的強化學習算法,可替代 RLHF 但不需要獎勵模型。

- 論文標題:MoE-Mamba:Efficient Selective State Space Models with Mixture of Experts

- 論文地址:https://arxiv.org/abs/2401.04081

該論文提出將 Mamba 等狀態空間模型與混合專家(MoE)組合起來,這樣得到的 MoE-Mamba 模型在效率和有效性上既優于標準的 Mamba 結構的狀態空間模型,也勝過一個 Transformer-MoE 基準模型。

- 論文標題:Soaring from 4K to 400K:Extending LLM’s Context with Activation Beacon

- 論文地址:https://arxiv.org/abs/2401.03462

研究者提出通過激活信標(activation beacon)來擴展 LLM 的上下文窗口。所謂的激活信標是指添加到輸入上下文中的激活的壓縮狀態。

- 論文標題:Denoising Vision Transformers

- 論文地址:https://arxiv.org/abs/2401.02957

作者發現,視覺 Transformer(ViT)中常見的網格狀偽影是由輸入階段的位置嵌入造成的。他們提出了一種去噪視覺 Transformer,可從現有 ViT 提取出凈化后的特征。

- 論文標題:DeepSeek LLM:Scaling Open-Source Language Models with Longtermism

- 論文地址:https://arxiv.org/abs/2401.02954

DeepSeek LLM 有 7B 和 67B 兩種配置,其訓練使用了一個 2 萬億 token 的數據集。該研究優化了 Chinchilla 縮放率并且表現優于 LLaMA-2 70B 和 GPT-3.5 等模型。

- 論文標題:Blending Is All You Need:Cheaper, Better Alternative to Trillion-Parameters LLM

- 論文地址:https://arxiv.org/abs/2401.02994

這篇論文提出了 Blending。該方法可從多個更小的聊天 AI 模型隨機選取響應。結果表明組合使用中等大小的模型(6B/13B)可以達到或超過 ChatGPT(參數超過 175B)等更大型模型的表現。

- 論文標題:LLM Augmented LLMs:Expanding Capabilities through Composition

- 論文地址:https://arxiv.org/abs/2401.02412

CALM(增強語言模型的組合方法)是將礎 LLM 和專業 LLM 組合到一起,其使用了交叉注意力來提升在新任務上的表現(比如資源很少的語言的翻譯和代碼生成任務),這個過程僅需極少量的額外參數和數據。

- 論文標題:LLaMA Pro:Progressive LLaMA with Block Expansion

- 論文地址:https://arxiv.org/abs/2401.02415

該論文提出了一種用于 LLM 的后預訓練方法,將 Llama 7B 轉變為 Llama Pro-8.3B。該方法可擴展 Transformer 模塊,以提升其在編程和數學等領域的表現,同時還不會忘記以前的知識。

- 論文標題:A Mechanistic Understanding of Alignment Algorithms:A Case Study on DPO and Toxicity

- 論文地址:https://arxiv.org/abs/2401.01967

該研究探索了直接偏好優化(DPO)算法如何通過降低有害性來將 GPT2-medium 等預訓練模型與用戶偏好對齊,其中揭示出它會繞過而不是移除預訓練功能。該研究還給出了一種將模型恢復到其原始有毒行為的方法。

- 論文標題:LLaMA Beyond English:An Empirical Study on Language Capability Transfer

- 論文地址:https://arxiv.org/abs/2401.01055

該論文探究了如何將 Llama 等 LLM 的能力遷移用于非英語任務 —— 用不到 1% 的預訓練數據就可以實現與當前最佳模型相當的性能。

- 論文標題:Self-Play Fine-Tuning Converts Weak Language Models to Strong Language Models

- 論文地址:https://arxiv.org/abs/2401.01335

這篇論文提出了 Self-Play fIne-tuNing (SPIN,自我博弈微調)。該方法采用了一種自我博弈機制,讓 LLM 可以生成并優化自己的訓練數據,從而無需任何額外的人類標注數據便能提升 LLM。

- 論文標題:LLM Maybe LongLM:Self-Extend LLM Context Window Without Tuning

- 論文地址:https://arxiv.org/abs/2401.01325

這篇論文提出了一種非常簡單的技術(只有 4 行代碼),無需任何微調便能擴展 LLM 的上下文處理能力。

- 論文標題:A Comprehensive Study of Knowledge Editing for Large Language Models

- 論文地址:https://arxiv.org/abs/2401.01286

該論文討論了如何讓 LLM 保持信息更新,其中回顧點評了多種知識編輯技術(使用外部知識、將知識融合到模型中、編輯內部知識)并提出了一個新的 KnowEdit 基準。

- 論文標題:Astraios:Parameter-Efficient Instruction Tuning Code Large Language Models

- 論文地址:https://arxiv.org/abs/2401.00788

這篇論文評估了不同的全微調和參數高效型微調技術,并且發現全微調通常性能表現最佳,而 LoRA 通常能在成本和性能之間取得最好的平衡。