看幾小時視頻就能模仿人類聊天?Facebook機器人表情豐富著呢

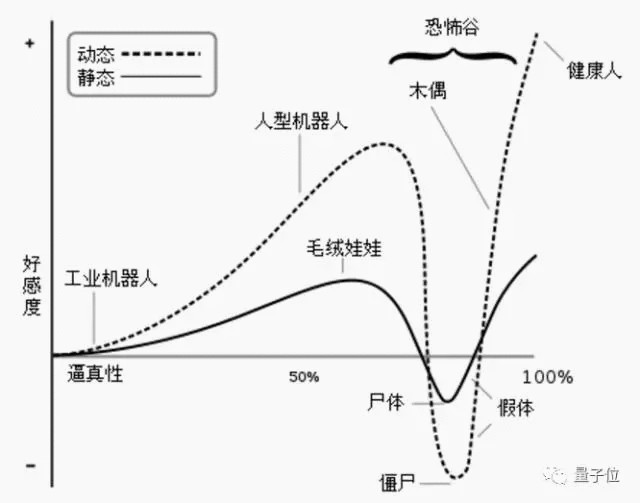

人形機器人的相似度與人類的好感度不成正比。根據(jù)日本機器人專家森政弘 1970 年提出的恐怖谷理論,隨著物體擬人程度增加,人類的反應(yīng)呈增-減-增曲線。當(dāng)擬人度達(dá)到某一程度時,人類好感度會大幅下降,甚至還會覺得擬人物驚悚可怕。

恐怖谷理論/維基百科

Facebook 正在努力讓自己的機器人盡快跨過恐怖谷。

近日,F(xiàn)acebook 人工智能實驗室(FAIR)的研究人員就開發(fā)出一個善于表達(dá)情緒的機器人。這是由一個由 AI 算法操控的虛擬動畫機器人,在觀察幾小時人類 Skype 聊天視頻能模仿人的表情。

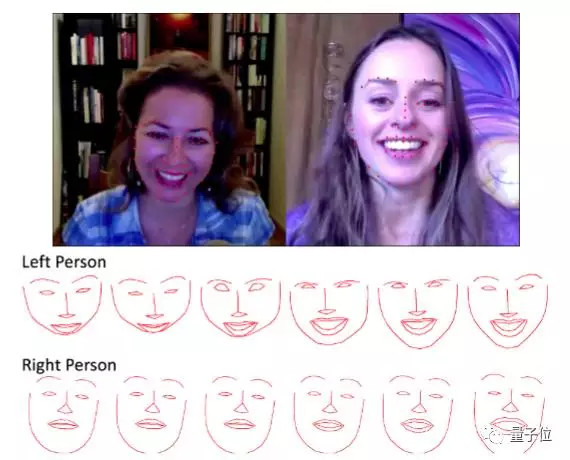

68 個面部標(biāo)記區(qū)塊

為了更好模擬人類的情感表達(dá)方式,研究人員將動畫中的人臉分成 68 個區(qū)塊,在 Skype 對話中重點觀察這些部位的變化。在交談中,人類的點頭、眨眼和嘴部的動作變化都會反應(yīng)出來,機器人會學(xué)會這些面部變化。

上圖為捕捉到的人類對話中的面部表情,下圖為系統(tǒng)對面部表情的追蹤

觀察一段時間后,動畫機器人可以實時預(yù)測可能出現(xiàn)的面部表情。如果視頻中人在笑,機器人也可能張開嘴,或者歪著頭。

測試結(jié)果

隨后,F(xiàn)acebook 研究人員進(jìn)行了一組測試。志愿者們觀看了人和人對話的原版視頻,以及訓(xùn)練后的機器人模擬的反應(yīng),他們認(rèn)為機器人表現(xiàn)得自然且真實。

圖片中線條高低表示嘴部(左)及眼部(右)的張合度,可以看出用戶(上)和智能體預(yù)測(下)的表情基本一致

因為目前算法還只能表現(xiàn)在動畫中,尚不清楚算法支持的人形機器人的反應(yīng)如何。

學(xué)習(xí)面部交流的基本規(guī)則不足以創(chuàng)造真正的對話伙伴,以色列特拉維夫大學(xué)的博士生 Goren Gordon 說,“真正的面部表情是要基于所思所感的。”

“在這種情況下,F(xiàn)acebook 系統(tǒng)會創(chuàng)造出一種平均性格”,卡內(nèi)基梅隆大學(xué)語言技術(shù)學(xué)院副教授 louis-Philippe Morency 說。在未來,機器人的性格可能更復(fù)雜,或能根據(jù)談話對象調(diào)整自己的性格。

機器人不擅長人類之間互動的這些微妙元素,Gordon 說。他同時表達(dá)了對機器人的期望:“在某一時刻,我們終會走出恐怖谷,走到另一邊。”

日本大阪大學(xué)智能機器人研究所設(shè)計的人形機器人女播音員 Otonaroid

Facebook 將在本月 24 號溫哥華召開的 IROS 2017 上展示這項技術(shù),目前已將這項技術(shù)的論文《Learn2Smile: Learning Non-Verbal Interaction Through Observation》公開。

論文摘要

在這篇論文中,我們研究了人類和智能體面對面交流中的非語言面部暗示,提出了基于用戶表情自動學(xué)習(xí)并升級智能體面部情感表達(dá)的方法。我們用數(shù)百個視頻訓(xùn)練神經(jīng)網(wǎng)絡(luò),包含人類相互對話的視頻,這其中沒有加入外部的人為監(jiān)督。

實驗結(jié)果顯示,我們的智能體面部標(biāo)記模型可以長時間預(yù)測人類的表情;對比結(jié)果也表明,模型明顯優(yōu)于基線方法。***,我們進(jìn)行了更深入的研究以更好地理解模型性能。

本項研究的數(shù)據(jù)集已經(jīng)開放,方便領(lǐng)域內(nèi)的其他研究者使用。