人物照片+文字 = 定制化視頻,騰訊光子開源ID-Animator

近年來,定制化的人物生成技術在社區中引起了廣泛關注。一系列創新性的模型,如 IP-Adapter、Photomaker、InstantID 等,已在圖像生成領域取得了令人矚目的成果。這些定制化內容生成方法逐漸成為主流,其一個重要的優勢便是即插即用,取代了那些需要逐例微調的 Dreambooth,LoRA 等方法。

然而,盡管在圖像生成領域取得了巨大的成功,這些方法在視頻生成領域卻遇到了阻礙。相較于圖像,視頻生成模型的訓練需要更大的算力投入。同時,在視頻數據集方面,迄今為止仍缺乏類似圖像生成領域高質量的文本 - 視頻配對人臉數據集。此外,如何提取人物身份一致性的特征也是一個難題。

為了應對這些挑戰,騰訊光子近期發布的工作 ID-Animator,提出了一種文本驅動的人物視頻生成框架。該框架旨在根據給定的一張參考圖片,生成一致性的角色 定制化視頻。通過這一創新性技術,研究者可以期待在不久的將來,人們將能夠更輕松地實現定制化的人物視頻生成,從而為各種應用場景帶來更加豐富的視覺體驗。

- 論文地址: https://arxiv.org/abs/2404.15275

- Github 地址: https://github.com/ID-Animator/ID-Animator

- Huggingface 地址: https://huggingface.co/spaces/ID-Animator/ID-Animator

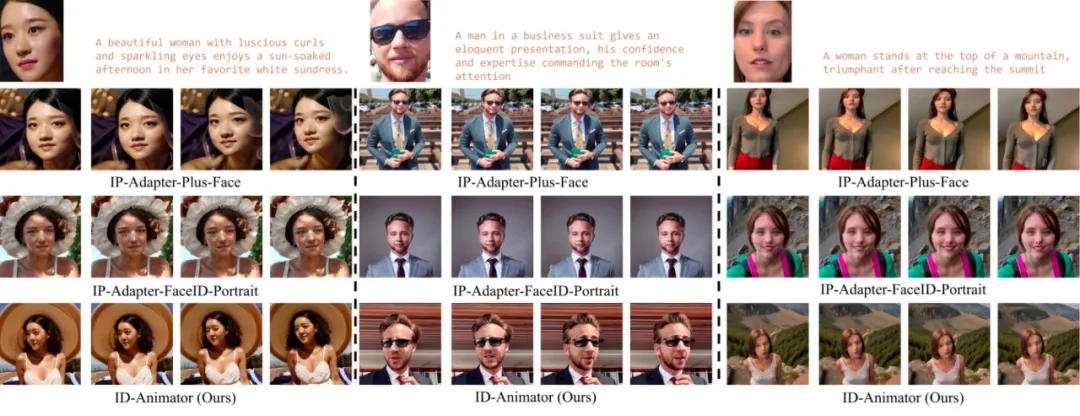

首先,讓我們直觀感受一下 ID-Animator 生成的視頻效果,能夠輕松的讓不同的角色做起豐富的動作:

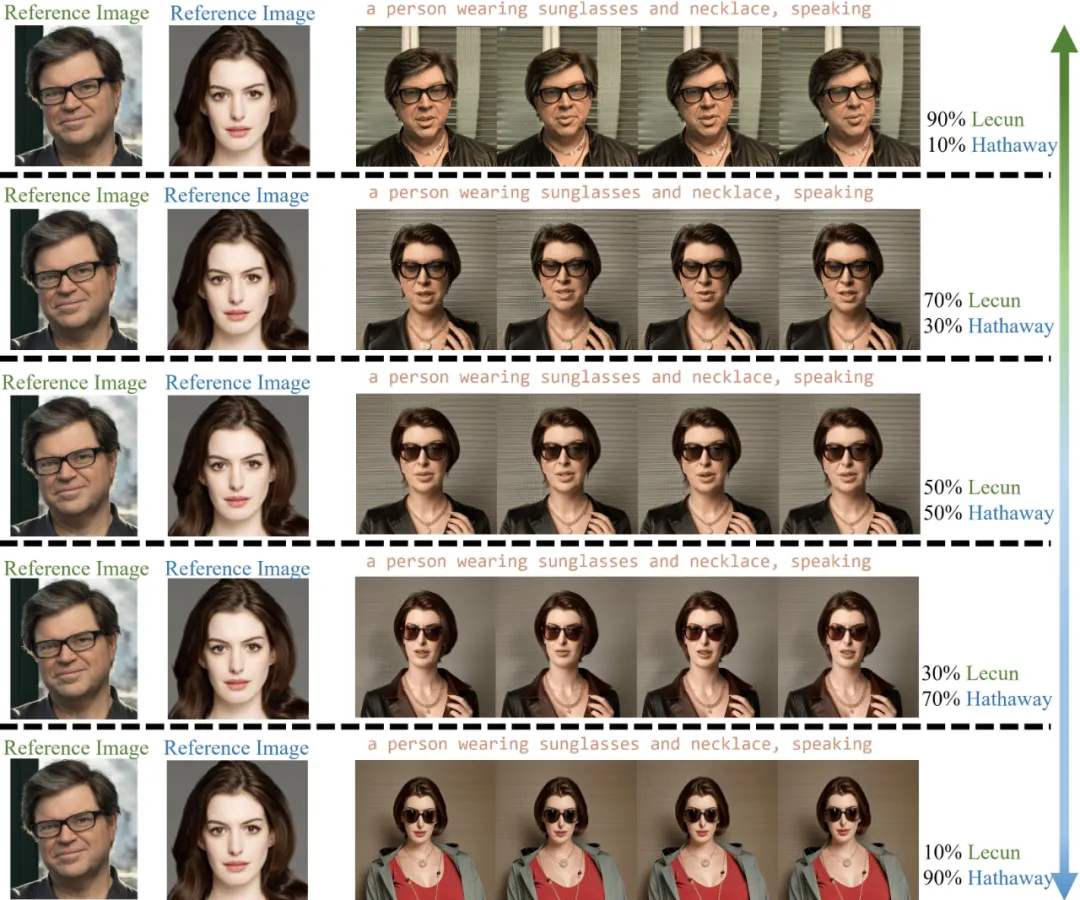

ID-Animator 不僅能生成 ID 一致的人類視頻,還具備人臉特征融合的能力:

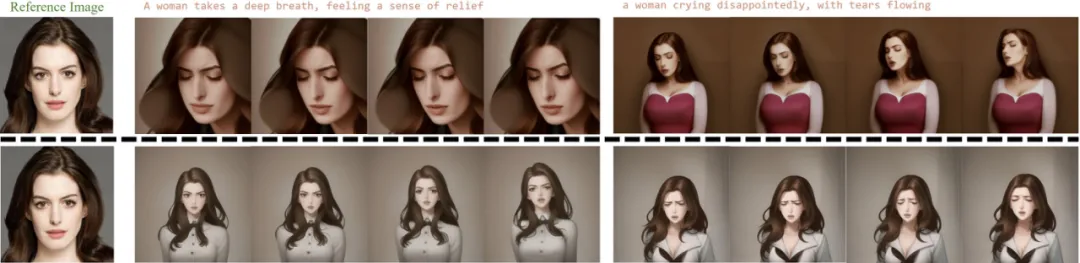

此外,ID-Animator 還可以兼容開源社區上的多種權重,為視頻生成帶來更多可能性:

方法概覽

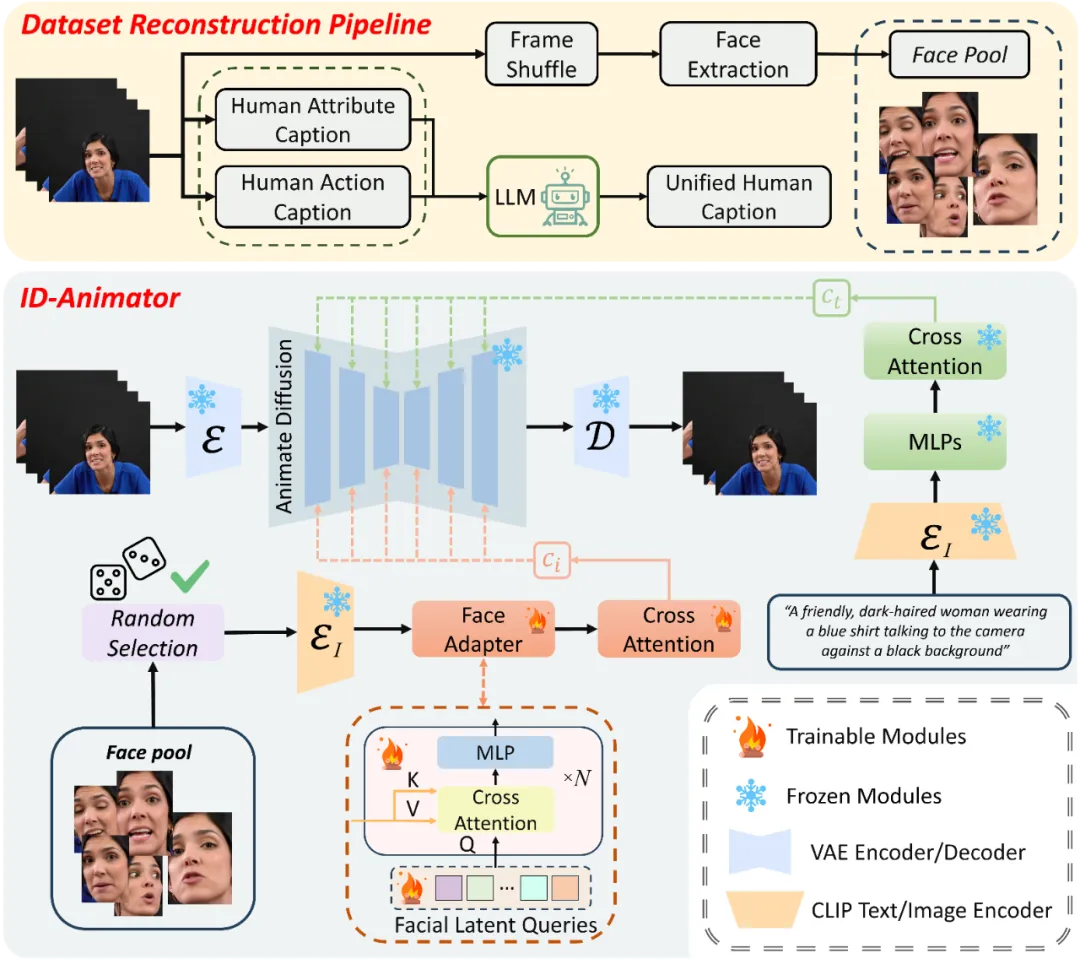

研究團隊提出的方法可以概括為三個核心組件,如圖所示。這三個部分包括:面向 ID 的視頻數據集重構流程、隨機人臉參考的訓練方法,以及 ID-Animator 模型框架。通過這三個關鍵組成部分,ID-Animator 成功實現了高保真的一致性人物視頻生成。

ID-Animator 框架

ID-Animator 框架由一個輕量級的人臉適配器模塊和一個視頻生成主干網絡組成。其視頻生成主干網絡權重在訓練過程中保持固定,無需微調。人臉適配器模塊則由交叉注意力模塊和可學習的面部特征查詢組成,負責從 CLIP 編碼的特征中提取與身份相關的表征,并將身份表征注入主干網絡。利用這種輕量級的適配器模塊,ID-Animator 只需要很小的訓練開銷就能實現人物一致性的視頻生成。

面向 ID 的數據集構建

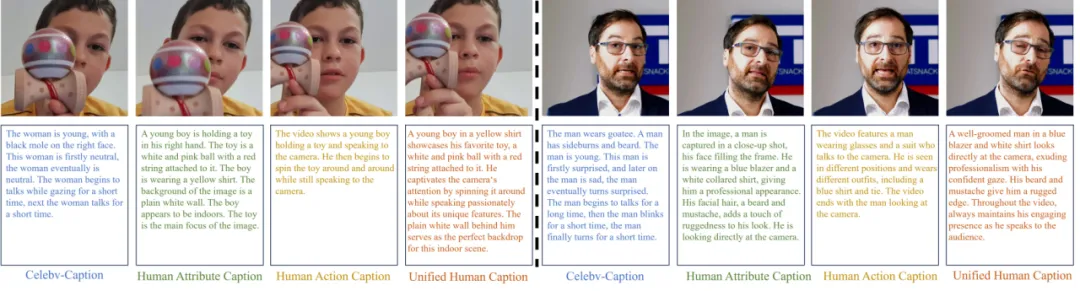

為了應對以 ID 為核心的成對視頻 - 文本數據集在視頻生成領域的稀缺挑戰,研究者們提出了一套巧妙的數據集重構策略。他們利用現有的 Celebv-HQ 數據集,將其重構為以 ID 為中心的人類視頻數據集。這一策略分為兩個主要步驟:文本重寫和面部圖像資源庫構建。

現有的 Celebv 數據集的文本描述采用固定模板,主要關注人物表情的變化,卻忽略了人物屬性與所處環境,同時缺乏對動作的描述,因此不適用于文本生成視頻的訓練。為了解決這一問題,研究者們提出了一種新穎的文本重寫方法,旨在生成更貼切的人類視頻描述文本。考慮到視頻整體特征和人物靜態屬性,他們采用了一種解耦式的文本重寫方法,分別描述人物屬性和環境,生成人類屬性描述;同時描述視頻中人物的整體動作,生成動作描述。最后,借助大型語言模型將兩種描述整合,生成連貫且豐富的全新文本。

如圖所示,重寫后的文本描述更接近人類的語言風格,并能更好地描述人物的運動和屬性。這一創新性方法為視頻生成領域提供了一個更實用、更高質量的數據集基礎。

為了進一步提升生成視頻的身份保持能力,研究者們引入了一種隨機面部提取技術。這種技術的特點在于,它并不直接采用整個視頻幀作為生參考圖像,而是構建數據集時專門針對人臉區域進行隨機采樣,從而形成一個獨立的面部圖像資源庫。這一策略有效地過濾了大量非身份決定性的視覺信息,如背景變化、衣著裝飾等,使得生成模型能夠更加專注于學習和重現個體的面部特征與表情細節。

隨機參考人臉訓練方法

利用數據集面部資源庫,研究者們提出了一種隨機參考人臉的訓練方法。這種方法的核心在于利用與視頻內容弱相關的參考圖像作為條件輸入,引導模型在生成視頻內容時,更多地關注指令指導的動作和 ID 無關特征。

具體操作上,研究者們從人臉資源庫中隨機選取參考圖像,使得每次訓練迭代都能為模型提供一個新的、與目標視頻序列關聯較弱的面部圖像作為參考。這種方法實現了視頻內容與人臉參考圖像的解耦,有助于模型更好地學習和生成符合指令的動作,同時減弱與身份無關的特征的影響。

實驗結果

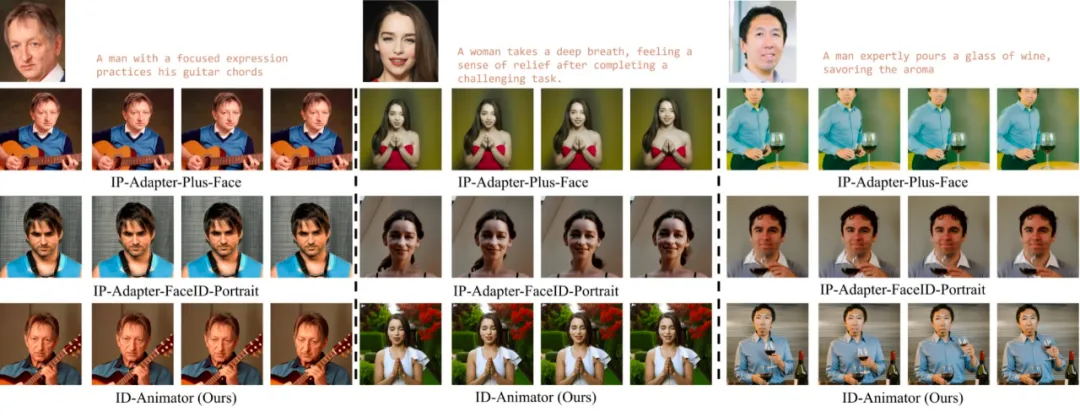

與 IP-Adapter 對比

研究者們首先將 ID-Animator 與常用的零樣本定制化圖像生成模型 IP-Adapter 的變體進行對比。將零樣本定制化圖像生成模型直接應用于視頻生成時,可能會導致指令跟隨能力和 ID 一致性的降低。為了證明 ID-Animator 的優越性能,研究者們展示了在 3 個名人和普通人上的對比結果。

如圖所示,ID-Animator 在視頻場景下展現出了更強大的指令跟隨能力和 ID 保真度。

應用展示

- 上下文重塑:ID-Animator 能夠利用文本引導,動態調整角色的多維度屬性,包括發型、服飾、性別,執行特定的動作和改變角色所處環境等。

- ID 特征融合: ID-Animator 能夠將不同身份的特征以不同比例混合,從而生成結合兩種身份特征的視頻。

- 與 ControlNet 結合:ID-Animator 具有與 ControlNet 等現有細粒度條件模塊的兼容性,這意味著用戶能通過上傳特定的引導圖像或圖像序列,精確指引視頻中每一幀的生成細節。

- 社區模型推理:ID-Animator 能夠和 Civitai 社區的多種模型兼容,即使在未曾訓練過的模型權重上也能保持有效性,能夠生成多種風格的視頻。

更多詳細內容,請閱讀原論文。

本文轉自 機器之心 ,作者:機器之心