Search-R1:強(qiáng)化學(xué)習(xí)增強(qiáng)大語(yǔ)言模型推理+搜索能力

研究背景是大語(yǔ)言模型雖然厲害,但在做復(fù)雜推理和獲取最新信息時(shí)不太給力。現(xiàn)有的和搜索引擎結(jié)合的方法,像檢索增強(qiáng)生成和把搜索引擎當(dāng)工具用,都有各自的問(wèn)題。重要意義在于提出的SEARCH - R1框架能讓大語(yǔ)言模型在推理的時(shí)候更好地利用搜索引擎,提高解決復(fù)雜問(wèn)題的能力,而且還對(duì)相關(guān)訓(xùn)練策略有新的發(fā)現(xiàn),對(duì)大語(yǔ)言模型的發(fā)展有很大幫助。

文章針對(duì)大語(yǔ)言模型(LLMs)在復(fù)雜推理和獲取外部最新信息方面的不足,提出SEARCH - R1強(qiáng)化學(xué)習(xí)框架。該框架將搜索引擎融入大語(yǔ)言模型的推理過(guò)程,通過(guò)多輪搜索交互優(yōu)化模型輸出,采用檢索令牌掩碼穩(wěn)定訓(xùn)練,并設(shè)計(jì)簡(jiǎn)單有效的結(jié)果獎(jiǎng)勵(lì)函數(shù)。在七個(gè)問(wèn)答數(shù)據(jù)集上的實(shí)驗(yàn)顯示,與基線模型相比,SEARCH - R1使用不同大語(yǔ)言模型時(shí)性能均有顯著提升。同時(shí),文章還對(duì)強(qiáng)化學(xué)習(xí)方法、模型選擇和響應(yīng)長(zhǎng)度等方面進(jìn)行了分析,為搜索增強(qiáng)推理的強(qiáng)化學(xué)習(xí)訓(xùn)練策略提供了見(jiàn)解 。

摘要&解讀

高效獲取外部知識(shí)和最新信息對(duì)于大語(yǔ)言模型(LLMs)進(jìn)行有效的推理和文本生成至關(guān)重要。將搜索引擎視為工具的檢索增強(qiáng)和工具使用訓(xùn)練方法,缺乏復(fù)雜的多輪檢索靈活性,或者需要大規(guī)模的監(jiān)督數(shù)據(jù)。在推理過(guò)程中,促使具有推理能力的先進(jìn)大語(yǔ)言模型使用搜索引擎也并非最優(yōu)選擇,因?yàn)榇笳Z(yǔ)言模型并未學(xué)會(huì)如何以最優(yōu)方式與搜索引擎進(jìn)行交互。本文介紹了SEARCH - R1,這是DeepSeek - R1模型的擴(kuò)展,其中大語(yǔ)言模型僅通過(guò)強(qiáng)化學(xué)習(xí)(RL),在逐步推理過(guò)程中自主生成(多個(gè))搜索查詢,并進(jìn)行實(shí)時(shí)檢索。SEARCH - R1通過(guò)多輪搜索交互優(yōu)化大語(yǔ)言模型的滾動(dòng)輸出,利用檢索到的令牌掩碼來(lái)穩(wěn)定強(qiáng)化學(xué)習(xí)訓(xùn)練,并使用基于簡(jiǎn)單結(jié)果的獎(jiǎng)勵(lì)函數(shù)。在七個(gè)問(wèn)答數(shù)據(jù)集上的實(shí)驗(yàn)表明,與最先進(jìn)的基線模型相比,SEARCH - R1使性能提高了26%(Qwen2.5 - 7B)、21%(Qwen2.5 - 3B)和10%(LLaMA3.2 - 3B)。本文進(jìn)一步對(duì)強(qiáng)化學(xué)習(xí)優(yōu)化方法、大語(yǔ)言模型的選擇以及檢索增強(qiáng)推理中的響應(yīng)長(zhǎng)度動(dòng)態(tài)提供了實(shí)證見(jiàn)解。代碼和模型檢查點(diǎn)可在https://github.com/PeterGriffinJin/Search - R1獲取。

?研究背景:大語(yǔ)言模型在自然語(yǔ)言處理領(lǐng)域取得顯著成果,但在復(fù)雜推理和獲取外部最新信息方面存在不足。現(xiàn)有整合搜索引擎的方法,如檢索增強(qiáng)生成和將搜索引擎視為工具,存在檢索不準(zhǔn)確、缺乏多輪檢索靈活性或依賴大規(guī)模監(jiān)督數(shù)據(jù)等問(wèn)題。強(qiáng)化學(xué)習(xí)雖已用于提升大語(yǔ)言模型推理能力,但在搜索與推理場(chǎng)景的應(yīng)用面臨框架和穩(wěn)定性、多輪交錯(cuò)推理和搜索、獎(jiǎng)勵(lì)設(shè)計(jì)等挑戰(zhàn)。

?創(chuàng)新貢獻(xiàn):提出SEARCH - R1強(qiáng)化學(xué)習(xí)框架,將搜索引擎建模為環(huán)境一部分,支持大語(yǔ)言模型滾動(dòng)輸出和強(qiáng)化學(xué)習(xí)優(yōu)化;引入檢索令牌掩碼穩(wěn)定訓(xùn)練,實(shí)現(xiàn)多輪交錯(cuò)推理和搜索以處理復(fù)雜任務(wù);設(shè)計(jì)簡(jiǎn)單有效的基于結(jié)果的獎(jiǎng)勵(lì)函數(shù)。實(shí)驗(yàn)證明SEARCH - R1能顯著提升大語(yǔ)言模型在復(fù)雜推理任務(wù)中的性能,且在不同基礎(chǔ)大語(yǔ)言模型上具有通用性,并對(duì)強(qiáng)化學(xué)習(xí)訓(xùn)練策略提供見(jiàn)解。

?實(shí)現(xiàn)設(shè)計(jì):

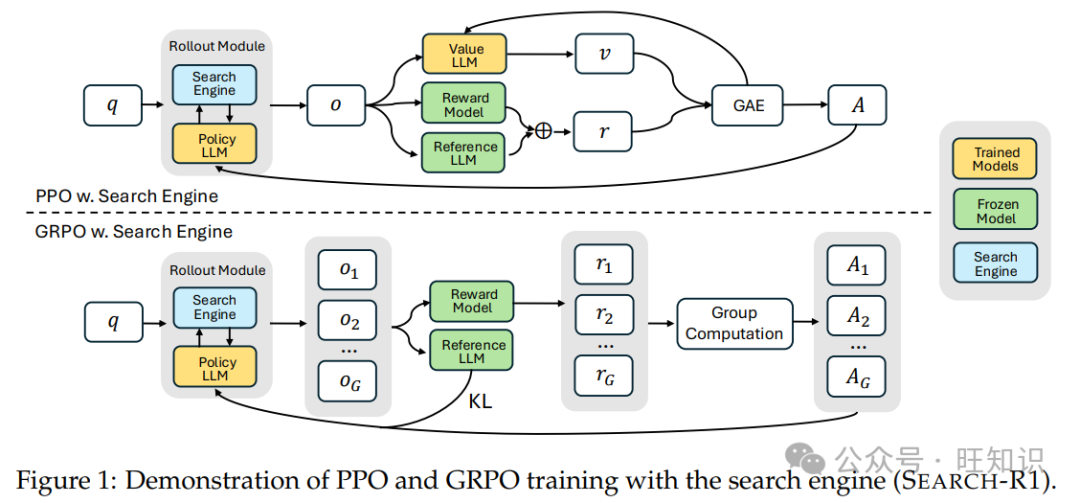

結(jié)合搜索引擎的強(qiáng)化學(xué)習(xí):基于近端策略優(yōu)化(PPO)和組相對(duì)策略優(yōu)化(GRPO),通過(guò)引入檢索交錯(cuò)推理和檢索令牌掩碼,優(yōu)化大語(yǔ)言模型在搜索與推理任務(wù)中的決策。

交錯(cuò)多輪調(diào)用搜索引擎的文本生成:大語(yǔ)言模型在文本生成和搜索引擎查詢間交替,用特定令牌標(biāo)識(shí)搜索查詢、檢索結(jié)果和推理步驟,實(shí)現(xiàn)結(jié)構(gòu)化迭代決策。

訓(xùn)練模板:設(shè)計(jì)簡(jiǎn)單模板引導(dǎo)大語(yǔ)言模型按推理、搜索、回答的結(jié)構(gòu)輸出,避免內(nèi)容偏差,保證模型學(xué)習(xí)動(dòng)態(tài)的可觀察性和無(wú)偏差性。

獎(jiǎng)勵(lì)建模:采用基于規(guī)則的結(jié)果獎(jiǎng)勵(lì)系統(tǒng),以精確字符串匹配等方式評(píng)估模型響應(yīng)正確性,避免復(fù)雜格式獎(jiǎng)勵(lì)和神經(jīng)獎(jiǎng)勵(lì)模型帶來(lái)的問(wèn)題。

?實(shí)驗(yàn)結(jié)果:在七個(gè)問(wèn)答數(shù)據(jù)集上對(duì)SEARCH - R1進(jìn)行評(píng)估,與多種基線方法對(duì)比。結(jié)果顯示,SEARCH - R1在使用Qwen2.5 - 7B、Qwen2.5 - 3B和LLaMA3.2 - 3B模型時(shí),平均相對(duì)提升分別為26%、21%和10%,在域內(nèi)和域外評(píng)估中均表現(xiàn)出色。不同強(qiáng)化學(xué)習(xí)方法中,GRPO收斂快但在部分模型上不穩(wěn)定,PPO更穩(wěn)定,二者最終獎(jiǎng)勵(lì)相當(dāng)且GRPO整體性能更優(yōu)。指令調(diào)整模型收斂更快,基礎(chǔ)模型和指令調(diào)整模型最終性能相似。對(duì)響應(yīng)長(zhǎng)度和檢索令牌損失掩碼的研究也得到相應(yīng)結(jié)論,案例研究展示了SEARCH - R1在推理和自我驗(yàn)證方面的優(yōu)勢(shì)。

1.引言

近年來(lái),大語(yǔ)言模型(LLMs)在自然語(yǔ)言理解和生成方面展現(xiàn)出了卓越的能力(Hendrycks等人,2020;Clark等人,2018)。盡管取得了這些成就,但大語(yǔ)言模型在處理復(fù)雜推理(Wei等人,2022)以及從外部來(lái)源檢索最新信息(Jin等人,2024)時(shí),常常會(huì)遇到挑戰(zhàn)。為了解決這些限制,有必要整合先進(jìn)的推理能力(Huang和Chang,2022)以及與搜索引擎有效交互的能力(Schick等人,2023)。

現(xiàn)有的將大語(yǔ)言模型與搜索引擎整合的方法通常分為兩類:(1)檢索增強(qiáng)生成(RAG)(Gao等人,2023;Lewis等人,2020)和(2)將搜索引擎視為工具(Yao等人,2023;Schick等人,2023)。檢索增強(qiáng)生成(RAG)根據(jù)輸入查詢檢索相關(guān)段落,并將其整合到大語(yǔ)言模型的上下文以進(jìn)行生成(Lewis等人,2020)。這使得大語(yǔ)言模型在回答問(wèn)題時(shí)能夠利用外部知識(shí)。然而,檢索增強(qiáng)生成(RAG)受到檢索不準(zhǔn)確的限制(Jin等人,2024),并且缺乏多輪、多查詢檢索的靈活性,而這對(duì)于復(fù)雜推理任務(wù)至關(guān)重要(Yang等人,2018)。另外,大語(yǔ)言模型可以在推理過(guò)程中被促使或訓(xùn)練去使用包括搜索引擎在內(nèi)的工具(Qu等人,2025;Trivedi等人,2022a)。然而,基于提示的方法通常在泛化方面存在困難,因?yàn)槟承┤蝿?wù)可能在大語(yǔ)言模型預(yù)訓(xùn)練期間未遇到過(guò)。另一方面,基于訓(xùn)練的方法具有更強(qiáng)的適應(yīng)性,但依賴于大規(guī)模、高質(zhì)量的搜索與推理交互的帶注釋軌跡,這使得它們難以有效擴(kuò)展(Schick等人,2023)。

強(qiáng)化學(xué)習(xí)(RL)(Sutton等人,1999;Kaelbling等人,1996)已成為增強(qiáng)大語(yǔ)言模型推理能力的有力范式(Guo等人,2025;Hou等人,2025;Xie等人,2025;Kumar等人,2024)。值得注意的是,像OpenAI - o1(Jaech等人,2024)和DeepSeek - R1(Guo等人,2025)這樣的模型已經(jīng)利用強(qiáng)化學(xué)習(xí)技術(shù)(例如近端策略優(yōu)化(PPO)(Schulman等人,2017)和組相對(duì)策略優(yōu)化(GRPO)(Shao等人,2024)),通過(guò)從經(jīng)驗(yàn)和反饋中學(xué)習(xí)來(lái)提高邏輯推理和問(wèn)題解決能力。經(jīng)過(guò)強(qiáng)化學(xué)習(xí)后,即使僅在結(jié)果獎(jiǎng)勵(lì)上進(jìn)行訓(xùn)練,模型也能學(xué)習(xí)到復(fù)雜的推理能力,包括自我驗(yàn)證(Weng等人,2022)和自我修正(Kumar等人,2024)。

然而,將強(qiáng)化學(xué)習(xí)應(yīng)用于搜索與推理場(chǎng)景存在三個(gè)關(guān)鍵挑戰(zhàn):(1)強(qiáng)化學(xué)習(xí)框架和穩(wěn)定性——目前尚不清楚如何在確保穩(wěn)定優(yōu)化的同時(shí),有效地將搜索引擎整合到大語(yǔ)言模型強(qiáng)化學(xué)習(xí)框架中,特別是在整合檢索到的上下文時(shí)。(2)多輪交錯(cuò)推理和搜索——理想情況下,大語(yǔ)言模型應(yīng)該能夠進(jìn)行迭代推理和調(diào)用搜索引擎,根據(jù)問(wèn)題的復(fù)雜性動(dòng)態(tài)調(diào)整其檢索策略。(3)獎(jiǎng)勵(lì)設(shè)計(jì)——為搜索與推理任務(wù)設(shè)計(jì)一個(gè)有效的獎(jiǎng)勵(lì)函數(shù)并非易事,因?yàn)閭鹘y(tǒng)的獎(jiǎng)勵(lì)公式可能無(wú)法很好地適用于這一新范式。

為了解決這些挑戰(zhàn),我們引入了SEARCH - R1,這是一種新穎的強(qiáng)化學(xué)習(xí)框架,使大語(yǔ)言模型能夠在自身推理過(guò)程中與搜索引擎進(jìn)行交錯(cuò)交互。具體而言,SEARCH - R1引入了以下關(guān)鍵創(chuàng)新:(1)我們將搜索引擎建模為環(huán)境的一部分,實(shí)現(xiàn)了將大語(yǔ)言模型令牌生成與搜索引擎檢索交錯(cuò)進(jìn)行的滾動(dòng)輸出序列。SEARCH - R1與各種強(qiáng)化學(xué)習(xí)算法兼容,包括近端策略優(yōu)化(PPO)和組相對(duì)策略優(yōu)化(GRPO),并且我們應(yīng)用檢索到的令牌掩碼來(lái)確保穩(wěn)定的優(yōu)化。(2)SEARCH - R1支持多輪檢索和推理,其中搜索調(diào)用由??<search>???和??</search>???令牌明確觸發(fā)。檢索到的內(nèi)容包含在??<information>???和??</information>???令牌內(nèi),而大語(yǔ)言模型的推理步驟則包含在??<think>???和??</think>???令牌內(nèi)。最終答案使用??<answer>???和??</answer>??令牌進(jìn)行格式化,從而實(shí)現(xiàn)結(jié)構(gòu)化的迭代決策。(3)我們采用簡(jiǎn)單的基于結(jié)果的獎(jiǎng)勵(lì)函數(shù),避免了基于過(guò)程的獎(jiǎng)勵(lì)的復(fù)雜性。我們的結(jié)果表明,這種極簡(jiǎn)的獎(jiǎng)勵(lì)設(shè)計(jì)在搜索與推理場(chǎng)景中是有效的。SEARCH - R1可以看作是DeepSeek - R1(Guo等人,2025)的擴(kuò)展,后者主要側(cè)重于參數(shù)推理,而SEARCH - R1通過(guò)引入搜索增強(qiáng)的強(qiáng)化學(xué)習(xí)訓(xùn)練,來(lái)增強(qiáng)檢索驅(qū)動(dòng)的決策能力。總之,我們的主要貢獻(xiàn)有三點(diǎn):

- ? 我們明確了將強(qiáng)化學(xué)習(xí)應(yīng)用于大語(yǔ)言模型調(diào)用搜索引擎進(jìn)行推理時(shí)所面臨的挑戰(zhàn)。

- ? 我們提出了SEARCH - R1,這是一種新穎的強(qiáng)化學(xué)習(xí)框架,支持大語(yǔ)言模型的滾動(dòng)輸出和與搜索引擎的強(qiáng)化學(xué)習(xí)優(yōu)化,包括使用檢索到的令牌掩碼來(lái)穩(wěn)定強(qiáng)化學(xué)習(xí)訓(xùn)練、多輪交錯(cuò)推理和搜索以支持復(fù)雜任務(wù)的解決,以及一個(gè)簡(jiǎn)單而有效的結(jié)果獎(jiǎng)勵(lì)函數(shù)。

- ? 我們進(jìn)行了系統(tǒng)的實(shí)驗(yàn),證明了SEARCH - R1的有效性,在使用三種大語(yǔ)言模型時(shí),相較于最先進(jìn)的基線模型,平均相對(duì)提升分別為26%、21%和10%。此外,我們對(duì)用于推理和搜索設(shè)置的強(qiáng)化學(xué)習(xí)提供了見(jiàn)解,包括強(qiáng)化學(xué)習(xí)方法的選擇、不同大語(yǔ)言模型的選擇以及響應(yīng)長(zhǎng)度的研究。

2.相關(guān)工作

2.1 大語(yǔ)言模型與檢索

盡管大語(yǔ)言模型(LLMs)(Zhao等人,2023;團(tuán)隊(duì),2024;Achiam等人,2023)已展示出卓越的推理(Guo等人,2025)和編碼(Guo等人,2024)能力,但它們?nèi)匀蝗狈μ囟I(lǐng)域的知識(shí)(Peng等人,2023;Li等人,2023),并且容易產(chǎn)生幻覺(jué)(Zhang等人,2023)。為了解決這些限制,搜索引擎(Zhao等人,2024)被廣泛用于提供外部信息。將搜索引擎與大語(yǔ)言模型整合主要有兩種方式:(1)檢索增強(qiáng)生成(RAG)(Gao等人,2023)和(2)將搜索引擎視為工具(Schick等人,2023)。檢索增強(qiáng)生成(RAG)(Lewis等人,2020;Yue等人,2024;Xiong等人,2025)通常遵循一輪檢索和順序生成的流程,搜索引擎根據(jù)輸入查詢獲取相關(guān)信息,然后將其與查詢連接并輸入到大語(yǔ)言模型中。然而,這種流程存在諸如檢索到不相關(guān)信息(Jin等人,2024)以及無(wú)法提供足夠有用的上下文(Jiang等人,2023)等問(wèn)題。另一種方法是將搜索作為工具,即促使或微調(diào)大語(yǔ)言模型與搜索引擎進(jìn)行交互。IRCoT(Trivedi等人,2022a)和ReAct(Yao等人,2023)使用提示來(lái)指導(dǎo)迭代推理和搜索引擎調(diào)用,而Toolformer(Schick等人,2023)則利用監(jiān)督微調(diào)來(lái)增強(qiáng)搜索能力。然而,這些方法依賴于高質(zhì)量的帶標(biāo)簽軌跡,難以擴(kuò)展。最近的研究(Guo等人,2025)表明,強(qiáng)化學(xué)習(xí)可以使大語(yǔ)言模型僅使用結(jié)果獎(jiǎng)勵(lì)就開(kāi)發(fā)出先進(jìn)的推理技能,但其在調(diào)用搜索引擎場(chǎng)景中的潛力仍有待探索。

2.2 大語(yǔ)言模型與強(qiáng)化學(xué)習(xí)

強(qiáng)化學(xué)習(xí)(RL)(Kaelbling等人,1996)是一種學(xué)習(xí)范式,智能體通過(guò)與環(huán)境交互并以獎(jiǎng)勵(lì)的形式接收反饋來(lái)學(xué)習(xí)進(jìn)行順序決策,旨在最大化隨時(shí)間累積的獎(jiǎng)勵(lì)(Sutton等人,1999)。Ouyang等人(2022)通過(guò)人類反饋強(qiáng)化學(xué)習(xí)(RLHF)(Kaufmann等人,2023)將強(qiáng)化學(xué)習(xí)引入大語(yǔ)言模型的微調(diào)。這種方法首先使用人類偏好數(shù)據(jù)訓(xùn)練一個(gè)獎(jiǎng)勵(lì)模型(Lambert等人,2024),然后通常通過(guò)近端策略優(yōu)化(PPO)算法指導(dǎo)基于強(qiáng)化學(xué)習(xí)的策略大語(yǔ)言模型的微調(diào)。然而,近端策略優(yōu)化(PPO)涉及多輪大語(yǔ)言模型優(yōu)化,實(shí)施起來(lái)具有挑戰(zhàn)性。為了簡(jiǎn)化基于強(qiáng)化學(xué)習(xí)的微調(diào),已經(jīng)提出了直接優(yōu)化方法,如直接偏好優(yōu)化(DPO)(Rafailov等人,2023)和SimPO(Meng等人,2024)。雖然這些方法提供了計(jì)算效率,但它們存在離策略問(wèn)題(Pang等人,2024),并且性能并不總是能與純強(qiáng)化學(xué)習(xí)方法相媲美。其他替代解決方案包括組相對(duì)策略優(yōu)化(GRPO)(Shao等人,2024),它通過(guò)從組分?jǐn)?shù)估計(jì)基線來(lái)消除對(duì)評(píng)論家模型的需求,以及RLOO(Ahmadian等人,2024),它引入了一種簡(jiǎn)化的REINFORCE風(fēng)格(Williams,1992)優(yōu)化框架。盡管取得了這些進(jìn)展,但強(qiáng)化學(xué)習(xí)在大語(yǔ)言模型驅(qū)動(dòng)的搜索引擎交互和推理中的應(yīng)用在很大程度上仍未得到探索。

3.Search-R1

在以下部分,我們將介紹SEARCH - R1的詳細(xì)設(shè)計(jì),包括:(1)結(jié)合搜索引擎的強(qiáng)化學(xué)習(xí);(2)交錯(cuò)多輪調(diào)用搜索引擎的文本生成;(3)訓(xùn)練模板;(4)獎(jiǎng)勵(lì)模型設(shè)計(jì)。

3.1 結(jié)合搜索引擎的強(qiáng)化學(xué)習(xí)

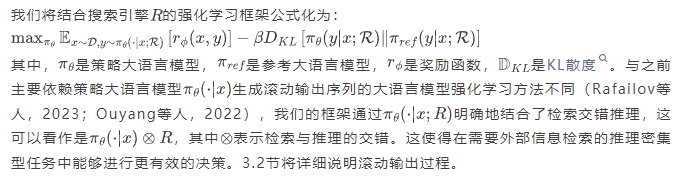

我們的方法基于兩種成熟的策略梯度強(qiáng)化學(xué)習(xí)方法:近端策略優(yōu)化(PPO)(Schulman等人,2017)和組相對(duì)策略優(yōu)化(GRPO)(Shao等人,2024;Guo等人,2025),利用它們各自的優(yōu)勢(shì)來(lái)優(yōu)化檢索增強(qiáng)推理。

檢索令牌的損失掩碼

在近端策略優(yōu)化(PPO)和組相對(duì)策略優(yōu)化(GRPO)中,令牌級(jí)損失是在整個(gè)滾動(dòng)輸出序列上計(jì)算的。在SEARCH - R1中,滾動(dòng)輸出序列既包含大語(yǔ)言模型生成的令牌,也包含從外部文本中檢索到的令牌。雖然優(yōu)化大語(yǔ)言模型生成的令牌可以增強(qiáng)模型與搜索引擎交互和進(jìn)行推理的能力,但對(duì)檢索到的令牌應(yīng)用相同的優(yōu)化可能會(huì)導(dǎo)致意外的學(xué)習(xí)動(dòng)態(tài)。為了解決這個(gè)問(wèn)題,我們引入了檢索令牌的損失掩碼,確保策略梯度目標(biāo)僅在大語(yǔ)言模型生成的令牌上計(jì)算,同時(shí)將檢索到的內(nèi)容排除在優(yōu)化過(guò)程之外。這種方法在保持搜索增強(qiáng)生成靈活性的同時(shí),穩(wěn)定了訓(xùn)練。

PPO+搜索引擎

近端策略優(yōu)化(PPO)(Schulman等人,2017)是一種流行的演員 - 評(píng)論家強(qiáng)化學(xué)習(xí)算法,通常用于在強(qiáng)化學(xué)習(xí)階段對(duì)大語(yǔ)言模型(LLMs)進(jìn)行微調(diào)(Ouyang等人,2022)。在我們的推理加搜索引擎調(diào)用場(chǎng)景中,它通過(guò)最大化以下目標(biāo)來(lái)優(yōu)化大語(yǔ)言模型:

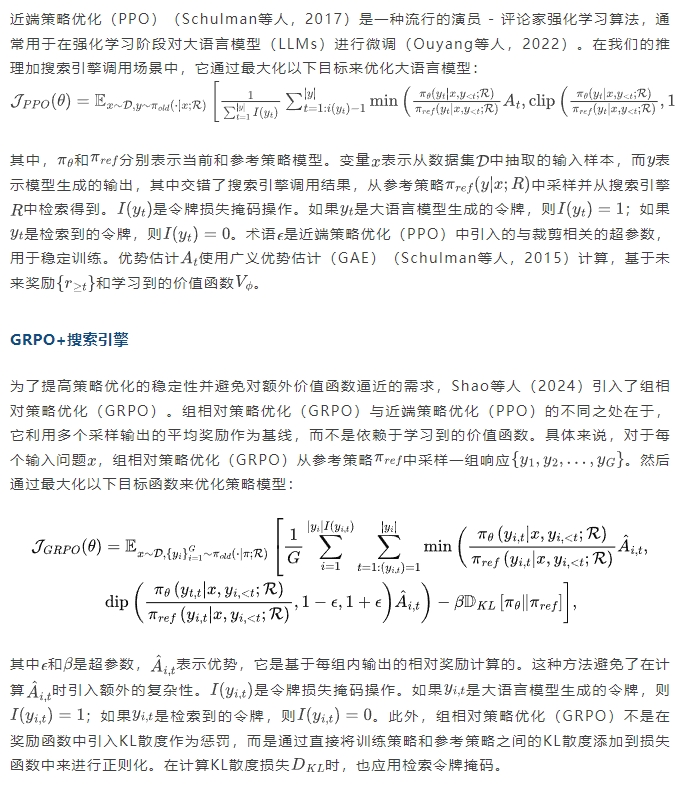

3.2 交錯(cuò)多輪調(diào)用搜索引擎的文本生成

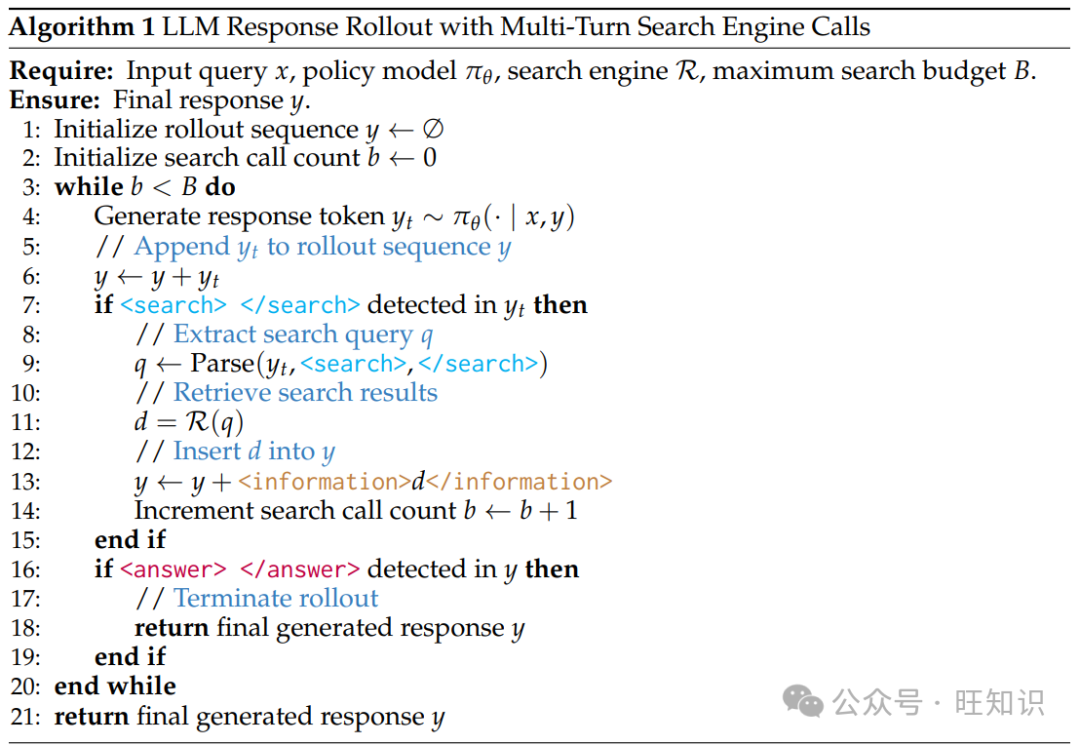

我們的方法遵循迭代框架,大語(yǔ)言模型在文本生成和外部搜索引擎查詢之間交替進(jìn)行。具體來(lái)說(shuō),每當(dāng)需要外部檢索時(shí),系統(tǒng)指令會(huì)引導(dǎo)大語(yǔ)言模型在兩個(gè)指定的搜索調(diào)用令牌??<search>???和??</search>???之間封裝其搜索查詢。系統(tǒng)在生成的序列中檢測(cè)到這些令牌后,會(huì)提取搜索查詢,查詢搜索引擎,并檢索相關(guān)結(jié)果。檢索到的信息隨后被封裝在特殊的檢索令牌??<information>???和??</information>???內(nèi),并附加到正在進(jìn)行的展開(kāi)序列中,作為下一個(gè)生成步驟的額外上下文。這個(gè)過(guò)程會(huì)迭代繼續(xù),直到滿足以下條件之一:(1)搜索引擎調(diào)用預(yù)算耗盡;(2)模型生成最終響應(yīng),該響應(yīng)被封裝在指定的答案令牌??<answer>???和??</answer>??之間。完整的工作流程如算法1所示。

3.3 訓(xùn)練模板

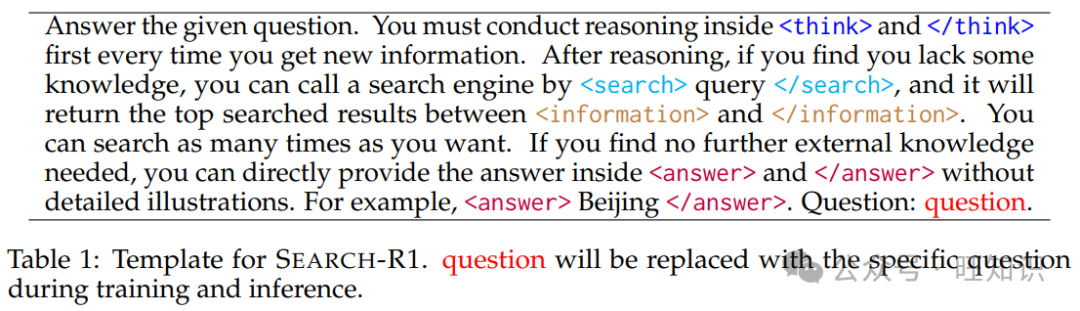

為了訓(xùn)練SEARCH - R1,我們首先創(chuàng)建一個(gè)簡(jiǎn)單的模板,指導(dǎo)初始大語(yǔ)言模型遵循我們預(yù)定義的指令。如表1所示,這個(gè)模板以迭代的方式將模型的輸出結(jié)構(gòu)化為三個(gè)部分:首先是推理過(guò)程,然后是搜索引擎調(diào)用函數(shù),最后是答案。我們特意將約束限制在這種結(jié)構(gòu)格式上,避免任何特定內(nèi)容的偏差,例如強(qiáng)制進(jìn)行反思性推理和搜索引擎調(diào)用,或者支持特定的問(wèn)題解決方法。這確保了在強(qiáng)化學(xué)習(xí)過(guò)程中,模型的自然學(xué)習(xí)動(dòng)態(tài)保持可觀察且無(wú)偏差。

回答給定的問(wèn)題。每次獲得新信息時(shí),你必須首先在??<think>???和??</think>???內(nèi)進(jìn)行推理。推理之后,如果你發(fā)現(xiàn)自己缺少某些知識(shí),可以通過(guò)??<search>查詢</search>???調(diào)用搜索引擎,它將在??<information>???和??</information>???之間返回搜索到的頂級(jí)結(jié)果。你可以根據(jù)需要多次進(jìn)行搜索。如果你認(rèn)為不再需要外部知識(shí),可以直接在??<answer>???和??</answer>???內(nèi)給出答案,無(wú)需詳細(xì)說(shuō)明。例如,??<answer>北京</answer>??。問(wèn)題:[具體問(wèn)題]

表1:SEARCH - R1的模板。在訓(xùn)練和推理過(guò)程中,“問(wèn)題”將被具體問(wèn)題替換。

3.4 獎(jiǎng)勵(lì)建模

獎(jiǎng)勵(lì)函數(shù)是強(qiáng)化學(xué)習(xí)中指導(dǎo)優(yōu)化過(guò)程的主要訓(xùn)練信號(hào)。為了訓(xùn)練SEARCH - R1,我們采用基于規(guī)則的獎(jiǎng)勵(lì)系統(tǒng),該系統(tǒng)僅由最終結(jié)果獎(jiǎng)勵(lì)組成,用于評(píng)估模型響應(yīng)的正確性。例如,在事實(shí)推理任務(wù)中,可以使用基于規(guī)則的標(biāo)準(zhǔn)(如精確字符串匹配)來(lái)評(píng)估正確性。其中是從響應(yīng)中提取的最終答案,是真實(shí)答案。與Guo等人(2025)不同,我們不納入格式獎(jiǎng)勵(lì),因?yàn)槲覀冇?xùn)練的模型已經(jīng)表現(xiàn)出很強(qiáng)的結(jié)構(gòu)遵循性。我們將更復(fù)雜格式獎(jiǎng)勵(lì)的探索留作未來(lái)工作。此外,我們有意避免訓(xùn)練用于結(jié)果或過(guò)程評(píng)估的神經(jīng)獎(jiǎng)勵(lì)模型,這與Guo等人(2025)的做法一致。做出這一決定的原因是,在大規(guī)模強(qiáng)化學(xué)習(xí)中,神經(jīng)獎(jiǎng)勵(lì)模型容易受到獎(jiǎng)勵(lì)作弊的影響,同時(shí)重新訓(xùn)練這些模型會(huì)帶來(lái)額外的計(jì)算成本和復(fù)雜性。

4 主要結(jié)果

4.1 數(shù)據(jù)集

我們?cè)谄邆€(gè)基準(zhǔn)數(shù)據(jù)集上評(píng)估SEARCH - R1,這些數(shù)據(jù)集分類如下:

?通用問(wèn)答:自然問(wèn)題(NQ)(Kwiatkowski等人,2019)、瑣事問(wèn)答(TriviaQA)(Joshi等人,2017)和流行文化問(wèn)答(PopQA)(Mallen等人,2022)。

?多跳問(wèn)答:火鍋問(wèn)答(HotpotQA)(Yang等人,2018)、2維基多跳問(wèn)答(2WikiMultiHopQA)(Ho等人,2020)、音樂(lè)問(wèn)答(Musique)(Trivedi等人,2022b)和Bamboogle(Press等人,2022)。

這些數(shù)據(jù)集涵蓋了各種搜索與推理挑戰(zhàn),能夠在單輪和多跳檢索場(chǎng)景中全面評(píng)估SEARCH - R1。

4.2 基線

為了評(píng)估SEARCH - R1的有效性,我們將其與以下基線方法進(jìn)行比較:

?無(wú)檢索推理:直接推理和思維鏈(CoT)推理(Wei等人,2022)。

?有檢索推理:檢索增強(qiáng)生成(RAG)(Lewis等人,2020)、IRCoT(Trivedi等人,2022a)和Search - o1(Li等人,2025)。

?基于微調(diào)的方法:監(jiān)督微調(diào)(SFT)(Chung等人,2024)和基于強(qiáng)化學(xué)習(xí)但不使用搜索引擎的微調(diào)(R1)(Guo等人,2025)。

這些基線涵蓋了廣泛的檢索增強(qiáng)和微調(diào)方法,能夠在零樣本和學(xué)習(xí)檢索設(shè)置中全面評(píng)估SEARCH - R1。為了在不同方法之間進(jìn)行公平比較,我們使用相同的檢索器、知識(shí)語(yǔ)料庫(kù)、訓(xùn)練數(shù)據(jù)和大語(yǔ)言模型。更多細(xì)節(jié)見(jiàn)4.3節(jié)。

4.3 實(shí)驗(yàn)設(shè)置

我們使用三種類型的模型進(jìn)行實(shí)驗(yàn):Qwen - 2.5 - 3B(基礎(chǔ)/指令)和Qwen - 2.5 - 7B(基礎(chǔ)/指令)(Yang等人,2024),以及Llama - 3.2 - 3B(基礎(chǔ)/指令)(Dubey等人,2024)。對(duì)于檢索,我們使用2018年的維基百科轉(zhuǎn)儲(chǔ)(Karpukhin等人,2020)作為知識(shí)源,并使用E5(Wang等人,2022)作為檢索器。為確保公平比較,我們遵循Lin等人(2023)的方法,將所有基于檢索的方法中檢索到的段落數(shù)量設(shè)置為三個(gè)。

在訓(xùn)練方面,我們將自然問(wèn)題(NQ)和火鍋問(wèn)答(HotpotQA)的訓(xùn)練集合并,為SEARCH - R1和其他基于微調(diào)的基線方法形成一個(gè)統(tǒng)一的數(shù)據(jù)集。在所有七個(gè)數(shù)據(jù)集的測(cè)試集或驗(yàn)證集上進(jìn)行評(píng)估,以評(píng)估域內(nèi)和域外性能。遵循Yu等人(2024)的方法,使用精確匹配(EM)作為評(píng)估指標(biāo)。對(duì)于推理風(fēng)格的基線方法,我們使用指令模型,因?yàn)榛A(chǔ)模型無(wú)法遵循指令。對(duì)于強(qiáng)化學(xué)習(xí)微調(diào)方法,在基礎(chǔ)模型和指令模型上都進(jìn)行實(shí)驗(yàn)。

在SEARCH - R1訓(xùn)練中,近端策略優(yōu)化(PPO)訓(xùn)練時(shí),策略大語(yǔ)言模型的學(xué)習(xí)率設(shè)置為,價(jià)值大語(yǔ)言模型的學(xué)習(xí)率設(shè)置為。廣義優(yōu)勢(shì)估計(jì)(GAE)參數(shù),。在組相對(duì)策略優(yōu)化(GRPO)訓(xùn)練中,策略大語(yǔ)言模型的學(xué)習(xí)率設(shè)置為,每個(gè)提示采樣五個(gè)響應(yīng)。我們使用精確匹配(EM)計(jì)算結(jié)果獎(jiǎng)勵(lì)。除非另有說(shuō)明,近端策略優(yōu)化(PPO)作為默認(rèn)的強(qiáng)化學(xué)習(xí)方法,5.1節(jié)將提供近端策略優(yōu)化(PPO)和組相對(duì)策略優(yōu)化(GRPO)之間的詳細(xì)比較。

4.4 性能

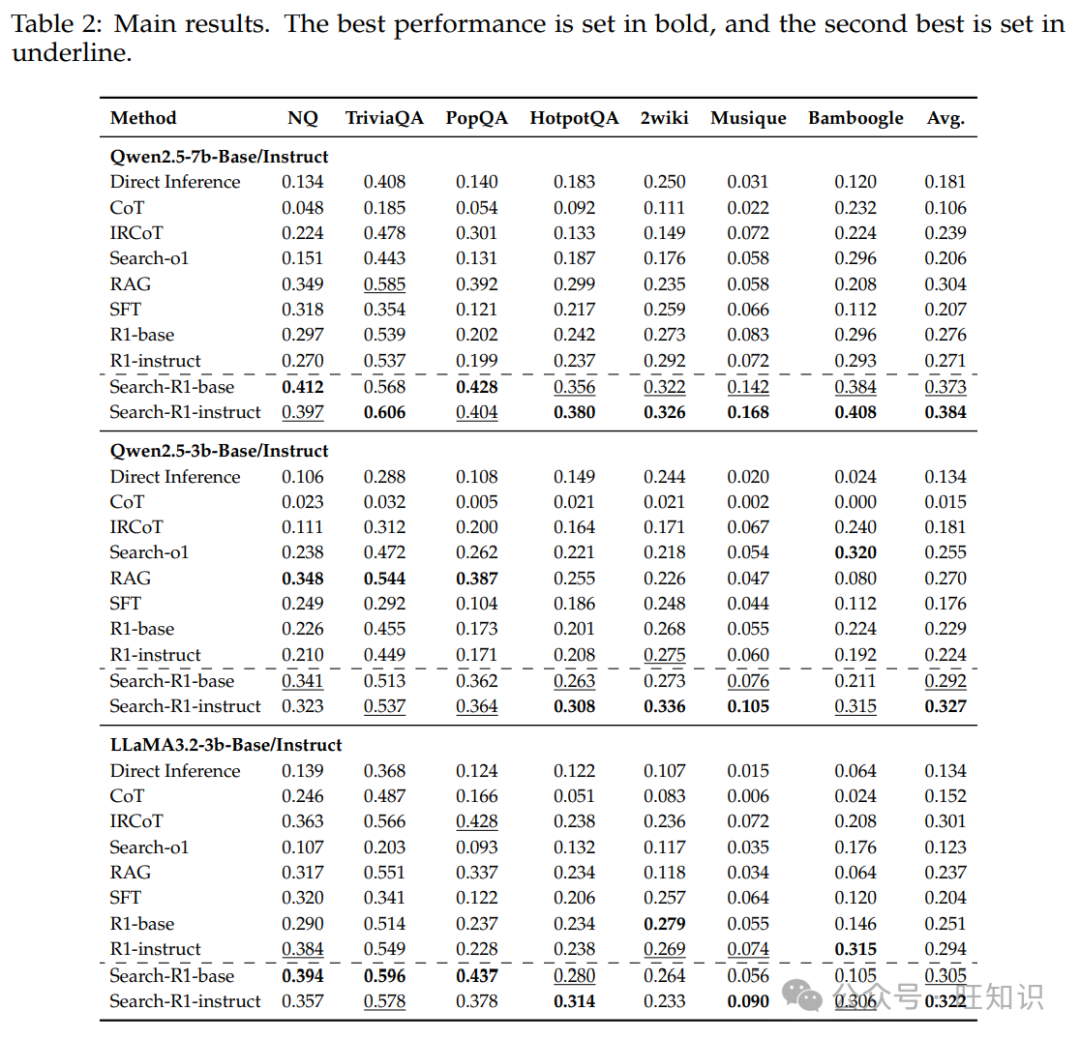

表2展示了在七個(gè)數(shù)據(jù)集上SEARCH - R1與基線方法比較的主要結(jié)果。從結(jié)果中,我們得出以下關(guān)鍵觀察:

? SEARCH - R1始終優(yōu)于強(qiáng)大的基線方法。使用Qwen2.5 - 7B、Qwen2.5 - 3B和LLaMA3.2 - 3B時(shí),我們分別實(shí)現(xiàn)了26%、21%和10%的平均相對(duì)提升。這些提升在分布內(nèi)評(píng)估(即自然問(wèn)題(NQ)和火鍋問(wèn)答(HotpotQA))和分布外評(píng)估(即瑣事問(wèn)答(TriviaQA)、流行文化問(wèn)答(PopQA)、2維基多跳問(wèn)答(2WikiMultiHopQA)、音樂(lè)問(wèn)答(Musique)和Bamboogle)中均成立。

? SEARCH - R1優(yōu)于不進(jìn)行檢索的大語(yǔ)言模型推理的強(qiáng)化學(xué)習(xí)訓(xùn)練方法(R1)(Guo等人,2025)。這符合預(yù)期,因?yàn)閷⑺阉骷{入大語(yǔ)言模型推理可以獲取相關(guān)的外部知識(shí),從而提高整體性能。

? SEARCH - R1對(duì)基礎(chǔ)模型和指令調(diào)整后的模型均有效。這表明,基于結(jié)果獎(jiǎng)勵(lì)的DeepSeek - R1 - Zero風(fēng)格強(qiáng)化學(xué)習(xí)(Guo等人,2025)可以成功應(yīng)用于結(jié)合搜索的推理,擴(kuò)展了其先前在純推理場(chǎng)景中已證實(shí)的有效性。

? SEARCH - R1在不同的基礎(chǔ)大語(yǔ)言模型(包括Qwen2.5和LLaMA3.2)上具有通用性。這與數(shù)學(xué)推理中強(qiáng)化學(xué)習(xí)的研究結(jié)果形成對(duì)比,在數(shù)學(xué)推理中,強(qiáng)化學(xué)習(xí)僅對(duì)某些基礎(chǔ)大語(yǔ)言模型有效(Zeng等人,2025)。我們的結(jié)果表明,搜索增強(qiáng)的強(qiáng)化學(xué)習(xí)在不同模型系列中具有更廣泛的適用性。

5 分析

5.1 不同的強(qiáng)化學(xué)習(xí)方法:PPO與GRPO

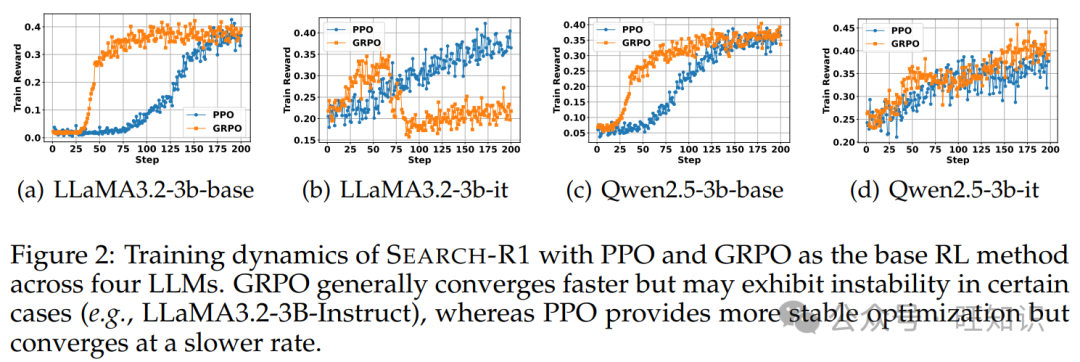

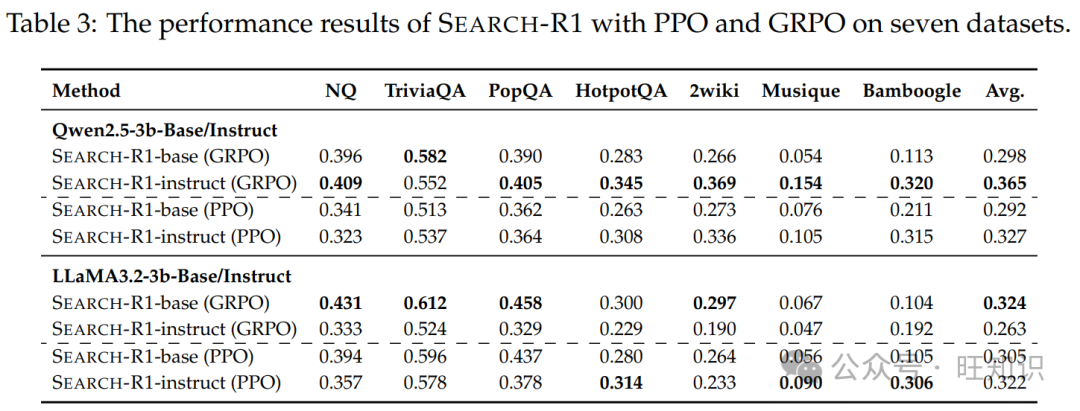

我們使用近端策略優(yōu)化(PPO)和組相對(duì)策略優(yōu)化(GRPO)作為基礎(chǔ)強(qiáng)化學(xué)習(xí)方法對(duì)SEARCH - R1進(jìn)行評(píng)估,并在LLaMA3.2 - 3B和Qwen2.5 - 3B模型上進(jìn)行實(shí)驗(yàn)。圖2展示了訓(xùn)練動(dòng)態(tài)的比較,揭示了以下見(jiàn)解:

? GRPO在所有情況下都比PPO收斂得更快。這是因?yàn)镻PO依賴于評(píng)論家模型,該模型在有效訓(xùn)練開(kāi)始前需要幾個(gè)熱身步驟。

? PPO表現(xiàn)出更高的訓(xùn)練穩(wěn)定性。如圖2(b)所示,當(dāng)應(yīng)用于LLaMA3.2 - 3B - Instruct模型時(shí),GRPO導(dǎo)致獎(jiǎng)勵(lì)崩潰,而PPO在不同的大語(yǔ)言模型架構(gòu)中保持穩(wěn)定。

? PPO和GRPO的最終訓(xùn)練獎(jiǎng)勵(lì)相當(dāng)。盡管收斂速度和穩(wěn)定性存在差異,但兩種方法都實(shí)現(xiàn)了相似的最終獎(jiǎng)勵(lì)值,表明它們都可用于優(yōu)化SEARCH - R1。

評(píng)估結(jié)果如表3所示,揭示了以下關(guān)鍵發(fā)現(xiàn):

? GRPO通常優(yōu)于PPO。在Qwen2.5 - 3B和LLaMA3.2 - 3B上,GRPO均取得了更高的平均性能,證明了其在優(yōu)化檢索增強(qiáng)推理方面的有效性。

? 指令變體的表現(xiàn)優(yōu)于基礎(chǔ)變體。對(duì)于Qwen2.5 - 3B,SEARCH - R1 - Instruct(GRPO)實(shí)現(xiàn)了最高的總體平均得分(0.365),優(yōu)于所有其他配置。對(duì)于LLaMA3.2 - 3B,表現(xiàn)最佳的變體是SEARCH - R1 - Base(GRPO),平均得分0.324,緊隨其后的是SEARCH - R1 - Instruct(PPO),平均得分0.322。

5.2 基礎(chǔ)大語(yǔ)言模型與指令調(diào)整后的大語(yǔ)言模型

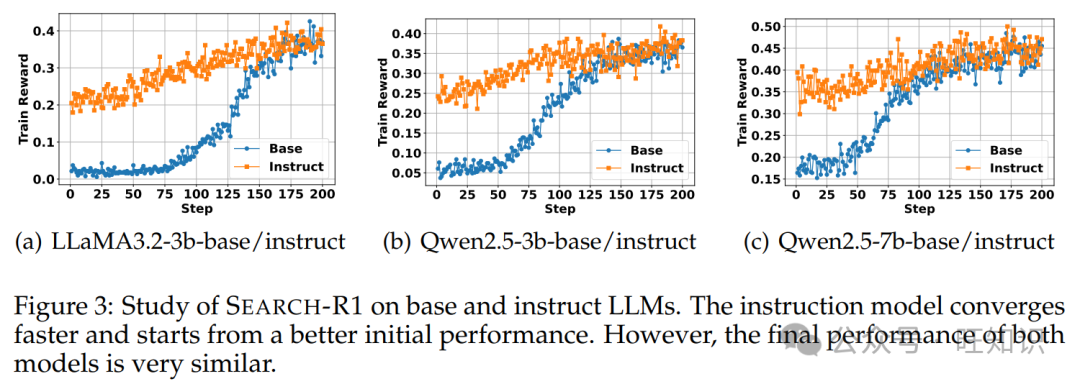

我們分析了SEARCH - R1在基礎(chǔ)大語(yǔ)言模型和指令調(diào)整后的大語(yǔ)言模型上的訓(xùn)練動(dòng)態(tài)。在三個(gè)模型變體(LLaMA3.2 - 3B、Qwen2.5 - 3B和Qwen2.5 - 7B)上進(jìn)行實(shí)驗(yàn)。如圖3所示,我們觀察到指令調(diào)整后的模型比基礎(chǔ)模型收斂得更快,并且初始性能更高。然而,經(jīng)過(guò)訓(xùn)練后,兩種模型類型的最終性能仍然非常相似。這一發(fā)現(xiàn)表明,雖然一般的訓(xùn)練后調(diào)整在推理加搜索場(chǎng)景中加速了學(xué)習(xí),但隨著時(shí)間的推移,強(qiáng)化學(xué)習(xí)可以有效地彌合差距,使基礎(chǔ)模型能夠達(dá)到可比的性能。

5.3 響應(yīng)長(zhǎng)度研究

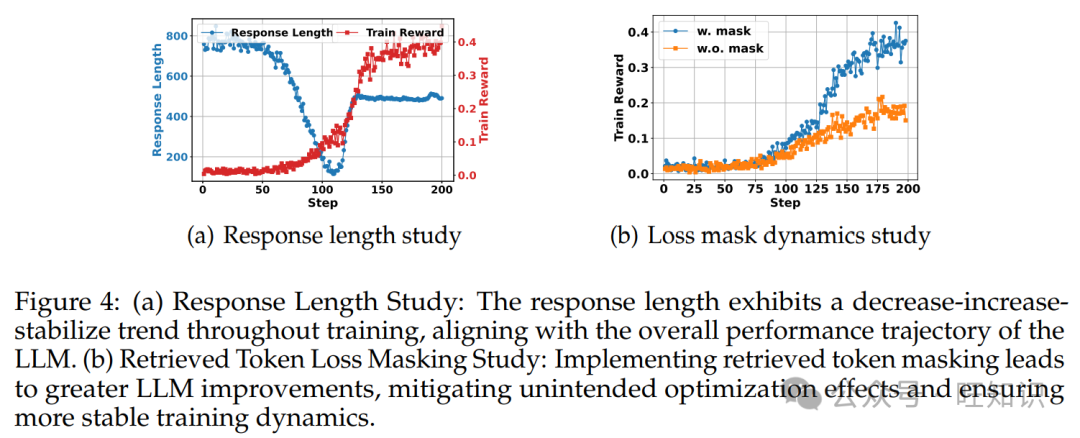

我們使用帶有LLaMA3.2 - 3b - base模型的SEARCH - R1進(jìn)行實(shí)驗(yàn),在自然問(wèn)題(NQ)上進(jìn)行訓(xùn)練,以分析訓(xùn)練過(guò)程中訓(xùn)練獎(jiǎng)勵(lì)和響應(yīng)長(zhǎng)度的動(dòng)態(tài)變化。結(jié)果如圖4(a)所示,揭示了以下關(guān)鍵趨勢(shì):

?早期階段(前100步):響應(yīng)長(zhǎng)度急劇下降,而訓(xùn)練獎(jiǎng)勵(lì)略有增加。在此階段,基礎(chǔ)模型學(xué)習(xí)消除過(guò)多的填充詞,并開(kāi)始適應(yīng)任務(wù)要求。

?中期階段(100 - 130步):響應(yīng)長(zhǎng)度和訓(xùn)練獎(jiǎng)勵(lì)都顯著增加。此時(shí),大語(yǔ)言模型學(xué)會(huì)調(diào)用搜索引擎,由于檢索到的段落,響應(yīng)變長(zhǎng)。隨著模型更有效地利用搜索結(jié)果,訓(xùn)練獎(jiǎng)勵(lì)大幅提高。

?后期階段(130步之后):響應(yīng)長(zhǎng)度穩(wěn)定下來(lái),訓(xùn)練獎(jiǎng)勵(lì)繼續(xù)略有增加。在此階段,模型已經(jīng)學(xué)會(huì)有效地使用搜索引擎,并專注于優(yōu)化其搜索查詢。鑒于自然問(wèn)題(NQ)是一個(gè)相對(duì)簡(jiǎn)單的任務(wù),響應(yīng)長(zhǎng)度穩(wěn)定在大約500個(gè)令牌左右,表明模型收斂。

5.4 檢索令牌損失掩碼的研究

在3.1節(jié)中,我們引入了檢索令牌的令牌級(jí)損失掩碼,以防止意外的優(yōu)化行為。在這里,我們通過(guò)分析其對(duì)訓(xùn)練穩(wěn)定性和模型性能的影響,實(shí)證評(píng)估其有效性。

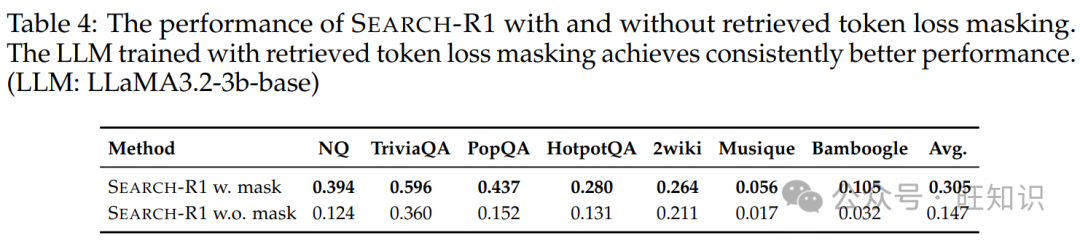

我們?cè)贚LaMA3.2 - 3b - base模型上進(jìn)行實(shí)驗(yàn),比較有無(wú)檢索令牌損失掩碼的訓(xùn)練動(dòng)態(tài)。如圖4(b)所示,應(yīng)用檢索令牌掩碼使大語(yǔ)言模型有更大的改進(jìn),減輕了意外的優(yōu)化影響,并確保了更穩(wěn)定的訓(xùn)練動(dòng)態(tài)。

表4提供了性能比較,表明使用檢索令牌損失掩碼訓(xùn)練的SEARCH - R1始終優(yōu)于未使用掩碼的變體。

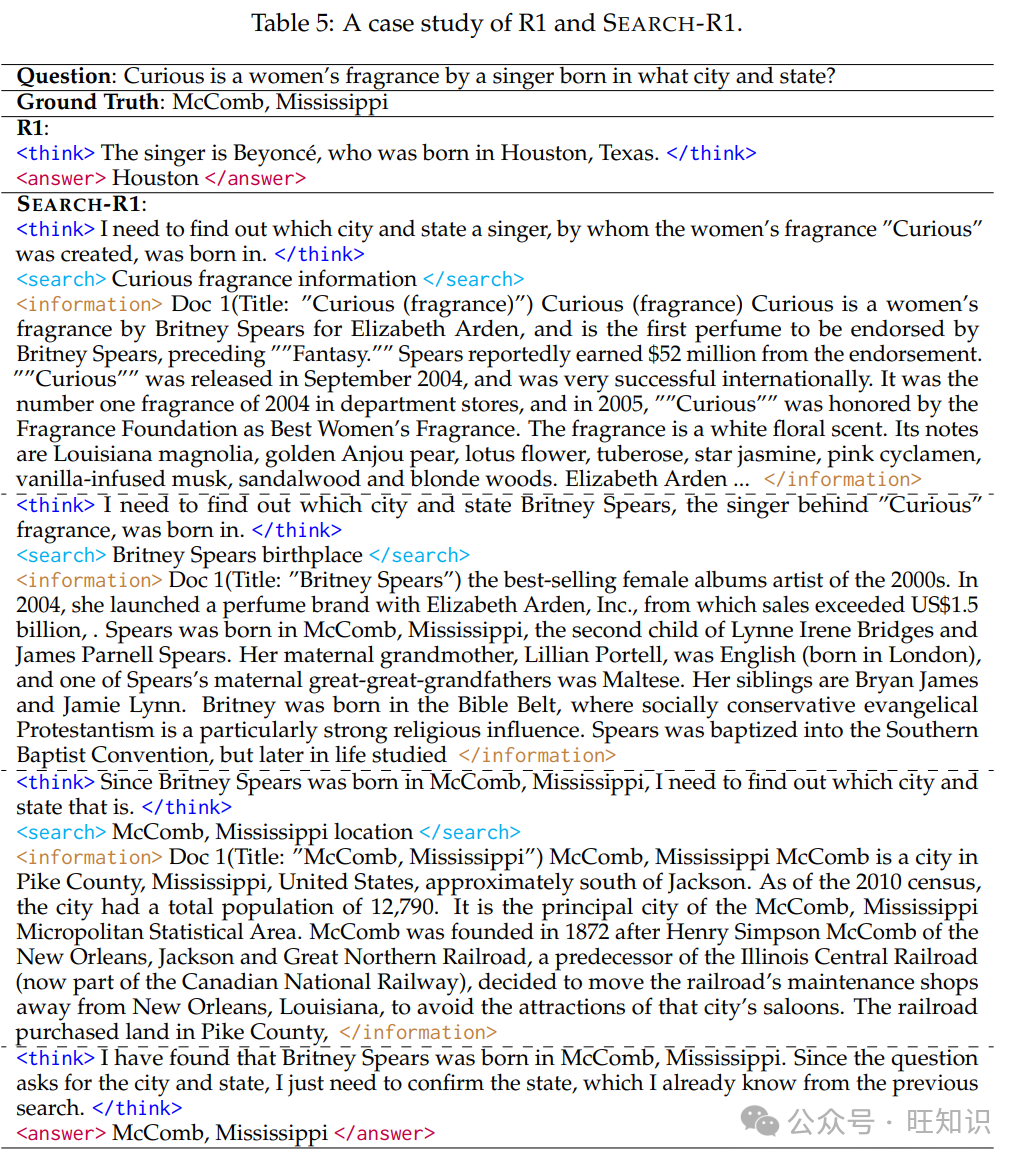

5.5 案例研究

為了更深入地了解SEARCH - R1,我們使用Qwen2.5 - 7B - Base進(jìn)行案例研究,將其行為與不使用搜索引擎的強(qiáng)化學(xué)習(xí)(Guo等人,2025)進(jìn)行比較。結(jié)果如表5所示,揭示了以下關(guān)鍵觀察:

?交錯(cuò)推理和檢索增強(qiáng)問(wèn)題分析:SEARCH - R1使大語(yǔ)言模型能夠通過(guò)多輪檢索進(jìn)行深入推理,而不使用搜索的強(qiáng)化學(xué)習(xí)僅依賴模型的內(nèi)部知識(shí)。通過(guò)整合檢索到的段落,SEARCH - R1允許大語(yǔ)言模型迭代優(yōu)化其推理,從而得出更明智、更準(zhǔn)確的響應(yīng)。

?通過(guò)迭代檢索進(jìn)行自我驗(yàn)證:我們觀察到,在第二輪檢索后,大語(yǔ)言模型已經(jīng)收集了足夠的信息來(lái)回答問(wèn)題。然而,SEARCH - R1執(zhí)行了額外的檢索步驟來(lái)自我驗(yàn)證其結(jié)論,進(jìn)一步增強(qiáng)了其對(duì)最終響應(yīng)的信心。這一現(xiàn)象與不使用檢索的大語(yǔ)言模型推理強(qiáng)化學(xué)習(xí)的發(fā)現(xiàn)一致(Guo等人,2025),突出了即使在搜索增強(qiáng)的設(shè)置中,強(qiáng)化學(xué)習(xí)也可以鼓勵(lì)基于驗(yàn)證的推理。

6 結(jié)論

在這項(xiàng)工作中,我們引入了SEARCH - R1,這是一種新穎的強(qiáng)化學(xué)習(xí)框架,使大語(yǔ)言模型(LLMs)能夠?qū)⒆晕彝评砼c實(shí)時(shí)搜索引擎交互交錯(cuò)進(jìn)行。與現(xiàn)有的檢索增強(qiáng)生成(RAG)方法不同,SEARCH - R1通過(guò)強(qiáng)化學(xué)習(xí)優(yōu)化大語(yǔ)言模型的滾動(dòng)輸出,允許自主查詢生成和對(duì)檢索信息的策略性利用,而檢索增強(qiáng)生成(RAG)方法缺乏多輪檢索的靈活性,工具使用方法則需要大規(guī)模的監(jiān)督訓(xùn)練數(shù)據(jù)。通過(guò)在七個(gè)數(shù)據(jù)集上的廣泛實(shí)驗(yàn),我們證明了SEARCH - R1顯著增強(qiáng)了大語(yǔ)言模型處理需要實(shí)時(shí)外部知識(shí)的復(fù)雜推理任務(wù)的能力。我們的分析還為搜索增強(qiáng)推理的強(qiáng)化學(xué)習(xí)訓(xùn)練策略提供了關(guān)鍵見(jiàn)解。展望未來(lái),未來(lái)的工作可以探索擴(kuò)展SEARCH - R1以支持更廣泛的搜索策略,包括更復(fù)雜的獎(jiǎng)勵(lì)機(jī)制、基于不確定性的動(dòng)態(tài)檢索調(diào)整,以及與網(wǎng)絡(luò)搜索之外的各種信息源的集成。研究其在多模態(tài)推理任務(wù)中的適用性也很有前景。

本文轉(zhuǎn)載自旺知識(shí),作者:旺知識(shí)