基于多模態(tài)大語言模型的上下文目標(biāo)檢測(cè) 原創(chuàng) 精華

摘要:

最近的多模態(tài)大語言模型(MLLMs)在視覺-語言任務(wù)(如圖像描述和問答)中表現(xiàn)出色,但缺乏關(guān)鍵的感知能力,即目標(biāo)檢測(cè)。本文提出了一種新的研究問題——上下文目標(biāo)檢測(cè),即在人機(jī)交互的上下文中理解可見物體。我們研究了三種代表性場(chǎng)景:語言填空測(cè)試、視覺描述生成和問答。此外,我們提出了ContextDET,一種統(tǒng)一的多模態(tài)模型,能夠端到端地對(duì)視覺-語言上下文進(jìn)行可微分建模,從而定位、識(shí)別并將視覺對(duì)象與語言輸入關(guān)聯(lián)起來,以支持人機(jī)交互。ContextDET包含三個(gè)關(guān)鍵子模型:(1)用于提取視覺表示的視覺編碼器,(2)用于多模態(tài)上下文解碼的預(yù)訓(xùn)練大語言模型(LLM),以及(3)用于根據(jù)上下文對(duì)象詞匯預(yù)測(cè)邊界框的視覺解碼器。這種“生成-檢測(cè)”框架使我們能夠檢測(cè)人類詞匯中的對(duì)象詞匯。大量實(shí)驗(yàn)表明,ContextDET在我們提出的CODE基準(zhǔn)、開放詞匯檢測(cè)和引用圖像分割任務(wù)中具有顯著優(yōu)勢(shì)。

1、引言

“對(duì)我來說,上下文是關(guān)鍵——從它衍生出對(duì)一切的理解。” —— Kenneth Noland

計(jì)算機(jī)視覺的一個(gè)不可或缺的基石——目標(biāo)檢測(cè)——是理解場(chǎng)景中的可見物體,它賦能了許多應(yīng)用,如機(jī)器人、自動(dòng)駕駛和AR/VR系統(tǒng)。最近,通過互聯(lián)網(wǎng)規(guī)模的視覺-語言數(shù)據(jù)訓(xùn)練的多模態(tài)大語言模型(MLLMs),包括Flamingo、PaLM-E和OpenAI的GPT-4,展示了革命性的能力,使人類能夠與AI模型進(jìn)行各種視覺-語言任務(wù)的交互,例如圖像描述和問答。這種交互式的人機(jī)環(huán)境需要對(duì)上下文信息進(jìn)行建模,即視覺對(duì)象、人類詞匯、短語甚至對(duì)話之間的關(guān)系。因此,有必要提升MLLMs的能力,使其能夠定位、識(shí)別并將視覺對(duì)象與語言輸入關(guān)聯(lián)起來,以支持人機(jī)交互。

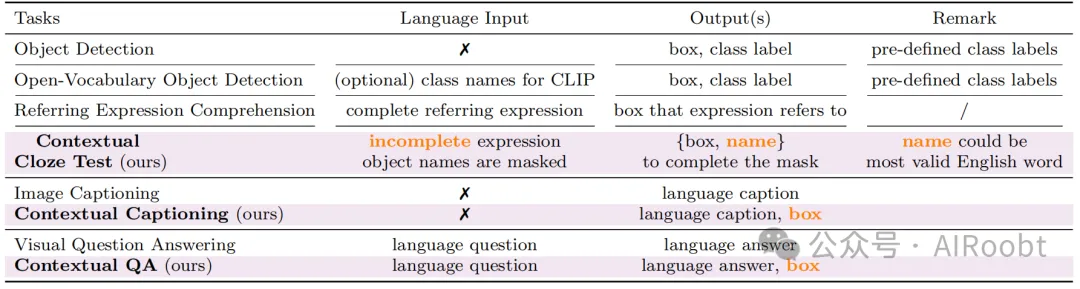

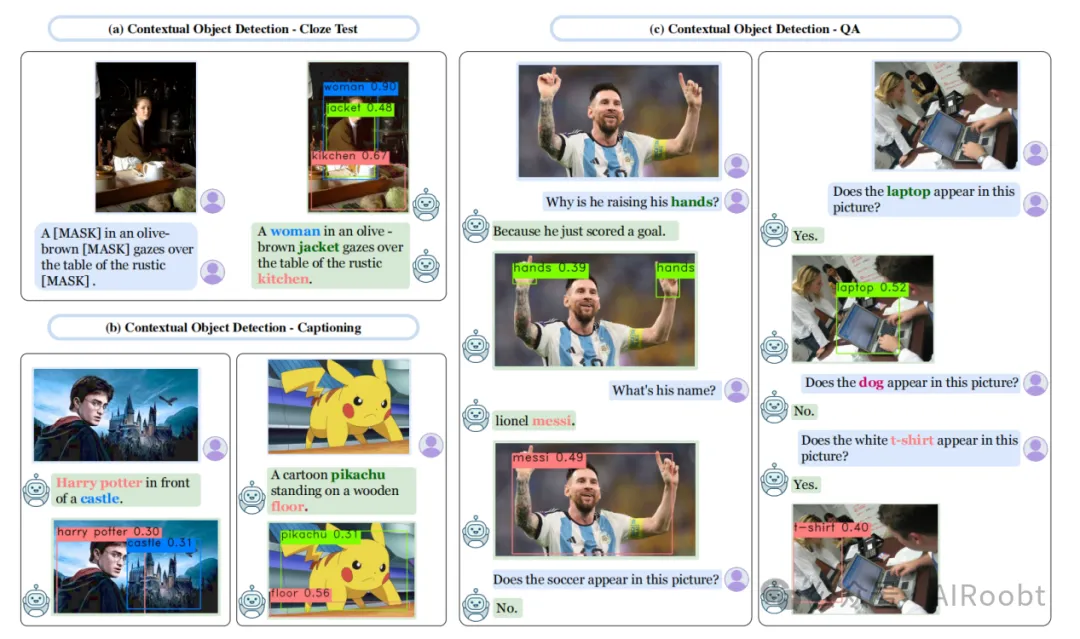

在本文中,我們研究了一個(gè)新的研究問題——上下文目標(biāo)檢測(cè),即在人機(jī)交互的上下文中理解可見物體。與現(xiàn)有的標(biāo)準(zhǔn)目標(biāo)檢測(cè)相比,我們?yōu)檫@種新設(shè)置考慮了四個(gè)綜合目標(biāo):(1)能力:能夠處理人類語言詞匯;(2)描述:用信息豐富的自然語言語句描述用戶的視覺輸入;(3)感知:定位并將視覺對(duì)象與語言查詢關(guān)聯(lián)起來;(4)理解:根據(jù)語言提示補(bǔ)充適當(dāng)?shù)脑~匯。為了涵蓋這四個(gè)目標(biāo),我們結(jié)合了三種代表性任務(wù):語言填空測(cè)試、視覺描述生成和問答,并將其與目標(biāo)檢測(cè)結(jié)合(見圖1)。

盡管在開發(fā)更準(zhǔn)確、更快速的目標(biāo)檢測(cè)算法方面取得了顯著進(jìn)展,但由于以下原因,現(xiàn)有的深度目標(biāo)檢測(cè)器無法直接與MLLMs集成以進(jìn)行上下文目標(biāo)檢測(cè)。首先,標(biāo)準(zhǔn)的深度檢測(cè)器(如Mask-RCNN和DETR)使用封閉集分類器進(jìn)行訓(xùn)練,無法在現(xiàn)實(shí)場(chǎng)景中很好地泛化,因?yàn)檫@些場(chǎng)景中的對(duì)象類別或類并未預(yù)先定義或限制在封閉集中。盡管最近基于最先進(jìn)的視覺-語言模型(如CLIP和ALIGN)的開放詞匯目標(biāo)檢測(cè)(如Gu et al., 2022; Zhou et al., 2022; Zang et al., 2022; Rasheed et al., 2022)可以提高對(duì)新類別的零樣本遷移能力,但它們受限于預(yù)定義的新類別規(guī)模,無法檢測(cè)人類語言詞匯中的對(duì)象。雖然一些論文(如Dai et al., 2023)探索了使用LLMs改進(jìn)二元OOD分類,但識(shí)別人類語言詞匯中的新類別名稱尚未得到解決。例如,這些開放詞匯檢測(cè)器無法處理圖1中的分布外類別,如“曲棍球守門員”“新郎”和“牛仔”。其次,現(xiàn)有深度檢測(cè)模型固有的“先定位再分類”范式不適合上下文目標(biāo)檢測(cè)。在通用的人機(jī)交互場(chǎng)景中,視覺場(chǎng)景中的自然對(duì)象和語言輸入中的人類詞匯在不同上下文中具有不同的含義。例如,在圖1(a)和(b)中,通用的“人”類別在不同的視覺上下文中表現(xiàn)為“守門員”“球員”“牛仔”“新郎”“新娘”和“工人”。此外,隨著語言上下文的變化,“拉布拉多”一詞取代了“狗”的表示(圖1(c))。因此,需要一種創(chuàng)新的檢測(cè)方法來適應(yīng)多樣且變化的上下文目標(biāo)檢測(cè)。

圖 1:我們提出了一個(gè)新的上下文目標(biāo)檢測(cè)任務(wù),包括:(a) 觀察圖像并補(bǔ)全被遮蓋的目標(biāo)名稱和位置;(b) 預(yù)測(cè)存在于描述性文字中的目標(biāo)的標(biāo)題和邊界框;(c) 回答有關(guān)目標(biāo)名稱和位置的問題。與通常專注于檢測(cè)有限的預(yù)定義目標(biāo)類別(例如“人”)的傳統(tǒng)目標(biāo)檢測(cè)任務(wù)不同,我們的任務(wù)需要基于上下文理解來預(yù)測(cè)更具體的目標(biāo)名稱(例如“冰球守門員”、“新郎”或“新娘”)。

為了應(yīng)對(duì)上述挑戰(zhàn),本文提出了ContextDET,一種專門用于上下文目標(biāo)檢測(cè)的“生成-檢測(cè)”框架。具體來說,它是一個(gè)端到端模型,包含三個(gè)關(guān)鍵模塊。首先,視覺編碼器提取給定圖像的高級(jí)表示,并生成局部和完整的視覺令牌以進(jìn)行進(jìn)一步的上下文建模。其次,為了有效建模多模態(tài)上下文,我們使用預(yù)訓(xùn)練的LLM進(jìn)行文本生成,并以局部視覺令牌和任務(wù)相關(guān)語言令牌作為多模態(tài)前綴的條件輸入。第三,將LLM生成的令牌作為視覺檢測(cè)的先驗(yàn)知識(shí),我們引入了一個(gè)視覺解碼器,該解碼器由多個(gè)交叉注意力層組成,在其中我們從上下文LLM令牌中計(jì)算條件對(duì)象查詢,并從完整視覺令牌中提取鍵和值,以預(yù)測(cè)相應(yīng)的匹配分?jǐn)?shù)和邊界框。這使得我們能夠檢測(cè)人類詞匯中的上下文對(duì)象詞匯。

貢獻(xiàn):總結(jié)來說,我們的貢獻(xiàn)如下:(1)我們研究了上下文目標(biāo)檢測(cè)——這是視覺目標(biāo)檢測(cè)的一個(gè)新方向,旨在提升MLLMs在人機(jī)交互中的能力。(2)為了推動(dòng)該領(lǐng)域的實(shí)證研究,我們提出了一個(gè)新的基準(zhǔn)CODE,包含10,346個(gè)獨(dú)特的對(duì)象詞匯,以促進(jìn)上下文目標(biāo)檢測(cè)的研究。(3)我們提出了一種新穎的“生成-檢測(cè)”框架ContextDET,專門用于上下文目標(biāo)檢測(cè)。(4)我們展示了ContextDET不僅在CODE基準(zhǔn)上具有優(yōu)勢(shì),還在開放詞匯檢測(cè)和引用圖像分割任務(wù)中表現(xiàn)出色。我們希望我們的工作能夠激發(fā)未來在上下文目標(biāo)檢測(cè)方面的研究,從而造福人機(jī)交互。

2、相關(guān)工作

1. 多模態(tài)大語言模型(MLLMs)

大語言模型(LLMs)已被開發(fā)用于理解和生成文本語言,在廣泛的自然語言處理(NLP)任務(wù)中表現(xiàn)出色。著名的LLMs包括OpenAI的GPT系列、Google的T5和PaLM,以及Meta的OPT和LLaMA。最近,MLLMs領(lǐng)域取得了進(jìn)展(如Mokady et al., 2021; Tsimpoukelli et al., 2021; Chen et al., 2022b; Koh et al., 2023; Li et al., 2023; Huang et al., 2023; Driess et al., 2023; OpenAI, 2023),例如GPT-4模型,這些模型擴(kuò)展了LLMs的能力,使其能夠理解語言和視覺輸入。MLLMs在圖像描述和視覺問答等視覺-語言任務(wù)中表現(xiàn)出色。然而,現(xiàn)有的MLLMs僅限于生成文本輸出。相比之下,我們的ContextDET基于MLLMs,擴(kuò)展了對(duì)上下文目標(biāo)檢測(cè)的支持,提供邊界框輸出。更多比較見第5.6節(jié)。

2. 使用視覺專家模型提示LLMs

最近的一些論文(如Shen et al., 2023; Wu et al., 2023a; Yang et al., 2023)提出了利用LLMs(如ChatGPT)生成的文本輸出來操縱外部視覺專家模型以完成各種視覺相關(guān)任務(wù)的系統(tǒng)。在目標(biāo)檢測(cè)的背景下,這些視覺專家模型包括DETR、Grounding DINO、SAM等。然而,由于LLMs和專家模型的參數(shù)是凍結(jié)的,LLMs的知識(shí)和表示無法共享,可能導(dǎo)致性能不佳。與這些基于提示的方法不同,我們的ContextDET采用端到端的訓(xùn)練流程,利用從MLLMs提取的潛在特征作為視覺解碼器的條件輸入,從而預(yù)測(cè)邊界框。

3. 具有上下文理解的目標(biāo)檢測(cè)

“上下文”通常指圖像中的鄰近像素或周圍區(qū)域,并已在先前的研究中廣泛探索以增強(qiáng)目標(biāo)檢測(cè)算法(如Divvala et al., 2009; Mottaghi et al., 2014; Shrivastava and Gupta, 2016; Chen et al., 2018)。在本文中,上下文信息的概念涵蓋了多模態(tài)模式和關(guān)系,涉及視覺圖像和文本詞匯。我們的ContextDET利用MLLMs的強(qiáng)大上下文理解能力,并將其應(yīng)用于下游目標(biāo)檢測(cè)任務(wù)。此外,我們提出了新的評(píng)估任務(wù)(如填空測(cè)試),以更有效地評(píng)估上下文理解能力。

4. 新類別上的目標(biāo)檢測(cè)

盡管深度學(xué)習(xí)技術(shù)在目標(biāo)檢測(cè)方面取得了顯著進(jìn)展(如Ren et al., 2015; Liu et al., 2016; Law and Deng, 2018; Tian et al., 2019; Carion et al., 2020; Chen et al., 2022b; Liu et al., 2021; Zhang et al., 2023; Zhu et al., 2021; Wang et al., 2023b),但在現(xiàn)實(shí)場(chǎng)景中,目標(biāo)檢測(cè)仍然是一個(gè)具有挑戰(zhàn)性的任務(wù),特別是在零樣本目標(biāo)檢測(cè)(Bansal et al., 2018)的情況下。零樣本目標(biāo)檢測(cè)要求模型在訓(xùn)練時(shí)僅使用基礎(chǔ)類別的數(shù)據(jù),但能夠檢測(cè)訓(xùn)練時(shí)未見的新類別。最近的一種零樣本檢測(cè)變體,稱為開放詞匯目標(biāo)檢測(cè),允許使用額外的圖像-文本對(duì)(Zareian et al., 2021),引起了研究社區(qū)的廣泛關(guān)注。在這一背景下,最近的視覺和語言預(yù)訓(xùn)練模型(如CLIP、ALIGN)被廣泛用于開放詞匯目標(biāo)檢測(cè)(如Gu et al., 2022; Zhou et al., 2022; Du et al., 2022; Zang et al., 2022; Rasheed et al., 2022; Kuo et al., 2022; Wu et al., 2023b,c)。與僅依賴CLIP的方法不同,我們的ContextDET表明,MLLMs也可以有效地應(yīng)用于開放詞匯設(shè)置。在MLLMs的幫助下,ContextDET不受預(yù)定義的基礎(chǔ)或新類別的限制。值得注意的是,ContextDET預(yù)測(cè)的對(duì)象名稱可以由MLLMs生成為最符合上下文的有效英文單詞。

表1:我們提出的三種上下文目標(biāo)檢測(cè)設(shè)置與之前相關(guān)任務(wù)的比較。

5. 視覺定位

視覺定位任務(wù)(如引用表達(dá)式理解)結(jié)合了目標(biāo)檢測(cè)和語言理解能力。在這些任務(wù)中,提供一個(gè)語言查詢來描述特定對(duì)象,模型的任務(wù)是預(yù)測(cè)被引用對(duì)象的位置。最先進(jìn)的算法(如Yang et al., 2022; Wang et al., 2022)通常采用基于Transformer的跨模態(tài)結(jié)構(gòu)或多模態(tài)預(yù)訓(xùn)練(如Kamath et al., 2021)。我們提出的上下文目標(biāo)檢測(cè)任務(wù)比視覺定位更具挑戰(zhàn)性。例如,在我們的填空測(cè)試中,語言查詢是不完整的,對(duì)象名稱被掩碼。模型需要根據(jù)上下文信息推斷缺失的對(duì)象名稱及其位置。此外,在我們的上下文描述生成設(shè)置中,沒有提供語言查詢。而在我們的上下文問答設(shè)置中,對(duì)象是在交互環(huán)境中使用人類語言描述的。

6. 圖像描述生成

圖像描述生成任務(wù)旨在生成描述性句子以理解給定圖像。通常,圖像描述生成模型首先使用預(yù)訓(xùn)練的分類模型(如Chen et al., 2017)、目標(biāo)檢測(cè)模型(如Anderson et al., 2018)或視覺語言模型(如Mokady et al., 2021)將輸入圖像編碼為特征嵌入。隨后,使用LSTM(Hochreiter and Schmidhuber, 1997)或Transformer(Vaswani et al., 2017)等子模塊將特征嵌入解碼為預(yù)測(cè)的句子。相比之下,我們的上下文描述生成任務(wù)不僅需要生成語言輸出,還要求模型預(yù)測(cè)生成描述中提到的對(duì)象的邊界框位置。

7. 視覺問答(VQA)

視覺問答任務(wù)涉及回答與給定圖像相關(guān)的問題(如Antol et al., 2015; Goyal et al., 2017)。在傳統(tǒng)的VQA中,模型的輸入和輸出由自然語言中的問答對(duì)組成。然而,在我們的上下文問答任務(wù)中,問題專門詢問對(duì)象名稱和位置,而相應(yīng)的答案需要包括被引用對(duì)象的邊界框。

3、方法

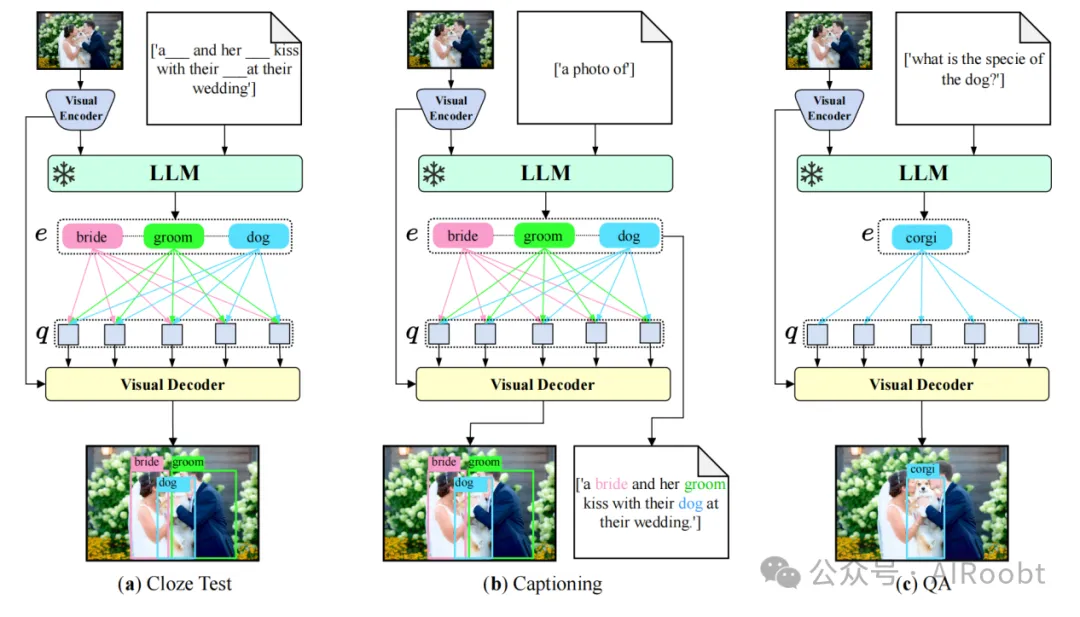

本節(jié)描述了我們的上下文目標(biāo)檢測(cè)框架ContextDET,它接受圖像和人類文本的交錯(cuò)輸入,并生成自由格式的文本和相應(yīng)的邊界框作為輸出。如圖2所示,我們的ContextDET是端到端的,包含三個(gè)關(guān)鍵架構(gòu)組件:(1)一個(gè)視覺編碼器,用于提取高級(jí)圖像表示并計(jì)算視覺令牌;(2)一個(gè)預(yù)訓(xùn)練的大語言模型(LLM),用于解碼帶有任務(wù)相關(guān)多模態(tài)前綴的多模態(tài)上下文令牌;(3)一個(gè)視覺解碼器,用于預(yù)測(cè)與上下文對(duì)象詞匯相關(guān)的條件查詢的匹配分?jǐn)?shù)和邊界框。

圖 2:我們的 ContextDET 是一個(gè)統(tǒng)一的端到端框架,能夠處理不同任務(wù)的不同語言標(biāo)記輸入,包括 (a) 完形填空測(cè)試、(b) 圖像描述生成和 (c) 問答。符號(hào)“雪花”表示凍結(jié)的部分。符號(hào) e 表示語言模型的潛在嵌入(第 3.2 節(jié)),符號(hào) q 表示視覺解碼器的目標(biāo)查詢(第 3.3 節(jié))。

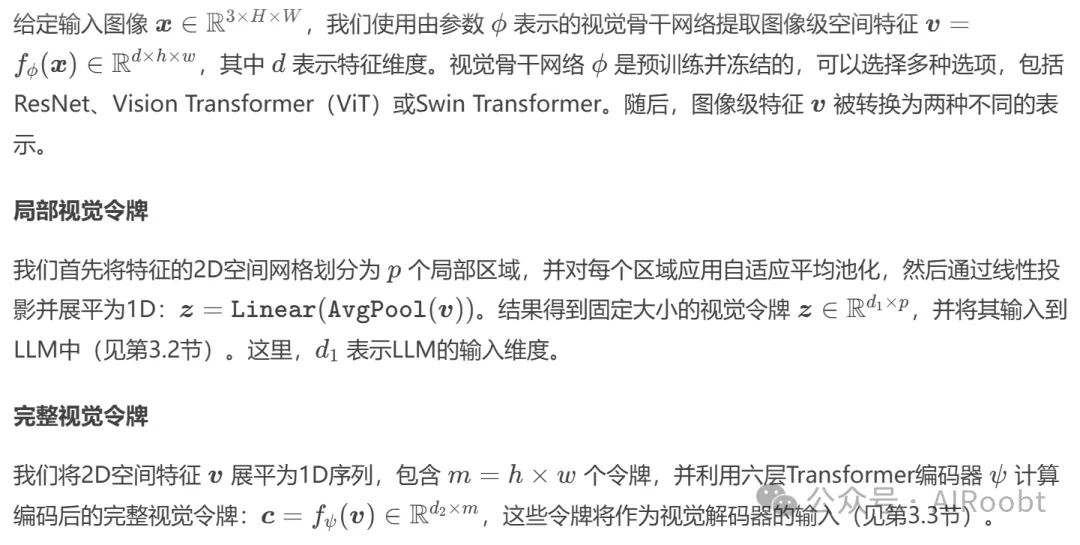

視覺編碼器

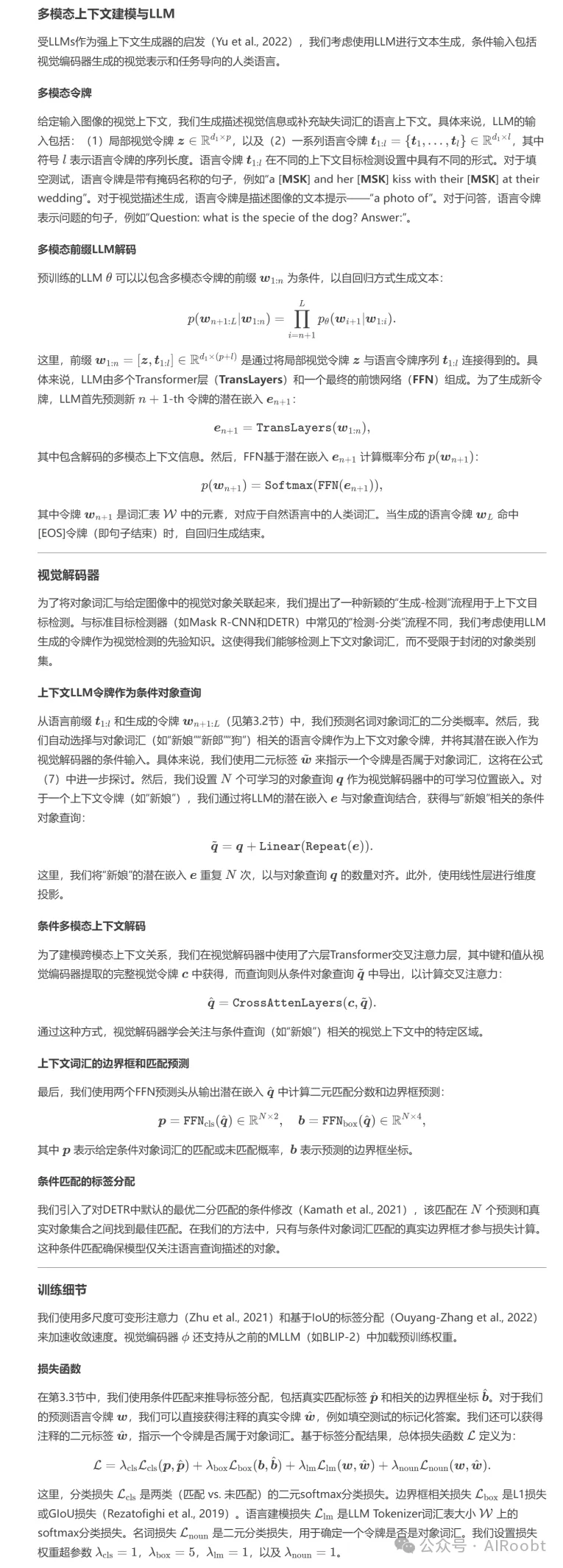

多模態(tài)上下文建模與LLM

4、CODE基準(zhǔn)

為了促進(jìn)上下文目標(biāo)檢測(cè)的研究,我們構(gòu)建了一個(gè)上下文目標(biāo)檢測(cè)(Contextual Object DEtection, CODE)數(shù)據(jù)集。具體來說,我們從Flickr30k(Young et al., 2014)和Flickr30k Entities(Plummer et al., 2015)中收集了圖像、邊界框和描述注釋。我們添加了包含描述字符串中對(duì)象名稱位置信息的注釋。這些對(duì)象名稱將被替換為“[MASK]”令牌,作為我們填空測(cè)試設(shè)置的輸入。CODE分為三個(gè)部分:訓(xùn)練集包含29,781張圖像中的665,161個(gè)邊界框,驗(yàn)證集包含1,000張圖像中的22,061個(gè)邊界框,測(cè)試集包含999張圖像中的21,641個(gè)邊界框。總體而言,CODE數(shù)據(jù)集包含10,346個(gè)獨(dú)特的對(duì)象名稱,超過了以往任何檢測(cè)數(shù)據(jù)集中的對(duì)象名稱數(shù)量,例如COCO(80個(gè)類別)和LVIS(1,203個(gè)類別)。

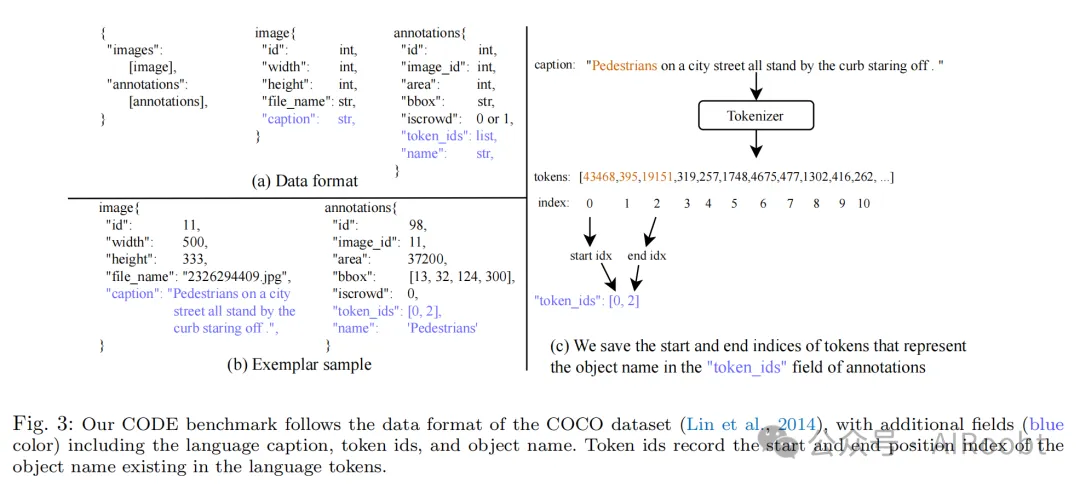

數(shù)據(jù)格式

我們的CODE基準(zhǔn)遵循COCO數(shù)據(jù)集(Lin et al., 2014)的數(shù)據(jù)格式,并添加了額外的字段(藍(lán)色標(biāo)注),包括語言描述、令牌ID和對(duì)象名稱。令牌ID記錄了對(duì)象名稱在語言令牌中的起始和結(jié)束位置索引。

圖3:我們的CODE基準(zhǔn)遵循COCO數(shù)據(jù)集的數(shù)據(jù)格式,并添加了額外的字段(藍(lán)色標(biāo)注),包括語言描述、令牌ID和對(duì)象名稱。令牌ID記錄了對(duì)象名稱在語言令牌中的起始和結(jié)束位置索引。

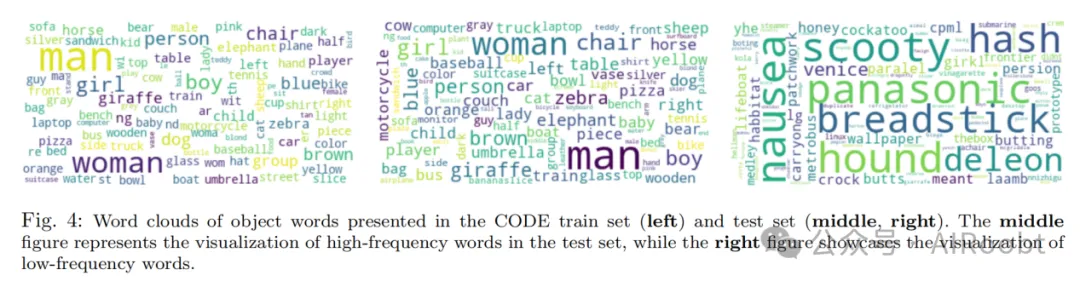

圖4:CODE訓(xùn)練集(左)和測(cè)試集(中、右)中對(duì)象詞匯的詞云可視化。中間的圖展示了測(cè)試集中高頻詞匯的可視化,而右側(cè)的圖展示了低頻詞匯的可視化。

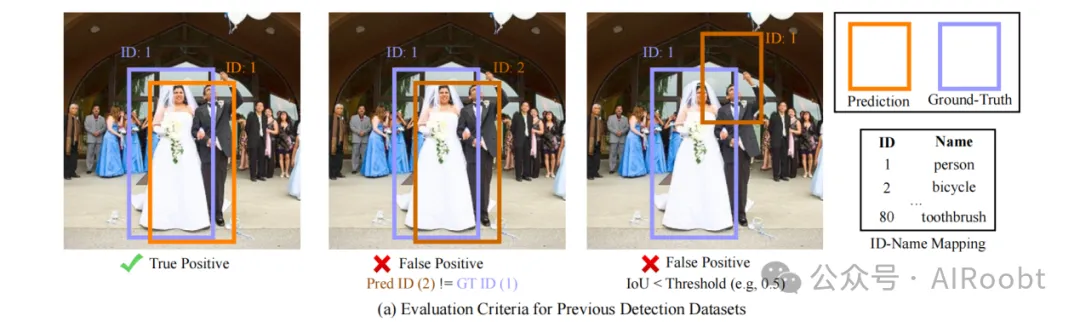

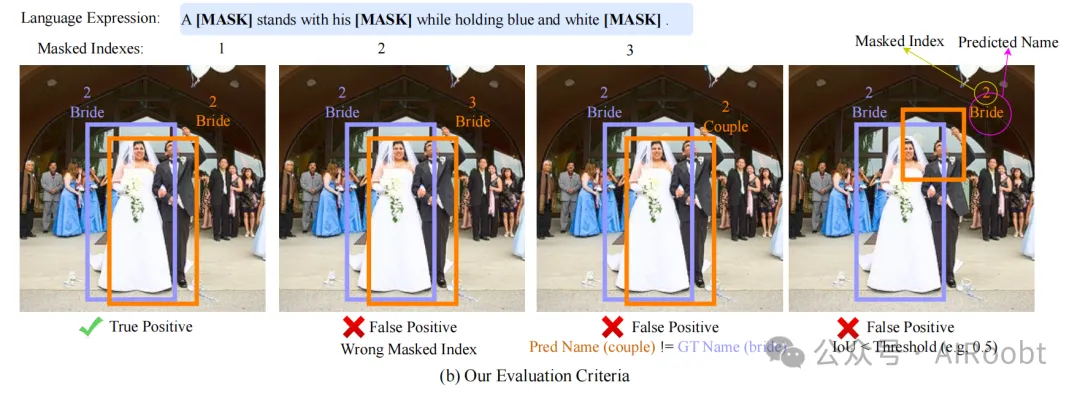

圖5:(a)傳統(tǒng)目標(biāo)檢測(cè)任務(wù)的評(píng)估標(biāo)準(zhǔn)與(b)我們的上下文填空測(cè)試評(píng)估標(biāo)準(zhǔn)的比較。

評(píng)估細(xì)節(jié)

現(xiàn)有的目標(biāo)檢測(cè)數(shù)據(jù)集(如Pascal VOC、Microsoft COCO、Open Images、LVIS、Object365和V3Det)依賴于標(biāo)簽ID與類別名稱之間的預(yù)定義映射進(jìn)行評(píng)估。例如,COCO數(shù)據(jù)集使用類似(1, person)、(2, bicycle)、...、(80, toothbrush)的映射來表示其80個(gè)類別。如圖5(a)所示,為了被分類為真正例(true positives),預(yù)測(cè)的邊界框必須與真實(shí)邊界框具有較高的IoU重疊,并且類別ID必須相同。在某些情況下,例如零樣本(Bansal et al., 2018)或開放詞匯(Zareian et al., 2021)目標(biāo)檢測(cè)設(shè)置中,預(yù)定義的類別被分為兩組:基礎(chǔ)和新類別,以評(píng)估模型的泛化能力。然而,這些評(píng)估仍然依賴于預(yù)定義的ID-名稱映射,而名稱未包含在預(yù)定義映射中的對(duì)象則無法被評(píng)估。

人類的感知并不依賴于預(yù)定義的類別ID。因此,對(duì)于我們提出的上下文填空測(cè)試任務(wù),我們建立了新的評(píng)估標(biāo)準(zhǔn),使用人類語言中的對(duì)象名稱進(jìn)行評(píng)估。在此評(píng)估中,給定一個(gè)帶有掩碼的語言表達(dá)式和掩碼詞匯的索引,如果預(yù)測(cè)的邊界框滿足以下條件,則將其分類為真正例:(1)與真實(shí)邊界框具有較高的IoU重疊;(2)具有相同的含義;(3)具有相同的掩碼索引。相反,如果預(yù)測(cè)不滿足這些條件,則被視為假正例(false positives)。掩碼索引用于區(qū)分句子中多個(gè)具有相同名稱但位于不同[MASK]令牌位置的對(duì)象。對(duì)象名稱對(duì)應(yīng)于LLMs的Tokenizer解碼的最有效的英文單詞。

在定義了基于名稱的真正例/假正例標(biāo)準(zhǔn)后,我們可以計(jì)算整體的平均精度(AP)指標(biāo)進(jìn)行評(píng)估。我們遵循COCO數(shù)據(jù)集設(shè)置IoU閾值,范圍從0.5到0.95,步長為0.05。由于存在大量長尾低頻名稱,其中只有少數(shù)示例可用于評(píng)估,因此我們未計(jì)算每個(gè)名稱的AP。

AP@5用于前5個(gè)預(yù)測(cè)名稱

在某些情況下,我們的評(píng)估指標(biāo)可能過于嚴(yán)格,特別是在處理大量同義詞或細(xì)粒度類別時(shí),這些類別對(duì)標(biāo)注者來說難以區(qū)分。類似的挑戰(zhàn)在之前的圖像分類數(shù)據(jù)集(如ImageNet)中也曾遇到,其中使用top-5準(zhǔn)確率作為top-1準(zhǔn)確率的補(bǔ)充指標(biāo)。因此,我們還引入了一個(gè)補(bǔ)充指標(biāo),稱為top-5 AP(AP@5),該指標(biāo)放寬了真正例的定義。在AP@5下,如果真實(shí)名稱位于前5個(gè)預(yù)測(cè)中,則預(yù)測(cè)被視為真正例。相比之下,基于top-1預(yù)測(cè)結(jié)果計(jì)算的AP指標(biāo)稱為AP@1,以區(qū)別于AP@5。

實(shí)現(xiàn)細(xì)節(jié)

我們修改了COCO數(shù)據(jù)集中提供的著名pycocotools包,并創(chuàng)建了評(píng)估腳本。

上下文問答和上下文描述生成的評(píng)估

填空測(cè)試、描述生成和問答設(shè)置的上下文理解性能高度相關(guān)。一個(gè)設(shè)置中的定量評(píng)估可以輕松轉(zhuǎn)換為另一個(gè)設(shè)置,只需使用不同的文本提示。例如:

- 填空測(cè)試提示:A -- stands with his bride while holding balloons。(預(yù)期答案:groom)

- 描述生成提示:A photo of a -- standing with his bride while holding balloons。(預(yù)期答案:groom)

- 問答提示:Question: who is standing with the bride while holding balloons in this image? Answer: ----。(預(yù)期答案:The groom)

這三種設(shè)置本質(zhì)上評(píng)估的是同一場(chǎng)景的上下文理解能力,但表現(xiàn)形式不同。

5、實(shí)驗(yàn)

我們?cè)诓煌蝿?wù)上展示了ContextDET的結(jié)果,包括(1)我們提出的上下文目標(biāo)檢測(cè)任務(wù)(見第5.1節(jié)),以及現(xiàn)有任務(wù),如(2)開放詞匯目標(biāo)檢測(cè)(見第5.3節(jié))和(3)引用圖像分割(見第5.4節(jié))。

實(shí)現(xiàn)細(xì)節(jié)

我們的方法使用PyTorch實(shí)現(xiàn),所有模型均在配備4塊NVIDIA A100 GPU的單臺(tái)機(jī)器上進(jìn)行訓(xùn)練。訓(xùn)練期間,應(yīng)用了數(shù)據(jù)增強(qiáng)技術(shù),包括隨機(jī)水平翻轉(zhuǎn)(概率為0.5)和大尺度抖動(dòng)(Ghiasi et al., 2021)。我們將批量大小設(shè)置為8,并訓(xùn)練模型6個(gè)周期。我們使用AdamW優(yōu)化器(Loshchilov and Hutter, 2019),學(xué)習(xí)率為 \(1e^{-4}\),權(quán)重衰減為0.05。對(duì)于ContextDET,我們報(bào)告了使用OPT-2.7B(Zhang et al., 2022b)作為語言模型和ResNet50(He et al., 2016)作為視覺骨干的結(jié)果。

5.1 上下文目標(biāo)檢測(cè)

本節(jié)報(bào)告了我們提出的CODE數(shù)據(jù)集(見第4節(jié))上的基準(zhǔn)測(cè)試結(jié)果。

評(píng)估指標(biāo)

在我們的上下文填空測(cè)試設(shè)置中,我們計(jì)算了分類準(zhǔn)確率和檢測(cè)AP指標(biāo)。準(zhǔn)確率表示正確預(yù)測(cè)對(duì)象詞匯的百分比。然而,由于人類語言中存在大量同義詞和細(xì)粒度對(duì)象詞匯,評(píng)估這一準(zhǔn)確率具有挑戰(zhàn)性。這與之前的大詞匯量圖像分類數(shù)據(jù)集(如ImageNet)面臨的問題類似,這些數(shù)據(jù)集使用top-5準(zhǔn)確率作為top-1準(zhǔn)確率的補(bǔ)充指標(biāo)。因此,我們同時(shí)采用了top-1準(zhǔn)確率(Acc@1)和top-5準(zhǔn)確率(Acc@5)作為評(píng)估指標(biāo)。對(duì)于邊界框評(píng)估,我們基于top-1和top-5預(yù)測(cè)名稱計(jì)算平均精度(mAP)指標(biāo),分別表示為AP@1和AP@5。在評(píng)估中,我們比較的是對(duì)象名稱詞匯,而不是預(yù)定義的類別ID,這使得評(píng)估能夠靈活擴(kuò)展到廣泛的人類詞匯。對(duì)于我們的上下文問答和描述生成設(shè)置,我們通過修改填空測(cè)試任務(wù)中使用的輸入文本提示格式來獲得定量結(jié)果。

基線方法

由于之前的方法不具備“生成-檢測(cè)”能力,我們使用級(jí)聯(lián)解決方案將現(xiàn)有方法結(jié)合作為基線:首先使用BLIP-2(Li et al., 2023)、LLaVA(Liu et al., 2023b)或LLaVA 1.5(Liu et al., 2023a)生成描述,然后使用代表性的定位方法GLIP(Li et al., 2022)。我們還選擇了GLIP-2(Zhang et al., 2022a)作為基線,因?yàn)樗c我們的上下文問答和描述生成場(chǎng)景兼容。然而,GLIP-2不適用于填空測(cè)試設(shè)置,因?yàn)樗枰暾膶?duì)象名稱。

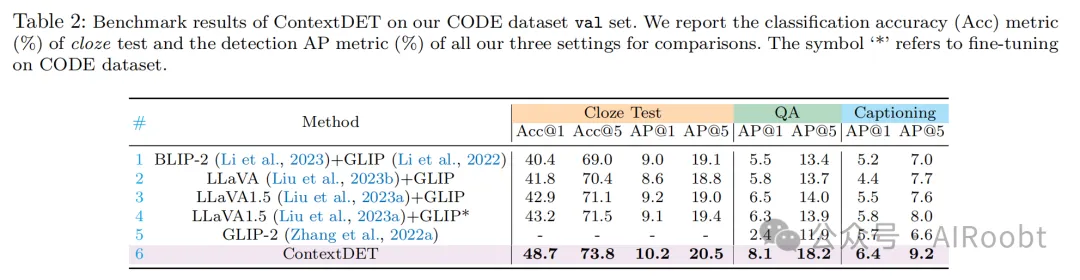

結(jié)果

我們?cè)诒?中提供了ContextDET在CODE數(shù)據(jù)集上的基準(zhǔn)測(cè)試結(jié)果。我們的結(jié)果表明,上下文目標(biāo)檢測(cè)非常具有挑戰(zhàn)性:top-1 AP顯著低于之前的目標(biāo)檢測(cè)數(shù)據(jù)集(如COCO),這主要?dú)w因于我們的基準(zhǔn)包含10,346個(gè)獨(dú)特的對(duì)象名稱(COCO僅有80個(gè)名稱)。與BLIP-2/LLaVA/LLaVA1.5+GLIP等級(jí)聯(lián)解決方案相比,我們的端到端ContextDET在所有設(shè)置上均表現(xiàn)更好。這歸因于從LLMs提取的隱藏嵌入通過自注意力操作符包含了視覺和文本令牌之間的上下文關(guān)系,這對(duì)于需要上下文理解能力的任務(wù)至關(guān)重要。

我們還比較了ContextDET與LLaVA 1.5以及在CODE數(shù)據(jù)集上微調(diào)GLIP檢測(cè)器的結(jié)果(表2中的第4行)。然而,我們發(fā)現(xiàn)微調(diào)GLIP并未顯著提高檢測(cè)性能。這是因?yàn)镚LIP依賴于對(duì)比學(xué)習(xí),可能無法有效適應(yīng)大量具有細(xì)微差異的對(duì)象類別。我們的觀察表明,LLM令牌提供的上下文信息對(duì)于檢測(cè)大詞匯量(如CODE數(shù)據(jù)集中超過10k個(gè)類別)中的新對(duì)象至關(guān)重要。

5.2 消融實(shí)驗(yàn)

我們研究了使用局部視覺令牌 \( \bm{z} \)、決定局部區(qū)域數(shù)量的超參數(shù) \( p \) 以及效率分析的影響。實(shí)驗(yàn)在CODE驗(yàn)證集上進(jìn)行。

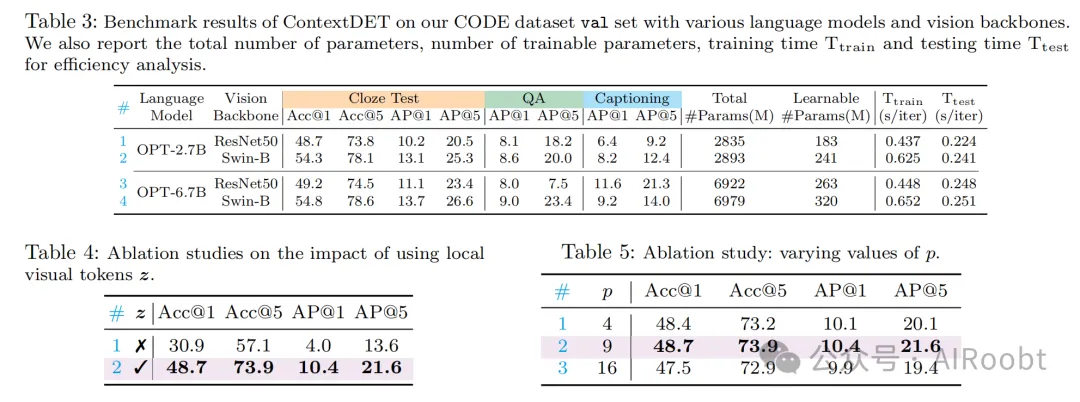

超參數(shù) \( p \)

如第3.1節(jié)所述,我們有 \( p \) 個(gè)局部視覺令牌作為LLM解碼的前綴輸入。在表5中,我們展示了使用不同 \( p \) 值的效果。我們觀察到,選擇 \( p = 9 \)(第2行)能夠獲得最佳結(jié)果,因此將其作為默認(rèn)選擇。

更多骨干網(wǎng)絡(luò)

我們?cè)诒?中提供了ContextDET在CODE數(shù)據(jù)集上的結(jié)果。我們首先報(bào)告了使用OPT-2.7B作為語言模型和ResNet50作為視覺骨干的結(jié)果(第1行)。我們的結(jié)果表明,上下文填空測(cè)試任務(wù)非常具有挑戰(zhàn)性:top-1 AP(AP@1)僅為10.2,顯著低于之前的目標(biāo)檢測(cè)數(shù)據(jù)集(如COCO)。此外,我們的研究表明,使用更強(qiáng)大的語言模型和視覺骨干可以提高性能。當(dāng)我們將ResNet50替換為Swin-B(第2行)時(shí),我們觀察到AP@1從10.2顯著提高到13.1。此外,通過將OPT-2.7B替換為更大的OPT-6.7B(第4行),我們實(shí)現(xiàn)了更高的AP@1性能(13.7)。

不使用局部視覺令牌的LLM

在我們的上下文填空測(cè)試設(shè)置中,即使沒有局部視覺令牌輸入 \( \bm{z} \),LLM也能夠進(jìn)行預(yù)測(cè)。然而,通過分析表4中的結(jié)果,我們觀察到性能顯著下降。例如,top-1準(zhǔn)確率從48.7下降到30.9(約20%)。這一觀察強(qiáng)調(diào)了在我們的方法中添加局部視覺令牌對(duì)于上下文理解的關(guān)鍵作用。我們還觀察到,在沒有 \( \bm{z} \) 的情況下,語言建模損失 \( \mathcal{L}_{\text{lm}} \) 的值幾乎沒有下降。這是因?yàn)橛?jì)算語言建模損失 \( \mathcal{L}_{\text{lm}} \) 與生成下一個(gè)文本令牌密切相關(guān),而生成文本令牌嚴(yán)重依賴于視覺令牌 \( \bm{z} \)。如果沒有視覺令牌 \( \bm{z} \),模型無法有效生成準(zhǔn)確描述視覺內(nèi)容的文本令牌,導(dǎo)致語言建模損失停滯。

效率分析

我們模型中的大多數(shù)參數(shù)(包括LLM組件)是凍結(jié)的,因此可訓(xùn)練參數(shù)的比例較小。如表2第1行所示,當(dāng)使用OPT-2.7B和ResNet50骨干時(shí),只有6.4%的參數(shù)(183/2,835)是可訓(xùn)練的。我們的設(shè)計(jì)并未帶來顯著的計(jì)算負(fù)擔(dān),并且可以輕松復(fù)現(xiàn)。

5.3 開放詞匯目標(biāo)檢測(cè)

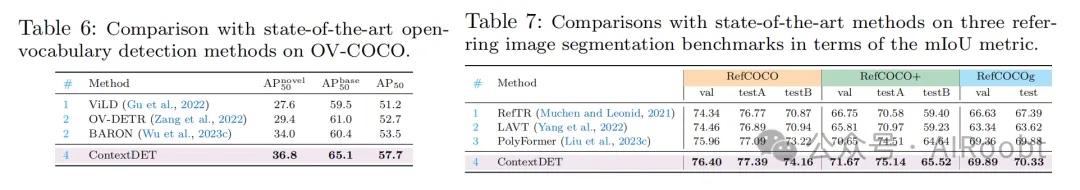

我們展示了我們提出的ContextDET也可以應(yīng)用于開放詞匯目標(biāo)檢測(cè)任務(wù),旨在評(píng)估其泛化能力。根據(jù)之前的工作(Bansal et al., 2018; Zareian et al., 2021),我們使用OV-COCO基準(zhǔn),并將65個(gè)類別分為基礎(chǔ)/新類別(48/17)。模型僅在基礎(chǔ)類別上訓(xùn)練,但在新類別上進(jìn)行評(píng)估(訓(xùn)練期間不可用)。我們使用平均精度(AP)指標(biāo)在基礎(chǔ)、新類別和所有類別上測(cè)量性能。

為了將ContextDET適應(yīng)開放詞匯設(shè)置,我們?yōu)槊總€(gè)類別(包括基礎(chǔ)和新類別)提出類似“Does the [CLASS] appear in this picture?”的問題。如果MLLM回答“Yes”,我們將相應(yīng)類別名稱的潛在嵌入 \( \bm{e} \) 作為視覺解碼器的條件輸入(見第3.3節(jié))。我們?cè)诒?中比較了ContextDET與選定的基線方法,包括最先進(jìn)的方法BARON(Wu et al., 2023c)。我們觀察到,ContextDET在新類別、基礎(chǔ)類別和所有類別上分別顯著優(yōu)于BARON,分別提高了2.8%、4.7%和4.2%。所有基線方法都依賴于視覺-語言模型CLIP的先驗(yàn)知識(shí)。相比之下,我們的ContextDET使用MLLM來檢測(cè)新對(duì)象。結(jié)果表明,在互聯(lián)網(wǎng)規(guī)模數(shù)據(jù)集上訓(xùn)練的MLLM具有強(qiáng)大的泛化能力,可以有益于開放詞匯任務(wù)。

效率分析

OV-DETR的訓(xùn)練和測(cè)試時(shí)間(秒/迭代)分別為0.47/0.63和0.54/0.25。雖然由于LLMs的參數(shù)較多,我們的方法增加了訓(xùn)練時(shí)間,但在測(cè)試時(shí)更加高效。這是因?yàn)镺V-DETR以所有類別為條件,而ContextDET通過提問僅以圖像中存在的類別為條件。

5.4 引用圖像分割

我們的ContextDET不僅限于目標(biāo)檢測(cè),還可以擴(kuò)展到圖像分割任務(wù),其目標(biāo)是為輸入圖像中的每個(gè)像素分配像素級(jí)標(biāo)簽。為了將ContextDET框架適應(yīng)分割任務(wù),我們引入了一個(gè)額外的像素級(jí)分割頭,該頭以完整視覺令牌 \( \bm{c} \) 作為輸入。為了訓(xùn)練分割模型,我們使用像素級(jí)交叉熵?fù)p失 \( \mathcal{L}_{\text{mask}} \) 和Dice損失 \( \mathcal{L}_{\text{dice}} \),其中真實(shí)標(biāo)簽是圖像中匹配對(duì)象的像素級(jí)掩碼。

我們選擇引用圖像分割任務(wù)作為代表性基準(zhǔn),以評(píng)估ContextDET的分割性能。引用圖像分割任務(wù)的目標(biāo)是根據(jù)細(xì)粒度的輸入語言查詢分割圖像中的區(qū)域。語言查詢將作為ContextDET中視覺解碼器的條件輸入。我們使用了三個(gè)常用的數(shù)據(jù)集:RefCOCO(Yu et al., 2016)、RefCOCO+(Yu et al., 2016)和RefCOCOg(Nagaraja et al., 2016)。在RefCOCO和RefCOCO+上,我們遵循Yu等人(Yu et al., 2016)中默認(rèn)的訓(xùn)練/驗(yàn)證/testA/testB數(shù)據(jù)劃分。對(duì)于RefCOCOg,我們使用RefCOCO-umd劃分(Nagaraja et al., 2016)。我們報(bào)告了平均交并比(mIoU),該指標(biāo)通過計(jì)算所有測(cè)試樣本的IoU分?jǐn)?shù)的平均值得到。我們?cè)诒?中將ContextDET與一些最先進(jìn)的方法進(jìn)行了比較。ContextDET在驗(yàn)證/測(cè)試集上分別比PolyFormer(Liu et al., 2023c)提高了0.63%和0.45%的mIoU。

表7:在三個(gè)引用圖像分割基準(zhǔn)上與最先進(jìn)方法的比較(以mIoU指標(biāo)衡量)。

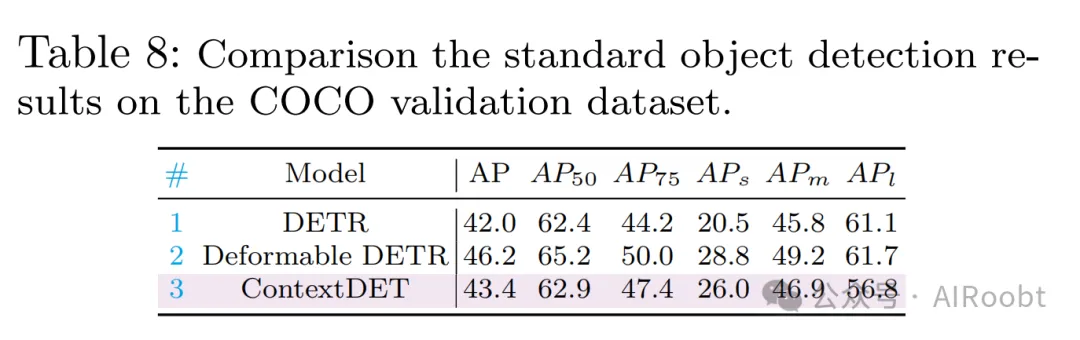

5.5 標(biāo)準(zhǔn)目標(biāo)檢測(cè)

我們進(jìn)一步評(píng)估了ContextDET在標(biāo)準(zhǔn)目標(biāo)檢測(cè)任務(wù)上的有效性,使用COCO基準(zhǔn)。通過應(yīng)用ContextDET的“描述生成”設(shè)置,并實(shí)施后處理調(diào)整(如過濾掉不相關(guān)的對(duì)象類別和置信度閾值),結(jié)果如表8所示。雖然我們的性能不如專門的目標(biāo)檢測(cè)方法(如Deformable DETR),但ContextDET在檢測(cè)小物體方面表現(xiàn)出色,這歸因于上下文信息在消除包含小物體的區(qū)域歧義方面的優(yōu)勢(shì)。

表8:在COCO驗(yàn)證數(shù)據(jù)集上標(biāo)準(zhǔn)目標(biāo)檢測(cè)結(jié)果的比較。

5.6 定性結(jié)果

除了在CODE基準(zhǔn)上的定量評(píng)估外,我們還通過更多樣化的圖像和對(duì)象對(duì)ContextDET進(jìn)行了定性評(píng)估,如圖7所示。我們觀察到ContextDET在復(fù)雜上下文理解和泛化到開放世界名稱方面的能力。例如,如圖7(a)所示,ContextDET能夠合理推斷出填充掩碼的對(duì)象名稱,并準(zhǔn)確地將對(duì)象名稱與邊界框關(guān)聯(lián)起來。此外,ContextDET能夠預(yù)測(cè)開放世界概念的名稱和位置(如“哈利·波特”“皮卡丘”“梅西”),這些概念使用之前的封閉集目標(biāo)檢測(cè)器難以檢測(cè)。最后,在圖7(c)中,我們展示了ContextDET能夠進(jìn)行多輪問答對(duì)話,并預(yù)測(cè)對(duì)話歷史中提到的對(duì)象的邊界框。

我們進(jìn)一步提供了ContextDET在上下文填空測(cè)試(圖8)、上下文描述生成(圖9)和上下文問答設(shè)置(圖10)中預(yù)測(cè)的更多定性結(jié)果。所選圖像隨機(jī)來自網(wǎng)絡(luò),并未包含在訓(xùn)練數(shù)據(jù)中。我們觀察到ContextDET能夠有效預(yù)測(cè)上下文對(duì)象詞匯,包括“老師”“學(xué)生”“醫(yī)生”和“護(hù)士”等術(shù)語,以及它們對(duì)應(yīng)的邊界框。此外,我們發(fā)現(xiàn)了一些失敗案例。例如,預(yù)測(cè)的對(duì)象詞匯可能不正確,特別是對(duì)于不太常見的術(shù)語(如“地球”)。當(dāng)處理遮擋對(duì)象(如“羊”)時(shí),ContextDET的魯棒性較差。我們計(jì)劃在未來的研究中解決這些局限性。

圖 7:ContextDET 在我們的三種上下文目標(biāo)檢測(cè)設(shè)置中預(yù)測(cè)的定性示例,包括 (a) 完形填空測(cè)試、(b) 圖像描述生成和 (c) 問答。其中的“哈利·波特”、“皮卡丘”和“梅西”是新出現(xiàn)的名稱,這些名稱并未在 CODE 訓(xùn)練集中標(biāo)注。ContextDET 展示了合理的上下文理解和泛化能力。

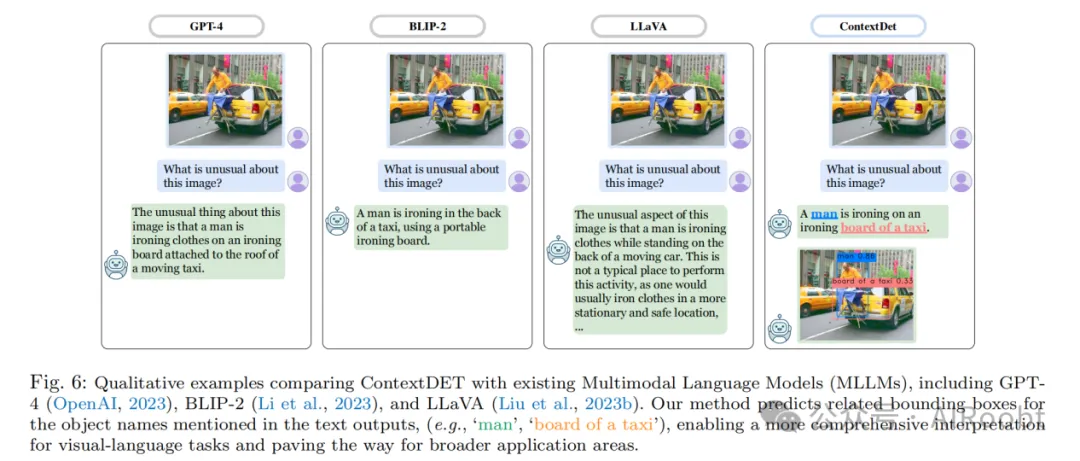

與MLLMs的比較

我們?cè)趫D6中展示了一些視覺示例,并將我們的ContextDET與一些流行的MLLMs(如GPT-4)進(jìn)行了比較。現(xiàn)有的MLLMs只能生成文本輸出,而我們的ContextDET通過提供感興趣對(duì)象的邊界框進(jìn)一步推動(dòng)了邊界。特別是,我們的方法允許對(duì)文本輸入中指定的感興趣對(duì)象進(jìn)行細(xì)粒度定位,這為視覺-語言模型提供了更高程度的可解釋性。總的來說,我們的方法為需要對(duì)象定位和對(duì)話交互的各種應(yīng)用提供了新的可能性,例如AR/VR系統(tǒng)和機(jī)器人。

6、結(jié)論

盡管最近的MLLMs在視覺-語言任務(wù)(如問答)中展示了顯著的能力,但它們?cè)诟兄蝿?wù)中的潛力仍然很大程度上未被探索。我們的ContextDET突出了MLLMs在多樣化感知任務(wù)中的巨大潛力,例如提出的上下文目標(biāo)檢測(cè)任務(wù),該任務(wù)預(yù)測(cè)圖像中精確的對(duì)象名稱及其位置以支持人機(jī)交互。為了訓(xùn)練我們的模型,我們需要將邊界框的對(duì)象詞匯與語言描述關(guān)聯(lián)起來,這帶來了高昂的標(biāo)注成本。因此,與之前的MLLM論文相比,我們使用了較少的訓(xùn)練數(shù)據(jù),這可能限制了我們的最終性能。在未來的工作中,我們計(jì)劃探索使用半監(jiān)督或弱監(jiān)督學(xué)習(xí)技術(shù)來減少標(biāo)注成本。此外,除了它們的上下文理解能力外,我們相信MLLMs的其他能力在下游任務(wù)中仍然未被充分探索,例如它們的交互能力用于指令調(diào)優(yōu)。例如,MLLMs能否用于根據(jù)人類語言指令對(duì)檢測(cè)輸出進(jìn)行后處理?通過提供諸如“將預(yù)測(cè)框稍微向左移動(dòng)”“移除冗余的重疊框”或“將預(yù)測(cè)類別從鷹更正為獵鷹”等指令,MLLMs能否相應(yīng)地調(diào)整預(yù)測(cè)以滿足我們的期望?我們希望本文提出的見解能夠激發(fā)進(jìn)一步研究,以將MLLMs應(yīng)用于更多計(jì)算機(jī)視覺任務(wù)的革命性變革。

本文轉(zhuǎn)載自公眾號(hào)AIRoobt ,作者:AIRoobt