MLLMs人類偏好增強對齊,自然圖像和數(shù)據(jù)圖表分離;視覺感知標記,模型自主決定感知內(nèi)容

OmniAlign-V: Towards Enhanced Alignment of MLLMs with Human Preference

2025-02-25|SJTU, Shanghai AI Lab, NJU, FDU, ZJU|??54

???http://arxiv.org/abs/2502.18411v1????

????https://huggingface.co/papers/2502.18411????

????https://github.com/PhoenixZ810/OmniAlign-V???

研究背景與意義

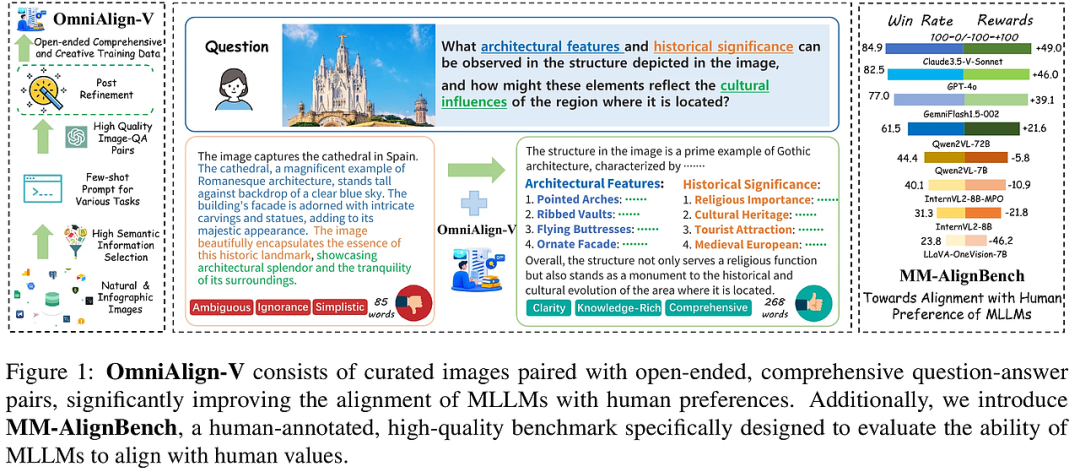

隨著多模態(tài)大語言模型(MLLMs)的快速發(fā)展,現(xiàn)有的研究主要集中在提升模型的基礎能力,如物體識別、OCR等,而在與人類偏好對齊方面存在顯著差距。這種對齊的缺失直接影響了多模態(tài)對話交互中的用戶體驗。本文提出的OmniAlign-V數(shù)據(jù)集,旨在通過提供高質(zhì)量、多樣化的訓練樣本,顯著提升MLLMs與人類偏好的對齊能力。此外,本文還引入了MM-AlignBench,一個專門設計用于評估MLLMs與人類價值觀對齊能力的高質(zhì)量基準。

研究方法與創(chuàng)新

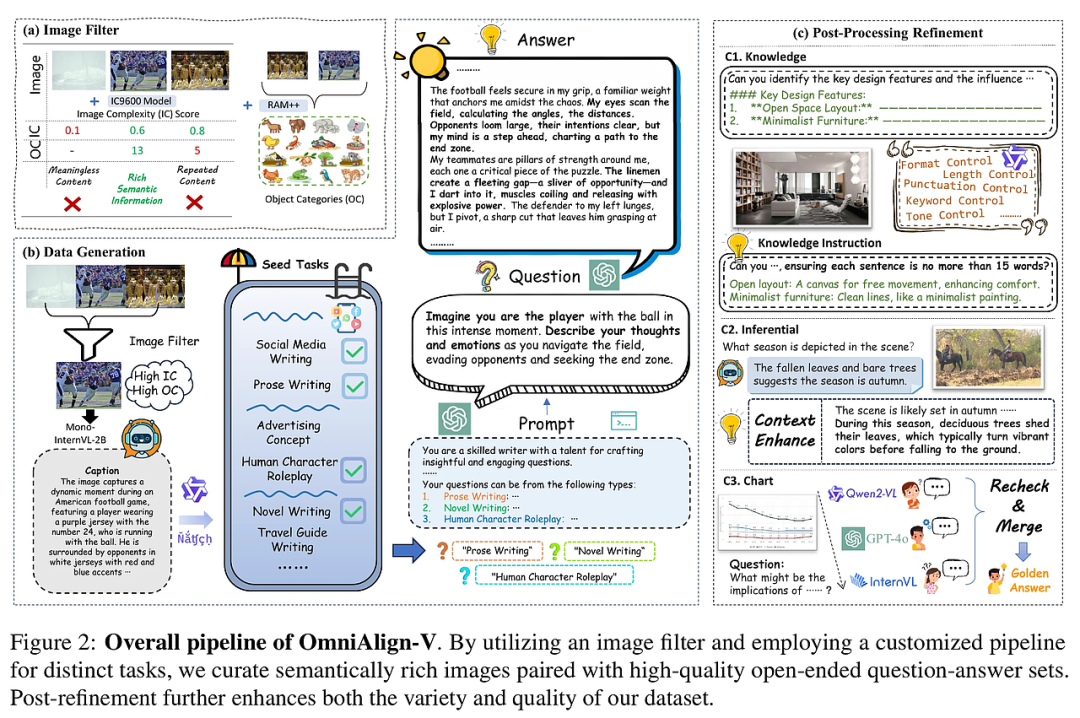

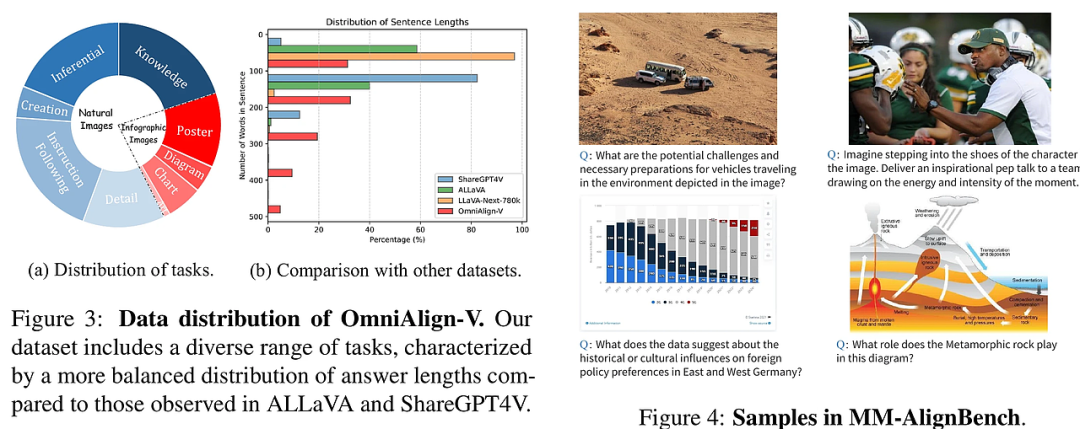

OmniAlign-V數(shù)據(jù)集的核心創(chuàng)新在于其多樣化的任務設計和高質(zhì)量的數(shù)據(jù)生成流程。首先,數(shù)據(jù)集將圖像分為自然圖像和信息圖表兩大類,并為每類圖像設計了不同的任務類型,如知識問答、推理任務和創(chuàng)造性任務。其次,通過圖像篩選策略,確保所選圖像具有豐富的語義信息,從而生成更具挑戰(zhàn)性和多樣性的問答對。

在數(shù)據(jù)生成過程中,OmniAlign-V采用了多階段的生成和優(yōu)化流程。對于自然圖像,使用GPT-4生成多樣化的問答對,并通過后處理步驟進一步優(yōu)化答案的質(zhì)量。對于信息圖表,設計了專門的提示詞,確保生成的問答對能夠深入挖掘圖像中的信息。此外,OmniAlign-V還引入了指令增強的知識問答,通過將復雜指令融入問題中,進一步提升模型的對齊能力。

實驗設計與結(jié)果分析

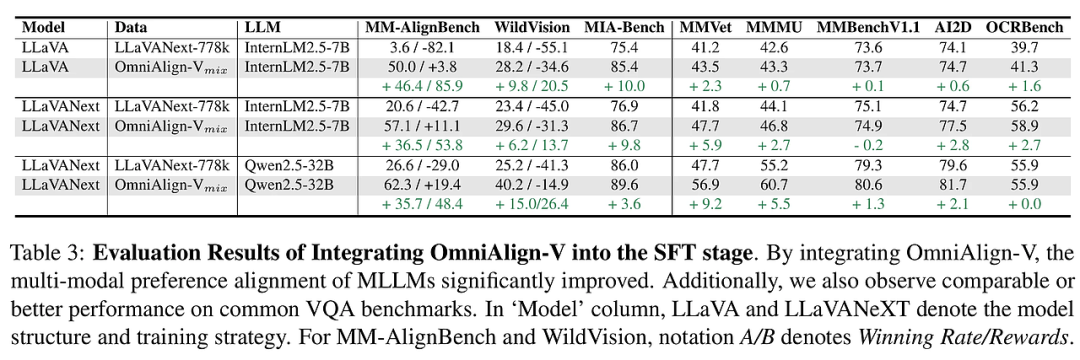

實驗結(jié)果表明,使用OmniAlign-V進行微調(diào)的MLLMs在多個基準測試中表現(xiàn)顯著提升。特別是在MM-AlignBench和WildVision等人類偏好對齊基準上,模型的性能得到了大幅改善。此外,OmniAlign-V在保持模型基礎能力的同時,進一步提升了其在復雜問答任務中的表現(xiàn)。

通過對比實驗,OmniAlign-V在多個任務類型上的表現(xiàn)均優(yōu)于現(xiàn)有的數(shù)據(jù)集。例如,在知識問答任務中,OmniAlign-V生成的問答對不僅涵蓋了廣泛的主題,還通過指令增強的方式提升了模型的指令遵循能力。在創(chuàng)造性任務中,OmniAlign-V通過多樣化的任務設計,顯著提升了模型在生成創(chuàng)意內(nèi)容方面的表現(xiàn)。

結(jié)論與展望

OmniAlign-V的引入為提升MLLMs與人類偏好的對齊能力提供了新的解決方案。通過多樣化的任務設計和高質(zhì)量的數(shù)據(jù)生成流程,OmniAlign-V顯著提升了模型在復雜問答任務中的表現(xiàn)。未來的研究可以進一步探索如何將OmniAlign-V與其他多模態(tài)數(shù)據(jù)集結(jié)合,以進一步提升模型的泛化能力和對齊效果。

此外,MM-AlignBench的引入為評估MLLMs的對齊能力提供了新的基準。通過精心設計的圖像和問題,MM-AlignBench能夠更全面地評估模型在真實世界場景中的表現(xiàn)。未來的工作可以進一步擴展MM-AlignBench的規(guī)模和多樣性,以覆蓋更多的應用場景和任務類型。

Introducing Visual Perception Token into Multimodal Large Language Model

2025-02-24|NUS|??5

???http://arxiv.org/abs/2502.17425v1????

????https://huggingface.co/papers/2502.17425????

????https://github.com/yu-rp/VisualPerceptionToken???

研究背景與意義

在當今的多模態(tài)大語言模型(MLLM)領(lǐng)域,視覺信息的處理能力直接影響模型在空間推理、細粒度理解等任務中的表現(xiàn)。然而,現(xiàn)有的MLLM系統(tǒng)缺乏自主控制其視覺感知過程的能力,例如無法選擇性地審查圖像的特定區(qū)域或聚焦于與特定對象類別相關(guān)的信息。這種局限性導致模型在處理復雜視覺任務時,往往依賴于手動設計的流程,限制了其在實際應用中的靈活性和效率。

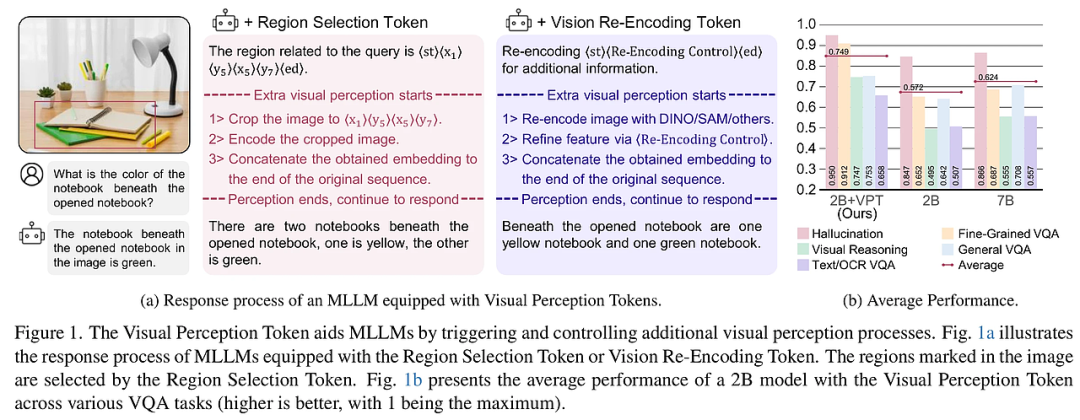

本文提出的“視覺感知標記”(Visual Perception Token)概念,旨在賦予MLLM一種機制,使其能夠自主控制視覺感知過程。通過設計兩種類型的視覺感知標記——區(qū)域選擇標記(Region Selection Token)和視覺重編碼標記(Vision Re-Encoding Token),MLLM可以像生成文本一樣生成這些標記,并利用它們觸發(fā)額外的視覺感知動作。這一創(chuàng)新不僅提升了模型在空間推理和細粒度理解任務中的表現(xiàn),還為MLLM在視覺信息處理中的自主性開辟了新的研究方向。

研究方法與創(chuàng)新

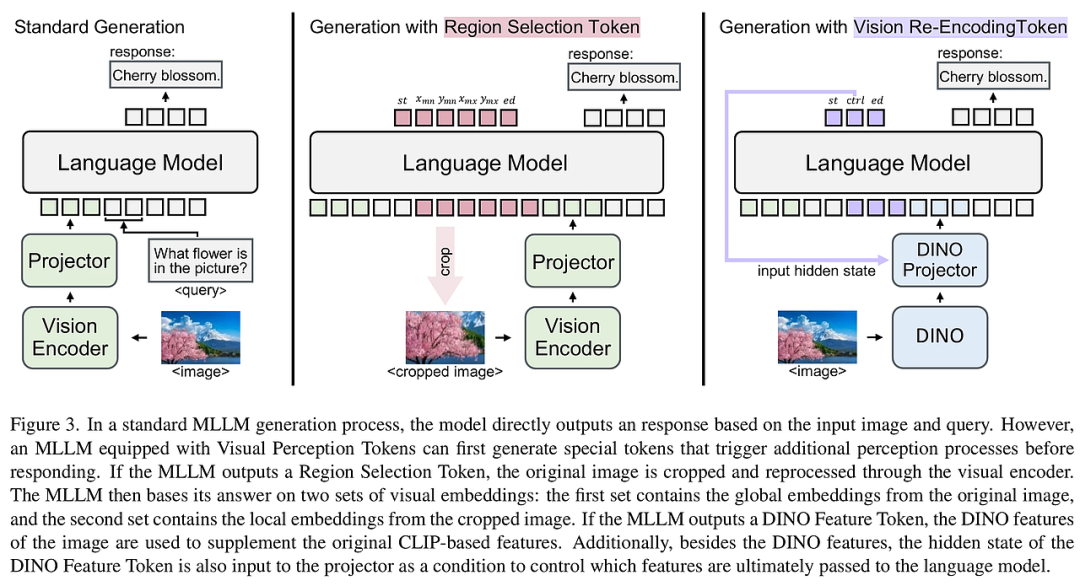

本文的核心創(chuàng)新在于引入了視覺感知標記,使MLLM能夠自主控制其視覺感知過程。具體來說,區(qū)域選擇標記能夠明確識別圖像中需要進一步感知的特定區(qū)域,而視覺重編碼標記則利用其隱藏狀態(tài)作為控制信號,引導額外的視覺感知過程。這兩種標記的引入,使得MLLM在處理視覺信息時,能夠更加靈活和精準。

區(qū)域選擇標記區(qū)域選擇標記通過將圖像劃分為若干單元格,并使用這些單元格的索引來描述需要進一步感知的區(qū)域。這種方法避免了直接使用像素坐標的復雜性,簡化了模型的訓練過程。具體來說,模型生成一組區(qū)域選擇標記,指示圖像中需要裁剪的區(qū)域,然后將裁剪后的圖像重新輸入模型進行進一步處理。這種方法在處理文檔理解、OCR相關(guān)任務時尤為有效,因為它能夠直接提高圖像的分辨率,從而提升任務表現(xiàn)。

視覺重編碼標記視覺重編碼標記則通過觸發(fā)額外的視覺編碼器(如DINO或SAM模型)來重新編碼原始圖像,并將生成的視覺特征與原始視覺特征結(jié)合,輸入到MLLM中。視覺重編碼標記的隱藏狀態(tài)作為控制信號,能夠精細地控制最終輸入到語言模型的嵌入序列。這種方法在處理需要多次視覺感知的任務時,表現(xiàn)出顯著的優(yōu)勢。

訓練數(shù)據(jù)與模型架構(gòu)為了訓練MLLM使用視覺感知標記,本文構(gòu)建了一個包含829k樣本的訓練數(shù)據(jù)集,涵蓋了通用視覺問答(General VQA)、細粒度視覺問答(Fine-Grained VQA)、空間推理(Spatial Reasoning)和文本/OCR相關(guān)視覺問答(Text/OCR-Related VQA)等任務。模型架構(gòu)方面,本文在標準的MLLM基礎上,增加了額外的視覺編碼器和投影器,使得模型能夠處理視覺重編碼標記生成的額外視覺特征。

實驗設計與結(jié)果分析

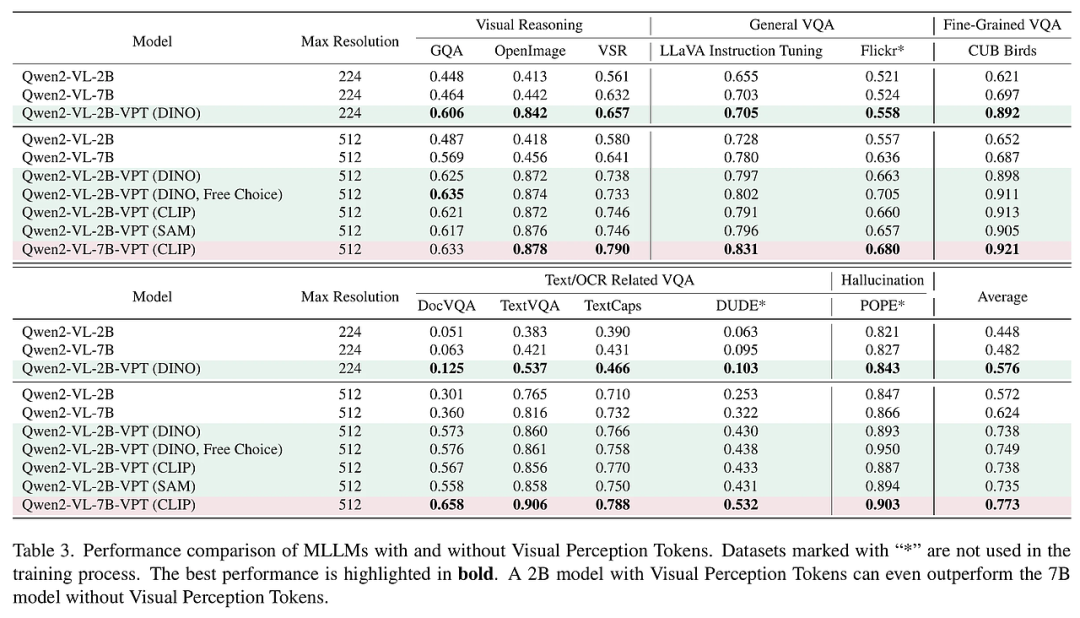

本文通過一系列實驗驗證了視覺感知標記的有效性。實驗結(jié)果表明,引入視覺感知標記后,2B參數(shù)的模型在多個任務中的表現(xiàn)顯著提升,甚至超過了7B參數(shù)的基線模型。具體來說,在空間推理和細粒度視覺問答任務中,2B+VPT模型的性能分別提升了34.6%和32.7%。此外,視覺感知標記在零樣本設置下也表現(xiàn)出色,進一步證明了其泛化能力。

實驗結(jié)果在通用視覺問答任務中,2B+VPT模型的表現(xiàn)與7B模型相當,但在空間推理和細粒度視覺問答任務中,2B+VPT模型顯著優(yōu)于7B模型。例如,在CUB-200-2011數(shù)據(jù)集上,2B+VPT模型的性能提升了20.7%。此外,在處理低分辨率圖像時,2B+VPT模型的表現(xiàn)也優(yōu)于7B模型,證明了視覺感知標記在不同分辨率下的有效性。

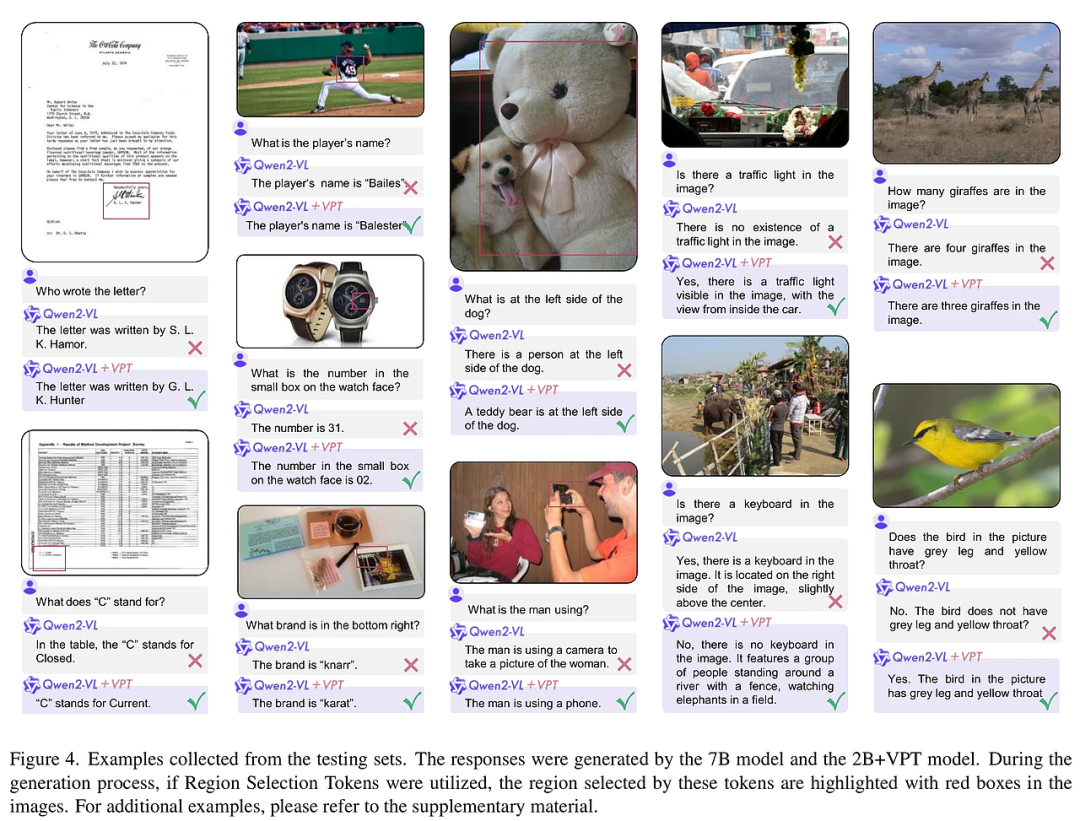

案例分析通過具體案例的分析,本文展示了視覺感知標記在處理復雜視覺任務時的優(yōu)勢。例如,在處理文檔理解任務時,區(qū)域選擇標記能夠精確定位圖像中的小區(qū)域(如簽名、頁腳等),從而顯著提升OCR任務的準確性。在處理空間推理任務時,視覺重編碼標記能夠通過多次視覺感知,增強模型對空間關(guān)系的理解。

結(jié)論與展望

本文提出的視覺感知標記為MLLM在視覺信息處理中的自主性提供了新的解決方案。通過區(qū)域選擇標記和視覺重編碼標記,MLLM能夠更加靈活和精準地處理視覺信息,顯著提升了其在空間推理、細粒度理解等任務中的表現(xiàn)。未來的研究方向可以進一步探索視覺感知標記在其他多模態(tài)任務中的應用,以及如何通過更復雜的控制機制,進一步提升MLLM的視覺感知能力。

此外,本文的實驗結(jié)果表明,視覺感知標記在處理低分辨率圖像時也表現(xiàn)出色,這為在資源受限環(huán)境下的應用提供了新的可能性。未來的工作可以進一步優(yōu)化視覺感知標記的訓練過程,探索如何在不增加模型參數(shù)的情況下,進一步提升其性能。

總之,視覺感知標記的引入為MLLM在視覺信息處理中的自主性開辟了新的研究方向,具有廣泛的應用前景。

本文轉(zhuǎn)載自 ??AI研究前瞻??,作者: 胡耀淇