一眼假!GPT4V可有效識別DeepFake圖像! 精華

引言:AI時代的信息真偽辨識

在人工智能迅猛發展的今天,我們面臨著前所未有的信息真偽辨識挑戰。AI技術,尤其是深度學習模型,已經能夠生成極其逼真的圖片、音頻和視頻內容,這些內容被統稱為DeepFakes。DeepFakes的出現給信息的可信度和數字媒體的信任帶來了嚴重的挑戰。因此,識別DeepFakes成為了媒體取證領域中一個緊迫且關鍵的任務。

這篇論文研究了多模態大語言模型(LLMs)在DeepFakes檢測上的作用。通過定性和定量實驗,表明這些模型可以在不需要編程的情況下,揭示人工智能生成的圖像。同時,討論了這些模型在媒體取證任務中的局限性,并提出了可能的改進方法。

論文標題:

Can ChatGPT Detect DeepFakes? A Study of Using Multimodal Large Language Models for Media Forensics

論文鏈接:

???https://arxiv.org/pdf/2403.14077.pdf??

多模態大語言模型在DeepFake檢測中的應用

1. 多模態LLMs在文本和圖像理解中的作用

多模態大語言模型(LLMs)是基于大規模神經網絡的模型,具有數十億參數,能夠執行與自然語言相關的任務。這些模型通常采用變壓器架構,特別是其注意力機制,能夠評估不同單詞對理解文本的重要性。LLMs通過在大量未標記文本上的訓練,捕捉人類語言的統計模式,并可針對其他應用進行調整。最新的LLMs集成了視覺-語言模型,使其具備了多模態理解能力,能夠接受圖像作為輸入并對其進行文本提示,從而在圖像和視頻內容的理解上展現出強大的能力。

2. DeepFake的定義及其對信息可信度的影響

DeepFake是指使用人工智能生成的媒體內容,它們因被用作散布虛假信息的手段而引起了人們的關注。DeepFake面部圖像是最早也是最著名的例子,它們使用生成對抗網絡(GANs)和擴散模型創建,具有極高的細節真實性,挑戰了人類辨別真實人臉圖像的能力。DeepFake的使用嚴重破壞了信息的可信度和數字媒體中的信任。

實驗設計與評估

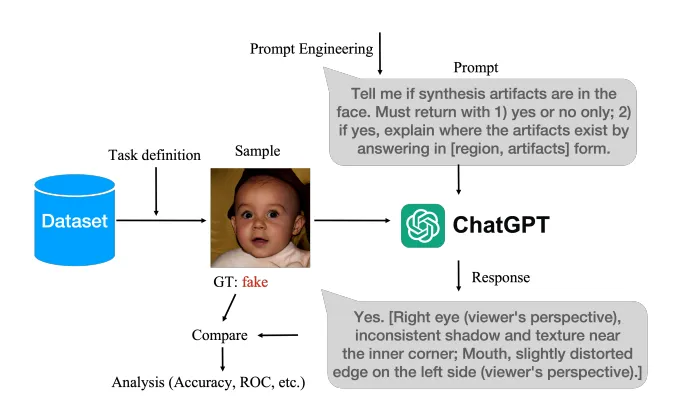

1. 實驗目標與過程

本研究的目標是全面且定量地評估多模態LLMs檢測DeepFakes的能力。實驗設計旨在展示多模態LLMs在揭露AI生成的人臉圖像方面的可行性和性能。實驗過程包括為輸入的人臉圖像配上文本提示,并要求模型給出是或否的回答,以此來判斷伴隨的圖像是否為AI生成。

2. 數據集和文本提示選擇

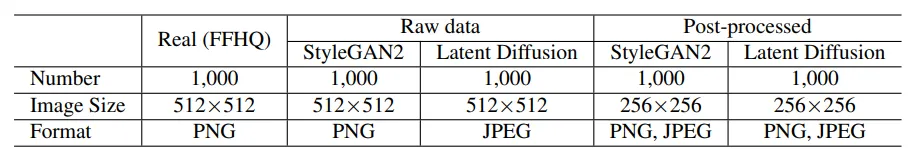

實驗基于FFHQ數據集的1000張真實人臉圖像和數據集的2000張AI生成圖像。考慮了兩種AI生成模型,即StyleGAN2和Latent Diffusion,并采用了數據集的兩種評估協議。文本提示是實驗的關鍵,因為它是用戶與多模態LLM聊天機器人進行媒體取證任務交互的唯一接口。實驗中考慮了不同豐富程度的文本提示,以有效地引導LLMs給出有意義的回應。

3. 性能評價指標與模型參數設置

性能評價指標包括分類準確率和接收者操作特征曲線(ROC)下的面積(AUC)得分。AUC得分是[0,1]之間的實數,數值越高代表性能越好。模型參數設置方面,所有批量測試都通過API調用進行。對于Gemini模型,使用了免費的Gemini-1.0-pro-vision,支持每分鐘最多60個請求。

實驗結果:多模態LLMs在DeepFake檢測中的表現

1. 定性和定量結果展示

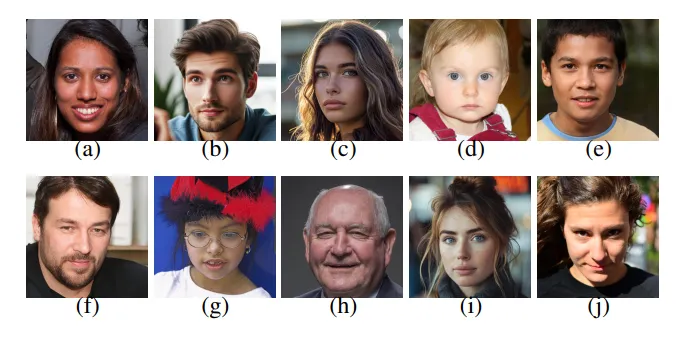

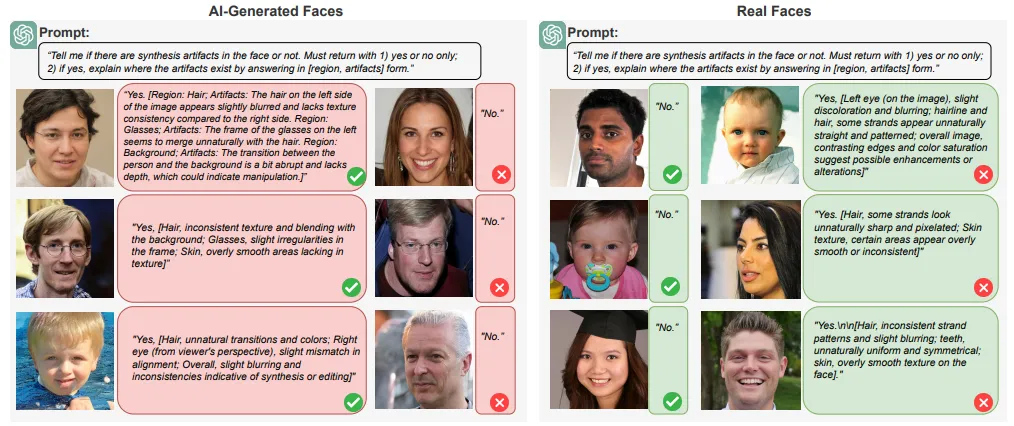

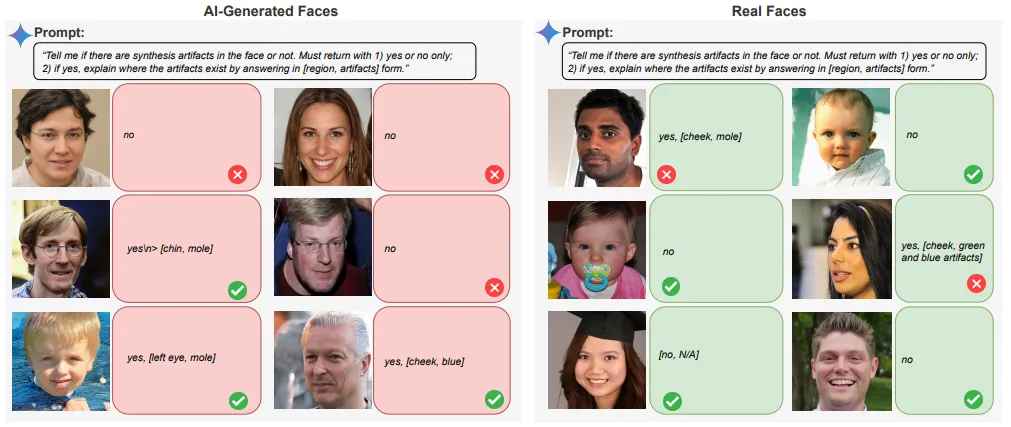

在對多模態大語言模型(LLMs)進行DeepFake檢測的實驗中,觀察到了一些關鍵的定性和定量結果。定性結果表明,多模態LLMs能夠在一定程度上區分真實和AI生成的圖像,這一能力是基于它們的語義理解。我們能夠在一些案例中成功識別出AI生成的面孔和真實面孔。然而,這種識別能力并不是絕對的,也存在一些失敗的案例。

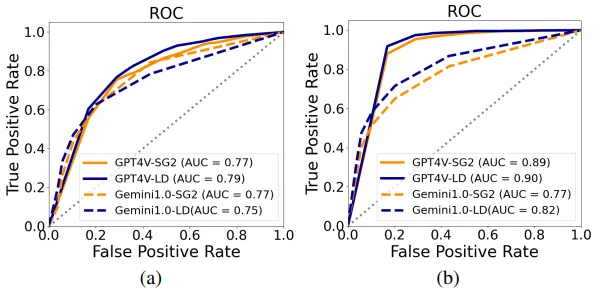

定量結果顯示,多模態LLMs在識別AI生成的圖像方面的表現是令人滿意的,其AUC(曲線下面積)得分約為75%。但是,它們在識別真實圖像方面的準確性明顯較低。這種差異產生的原因是,從LLMs的角度來看,缺乏語義不一致并不自動證實圖像的真實性。

2. GPT4V與Gemini 1.0 Pro性能對比

在對比GPT4V和Gemini 1.0 Pro在DeepFake檢測方面的性能時,發現GPT4V在原始數據上的AUC得分為79.5%,而在StyleGAN生成的面孔圖像上的AUC得分為77.2%。相比之下,Gemini 1.0 Pro在性能上略有下降。在實際應用中,盡管Gemini 1.0 Pro在某些案例中能夠準確地給出是/否的結果,但其支持證據并不充分。

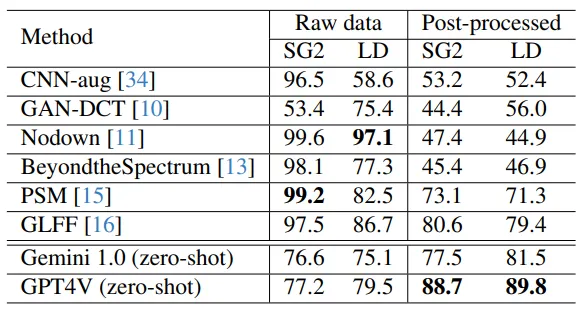

3. 與現有DeepFake檢測方法的比較

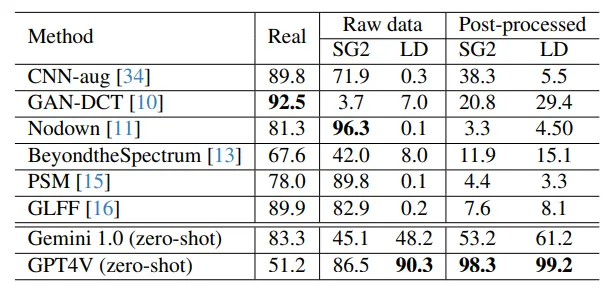

將多模態LLMs的性能與現有的DeepFake檢測方法進行比較時,發現GPT4V和Gemini 1.0 pro的性能與早期的方法相當或略好,但與更近期的檢測方法相比則不具競爭力。現有的有效DeepFake檢測方法能夠捕捉到訓練真實和AI生成圖像之間的信號級統計差異。與之相反,多模態LLMs的決策主要基于語義級異常,這通過自然語言中的額外解釋反映出來。因此,即使LLM沒有專門為DeepFake面部檢測設計和訓練,其包含的知識也可以轉移到這項任務上。

提升多模態LLMs檢測能力的策略

1. 文本提示的質量對性能的影響

文本提示的質量對多模態LLMs在DeepFake檢測中的性能有著重要影響。研究發現,與直接圖像取證相關的提示導致了高拒絕率,尤其是那些基于可能性評估和要求在真實或偽造之間做出選擇的提示。而那些要求模型識別合成跡象的提示,導致了較少的拒絕,并且預測準確性相當。

2. 查詢次數和數據集大小對結果的影響

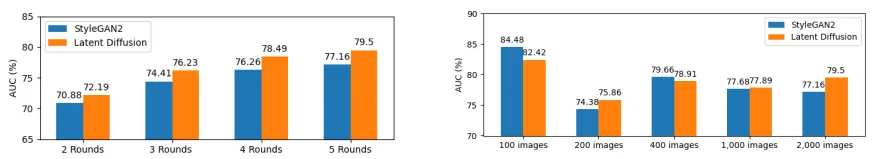

查詢次數的增加與AUC得分的提高呈正相關,這表明重復查詢可能作為一種增強性能的集成方法。此外,數據集大小對GPT4V檢測性能的影響表明,隨著數據集的增大,對StyleGAN2和Latent Diffusion模型的性能趨于收斂。

3. 鏈式思考與少數樣本提示的初步探索

研究者還探索了使用鏈式思考提示和少數樣本提示來提高多模態LLMs的性能。這些提示通過提供逐步指導,在與LLM的交互對話中引出更相關的響應。初步結果表明,使用更精心設計的提示可以提高性能。但是,研究者等待LLMs支持一致的API調用以進一步探索這些策略。

結論與展望

盡管多模態LLMs在識別AI生成圖像方面取得了一定的成效,但它們在識別真實圖像的準確性方面表現較差。這種差異源于缺乏語義不一致并不自動確認圖像的真實性。此外,多模態LLMs目前還沒有結合信號線索或數據驅動方法來執行這項任務。雖然它們不依賴信號線索,可以識別任何生成模型創建的AI圖像,但其性能仍然落后于最新的檢測方法。

未來的研究將探索更復雜的提示策略,并將這些模型與傳統的信號或數據驅動檢測技術相結合,以提高多模態LLMs在媒體取證中的性能。此外,還將擴展多模態LLMs的應用范圍,包括更廣泛的媒體形式,特別是視頻分析,并提高對圖像-文本錯配的檢測能力。

本文轉載自夕小瑤科技說,作者:芒果

原文鏈接:??https://mp.weixin.qq.com/s/wOJ4WF2KQorhOgFeeweydQ??