“最強具身VLA大模型”,究竟強在哪兒?

看似輕描淡寫,實則力透紙背。

Physical Intelligence刷屏全網的機器人基礎模型π*0.6,一亮相就秀出了實力:

讓機器人連續一整天制作意式濃縮咖啡,數小時不間斷折疊各類衣物,還能精準組裝工廠所需的包裝紙箱。

在π*0.6的加持下,這些任務的成功率都達到了90%以上。

然而,仔細閱讀論文就會發現,比起連做13個小時咖啡,π*0.6真正的突破在于引入了一種更直覺的學習方法——Recap:

- 指導:用人類示范教它基礎動作

- 輔導:糾錯指導讓它修正錯誤

- 練習:從自主經驗中不斷優化、變得更強

這徹底扭轉了過去機器人只會逼近 “真值” 的模仿學習模式,讓機器人能從自己的錯誤中成長。

就連網友也直呼:

從錯誤中學習,這不比人都強?

最強VLA模型——π*0.6

π*0.6延續了Physical Intelligence此前一貫的VLA(視覺-語言-動作模型)路線,是今年四月份發布π0.5以來最新的VLA模型。

總的來說,π*0.6的核心貢獻在于提出了一種通用訓練方法——基于優勢條件策略的經驗與糾偏強化學習(RL with Experience & Corrections via Advantage-conditioned Policies,RECAP)。

RECAP讓VLA能夠使用獎勵反饋和人類介入進行訓練,其主要包含三個階段:

- 離線RL:基于多機器人、多任務的示范數據(包括失敗數據)訓練價值函數和策略

- 微調:用人類示范將π*0.6適配到具體任務(咖啡/折衣服/組裝盒子)

- 在線階段:機器人自主執行任務,獲得稀疏獎勵,并結合專家在線糾偏,更新價值函數,再通過優勢條件化改進策略

接下來,讓我們具體來看。

首先,對于為什么RECAP選擇價值函數,而不是標準的策略梯度,這里有個關鍵的巧思。

一方面,真實機器人數據極度異構:包括人類示范、專家干預、以及機器人在不同策略下的執行軌跡。標準的策略梯度方法需要on-policy的新鮮數據,難以有效吸收這些歷史混合數據,因此天然不適合具身場景。

另一方面,VLA模型基于Flow Matching生成連續動作,這類模型沒有顯式的log π(a|s),導致無法像傳統策略那樣對直接求梯度。

換句話說,PPO、REINFORCE 這些算法在這種模型結構上根本施展不開。

因此,RECAP沒有走傳統RL的路線,而是采用了一個巧妙的“優勢條件化”策略:

模型仍按監督學習方式訓練,但額外給它一個輸入,告訴它當前動作的優勢值(advantage)。優勢越高,代表“這個動作更值得模仿”。

于是整個流程變成了:

價值函數負責評價 → 優勢條件化負責表達 → VLA用監督學習吸收所有數據

換句話說,RECAP用價值函數判斷動作質量,再用優勢條件化把原本需要RL求解的策略更新,重新寫成了大模型最擅長的監督學習問題。

訓練價值函數與策略提取:

為了讓模型從異構數據中學習,首先需要訓練一個能夠識別“好壞”的價值函數。無論數據來自哪里(演示或自主嘗試),處理過程如下:

- 計算經驗回報:對每條軌跡,從當前時間步到結束計算累計回報,并歸一化、離散化成201個區間,為價值函數提供訓練目標。

- 訓練分布式價值函數:用多任務分布式價值函數預測離散價值分布,通過最小化交叉熵損失進行訓練,再提取連續價值函數,得到每個狀態-動作的實際價值。

- 計算優勢(advantage):用動作的實際回報減去價值函數預測,得到優勢值,并二值化形成高/低優勢指標,作為策略訓練的額外輸入,引導模型選擇更優動作。

有了優勢信號,我們就能實現高效的策略提取。這種方法完美滿足了前文提到的對離線RL的需求:

- 充分利用多樣化的離策略數據:包括最初的人類示范、專家干預,以及機器人自主執行的軌跡(既有最新策略的,也有早期策略的)。

- 可擴展性:方法需要能夠應用于大型VLA模型,包括那些使用流匹配(flow matching)或擴散(diffusion)生成動作的模型。

- 同時利用優劣數據:既要有效利用近似最優的動作,也要利用次優動作的數據,這對于通過自主經驗提升策略尤其重要。

通過這種設計,RECAP成功地在不依賴昂貴在線PPO更新的情況下,利用混合質量的離線數據實現了機器人的自我進化。

在線階段:專家糾錯 + 自主經驗

在機器人自主執行階段,RECAP通過兩類數據持續優化策略:

- 專家糾錯:專家遠程干預糾正嚴重錯誤(如紙箱折疊順序顛倒),每一次糾錯動作都會被標記為“正向優勢”,訓練模型學習如何恢復錯誤。

- 自主經驗:模型自主完成的軌跡,無論成功還是失敗,都納入訓練數據。通過價值函數和優勢指標,自動篩選有效信號,優化精細動作。

模型架構與性能

π*0.6是在π0.6基礎上構建的,而π0.6又是對π0.5的升級版本。

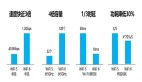

π0.6的Backbone從Pi0、π0.5的Gemma(2.6B)擴展到Gemma3(4B),Action Expert參數量也升級到了860M。

在模型架構方面,π0.6延續了π0和π0.5架構,通過流匹配(flow matching) 和離散動作token 輸出生成動作片段。

從實驗來看,研究團隊在三個高難度的現實任務中評估了模型:折疊多樣化的衣物、組裝紙箱(工廠環境)和制作濃縮咖啡。

在最難的任務(如折疊多樣化衣物和制作咖啡)中,RECAP將任務的吞吐量(每小時成功次數)提高了一倍以上,相比于僅進行監督微調(SFT)的模型,RECAP將任務失敗率降低了約2倍。

與此同時,模型表現出極高的穩定性,例如連續13小時制作咖啡、連續2小時折疊衣物而無需人為重置。

從失敗經驗中學習

正如開頭提到的,Recap最具啟發性的地方,莫過于它讓機器人能夠從錯誤經驗中學習。

俗話說“失敗乃成功之母”,但在傳統的模仿學習,乃至更廣泛的監督學習中,逼近真值或最優解通常被認為是最直接、最有效的策略。

這種方法在大規模語言模型(LLM)和其他機器學習系統上確實表現出色,數學上也簡潔優雅。

然而,對于現實世界的機器人,僅僅知道如何做對,卻不知道如何從錯誤中恢復,就會成為關鍵障礙。

在LLM等生成靜態輸出的AI系統中,監督學習假設數據是獨立同分布(i.i.d.),預測輸出不會影響后續輸入,因此偶爾的偏差不會帶來致命問題。

但對于需要持續與外界互動的系統,例如機器人,情況則完全不同。

模仿學習中模型的每一次動作都會影響未來狀態,一旦出現輕微錯誤,就可能進入訓練數據未覆蓋的新狀態,從而觸發滾雪球式誤差。這些錯誤疊加后,任務可能徹底失敗。

因此,要想讓機器人“每次都成功”,光靠復制示范數據是不夠的。

解決之道在于:讓視覺-語言-動作(VLA)模型能夠從自身實際犯過的錯誤中學習,就像人類通過練習不斷糾正失誤一樣。

問題在于,這些經歷該如何標注?如果簡單地讓模型復制過去的行為,它只會學會重復錯誤。關鍵是如何從“壞數據”中提煉出有效的訓練信號。

Recap通過指導中輔以糾正,練習中輔以強化來實現這一點:

教練式糾偏(corrections)當機器人犯錯時,專家通過遙操作介入,示范如何恢復、如何更好地完成任務。

不同于傳統的示范教學,這里不是教“該怎么做”,而是教“當事情出錯時該如何修正”。

這種針對性糾偏彌補了傳統模仿數據的不足,是防止錯誤累積的關鍵。

強化學習(reinforcement learning)

然而,僅僅依靠人類提供糾正措施是遠遠不夠的,機器人需要自主學習。

機器人需要根據一個回合的總體結果自行判斷其行為的好壞,并迭代地學習執行好的行為,同時避免壞的行為。

由此,就引出了基于對錯獎勵的強化學習。

如上文所說,為了實現強化學習,核心在于解決信用分配(credit assignment)的問題。

比如,要知道機器人執行的哪些動作導致了好的結果,哪些動作導致了壞的結果。

這里,Recap通過訓練一個價值函數(value function)來應對這一挑戰,它可以預測當前狀態相較于其他狀態的優劣。

△圖源:Reinforcement learning: An introduction

舉例來說,在經典的格子世界中,智能體會通過一次次嘗試更新每個狀態的價值:落在好格子上,價值提高;掉進壞格子里,價值降低。

隨著價值評估逐漸準確,智能體自然會傾向于選擇那些通向高價值狀態的動作。

同樣的邏輯放到機器人身上:價值函數的變化為模型提供了一個簡單而強大的判斷信號。

- 讓價值上升的動作:代表機器人朝任務成功更近了一步,應當被強化;

- 讓價值下降的動作:意味著偏離目標,需要被抑制或修正。

舉例來說,在折疊衣服任務中(左圖),紅色區域表示機器人突然將衣服拉起的錯誤動作,對應價值下降;而綠色區域表示機器人正確完成折疊時,價值上升。

可以說,價值函數幫助機器人識別“關鍵步驟”與“錯誤來源”,讓它真正具備在復雜真實環境中從經驗中變強的能力。

當訓練好價值函數后,下一步是“策略抽取”:讓策略(即VLA模型)以價值變化為條件進行訓練。

所有數據——包括成功和未成功——都被保留,同時告知模型哪些動作是有效的、哪些動作應避免。

這種優勢條件化(advantage-conditioned)訓練能夠讓模型在保留全部經驗的前提下,從失敗中學習,從而表現超越單純示范數據的水平。

綜上,Recap不僅讓機器人學會了執行任務,更重要的是,它讓機器人學會了自我糾正和優化策略,為后續復雜任務的魯棒性和效率提升提供了可擴展的解決方案。

與此同時,如果從好數據(示范)少,壞數據(錯誤經驗)多的視角來看,π*0.6 的突破可能更具深遠意義 ——

它證明了機器人能從真實執行中收集的 “不完美經驗” 里,提煉出高效的學習信號,這也為后續機器人研究開辟了全新思路,提供了極具價值的探索方向。