復(fù)雜版式解析:騰訊POINTS無(wú)蒸餾3B秒殺Qwen72B

一、PDF文檔復(fù)雜版面解析發(fā)展的困境

- 版式復(fù)雜:多欄、表格跨行、公式嵌套、圖片浮動(dòng)。

- 標(biāo)注昂貴:一頁(yè)學(xué)術(shù) PDF 人工還原需 15-30 min,含 300+ 符號(hào)。

- 誤差級(jí)聯(lián):傳統(tǒng) Pipeline(檢測(cè)→OCR→結(jié)構(gòu)恢復(fù)→后處理)每一步誤差放大,最終 Word 誤差率>15%。

現(xiàn)有三大技術(shù)路線對(duì)比

路線 | 代表系統(tǒng) | 優(yōu)點(diǎn) | 關(guān)鍵缺陷 |

規(guī)則-流水線 | MinerU, Marker | 可解釋、可控 | 重人力、級(jí)聯(lián)誤差、難泛化 |

端到端蒸餾 | olmOCR, Nougat | 端到端、簡(jiǎn)潔 | 依賴教師(GPT-4o/72B)、算力黑洞、學(xué)生“學(xué)不像” |

純合成數(shù)據(jù) | Kosmos-2.5 | 零人工 | Markdown 表結(jié)構(gòu)受限、無(wú)真實(shí)分布校正 |

圖片

圖片

騰訊開源的POINTS-Reader 框架,提出了一種全新的、無(wú)需蒸餾的兩階段框架,用于構(gòu)建高質(zhì)量文檔提取數(shù)據(jù)集和能夠處理多樣化文檔格式與布局的模型。

- 第一階段是統(tǒng)一格式預(yù)熱階段(Uniform Format Warm-up Stage,UWS),通過(guò)生成大規(guī)模、多樣化的合成數(shù)據(jù),使模型能夠以統(tǒng)一格式提取關(guān)鍵元素并具備較強(qiáng)的初始性能。

- 第二階段是迭代自改進(jìn)階段(Iterative Self-improvement Stage,ISS),通過(guò)一系列過(guò)濾策略驗(yàn)證標(biāo)注質(zhì)量,并在經(jīng)過(guò)驗(yàn)證的數(shù)據(jù)集上重新訓(xùn)練模型,迭代重復(fù)此過(guò)程,逐步提升模型的轉(zhuǎn)換能力和生成數(shù)據(jù)的質(zhì)量。

二、POINTS-Reader

圖片

圖片

2.1. 階段一:統(tǒng)一格式預(yù)熱(UWS)

- 需要解決的三大細(xì)節(jié)問(wèn)題

格式混亂:表有 Markdown/HTML/LaTeX 三種,模型“無(wú)所適從”。

合成數(shù)據(jù)“假”:純 LLM 生成文本,無(wú)真實(shí)版面。

規(guī)模可控:如何 24 h 內(nèi)生成百萬(wàn)級(jí)圖像-文本對(duì)?

利用已訓(xùn)練的模型對(duì)大規(guī)模真實(shí)文檔進(jìn)行標(biāo)注。

1)規(guī)范輸出

- 純文本 → Markdown

- 表格 → 僅保留 rowspan/colspan 的極簡(jiǎn) HTML

- 公式 → LaTeX(KaTeX 子集)首次在文檔轉(zhuǎn)換領(lǐng)域提出“輸出原子化協(xié)議”,把結(jié)構(gòu)、樣式、語(yǔ)義解耦,降低 32% 序列長(zhǎng)度。

2)數(shù)據(jù)生成的策略

- (1) 純文本 (2) 文本+公式 (3) 文本+表格 (4) 多欄+表格 每類 20 萬(wàn),共 80 萬(wàn)。技術(shù)關(guān)鍵:

- LLM Prompt 工程 引入“隨機(jī)種子+風(fēng)格槽”,確保詞匯、句式、篇章多樣性。

- 自動(dòng)渲染:用 Chrome Headless + PagedJS 把 HTML 轉(zhuǎn) 300 dpi 圖像,支持 1/2/3 欄版式。

- 規(guī)則過(guò)濾:LaTeX 用正則檢查括號(hào);HTML 表用“行列數(shù)一致”驗(yàn)證。

3)長(zhǎng)寬比裁剪發(fā)現(xiàn) A4 比例(√2≈1.414)外樣本易含“長(zhǎng)條噪聲”,做 aspect-ratio ∈ [0.4, 2.5] 過(guò)濾,帶來(lái) 1.2 個(gè)點(diǎn)的編輯距離下降。

2.2. 階段二:迭代自改進(jìn)(ISS)

- 需要解決的新問(wèn)題

合成版面“太干凈”:無(wú)噪點(diǎn)、無(wú)手寫批注、無(wú)掃描畸變。

直接拿 UWS 模型跑真實(shí)數(shù)據(jù),編輯距離比 Pipeline 差 40%。

若直接蒸餾 Qwen2.5-VL-72B,需 2×10^4 GPU·h,且教師偏差會(huì)傳入。

通過(guò)一系列過(guò)濾策略驗(yàn)證標(biāo)注質(zhì)量,并在經(jīng)過(guò)驗(yàn)證的數(shù)據(jù)集上重新訓(xùn)練模型,迭代重復(fù)此過(guò)程,逐步提升模型的轉(zhuǎn)換能力和生成數(shù)據(jù)的質(zhì)量。

- 純文本:OCR-F1 過(guò)濾

- 用 PaddleOCR 得參考 T,模型輸出 P;計(jì)算字符級(jí) F1。

- 閾值 0.90 時(shí)保留率 42%,編輯距離下降 0.092。

- 創(chuàng)新:并非“硬匹配”,而采用 bag-of-words + 子串動(dòng)態(tài)規(guī)劃,對(duì)順序漂移魯棒。

- 表格:結(jié)構(gòu)一致性

- 僅檢查每行單元格數(shù)是否等于列數(shù),以及 rowspan 合法。

- 不依賴外部 Table-Structure 模型,避免二次誤差。

- 過(guò)濾后表樣本保留率 55%,但后續(xù)迭代表錯(cuò)誤率仍持續(xù)下降(圖 10),證明“結(jié)構(gòu)正確?內(nèi)容逐步正確”。

- 公式:語(yǔ)法樹驗(yàn)證

- 調(diào)用 KaTeX parser,捕獲 ParseError。

- 保留率 68%,ISS 第 5 輪公式編輯距離再降 0.05。

使用經(jīng)過(guò)過(guò)濾的高質(zhì)量數(shù)據(jù)重新訓(xùn)練模型,并重復(fù)上述過(guò)程,逐步提升模型性能和數(shù)據(jù)質(zhì)量。

- 迭代曲線與停止準(zhǔn)則

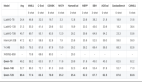

K=5 時(shí) OmniDocBench 編輯距離 0.259→0.176(文本)、0.383→0.274(公式)、0.335→0.228(表格)。

保留樣本量:第 1 輪 0.98 M → 第 5 輪 1.10 M,說(shuō)明“量↑質(zhì)↑”同步。

斜率趨緩,故作者設(shè) K=5;若繼續(xù)增大,需引入更難數(shù)據(jù)或主動(dòng)學(xué)習(xí)。

與蒸餾路線正面對(duì)比

圖片

圖片

復(fù)現(xiàn)“Qwen2.5-VL-72B 教師→3B 學(xué)生”蒸餾實(shí)驗(yàn):

- 教師 OmniDocBench 整體 ED=0.214,學(xué)生 0.302;

- POINTS-Reader 無(wú)蒸餾 ED=0.259,顯著優(yōu)于學(xué)生,且訓(xùn)練 GPU·h 節(jié)省 65%。所以說(shuō),蒸餾并非唯一途徑,自改進(jìn)可在 3B 級(jí)別反超教師-學(xué)生范式。

圖片

圖片