4o-mini只有8B,Claude 3.5 Sonnet有175B,微軟論文「透露」了下頂級(jí)模型參數(shù)

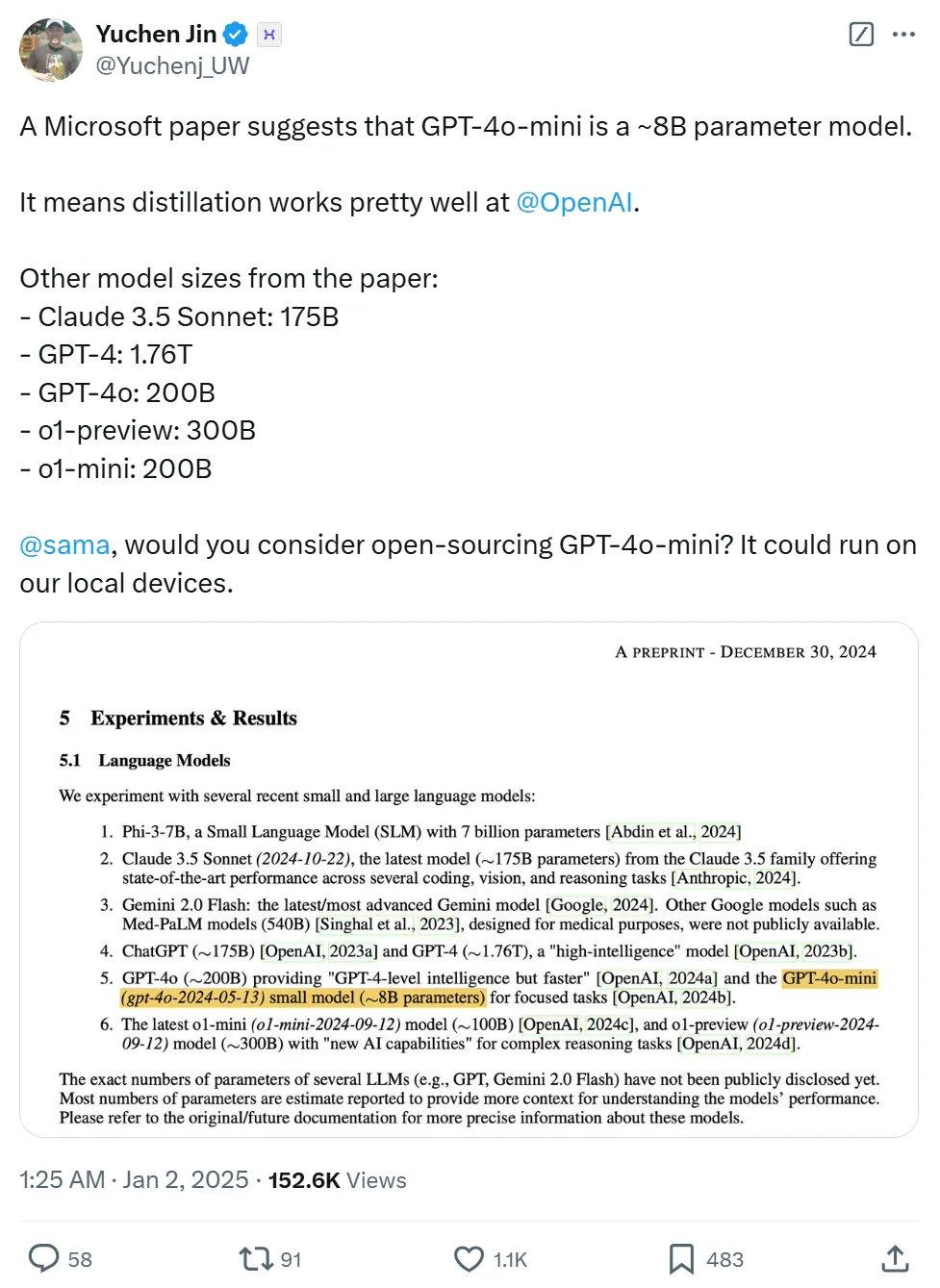

剛剛,X 上的一則推文受到了大家的廣泛討論,瀏覽量迅速增長。原來,OpenAI 發(fā)布的 GPT-4o-mini 居然是一個(gè)僅有 8B 參數(shù)的模型?

圖源:https://x.com/Yuchenj_UW/status/1874507299303379428

事情是這樣的。就在前幾天,微軟和華盛頓大學(xué)合作完成了一篇論文《MEDEC: A BENCHMARK FOR MEDICAL ERROR DETECTION AND CORRECTION IN CLINICAL NOTES 》。

論文地址:https://arxiv.org/pdf/2412.19260

論文地址:https://arxiv.org/pdf/2412.19260

這篇論文主要介紹了一個(gè)用于檢測(cè)和糾正臨床記錄中醫(yī)療錯(cuò)誤的公開基準(zhǔn)測(cè)試 MEDEC1,其包含 3,848 個(gè)臨床文本。論文描述了數(shù)據(jù)創(chuàng)建方法,并評(píng)估了近期的 LLMs(例如 o1-preview、GPT-4、Claude 3.5 Sonnet 和 Gemini 2.0 Flash)在檢測(cè)和糾正需要醫(yī)學(xué)知識(shí)和推理能力的醫(yī)療錯(cuò)誤任務(wù)上的表現(xiàn)。

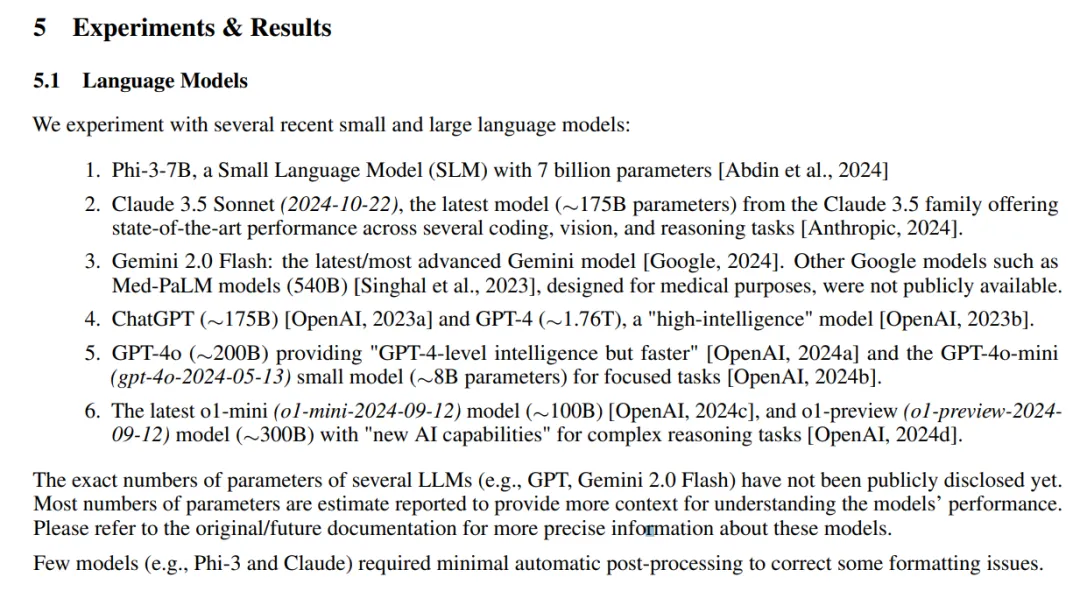

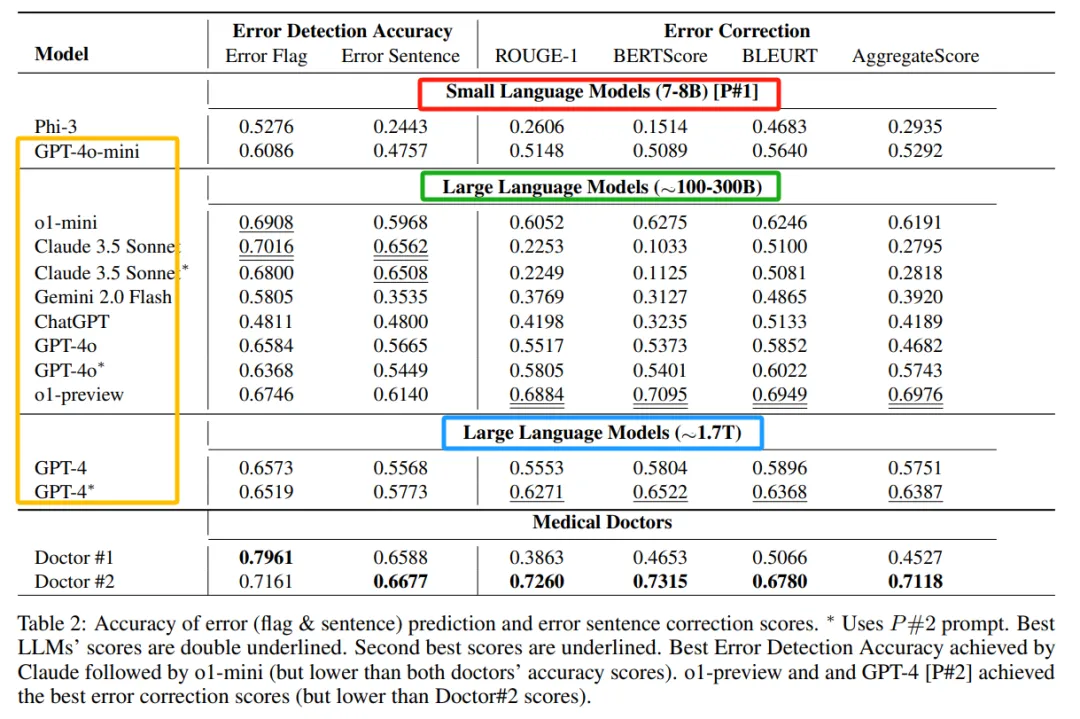

因?yàn)橐M(jìn)行實(shí)驗(yàn),因而在論文實(shí)驗(yàn)部分出現(xiàn)了眾多模型的參數(shù)量,如下所示。

此前,有些模型的參數(shù)量都是未知的,也是大家比較好奇的。

此外,在這部分內(nèi)容底下,微軟還列出了一句聲明「大多數(shù)模型參數(shù)的數(shù)量是估計(jì)的」。

通過這張圖,我們不難發(fā)現(xiàn),除了 GPT-4o-mini,大家還發(fā)現(xiàn)了其他模型的大小,比如:

- Claude 3.5 Sonnet: 175B;

- GPT-4: 1.76T;

- GPT-4o: 200B;

- o1-preview: 300B;

- o1-mini: 200B。

結(jié)果部分也是將模型參數(shù)分為多個(gè)等級(jí):

但是在這個(gè)推文下面大家討論的非常激烈,主要圍繞微軟對(duì)模型大小的估計(jì)到底準(zhǔn)不準(zhǔn)確。

前面我們已經(jīng)提到,模型參數(shù)都是估計(jì)出來的。因此有網(wǎng)友表示「就算微軟確實(shí)知道,但并不代表微軟 99% 的員工都知道。」「有 98% 的可能性是他們只是微軟雇傭的研究人員,但與有權(quán)訪問 OpenAI 的團(tuán)隊(duì)沒有任何聯(lián)系。」

「感覺這些數(shù)字只是作者的猜測(cè),因?yàn)樗麄儧]有解釋他們是如何估計(jì)的。」不過這位網(wǎng)友強(qiáng)調(diào)的這一點(diǎn),論文確實(shí)說明了參數(shù)是估計(jì)的。

還有網(wǎng)友表示這篇論文將 Claude 3.5 Sonnet 估計(jì)為 175B 有點(diǎn)扯。

「Claude 不可能只有 175B,我敢打賭它接近這個(gè)數(shù)字的兩倍。尤其是自 deepseek-v3 發(fā)布以來,其內(nèi)存大小達(dá)到 671B,而 Claude 的表現(xiàn)輕松超越了后者。」

「我敢打賭 4o-mini 是一個(gè) MoE 模型,總共有大約 400 億個(gè)參數(shù),可能有 80 億個(gè)激活參數(shù)。我發(fā)現(xiàn)它比 80 億個(gè)模型擁有更多的知識(shí)(當(dāng)詢問事實(shí)時(shí)),同時(shí)速度相當(dāng)快。」

還有網(wǎng)友認(rèn)為這是一個(gè)合理的猜測(cè)。消息畢竟出自微軟。

討論來討論去,最后的結(jié)論依然是沒有結(jié)論,你怎么看這篇論文給出的數(shù)據(jù)呢?