大模型也沖“奧斯卡”:港科大騰訊等提出AI角色扮演全景綜述,四方面剖析關(guān)鍵細節(jié)

AI界也有了自己的“奧斯卡”,哪家大模型角色扮演更入戲?

來自香港科技大學(xué)、騰訊、新加坡管理大學(xué)的團隊提出新綜述——

不僅系統(tǒng)性地回顧了角色扮演語言模型的發(fā)展歷程,還對每個階段的關(guān)鍵進展進行了深入剖析,展示了這些進展如何推動模型逐步實現(xiàn)更復(fù)雜、更逼真的角色扮演。

AI世界如同不斷擴展的“舞臺”,語言模型則是這個舞臺上不斷精進的“演員”。

論文從早期簡單的“人格小品”到如今復(fù)雜而多面的“角色大片”,詳盡描繪了role-playing領(lǐng)域的發(fā)展。

作者不僅對學(xué)術(shù)界的方法進行了詳細的剖析和總結(jié),還在多個地方闡述了在工業(yè)界構(gòu)建role-playing LLM的切身經(jīng)驗,為研究人員提供了明晰的結(jié)構(gòu)和指引。

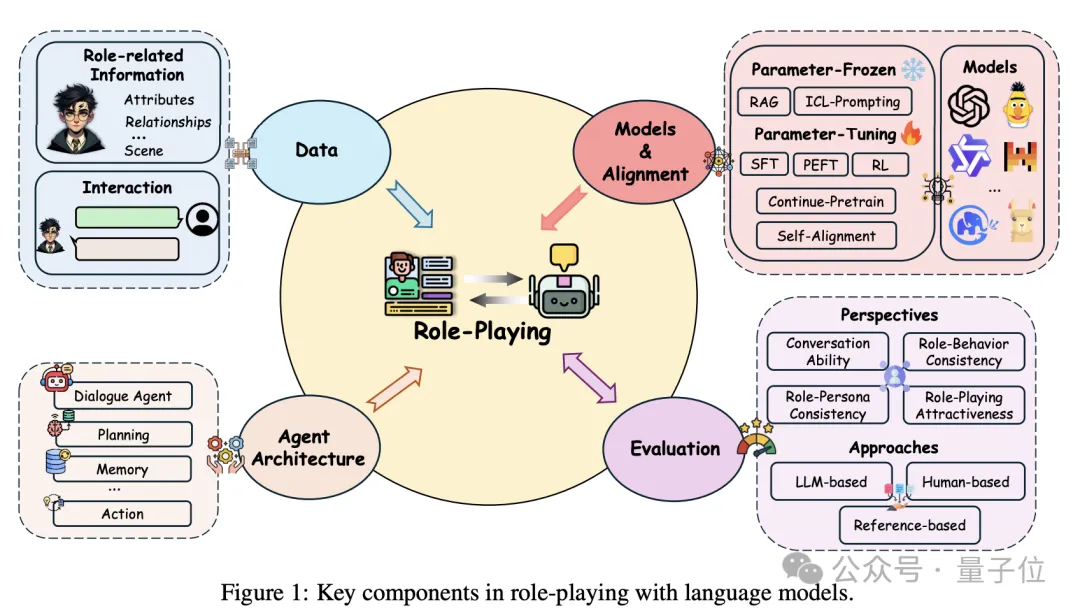

在接下來的內(nèi)容中,作者通過四個部分詳細介紹角色扮演語言模型的組成:數(shù)據(jù)、模型與對齊、Agent架構(gòu)以及評估方法。

每一個部分都揭示了角色扮演的關(guān)鍵細節(jié),以及這些細節(jié)如何協(xié)同作用,打造出一個逼真的角色扮演體驗。

數(shù)據(jù)

數(shù)據(jù)是角色扮演的劇本,這里,作者們詳細討論了支撐角色扮演模型的數(shù)據(jù)源。

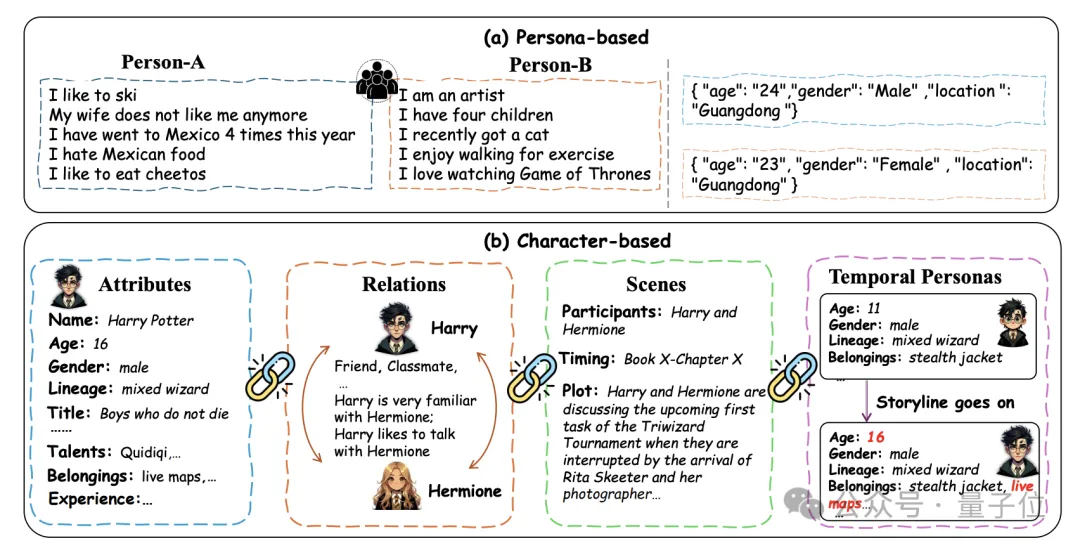

根據(jù)數(shù)據(jù)是否包含詳細的character-level的信息,將現(xiàn)有的數(shù)據(jù)分成兩類:Persona-based Role-Playing (P-RP) 和Character-based Role-Playing(C-RP)。

P-RP數(shù)據(jù)集通常包含粗粒度的角色信息,比如位置、性別等,用于確保基本的角色一致性。

相比之下,C-RP數(shù)據(jù)集則包含更為細致的角色背景信息,如角色屬性、復(fù)雜的關(guān)系網(wǎng)絡(luò)、特定場景及時間維度的信息,用于創(chuàng)建更深度、個性化的角色互動。

P-RP就像是演員在收到簡短的角色描述后進行即興表演,而C-RP則要求演員融入豐富的背景細節(jié),比如角色的屬性、關(guān)系和場景,就像深入揣摩一個電影角色。

作者們還詳細描述了數(shù)據(jù)構(gòu)造的多種方法:

1)眾包方式(Employing Crowdsourced Workers):通過雇傭眾包工人來創(chuàng)建個性化對話數(shù)據(jù)集,例如Persona-Chat數(shù)據(jù)集和Focus數(shù)據(jù)集。這些數(shù)據(jù)集通常質(zhì)量較高,但規(guī)模有限。

2)社交媒體數(shù)據(jù)收集(Extracting from Social Media):通過社交媒體平臺收集大量用戶對話數(shù)據(jù),如Pchatbot和PersonalDialog數(shù)據(jù)集。這些數(shù)據(jù)集規(guī)模龐大,但質(zhì)量控制較為困難。

3)從文學(xué)資源中提取(Extracting from Literary Resources):特別是對于復(fù)雜的角色扮演場景,作者從小說、電影等文學(xué)資源中提取角色相關(guān)的對話和背景信息,例如HPD數(shù)據(jù)集基于《哈利·波特》小說。這些數(shù)據(jù)源的語言質(zhì)量非常高,但與日常用戶-AI對話風(fēng)格之間可能存在差異,影響與真實用戶交互時的表現(xiàn)。

4)使用大語言模型生成(LLM as Data Generator):通過先進的大語言模型(如GPT-4)生成角色簡介和對話數(shù)據(jù),例如RoleInteract和Rolebench數(shù)據(jù)集。雖然這種方法有效,但可能引入偏差,數(shù)據(jù)質(zhì)量需要手動審查和驗證。

5)人工角色扮演(Human Role-Playing):通過雇傭眾包工人根據(jù)特定的角色簡介進行角色扮演,生成對話數(shù)據(jù)。這種方法數(shù)據(jù)質(zhì)量高,但缺乏多樣性且成本較高。

6)未公開資源(Unpublished Resources):特別值得一提的是,作者在數(shù)據(jù)部分詳細討論了未公開資源的獨特貢獻,這也是這篇綜述的一大亮點。

作者們主要列舉了三種:

- 角色扮演論壇:這類資源包含了大量的人與人之間的角色扮演數(shù)據(jù),一些著名的論壇包括Blue Moon、NationStates、Aryion、Questionable Questing、Role-Player和Spacebattles。這些論壇中往往包含成人內(nèi)容,因此在使用這些數(shù)據(jù)之前需要進行嚴(yán)格的數(shù)據(jù)清洗,以確保其適用于訓(xùn)練角色扮演語言模型。

- 在線角色扮演產(chǎn)品日志:包括一些在線角色扮演產(chǎn)品的日志數(shù)據(jù),如CharacterAI。這些數(shù)據(jù)記錄了用戶在角色扮演過程中的互動,但使用這些數(shù)據(jù)需要獲得用戶和產(chǎn)品開發(fā)者雙方的雙重授權(quán),數(shù)據(jù)的獲取和使用存在一定的法律和倫理挑戰(zhàn)。

- 同人小說社區(qū):例如AO3(Archive of Our Own)這樣的社區(qū),特別是一些著名角色(如哈利·波特)相關(guān)的同人小說,其數(shù)量是原作的數(shù)千倍。然而,這類資源的風(fēng)險在于存在大量的“角色失真”(Out-of-Character)情況,因為作者往往根據(jù)自己的偏好加入許多額外的角色特征和情節(jié),可能與原始角色設(shè)定不符。

這些數(shù)據(jù)來源和構(gòu)造方式的多樣性使得角色扮演模型能夠在各種場景中展現(xiàn)更為豐富和個性化的表現(xiàn),為模型的開發(fā)提供了堅實的數(shù)據(jù)基礎(chǔ)。

這些數(shù)據(jù)來源的多樣性為模型塑造豐富多彩的角色提供了重要支持,但同時也伴隨著法律和倫理方面的風(fēng)險,需要在使用時格外謹(jǐn)慎。

模型與對齊

如果說數(shù)據(jù)是劇本,那么模型就是演員,演員如何表現(xiàn)出角色的靈魂,離不開對齊的訓(xùn)練。

在這一部分,作者詳細分析了角色扮演模型的基礎(chǔ)模型和對齊方法的演變過程,從最早的非預(yù)訓(xùn)練模型(Non-pretrained Models)到預(yù)訓(xùn)練語言模型(PLM)和大規(guī)模語言模型(LLMs),這些階段代表了角色扮演模型在架構(gòu)選擇上的重大轉(zhuǎn)變。

基礎(chǔ)模型

基礎(chǔ)模型在設(shè)定角色扮演模型的基本能力方面起到了關(guān)鍵作用。

早期的非預(yù)訓(xùn)練模型是為特定任務(wù)從頭開發(fā)的,沒有大規(guī)模預(yù)訓(xùn)練數(shù)據(jù)的支持。這些模型通常采用定制的架構(gòu),如記憶網(wǎng)絡(luò)或?qū)iT設(shè)計的Transformer,用于處理個人信息的存儲和嵌入融合。

隨著預(yù)訓(xùn)練語言模型(PLM)的引入,模型的基礎(chǔ)能力得到了顯著提升,能夠更好地理解上下文并生成文本,例如BERT、ConvAI2等模型。這些模型利用了大量預(yù)訓(xùn)練數(shù)據(jù),增強了它們在角色扮演中的應(yīng)用能力。

大規(guī)模語言模型(LLM)代表了角色扮演模型的最新前沿,具備前所未有的參數(shù)規(guī)模和預(yù)訓(xùn)練數(shù)據(jù)能力。諸如GPT-4和CharacterGLM等LLMs能夠在極少的提示下保持連貫且具有豐富上下文的對話,這些模型主要基于解碼器架構(gòu),通過指令微調(diào)等方式進行角色配置,形成特定角色扮演的效果。

這些LLM的出現(xiàn)使得角色扮演的個性化和連貫性達到了新的高度。

特別是,作者們以CharacterGLM為例,深入探討了如何優(yōu)化大語言模型以支持角色扮演。

首先,通過收集角色相關(guān)的對話訓(xùn)練語料,以及相應(yīng)的角色背景信息,生成豐富的角色化對話數(shù)據(jù)集。

接著是指令微調(diào)階段,將角色背景信息和對話數(shù)據(jù)組織成結(jié)構(gòu)化的指令,并通過多樣化提示進行數(shù)據(jù)增強,以提高模型生成多樣化、上下文適宜的對話回復(fù)能力。

最后,模型可能會通過自對齊(Self-Alignment)進行進一步優(yōu)化,即利用更先進的模型的輸出對較弱模型進行訓(xùn)練,并結(jié)合人類反饋,以確保角色一致性。這種綜合的方法確保了大語言模型在角色扮演場景中能夠有效地體現(xiàn)并保持角色特質(zhì)。

對齊方法

對齊方法旨在確保角色扮演模型的回復(fù)與預(yù)期角色保持一致,分為“參數(shù)調(diào)整”(Parameter-Tuning)和“凍結(jié)參數(shù)”(Parameter-Frozen)兩大類。

參數(shù)調(diào)整(Parameter-Tuning)

- 繼續(xù)預(yù)訓(xùn)練(Continue-Pretrain):通過在目標(biāo)領(lǐng)域的語料上繼續(xù)訓(xùn)練模型,幫助模型獲取角色相關(guān)知識,彌合通用預(yù)訓(xùn)練和下游角色扮演之間的領(lǐng)域差距。例如,ChatPlug和MCP通過在特定文學(xué)語料上訓(xùn)練模型,捕捉角色特定的敘述和詞匯。

- 監(jiān)督微調(diào)(Supervised Fine-Tuning, SFT):這是最直接的訓(xùn)練方法,通過將個人信息與對話連接起來進行監(jiān)督學(xué)習(xí),使用如注意力路由機制、記憶網(wǎng)絡(luò)等技術(shù)增強模型對角色和對話的理解。代表性工作包括RoleLLM、CharacterLLM和CharacterGLM等。

- 自對齊(Self-Alignment):通過使用更強大的模型生成的數(shù)據(jù)對較弱的模型進行微調(diào),例如CharacterGLM和Ditto使用自生成的數(shù)據(jù)進一步增強LLMs在角色扮演中的表現(xiàn)。

凍結(jié)參數(shù)(Parameter-Frozen)

- 上下文學(xué)習(xí)(In-Context Learning):通過提示詞進行學(xué)習(xí),例如在提示中配置角色背景信息以模擬特定角色的行為。

- 檢索增強生成(Retrieval-Augmented Generation, RAG):結(jié)合檢索機制,將相關(guān)信息與生成任務(wù)結(jié)合,提高響應(yīng)的相關(guān)性和連貫性。

這些對齊方法如同不同類型的表演訓(xùn)練,從不斷反復(fù)的臺詞練習(xí)到沉浸式的即興表演,每種方法都在為角色的完美呈現(xiàn)而努力。通過這些技術(shù),角色扮演語言模型得以在不同場景中展現(xiàn)出更高的表現(xiàn)力和一致性。

Agent架構(gòu)

在Agent架構(gòu)部分,作者將角色扮演語言Agent(RPLAs)比作舞臺上的演員,涵蓋了記憶、規(guī)劃和行動三個重要模塊。

記憶模塊就像演員的“回憶錄”,幫助Agent記住與用戶或其他Agent的交互細節(jié);規(guī)劃模塊就像導(dǎo)演的“分鏡頭腳本”,為Agent制定每一步的行動計劃;而行動模塊則是演員的“即興表演”,讓Agent能夠靈活使用工具并生成多樣化的響應(yīng)。

通過這些模塊的協(xié)同運作,角色扮演語言Agent得以呈現(xiàn)出更加立體、生動的互動體驗。

RPLAs的設(shè)計基于三大核心模塊:

記憶模塊(Memory)

記憶模塊是RPLAs的基礎(chǔ),用于在不同的交互場景中保存和調(diào)用重要信息。記憶來源主要分為兩類:user-agent 交互和agent-agent交互。

User-agent交互記憶使Agent能夠在長期互動中保持一致性,例如記住用戶的選擇和偏好,而agent-agent交互則用于支持多Agent之間的合作或競爭,使Agent在復(fù)雜場景中形成更具策略性的行為。

記憶的使用分為檢索型記憶和壓縮型記憶,前者通過維護數(shù)據(jù)庫來存儲歷史信息,后者通過壓縮歷史數(shù)據(jù)來減少存儲需求,增強對話的一致性和效率。

規(guī)劃模塊(Planning)

規(guī)劃模塊主要用于角色的目標(biāo)設(shè)定和行動策略的制定,分為“規(guī)劃制定”和“規(guī)劃反思”兩個階段。

在規(guī)劃制定階段,Agent會分析當(dāng)前情境、預(yù)測可能的未來狀態(tài),并設(shè)計一系列符合角色動機的行動。規(guī)劃反思則是在行動之后對其有效性進行評估,以確保角色的行為與劇情發(fā)展和角色特征保持一致。

通過這種反思機制,RPLAs能夠不斷優(yōu)化自己的行動策略,以在未來的交互中更加符合用戶的期望和故事情節(jié)的發(fā)展。

行動模塊(Action)

行動模塊是Agent將規(guī)劃付諸實施的環(huán)節(jié),最常見的形式是生成符合角色特性的對話。

此外,RPLAs還可以通過工具(例如搜索相關(guān)API)獲取和整合特定知識,從而豐富對話內(nèi)容,確保在需要深度領(lǐng)域知識的場景中提供準(zhǔn)確的信息。

未來,RPLAs還可能擴展到具備“具身行動”的能力,即在虛擬或增強現(xiàn)實環(huán)境中與周圍環(huán)境進行更直接的交互,這將為角色扮演的沉浸感帶來全新突破。

通過這三大模塊的協(xié)同運作,RPLAs不僅能在對話中表現(xiàn)出角色特性,還能夠在復(fù)雜場景中主動推進情節(jié)的發(fā)展,為用戶提供更加動態(tài)和有趣的互動體驗。

評估

Evaluation是檢驗角色扮演是否成功的關(guān)鍵,就像頒獎典禮上的評審團,嚴(yán)格考核演員的表現(xiàn)。作者們從對話能力、角色一致性、行為一致性和角色吸引力四個維度總結(jié)和討論了role-playing llm的評估體系。

評估方法概述

作者們將角色扮演語言模型的評估分為三種主要方法:Reference-based Evaluation、Human-based Evaluation和LLM-based Evaluation。

Reference-based Evaluation

這種方法使用參考輸出(即測試集中的“ground-truth”)來評估模型輸出與用戶期望之間的一致性。常用的評估指標(biāo)包括困惑度(Perplexity, PPL)、BLEU和ROUGE。

這些指標(biāo)用于評估模型輸出的語言質(zhì)量和與參考的相似度。

然而,這些傳統(tǒng)指標(biāo)在評估角色扮演的一致性方面存在局限。為了更好地評估角色一致性,研究人員提出了多選回答格式的評估方法,要求模型在多個選項中選擇最符合角色的回答。

Human-based Evaluation

人類評估是評估角色扮演模型性能的重要方法,特別是在捕捉對話中微妙的角色特征和用戶參與感方面。

常用的人類評估方法包括打分和排序兩種方式。打分方法要求評估者根據(jù)特定標(biāo)準(zhǔn)對模型的響應(yīng)進行評分,而排序方法則要求評估者對不同模型的輸出按質(zhì)量進行排序。

雖然人類評估能夠提供深刻的洞察,但它也面臨主觀性強、成本高和難以擴展的問題。

LLM-based Evaluation

隨著大型語言模型(如ChatGPT)的發(fā)展,基于LLM的評估逐漸受到關(guān)注。通過使用預(yù)先設(shè)定的評分標(biāo)準(zhǔn)和示例,大語言模型可以模擬人類評估的過程,并提供快速的可擴展評估。

然而,基于LLM的評估在一致性和可靠性方面存在挑戰(zhàn),特別是在評估角色扮演能力強于評估模型的場景中表現(xiàn)不佳。

此外,LLM在評分時對順序敏感,往往會對順序考前的回復(fù)給予更高的評分。LLM進行評估的另一缺陷便在于弱LLM很難去評估更強的LLM,比如gpt3.5難以去評估gpt4的角色化能力。

作者們還額外強調(diào),學(xué)術(shù)界越來越依賴于僅使用LLM去評估模型的角色化能力,這是完全不夠的。

在作者們的相關(guān)經(jīng)驗中,在略微復(fù)雜的角色化場景中發(fā)現(xiàn)LLM-based 評價方式和人工評價依然還存在較大差距,因此作者們呼吁當(dāng)論文中使用LLM-based 評價方式中,應(yīng)該至少在少量樣本上證明LLM-based和人工評價的一致性。

評估維度

評估角色扮演模型的能力涉及多個維度,這些維度共同衡量模型在角色扮演中的表現(xiàn)。

對話能力:衡量模型在對話中的流暢性、連貫性和語言多樣性。流暢性要求模型輸出的語法正確、結(jié)構(gòu)自然,而語言多樣性則反映模型在用詞上的豐富性,避免重復(fù)和單一化。

角色一致性:評估模型在整個互動中是否一致地扮演好自己的角色,包括角色的屬性、行為方式等。

行為一致性:關(guān)注角色在對話中的行為是否符合其設(shè)定,例如對話風(fēng)格和角色個性是否始終如一。

角色吸引力:評估角色的互動是否能夠吸引用戶并激發(fā)用戶的興趣和共鳴,例如角色的主動性和共情能力。

各種評估方法的挑戰(zhàn)與討論

雖然上述評估方法各有其優(yōu)勢,但作者們指出它們也面臨許多挑戰(zhàn)。基于參考的評估在準(zhǔn)確性和效率方面表現(xiàn)良好,但缺乏對角色一致性的深度理解。

基于人類的評估盡管能捕捉對話中的細微之處,但由于評估者的主觀性和高昂的成本,難以大規(guī)模應(yīng)用。基于LLM的評估在成本和可擴展性上具有優(yōu)勢,但其一致性和與人類評估的匹配度有待提高。

作者們還強調(diào),無論采用何種評估方法,都必須確保方法能夠在特定場景下有效地評估角色扮演能力。

例如,在進行人類或LLM評估時,評估者需要具備足夠的角色背景知識,否則評估的準(zhǔn)確性將受到影響。對話能力是角色語言是否流暢、自然;角色一致性則是角色在整個互動中是否始終如一地扮演好自己的角色;行為一致性關(guān)注角色的舉止是否符合其身份,而角色吸引力則考察角色是否能夠吸引用戶、激發(fā)共鳴。

作者還對比了基于參考、人工和大語言模型的評估方法,指出每種方法在不同角色扮演場景中的優(yōu)勢和不足。

未來的挑戰(zhàn)與發(fā)展方向

在角色扮演語言模型的發(fā)展過程中,盡管已有顯著的進展,但仍存在許多挑戰(zhàn)需要克服,以實現(xiàn)更為復(fù)雜和互動性更強的敘事體驗。在這一部分,作者詳細總結(jié)了當(dāng)前系統(tǒng)的不足之處,并提出了未來研究的方向。

評價方法的改進:

目前的參考基準(zhǔn)評估方法主要集中在語言準(zhǔn)確性和連貫性上,這對于評估角色扮演的能力(如角色一致性和敘事吸引力)是遠遠不夠的。現(xiàn)有的評價指標(biāo)(如?PPL)雖然在某些方面表現(xiàn)良好,但無法直接評估生成的輸出與設(shè)定角色之間的一致性。因此,未來需要開發(fā)更多適用于角色扮演的評價方法,特別是能夠捕捉角色之間關(guān)系動態(tài)和心理狀態(tài)的深度對齊方法。

大語言模型(LLM)評估的局限性:

LLM在進行角色評估時,常常面臨與人類評估結(jié)果不一致的問題。例如,當(dāng)LLM評估它們不熟悉的角色時,準(zhǔn)確性可能會受到影響。此外,LLM在進行評分時對響應(yīng)順序存在敏感性,通常會優(yōu)先給較長的響應(yīng)打分較高。因此,未來的研究需要在評估過程中引入更多的細化機制,以解決這些一致性和可靠性方面的問題。

記憶管理和多模態(tài)集成:

RPLAs的記憶模塊在提供上下文連續(xù)性、角色扮演互動和深度敘事參與方面非常重要,但在管理大量數(shù)據(jù)和保持存儲效率上面臨諸多挑戰(zhàn)。此外,多模態(tài)交互(如圖像-文本對)可以顯著增強角色扮演的深度和真實性,未來應(yīng)加強多模態(tài)整合,開發(fā)更為沉浸的角色扮演體驗。

終身學(xué)習(xí)和安全性:

角色扮演語言模型的長期目標(biāo)是具備終身學(xué)習(xí)能力,使得系統(tǒng)能夠不斷適應(yīng)用戶交互和環(huán)境變化。然而,終身學(xué)習(xí)也帶來了對齊和安全性方面的巨大挑戰(zhàn),可能導(dǎo)致系統(tǒng)出現(xiàn)未預(yù)料的有害行為(如獎勵黑客和目標(biāo)失調(diào))。未來的研究需要開發(fā)穩(wěn)健的框架,以管理RPLA的學(xué)習(xí)軌跡,確保其發(fā)展始終符合倫理標(biāo)準(zhǔn)和設(shè)計目標(biāo)。

論文鏈接:https://arxiv.org/abs/2407.11484

項目主頁:https://github.com/nuochenpku/Awesome-Role-Play-Papers