大模型走向物理世界,TeleAI 發布大模型驅動的具身智能綜述,覆蓋300篇文獻

近年來,大模型在人工智能領域掀起了一場革命,各種文本、圖像、多模態大模型層出不窮,已經深深地改變了人們的工作和生活方式。另一方面,在國際半導體大會上,英偉達創始人黃仁勛表示,人工智能下一個浪潮將是 “具身智能”,即能理解、推理、并與物理世界互動的智能系統。近年來,國內外商業巨頭也紛紛推出自己的具身機器人發展計劃。大模型和具身智能,無疑是當前人工智能領域最閃耀的雙子星。在光電感知技術、機器人技術、大模型技術的快速發展下,大模型驅動的具身智能,不僅有望極大提升機器人的智能水平,更將推動人工智能技術邁向物理世界,從而產生更加廣泛的應用。

在此背景下,中國電信 CTO、首席科學家李學龍教授牽頭組建中國電信人工智能研究院 (TeleAI), 并將大模型和具身智能作為重要的研究方向。近期,由 TeleAI 研究科學家白辰甲、清華大學助理教授許華哲、TeleAI 院長李學龍教授共同撰寫的中文綜述《大模型驅動的具身智能:發展與挑戰》一文在《中國科學:信息科學》發表,綜述通過對 300 篇相關文獻的分類和解讀,深度剖析大模型驅動的具身智能的基本概念、技術框架、現有挑戰和未來展望,梳理這一熱點問題背后的研究脈絡和技術體系,進一步推動具身智能領域的發展,助力國家人工智能發展戰略。

- 論文地址:https://www.sciengine.com/SSI/doi/10.1360/SSI-2024-0076

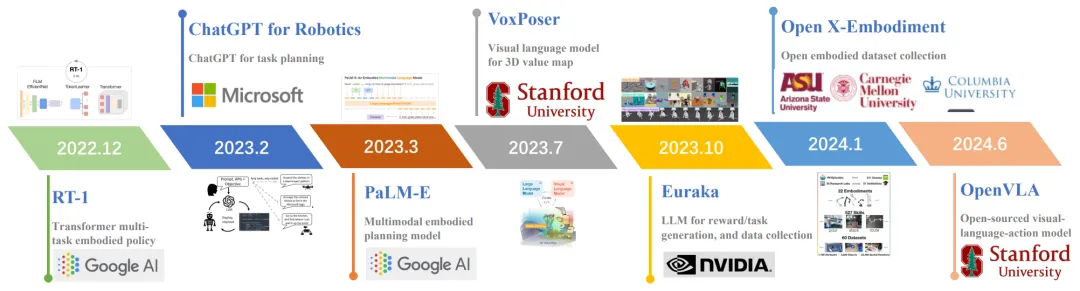

具身智能是人工智能、機器人學、認知科學的交叉領域,主要研究如何使機器人具備類似人類的感知、規劃、決策和行為能力。具身智能強調感知 - 運動回路,使用物理實體來感知環境,根據任務目標進行規劃和決策,使用運動操作能力來完成任務。大模型具有對物理世界的豐富知識,能夠為智能體提供自然語言交互、環境感知和任務規劃的能力,同時能夠和具身智能的傳統框架相結合,提升智能體策略學習的泛化性。圖 1 展示了該領域的典型進展。

圖 1 領域典型進展

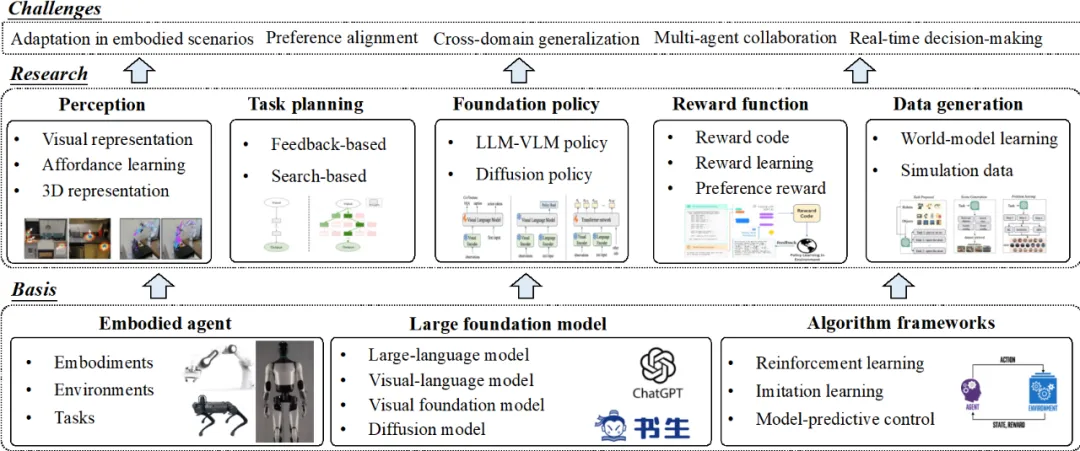

綜述首先介紹相關技術背景,包括具身智能的基本概念,大模型相關技術,以及強化學習、模仿學習、模型預測控制等策略學習框架。隨后,從學習范式的角度將大模型驅動的具身智能算法概括了五大類并依次進行了詳細闡述,分別是大模型驅動的環境感知、大模型驅動的任務規劃、大模型驅動的基礎策略、大模型驅動的獎勵函數、大模型驅動的數據生成。圖 2 展示了綜述的整體框架。

圖 2 綜述整體框架

大模型驅動的具身環境感知

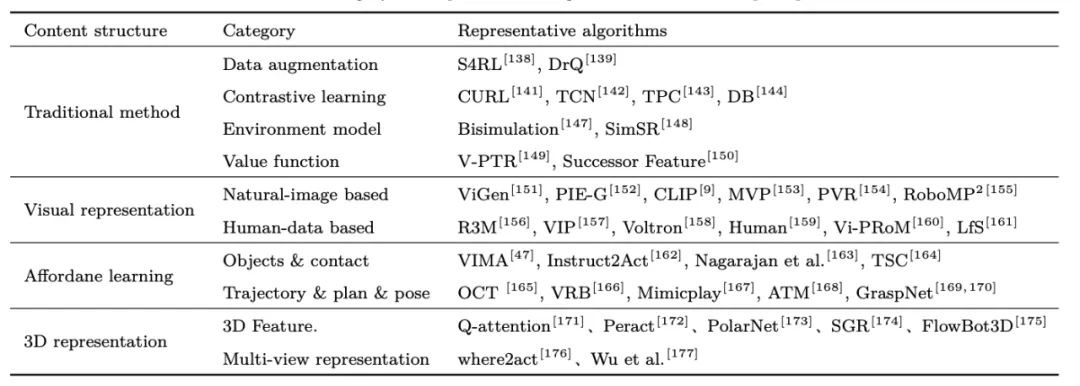

在具身智能任務中,智能光電設備可以為具身智能體提供周圍環境的視覺信號,隨后大模型感知技術為具身決策提供基礎。1)相比于傳統的特征提取方法,視覺大模型具有較好的泛化性,許多研究通過引入視覺預訓練模型來提高策略的視覺泛化能力和魯棒性。2)機器人 Affordance 是一種對操作任務更具有解釋性的通用特性,通過預訓練 Affordance 模型能夠為具身操作提供更詳細的指導,例如物體的交互位置 (如門把手,茶壺手柄等),物體的交互軌跡 (如向內推、向上提等),如圖 3 所示。3)復雜任務需要獲取操作物體的 3D 場景特征,許多方法設計從點云和多視角圖像中提取目標位置、方向、遮擋、物體之間的堆疊關系等。該領域典型方法如表 1 所示。

圖 3 典型的 Affordance 提取方式

表 1 大模型驅動的具身感知算法總結

大模型驅動的具身任務規劃

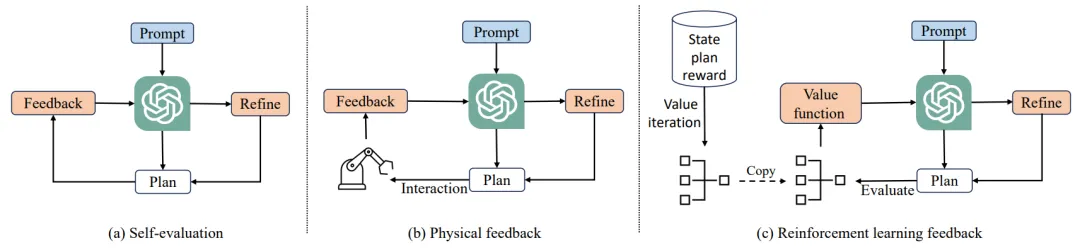

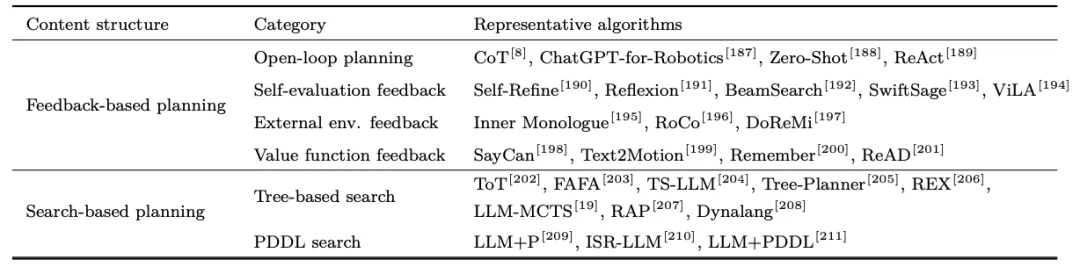

在大規模語言數據中訓練得到的大模型對現實世界有著豐富的先驗知識,可以用來作為具身智能任務的規劃器。然而,大模型的知識與具身環境存在不匹配的現象,可能會導致大模型的規劃無法執行。1)現有研究通過構建閉環反饋的方法來解決開環規劃中存在的問題,包括大模型自我反饋、外部環境反饋、強化學習反饋等,對大模型等規劃進行糾錯,如圖 4 所示。2)通過規劃搜索算法能夠提升大模型在長周期任務規劃中的最優性,這一領域包含蒙特卡洛樹搜索、世界模型、規劃領域定義語言搜索等。該領域典型方法如表 2 所示。

圖 4 大模型規劃等閉環反饋方法

表 2 大模型驅動的具身規劃算法總結

大模型驅動的具身基礎策略

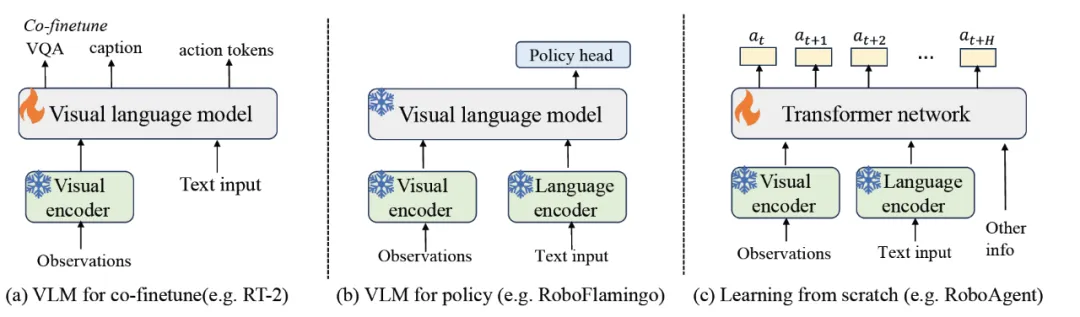

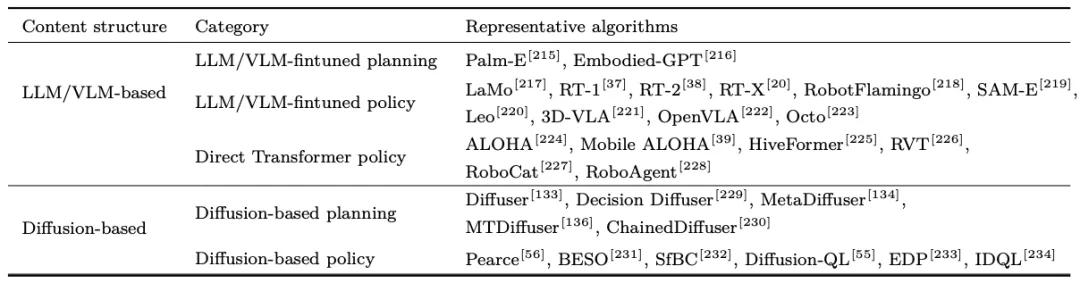

大模型任務規劃依賴于能夠執行規劃對底層技能庫。為了減輕底層技能庫定義的依賴,提升決策效率,1)許多研究考慮將大模型參數作為具身基礎策略,并利用具身數據對大模型參數進行微調,使大模型能夠更加適應于具身決策場景。基礎策略可以輸出更具體的任務規劃,也可以直接輸出機器人需要執行的動作,如圖 5 所示。2)擴散模型由于對長序列數據建模中的強大能力,許多研究將其用于建模專家軌跡的多樣化數據分布,從而用于長序列任務的軌跡規劃或動作規劃,或作為具身策略結合強化學習算法進行策略優化。

圖 5 大模型驅動的具身策略微調

表 3 大模型具身基礎策略算法總結

大模型驅動的具身獎勵函數

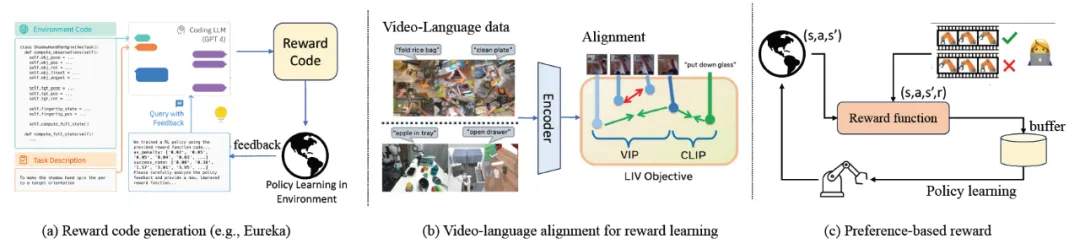

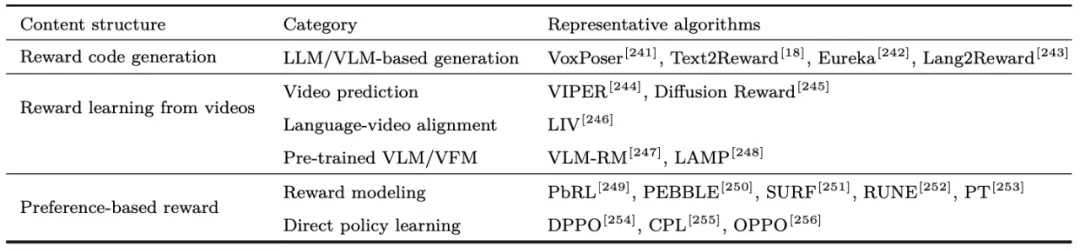

在基于強化學習和模型規劃控制的具身算法中,最優策略通過優化獎勵函數產生。傳統方法中獎勵函數由機器人領域專家設計,具有一定的設計難度。1)大模型對機器人和任務具有豐富的先驗知識,許多研究提出使用大語言模型 / 視覺語言模型進行獎勵圖或獎勵函數的生成,隨后通過策略優化和環境反饋進行優化。2)其他研究學習通過從狀態視頻預測、描述 - 軌跡匹配程度、軌跡相似性等方面學習參數化的獎勵模型。3)受大模型偏好學習等啟發,許多研究通過人類反饋對軌跡偏好進行打分,使用人類反饋強化學習(RLHF)算法進行獎勵模型等訓練。典型框架如圖 6 和表 4 所示。

圖 6 大模型驅動的獎勵函數框架

表 4 大模型驅動的具身獎勵函數算法總結

大模型驅動的具身數據生成

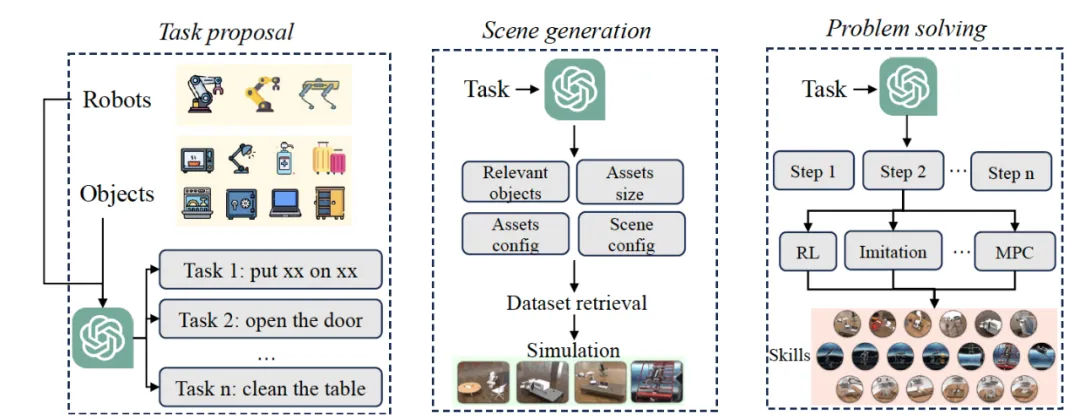

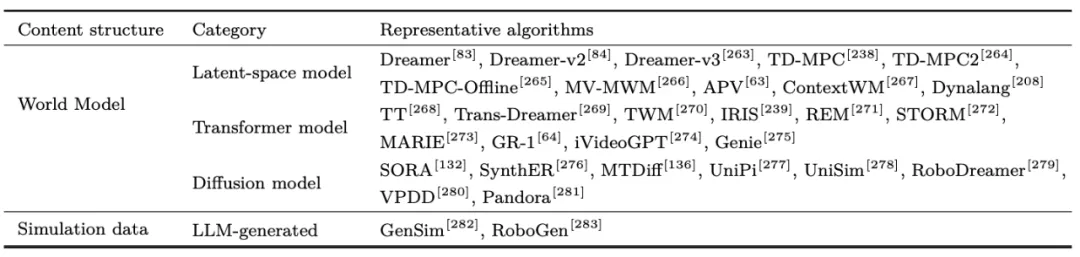

大模型進行具身數據生成有望解決機器人數據稀缺的難題。1)世界模型(World Model)揭示了物理世界的運行規律,包括未來視覺觀測如何改變,狀態如何根據環境動力學進行轉移,以及智能體最終達到的狀態等。構建世界模型能夠快速產生大量軌跡來豐富強化學習或模仿學習的數據,基本框架包含隱空間世界模型、Transformer 世界模型、擴散世界模型等。2)大模型能夠借助仿真環境進行自動化的環境生成和數據采集,主要流程包括大模型自動任務提出、自動環境構造、自動任務解決、自動數據采集、自動技能學習等,快速產生針對特定任務的仿真數據,進行機器人技能和策略的學習,如圖 7 所示。該領域典型方法如表 5 所示。

圖 7 大模型驅動的仿真環境和數據生成框架

表 5 大模型驅動的具身數據生成算法總結

大模型驅動的具身智能已具備了研究和技術體系的雛形,有望使 “數字” 大模型在 “實體” 機器人中生根發芽。綜述隨后分析了現有研究之間存在的聯系,并總結了目前大模型驅動的具身智能領域面臨的挑戰,包括大模型在特定具身場景中的適應問題、大模型策略和人類偏好的對齊問題、具身策略的跨域泛化問題、大模型驅動多智能體協作問題、具身智能在真實環境中所面臨的挑戰和大模型具身策略的決策實時性問題等。

雖然目前關于采取何種路線能夠達到通用具身智能仍很難定論,但大模型的成功切實的推動了具身智能的發展。綜述對該領域的未來研究進行了展望,包括統一具身數據平臺、通用具身數據表征、魯棒具身控制策略、可控具身策略生成、人機合作具身智能、異構智能體協同、輕量化具身策略和人形機器人等方面。