Meta浙大校友讓評估模型「自學(xué)成才」,數(shù)據(jù)全合成無需人工標(biāo)注,訓(xùn)練Llama 3 70B超過405B

LLM在開發(fā)周期的每個(gè)階段都依賴強(qiáng)大的評估模型,比如訓(xùn)練階段用于對齊人類偏好或迭代自我改進(jìn)的獎勵模型,以及推理階段作為人類評估的替代方案。

構(gòu)建評估模型往往依賴大量的高質(zhì)量人類偏好數(shù)據(jù),不僅耗時(shí)長、成本高,而且在模型擴(kuò)展到新任務(wù)或評估標(biāo)準(zhǔn)時(shí)造成了阻礙。

此外,隨著新模型不斷迭代改進(jìn)時(shí),現(xiàn)有的標(biāo)注數(shù)據(jù)往往會過時(shí),因?yàn)槠渲械脑u估是基于舊有的、性能較差的模型相應(yīng)。這意味著需要不斷重復(fù)上述的數(shù)據(jù)標(biāo)注和收集流程。

最近,Meta FAIR發(fā)表的一篇研究就嘗試使用合成數(shù)據(jù)的方法來解決這個(gè)問題。他們提出了一種迭代的自我訓(xùn)練方法,在訓(xùn)練循環(huán)中完全不使用人類標(biāo)注的偏好數(shù)據(jù),而是純粹依賴合成數(shù)據(jù)。

論文地址:https://arxiv.org/abs/2408.02666

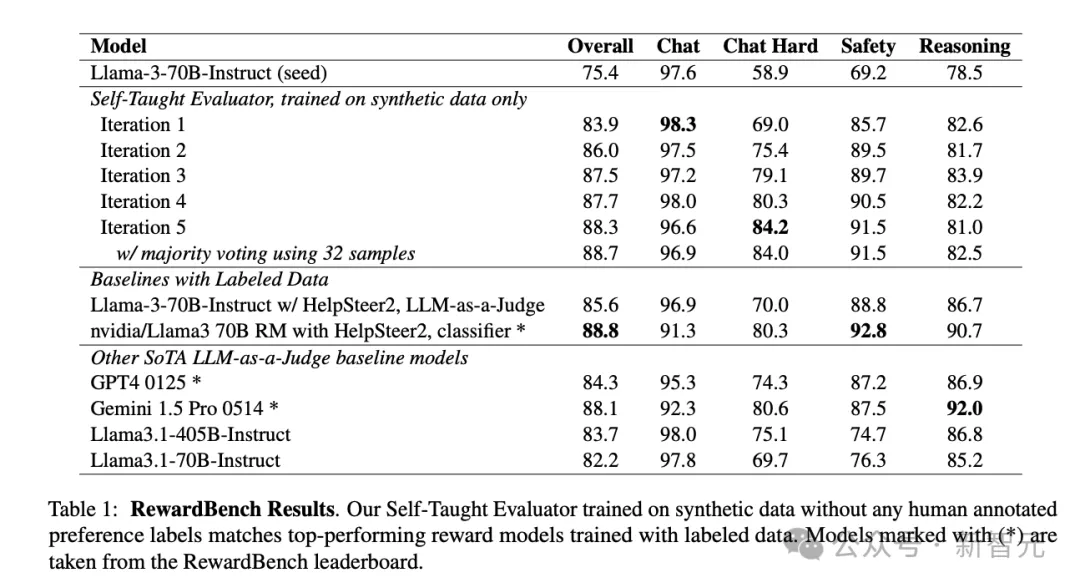

實(shí)驗(yàn)中,這種方法將Llama-3-70B-Instruct在RewardBench上的準(zhǔn)確率從75.4提升至88.7,超過了使用人類標(biāo)注數(shù)據(jù)的方法。

arXiv頁面顯示,這篇論文最后修訂于8月8日,目前作者還沒有公開相關(guān)代碼。

方法概述

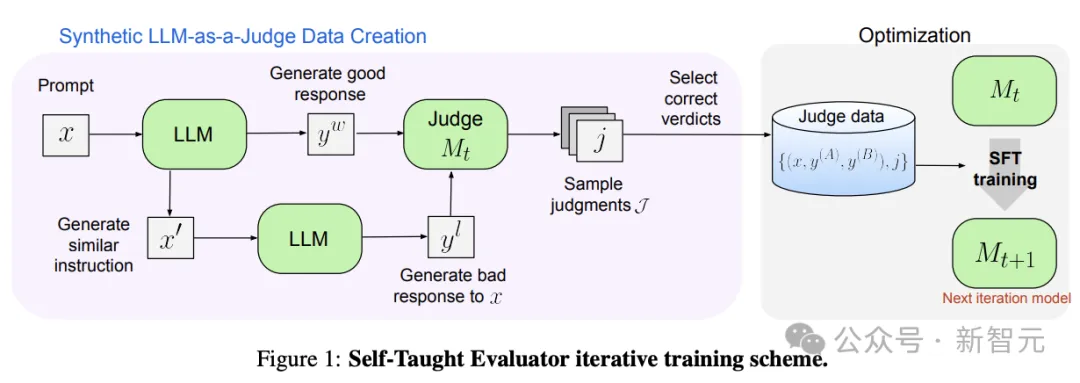

整個(gè)pipeline的流程大致如下(圖1):

- 初始化:收集大量人類編寫的用戶指令,這在生產(chǎn)系統(tǒng)中較為常見,以及初始的種子LLM

- 指令選擇:用LLM從數(shù)據(jù)集中選擇出具有挑戰(zhàn)性的、平衡的用戶指令分布

- 響應(yīng)對構(gòu)建:對每個(gè)用戶指令,通過提示創(chuàng)建LLM模型響應(yīng)偏好對,讓其中一個(gè)的質(zhì)量(被拒絕響應(yīng))略低于另一個(gè)(被選擇響應(yīng))

- 迭代訓(xùn)練:每次迭代包括兩個(gè)步驟,判斷標(biāo)注和模型微調(diào)。

(i) 對每條數(shù)據(jù)采樣N個(gè)LLM-as-a-Judge生成的推理鏈和判斷結(jié)果。如果其中包含正確判斷,則將該數(shù)據(jù)加入訓(xùn)練集,否則丟棄這條數(shù)據(jù)。

(ii) 在本次迭代構(gòu)建的訓(xùn)練集上微調(diào)模型

值得注意的是,每次訓(xùn)練迭代中,訓(xùn)練集大小取決于當(dāng)前模型的質(zhì)量。預(yù)計(jì)隨著模型能力的提升,能夠生成更多正確的判斷,訓(xùn)練集大小也會逐步增加,從而構(gòu)成了一個(gè)自學(xué)過程。

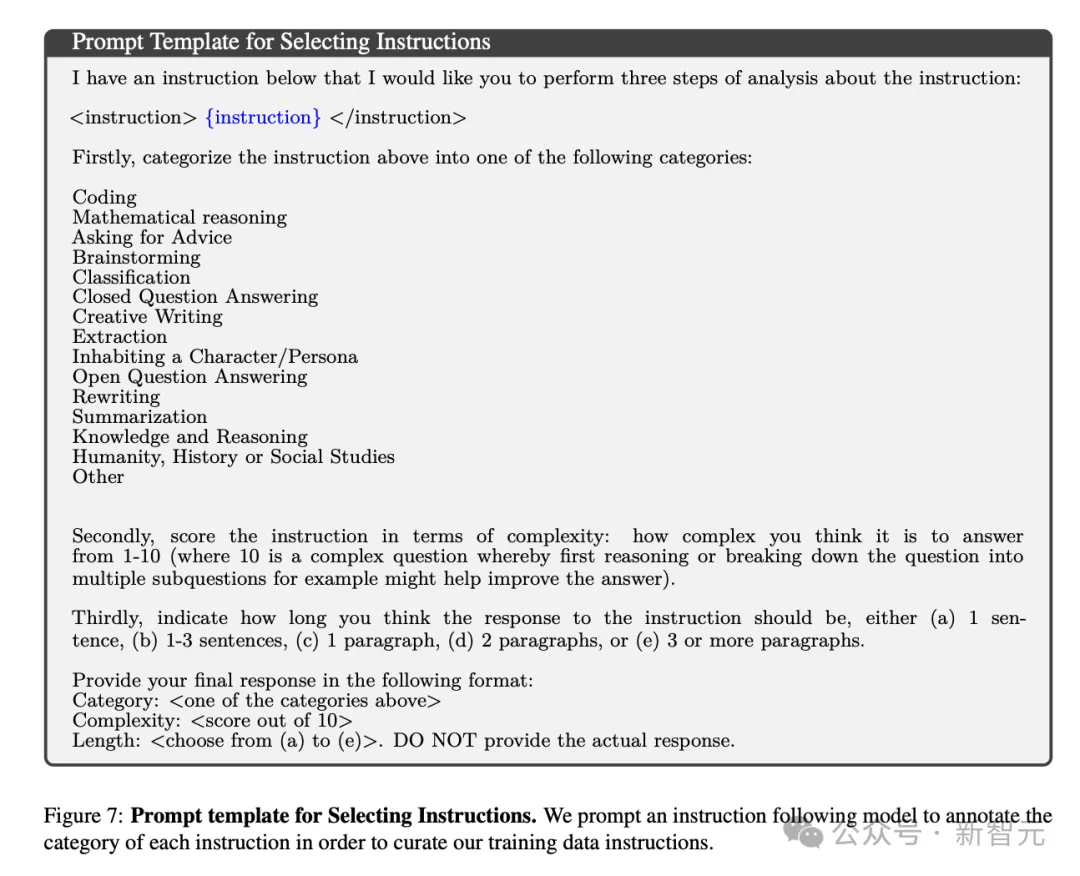

指令選擇

之所以要進(jìn)行指令選擇,是因?yàn)樯a(chǎn)系統(tǒng)中收集的用戶數(shù)據(jù)可能存在大量噪音,模型響應(yīng)的主題、多樣性、難度和能力都有很大程度的不平衡。

因此,這一步驟的目標(biāo)是篩選出特定分布的指令子集,用于生成高質(zhì)量的響應(yīng)和判斷結(jié)果。

如圖7所示,先給出精確的提示讓LLM對每個(gè)輸入進(jìn)行分類,構(gòu)建數(shù)據(jù)集時(shí)就可以在這些類別中「按需取用」。

響應(yīng)對構(gòu)建

經(jīng)過前兩步我們得到了一個(gè)精心構(gòu)建的訓(xùn)練數(shù)據(jù)池。這一步驟就是要對其中每個(gè)輸入xi,生成涉及到兩個(gè)響應(yīng)yiw、yil的偏好數(shù)據(jù),其中前者yw(winning)的質(zhì)量預(yù)計(jì)會優(yōu)于后者yl(losing)。

但這一步完全使用合成數(shù)據(jù)而非依賴人工標(biāo)注,那么如何保證yw和yl的響應(yīng)質(zhì)量差異?

論文提出了一種比較巧妙的方法,即先讓LLM根據(jù)指令xi生成基線響應(yīng)yiw;然后指示模型生成一個(gè)「嘈雜」版本的指令xi′=??(xi) 。xi'與xi語義高度相關(guān)但不完全相同,之后生成對應(yīng)xi'的模型高質(zhì)量響應(yīng)yil。

對于同一個(gè)指令xi而言,yil的質(zhì)量預(yù)計(jì)會低于yiw。由此,我們構(gòu)建出了一條完整的訓(xùn)練數(shù)據(jù):

ei := xi, yiA, yiB

其中,w=A或w=B是隨機(jī)分布的,且在最后的訓(xùn)練集構(gòu)建中保證兩種情況出現(xiàn)次數(shù)均衡,這對消除LLM-as-a-Judge的位置偏見非常重要。

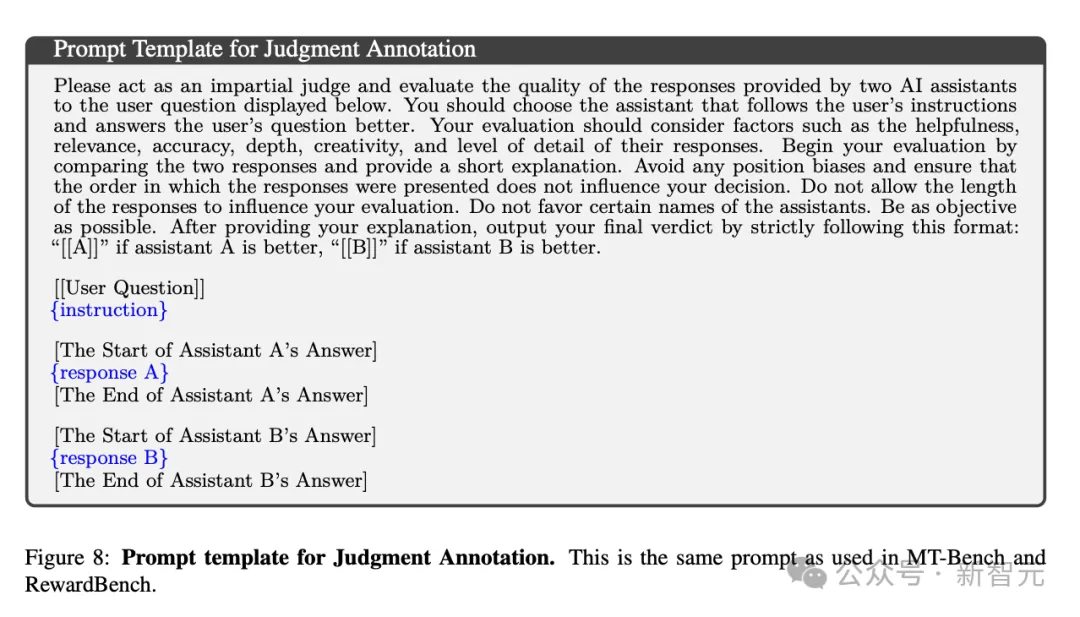

判斷標(biāo)注

對于每條訓(xùn)練數(shù)據(jù)ei,LLM-as-a-Judge模型都會生成N個(gè)多樣化的評價(jià) ??:={ji1, …, jiN},然后應(yīng)用拒絕采樣過濾掉??中與事實(shí)標(biāo)簽不一致的判斷結(jié)果。實(shí)驗(yàn)中,N被設(shè)置為15。

若??過濾后為空,該條數(shù)據(jù)在本次迭代中直接被丟棄。

若??不為空,則從正確判決中隨機(jī)選擇一個(gè),構(gòu)建最終用于微調(diào)的訓(xùn)練數(shù)據(jù):

(xi, yiA, yiB, ji)

實(shí)驗(yàn)中還嘗試使用多數(shù)投票機(jī)制代替單個(gè)模型進(jìn)行LLM-as-a-Judge判斷,根據(jù)之前的研究結(jié)論,這可以帶來性能改進(jìn)。

實(shí)驗(yàn)及評估

初始模型M0從Llama-3-70B-Instruct進(jìn)行初始化,每輪迭代i=1,…T中,使用Mi-1生成偏好數(shù)據(jù)并作為LLM-as-a-Judge模型進(jìn)行判斷,然后再次微調(diào)M0模型(即Llama-3-70B-Instruct)。

其中,指令微調(diào)利用了fairseq2庫,并使用vLLM進(jìn)行推理。

大量人類編寫的指令數(shù)據(jù){xi}來自WildChat數(shù)據(jù)集,指令選擇步驟中使用Mixtral 22B×8進(jìn)行分類,共篩選出了20,582個(gè)有挑戰(zhàn)性的指令。響應(yīng)生成步驟同樣使用Mixtral 22B×8模型。

評估結(jié)果

在RewardBench上的分?jǐn)?shù)如表1所示。與種子模型相比,總分從75.4顯著提升至88.7,超過了GPT-4和Gemini 1.5 Pro,甚至也超過了405B參數(shù)的Llama模型,而且好于使用人類標(biāo)注數(shù)據(jù)集HelpSteer2的85.6分。

4個(gè)類別分別來看,Chat Hard和Safety的分?jǐn)?shù)隨著每輪迭代都有穩(wěn)步上升,但Reasoing和Chat類別較為波動。Chat類別在訓(xùn)練后的分?jǐn)?shù)甚至低于種子模型,作者推測,這是由于篩選的合成數(shù)據(jù)過于偏重困難任務(wù)。

此外可以發(fā)現(xiàn),在LLM-as-a-Judge模型生成判斷時(shí)使用32個(gè)樣本進(jìn)行多數(shù)投票的確可以提升整體性能。

HelpSteer2由英偉達(dá)和ScaleAI合作創(chuàng)建,是一個(gè)幫助模型響應(yīng)變得更加事實(shí)正確且連貫的開源數(shù)據(jù)集。

倉庫地址:https://huggingface.co/datasets/nvidia/HelpSteer2

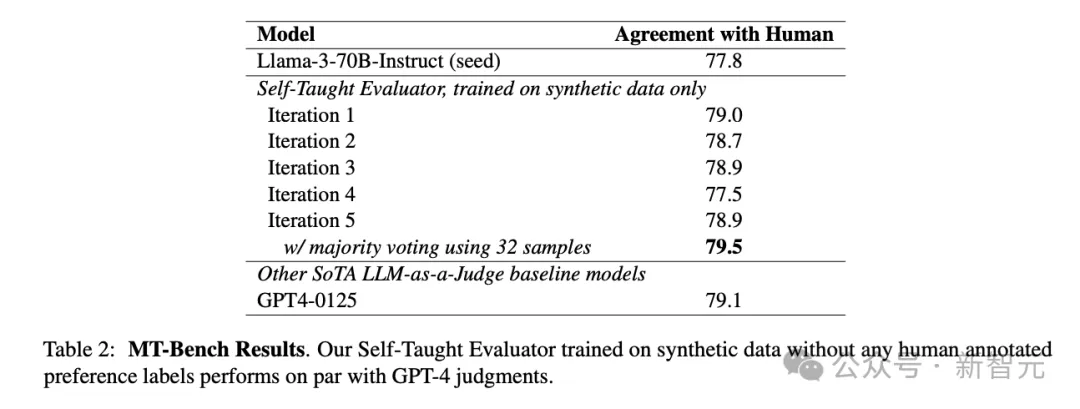

在MT-Bench上的評估結(jié)果如表2所示。雖然分?jǐn)?shù)在第4輪迭代出現(xiàn)一些波動,但訓(xùn)練后的分?jǐn)?shù)依舊有小幅度提升,與GPT-4相當(dāng)。

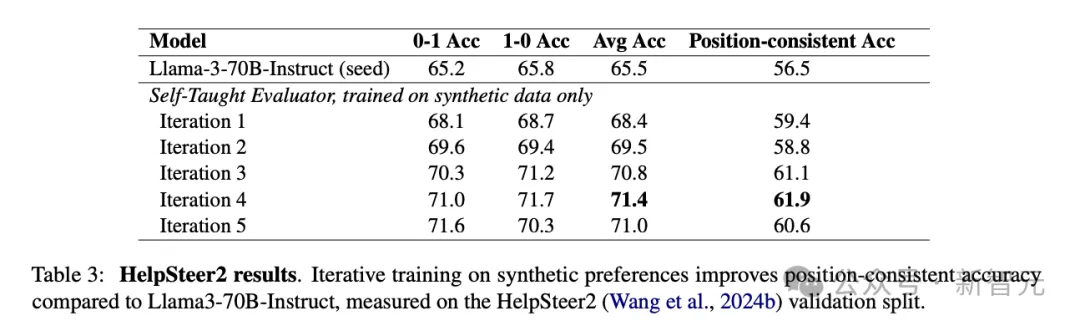

根據(jù)在HelpSteer2上的評估結(jié)果(表3),在合成數(shù)據(jù)上的訓(xùn)練也提升了模型作為judge進(jìn)行判斷時(shí)的平均精度和位置一致精度,但似乎最佳結(jié)果出現(xiàn)在第4輪迭代,多一輪迭代后反而降低了性能。

結(jié)論

總體來看,本文提出了一種可擴(kuò)展的方法,在不使用任何人工標(biāo)注數(shù)據(jù)的情況下構(gòu)建響應(yīng)偏好對,在此基礎(chǔ)上訓(xùn)練的「自學(xué)評估模型」相比種子模型有顯著的性能提升。

作者提出,該研究還存在一些未討論的問題和局限:

- 第一輪訓(xùn)練迭代時(shí),直接使用種子模型生成第一批偏好數(shù)據(jù),但這背后的假設(shè)是Llama-3-70B-Instruct已經(jīng)有生成合理評估的能力;論文并沒有驗(yàn)證該假設(shè)是否成立

- 只使用了Llama-3-70B-Instruct作為種子模型進(jìn)行實(shí)驗(yàn),沒有探究該方法對較小模型的適用性

- 在LLM-as-a-Judge的判斷中,只研究了成對評估這一種模式;其實(shí)模型也可以直接評估單個(gè)響應(yīng)的指令的質(zhì)量

- 相比只輸出分?jǐn)?shù)的獎勵模型,生成式的LLM-as-a-Judge還需要輸出推理鏈,更長的輸出會提升推理成本

作者介紹

Tianlu是Meta FAIR的一名研究科學(xué)家,她本科畢業(yè)于浙江大學(xué)計(jì)算機(jī)科學(xué)專業(yè),博士畢業(yè)于弗吉尼亞大學(xué)。Tianlu的研究主要關(guān)注機(jī)器學(xué)習(xí)模型中有關(guān)公平性、穩(wěn)健性和問責(zé)制的主題,特別是在計(jì)算機(jī)視覺和自然語言處理系統(tǒng)中。