240萬億巨量數據被洗出,足夠訓出18個GPT-4!全球23所機構聯手,清洗秘籍公開

是時候把數據Scale Down了!

如今,這個問題已經迫在眉睫。

清華博士秦禹嘉表示,Llama 3就揭示了一個嚴峻且悲觀的現實:在不改變模型架構的情況下,將數據量從2萬億(2T)增加到15萬億(15T),就能大力出奇跡。

這也就意味著,從長遠來看,基座模型的發展機會,只能獨屬于大公司。

而考慮到Scalng Law的邊際效應,如果我們希望在下一代模型身上看到從GPT-3到GPT-4級別的演進,就需要至少再清洗出至少10個數量級的數據(比如150T)。

就在最近,好消息來了!

DCLM團隊從CommonCrawl里,清洗出了240T的數據。

論文地址:https://arxiv.org/abs/2406.11794

顯然,這給Scaling Law的支持者們帶來了福音——數據是不缺的,然而,你有卡嗎?

后Scaling Law時代:不要Scale Up,要Scale Down

誠然,擴大數據規模非常重要,但如何縮減規模并提高每單位數據的質量,也同樣關鍵。

模型的智能來自于數據壓縮;反之,模型也會重新定義數據的組織方式。

秦禹嘉總結了以下多篇論文的內容后,給出了非常具有綜合性的高度總結。

論文地址:https://arxiv.org/abs/2405.20541

論文地址 :https://arxiv.org/abs/2406.14491

項目地址:https://azure.microsoft.com/en-us/products/phi-3

DeepSeekMath::https://arxiv.org/abs/2402.03300

DeepSeek-Coder-V2:https://arxiv.org/abs/2406.11931

首先,最簡單的方法,就是使用模型過濾掉噪聲數據:

(1)PbP使用小模型的困惑度來過濾數據,從而獲得了可以顯著提高大模型性能和收斂速度的數據;

(2)DeepSeek使用fastText清理高質量數據,在數學和代碼場景中取得了出色的成果;

(3)DCLM進行了更詳細的消融研究,發現與BGE嵌入、困惑度等相比,fastText表現最佳。

這些研究無一例外有著相似的發現:「干凈數據+小模型」,可以極大地接近「臟數據+大模型」的效果。

從這個角度來看,增加模型規模,本質上就是讓我們看到在臟數據上訓練的模型能力的上限。

也即是說,大模型在訓練過程中通過使用更多冗余參數自動完成了去噪過程,但如果提前進行數據去噪,實際上需要的模型參數量并不大。

同樣可以得出結論,通過數據微調把大模型打磨得很好,并不意味著訓練大模型效果就會更好。

原因在于:「干凈數據+大模型」和「臟數據+大模型」的效果,不會有太大差異。

總而言之,在前Scaling Law時代,我們強調的是Scale Up,即在數據壓縮后爭取模型智能的上限;在后Scaling Law時代,需要比拼的則是Scale Down,即誰能訓出更具「性價比」的模型。

目前主流的數據縮減方法,是基于模型的數據去噪。

最近,也有一些研究開始使用訓好的模型來改寫預訓練數據。這個過程就需要注意,避免模型在改寫過程中生成虛假信息,同時還要有效地去除數據中的固有噪聲。

Phi-2/Phi-3的成功也驗證了這一點:如果預訓練級別的數據可以被機器處理,用小模型擊敗大模型是很容易的。

不過,目前的方法仍然專注于單個數據點的質量提升,但是在未來,更重要的研究方向就是如何對多個數據點進行語義級別的去重和合并。

這雖然困難,但對Scale Down意義重大。

下面就讓我們看一下,DCLM團隊的這篇論文。

DataComp-LM(DCLM)基準

為了應對訓練數據各種挑戰,研究人員引入了DataComp-LM(DCLM),是語言模型訓練數據管理的「第一個基準」。

傳送門:https://www.datacomp.ai/dclm/

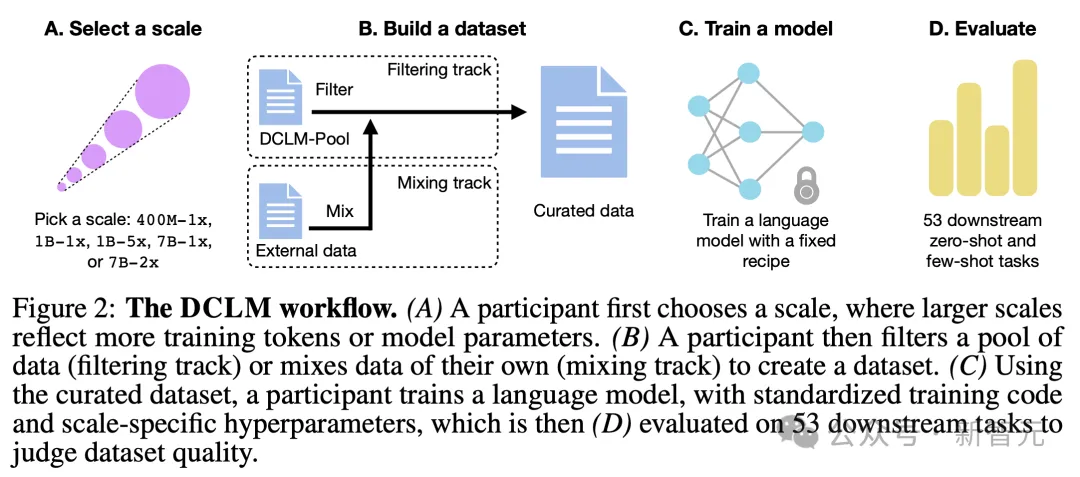

在DCLM中,他們提出了全新的訓練集和數據管理算法,然后通過使用固定的方法,訓練模型以評估數據集。

通過測量由此產生的模型在下游任務上的表現,研究人員可以量化相應訓練集的優勢和劣勢。

接下來,為了實現DCLM,研究人員開發了一個全面的實驗測試平臺,包含了多個重要的組件。

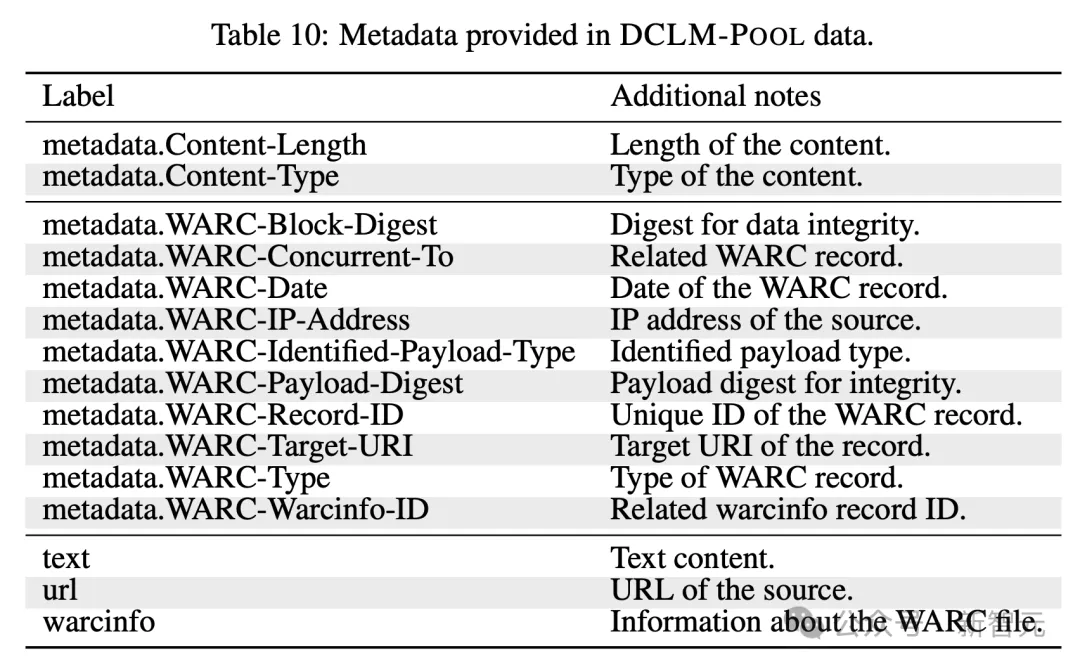

其中一個關鍵的組件,便是最大的語言模型訓練語料庫DCLM-POOL。

這是從未經過濾的爬蟲網站Common Crawl上,扒下來來足足有240T的數據集,涵蓋了2023年之前所有的數據。

具體來說,DCLM-POOL包含2000億個文檔(gzip壓縮后為370TB),產生了240萬億個GPT-NeoX token。

據介紹,獲取如此龐大的數據,是通過resiliparse架構從HTML中重新提取文本,與Common Crawl原本預處理的方法并不相同。

此外,在訓練AI語言模型時,有時候用來測試模型的數據會不小心混入訓練數據中。這就像LLM在考試前偷看了試卷,這可能會導致測試結果不準確。

然而,這些樣本對下游性能的影響,在很大程度上業界研究人員對此仍不清楚。

為了讓人們更好地理解這一問題,研究人員并沒有去清理數據,而是發布了「去數據污染」的工具。

這一工具,可以讓參與者檢查自己的測試集和訓練集,是否有重疊的情況,并提交相關的報告。

對于那些表現最好的AI模型,研究人員會特別檢查它們是否「作弊」。

同樣,論文的研究人員也將這一工具,應用在了DCLM-POOL,以評估數據污染是否影響模型。

不同參數LLM都可PK

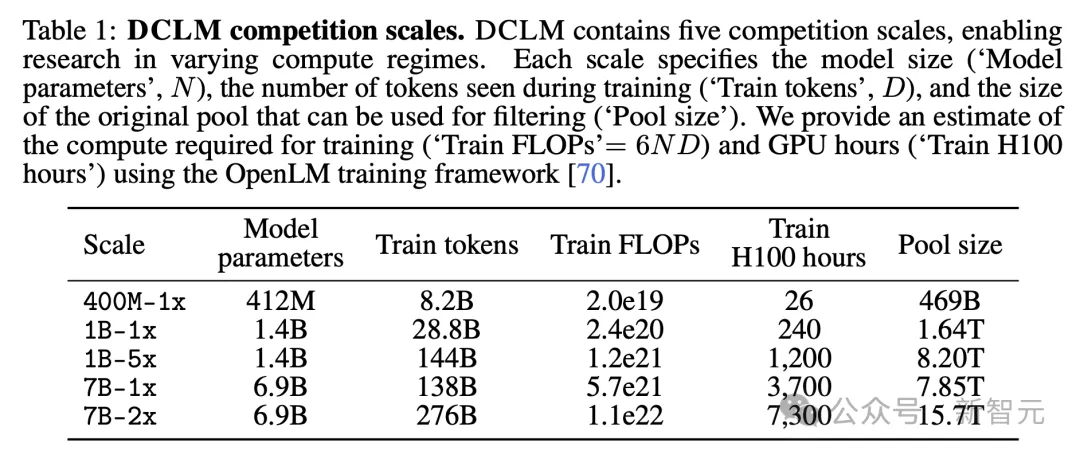

為了確保DCLM對擁有不同計算資源的研究人員能夠訪問,并推動對Scaling Law趨勢的研究,研究人員創建了跨越三個數量級計算規模的不同競賽級別(表1)。

每個級別(即400M-1x、1B-1x、1B-5x、7B-1x和7B-2x)指定了模型參數的數量和一個Chinchilla乘數。

比如,7B-1x中,7B表示模型有70億參數,1x是Chinchilla乘數。

每個級別訓練token數量=20×參數數量×Chinchilla乘數。其中,1x乘數對應的計算資源分配接近Hoffmann等人研究中發現的最優水平。

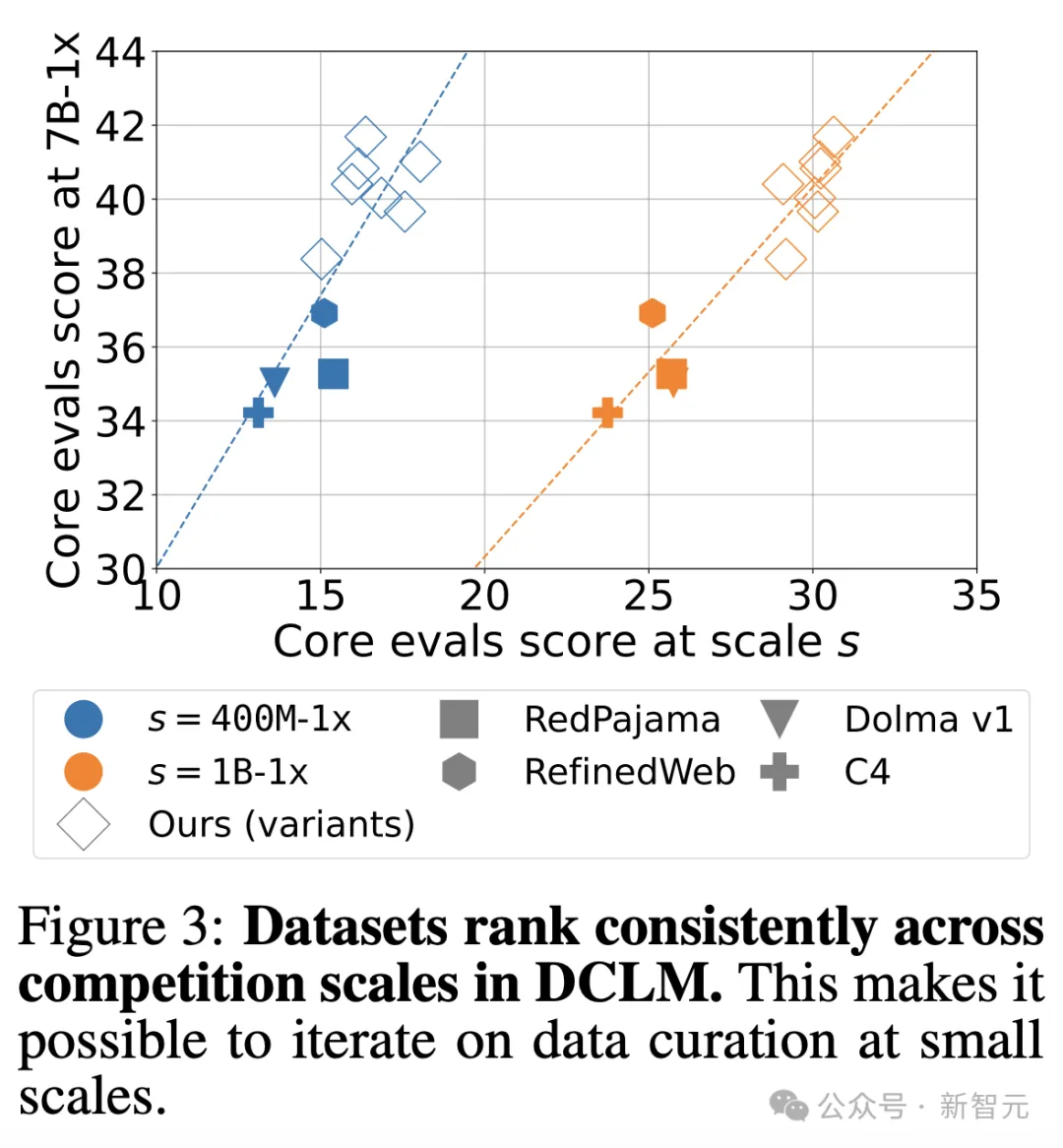

這樣多種參數規模競賽的設計,存在一個問題——當增加計算規模時,數據整理方法的排名可能會發生變化。

由此,研究人員比較了10種方法在不同參數規模(400M-1x、1B-1x和7B-1x)下的表現。

結果發現,小參數(400M-1x、1B-1x)和大參數(7B-1x)結果之間存在高度相關性。

兩大賽道

在參與者選擇了參數規模后,還需從兩個基準測試賽道選擇其一:過濾和混合。

1)在過濾賽道中,參與者提出算法從候選池中選擇訓練數據。有五個不同規模的數據池,對應(表1)不同的計算規模,這些池是DCLM-POOL的隨機文檔子集。研究人員根據參數規模限制初始池的大小,以模擬現實世界的約束。

2)在混合賽道中,允許參與者從多個來源自由組合數據,創造出最好的「配方」。比如,他們可以從DCLM-POOL、自定義爬取的數據、Stack Overflow和維基百科合成數據文檔。

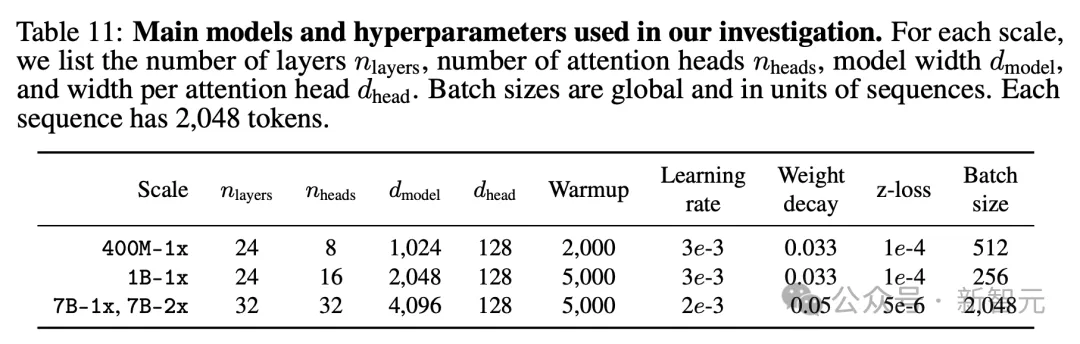

訓練

為了單獨研究數據集干預的效果,研究人員還在每種參數規模上固定一個訓練方案。

基于之前對模型架構和訓練的消融實驗,他們采用了一個僅有解碼器的Transformer模型(例如,GPT-2,Llama),該模型在OpenLM中實現。

下表中詳細列出了模型的超參數。

評估

研究的完整評估套件基于LLM-Foundry,包含53個適合基礎模型評估的下游任務(即無需微調)。

從問答到開放式生成格式,涵蓋了編碼、教科書知識和常識推理等各種領域。

為了評估數據整理算法,主要關注三個性能指標:

1. MMLU 5-shot準確率

2. CORE中心準確率

3. EXTENDED中心準確率

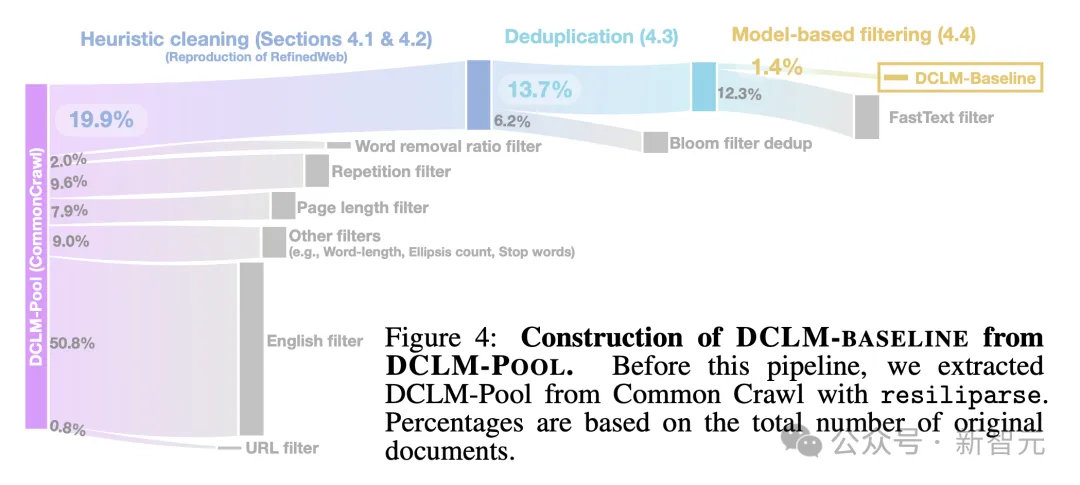

用DCLM構建高質量數據集

接下來,一起看看研究人員是如何使用DCLM構建高質量訓練數據集,整個流程如下圖4所示。

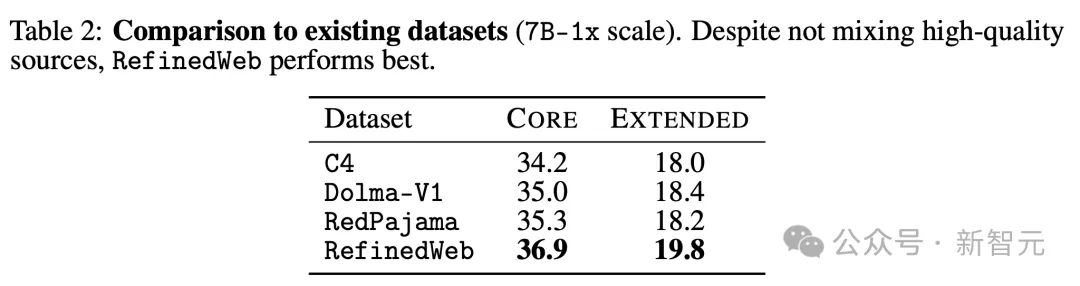

首先,研究人員對表2中幾個著名的數據集進行了評價,發現RefinedWeb在7B-1x規模的核心和擴展指標上表現最好。

有趣的是,RefinedWeb是完全從Common Crawl數據中過濾而來。

RefinedWeb采用了以下過濾管線:Common Crawl文本提取、啟發式數據選擇、重復數據內容刪除。

文本提取

文本提取是一個常見的早期處理步驟,用于從原始HTML中提取內容。

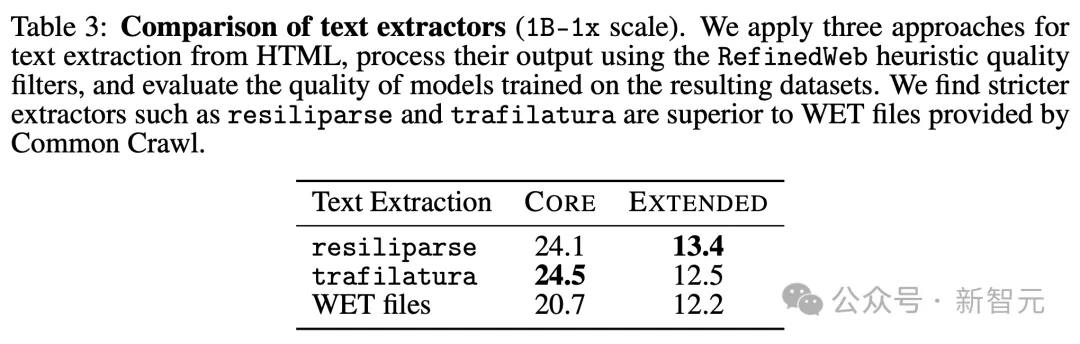

為了理解這一步驟的影響,研究人員比較了三種文本提取方法:resiliparse、trafilatura(RefinedWeb使用)和Common Crawl提供的包含預先提取文本的WET文件。

然后,對每種文本提取結果應用RefinedWeb的啟發式質量過濾器。

在表3中,研究人員發現resiliparse和trafilatura都比WET提取至少提高了2.5個CORE得分。

這很重要,因為大多數開源數據集,包括C4、RedPajama和Dolma-V1,都使用WET提取,這可能部分解釋了它們在表2中表現較差的原因。

雖然resiliparse和trafilatura在下游任務性能上相似,但resiliparse的運行速度快8倍,因此更適合大規模處理。

由此,如前文所述,研究人員最終選擇采用了resiliparse策略。

數據去重

網絡爬蟲的數據集,通常包含許多復或接近重復的數據字符串。

而從訓練集中刪除這些重復項有著雙重目的,既可以減輕LLM記憶來提高性能,又可以增加數據多樣性。

為了去重,研究人員探索了算法MinHash(作為后綴數組管線一部分),以及近似重復的Bloom過濾器(對精確文檔和段落重復數據刪除修改后的方案)。

結果發現,這兩種方法在下游的表現中,性能相當。

在7B-2x參數規模下,差異在0.2個CORE百分點以內。不過,修改后的Bloom過濾器更容易擴展到10TB的數據集。

質量過濾

文獻表明,使用可學習模型作為質量過濾器,可以帶來下游的改進。

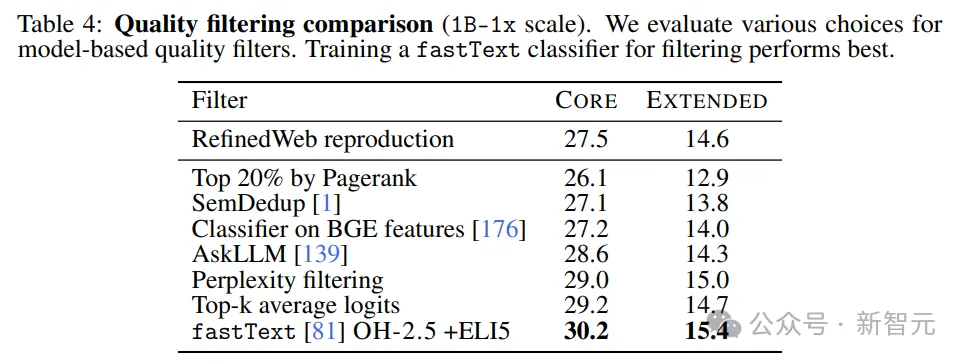

研究人員比較了多種基于模型的過濾方法——

1. 使用PageRank得分進行過濾,根據文檔與其他文檔鏈接的可能性來保留文檔;

2. 語義去重(SemDedup),刪除具有相似信息內容的文檔;

3. 線性分類器,基于預訓練的BGE文本嵌入;

4. AskLLM,通過提示大語言模型來查看文檔是否有幫助;

5. 困惑度過濾,遵循CCNet保留低困惑度序列,

6. Top-k平均對數:對文檔中所有單詞的top-k模型對數進行平均,以評定模型對k個合理選擇范圍內的正確單詞有多大信心;

7. fastText二元分類器,用于區分數據質量。

比較表4中的各個方法后研究人員發現,基于fastText的過濾優于所有其他方法。

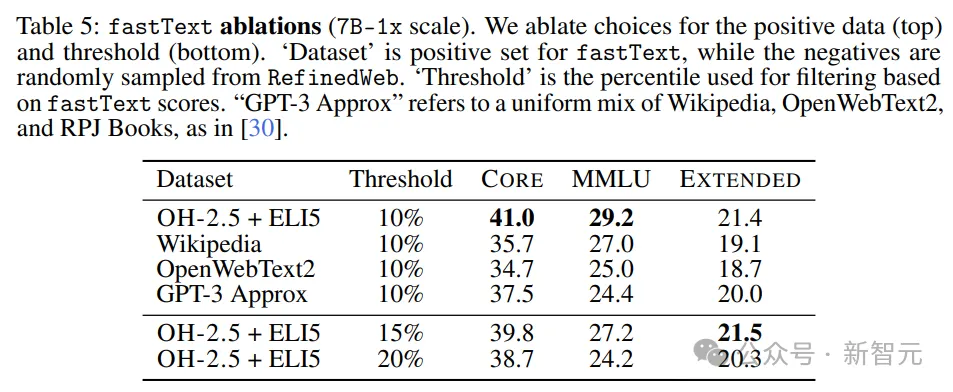

為了更好地理解fastText的局限性,研究人員訓練了幾個變體,探索參考數據、特征空間和過濾閾值的不同選擇,如表5所示。

研究人員發現,在控制其他超參數時,與傳統選擇相比,fastText OH-2.5+ELI5方法的 CORE提升了3.5個百分點。

那么,使用OH-2.5數據進行過濾,是否會妨礙指令調整帶來的額外增益呢?

研究人員發現,情況并非如此。

數據混合

業內的常見做法是,將Common Crawl和其他高質量數據源結合起來,如Wikipedia、arXiv、Stack Exchange和peS2o。

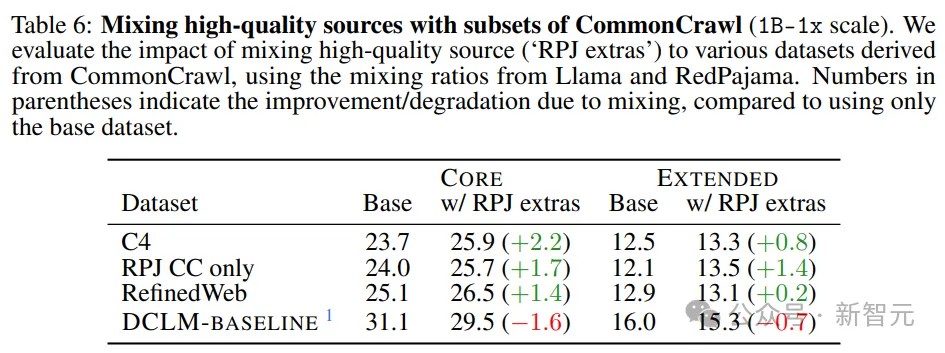

將高質量源添加到僅源自Common Crawl的訓練集,有哪些潛在好處?

研究人員將100%過濾的CC數據訓練的模型,與使用Llama1和RedPajama的混合比例訓練的模型進行了比較。

表6中的結果表明,混合可提高性能較低的CC子集;然而,在高性能過濾的情況下,混合可能會適得其反。

數據清洗

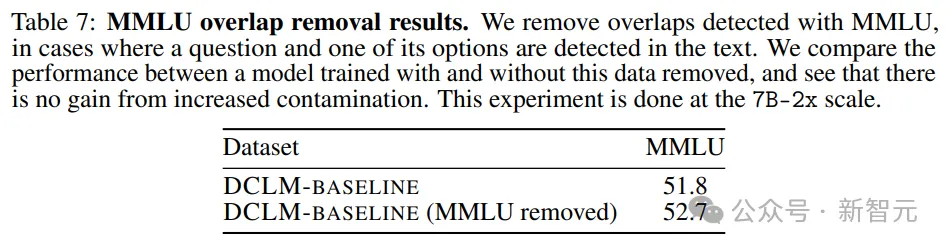

隨后,研究人員進行了分析,以檢查未經評估的預訓練數據污染,是否會影響到結果。他們將重點放在MMLU上。

作為實驗,研究人員還嘗試檢測并刪除MMLU中存在于DCLM-BASELINE中的問題。

結果如表7所示——污染樣品的去除,并不會導致模型的性能下降。

由此可見,MMLU的性能提升并不是由數據集中MMLU的增加引起的。

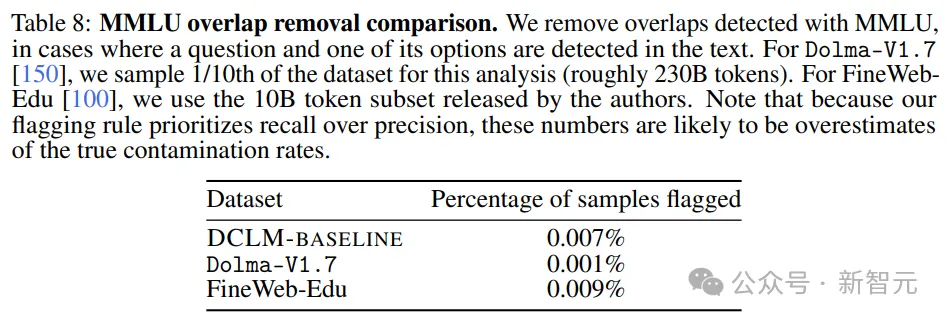

在Dolma-V1.7和FineWeb-Edu上應用上述去除策略可知,DLCM-BASELINE的污染統計數據,和其他高性能數據集大致相似。

擴展萬億token

最后,研究人員測試了DCLM基準上,數據集在更大參數規模(萬億token)下的表現。

為此,確保訓練模型廣泛適用,他們還構建了一個4.1T token的數據集,將3.8T的DCLM-BASELINE與StarCoder、ProofPile2數據相結合,包含了數學和編碼任務。

得到數據集之后,研究人員在其之上訓練了一個7B參數的模型,使用了2.5T token,以及與最大競賽參數規模相同的超參數。

其中,還采取了特殊的訓練策略,包括兩個冷卻階段(在200B和270B token時),以及「模型湯」(model soup)。

之后,研究人員采用了持續預訓練方法,在在相同分布上再訓練100B個token,將上下文長度從2048增加到8192。

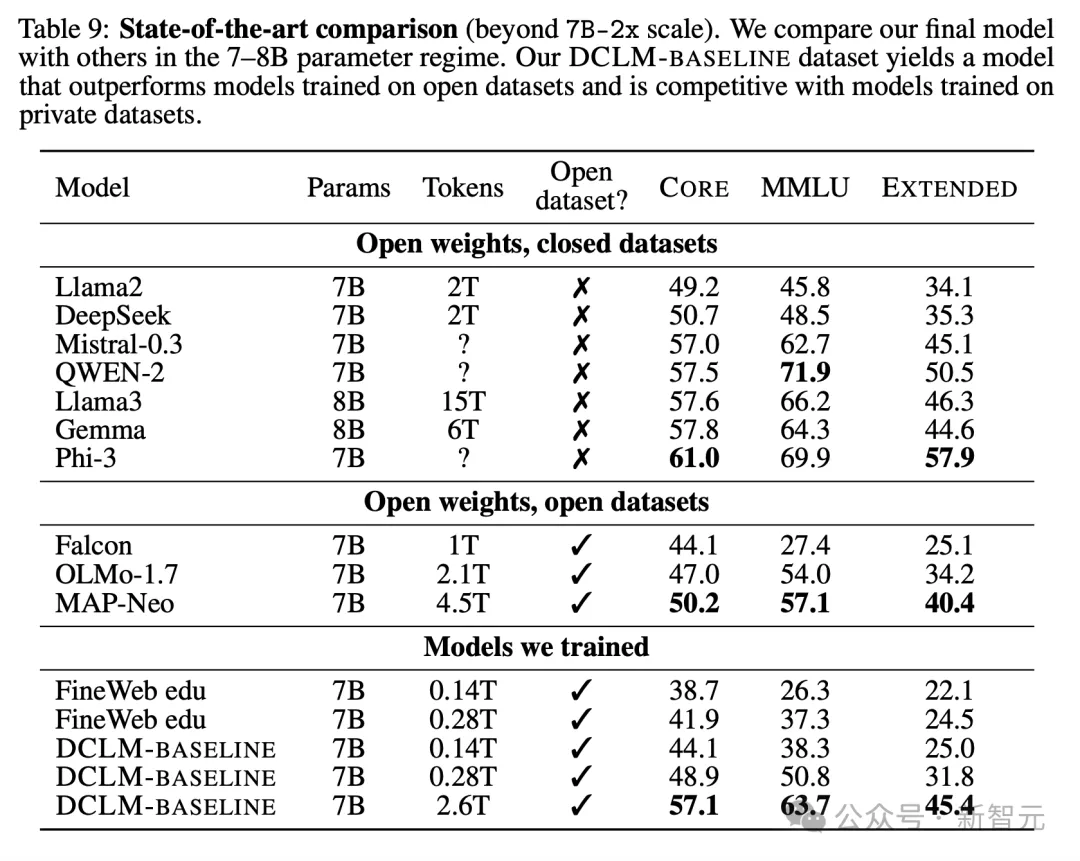

在表9中,展示了新模型優于所有在公開訓練集上訓練的7B模型,并接近于訓練token更多的閉源模型,如Llama-8B、Mistral-7B和Gemma-7B。

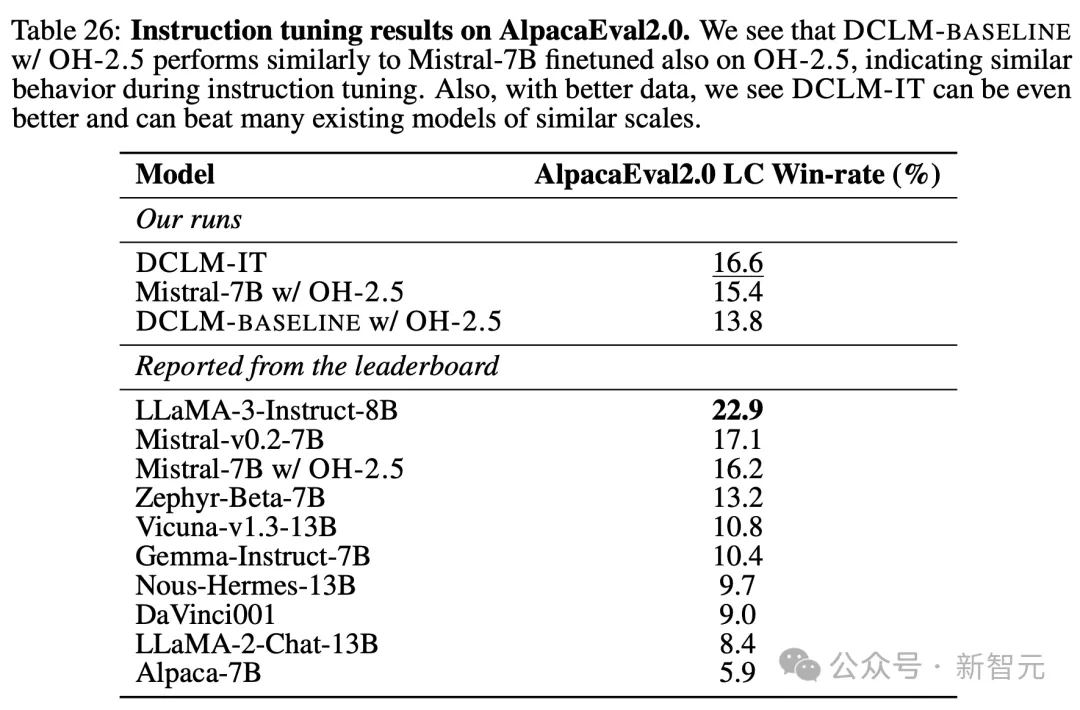

此外,表26展示了新模型在指令微調方面也取得了強勁的表現。

在公開可用的IT數據集上進行指令微調后,研究人員的模型保持了大部分基準性能,并在AlpacaEval2.0 LC中獲得了16.6的勝率,超過了Gemma-Instruct(10.4),同時接近Mistral-v0.2-7B(17.1)和Llama3-Instruct(22.9)的強勁表現。

局限性

由于計算資源的限制,研究人員只能單獨消融設計維度,無法在更大參數規模上測試所有方法。

此外,還有許多未探索的DCLM-BASELINE變體。

例如,更詳細地理解分片去重的影響很重要,而且在訓練過濾模型方面,無論是架構還是訓練數據,都還有很多其他方法。

研究中大多數實驗也僅使用了一種分詞器(GPT-NeoX),其他分詞器可能在多語言任務或數學方面表現更好。

另一個局限是,論文無法充分探索不同隨機種子導致的運行間的差異。

盡管在DCLM-BASELINE上訓練的7B模型在常見的語言理解評估中具有競爭力,但它們目前在代碼和數學方面的表現還不夠理想。

研究人員對此表示,下一步,將會繼續測試能否擴展到更大參數規模的模型。