不依賴Token,字節級模型來了!直接處理二進制數據

最新GPT,不預測token了。

微軟亞研院等發布bGPT,仍舊基于Transformer,但是模型預測的是下一個字節(byte)。

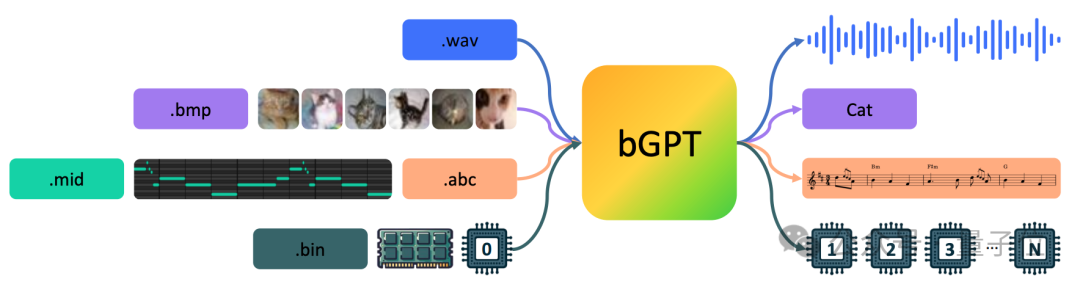

通過直接處理原生二進制數據,bGPT將所有輸入內容都視為字節序列,從而可以不受限于任何特定的格式或任務。

能預測CPU行為,準確率超過99.99%;還能直接模擬MIDI——一種音樂傳輸和存儲的標準格式。

研究團隊認為,傳統的深度學習往往忽視了字節——數字世界的構建基石。

不論是信息的形式還是操作,都是通過二進制格式編碼和處理的。字節構成了所有數據、設備和軟件的基礎,從計算機處理器到我們日常使用的電子產品中的操作系統。

這篇論文的標題清晰地指出了其目標:

超越語言模型:將字節模型作為數字世界的模擬器。

模擬CPU行為準確率超99.99%

bGPT通過字節級處理,不僅能夠應用于常規的AI生成和理解任務,還能處理更多非傳統應用。

例如,它能夠直接模擬MIDI——一種音樂傳輸和存儲的標準格式,之前的研究由于MIDI的二進制本質而避免了直接對這類數據的建模。

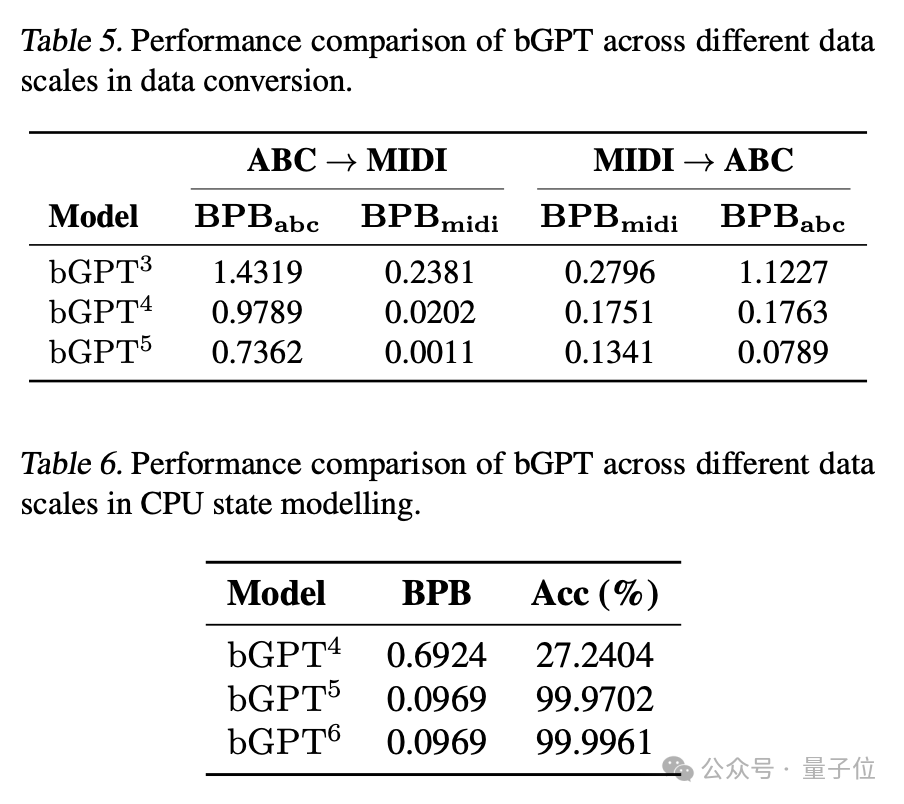

但bGPT天生適合此類任務。它能夠準確模擬符號音樂數據轉換算法,在將ABC記譜法轉換為MIDI格式時,達到極低的錯誤率(0.0011 BPB)。

在模擬CPU行為方面,bGPT展現出超過99.99%的準確率。這些實驗顯示了bGPT在處理原生二進制數據方面的強大能力和可擴展性。

bGPT還展示了在處理諸如文本、圖像和音頻傳統媒體文件的生成/分類任務上的潛力,而且不需要任何針對特定模態的定制。

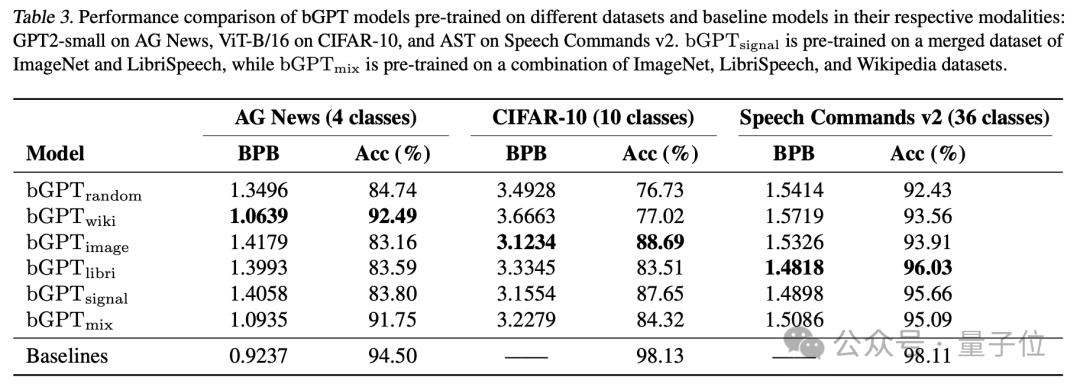

研究團隊訓練了一個大約有100M參數的bGPT,根據論文中的實驗結果,bGPT可以與同樣規模的文本模型(GPT-2)、視覺模型(ViT)和音頻模型(AST)在各自的模態下有著可比的性能。

字節到塊策略:拓展序列建模長度

在處理數字數據時,bGPT代表了一次重要的進步。

因為字節的粒度非常細,處理的字節序列通常較長,這對基于Transformer的傳統模型來說是一個挑戰。由于自注意機制的復雜度是二次方的,處理長序列的效率和可擴展性受到了限制。

bGPT的研發團隊此前在音樂AI領域推出了CLaMP項目,并因此在ISMIR 2023上獲得了最佳學生論文獎。

基于這項成果,bGPT采取了一種“字節到塊(patch)”的轉化方法。這個方法不僅極大提升了數據處理效率,還讓長序列數據的處理和擴展變得更加簡便。

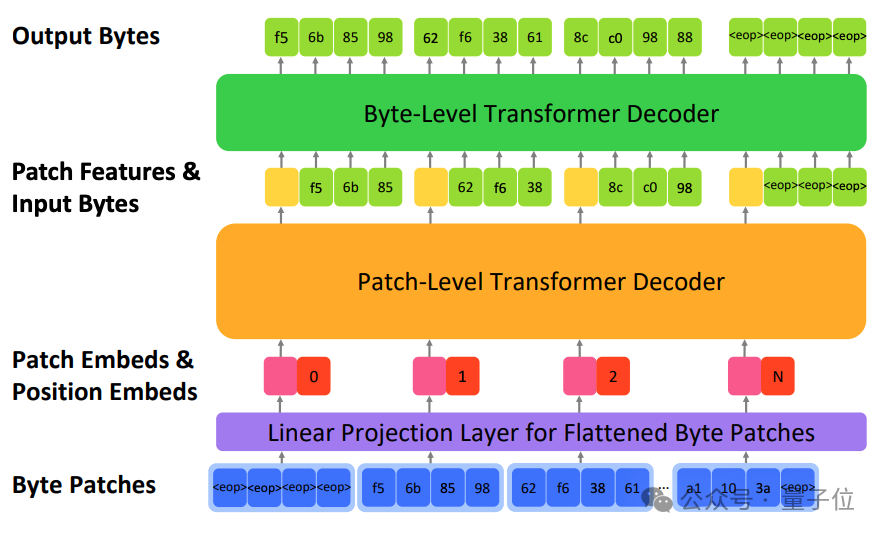

bGPT包含三個關鍵組成部分:

- 線性投影層:通過線性投影將每個字節塊轉化為密集向量表示,既保留了關鍵信息,又降低了維度。

- 塊級解碼器:順序處理塊的embeddings以預測下一個塊的特征,使用自回歸機制學習字節序列的整體結構。

- 字節級解碼器:根據塊級解碼器的預測特征來預測每個塊內的字節序列,這一過程獨立于每個塊進行,依據當前塊的特征表示。

bGPT提供了一種有前景的解決方案來應對傳統模型在處理字節級數據時面臨的挑戰,顯著提高了處理大規模數字數據序列的效率和可擴展性。

拓寬邊界:bGPT與未來數字世界的無限潛力

盡管bGPT展現出巨大的潛力,但其也存在一定的局限性和改進空間。

目前,bGPT只能處理不超過8KB的數據序列,對于需要生成大量數據的現代應用來說,這一容量顯然不夠。這一局限主要由于訓練和部署這類模型需要巨大的計算資源需求。

為了推進bGPT的實用性和適用范圍,未來的研究將專注于開發更高效的算法和利用硬件進步以降低計算成本,使bGPT能夠更加經濟高效地處理更大規模的數據序列,從而拓寬其應用前景。

在探討字節模型未來的話題中,來自世界各地的網友們已經提出了一系列腦洞。

他們探討了在裸機上運行純粹的神經網絡,以取代操作系統執行命令的前景,或者利用網絡修剪和自我學習來優化連接,使得超大規模網絡具備自我重構的能力。

雖然實現這些目標需要時間,但bGPT有望實現將所有數據以字節形式輸入,通過超大規模自我重構網絡處理后再以字節形式輸出的終極目標。

或許,在探索bGPT能力的邊界時,想象力才是唯一的限制。

長期來看,bGPT展示的字節模型在推動人工智能進步方面展現了兩大巨大潛能。

首先,它有望實現一個統一模型,將計算機中的所有數據整合起來,為實現真正的通用人工智能(AGI)邁出關鍵一步。

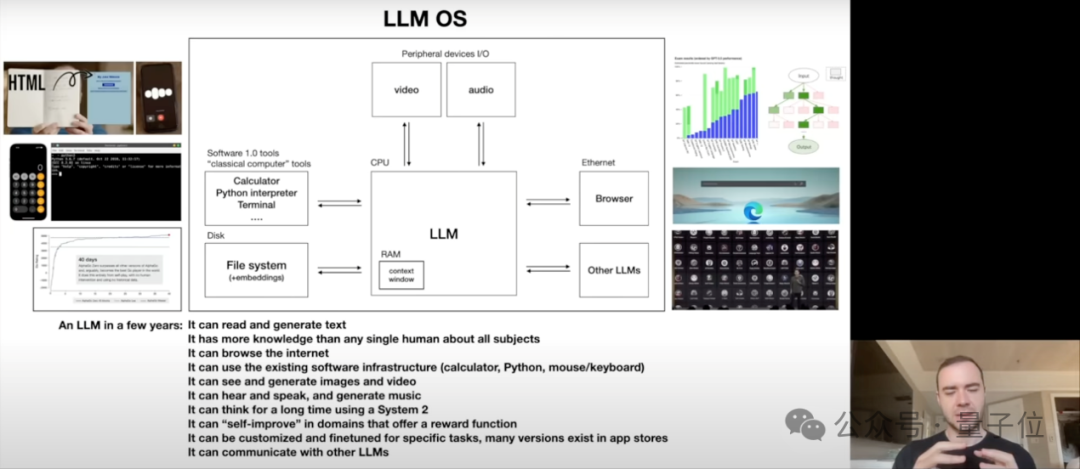

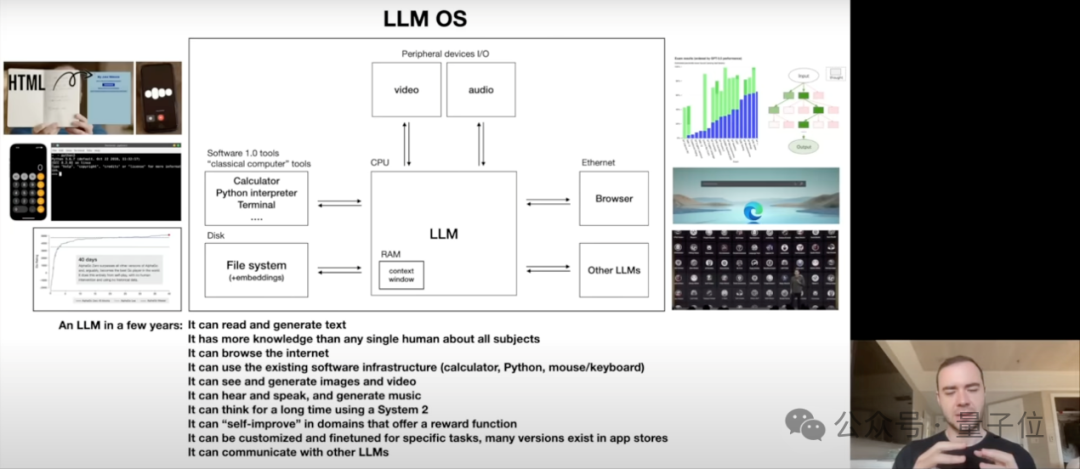

其次,bGPT推動了將AI作為操作系統(LLM OS)的概念,即利用這種字節模型作為核心,直接與文件、軟件及底層硬件數據進行深度交互。

這不僅與Andrej Karpathy的AI愿景不謀而合,更重要的是,它開啟了使用AI模擬數字世界各種層面的可能性——從精確模擬CPU操作到系統級軟件的行為模擬,bGPT的能力遠超傳統界限。通過這種方式,bGPT有望成為數字世界的全面模擬器,探索和理解從基礎硬件到復雜系統級軟件操作的每一個角落。

單憑對計算機文本數據的深入建模,我們已經見證了ChatGPT如何引發社會的廣泛關注。

然而,文本數據在數字世界中海量數據的宏觀圖景里,不過只是冰山一角而已。想象一下,如果我們能夠利用計算機中存儲的所有形式的數據——無論是文本、圖像、音頻,還包括更復雜的二進制數據,乃至軟件、操作系統和硬件本身的信息——來訓練模型,能否創造出一個更加深入理解和精確模擬數字世界各個層面的模型?

bGPT的代碼和模型已開源,如果你對探索字節級模型感興趣,可以嘗試在自己的數據集上使用bGPT進行訓練,大膽探索它的潛能。

論文:https://arxiv.org/abs/2402.19155。

代碼:https://github.com/sanderwood/bgpt。

模型:https://huggingface.co/sander-wood/bgpt。

項目主頁:https://byte-gpt.github.io。