用上這個工具包,大模型推理性能加速達40倍

英特爾? Extension for Transformer是什么?

英特爾? Extension for Transformers[1]是英特爾推出的一個創新工具包,可基于英特爾? 架構平臺,尤其是第四代英特爾? 至強? 可擴展處理器(代號Sapphire Rapids[2],SPR)顯著加速基于Transformer的大語言模型(Large Language Model,LLM)。其主要特性包括:

- 通過擴展Hugging Face transformers API[3]和利用英特爾? Neural Compressor[4],為用戶提供無縫的模型壓縮體驗;

- 提供采用低位量化內核(NeurIPS 2023:在CPU上實現高效LLM推理[5])的LLM推理運行時,支持Falcon、LLaMA、MPT、Llama2、 BLOOM、OPT、ChatGLM2、GPT-J-6B、Baichuan-13B-Base、Baichuan2-13B-Base、Qwen-7B、Qwen-14B和Dolly-v2-3B等常見的LLM[6];

- 先進的壓縮感知運行時[7](NeurIPS 2022:在CPU上實現快速蒸餾和QuaLA-MiniLM:量化長度自適應MiniLM;NeurIPS 2021:一次剪枝,一勞永逸:對預訓練語言模型進行稀疏/剪枝)。

本文將重點介紹其中的LLM推理運行時(簡稱為“LLM運行時”),以及如何利用基于Transformer的API在英特爾? 至強? 可擴展處理器上實現更高效的LLM推理和如何應對LLM在聊天場景中的應用難題。

LLM運行時(LLM Runtime)

英特爾? Extension for Transformers提供的LLM Runtime[8]是一種輕量級但高效的LLM推理運行時,其靈感源于GGML[9],且與llama.cpp[10]兼容,具有如下特性:

- 內核已針對英特爾? 至強? CPU內置的多種AI加速技術(如 AMX、VNNI)以及AVX512F和AVX2指令集進行了優化;

- 可提供更多量化選擇,例如:不同的粒度(按通道或按組)、不同的組大小(如:32/128);

- 擁有更優的KV緩存訪問以及內存分配策略;

- 具備張量并行化功能,可助力在多路系統中進行分布式推理。

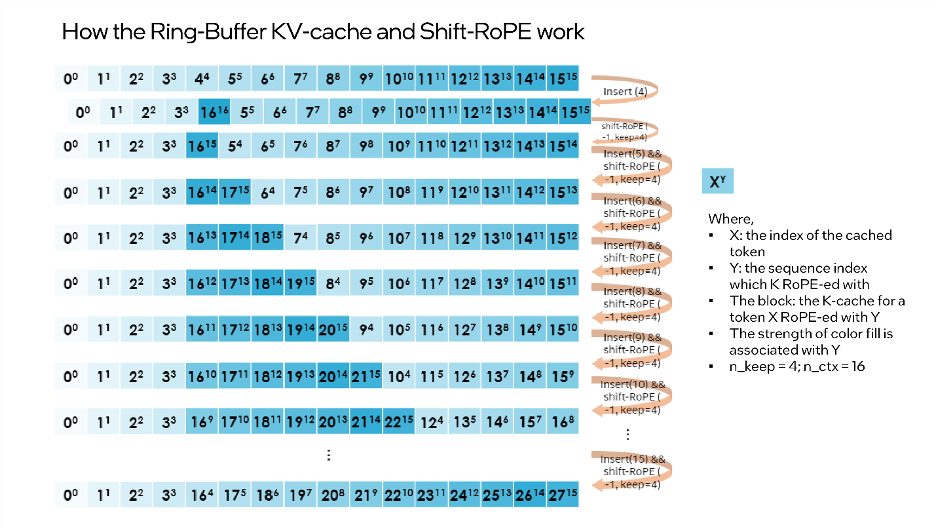

LLM Runtime的簡化架構圖如下:

△圖1.英特爾? Extension for Transformers的LLM Runtime簡化架構圖

使用基于Transformer的API,在CPU上實現LLM高效推理

只需不到9行代碼,即可讓您在CPU上實現更出色的LLM推理性能。用戶可以輕松地啟用與Transformer類似的API來進行量化和推理。只需將 ‘load_in_4bit’設為true,然后從HuggingFace URL或本地路徑輸入模型即可。下方提供了啟用僅限權重的(weight-only)INT4量化的示例代碼:

from transformers import AutoTokenizer, TextStreamer

from intel_extension_for_transformers.transformers import AutoModelForCausalLM

model_name = "Intel/neural-chat-7b-v3-1”

prompt = "Once upon a time, there existed a little girl,"

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

inputs = tokenizer(prompt, return_tensors="pt").input_ids

streamer = TextStreamer(tokenizer)

model = AutoModelForCausalLM.from_pretrained(model_name, load_in_4bit=True)

outputs = model.generate(inputs, streamer=streamer, max_new_tokens=300)默認設置為:將權重存儲為4位,以8位進行計算。但也支持不同計算數據類型(dtype)和權重數據類型組合,用戶可以按需修改設置。下方提供了如何使用這一功能的示例代碼:

from transformers import AutoTokenizer, TextStreamer

from intel_extension_for_transformers.transformers import AutoModelForCausalLM, WeightOnlyQuantConfig

model_name = "Intel/neural-chat-7b-v3-1”

prompt = "Once upon a time, there existed a little girl,"

woq_config = WeightOnlyQuantConfig(compute_dtype="int8", weight_dtype="int4")

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

inputs = tokenizer(prompt, return_tensors="pt").input_ids

streamer = TextStreamer(tokenizer)

model = AutoModelForCausalLM.from_pretrained(model_name,quantization_cnotallow=woq_config)

outputs = model.generate(inputs, streamer=streamer, max_new_tokens=300)性能測試

經過持續努力,上述優化方案的INT4性能得到了顯著提升。本文在搭載英特爾? 至強? 鉑金8480+的系統上與llama.cpp進行了性能比較;系統配置詳情如下:@3.8GHz,56核/路,啟用超線程,啟用睿頻,總內存 256 GB (16 x 16 GB DDR5 4800 MT/s [4800 MT/s]),BIOS 3A14.TEL2P1,微代碼0x2b0001b0,CentOS Stream 8。

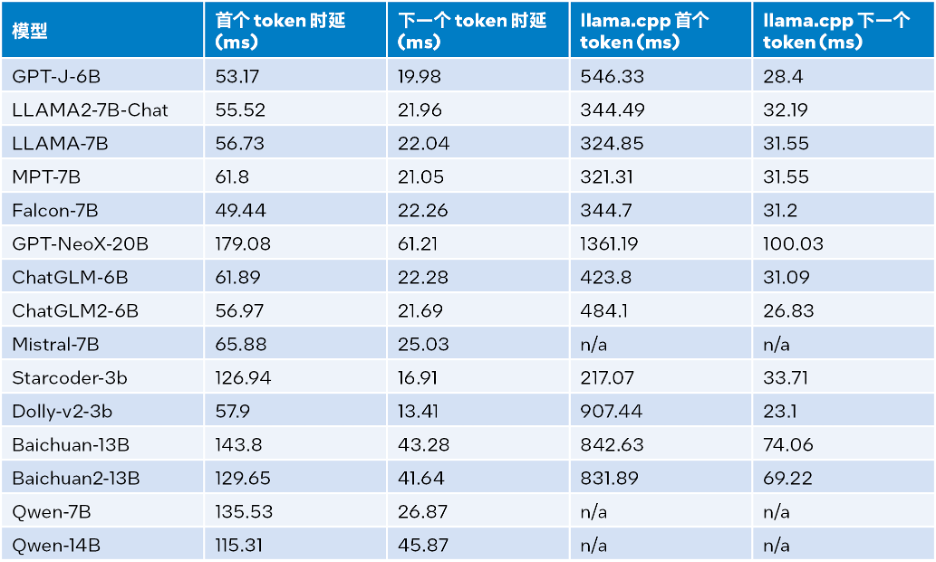

當輸入大小為32、輸出大小為32、beam為1時的推理性能測試結果,詳見下表:

△表1.LLM Runtime與llama.cpp推理性能比較(輸入大小=32,輸出大小=32,beam=1)

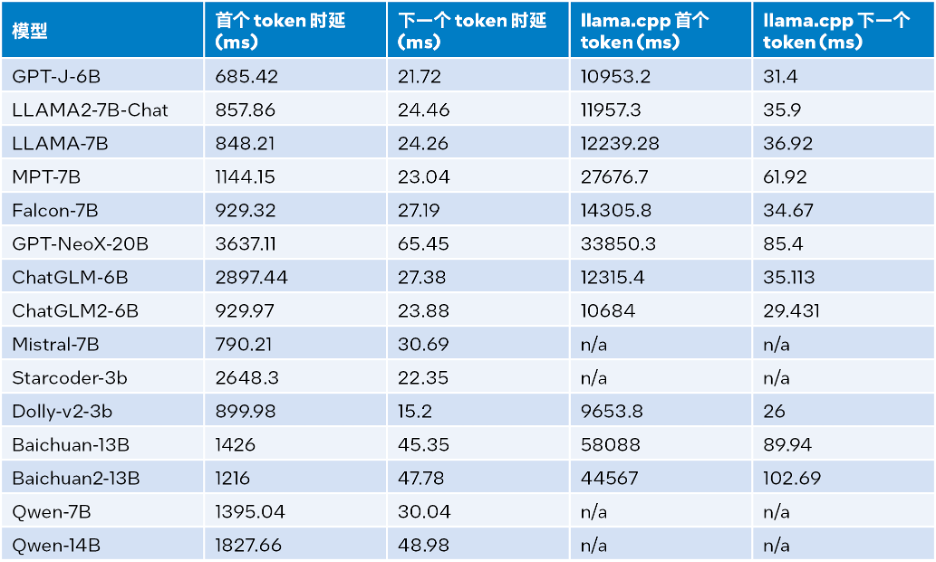

輸入大小為1024、輸出大小為32、beam為1時的推理性能的測試結果,詳見下表:

△表2.LLM Runtime與llama.cpp推理性能比較(輸入大小=1024,輸出大小=32,beam=1)

根據上表2可見:與同樣運行在第四代英特爾? 至強? 可擴展處理器上的llama.cpp相比,無論是首個token還是下一個token,LLM Runtime都能顯著降低時延,且首個token和下一個token的推理速度分別提升多達 40 倍[a](Baichuan-13B,輸入為1024)和2.68倍[b](MPT-7B,輸入為1024)。llama.cpp的測試采用的是默認代碼庫[10]。

而綜合表1和表2的測試結果,可得:與同樣運行在第四代英特爾? 至強? 可擴展處理器上的llama.cpp相比,LLM Runtime能顯著提升諸多常見LLM的整體性能:在輸入大小為1024時,實現3.58到21.5倍的提升;在輸入大小為32時,實現1.76到3.43倍的提升[c]。

準確性測試

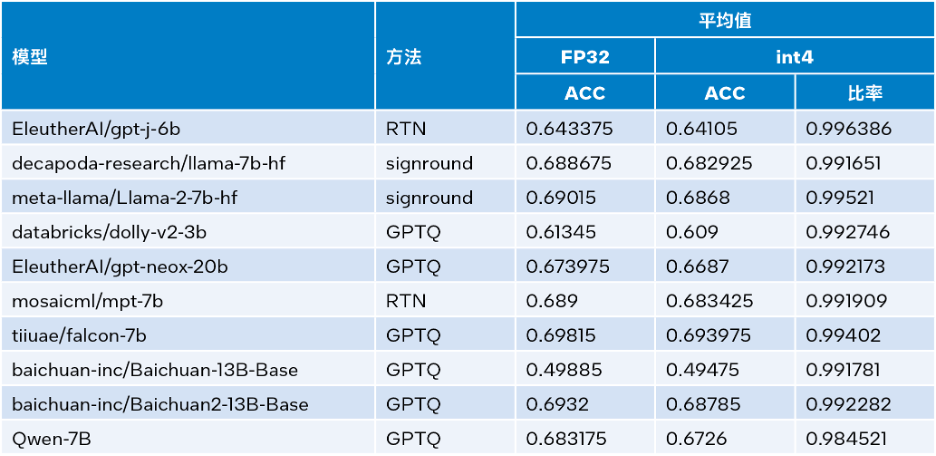

英特爾? Extension for Transformers可利用英特爾? Neural Compressor中的SignRound[11]、RTN和GPTQ[12]等量化方法,并使用lambada_openai、piqa、winogrande和hellaswag數據集驗證了 INT4 推理準確性。下表是測試結果平均值與FP32準確性的比較。

△表3.INT4與FP32準確性對比

從上表3可以看出,多個模型基于LLM Runtime進行的INT4推理準確性損失微小,幾乎可以忽略不記。我們驗證了很多模型,但由于篇幅限制此處僅羅列了部分內容。如您欲了解更多信息或細節,請訪問此鏈接:https://medium.com/@NeuralCompressor/llm-performance-of-intel-extension-for-transformers-f7d061556176。

更先進的功能:滿足LLM更多場景應用需求

同時,LLM Runtime[8]還具備雙路CPU的張量并行化功能,是較早具備此類功能的產品之一。未來,還會進一步支持雙節點。

然而,LLM Runtime的優勢不僅在于其更出色的性能和準確性,我們也投入了大量的精力來增強其在聊天應用場景中的功能,并且解決了LLM 在聊天場景中可能會遇到的以下應用難題:

- 對話不僅關乎LLM推理,對話歷史也很有用。

- 輸出長度有限:LLM模型預訓練主要基于有限的序列長度。因此,當序列長度超出預訓練時使用的注意力窗口大小時,其準確性便會降低。

- 效率低下:在解碼階段,基于Transformer的LLM會存儲所有先前生成的token的鍵值狀態(KV),從而導致內存使用過度,解碼時延增加。

關于第一個問題,LLM Runtime的對話功能通過納入更多對話歷史數據以及生成更多輸出加以解決,而llama.cpp目前尚未能很好地應對這一問題。

關于第二和第三個問題,我們將流式LLM(Steaming LLM)集成到英特爾? Extension for Transformers中,從而能顯著優化內存使用并降低推理時延。

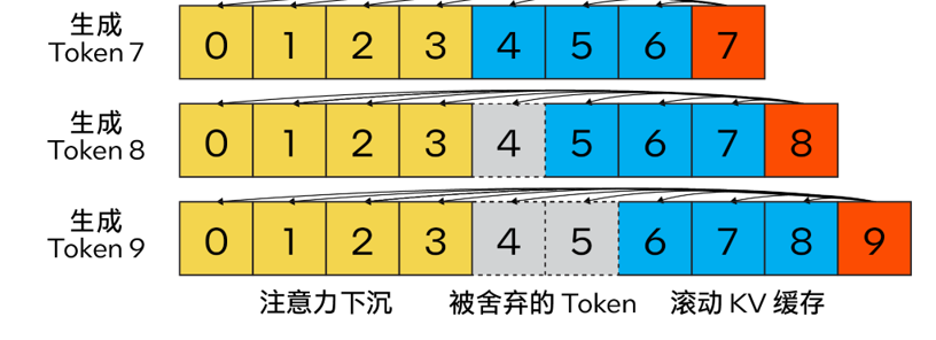

Streaming LLM

與傳統KV緩存算法不同,我們的方法結合了注意力匯聚(Attention Sink)(4個初始token)以提升注意力計算的穩定性,并借助滾動KV緩存保留最新的token,這對語言建模至關重要。該設計具有強大的靈活性,可無縫集成到能夠利用旋轉位置編碼RoPE和相對位置編碼ALiBi的自回歸語言模型中。

△圖2.Steaming LLM的KV緩存(圖片來源:通過注意力下沉實現高效流式語言模型[13])

此外,與llama.cpp不同,本優化方案還引入了“n_keep”和“n_discard”等參數來增強Streaming LLM策略。用戶可使用前者來指定要在KV緩存中保留的token數量,并使用后者來確定在已生成的token中要舍棄的數量。為了更好地平衡性能和準確性,系統默認在KV緩存中舍棄一半的最新token。

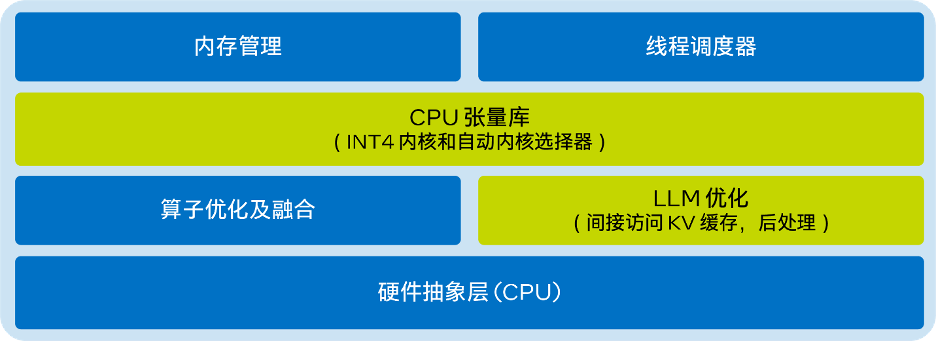

同時,為進一步提高性能,我們還將Streaming LLM添加到了MHA融合模式中。如果模型是采用旋轉位置編碼(RoPE)來實現位置嵌入,那么只需針對現有的K-Cache應用“移位運算(shift operation)”,即可避免對先前生成的、未被舍棄的token進行重復計算。這一方法不僅充分利用了長文本生成時的完整上下文大小,還能在KV緩存上下文完全被填滿前不產生額外開銷。

“shift operation”依賴于旋轉的交換性和關聯性,或復數乘法。例如:如果某個token的K-張量初始放置位置為m并且旋轉了m×θi for i ∈ [0,d/2),那么當它需要移動到m-1這個位置時,則可以旋轉回到(-1)×θi for i ∈ [0,d/2)。這正是每次舍棄n_discard個token的緩存時發生的事情,而此時剩余的每個token都需要“移動”n_discard個位置。下圖以“n_keep=4、n_ctx=16、n_discard=1”為例,展示了這一過程。

△圖3.Ring-Buffer KV-Cache和Shift-RoPE工作原理

需要注意的是:融合注意力層無需了解上述過程。如果對K-cache和V-cache進行相同的洗牌,注意力層會輸出幾乎相同的結果(可能存在因浮點誤差導致的微小差異)。

您可通過以下代碼啟動Streaming LLM:

from transformers import AutoTokenizer, TextStreamer

from intel_extension_for_transformers.transformers import AutoModelForCausalLM, WeightOnlyQuantConfig

model_name = "Intel/neural-chat-7b-v1-1" # Hugging Face model_id or local model

woq_config = WeightOnlyQuantConfig(compute_dtype="int8", weight_dtype="int4")

prompt = "Once upon a time, a little girl"

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

inputs = tokenizer(prompt, return_tensors="pt").input_ids

streamer = TextStreamer(tokenizer)

model = AutoModelForCausalLM.from_pretrained(model_name, quantization_cnotallow=woq_config, trust_remote_code=True)

# Recommend n_keep=4 to do attention sinks (four initial tokens) and n_discard=-1 to drop half rencetly tokens when meet length threshold

outputs = model.generate(inputs, streamer=streamer, max_new_tokens=300, ctx_size=100, n_keep=4, n_discard=-1)結論與展望

本文基于上述實踐經驗,提供了一個在英特爾? 至強? 可擴展處理器上實現高效的低位(INT4)LLM推理的解決方案,并且在一系列常見LLM上驗證了其通用性以及展現了其相對于其他基于CPU的開源解決方案的性能優勢。未來,我們還將進一步提升CPU張量庫和跨節點并行性能。

歡迎您試用英特爾? Extension for Transformers[1],并在英特爾? 平臺上更高效地運行LLM推理!也歡迎您向代碼倉庫(repository)提交修改請求 (pull request)、問題或疑問。期待您的反饋!

特別致謝

在此致謝為此篇文章做出貢獻的英特爾公司人工智能資深經理張瀚文及工程師許震中、余振滔、劉振衛、丁藝、王哲、劉宇澄。

[a]根據表2 Baichuan-13B的首個token測試結果計算而得。

[b]根據表2 MPT-7B的下一個token測試結果計算而得。

[c]當輸入大小為1024時,整體性能=首個token性能+1023下一個token性能;當輸入大小為32時,整體性能=首個token性能+31下一個token性能。