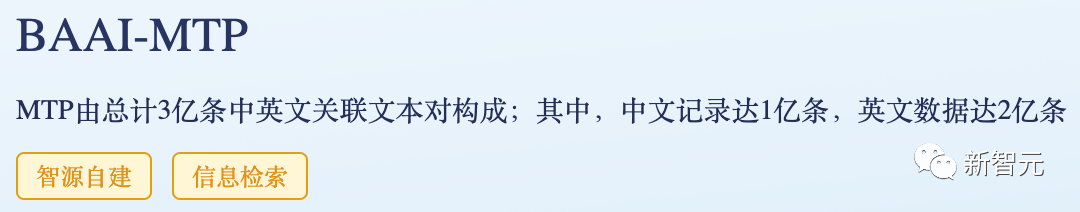

智源發(fā)布全球最大中英文向量模型訓(xùn)練數(shù)據(jù)集!規(guī)模高達(dá)3億文本對(duì)

9月15日,北京人工智能產(chǎn)業(yè)峰會(huì)暨中關(guān)村科學(xué)城科創(chuàng)大賽頒獎(jiǎng)典禮現(xiàn)場(chǎng),智源研究院發(fā)布面向中英文語(yǔ)義向量模型訓(xùn)練的大規(guī)模文本對(duì)數(shù)據(jù)集MTP(massive text pairs)。

這是全球最大的中、英文文本對(duì)訓(xùn)練數(shù)據(jù)集,數(shù)據(jù)規(guī)模達(dá)3億對(duì),具有規(guī)模巨大、主題豐富、數(shù)據(jù)質(zhì)量高三大特征,進(jìn)而可以推動(dòng)解決中文模型訓(xùn)練數(shù)據(jù)集缺乏問(wèn)題。

通用語(yǔ)義向量模型是決定大模型性能的關(guān)鍵組件,可以鏈接外模型與外部知識(shí);由「關(guān)聯(lián)文本」為基本元素的優(yōu)質(zhì)訓(xùn)練數(shù)據(jù),是構(gòu)建通用語(yǔ)義向量模型的核心要素。

本次開(kāi)源的MTP數(shù)據(jù)集,正是智源BGE中英文語(yǔ)義向量模型訓(xùn)練所用中英文數(shù)據(jù)。

3億中英向量模型訓(xùn)練數(shù)據(jù)開(kāi)放

數(shù)據(jù)在大模型訓(xùn)練中至關(guān)重要,構(gòu)建高質(zhì)量開(kāi)源數(shù)據(jù)集,特別是用于訓(xùn)練基礎(chǔ)模型的開(kāi)源數(shù)據(jù)集對(duì)大模型發(fā)展意義重大,然而中文社區(qū)卻鮮少數(shù)據(jù)開(kāi)源貢獻(xiàn)者。

本次發(fā)布的全球最大語(yǔ)義向量模型訓(xùn)練數(shù)據(jù)MTP,具備如下特征:

- 規(guī)模巨大:

3億文本對(duì),中文1億,英文2億。

- 主題豐富:

源自海量?jī)?yōu)質(zhì)文本數(shù)據(jù),涉及搜索、社區(qū)問(wèn)答、百科常識(shí)、科技文獻(xiàn)等多種主題。

- 數(shù)據(jù)質(zhì)量高:

數(shù)據(jù)經(jīng)過(guò)必要的采樣、抽取、過(guò)濾獲得;由該數(shù)據(jù)訓(xùn)練得到的語(yǔ)義向量模型BGE (BAAI General Embedding)性能大幅領(lǐng)先同類(lèi)別模型。

MTP數(shù)據(jù)集鏈接:https://data.baai.ac.cn/details/BAAI-MTP

BGE 模型鏈接:https://huggingface.co/BAAI

BGE 代碼倉(cāng)庫(kù):https://github.com/FlagOpen/FlagEmbedding

鑒于數(shù)據(jù)的重要性,智源在2021年就推出了全球最大語(yǔ)料庫(kù)WuDaoCorpora,開(kāi)放200GB高質(zhì)量低風(fēng)險(xiǎn)中文語(yǔ)料,由400余個(gè)產(chǎn)學(xué)研單位合作,已有770多個(gè)研發(fā)團(tuán)隊(duì)申請(qǐng),為微軟、哈佛大學(xué)、斯坦福大學(xué)、華為、阿里巴巴、騰訊、鵬城實(shí)驗(yàn)室等提供數(shù)據(jù)服務(wù),有效支撐全球大模型相關(guān)研究。

今年開(kāi)放的最大規(guī)模、可商用、持續(xù)更新的中文開(kāi)源指令數(shù)據(jù)集COIG,由來(lái)自全球40余個(gè)機(jī)構(gòu)的100多名工程師共同參與,創(chuàng)造了跨越國(guó)界、緊密合作的全球數(shù)據(jù)開(kāi)源動(dòng)人故事。

下載達(dá)數(shù)十萬(wàn),廣受歡迎的BGE模型升級(jí)更新

BGE 語(yǔ)義向量模型一經(jīng)發(fā)布就備受大模型開(kāi)發(fā)者社區(qū)關(guān)注,目前Hugging Face累計(jì)下載量達(dá)到數(shù)十萬(wàn),且已被LangChain, LangChain-Chatchat, llama_index 等知名開(kāi)源項(xiàng)目集成。

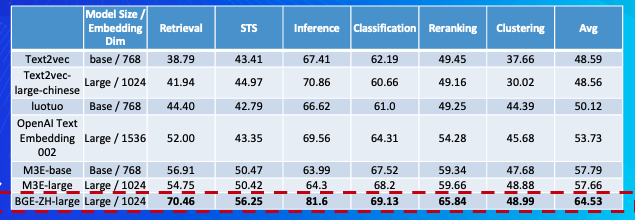

中文語(yǔ)義向量模型評(píng)測(cè)(C-MTEB)

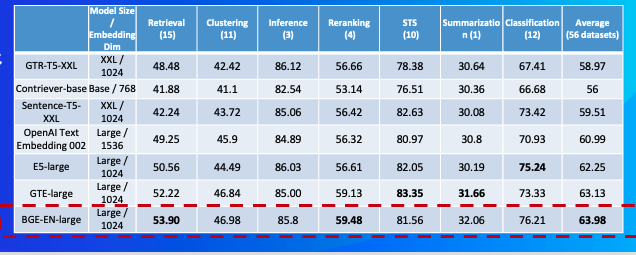

英文語(yǔ)義向量模型評(píng)測(cè)榜(MTEB)

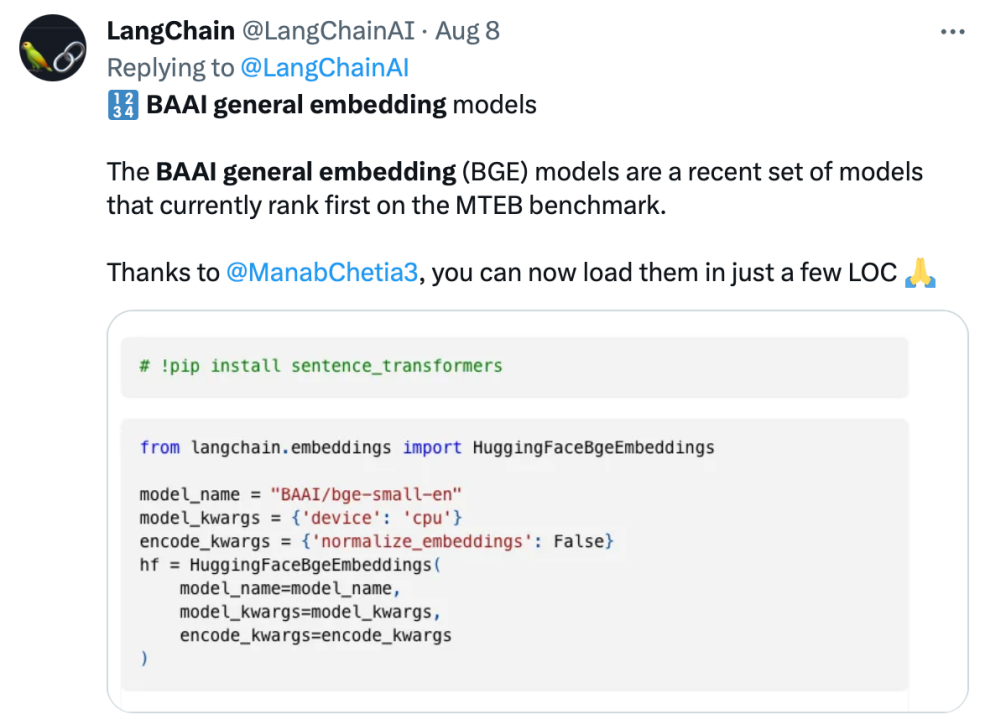

Langchain官方推文:「BGE模型在MTEB基準(zhǔn)上排名第一」

LangChain聯(lián)合創(chuàng)始人兼首席執(zhí)行官Harrison Chase推薦

基于社區(qū)反饋,BGE進(jìn)一步優(yōu)化更新,表現(xiàn)更加穩(wěn)健、出色。具體升級(jí)如下:

- 模型更新:

BGE-*-zh-v1.5緩解了相似度分布問(wèn)題,通過(guò)對(duì)訓(xùn)練數(shù)據(jù)進(jìn)行過(guò)濾,刪除低質(zhì)量數(shù)據(jù),提高訓(xùn)練時(shí)溫度系數(shù)temperature至0.02,使得相似度數(shù)值更加平穩(wěn) 。

- 新增模型:

開(kāi)源BGE-reranker 交叉編碼器模型,可更加精準(zhǔn)找到相關(guān)文本,支持中英雙語(yǔ)。不同于向量模型需要輸出向量,BGE-reranker直接文本對(duì)輸出相似度,排序準(zhǔn)確度更高,可用于對(duì)向量召回結(jié)果的重新排序,提升最終結(jié)果的相關(guān)性。

- 新增功能:

BGE1.1增加難負(fù)樣本挖掘腳本,難負(fù)樣本可有效提升微調(diào)后檢索的效果;在微調(diào)代碼中增加在微調(diào)中增加指令的功能;模型保存也將自動(dòng)轉(zhuǎn)成 sentence transformer 格式,更方便模型加載。

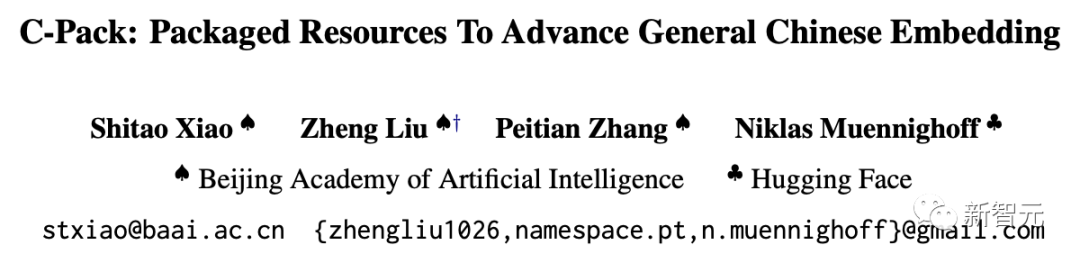

值得一提的是,日前智源聯(lián)合Hugging Face發(fā)布了一篇技術(shù)報(bào)告,報(bào)告提出用C-Pack增強(qiáng)中文通用語(yǔ)義向量模型。

報(bào)告地址:https://arxiv.org/abs/2309.07597

構(gòu)建大模型時(shí)代的類(lèi)Linux生態(tài)

伴隨2022年末ChatGPT 橫空出世,全球大模型研發(fā)進(jìn)入如火如荼的爆發(fā)期,而激烈的競(jìng)爭(zhēng)與高昂的成本,也同時(shí)推動(dòng)著開(kāi)源崛起成為人工智能發(fā)展的關(guān)鍵推動(dòng)力量。

標(biāo)志性的事件是今年5月在全球人工智能圈廣為流傳的一篇Google內(nèi)部文件,聲稱(chēng)「開(kāi)源AI將擊敗谷歌和OpenAI」;來(lái)自Meta的代表性開(kāi)源模型 Llama則對(duì)當(dāng)前產(chǎn)業(yè)發(fā)展起到至關(guān)重要的作用。

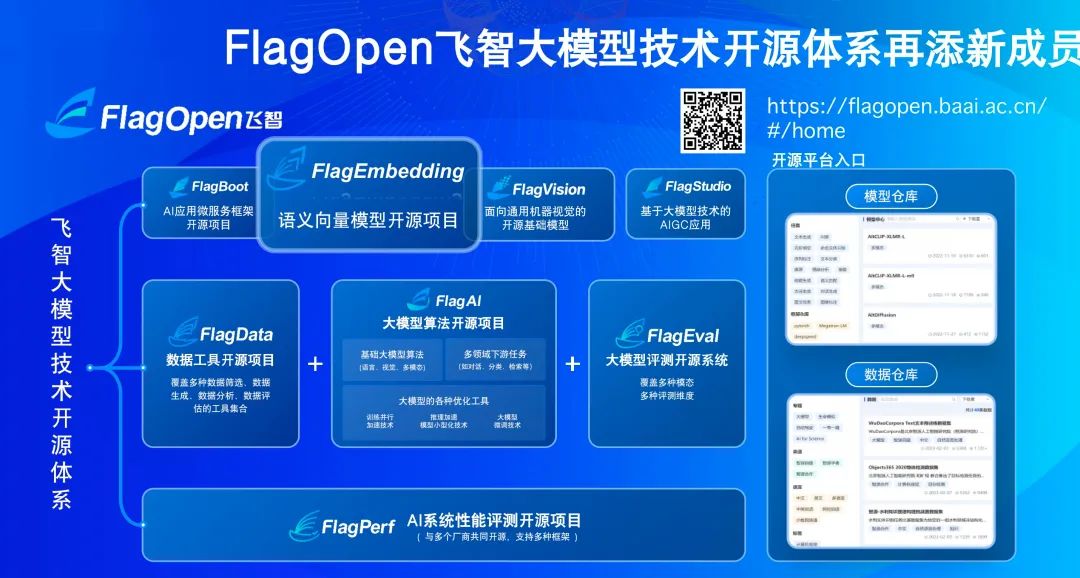

作為中國(guó)大模型開(kāi)源生態(tài)圈的代表機(jī)構(gòu),智源正在著力打造FlagOpen飛智大模型技術(shù)開(kāi)源體系,引領(lǐng)共建共享大模型時(shí)代的「類(lèi)Linux」開(kāi)源開(kāi)放生態(tài)。

上線于2022年11月,正式發(fā)布于2023年2月,F(xiàn)lagOpen大模型技術(shù)開(kāi)源體系先見(jiàn)性地預(yù)見(jiàn)大模型開(kāi)源建設(shè)這一大勢(shì)所趨。

現(xiàn)在,智源大模型技術(shù)開(kāi)體系 FlagOpen 新增 FlagEmbedding 版塊,聚焦于 Embedding 技術(shù)和模型,BGE 是其中首個(gè)開(kāi)源模型。

FlagEmbedding:https://github.com/FlagOpen/FlagEmbedding

在BGE項(xiàng)目之外,F(xiàn)lagOpen還有包括大模型算法、模型、數(shù)據(jù)、工具、評(píng)測(cè)等重要組成部分。

其中,F(xiàn)lagEval(天秤)大模型評(píng)測(cè)體系及開(kāi)放平臺(tái),構(gòu)建3維評(píng)測(cè)體系、覆蓋600余項(xiàng)全面能力評(píng)測(cè),旨在建立科學(xué)、公正、開(kāi)放的評(píng)測(cè)基準(zhǔn)、方法、工具集,協(xié)助研究人員全方位評(píng)估基礎(chǔ)模型及訓(xùn)練算法的性能。

每月發(fā)布的FlagEval大模型評(píng)測(cè)榜單,對(duì)主流模型進(jìn)行多維評(píng)測(cè)解讀,打造公正全面金標(biāo)準(zhǔn),正在愈來(lái)愈成為大模型能力評(píng)價(jià)的風(fēng)向標(biāo)。