再勝OpenAI!谷歌發(fā)布20億參數(shù)通用模型,100多種語(yǔ)言自動(dòng)識(shí)別翻譯

上周,OpenAI發(fā)布的ChatGPT API和Whisper API,剛剛引動(dòng)了一場(chǎng)開(kāi)發(fā)者的狂歡。

3月6日,谷歌就推出了一款對(duì)標(biāo)的模型——USM。不僅可以支持100多種語(yǔ)言,而且參數(shù)量也達(dá)到了20個(gè)億。

當(dāng)然了,模型依然沒(méi)有對(duì)外開(kāi)放,「這很谷歌」!

簡(jiǎn)單來(lái)說(shuō),USM模型在涵蓋1200萬(wàn)小時(shí)語(yǔ)音、280億個(gè)句子和300種不同語(yǔ)言的無(wú)標(biāo)注數(shù)據(jù)集中進(jìn)行了預(yù)訓(xùn)練,并在較小的標(biāo)注訓(xùn)練集中進(jìn)行了微調(diào)。

谷歌的研究人員表示,雖然用于微調(diào)的標(biāo)注訓(xùn)練集僅有Whisper的1/7,但USM卻有著與其相當(dāng)甚至更好的性能,并且還能夠有效地適應(yīng)新的語(yǔ)言和數(shù)據(jù)。

論文地址:https://arxiv.org/abs/2303.01037

結(jié)果顯示,USM不僅在多語(yǔ)種自動(dòng)語(yǔ)音識(shí)別和語(yǔ)音-文本翻譯任務(wù)評(píng)測(cè)中實(shí)現(xiàn)了SOTA,而且還可以實(shí)際用在YouTube的字幕生成上。

目前,支持自動(dòng)檢測(cè)和翻譯的語(yǔ)種包括,主流的英語(yǔ)、漢語(yǔ),以及阿薩姆語(yǔ)這類的小語(yǔ)種。

最重要的是,還能用于谷歌在去年IO大會(huì)展示的未來(lái)AR眼鏡的實(shí)時(shí)翻譯。

Jeff Dean親自官宣:讓AI支持1000種語(yǔ)言

當(dāng)微軟和谷歌就誰(shuí)家擁有更好的AI聊天機(jī)器人爭(zhēng)論不休時(shí),要知道,大型語(yǔ)言模型的用途可不僅于此。

去年11月,谷歌最先宣布了新項(xiàng)目「開(kāi)發(fā)一種支持全球1000種最常用語(yǔ)言的人工智能語(yǔ)言模型」。

同年,Meta也發(fā)布了一個(gè)名為「No Language Left Behind」模型,并稱可以翻譯200多種語(yǔ)言,旨在打造「通用翻譯器」。

而最新模型的發(fā)布,谷歌將其描述為通向目標(biāo)的「關(guān)鍵一步」。

在打造語(yǔ)言模型上,可謂群雄逐鹿。

據(jù)傳言,谷歌計(jì)劃在今年的年度 I/O 大會(huì)上展示20多款由人工智能驅(qū)動(dòng)的產(chǎn)品。

當(dāng)前,自動(dòng)語(yǔ)音識(shí)別面臨許多挑戰(zhàn):

- 傳統(tǒng)的監(jiān)督學(xué)習(xí)方法缺乏可擴(kuò)展性

在傳統(tǒng)的方法中,音頻數(shù)據(jù)需要費(fèi)時(shí)又費(fèi)錢的手動(dòng)標(biāo)記,或者從有預(yù)先存在的轉(zhuǎn)錄的來(lái)源中收集,而對(duì)于缺乏廣泛代表性的語(yǔ)言來(lái)說(shuō),這很難找到。

- 擴(kuò)大語(yǔ)言覆蓋面和質(zhì)量的同時(shí),模型必須以高效的計(jì)算方式進(jìn)行改進(jìn)?

這就要求算法能夠使用來(lái)自不同來(lái)源的大量數(shù)據(jù),在不需要完全重新訓(xùn)練的情況下實(shí)現(xiàn)模型的更新,并且能夠推廣到新的語(yǔ)言和使用案例。

微調(diào)自監(jiān)督學(xué)習(xí)

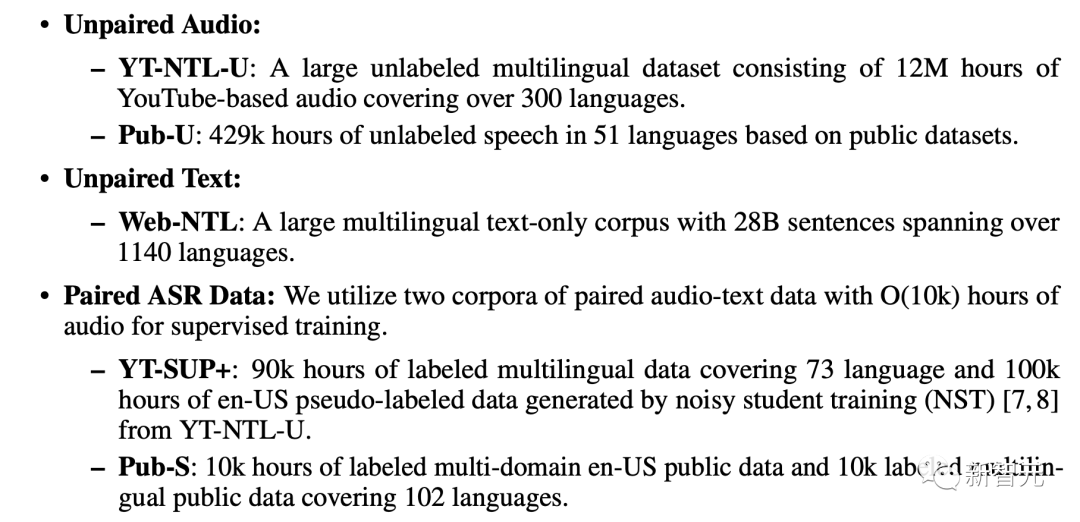

據(jù)論文介紹,USM的訓(xùn)練采用了三種數(shù)據(jù)庫(kù):未配對(duì)的音頻數(shù)據(jù)集、未配對(duì)的文本數(shù)據(jù)集、配對(duì)的ASR語(yǔ)料庫(kù)。

- 未配對(duì)的音頻數(shù)據(jù)集?

包括YT-NTL-U(超1200萬(wàn)小時(shí)YouTube無(wú)標(biāo)簽音頻數(shù)據(jù))和Pub-U(超429,000小時(shí)的51種語(yǔ)言的演講內(nèi)容)

- 未配對(duì)的文本數(shù)據(jù)集?

Web-NTL(超1140種不同語(yǔ)言的280億個(gè)句子)

- 配對(duì)的ASR語(yǔ)料庫(kù)?

YT-SUP +和 Pub-S語(yǔ)料庫(kù)(超10,000小時(shí)的音頻內(nèi)容和匹配文本)

USM使用標(biāo)準(zhǔn)的編碼器-解碼器結(jié)構(gòu),其中解碼器可以是CTC、RNN-T或LAS。

對(duì)于編碼器,USM使用了Conformor,或卷積增強(qiáng)Transformer。

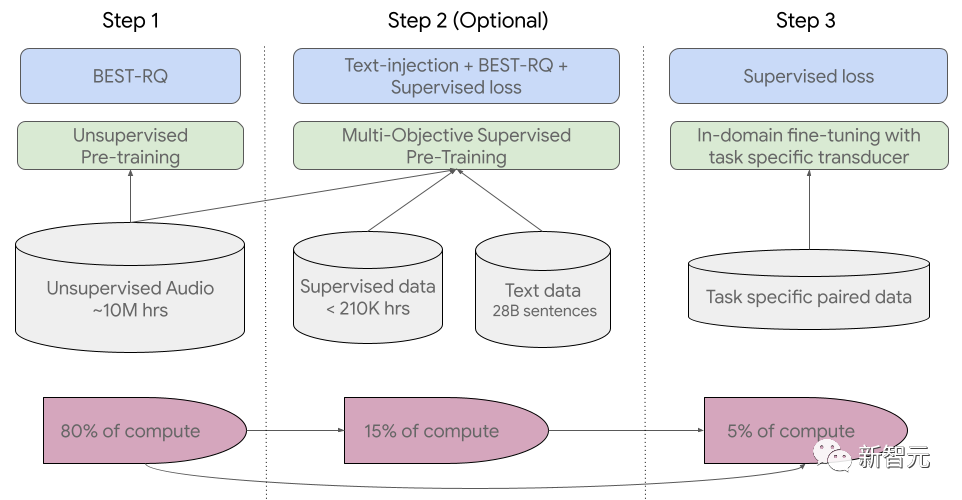

訓(xùn)練過(guò)程共分為三個(gè)階段。

在初始階段,使用BEST-RQ(基于BERT的隨機(jī)投影量化器的語(yǔ)音預(yù)訓(xùn)練)進(jìn)行無(wú)監(jiān)督的預(yù)訓(xùn)練。目標(biāo)是為了優(yōu)化RQ。

在下一階段,進(jìn)一步訓(xùn)練語(yǔ)音表征學(xué)習(xí)模型。

使用MOST(多目標(biāo)監(jiān)督預(yù)訓(xùn)練)來(lái)整合來(lái)自其他文本數(shù)據(jù)的信息。

該模型引入了一個(gè)額外的編碼器模塊,以文本作為輸入,并引入了額外的層來(lái)組合語(yǔ)音編碼器和文本編碼器的輸出,并在未標(biāo)記的語(yǔ)音、標(biāo)記的語(yǔ)音和文本數(shù)據(jù)上聯(lián)合訓(xùn)練模型。

最后一步便是,對(duì)ASR(自動(dòng)語(yǔ)音識(shí)別)和AST(自動(dòng)語(yǔ)音翻譯)任務(wù)進(jìn)行微調(diào),經(jīng)過(guò)預(yù)訓(xùn)練的USM模型只需少量監(jiān)督數(shù)據(jù)就可以取得很好的性能。

USM整體訓(xùn)練流程

USM的性能如何,谷歌對(duì)其在YouTube字幕、下游ASR任務(wù)的推廣、以及自動(dòng)語(yǔ)音翻譯上進(jìn)行了測(cè)試。

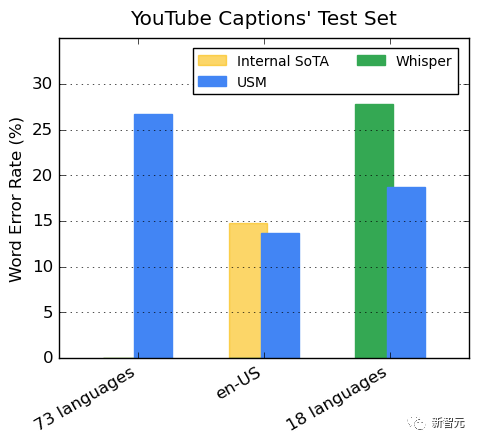

YouTube多語(yǔ)言字幕上的表現(xiàn)

受監(jiān)督的YouTube數(shù)據(jù)包括73種語(yǔ)言,每種語(yǔ)言的數(shù)據(jù)時(shí)長(zhǎng)平均不到3000個(gè)小時(shí)。盡管監(jiān)督數(shù)據(jù)有限,但模型在73種語(yǔ)言中實(shí)現(xiàn)了平均不到30%的單詞錯(cuò)誤率(WER),這比美國(guó)內(nèi)部最先進(jìn)的模型相比還要低。

此外,谷歌與超40萬(wàn)小時(shí)標(biāo)注數(shù)據(jù)訓(xùn)練出的Whisper模型 (big-v2) 進(jìn)行了比較。

在Whisper能解碼的18種語(yǔ)言中,其解碼錯(cuò)誤率低于40%,而USM平均錯(cuò)誤率僅為32.7%。

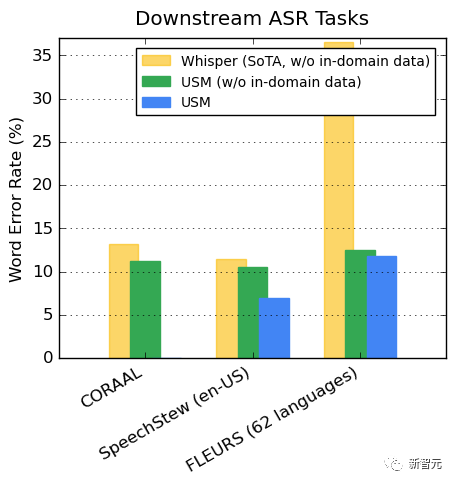

對(duì)下游ASR任務(wù)的推廣

在公開(kāi)的數(shù)據(jù)集上,與Whisper相比,USM在CORAAL(非裔美國(guó)人的方言英語(yǔ))、SpeechStew(英文-美國(guó))和FLEURS(102種語(yǔ)言)上顯示出更低的WER,不論是否有域內(nèi)訓(xùn)練數(shù)據(jù)。

兩種模型在FLEURS上的差異尤為明顯。

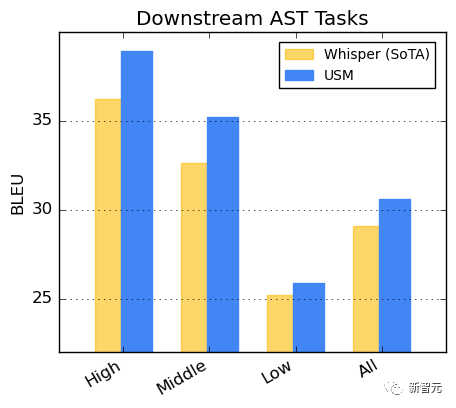

在AST任務(wù)上的表現(xiàn)

在CoVoST數(shù)據(jù)集上對(duì)USM進(jìn)行微調(diào)。

將數(shù)據(jù)集中的語(yǔ)言按資源可用性分為高、中、低三類,在每一類上計(jì)算BLEU分?jǐn)?shù)(越高越好),USM在每一類中的表現(xiàn)的優(yōu)于Whisper。

研究發(fā)現(xiàn),BEST-RQ預(yù)訓(xùn)練是將語(yǔ)音表征學(xué)習(xí)擴(kuò)展到大數(shù)據(jù)集的一種有效方法。

當(dāng)與MOST中的文本注入相結(jié)合時(shí),它提高了下游語(yǔ)音任務(wù)的質(zhì)量,在FLEURS和CoVoST 2基準(zhǔn)上實(shí)現(xiàn)了最好的性能。

通過(guò)訓(xùn)練輕量級(jí)剩余適配器模塊,MOST表示能夠快速適應(yīng)新的域。而這些剩余適配器模塊只增加2%的參數(shù)。

谷歌稱,目前,USM支持100多種語(yǔ)言,到未來(lái)將擴(kuò)展到1000多種語(yǔ)言。有了這項(xiàng)技術(shù),或許對(duì)于每個(gè)人來(lái)講走到世界各地穩(wěn)妥了。

甚至,未來(lái)實(shí)時(shí)翻譯谷歌AR眼鏡產(chǎn)品將會(huì)吸引眾多粉絲。

不過(guò),現(xiàn)在這項(xiàng)技術(shù)的應(yīng)用還是有很長(zhǎng)的一段路要走。

畢竟在面向世界的IO大會(huì)演講中,谷歌還把阿拉伯文寫反了,引來(lái)眾多網(wǎng)友圍觀。