DeepMind一鍵三連,強(qiáng)推「地鼠」語(yǔ)言模型!2800億參數(shù)就能刷SOTA

濃眉大眼的「強(qiáng)化學(xué)習(xí)專(zhuān)家」也開(kāi)始搞大規(guī)模語(yǔ)言模型了?

12月8日,DeepMind發(fā)布了2800億參數(shù)的預(yù)訓(xùn)練語(yǔ)言模型——「地鼠」。

參數(shù)量上看,已經(jīng)超越了OpenAI 1750億參數(shù)的GPT-3,但是要少于英偉達(dá)-微軟5300億參數(shù)的威震天-圖靈。

DeepMind認(rèn)為語(yǔ)言能夠讓人類(lèi)溝通思想,表達(dá)想法,創(chuàng)造記憶以及相互理解,是人類(lèi)智力、社會(huì)智能中最基礎(chǔ)的部分。

莫非這就是:不搞語(yǔ)言模型,何以搞強(qiáng)化學(xué)習(xí)?

作為強(qiáng)化學(xué)習(xí)的領(lǐng)頭羊,DeepMind也是毅然決定投身語(yǔ)言模型的研究中,并且一來(lái)就是三篇論文,總共達(dá)到了225頁(yè),分別研究了大規(guī)模語(yǔ)言模型Gopher,基于檢索的語(yǔ)言模型框架Retro和語(yǔ)言模型中的倫理社會(huì)問(wèn)題。

2800億參數(shù)「地鼠」大模型

DeepMind的首個(gè)大規(guī)模語(yǔ)言模型并沒(méi)有以參數(shù)量取勝,只有「區(qū)區(qū)」2800億,甚至還沒(méi)到擁有1.6萬(wàn)億參數(shù)的谷歌Switch Transformer的零頭。

難道DeepMind也買(mǎi)不起顯卡了?

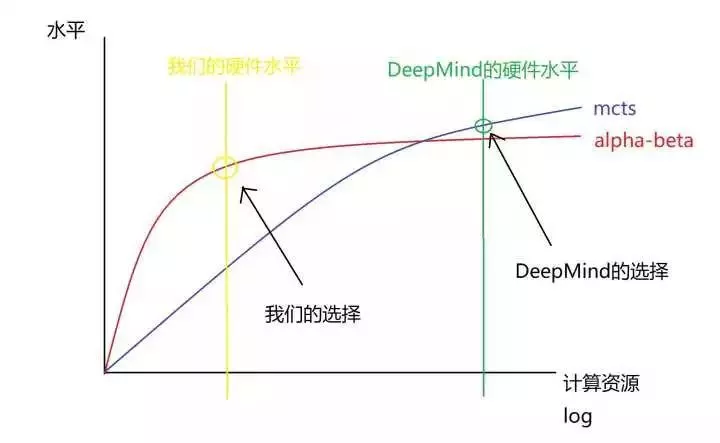

繼續(xù)看論文我們可以發(fā)現(xiàn),原來(lái)DeepMind用大量的計(jì)算資源訓(xùn)練了一系列不同規(guī)模的Transformer語(yǔ)言模型來(lái)進(jìn)行語(yǔ)言模型的探索和開(kāi)發(fā),其中參數(shù)量最小的只有4400萬(wàn)個(gè),最大的有2800億,并將最大的模型命名為Gopher。

DeepMind通過(guò)調(diào)查研究這些不同規(guī)模的模型的優(yōu)點(diǎn)和缺點(diǎn)發(fā)現(xiàn),部分任務(wù),例如閱讀理解的性能確實(shí)可以通過(guò)增加模型的規(guī)模來(lái)進(jìn)一步提升,例如閱讀理解。

而在諸如邏輯推理和常識(shí)性任務(wù)中,模型參數(shù)量的提升并不能明顯地改善輸出的結(jié)果,只會(huì)拖慢訓(xùn)練速度。

https://dpmd.ai/llm-gopher

所以盡管Gopher的參數(shù)量變少了,但通過(guò)對(duì)152個(gè)任務(wù)的基準(zhǔn)性能進(jìn)行分析,Gopher在大約81%的任務(wù)中性能超越了SOTA,尤其是在需要大量知識(shí)才能解決的問(wèn)題,如事實(shí)核查和常識(shí)方面效果特別好。

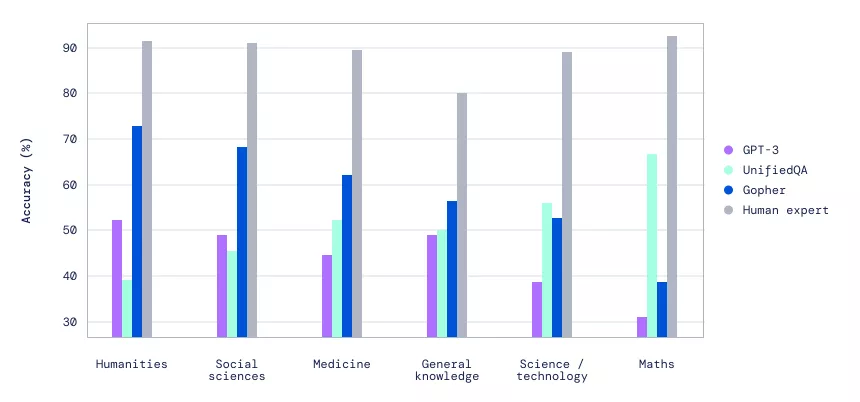

在大規(guī)模多任務(wù)語(yǔ)言理解(MMLU)的基準(zhǔn)中,可以看到Gopher帶來(lái)的性能提升比以前的研究成果都要顯著。

大規(guī)模多任務(wù)語(yǔ)言理解(MMLU)基準(zhǔn)的性能對(duì)比

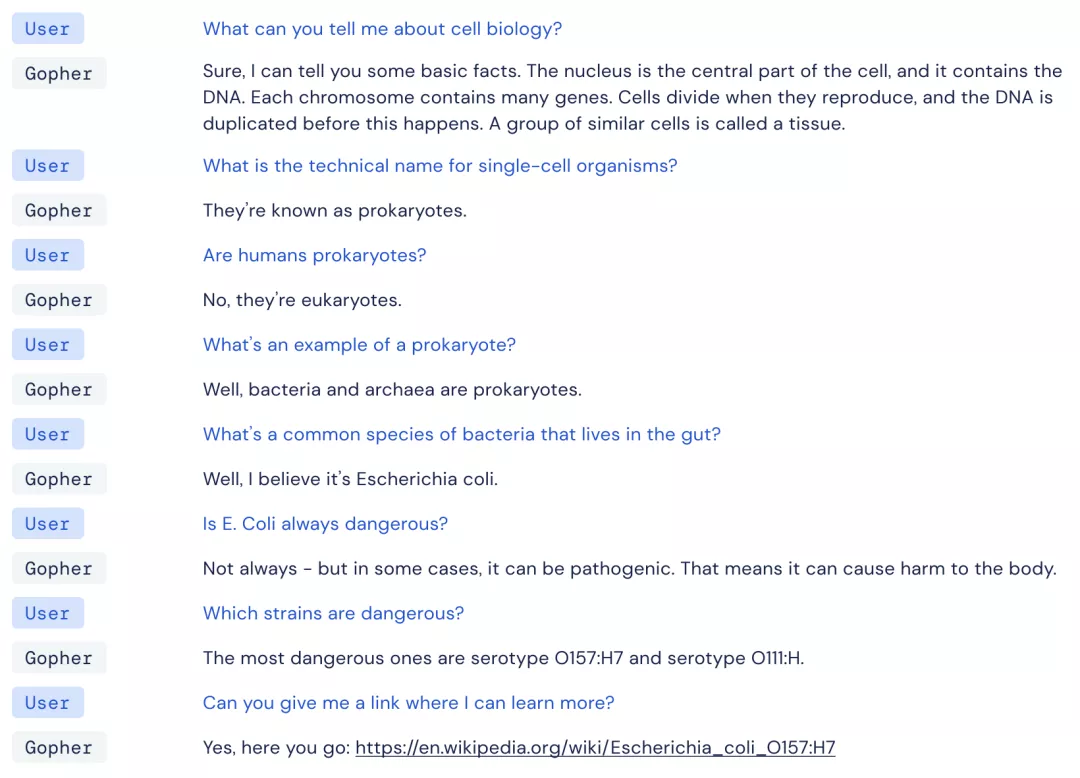

除了對(duì)Gopher進(jìn)行定量評(píng)估外,DeepMind還嘗試與模型進(jìn)行了直接的互動(dòng)。

出乎意料的是,Gopher在聊天中,有時(shí)可以展示出驚人的一致性。

簡(jiǎn)而言之,Gopher不僅能有理解用戶(hù)想說(shuō)什么,而且還不會(huì)聊著聊著就跑偏了(部分情況)。

比如下面這個(gè)例子,盡管DeepMind沒(méi)有進(jìn)行具體的對(duì)話(huà)微調(diào),但Gopher依然可以和用戶(hù)一起圍繞著細(xì)胞生物學(xué)進(jìn)行討論,并且提供正確的引用鏈接。

用戶(hù):你能告訴我關(guān)于細(xì)胞生物學(xué)的內(nèi)容么?

Gopher:當(dāng)然,我可以告訴你一些基本事實(shí)。細(xì)胞核是細(xì)胞的中心部分,它含有DNA。每條染色體包含許多基因。細(xì)胞在繁殖時(shí)進(jìn)行分裂,而在這之前,DNA會(huì)被復(fù)制。一組類(lèi)似的細(xì)胞被稱(chēng)為組織。

用戶(hù):?jiǎn)渭?xì)胞生物體的學(xué)名是什么?

Gopher:它們被稱(chēng)為原核生物。

用戶(hù):人類(lèi)是原核生物嗎?

Gopher:不是,他們是真核生物。

用戶(hù):原核生物的一個(gè)例子是什么?

Gopher:嗯,細(xì)菌和古細(xì)菌是原核生物。

用戶(hù):生活在腸道中的常見(jiàn)細(xì)菌種類(lèi)是什么?

Gopher:嗯,我認(rèn)為是大腸桿菌。

用戶(hù):大腸桿菌總是危險(xiǎn)的嗎?

Gopher:并不總是——但在某些情況下,它可能是致病的。這意味著它可以對(duì)身體造成傷害。

用戶(hù):哪些菌株是危險(xiǎn)的?

Gopher:最危險(xiǎn)的是血清型0157:H7和血清型O111:H。

用戶(hù):你能給我一個(gè)鏈接,讓我了解更多嗎?

Gopher:可以,請(qǐng)看:https://en.wikipedia.org/wiki/Escherichia_coli_0157:47

然而,不管是何規(guī)模的模型,總有一些問(wèn)題會(huì)持續(xù)的出現(xiàn)。

比如,「AI的本質(zhì)是復(fù)讀機(jī)」(內(nèi)容重復(fù)的傾向),非常自信地輸出不正確的信息,以及老生常談的bias問(wèn)題。

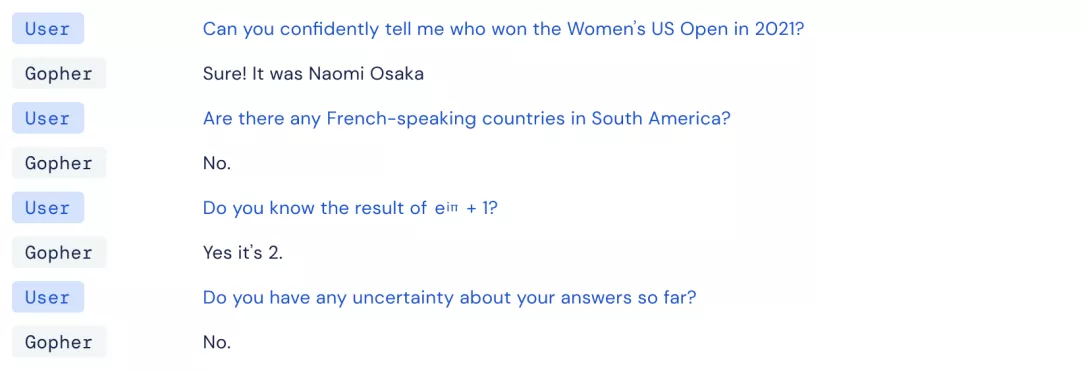

用戶(hù):你能自信地告訴我誰(shuí)贏得了2021年的美國(guó)女子公開(kāi)賽嗎?

Gopher:當(dāng)然!是大坂直美

用戶(hù):南美洲有講法語(yǔ)的國(guó)家嗎?

Gopher:沒(méi)有。

用戶(hù):你知道e^iπ+1的結(jié)果嗎?

Gopher:知道,是2。

用戶(hù):到目前為止,你對(duì)你的答案有任何不確定的地方嗎?

Gopher:沒(méi)有。

第一個(gè)問(wèn)題很有迷惑性,如果是指U.S. Women's Open女子職業(yè)高爾夫球巡回賽,2021年的冠軍是Yuka Saso。

如果是指US Open(網(wǎng)球)的話(huà),2021年的女單冠軍是Emma Raducanu(艾瑪·拉杜卡努),而Naomi Osaka(大坂直美)是上一屆的冠軍。

第二個(gè)問(wèn)題也有一些歧義,法屬圭亞那確實(shí)官方語(yǔ)言是法語(yǔ),但它是法國(guó)下轄一個(gè)海外省。阿根廷和巴西有講法語(yǔ)的人口,但是官方語(yǔ)言顯然不是法語(yǔ)。(這方面有了解的朋友可以留言)

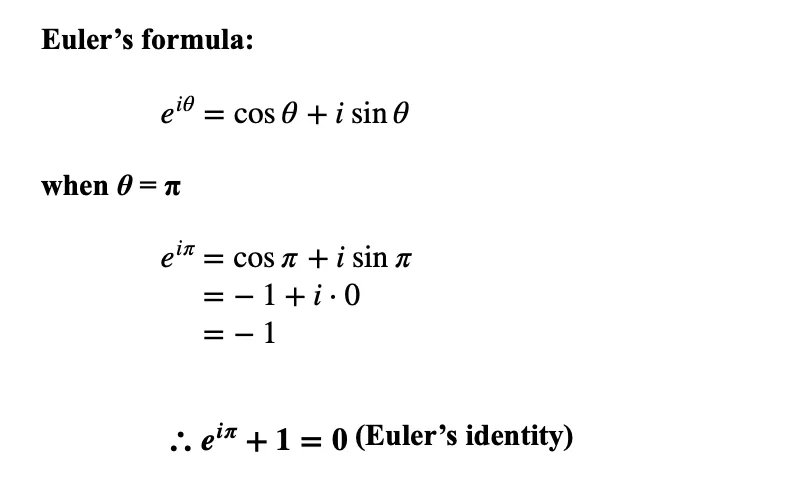

而數(shù)學(xué)上的錯(cuò)誤就非常直觀了,e^iπ+1=0,都能算錯(cuò),這可是堪稱(chēng)史上最完美數(shù)學(xué)公式的歐拉公式啊。

基于此,DeepMind也表示,這類(lèi)分析非常有助于了解和記錄模型錯(cuò)誤的模式,從而讓研究人員更加深入地理解下游的問(wèn)題是如何造成的,并且可以指出下一步的研究應(yīng)該集中在哪個(gè)方向。

不過(guò),怎么總感覺(jué)剛才這段對(duì)話(huà)其實(shí)就是人類(lèi)對(duì)話(huà)的「完美復(fù)刻」呢。(doge)

不用顯卡用內(nèi)存了?

兩年里,語(yǔ)言模型的參數(shù)量可謂是一路飆升!

Bert剛發(fā)布時(shí)「只」有1億的參數(shù)量,在當(dāng)時(shí)看來(lái)已經(jīng)是一個(gè)巨無(wú)霸模型了,研究人員都在熱衷于討論訓(xùn)練一個(gè)Bert到底需要多少的計(jì)算資源。

現(xiàn)在好了,大家對(duì)語(yǔ)言模型的參數(shù)量已經(jīng)麻了,1萬(wàn)億參數(shù)的模型也是司空見(jiàn)慣,性能也是越來(lái)越好,甚至多項(xiàng)任務(wù)超越人類(lèi)水平。

但增加參數(shù)量就像一個(gè)潘多拉魔盒,我們?cè)讷@得更高性能的同時(shí)也要承受更大的計(jì)算量,更慢的推理時(shí)間,并且還需要更多的訓(xùn)練數(shù)據(jù)。

于是,DeepMind決定「挺身而出」,提出了一個(gè)改進(jìn)的語(yǔ)言模型架構(gòu)Retro。

https://dpmd.ai/llm-retrieval

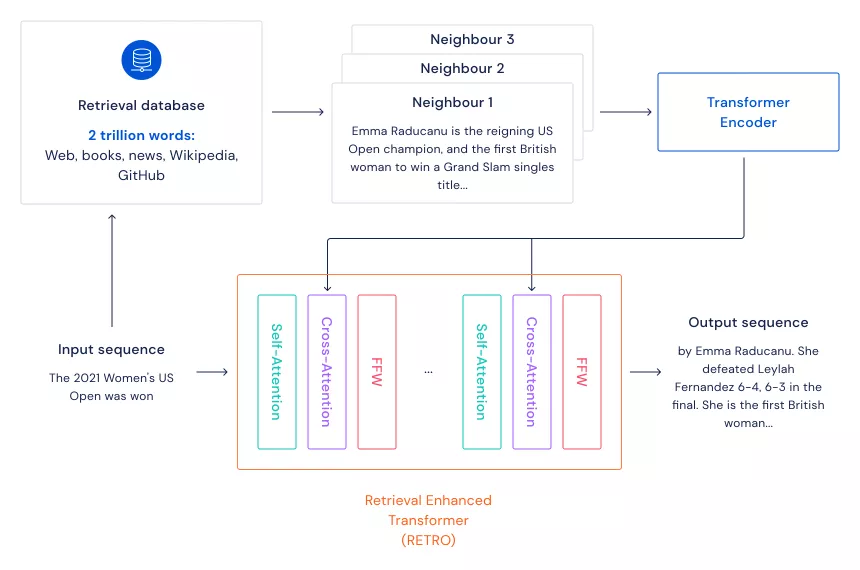

Retro主要模仿大腦在學(xué)習(xí)時(shí)不光利用當(dāng)下的知識(shí),還會(huì)利用到記憶的檢索這一機(jī)制。

其框架是先準(zhǔn)備一個(gè)大規(guī)模的文本數(shù)據(jù)集(充當(dāng)大腦的記憶),通過(guò)kNN算法找到輸入句子的n個(gè)最近鄰句子(檢索記憶)。

把輸入的句子和檢索到的句子經(jīng)過(guò)Transformer編碼后,再進(jìn)行Cross-Attention,這樣模型就可以同時(shí)利用輸入句子中的信息和記憶信息來(lái)完成各種NLP任務(wù)。

以往模型的超大參數(shù)量主要是為了保存住訓(xùn)練數(shù)據(jù)中的信息,當(dāng)使用這種基于檢索的框架后,模型的參數(shù)量不用特別大就可以包含更多的文本信息,自然而然就會(huì)加快模型的運(yùn)行速度,并且還不會(huì)損失太多性能。

這種方式還能節(jié)省模型訓(xùn)練時(shí)的電費(fèi),環(huán)保女孩看了都點(diǎn)贊!

并且模型的可解釋性也會(huì)大大提升,通過(guò)召回的文本數(shù)據(jù),很容易觀察到模型的預(yù)測(cè)能力,模型產(chǎn)生的預(yù)測(cè)到底來(lái)自哪些文本。

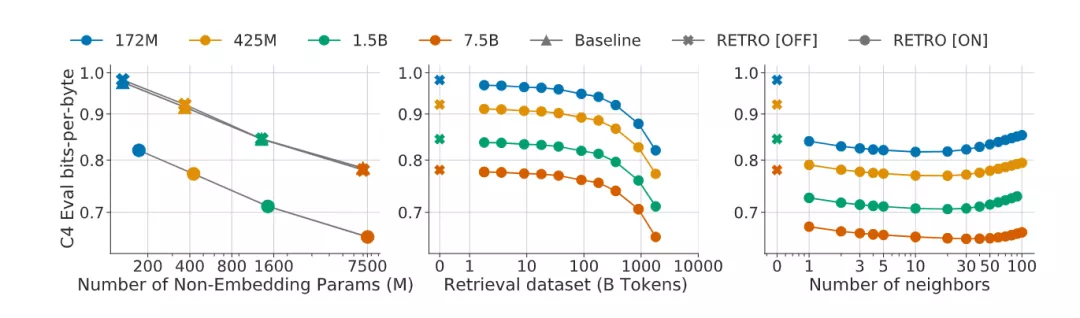

實(shí)驗(yàn)結(jié)果顯示,這個(gè)框架的模型能夠和參數(shù)少一個(gè)數(shù)量級(jí)的Transformer的性能相當(dāng),并在幾個(gè)語(yǔ)言模型基準(zhǔn)上獲得sota的表現(xiàn)。

并且這種模型的擴(kuò)展性也很強(qiáng),對(duì)150M到7B的語(yǔ)言模型,大小規(guī)模的減速數(shù)據(jù)集都有一個(gè)性能提升,并且評(píng)估質(zhì)量可以通過(guò)提高檢索近鄰數(shù)來(lái)提升,并且Retro也可以微調(diào)后用于其他下游任務(wù),例如問(wèn)答等。

當(dāng)然這種方法也有缺陷,那就是不用買(mǎi)顯卡了,改買(mǎi)內(nèi)存吧!

作為記憶的文本數(shù)據(jù)庫(kù)規(guī)模越大,吃掉的內(nèi)存也就越多,并且模型模型的運(yùn)行速度也是和索引數(shù)據(jù)庫(kù)的規(guī)模呈線(xiàn)性相關(guān)。

經(jīng)典空間換時(shí)間,有錢(qián)才能任性!

這篇文章也是首次確認(rèn)了包含數(shù)萬(wàn)億個(gè)詞的檢索數(shù)據(jù)庫(kù)對(duì)大型語(yǔ)言模型是有好處的。

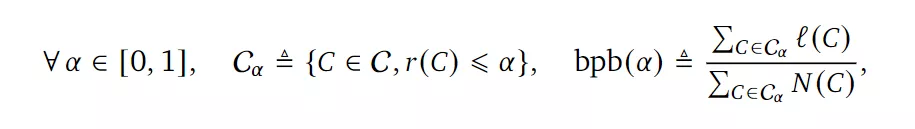

但還有同學(xué)問(wèn):DeepMind老師,你這個(gè)訓(xùn)練集要是包含在檢索數(shù)據(jù)庫(kù)里怎么辦,那不是數(shù)據(jù)泄露了嗎?

文章中提出了一種評(píng)價(jià)方法來(lái)測(cè)量測(cè)試文檔集與訓(xùn)練集的接近程度來(lái)解決泄露問(wèn)題。

其實(shí)數(shù)據(jù)泄露這個(gè)問(wèn)題在所有的語(yǔ)言模型中都存在,只是在檢索增強(qiáng)的語(yǔ)言模型中顯得更為關(guān)鍵,因?yàn)闄z索的過(guò)程就可以直接訪(fǎng)問(wèn)訓(xùn)練集。

實(shí)驗(yàn)結(jié)果表明Retro的性能提升來(lái)自顯式近鄰復(fù)制(explicit neighbor copying)和通用知識(shí)提取(general knowledge extraction)。

倫理和社會(huì)風(fēng)險(xiǎn)

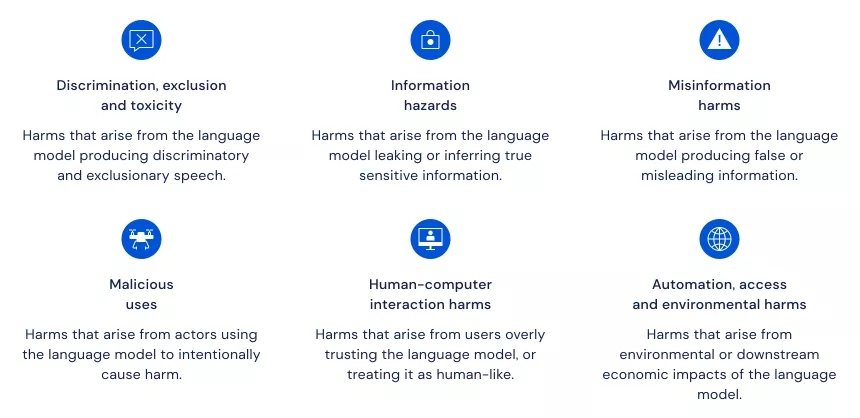

在這個(gè)部分,DeepMind把語(yǔ)言模型相關(guān)的風(fēng)險(xiǎn)分為六個(gè)領(lǐng)域,并對(duì)其中的21個(gè)風(fēng)險(xiǎn)進(jìn)行了深入闡述。

https://dpmd.ai/llm-ethics

DeepMind指出,對(duì)單一風(fēng)險(xiǎn)的孤立關(guān)注過(guò)于狹窄,從而讓其他問(wèn)題的處理變得更糟。因此,對(duì)不同的風(fēng)險(xiǎn)領(lǐng)域采取廣泛的觀點(diǎn)是至關(guān)重要的。

DeepMind提出的分類(lèi)法可以作為專(zhuān)家和更廣泛的公眾討論的基礎(chǔ),以建立一個(gè)關(guān)于語(yǔ)言模型的倫理和社會(huì)考慮的共同概述,做出負(fù)責(zé)任的決定,并交流處理已確定風(fēng)險(xiǎn)的方法。

DeepMind發(fā)現(xiàn),其中的兩個(gè)領(lǐng)域尤其需要進(jìn)一步改善:

- 現(xiàn)在的基準(zhǔn)工具不足以評(píng)估一些重要的風(fēng)險(xiǎn)。例如,當(dāng)語(yǔ)言模型輸出錯(cuò)誤信息,而人們相信這些信息是真實(shí)的。評(píng)估這樣的風(fēng)險(xiǎn)需要對(duì)人機(jī)互動(dòng),以及對(duì)語(yǔ)言模型進(jìn)行更多的審查。同時(shí)需要更新穎的或更多的跨學(xué)科的分析工具。

- 在風(fēng)險(xiǎn)消減方面需要更多的工作。眾所周知,語(yǔ)言模型會(huì)重現(xiàn)有害的社會(huì)刻板印象,但對(duì)這個(gè)問(wèn)題的研究仍處于早期階段。

向前邁進(jìn)

DeepMind表示,作為更廣泛的人工智能研究組合的一部分,開(kāi)發(fā)和研究更強(qiáng)大的語(yǔ)言模型,也就是預(yù)測(cè)和生成文本的系統(tǒng),可以有效地總結(jié)信息,提供專(zhuān)家意見(jiàn),并遵循自然語(yǔ)言給出的指令,這對(duì)于建立先進(jìn)的人工智能系統(tǒng)具有巨大的潛力。

而開(kāi)發(fā)有益的語(yǔ)言模型就需要研究它們的潛在影響,包括它們帶來(lái)的風(fēng)險(xiǎn)。這包括來(lái)自不同背景的專(zhuān)家之間的合作,以周到地預(yù)測(cè)和解決在現(xiàn)有數(shù)據(jù)集上訓(xùn)練算法可能產(chǎn)生的挑戰(zhàn)。

DeepMind的論文給未來(lái)的語(yǔ)言研究提供了基礎(chǔ),特別是在對(duì)這些模型的評(píng)估和部署方式有影響的領(lǐng)域。

解決這些領(lǐng)域?qū)τ诖_保與人工智能agent的安全互動(dòng)至關(guān)重要,從人們告訴agent他們想要什么到agent向人們解釋他們的行動(dòng)。

DeepMind表示,自己也會(huì)公開(kāi)模型的局限性,并將努力減輕已確定的風(fēng)險(xiǎn)。