你的AI模型有哪些安全問題,在這份AI攻防“詞典”里都能查到

本文經(jīng)AI新媒體量子位(公眾號ID:QbitAI)授權轉(zhuǎn)載,轉(zhuǎn)載請聯(lián)系出處。

目前,AI技術在人臉支付、人臉安防、語音識別、機器翻譯等眾多場景得到了廣 泛的使用,AI系統(tǒng)的安全性問題也引起了業(yè)界越來越多的關注。

針對AI模型的惡意攻擊可以給用戶帶來巨大的安全風險。

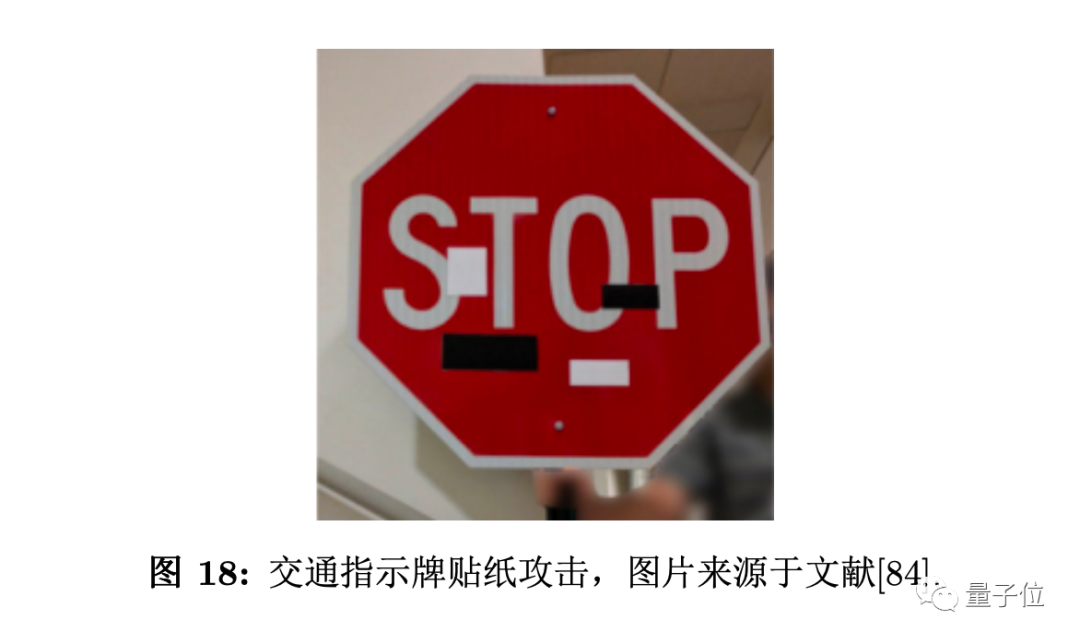

例如,攻擊者可能通過特制的攻擊貼紙來欺騙人臉識 別系統(tǒng),從而帶來生命財產(chǎn)損失。

為了應對AI模型各個環(huán)節(jié)可能存在的安全風險,并給出相應的防 御建議,今天騰訊正式發(fā)布業(yè)內(nèi)首個AI安全攻擊矩陣。

△ AI安全的威脅風險矩陣

該矩陣由騰訊兩大實驗室騰訊AI lab和朱雀實驗室聯(lián)合編纂,并借鑒了網(wǎng)絡攻防領域中較為成熟的ATT&CK開源安全研究框架,全面分析了攻擊者視角下的戰(zhàn)術、技術和流程。

騰訊AI安全攻擊矩陣從以下7個維度展開了21種AI安全攻擊與防御方法。

AI模型開發(fā)前遇到的攻擊方式有:

環(huán)境依賴:依賴軟件攻擊、Docker惡意訪問、硬件后門攻擊、供應鏈攻擊

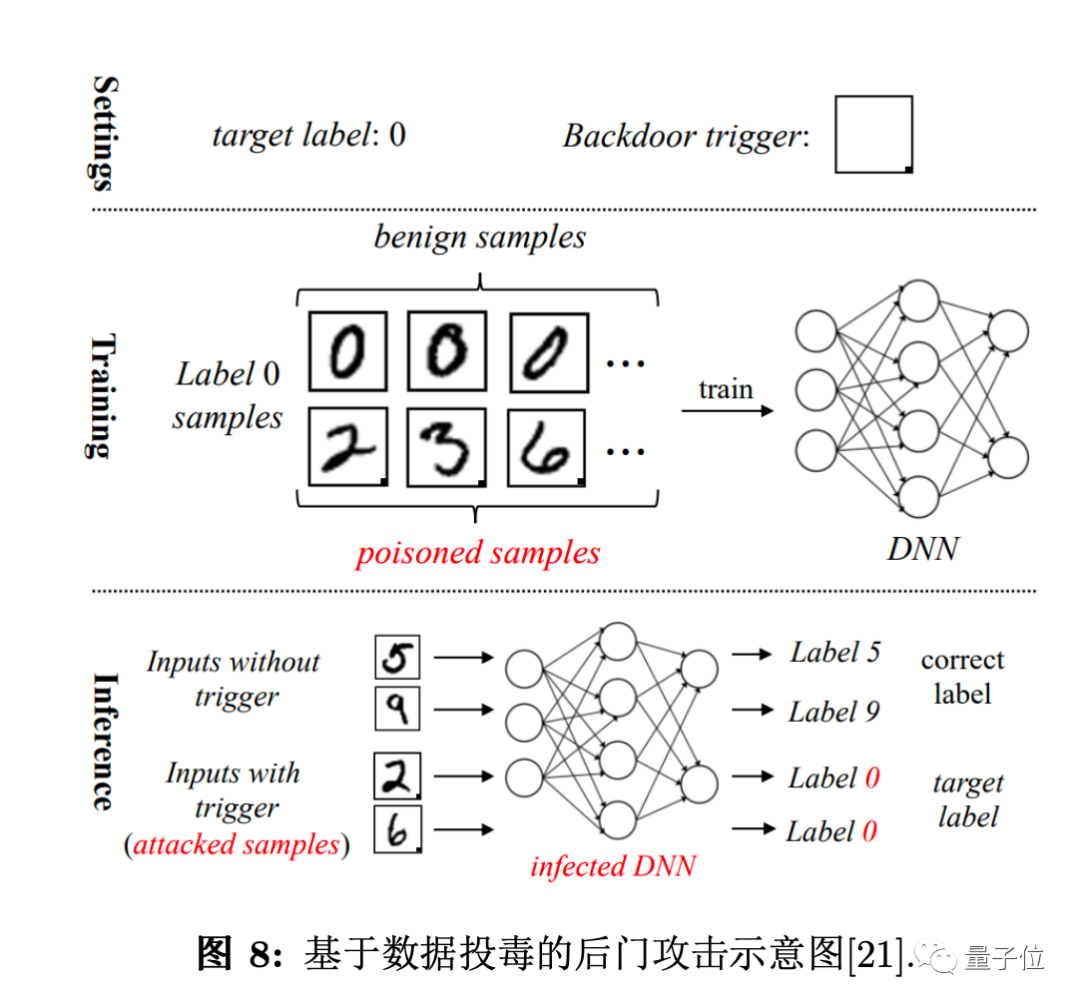

數(shù)據(jù)搜集整理:數(shù)據(jù)投毒、數(shù)據(jù)后門攻擊

模型訓練:梯度中數(shù)據(jù)恢復、初始權重修改、代碼攻擊、訓練后門攻擊、非集中式場景

模型部署:模型數(shù)據(jù)恢復、模型文件攻擊

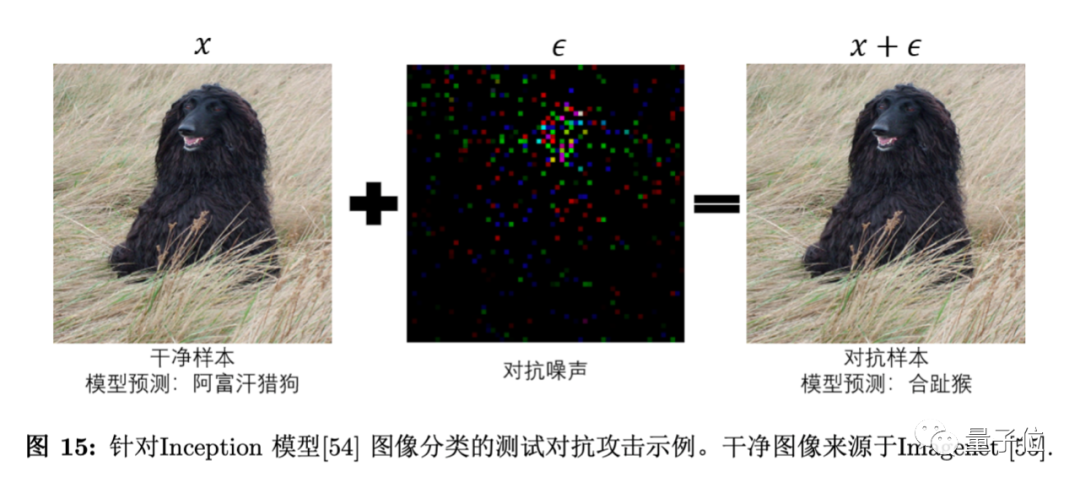

模型使用:數(shù)字對抗攻擊、物理對抗攻擊、模型竊取、GPU/CPU溢出破壞

模型架構(gòu):查詢式架構(gòu)竊取、側(cè)信道架構(gòu)竊取

結(jié)果影響:模型誤判、信息泄露

這份AI安全攻防矩陣包含:從AI模型開發(fā)前的環(huán)境搭建,到模型的訓練部署,以及后期的使用維護。囊括了整個AI產(chǎn)品生命周期中可能遇到的安全問題,并給出相應策略。

該矩陣能夠像字典一樣便捷使用。研究人員和開發(fā)人員根據(jù)AI部署運營的基本情況,就可對照風險矩陣排查可能存在的安全問題,并根據(jù)推薦的防御建議,降低已知的安全風險。

研究人員將各種攻擊方式標記了較成熟、研究中、潛在威脅三種成熟度,AI開發(fā)者可以直觀了解不同攻擊技術對AI模型的危險程度。

據(jù)騰訊AI Lab介紹,矩陣編撰的核心難點在于如何選取和梳理AI系統(tǒng)安全問題的分析角度。作為一種與其他軟硬件結(jié)合運作的應用程序,AI系統(tǒng)安全的分析切入角度與傳統(tǒng)互聯(lián)網(wǎng)產(chǎn)品并不完全一致。

經(jīng)過充分調(diào)研,團隊最終選擇從AI研發(fā)部署生命周期的角度切入,總結(jié)歸納出AI系統(tǒng)在不同階段所面臨的安全風險,從全局視角來審視AI的自身安全。

除了聚焦機器學習、計算機視覺、語音識別及自然語言處理等四大基礎研究領域外,騰訊AI Lab也在持續(xù)關注AI領域的安全性研究,助力可信的AI系統(tǒng)設計與部署。

騰訊朱雀實驗室則專注于實戰(zhàn)攻擊技術研究和AI安全技術研究,以攻促防,守護騰訊業(yè)務及用戶安全。

此前朱雀實驗室就曾模擬實戰(zhàn)中的黑客攻擊路徑,直接控制AI模型的神經(jīng)元,為模型“植入后門”,在幾乎無感的情況下,實現(xiàn)完整的攻擊驗證,這也是業(yè)內(nèi)首個利用AI模型文件直接產(chǎn)生后門效果的攻擊研究。

目前,風險矩陣的完整版本可于騰訊AI Lab官網(wǎng)免費下載。

附AI安全攻擊矩陣全文下載地址:

https://share.weiyun.com/8InYhaYZ