PyTorch版EfficientDet比官方TF實現快25倍?這個GitHub項目數天狂攬千星

EfficientDet 難復現,復現即趟坑。在此 Github 項目中,開發者 zylo117 開源了 PyTorch 版本的 EfficientDet,速度比原版高 20 余倍。如今,該項目已經登上 Github Trending 熱榜。

去年 11 月份,谷歌大腦提出兼顧準確率和模型效率的新型目標檢測器 EfficientDet,實現了新的 SOTA 結果。前不久,該團隊開源了 EfficientDet 的 TensorFlow 實現代碼。

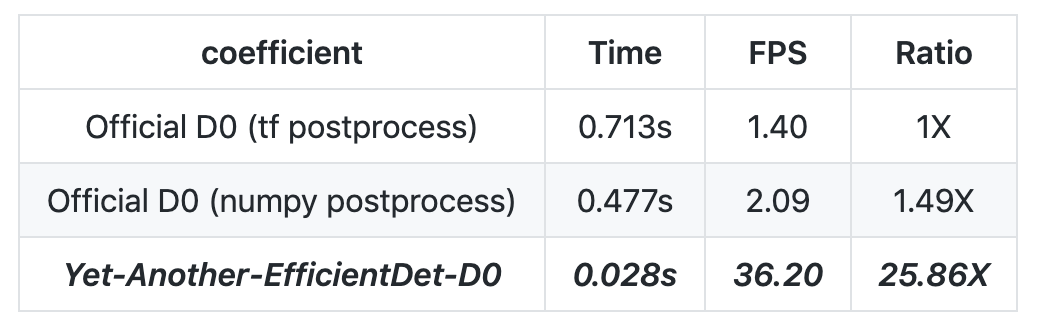

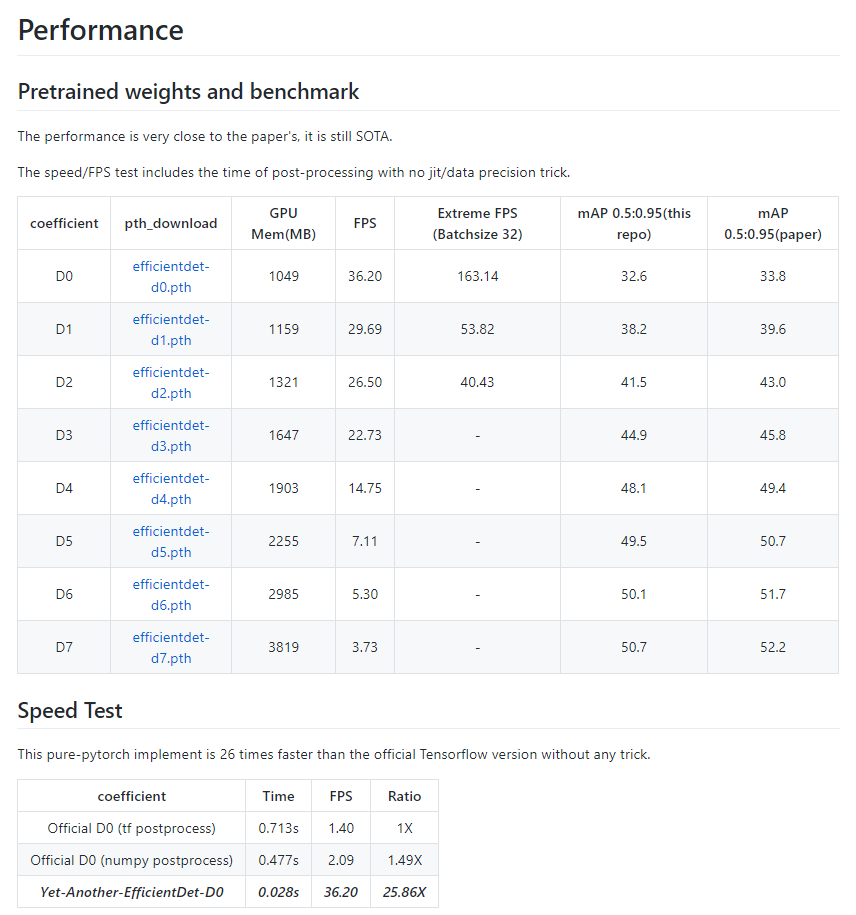

如此高效的 EfficientDet 還能更高效嗎?最近,有開發者在 GitHub 上開源了「PyTorch 版本的 EfficientDet」。該版本的性能接近原版,但速度是官方 TensorFlow 實現的近 26 倍!

目前,該項目在 GitHub 上獲得了 957 顆星,最近一天的收藏量接近 300。

GitHub 地址:https://github.com/zylo117

EfficientDet 簡介

近年來,在面對廣泛的資源約束時(如 3B 到 300B FLOPS),構建兼具準確率和效率的可擴展檢測架構成為優化目標檢測器的重要問題。基于單階段檢測器范式,谷歌大腦團隊的研究者查看了主干網絡、特征融合和邊界框/類別預測網絡的設計選擇,發現了兩大主要挑戰并提出了相應的解決方法:

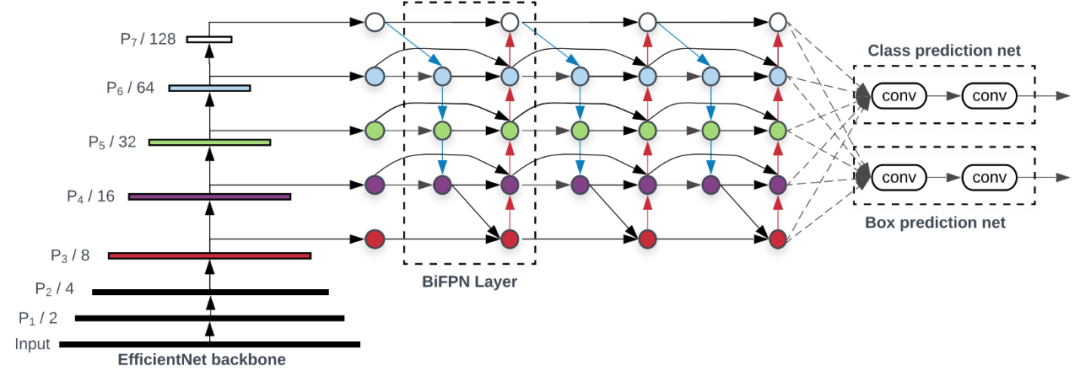

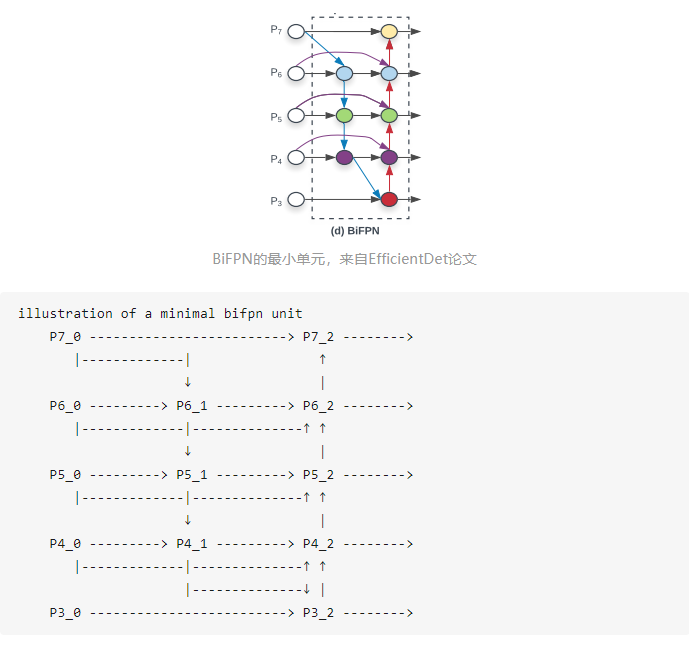

挑戰 1:高效的多尺度特征融合。研究者提出一種簡單高效的加權雙向特征金字塔網絡(BiFPN),該模型引入了可學習的權重來學習不同輸入特征的重要性,同時重復應用自上而下和自下而上的多尺度特征融合。

挑戰 2:模型縮放。受近期研究的啟發,研究者提出一種目標檢測器復合縮放方法,即統一擴大所有主干網絡、特征網絡、邊界框/類別預測網絡的分辨率/深度/寬度。

谷歌大腦團隊的研究者發現,EfficientNets 的效率超過之前常用的主干網絡。于是研究者將 EfficientNet 主干網絡和 BiFPN、復合縮放結合起來,開發出新型目標檢測器 EfficientDet,其準確率優于之前的目標檢測器,同時參數量和 FLOPS 比它們少了一個數量級。

下圖展示了 EfficientDet 的整體架構,大致遵循單階段檢測器范式。谷歌大腦團隊的研究者將在 ImageNet 數據集上預訓練的 EfficientNet 作為主干網絡,將 BiFPN 作為特征網絡,接受來自主干網絡的 level 3-7 特征 {P3, P4, P5, P6, P7},并重復應用自上而下和自下而上的雙向特征融合。然后將融合后的特征輸入邊界框/類別預測網絡,分別輸出目標類別和邊界框預測結果。

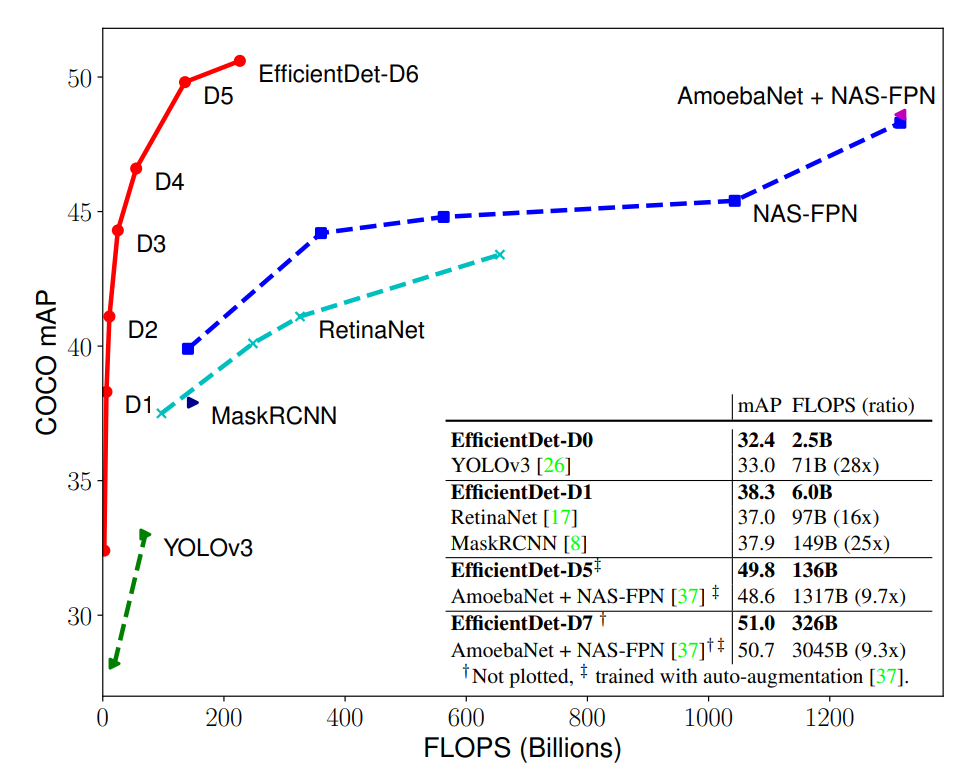

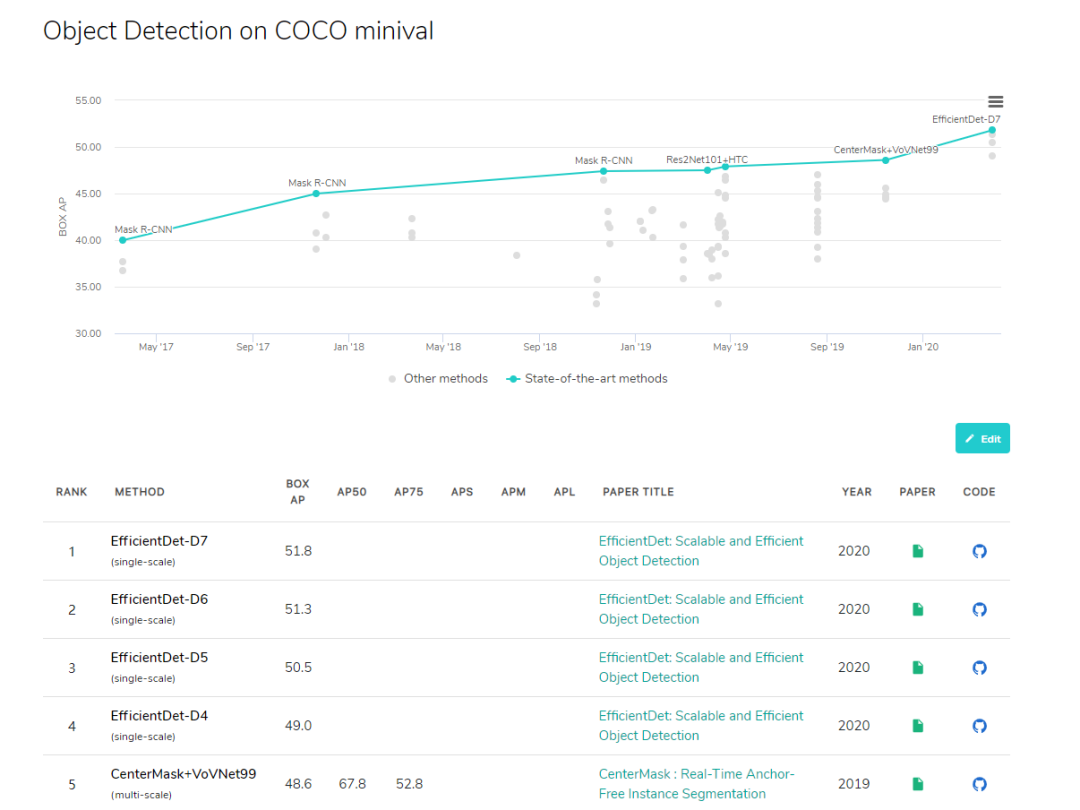

下圖展示了多個模型在 COCO 數據集上的性能對比情況。在類似的準確率限制下,EfficientDet 的 FLOPS 僅為 YOLOv3 的 1/28、RetinaNet 的 1/30、NASFPN 的 1/19,所有數字均為單個模型在單一尺度下所得。可以看到,EfficientDet 的計算量較其他檢測器少,但準確率優于后者,其中 EfficientDet-D7 獲得了當前最優性能。

更詳細的介紹,可參見機器之心文章:比當前 SOTA 小 4 倍、計算量少 9 倍,谷歌最新目標檢測器 EfficientDet

「宅」是第一生產力

項目作者今年 1 月宅家為國出力時,開始陸續嘗試各類 EfficientDet PyTorch 版實現,期間趟過了不少坑,也流過幾把辛酸淚。但最終得出了非常不錯的效果,也是全網第一個跑出接近論文成績的 PyTorch 版。

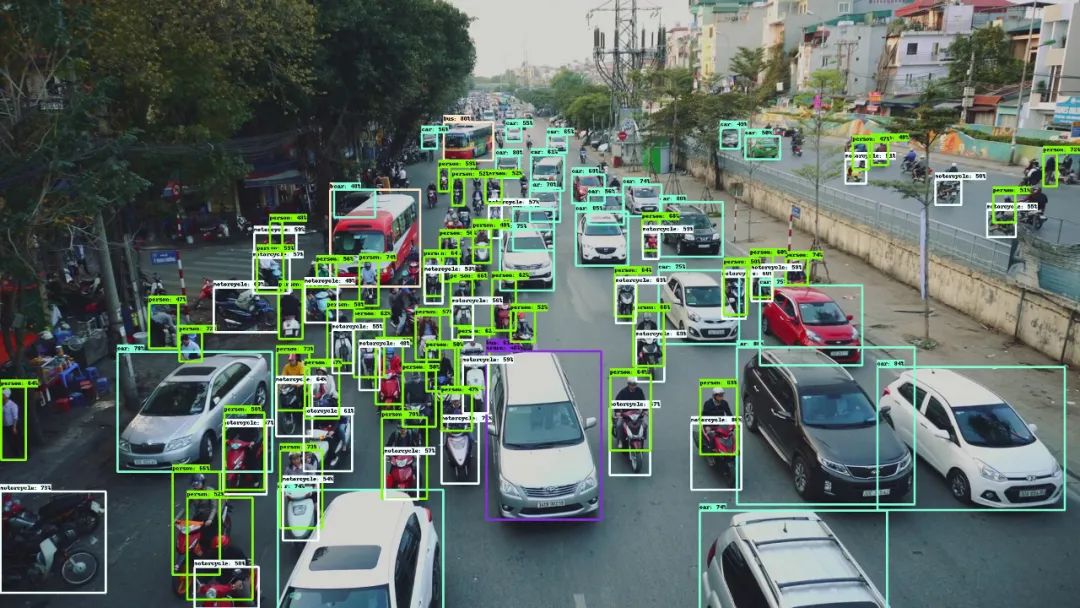

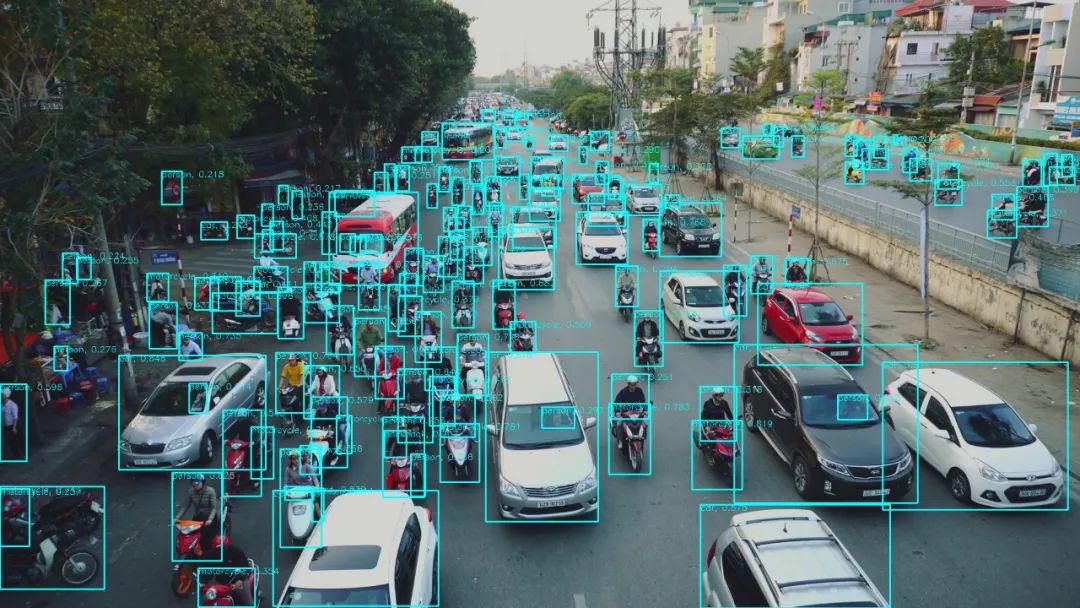

我們先來看一下項目作者與 EfficientDet 官方提供代碼的測試效果對比。第一張圖為官方代碼的檢測效果,第二張為項目作者的檢測效果。項目作者的實現竟然透過汽車的前擋風玻璃檢測出了車輛里面的人?!!這樣驚艷的檢測效果不愧是目前 EfficientDet 的霸榜存在。

接下來我們來看一下 coco 數據集上目標檢測算法的排名,多個屠榜的目標檢測網絡基于 EfficientDet 構建。一圖以言之:

來自 paperswithcode

前五里包攬前四,屠榜之勢不言而喻,也難怪各類煉金術士們躍躍欲試。但是,EfficientDet 的實現難度貌似與其知名度「成正比」,眾煉金師紛紛表示「難訓練」「至今未訓練好」「誰復現誰被坑」。項目作者也表示「由于谷歌一直不發官方 repository,所以只能民間發力,那些靠 paper 的內容實現出來的真的不容易」。

假期三天,拿下 PyTorch 版 EfficientDet D0 到 D7

項目作者復現結果與論文中并沒完全一致,但相較于其他同類復現項目來說,稱的上是非常接近了(詳細信息可參考項目鏈接)。

值得注意的是,此次項目處理速度比原版快了 20 余倍。

那么為什么之前都沒有人復現 EfficientDet 的成績?具體哪些細節需要注意?

「民間」EfficientDet 的取舍

作者前后試用了兩個 GitHub 項目進行實現,但效果并不理想。首先采用的 star 量最高的一個,同時可能也說明了一點,不是 star 越高就越適合。

針對第一個項目,作者表示:「因為 EfficientDet 的特性之一是 BiFPN,它會融合 backbone 輸出的任意相鄰兩層的 feature,但是由于有兩層尺寸的寬高是不同的,所以會進行 upsample 或者 pooling 來保證它們寬高一致。而這個作者沒有意識到,他不知道從 backbone 抽哪些 feature 出來,他覺得是 backbone 有問題,改了人家的 stride,隨便挑了幾層,去強迫 backbone 輸出他想要的尺寸」

「改了網絡結構,pretrained 權值基本就廢了,所以作者也發現了,發現訓練不下去了」。至此第一個項目畫上句號,同時作者提供了官方參數與試用項目作者改后的參數對比鏈接,有興趣的朋友可瀏覽參考鏈接。

而面向第二個項目,雖然 star 不及前者一半,但顯然可靠度更甚前者。作者表示,第二個項目起碼在 D0 上有論文成績的支撐,同時 repo 也提供了 coco 的 pretrained 權值 31.4mAP。然而實操后作者得到 24mAP,同時社區普遍也在 20-22 范圍中。

那么此次結果的原因是什么?作者經過反復的思考檢測,得到以下 7 點總結,并就此 7 點復盤進行適當得調整,得到了當前項目不錯的效果。

一波三折后的答案

針對第二個測試項目的復盤,作者表示一共有 7 個關鍵點需要額外注意:

- 第二個項目的 BN 實現有問題:BatchNorm 是有一個參數,叫做 momentum,用來調整新舊均值的比例,從而調整移動平均值的計算方式的。

- Depthwise-Separatable Conv2D 的錯誤實現。

- 誤解了 maxpool2d 的參數,kernel_size 和 stride。

- 減少通道的卷積后面,沒有進行 BN

- backbone feature 抽頭抽錯了

- Conv 和 pooling,沒有用到 same padding

- 沒有能正確的理解 BiFPN 的流程

來源于項目作者知乎賬號,詳情請見參考鏈接

作者還表示,其中有個非常關鍵點,「雞賊的官方并沒有表示這里是兩個獨立的 P4_0」。

簡而言之,這篇知乎博客非常詳細的介紹了各種復現注意事項,細節在此不再一一贅述。筆者認為對各煉金術師有一定參考價值,感興趣的可以直接查看原文博客。

同時,機器之心對此項目也進行了實測。

項目實測

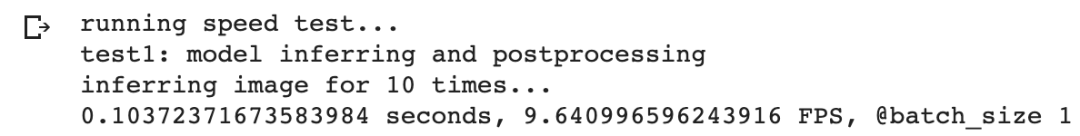

測試

我們在 P100 GPU,Ubuntu 18.04 系統下對本項目進行了測試。

首先將項目克隆到本地,并切換到相關目錄下:

- !git clone https://github.com/zylo117/Yet-Another-EfficientDet-Pytorch

- import os

- os.chdir('Yet-Another-EfficientDet-Pytorch')

安裝如下依賴環境:

- !pip install pycocotools numpy opencv-python tqdm tensorboard tensorboardX pyyaml

- !pip install torch==1.4.0

- !pip install torchvision==0.5.0

項目作者為我們提供了用于推斷測試的 Python 腳本 efficientdet_test.py,該腳本會讀取 weights 文件夾下保存的網絡權重,并對 test 文件夾中的圖片進行推斷,之后將檢測結果保存到同一文件夾下。首先,我們使用如下命令下載預訓練模型:

- !mkdir weights

- os.chdir('weights')

- !wget https://github.com/zylo117/Yet-Another-Efficient-Pytorch/releases/download/1.0/efficientdet-d0.pth

之后把需要檢測的圖片放在 test 文件夾下,這里別忘了還要把 efficientdet_test.py 中對應的圖像名稱修改為我們想要檢測圖片的名稱,運行 efficientdet_test.py 腳本即可檢測圖片中的物體,輸出結果如下:

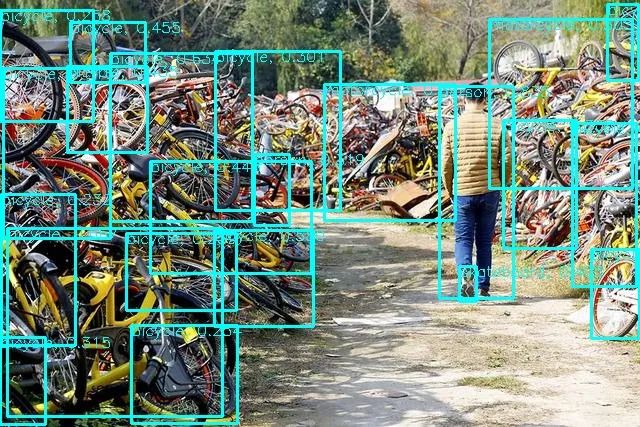

我們先用曾經爆火的共享單車,現如今倒了一大片淪為「共享單車墳場」測試一下效果如何。下圖分別為原圖與使用本項目的檢測結果。

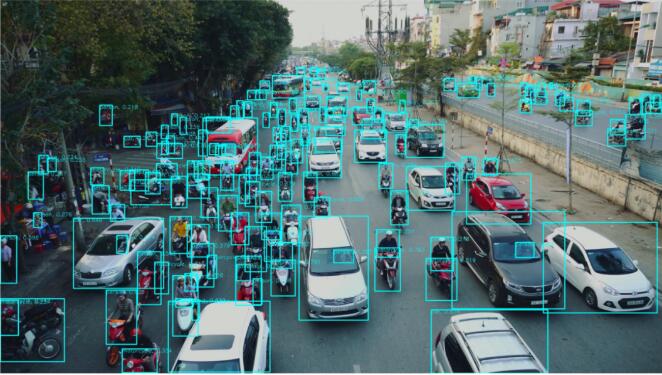

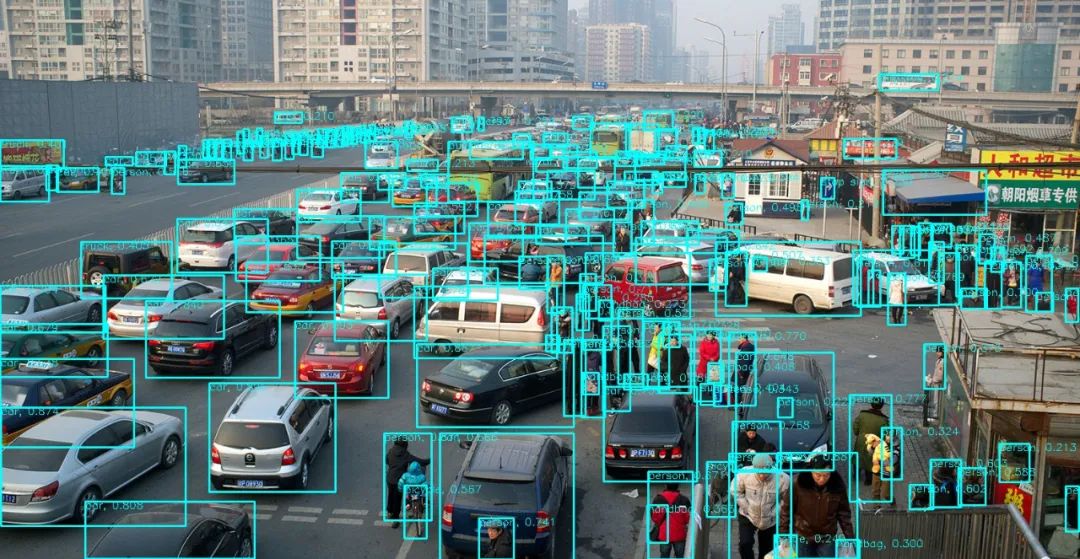

效果很不錯,圖片中的人與密密麻麻、橫七豎八擺放的共享單車大多都檢測了出來。接下來我們用一張國內常見的堵車場景來測試一下,車輛、非機動車、行人交錯出現在畫面中,可以說是非常復雜的場景了。從檢測結果可以看出,基本上所有的行人、車輛、背包、袋子等物體都較好地檢測了出來。

最后當然要在「開掛民族」坐火車的場景下測試一番,密集恐懼癥慎入。雖然把旗子檢測成了風箏(很多目標檢測算法都容易出現這樣的問題),但總體來說檢測效果可以說是非常驚艷的。它檢測出了圖片中大部分的人物,和機器之心此前報道過的高精度人臉檢測方法-DBFace 的準確率有得一拼。需要注意的是,DBFace 是專用于人臉檢測的方法,而本項目實現的是通用物體檢測。

訓練

項目作者同時也提供了訓練 EfficientDet 相關的代碼。我們只需要準備好訓練數據集,設置好類似于如下代碼所示的訓練參數,運行 train.py 即可進行訓練。

- # create a yml file {your_project_name}.yml under 'projects'folder

- # modify it following 'coco.yml'

- # for example

- project_name: coco

- train_set: train2017

- val_set: val2017

- num_gpus: 4 # 0 means using cpu, 1-N means using gpus

- # mean and std in RGB order, actually this part should remain unchanged as long as your dataset is similar to coco.

- mean: [0.485, 0.456, 0.406]

- std: [0.229, 0.224, 0.225]

- # this is coco anchors, change it if necessary

- anchors_scales: '[2 ** 0, 2 ** (1.0 / 3.0), 2 ** (2.0 / 3.0)]'

- anchors_ratios: '[(1.0, 1.0), (1.4, 0.7), (0.7, 1.4)]'

- # objects from all labels from your dataset with the order from your annotations.

- # its index must match your dataset's category_id.

- # category_id is one_indexed,

- # for example, index of 'car' here is 2, while category_id of is 3

- obj_list: ['person', 'bicycle', 'car', ...]

在 coco 數據集上訓練代碼如下:

- # train efficientdet-d0 on coco from scratch

- # with batchsize 12

- # This takes time and requires change

- # of hyperparameters every few hours.

- # If you have months to kill, do it.

- # It's not like someone going to achieve

- # better score than the one in the paper.

- # The first few epoches will be rather unstable,

- # it's quite normal when you train from scratch.

- python train.py -c 0 --batch_size 12

在自定義數據集上訓練:

- # train efficientdet-d1 on a custom dataset

- # with batchsize 8 and learning rate 1e-5

- python train.py -c 1 --batch_size 8 --lr 1e-5

項目作者強烈推薦在預訓練的權重上對網絡進行訓練:

- # train efficientdet-d2 on a custom dataset with pretrained weights

- # with batchsize 8 and learning rate 1e-5 for 10 epoches

- python train.py -c 2 --batch_size 8 --lr 1e-5 --num_epochs 10

- --load_weights /path/to/your/weights/efficientdet-d2.pth

- # with a coco-pretrained, you can even freeze the backbone and train heads only

- # to speed up training and help convergence.

- python train.py -c 2 --batch_size 8 --lr 1e-5 --num_epochs 10

- --load_weights /path/to/your/weights/efficientdet-d2.pth

- --head_only True

【編輯推薦】