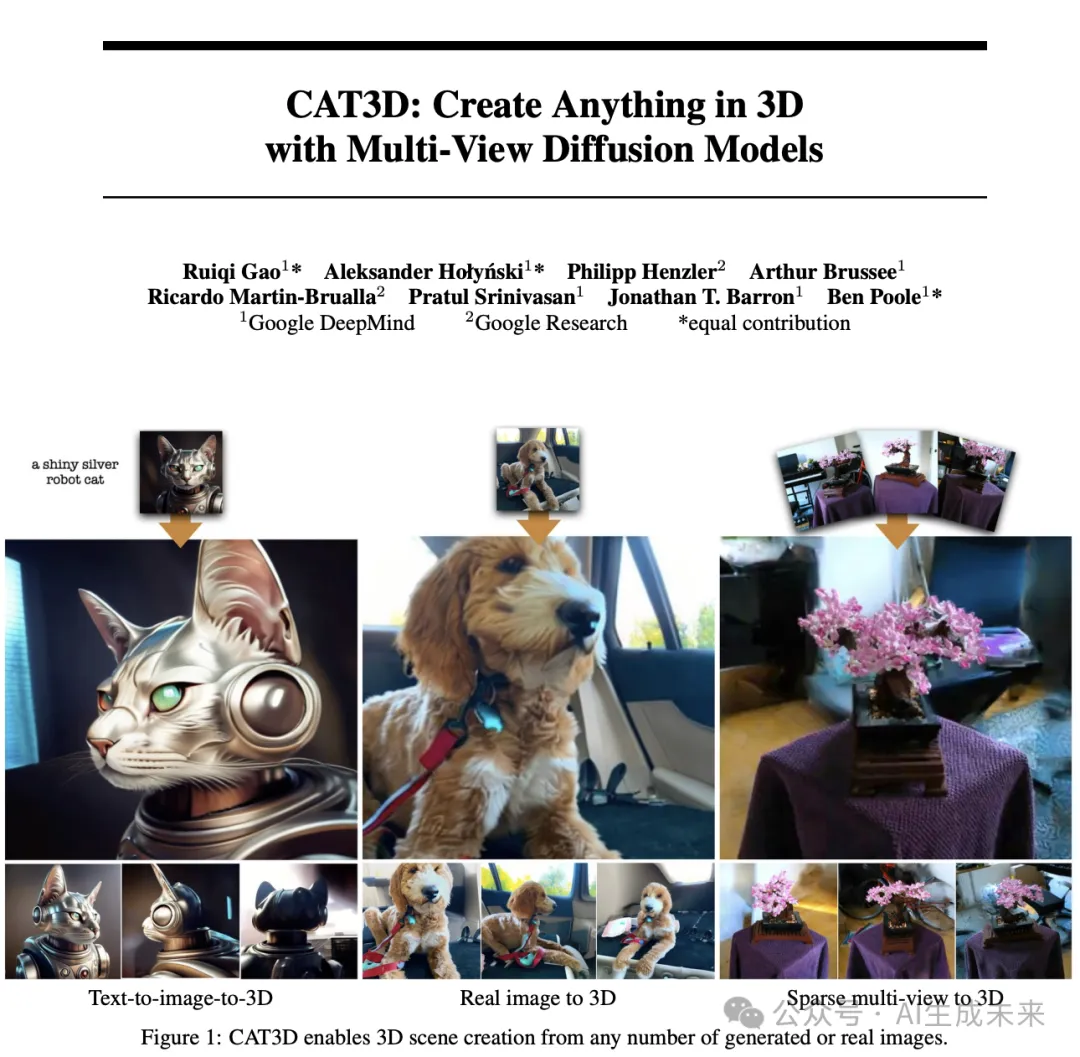

谷歌重磅發(fā)布CAT3D:一分鐘搞定任意數(shù)量視圖到3D場景重建

論文鏈接:https://arxiv.org/pdf/2405.10314

項(xiàng)目鏈接:https://cat3d.github.io/

3D重建的進(jìn)步使得高質(zhì)量的3D捕捉成為可能,但需要用戶收集數(shù)百到數(shù)千張圖像來創(chuàng)建一個(gè)3D場景。本文提出了CAT3D,一種通過多視點(diǎn)擴(kuò)散模型模擬這種現(xiàn)實(shí)世界捕捉過程的方法,可以在3D中創(chuàng)建任何東西。給定任意數(shù)量的輸入圖像和一組目標(biāo)新視點(diǎn),本文的模型生成高度一致的場景新視圖。這些生成的視圖可以作為輸入,用于穩(wěn)健的3D重建技術(shù),從而生成可以實(shí)時(shí)從任何視點(diǎn)渲染的3D representation。CAT3D可以在短至一分鐘內(nèi)創(chuàng)建完整的3D場景,并且在單圖像和少視點(diǎn)3D場景創(chuàng)建方面優(yōu)于現(xiàn)有方法。

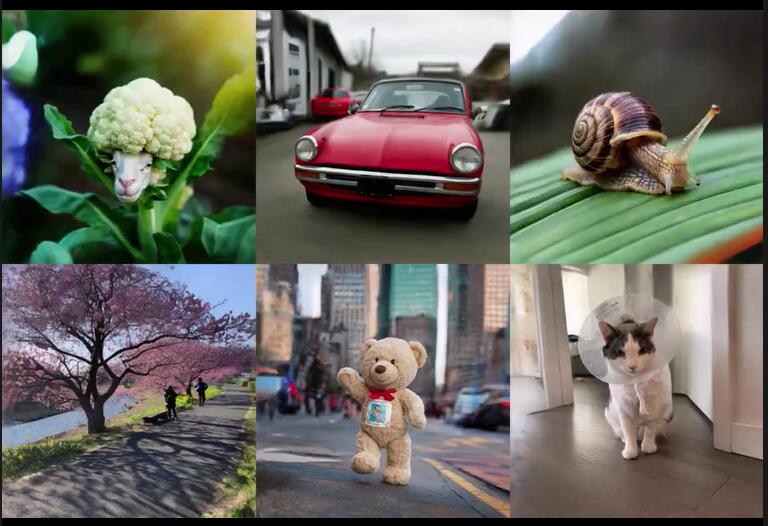

我們先來一起看下建模效果吧

介紹

對(duì)3D內(nèi)容的需求比以往任何時(shí)候都高,因?yàn)樗?strong>對(duì)于實(shí)現(xiàn)游戲、視覺效果和可穿戴混合現(xiàn)實(shí)設(shè)備的實(shí)時(shí)交互至關(guān)重要。盡管需求很高,高質(zhì)量的3D內(nèi)容仍然相對(duì)稀缺。與可以輕松用消費(fèi)級(jí)攝影設(shè)備捕捉的2D圖像和視頻不同,創(chuàng)建3D內(nèi)容需要復(fù)雜的專業(yè)工具以及大量的時(shí)間和精力投入。

幸運(yùn)的是,最近在攝影測量技術(shù)方面的進(jìn)展大大提高了從2D圖像創(chuàng)建3D資產(chǎn)的可行性。方法如NeRF、Instant-NGP和Gaussian Splatting允許任何人通過拍攝真實(shí)場景的照片并優(yōu)化該場景的底層3D幾何和外觀表示來創(chuàng)建3D內(nèi)容。生成的3D representation可以從任何視角渲染,類似于傳統(tǒng)的3D資產(chǎn)。然而,不幸的是,創(chuàng)建詳細(xì)場景仍然需要一個(gè)勞動(dòng)密集的過程,需要捕捉數(shù)百到數(shù)千張照片。對(duì)場景覆蓋不足的捕捉可能導(dǎo)致一個(gè)不適定的優(yōu)化問題,通常會(huì)導(dǎo)致錯(cuò)誤的幾何和外觀,并在從新視角渲染恢復(fù)的3D模型時(shí)產(chǎn)生不合理的圖像。

將這種要求從密集的多視角捕捉減少到較少的輸入,例如單張圖像或文本,將使3D內(nèi)容創(chuàng)建更加便捷。先前的研究已經(jīng)針對(duì)不同的輸入設(shè)置開發(fā)了專門的解決方案,例如針對(duì)稀疏視角重建的幾何規(guī)則化技術(shù),訓(xùn)練從單張圖像創(chuàng)建3D對(duì)象的前饋模型,或在優(yōu)化過程中使用圖像條件或文本條件的生成先驗(yàn)——但這些專門方法各自都存在質(zhì)量、效率和通用性方面的限制。

本文集中研究限制已建立的3D重建方法在觀測受限環(huán)境中使用的基本問題:監(jiān)督視圖數(shù)量不足。與其為不同的輸入情況設(shè)計(jì)專門的解決方案,一種共享的解決方案是簡單地創(chuàng)建更多的觀測 —— 將不太受約束的、不確定的3D創(chuàng)建問題轉(zhuǎn)化為完全約束、完全觀測的3D重建環(huán)境。通過這種方式,本文將一個(gè)困難的病態(tài)重建問題重新表述為一個(gè)生成問題:給定任意數(shù)量的輸入圖像,生成一組一致的新穎3D場景觀測。最新的視頻生成模型在應(yīng)對(duì)這一挑戰(zhàn)方面顯示出希望,因?yàn)樗鼈冋故玖撕铣删哂泻侠?D結(jié)構(gòu)的視頻片段的能力。然而,這些模型通常采樣成本高,難以控制,并且僅限于平滑且短的相機(jī)軌跡。

本文的系統(tǒng)CAT3D則通過專門為新視圖合成訓(xùn)練的多視圖擴(kuò)散模型實(shí)現(xiàn)這一目標(biāo)。給定任意數(shù)量的輸入視圖和任意指定的新視點(diǎn),本文的模型通過高效的并行采樣策略生成多個(gè)3D一致的圖像。隨后,這些生成的圖像通過一個(gè)強(qiáng)大的3D重建pipeline,生成一個(gè)可以從任何視點(diǎn)以交互速度渲染的3D representation。

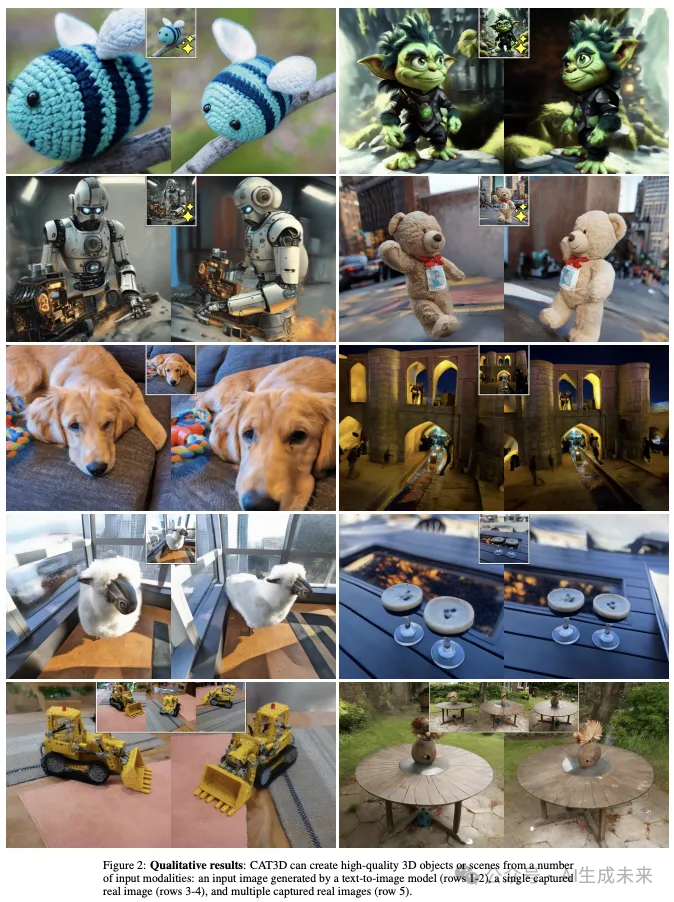

本文展示了CAT3D模型能夠在不到一分鐘的時(shí)間內(nèi),從任意數(shù)量的捕獲或合成輸入視圖生成任意對(duì)象或場景的逼真效果。在各種輸入設(shè)置中評(píng)估了本文的工作,范圍從稀疏的多視圖捕獲到單個(gè)捕獲圖像,甚至僅僅是一個(gè)文本提示(通過使用文本到圖像模型從該提示生成一個(gè)輸入圖像)。在可測量任務(wù)(如多視圖捕獲案例)中,CAT3D在多個(gè)基準(zhǔn)測試中優(yōu)于之前的工作,并且速度比之前的最先進(jìn)方法快一個(gè)數(shù)量級(jí)。對(duì)于經(jīng)驗(yàn)性能難以衡量的任務(wù)(如文本到3D和單圖像到3D),CAT3D在所有設(shè)置中都與之前的工作相比表現(xiàn)良好。

相關(guān)工作

從有限的觀測中創(chuàng)建完整的3D場景需要3D生成技術(shù),例如在未見區(qū)域中創(chuàng)建內(nèi)容,本文的工作建立在不斷增長的3D生成模型研究領(lǐng)域上。由于3D數(shù)據(jù)集相對(duì)稀缺,3D生成的許多研究集中在轉(zhuǎn)移從2D圖像空間先驗(yàn)知識(shí)中學(xué)到的知識(shí),因?yàn)?D數(shù)據(jù)是豐富的。

本文的擴(kuò)散模型建立在最近的視頻和多視圖擴(kuò)散模型的發(fā)展之上, 這些模型可以生成高度一致的新視圖。本文展示了將這些模型與3D重建配對(duì)(類似于[17, 58])可以實(shí)現(xiàn)高效且高質(zhì)量的3D創(chuàng)建。

2D先驗(yàn)。 給定有限的信息,例如文本,預(yù)訓(xùn)練的文本到圖像模型可以為文本到3D生成提供強(qiáng)大的生成先驗(yàn)。然而,將這些基于圖像的先驗(yàn)知識(shí)提煉成一個(gè)連貫的3D模型,目前需要一種迭代提煉的方法。DreamFusion引入了評(píng)分提煉采樣(SDS)來從文本提示中合成3D對(duì)象(如NeRFs)。這一領(lǐng)域的研究旨在改進(jìn)提煉策略,替換其他3D representation,并攤銷優(yōu)化過程。使用基于文本的先驗(yàn)進(jìn)行單圖像到3D生成也顯示出希望,但需要在圖像觀測與附加約束之間進(jìn)行復(fù)雜的平衡。結(jié)合單目深度模型或修復(fù)模型等先驗(yàn)對(duì)于創(chuàng)建3D場景非常有用,但往往會(huì)導(dǎo)致較差的全局幾何。

基于攝像機(jī)條件的2D先驗(yàn)。 雖然文本到圖像模型在生成視覺上吸引人的圖像方面表現(xiàn)出色,但它們?cè)趫D像姿態(tài)的精確控制方面存在不足,因此需要耗時(shí)的3D蒸餾過程來鼓勵(lì)3D模型符合2D先驗(yàn)。為了克服這一限制,一些方法通過顯式圖像和姿態(tài)條件來訓(xùn)練或微調(diào)生成模型。這些模型為給定文本和/或輸入圖像提供了更強(qiáng)的先驗(yàn),表明物體或場景應(yīng)該是什么樣子,但它們也獨(dú)立地建模所有輸出視圖。在新視圖的外觀幾乎沒有不確定性的情況下,獨(dú)立地推理生成的視圖對(duì)于高效的3D重建是足夠的。但在存在一些不確定性的情況下,這些頂尖方法仍然需要昂貴的3D蒸餾來解決不同新視圖之間的不一致性。

多視圖先驗(yàn)。 建模多個(gè)視圖之間的相關(guān)性可以提供更強(qiáng)的先驗(yàn),使得3D內(nèi)容在部分觀測下保持一致性。像MVDream、ImageDream、Zero123++、ConsistNet、SyncDreamer和ViewDiff等方法通過微調(diào)文本到圖像模型來同時(shí)生成多個(gè)視圖。CAT3D在架構(gòu)上類似于ImageDream,其中多視圖依賴性通過類似視頻擴(kuò)散模型的架構(gòu)和3D自注意力機(jī)制來捕捉。基于這種更強(qiáng)的先驗(yàn),這些論文還展示了更高質(zhì)量和更高效的3D提取。

視頻先驗(yàn)。 視頻擴(kuò)散模型在生成逼真視頻方面展示了驚人的能力,并被認(rèn)為能夠隱式推理3D。然而,出于多種原因,使用現(xiàn)成的視頻擴(kuò)散模型進(jìn)行3D生成仍然具有挑戰(zhàn)性。目前的模型缺乏精確的相機(jī)控制,限制了生成的片段只能包含平滑且短暫的相機(jī)軌跡,并且難以生成只有相機(jī)運(yùn)動(dòng)而沒有場景動(dòng)態(tài)的視頻。

一些研究提出通過微調(diào)視頻擴(kuò)散模型來解決這些挑戰(zhàn),以實(shí)現(xiàn)相機(jī)控制或多視圖生成。例如,AnimateDiff使用固定類型的相機(jī)運(yùn)動(dòng)微調(diào)了一個(gè)視頻擴(kuò)散模型,而MotionCtrl則基于任意指定的相機(jī)軌跡對(duì)模型進(jìn)行了條件化。ViVid-1-to-3結(jié)合了一個(gè)新的視圖合成模型和一個(gè)視頻擴(kuò)散模型,用于生成平滑的軌跡。SVD-MV、IM-3D和SV3D進(jìn)一步探索了利用相機(jī)控制或多視圖視頻擴(kuò)散模型進(jìn)行3D生成。然而,它們的相機(jī)軌跡僅限于圍繞中心內(nèi)容的軌道。這些方法主要關(guān)注3D對(duì)象生成,而不適用于3D場景、少視圖3D重建或上下文中的對(duì)象(即未被遮蔽或從圖像背景中分離的對(duì)象)。

前饋方法。 另一條研究方向是學(xué)習(xí)前饋模型,這些模型以少量視圖作為輸入,直接輸出3D representation,而無需針對(duì)每個(gè)實(shí)例進(jìn)行優(yōu)化過程。這些方法可以高效地生成3D representation(在幾秒鐘內(nèi)),但其質(zhì)量通常比基于圖像空間先驗(yàn)的方法差。

方法

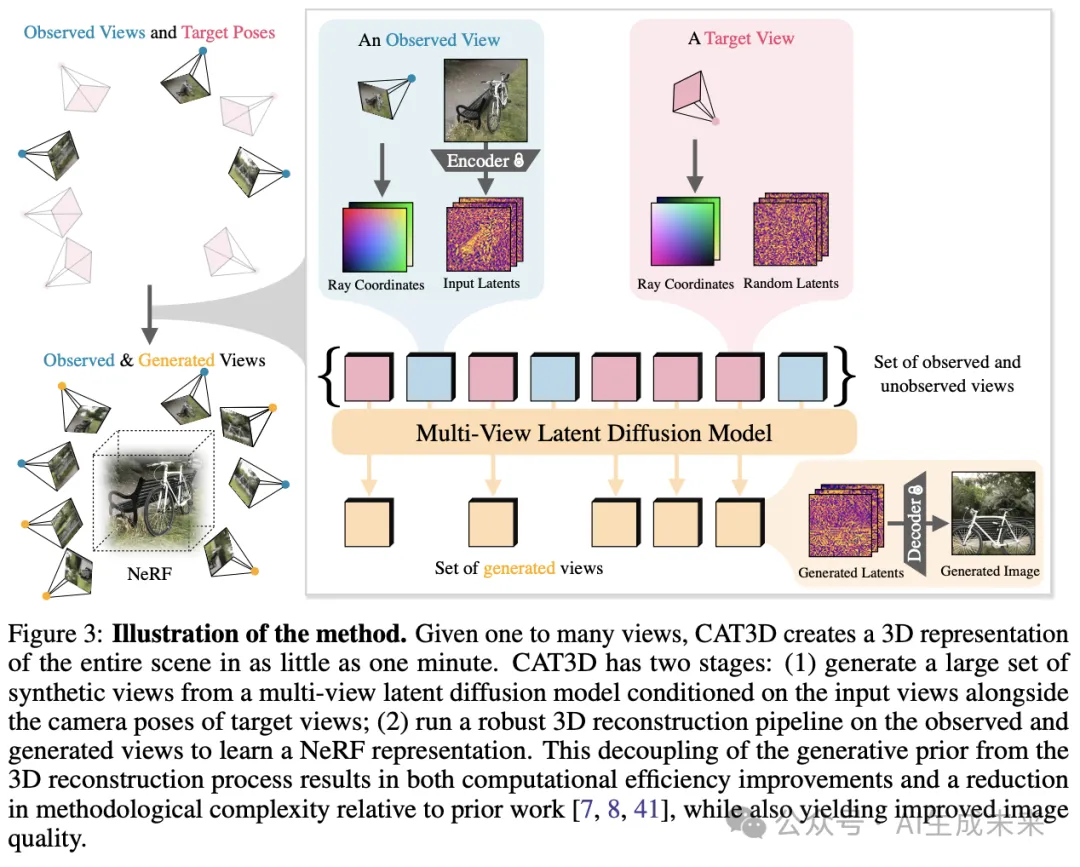

CAT3D 是一種兩步法的3D創(chuàng)建方法:首先,本文使用多視圖擴(kuò)散模型生成與一個(gè)或多個(gè)輸入視圖一致的大量新視圖;其次,本文在生成的視圖上運(yùn)行一個(gè)穩(wěn)健的3D重建pipeline(見下圖3)。下面本文將描述本文的多視圖擴(kuò)散模型、本文生成大量幾乎一致的新視圖的方法,以及這些生成的視圖如何在3D重建pipeline中使用。

多視圖擴(kuò)散模型

本文訓(xùn)練了一個(gè)多視圖擴(kuò)散模型,該模型以單個(gè)或多個(gè)3D場景視圖作為輸入,并根據(jù)其相機(jī)姿態(tài)生成多個(gè)輸出圖像(其中“a view”是圖像和相機(jī)姿態(tài)的配對(duì))。具體來說,給定包含個(gè)條件視圖的 張圖像 及其對(duì)應(yīng)的相機(jī)參數(shù) ,該模型學(xué)習(xí)捕捉N個(gè)目標(biāo)圖像 的聯(lián)合分布,假設(shè)其 N 個(gè)目標(biāo)相機(jī)參數(shù) 也已給定:

模型架構(gòu)。 本文的模型架構(gòu)類似于視頻潛在擴(kuò)散模型(LDMs),但每個(gè)圖像使用相機(jī)姿態(tài)embedding而不是時(shí)間embedding。給定一組條件和目標(biāo)圖像,模型通過圖像變分自動(dòng)編碼器將每個(gè)圖像編碼為潛在表示。然后,訓(xùn)練一個(gè)擴(kuò)散模型以估計(jì)在給定條件信號(hào)下的潛在表示的聯(lián)合分布。本文從一個(gè)用于文本到圖像生成的LDM模型初始化,該模型類似于[62]在網(wǎng)絡(luò)規(guī)模圖像數(shù)據(jù)上訓(xùn)練的LDM,輸入圖像分辨率為512×512×3,潛在表示的形狀為64×64×8。如同在視頻擴(kuò)散模型中常見的做法[49, 10, 11],本文的模型主要骨干仍然是預(yù)訓(xùn)練的2D擴(kuò)散模型,但增加了連接多個(gè)輸入圖像潛在表示的層。

如同[43],本文使用3D自注意力(在空間上是2D,在圖像間是1D)代替簡單的跨圖像1D自注意力。本文在原始LDM的每個(gè)2D殘差塊之后直接膨脹現(xiàn)有的2D自注意力層,以連接潛在表示與3D自注意力層,同時(shí)繼承預(yù)訓(xùn)練模型的參數(shù),增加的模型參數(shù)量極少。本文發(fā)現(xiàn),通過3D自注意力層對(duì)輸入視圖進(jìn)行條件化可以消除之前狀態(tài)最先進(jìn)模型在少視圖重建中使用的PixelNeRF和CLIP圖像embedding的需求,例如ReconFusion。本文使用FlashAttention 進(jìn)行快速訓(xùn)練和采樣,并微調(diào)潛在擴(kuò)散模型的所有權(quán)重。

與之前的工作類似,本文發(fā)現(xiàn)從預(yù)訓(xùn)練的圖像擴(kuò)散模型到捕捉更高維度數(shù)據(jù)的多視圖擴(kuò)散模型時(shí),將噪聲調(diào)度向高噪聲水平轉(zhuǎn)移是重要的。具體來說,遵循與[67]類似的邏輯,本文將信噪比的對(duì)數(shù)按log(N)偏移,其中N是目標(biāo)圖像的數(shù)量。在訓(xùn)練中,目標(biāo)圖像的潛在表示被噪聲擾動(dòng),而條件圖像的潛在表示保持干凈,并且擴(kuò)散損失僅在目標(biāo)圖像上定義。一個(gè)二進(jìn)制 mask 沿通道維度連接到潛在表示,以表示條件圖像和目標(biāo)圖像。為了處理多個(gè)3D生成設(shè)置,本文訓(xùn)練了一個(gè)單一的多功能模型,可以建模總共8個(gè)條件和目標(biāo)視圖(N + M = 8),并在訓(xùn)練期間隨機(jī)選擇條件視圖數(shù)量N為1或3,分別對(duì)應(yīng)7個(gè)和5個(gè)目標(biāo)視圖。

攝像機(jī)條件。 為了根據(jù)攝像機(jī)姿態(tài)進(jìn)行條件,本文使用了一種攝像機(jī)光線表示(“光線圖”),其高度和寬度與潛在表示相同,并在每個(gè)空間位置編碼光線的起點(diǎn)和方向。光線是相對(duì)于第一個(gè)條件圖像的攝像機(jī)姿態(tài)計(jì)算的,因此本文的姿態(tài)表示對(duì)3D世界坐標(biāo)的剛性變換是不變的。每個(gè)圖像的光線圖按通道連接到相應(yīng)圖像的潛在表示上。

產(chǎn)生新穎的觀點(diǎn)

給定一組輸入視圖,本文的目標(biāo)是生成大量一致的視圖,以全面覆蓋場景并實(shí)現(xiàn)精確的3D重建。 為此,本文需要決定要采樣的攝像機(jī)姿態(tài)集,并設(shè)計(jì)一種采樣策略,該策略可以使用在少量視圖上訓(xùn)練的多視圖擴(kuò)散模型生成更大的一組一致視圖。

攝像機(jī)軌跡。 與軌道攝像機(jī)軌跡在3D對(duì)象重建中可以有效相比,3D場景重建的挑戰(zhàn)在于完全覆蓋一個(gè)場景所需的視角可能復(fù)雜且依賴于場景內(nèi)容。本文通過實(shí)驗(yàn)發(fā)現(xiàn),為不同類型的場景設(shè)計(jì)合理的攝像機(jī)軌跡對(duì)于實(shí)現(xiàn)引人注目的少視角3D重建至關(guān)重要。攝像機(jī)路徑必須足夠徹底和密集,以完全約束重建問題,但也不能穿過場景中的物體或從不尋常的角度查看場景內(nèi)容。總之,本文基于場景特征探索了四種類型的攝像機(jī)路徑:

- 圍繞中心場景的不同規(guī)模和高度的軌道路徑

- 不同規(guī)模和偏移的前向圓路徑

- 不同偏移的樣條路徑

- 沿著圓柱路徑的螺旋軌跡,進(jìn)入和離開場景

?

生成大量合成視圖。 在將本文的多視圖擴(kuò)散模型應(yīng)用于新視角合成時(shí)的一個(gè)挑戰(zhàn)是,它是用有限的小集合輸入和輸出視圖進(jìn)行訓(xùn)練的——總共只有8個(gè)視圖。為了增加輸出視圖的總數(shù),本文將目標(biāo)視點(diǎn)聚類成較小的組,并在給定條件視圖的情況下獨(dú)立生成每個(gè)組。本文將攝像機(jī)位置接近的目標(biāo)視圖分組,因?yàn)檫@些視圖通常是最具依賴性的。對(duì)于單圖像條件,本文采用自回歸采樣策略,首先生成一組覆蓋場景的7個(gè)錨點(diǎn)視圖(類似于[41],并使用[69]中的貪心初始化選擇),然后在給定觀察到的和錨點(diǎn)視圖的情況下并行生成剩余的視圖組。這使本文能夠高效地生成大量合成視圖,同時(shí)仍然保持錨點(diǎn)視圖之間的長距離一致性和相鄰視圖之間的局部相似性。對(duì)于單圖像設(shè)置,本文生成80個(gè)視圖,而對(duì)于少視角設(shè)置,本文使用480-960個(gè)視圖。

將較大集的輸入視圖和非正方形圖像進(jìn)行條件化。 為了擴(kuò)展本文可以進(jìn)行條件化的視圖數(shù)量,本文選擇最近的M個(gè)視圖作為條件集,如[7]所述。本文嘗試通過在采樣過程中簡單地增加多視圖擴(kuò)散架構(gòu)的序列長度,但發(fā)現(xiàn)最近視圖條件化和分組采樣策略效果更好。 為了處理寬高比較大的圖像,本文將從正方形裁剪的輸入視圖中提取的正方形樣本與從填充為正方形的輸入視圖中裁剪的寬樣本結(jié)合起來。

魯棒的3D重建

本文的多視圖擴(kuò)散模型生成了一組高質(zhì)量的合成視圖,這些視圖在一定程度上相互一致。然而,生成的視圖通常并不是完全三維一致的。事實(shí)上,即使是當(dāng)前最先進(jìn)的視頻擴(kuò)散模型,生成完全三維一致的圖像仍然是一個(gè)非常具有挑戰(zhàn)性的問題。由于三維重建方法設(shè)計(jì)時(shí)是以照片(按定義是完全一致的)作為輸入的,本文修改了標(biāo)準(zhǔn)的NeRF訓(xùn)練過程,以提高其對(duì)不一致輸入視圖的魯棒性。

?

本文基于 Zip-NeRF 構(gòu)建,其訓(xùn)練過程最小化了攝影重建損失、畸變損失、層間損失和歸一化的 L2 權(quán)重正則化器的總和。本文另外在渲染圖像和輸入圖像之間加入了感知損失(LPIPS)。與攝影重建損失相比,LPIPS 強(qiáng)調(diào)渲染圖像和觀察圖像之間的高級(jí)語義相似性,同時(shí)忽略低級(jí)高頻細(xì)節(jié)中的潛在不一致性。由于生成的視圖越接近觀察到的視圖,其不確定性越小,因此一致性更高,本文根據(jù)生成視圖與最近觀察到的視圖之間的距離對(duì)其損失進(jìn)行加權(quán)。這種加權(quán)在訓(xùn)練開始時(shí)是均勻的,并逐漸退化為一種加權(quán)函數(shù),對(duì)靠近觀察視圖的重建損失進(jìn)行更強(qiáng)烈的懲罰。

實(shí)驗(yàn)

本文在四個(gè)具有相機(jī)姿態(tài)標(biāo)注的數(shù)據(jù)集上訓(xùn)練了CAT3D核心的多視圖擴(kuò)散模型:Objaverse、CO3D、RealEstate10k和 MVImgNet。然后,本文在少視圖重建任務(wù)和單圖像到3D任務(wù)上評(píng)估了CAT3D,展示了相較于之前工作的定性和定量改進(jìn)。導(dǎo)致CAT3D設(shè)計(jì)選擇的消融實(shí)驗(yàn)和進(jìn)一步討論在本節(jié)中進(jìn)行。

少視圖 3D 重建

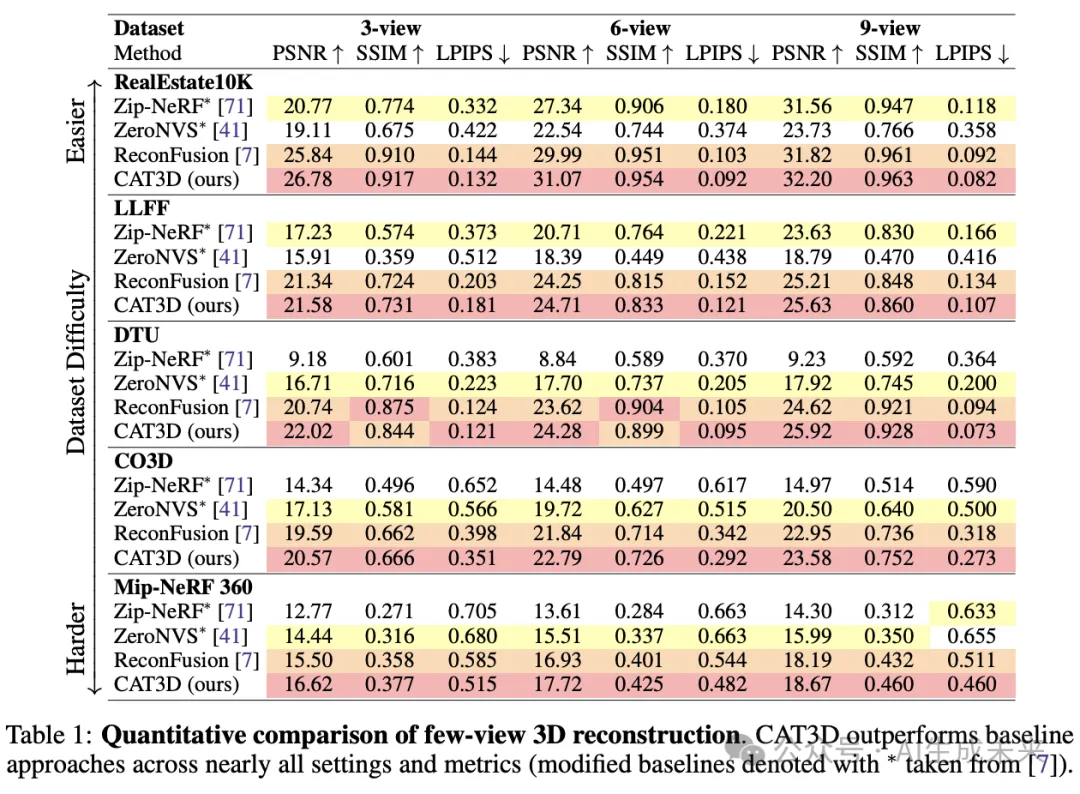

本文首先在五個(gè)真實(shí)世界的基準(zhǔn)數(shù)據(jù)集上評(píng)估CAT3D在少視圖3D重建任務(wù)中的表現(xiàn)。其中,CO3D和 RealEstate10K是分布內(nèi)數(shù)據(jù)集,其訓(xùn)練集的一部分用于本文的訓(xùn)練集(本文使用它們的測試集進(jìn)行評(píng)估),而 DTU、LLFF 和 mip-NeRF 360 數(shù)據(jù)集是分布外數(shù)據(jù)集,不在訓(xùn)練數(shù)據(jù)集中。本文在3視圖、6視圖和9視圖重建任務(wù)上測試了CAT3D,使用與 [7] 相同的訓(xùn)練和評(píng)估集劃分。在下表1中,本文與無學(xué)習(xí)先驗(yàn)的密集視圖NeRF重建的最新方法(Zip-NeRF)以及大量利用生成先驗(yàn)的方法(如 ZeroNVS和 ReconFusion )進(jìn)行了比較。

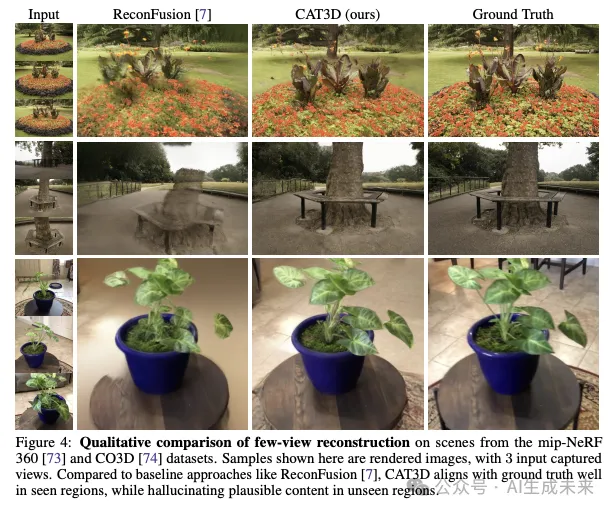

本文發(fā)現(xiàn),CAT3D在幾乎所有設(shè)置中都達(dá)到了最先進(jìn)的性能,同時(shí)將生成時(shí)間從1小時(shí)(對(duì)于ZeroNVS和ReconFusion)減少到幾分鐘。CAT3D在更具挑戰(zhàn)性的數(shù)據(jù)集(如CO3D和mip-NeRF 360)上以更大的優(yōu)勢超越了基線方法,從而展示了其在重建大型和高度詳細(xì)場景中的價(jià)值。下圖4顯示了定性比較。在未觀測區(qū)域,CAT3D能夠生成合理的紋理內(nèi)容,同時(shí)保留輸入視圖的幾何和外觀,而之前的工作往往會(huì)產(chǎn)生模糊的細(xì)節(jié)和過度平滑的背景。

單幅圖像轉(zhuǎn) 3D

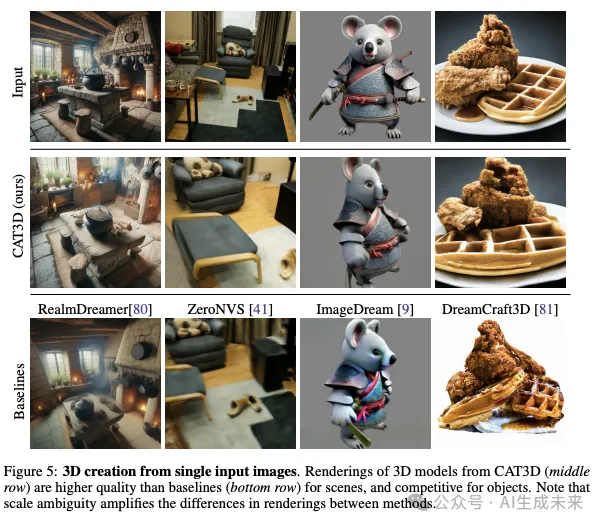

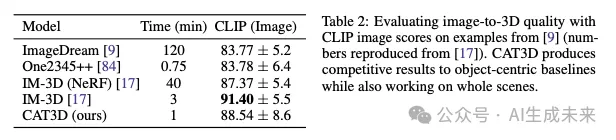

CAT3D支持從單個(gè)輸入視圖高效生成多樣的3D內(nèi)容。在這種欠約束的情況下進(jìn)行評(píng)估非常具有挑戰(zhàn)性,因?yàn)橛性S多與單個(gè)視圖一致的3D場景,例如不同尺度的場景。因此,本文將單圖像評(píng)估集中在定性比較(下圖5)和使用CLIP 進(jìn)行的定量語義評(píng)估(下表2)上。

在場景方面,CAT3D生成的高分辨率結(jié)果比ZeroNVS和RealmDreamer更好,對(duì)于場景和物體,本文都能更好地保留輸入圖像的細(xì)節(jié)。在包含分割對(duì)象的圖像中,本文的幾何表現(xiàn)通常不如ImageDream和DreamCraft3D等現(xiàn)有方法,但保持了競爭力的CLIP得分。與這些在3D蒸餾中迭代利用生成先驗(yàn)的方法相比,CAT3D的生成速度快了一個(gè)數(shù)量級(jí)以上。盡管已有針對(duì)物體的更快生成方法被提出,但它們的分辨率結(jié)果顯著低于其迭代對(duì)手,因此未被納入此次比較。IM-3D在分割對(duì)象上表現(xiàn)更好,且運(yùn)行時(shí)間相似,但無法處理場景或上下文中的物體。

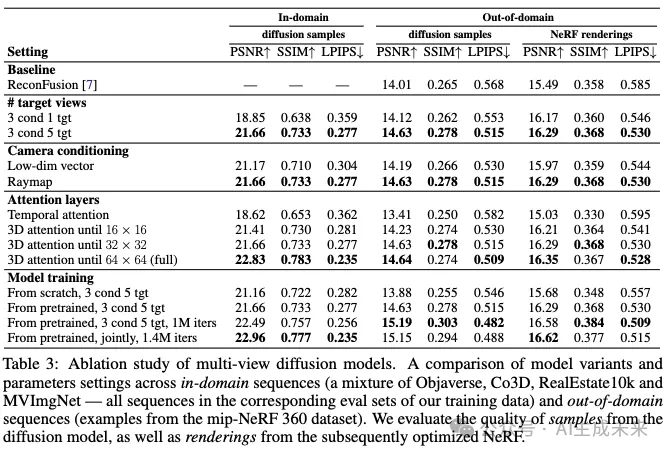

消融實(shí)驗(yàn)

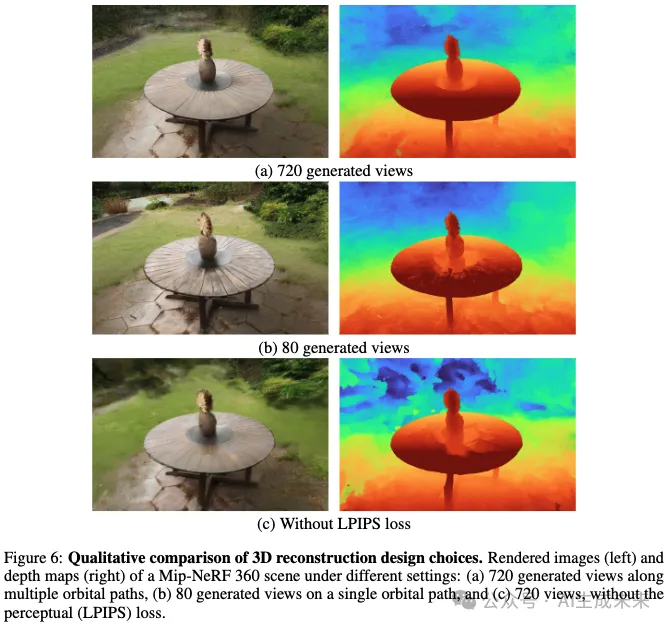

CAT3D的核心是一種多視圖擴(kuò)散模型,該模型經(jīng)過訓(xùn)練能夠生成一致的新視圖。本文考慮了幾種不同的模型變體,并評(píng)估了它們?cè)谟騼?nèi)和域外數(shù)據(jù)集上的樣本質(zhì)量以及少視圖3D重建性能。本文還比較了3D重建中的重要設(shè)計(jì)選擇。本文的消融研究結(jié)果參考下表3和圖6中報(bào)告,并總結(jié)如下。總體而言,本文發(fā)現(xiàn)視頻擴(kuò)散架構(gòu)結(jié)合3D自注意力(時(shí)空)和相機(jī)姿態(tài)的射線圖embedding,當(dāng)與魯棒的重建損失結(jié)合時(shí),能夠生成足夠一致的視圖以恢復(fù)3D representation。

在圖像和姿態(tài)的處理方面, 之前的工作使用了PixelNeRF的特征圖條件化來處理多個(gè)輸入視圖。本文發(fā)現(xiàn),在條件視頻擴(kuò)散架構(gòu)中,用基于注意力的條件化替換PixelNeRF,并使用每個(gè)圖像的相機(jī)姿態(tài)embedding,可以改進(jìn)樣本和3D重建,同時(shí)減少模型復(fù)雜性和參數(shù)數(shù)量。本文發(fā)現(xiàn),將相機(jī)姿態(tài)embedding為低維向量(如[36]所述)在域內(nèi)樣本上效果很好,但與射線圖條件化相比,泛化性能較差(詳見前文)。

增加視圖數(shù)量。 本文發(fā)現(xiàn),聯(lián)合建模多個(gè)輸出視圖(即5個(gè)或7個(gè)視圖,而不是1個(gè)視圖)可以改進(jìn)樣本指標(biāo)——即使是評(píng)估每個(gè)輸出圖像質(zhì)量的獨(dú)立指標(biāo)也有所改進(jìn)。聯(lián)合建模多個(gè)輸出視圖能夠生成更一致的視圖,從而也改進(jìn)了3D重建的效果。

注意力層。 本文發(fā)現(xiàn)3D自注意力(時(shí)空)是至關(guān)重要的,因?yàn)樗鄬?duì)于因子化的2D自注意力(僅空間)和1D自注意力(僅時(shí)間)表現(xiàn)出更好的性能。雖然在最精細(xì)的特征圖(64 × 64)中使用3D自注意力的模型可以產(chǎn)生最高保真度的圖像,但它們?cè)谟?xùn)練和采樣過程中會(huì)產(chǎn)生顯著的計(jì)算開銷,而保真度的提升相對(duì)較小。因此,本文決定僅在尺寸為32 × 32及更小的特征圖中使用3D自注意力。

多視圖擴(kuò)散模型訓(xùn)練。 從預(yù)訓(xùn)練的文本到圖像潛在擴(kuò)散模型進(jìn)行初始化,提高了在域外樣本上的表現(xiàn)。本文嘗試對(duì)多視圖擴(kuò)散模型進(jìn)行微調(diào),使其適應(yīng)特定數(shù)量的輸入和輸出視圖的多個(gè)變體,但發(fā)現(xiàn)一個(gè)單一模型在8幀圖像上聯(lián)合訓(xùn)練,并使用1或3個(gè)條件視圖,就足以實(shí)現(xiàn)準(zhǔn)確的單圖像和少視圖3D重建。

3D重建。 LPIPS損失對(duì)于實(shí)現(xiàn)高質(zhì)量的紋理和幾何形狀至關(guān)重要,這與[17, 7]中的發(fā)現(xiàn)一致。在Mip-NeRF 360上,將生成的視圖數(shù)量從80(單橢圓軌道)增加到720(九個(gè)軌道)改善了中央物體的幾何形狀,但有時(shí)會(huì)引入背景模糊,這可能是由于生成內(nèi)容的不一致性所致。

討論

本文介紹了CAT3D,一種從任意數(shù)量的輸入圖像生成3D內(nèi)容的統(tǒng)一方法。 CAT3D利用多視圖擴(kuò)散模型生成高度一致的3D場景新視圖,然后將這些視圖輸入到3D多視圖重建pipeline中。CAT3D將生成先驗(yàn)與3D提取解耦,從而實(shí)現(xiàn)高效、簡單且高質(zhì)量的3D生成。

盡管CAT3D在多個(gè)任務(wù)上產(chǎn)生了引人注目的結(jié)果并優(yōu)于之前的工作,但它也存在一些限制。由于本文的訓(xùn)練數(shù)據(jù)集對(duì)同一場景的視圖具有大致恒定的相機(jī)內(nèi)參,訓(xùn)練模型無法很好地處理由不同內(nèi)參的多臺(tái)相機(jī)捕獲的測試案例。CAT3D的生成質(zhì)量依賴于基礎(chǔ)文本到圖像模型的表達(dá)能力,對(duì)于基礎(chǔ)模型分布之外的場景內(nèi)容,其表現(xiàn)較差。本文的多視圖擴(kuò)散模型支持的輸出視圖數(shù)量仍然相對(duì)較少,因此當(dāng)本文從模型生成大量樣本時(shí),并非所有視圖都能在3D上保持一致。最后,CAT3D使用手動(dòng)構(gòu)建的相機(jī)軌跡來全面覆蓋場景,這對(duì)于大規(guī)模開放式3D環(huán)境可能難以設(shè)計(jì)。

未來工作中有幾個(gè)方向值得探索以改進(jìn)CAT3D。多視圖擴(kuò)散模型可能會(huì)受益于從預(yù)訓(xùn)練的視頻擴(kuò)散模型進(jìn)行初始化,如[10, 17]所觀察到的。通過擴(kuò)展模型處理的條件視圖和目標(biāo)視圖數(shù)量,可以進(jìn)一步提高樣本的一致性。自動(dòng)確定不同場景所需的相機(jī)軌跡可以增加系統(tǒng)的靈活性。

本文轉(zhuǎn)自 AI生成未來 ,作者:Ruiqi Gao等