阿里RAG新框架R4:增強檢索器-重排序-響應器,5個知識密集任務上都超過Self-RAG等!

大型語言模型(LLMs)在生成文本時可能會產生錯誤信息,即“幻覺”問題。盡管檢索增強的LLMs通過檢索外部數據來減少這種幻覺,但現有的方法通常不考慮檢索文檔與LLMs之間的細粒度結構語義交互,這在處理長文檔時尤其影響回答的準確性。

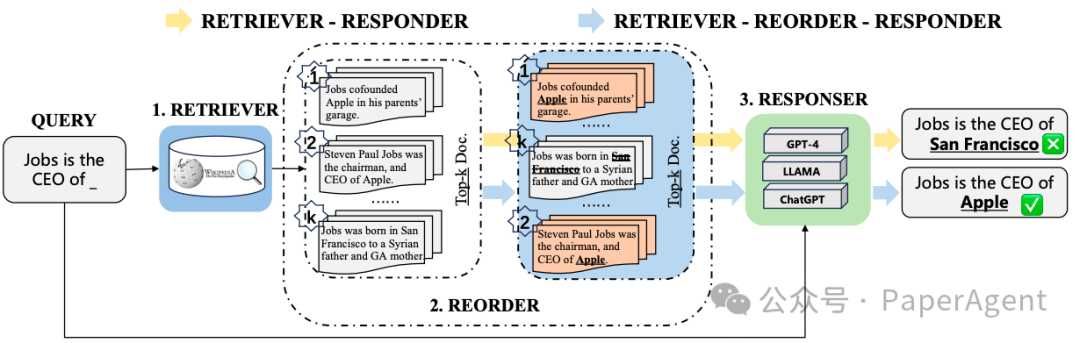

不同的檢索增強方法范式,包括傳統(tǒng)的檢索器-響應器方法和增強檢索器-重排序-響應器框架。強調了學習關鍵檢索文檔的排序結構的重要性,以幫助LLMs更好地處理與事實知識相關的用戶查詢。

為了解決這一問題,提出了一個新的大模型RAG框架R4:Reinforced Retriever-Reorder-Responder(增強檢索器-重排序-響應器),它包含三個主要模塊:

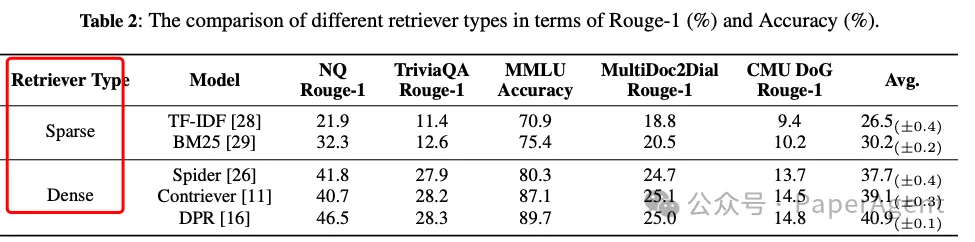

- 檢索器(Retriever):使用Dense Passage Retriever(DPR)檢索相關文檔。

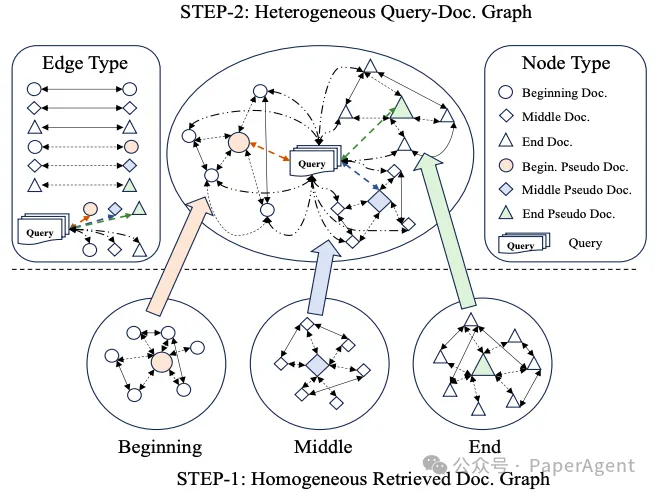

- 重排序器(Reorder):通過圖注意力學習和強化學習機制動態(tài)調整檢索文檔的順序。

- 響應器(Responder):將查詢和調整后的文檔作為輸入,生成回答。

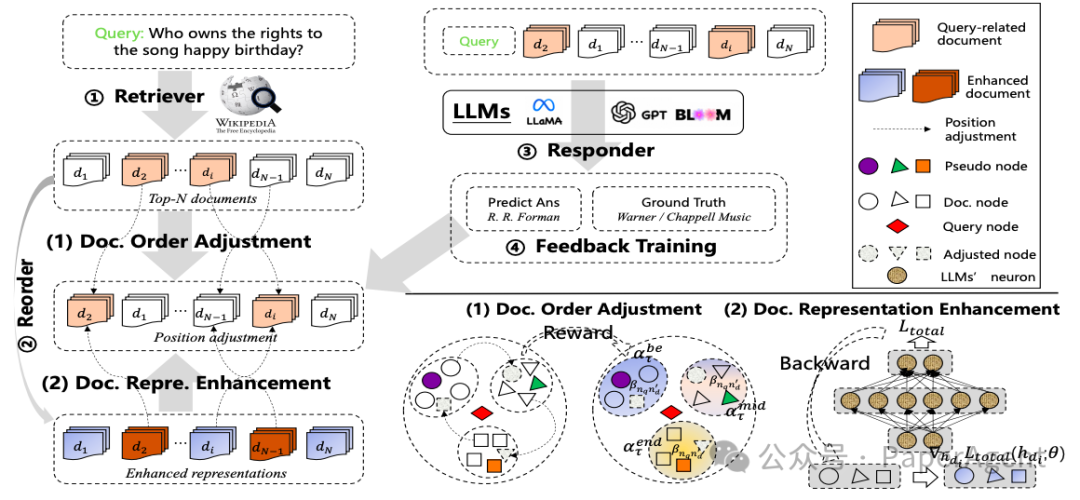

R4概覽。文檔順序調整:根據反饋,文檔在簇中的位置會動態(tài)調整。文檔表示增強:文檔表示會根據訓練損失的權重梯度進行更新(彩色查看效果最佳)。

具體過程包括:

- 文檔順序調整:利用圖注意力學習將檢索文檔動態(tài)調整到開始、中間和結束位置,以最大化回答質量的強化獎勵。?

在R4框架內,查詢和檢索到的文檔之間異構圖構建過程的示意圖。

- 文檔表示增強:對于生成質量較差的回答,通過文檔級別的梯度對抗學習來細化檢索文檔的表示。

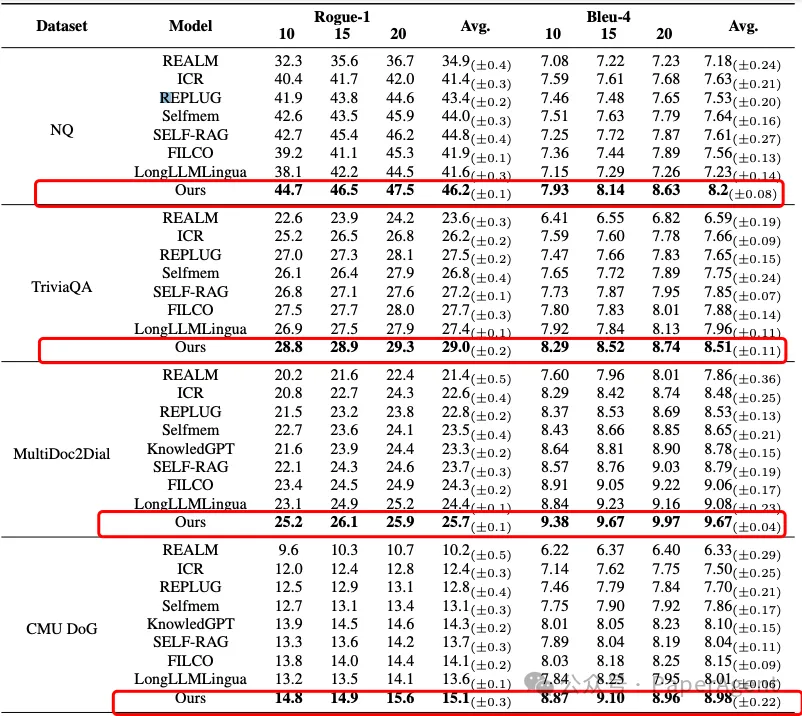

實驗使用了3類任務5個數據集,包括生成式問答(Generative QA)、多項選擇問答(Multi-choice QA)和對話(Dialogue)任務。

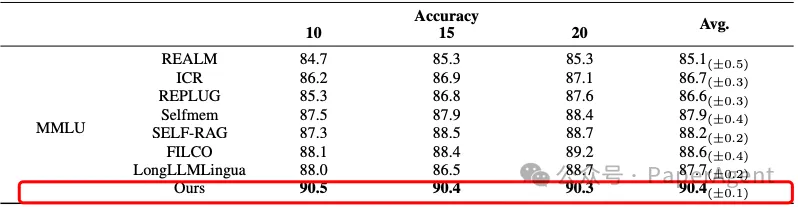

- R4框架在知識密集型任務上的表現超過了多個強基線模型,包括REALM、ICR、REPLUG、Selfmem、SELF-RAG、FILCO和LongLLMLingua。

R4模型在公共數據集上的總體結果。T檢驗表明,R4工作改進在統(tǒng)計上是顯著的,p值<0.05。

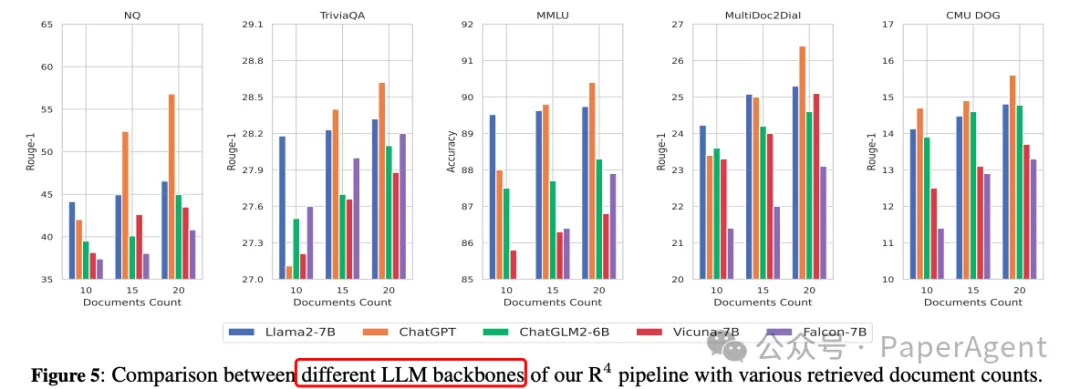

- R4框架對于不同的檢索器和LLMs表現出良好的適應性,證明了其在不同文檔數量下的魯棒性。

- 增加檢索文檔的數量(10->15->20)可以提高模型性能,但性能提升隨著檢索文檔數量的增加而減少。

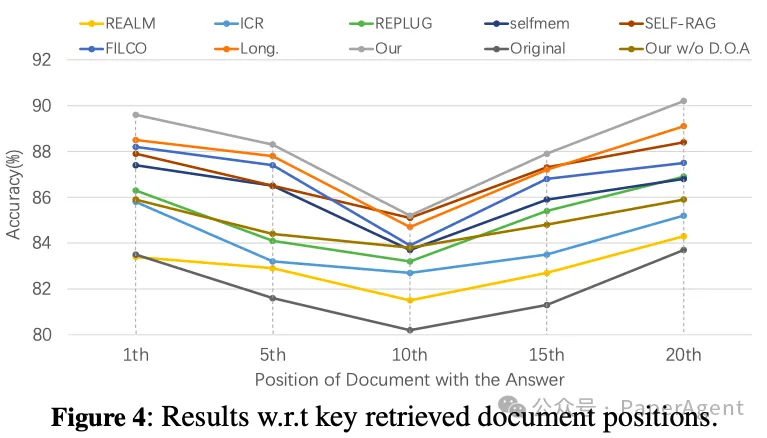

- 基線(Self-RAG、REALM等)也表現出對位置敏感的現象,即開始和結束位置比中間位置更有效。

- R4無論關鍵文檔的初始位置如何,都能展現出穩(wěn)定且強健的輸出。這證實了文檔的排序和優(yōu)化在本質上增強了LLMs在RAG系統(tǒng)中處理用戶查詢的能力的觀點。

https://arxiv.org/pdf/2405.02659

R4: Reinforced Retriever-Reorder-Responder for Retrieval-Augmented Large Language Models

code:paper錄用后會發(fā)布本文轉載自 ??PaperAgent??,作者: PaperAgent

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦