清華SuperBench全球測評出爐,Claude 3拿下多個冠軍!合成數據才是人類未來?

就在最近,清華大學SuperBench團隊的新一輪全球大模型評測結果出爐了!

此次測評,還增加了Llama 3-8b 和Llama 3-70b兩個最近炙手可熱的模型。

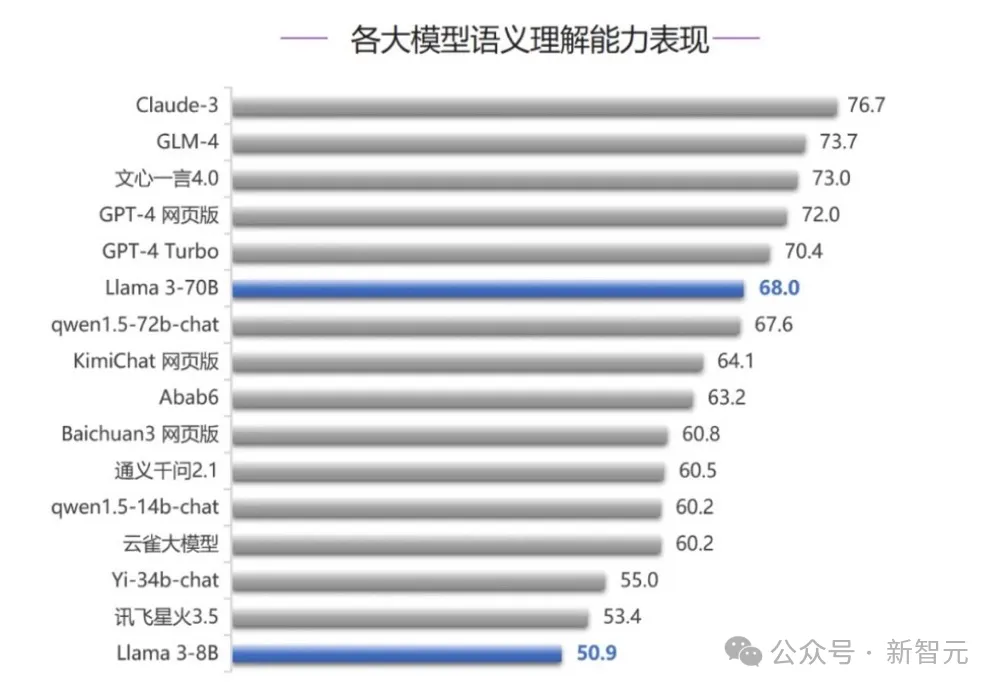

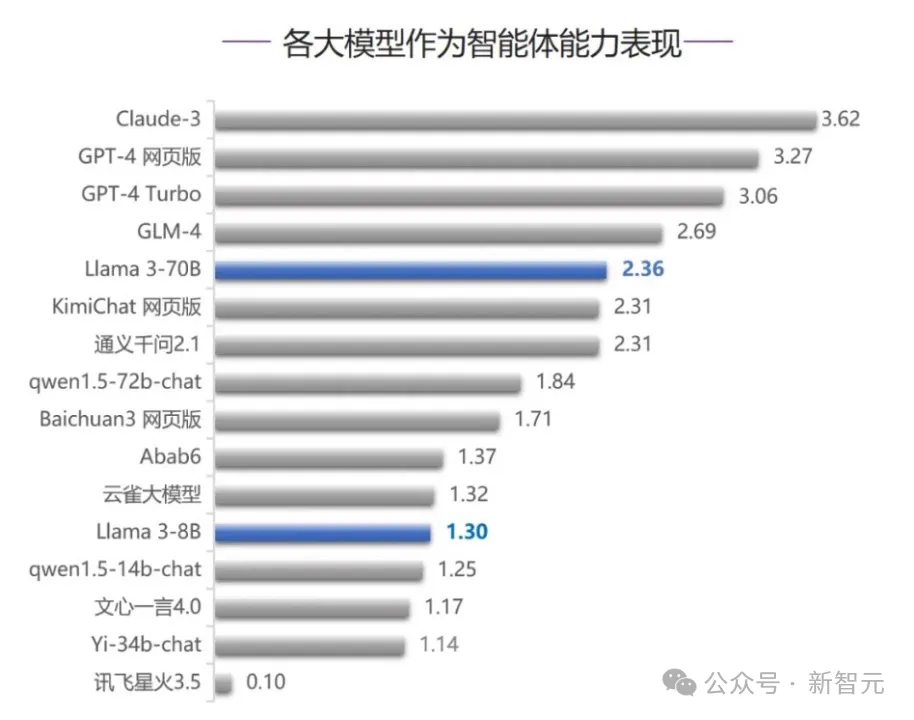

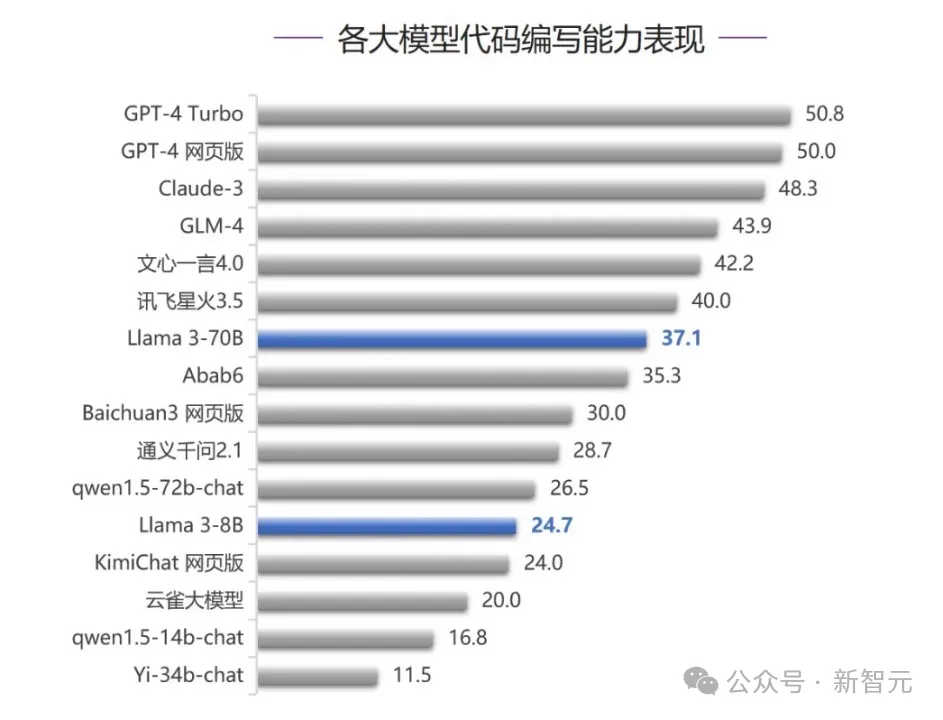

在語義理解、智能體能力、代碼能力三個測評中,我們發現:Claude-3拿下兩個top 1,穩穩位于前三之列。

Claude 3果然實強。

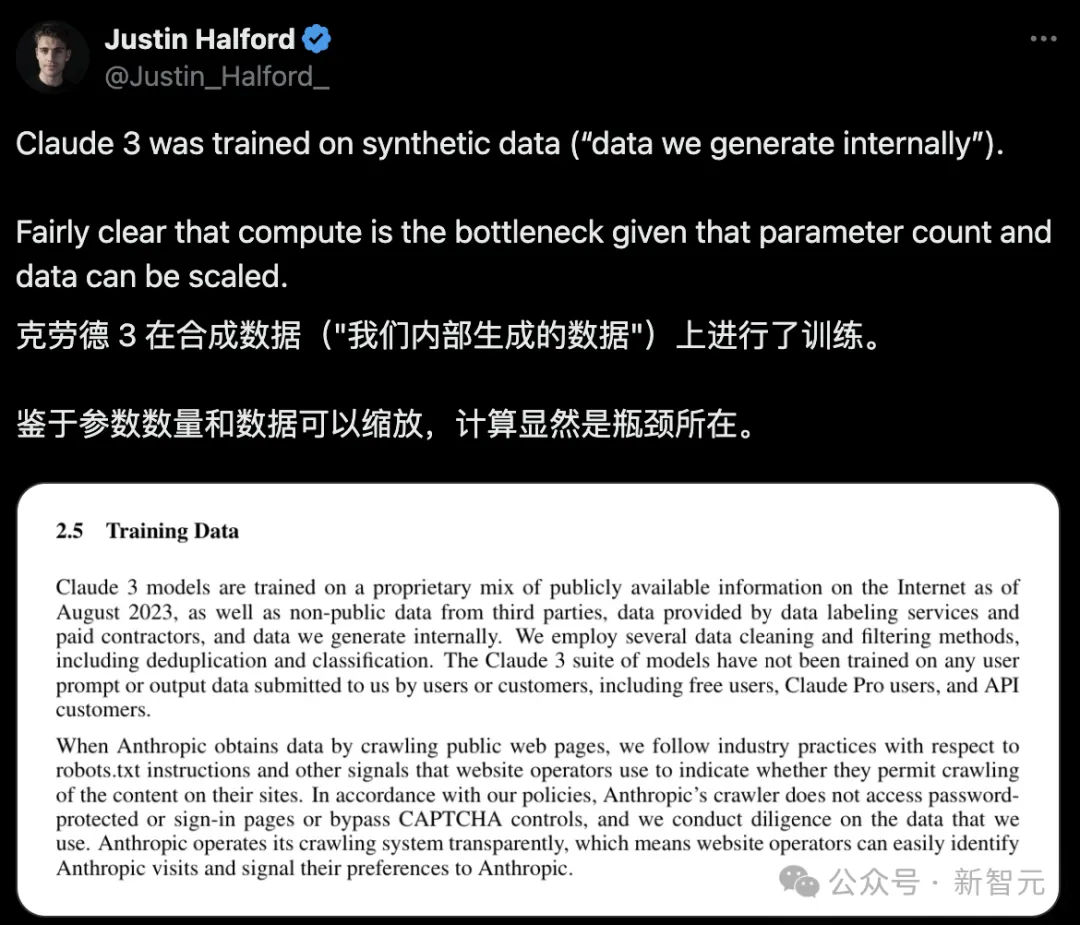

技術報告曝出:Claude 3靠合成數據

在技術報告中,大家發現了Claude 3的亮點——

它是在合成數據上訓練的。

鑒于大模型的參數數量和數據都是可以縮放的,所以以后計算就是瓶頸了。

所以,Claude 3的成功,可以說是對合成數據而言是一個巨大的進步。

其實,此前艾倫人工智能研究所的科學家Nathan Lambert就曾經就Anthropic的合成數據做了一些猜測。

而現在詳細技術報告的發布,將他的猜測完全證實了!

合成數據的探索

關于合成數據,Lambert曾在23年11月寫下了一篇文章《合成數據:Anthropic 的 CAI,從微調到預訓練,OpenAI 的超對齊,提示、類型和開放示例》。

在這篇文章里,他做出判斷——合成數據是AI下一階段的加速器,并且詳細解釋了合成數據是什么,以及它意味著什么。

合成數據,也就是由機器生成而非人工創建的數據,在自然語言處理(NLP)和整個機器學習(ML)領域都有著長久的歷史背景。與之密切相關的概念是數據增強,即通過對數據進行細微調整來豐富數據集的多樣性。

在NLP領域,一個經典的應用是回譯,即利用ML模型的輸出對原始文本進行重新翻譯,生成新的數據。

如今,合成數據的使命變得更加重大:通過去除人類的介入,讓AI更加符合預期且用戶友好。

這一任務由Anthropic的訓練方法和OpenAI新成立的、充滿神秘色彩的超對齊團隊牽頭,后者致力于利用AI反饋解決對齊問題。

同時,合成數據已經成為眾多知名開源模型供應商微調Meta和Mistral模型的首選工具。

合成數據,能成為下一次技術突破的關鍵嗎?

隨著當前或下一代模型很可能已經用盡了互聯網上所有的高質量數據源,模型開發者正在尋找新的途徑來獲取所需的大規模數據,以支持模型的持續擴展。

合成數據的支持者認為,增加更多的數據有助于模型更好地解決那些長尾任務或評估問題。為了模型能夠擴大100倍,將需要大量的合成或數字化數據。

反對者則認為,我們生成的所有數據都來源于與當前SOTA模型相同的分布,因此不太可能推動技術產生新的進展。

盡管如此,開源領域仍然遠遠落后于GPT-4和GPT-4-Turbo,這意味著我們想要在開發的各個階段復制這些數據,還有很長的路要走。

開源的支持者和HuggingFace Hub 上的大多數趨勢模型都將合成數據作為一種快速行動的方式,并有能力在行業中嘗試 SOTA 語言模型背后的技術。

開源支持者和HuggingFace Hub上大多數流行模型,都將合成數據作為一種快速發展,并嘗試業內最先進SOTA語言模型的方法。

像Anthropic和OpenAI這樣的公司使用合成數據,因為這是他們在規模和能力上取得進展的唯一方式,而小模型之所以使用合成數據,是因為相同規模的人類數據的成本要高出數千倍。

在這種二分法中,雖然方法看起來相似,但大公司會在創建數據集(預訓練規模的合成數據)上投入超過1000萬美元的推理計算成本,而開源競爭者可能只需要花費大約10美元。

盡管開源和閉源這兩個社區追求的目標截然不同,合成數據卻同時為他們雙方提供了支持。

合成數據可以讓模型在訓練中能多次看到某些不常見的數據點,從而使模型的魯棒性得到提升。

通過投喂大量數據,模型在小眾事實、語言和任務的處理能力也都將顯著提高。

Anthropic的CAI技術與合成數據的復雜性

關于Anthropic大量使用合成數據的傳言眾所周知,這種做法顯著提升了他們的模型魯棒性。

盡管Meta的Llama 2聊天機器人因基于隱藏的觸發詞列表而做出荒謬的拒絕而受到批評,但Anthropic的模型在拒絕不了解的問題時表現出了更加合理的判斷,值得我們給予肯定。

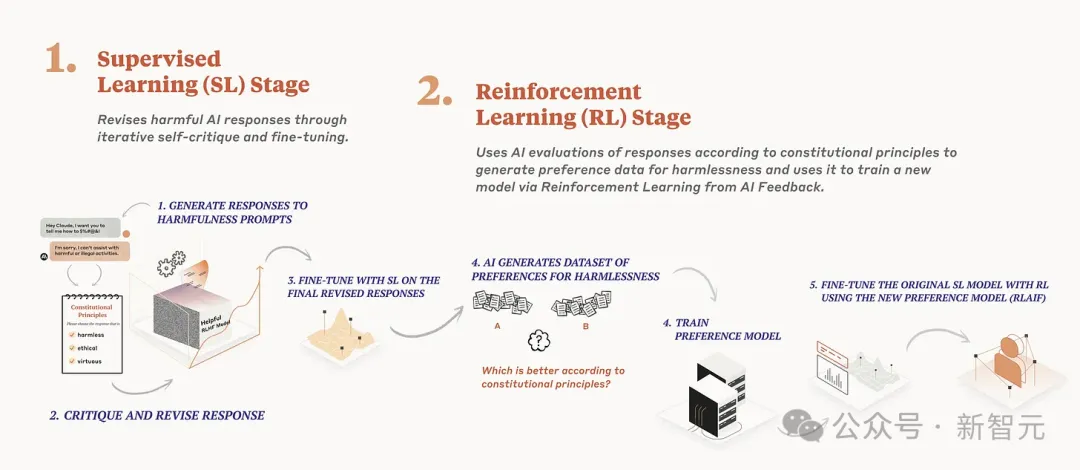

Anthropic在其Claude系列模型中廣泛采用的憲法AI(Constitutional AI, CAI)技術,是迄今為止已知最大規模的合成數據應用實例。

具體來說,憲法AI通過兩種方式利用合成數據:

1. 對指令調整數據進行評估,確保其遵循一系列原則,如「答案是否鼓勵暴力」或「答案是否真實」。模型在生成問題答案時會根據這些原則進行檢查,并隨時間優化答案。之后,模型會根據這些經過篩選的數據進行微調。

2. 利用語言模型生成成對偏好數據,評估在特定原則指導下哪個答案更為恰當(類似于某篇論文中對原則引導獎勵模型的使用)。隨后,模型通過合成數據進行正常的從人類反饋中學習(RLHF),這一過程也稱為RLAIF。

如今,RLAIF已成為業界廣泛認可的術語,很多研究人員都會通過使用GPT-4來獲取評分或選擇,這些評分或選擇可以轉化為RLHF所需的接受/拒絕樣本。

然而,由于在生成批評/對多個答案進行評分與在合成數據生成階段確定一套經驗穩定原則之間存在細微差別,CAI的復雜性和細節并未被充分理解。

在進行CAI的兩個核心步驟時,Anthropic必須確保各項原則長度一致,避免概念上的重疊,并且不能隨意更改其規模。此外,有些原則所生成的數據在數值上可能會出現不穩定。

合成指令、偏好和評論

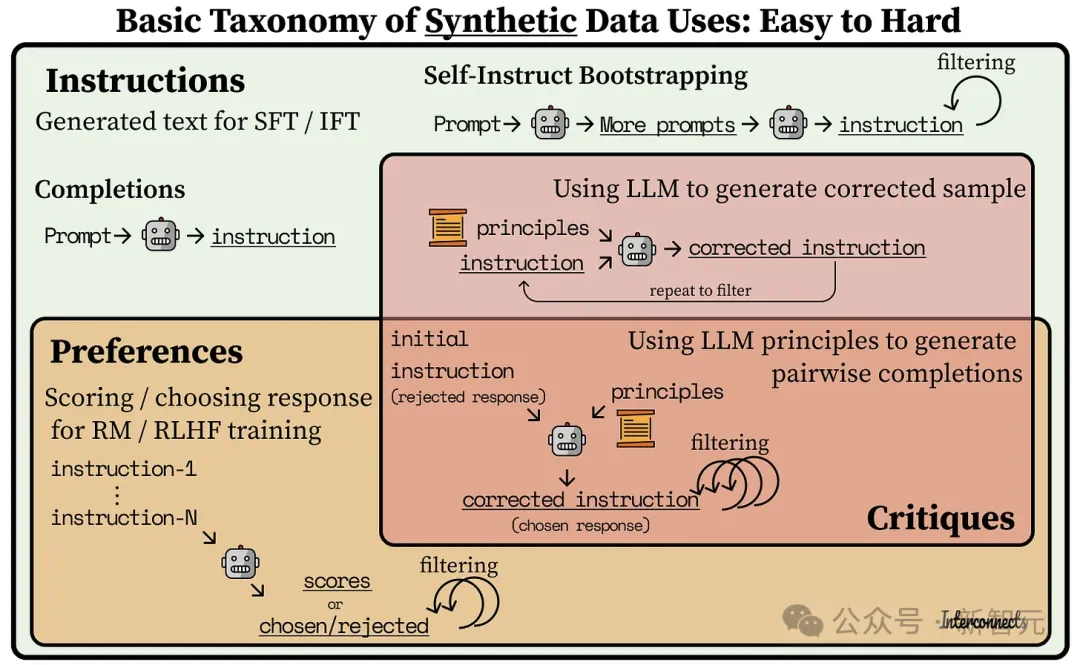

在開源模型里,我們可以清晰地看到合成數據應用方式的演進。

2023年初,模型如Alpaca和Vicuna通過使用合成指令數據對Llama模型進行監督式微調(SFT),在7-13B參數規模上實現了顯著的性能提升。

其中,很多開源指令數據集都是基于Self-Instruct方法的進步——先創建一組「種子」指令,然后利用大語言模型(LLM)生成類似的指令。目前有許多方法可以實現這一點,但都還在探索如何為數據集增加多樣性的初期階段。

與此同時,一些研究人員通過從互聯網上抓取提示,并用GPT-4將這些提示轉化為指令。但要注意,像ShareGPT這樣的提示數據集,其平均質量較低,分布也較為窄。

如今,合成偏好開始出現。這主要是通過評分或比較哪個更好來實現,類似于MT Bench和AlpacaEval的評分方法,但是會保留分數或勝負作為訓練數據。

例如,UltraFeedback就是從用戶來源(如ShareGPT)和現有的指令數據集(如FLAN)中收集提示,并生成模型的評論和完成情況。

最新的進展是通過AI評論生成的偏好或指令數據。評論是一個反復利用經過特定原則或問題微調的大語言模型(LLM)的過程。期間,增加更多的上下文信息,會大幅提高模型評論合成數據的能力,但系統設計也更加復雜。

像Meta的Shephard和KAIST的Prometheus這樣的評論模型開始出現,它們能夠對提示-生成對做出響應。但我們距離模型、意圖和知識協同作用的反饋循環還有很長的路要走

下面是一張簡單的圖表,用來展示合成指令生成是偏好上游,而偏好既是評論的上游,也是訓練難度的上游。

盡管原始的ChatGPT模型(GPT-3.5-turbo)在執行一些任務時會遇到困難,比如返回一個1到10之間的單個整數,但最新的模型輕松做到了這一點。

當開源模型能夠穩定地生成評論時,將迎來另一個轉折點。

雖然目前還不完全清楚,評論數據相比通用偏好評分對于模型的改進到底有多重要,但如果以Claude為例,它肯定是有用的。

兩個合成數據的小竅門

1. 始終使用最優的模型來生成數據:

眾所周知,模型的效果完全依賴于數據的質量。

很多研究者可能不愿意支付OpenAI的數據訓練費用,但從成本效益來看,使用SOTA模型絕對是值得的。

這甚至包括使用一些非傳統方法,例如通過網頁版的ChatGPT來生成一系列的提示詞,這是作者親自嘗試過的。

2.API會發生變化,因此需要盡可能鎖定版本:

這一建議來自于作者數百次的MT-Bench評估經驗——模型API端點的變化可能會導致研究結果出現重大偏差。

例如,某個API端點會在評分時變得非常嚴厲,并且無緣無故地給出只有1分的評價。

如果不固定API的版本,你可能會遇到一些意想不到的問題,進而無法使合成數據完全可靠或符合邏輯。

本文轉自 新智元 ,作者:新智元