【深度解析】自然語(yǔ)言生成中的“幻覺(jué)”現(xiàn)象 精華

?NLG技術(shù)在文本摘要、對(duì)話系統(tǒng)、問(wèn)答以及機(jī)器翻譯等多個(gè)領(lǐng)域扮演著至關(guān)重要的角色。伴隨著深度學(xué)習(xí)技術(shù)的飛速發(fā)展,尤其是以Transformer為基礎(chǔ)的模型如BERT、BART、GPT-2和GPT-3的問(wèn)世,NLG領(lǐng)域迎來(lái)了前所未有的繁榮。然而,在NLG模型訓(xùn)練與解碼過(guò)程中,我們不得不面對(duì)一個(gè)挑戰(zhàn)——幻覺(jué)現(xiàn)象。這種現(xiàn)象指的是模型生成的文本可能缺乏趣味性、連貫性,甚至出現(xiàn)重復(fù)且毫無(wú)意義的輸出,有時(shí)這些輸出還會(huì)與原始輸入相矛盾。這些“幻覺(jué)”問(wèn)題不僅對(duì)模型性能產(chǎn)生負(fù)面影響,還可能帶來(lái)安全和隱私方面的隱患。例如,在醫(yī)療領(lǐng)域,若生成的摘要出現(xiàn)錯(cuò)誤,可能會(huì)對(duì)患者的健康造成風(fēng)險(xiǎn);而在涉及個(gè)人信息的應(yīng)用中,若模型恢復(fù)并泄露了敏感數(shù)據(jù),則會(huì)侵犯?jìng)€(gè)人隱私。

一、定義

在心理學(xué)中,幻覺(jué)是指在沒(méi)有外部刺激的情況下,清醒的個(gè)體所經(jīng)歷的一種真實(shí)感知。類似地,NLG模型產(chǎn)生的這些不忠實(shí)或無(wú)意義的文本,也給人們帶來(lái)了類似心理幻覺(jué)的體驗(yàn)。這些文本看似流暢自然,實(shí)則內(nèi)容可能并不真實(shí),甚至荒謬至極。這種難以與真實(shí)感知區(qū)分的現(xiàn)象,往往讓人難以一眼識(shí)別。

1分類

幻覺(jué)主要分為內(nèi)在幻覺(jué)和外在幻覺(jué)。內(nèi)在幻覺(jué)指的是與源內(nèi)容相矛盾的輸出,例如在抽象摘要任務(wù)中,生成的摘要“the first Ebola vaccine was approval in 2021”與源內(nèi)容“the first vaccine For Ebola was approval by FDA in 2019”相矛盾。外在幻覺(jué)則是無(wú)法從源內(nèi)容驗(yàn)證的輸出,雖然這種事實(shí)幻覺(jué)有助于回憶起額外的背景知識(shí),提高生成文本的信息量,但由于額外信息的不可驗(yàn)證性增加了風(fēng)險(xiǎn),因此在大多數(shù)文獻(xiàn)中,外在性幻覺(jué)仍然被謹(jǐn)慎對(duì)待。

2術(shù)語(yǔ)說(shuō)明

自然語(yǔ)言生成(NLG)領(lǐng)域中有兩個(gè)極易混淆的概念——“忠實(shí)性”與“事實(shí)性”,以及它們與“幻覺(jué)”現(xiàn)象的關(guān)系。

在NLG的研究與應(yīng)用中,我們經(jīng)常遇到這兩個(gè)術(shù)語(yǔ)。簡(jiǎn)而言之,“忠實(shí)性”指的是生成文本與源材料在內(nèi)容和意圖上的一致性,它是“幻覺(jué)”的對(duì)立面。而“事實(shí)性”則涉及到生成內(nèi)容的真實(shí)性,即它是否基于真實(shí)發(fā)生的事件或事實(shí)。

這兩個(gè)概念在定義上的細(xì)微差別,有時(shí)會(huì)導(dǎo)致“真實(shí)性”與“忠實(shí)性”之間的界限變得模糊。例如,Maynez等研究者[1]通過(guò)將“事實(shí)”定義為世界知識(shí),來(lái)明確區(qū)分“真實(shí)性”與“忠實(shí)性”。而Dong等研究者[2]則將來(lái)源輸入視為“事實(shí)”的基礎(chǔ),以此來(lái)判斷事實(shí)的正確性,這使得“真實(shí)性”與“忠實(shí)性”之間的區(qū)別變得不那么清晰。

在我們的討論中,我們傾向于采納Maynez等人的定義,我們認(rèn)為區(qū)分源知識(shí)和世界知識(shí)有助于我們更深入地理解這兩個(gè)概念。然而,需要注意的是,判斷文本是否忠實(shí)或存在幻覺(jué)的標(biāo)準(zhǔn)并非一成不變,它可能會(huì)根據(jù)不同的任務(wù)和應(yīng)用場(chǎng)景而有所變化。

二、NLG中導(dǎo)致幻覺(jué)的因素

視覺(jué)編碼器的輸入分辨率將會(huì)大幅提升。目前2階段多模態(tài)主流方案由CLIP視覺(jué)編碼器和大語(yǔ)言模型組成,主流開(kāi)源CLIP為的openai、open_clip、智源提供的,這些視覺(jué)編碼器的輸入一般為224*224、336*336,無(wú)法將圖像細(xì)節(jié)特征傳遞給大語(yǔ)言模型,限制了多模態(tài)大模型的發(fā)展。為了解決這個(gè)問(wèn)題,視覺(jué)編碼器輸入分辨率需要提升到2K甚至4K。

1.數(shù)據(jù)幻覺(jué)

數(shù)據(jù)產(chǎn)生幻覺(jué)的主要原因是源參考偏差,這可能源于啟發(fā)式數(shù)據(jù)收集或某些NLG任務(wù)的性質(zhì)。例如,在構(gòu)建WIKIBIO[3]數(shù)據(jù)集時(shí),目標(biāo)引用可能包含源不支持的信息,導(dǎo)致62%的首句有未在信息框中說(shuō)明的附加信息。此外,重復(fù)項(xiàng)沒(méi)有正確過(guò)濾也會(huì)導(dǎo)致模型傾向于生成記憶短語(yǔ)的重復(fù)。一些NLG任務(wù)并不總是在源輸入文本和目標(biāo)參考之間具有事實(shí)知識(shí)對(duì)齊,如開(kāi)放域?qū)υ捪到y(tǒng),這種特征會(huì)導(dǎo)致不可避免的外在幻覺(jué)。

2.訓(xùn)練與推理的幻覺(jué)

編碼器的主要功能是理解并轉(zhuǎn)化輸入文本為有意義的表示。然而,如果編碼器的理解能力存在缺陷,可能會(huì)影響其生成結(jié)果的準(zhǔn)確性。特別是當(dāng)編碼器在學(xué)習(xí)訓(xùn)練數(shù)據(jù)時(shí),錯(cuò)誤地關(guān)聯(lián)了不同部分的數(shù)據(jù),就可能導(dǎo)致與實(shí)際輸入有偏差的錯(cuò)誤輸出。

Imperfect representation learning 編碼器的主要功能是理解并轉(zhuǎn)化輸入文本為有意義的表示。然而,如果編碼器的理解能力存在缺陷,可能會(huì)影響其生成結(jié)果的準(zhǔn)確性。特別是當(dāng)編碼器在學(xué)習(xí)訓(xùn)練數(shù)據(jù)時(shí),錯(cuò)誤地關(guān)聯(lián)了不同部分的數(shù)據(jù),就可能導(dǎo)致與實(shí)際輸入有偏差的錯(cuò)誤輸出。

Erroneous decoding 解碼器在獲取編碼后的輸入并生成目標(biāo)序列時(shí),可能出現(xiàn)兩種幻覺(jué)。首先,解碼器可能關(guān)注編碼輸入源的錯(cuò)誤部分,導(dǎo)致錯(cuò)誤生成和事實(shí)混淆。其次,解碼策略的設(shè)計(jì)也可能導(dǎo)致幻覺(jué)。例如,提高生成多樣性的解碼策略如top-k采樣,與幻覺(jué)的增加呈正相關(guān)。這種策略通過(guò)從前k個(gè)樣本中抽樣,增加了生成的意外性質(zhì),從而提高了包含幻覺(jué)內(nèi)容的可能性。

Exposure Bias 訓(xùn)練和推理時(shí)間之間的解碼差異,即暴露偏差問(wèn)題,也可能成為產(chǎn)生幻覺(jué)的因素。通常,解碼器通過(guò)教師強(qiáng)制最大似然估計(jì)(MLE)訓(xùn)練進(jìn)行訓(xùn)練,鼓勵(lì)其預(yù)測(cè)基于基本事實(shí)前綴序列生成下一個(gè)token。然而,在推理生成過(guò)程中,模型以自身先前生成的歷史序列為條件生成下一個(gè)token。這種差異可能導(dǎo)致錯(cuò)誤生成的增加,尤其是在目標(biāo)序列變得更長(zhǎng)時(shí)。

Parametric knowledge bias 大型語(yǔ)料庫(kù)預(yù)訓(xùn)練模型在提高下游任務(wù)性能的同時(shí),也可能導(dǎo)致模型過(guò)度依賴參數(shù)化知識(shí),產(chǎn)生幻覺(jué)。研究發(fā)現(xiàn),這些模型更傾向于使用自身的參數(shù)知識(shí)生成輸出,而非輸入源的信息,這可能導(dǎo)致輸出中存在多余

三、衡量幻覺(jué)的指標(biāo)

近期研究指出,傳統(tǒng)的寫(xiě)作質(zhì)量評(píng)估指標(biāo)無(wú)法準(zhǔn)確量化文本中的幻覺(jué)程度。先進(jìn)的摘要系統(tǒng)如ROUGE、BLEU和METEOR在生成的摘要中,有25%的內(nèi)容存在幻覺(jué)現(xiàn)象。此外,其他NLG任務(wù)也顯示出類似問(wèn)題,傳統(tǒng)指標(biāo)與人類對(duì)幻覺(jué)的判斷相關(guān)性差。因此,研究者正在積極尋找有效的幻覺(jué)量化指標(biāo)。

1.統(tǒng)計(jì)指標(biāo)

通過(guò)利用詞匯特征(n-grams),我們可以快速評(píng)估生成文本與參考文本之間的信息重疊和矛盾。不匹配計(jì)數(shù)越高,文本的可信度越低,因此會(huì)導(dǎo)致幻覺(jué)分?jǐn)?shù)上升。傳統(tǒng)指標(biāo)如ROUGE、BLEU主要依賴目標(biāo)文本作為真實(shí)參考,而Dhingra等[4]提出的PARENT指標(biāo)則可以結(jié)合源文本和目標(biāo)文本進(jìn)行評(píng)估,使評(píng)估更為全面。此方法通過(guò)n-gram詞法蘊(yùn)涵將生成文本與源表和目標(biāo)文本進(jìn)行匹配,并結(jié)合f1分?jǐn)?shù)反映table-to-text任務(wù)的準(zhǔn)確性。為了更有效地評(píng)估,我們不能僅依賴目標(biāo)文本,因?yàn)闊o(wú)法保證輸出目標(biāo)文本包含輸入源文本中可用的完整信息集。對(duì)于NLG任務(wù),從相同輸入獲取多個(gè)可信輸出的情況很常見(jiàn),這被稱為一對(duì)多映射。但全面評(píng)估所有可能的輸出是不現(xiàn)實(shí)的。因此,許多工作選擇依賴源文本作為唯一參考來(lái)簡(jiǎn)化評(píng)估過(guò)程。這些工作的指標(biāo)主要關(guān)注輸入源引用的信息,以測(cè)量幻覺(jué),尤其是內(nèi)在幻覺(jué)。例如,Wang[5]等提出的PARENT-T,只使用表格內(nèi)容作為參考來(lái)簡(jiǎn)化PARENT。雖然詞法匹配是一種簡(jiǎn)單而有效的評(píng)估方法,但它只能處理詞法信息,無(wú)法處理語(yǔ)法或語(yǔ)義的變化。因此,我們需要結(jié)合其他方法進(jìn)行更全面的評(píng)估。

2.基于模型指標(biāo)

基于模型的度量利用神經(jīng)模型來(lái)測(cè)量生成文本中的幻覺(jué)程度。它們被用來(lái)處理更復(fù)雜的句法甚至語(yǔ)義變化。基于模型的度量理解源和生成的文本,并檢測(cè)知識(shí)/內(nèi)容的不匹配。然而,神經(jīng)模型可能會(huì)受到誤差的影響,這些誤差可能會(huì)傳播并對(duì)幻覺(jué)的準(zhǔn)確量化產(chǎn)生不利影響。

Information Extraction (IE)-based 基于IE的度量使用IE模型以更簡(jiǎn)單的關(guān)系元組格式(例如,主題、關(guān)系、對(duì)象)表示知識(shí),然后根據(jù)從源/引用中提取的關(guān)系元組進(jìn)行驗(yàn)證。在這里,IE模型識(shí)別并提取需要驗(yàn)證的“事實(shí)”。通過(guò)這種方式,無(wú)信息的單詞(例如,停止語(yǔ)、連詞等)不包括在驗(yàn)證步驟中。

QA-based 這種方法測(cè)量生成和源引用之間的知識(shí)重疊。它基于直覺(jué),即如果生成的結(jié)果與源參考事實(shí)一致,將從同一個(gè)問(wèn)題生成類似的答案。它已經(jīng)被用于評(píng)估許多任務(wù)中的幻覺(jué),比如總結(jié)、對(duì)話和數(shù)據(jù)文本生成。

基于QA的衡量生成文本忠實(shí)度的指標(biāo)由三部分組成:首先,給定生成的文本,問(wèn)題生成(QG)模型生成一組問(wèn)答對(duì)。其次,問(wèn)答 (QA) 模型在給定真實(shí)源文本作為參考(包含知識(shí))的情況下回答生成的問(wèn)題。最后,基于相應(yīng)答案的相似性來(lái)計(jì)算幻覺(jué)得分。與基于IE的度量類似,這種方法的局限性在于可能從QG模型或QA模型產(chǎn)生和傳播的潛在錯(cuò)誤。

Natural Language Inference (NLI) Metrics 在早期的幻覺(jué)檢測(cè)任務(wù)中,標(biāo)記數(shù)據(jù)集較少。作為替代方案,許多工作使用NLI數(shù)據(jù)集處理幻覺(jué)問(wèn)題。NLI任務(wù)給定前提下,確定“假設(shè)”是否為真(蘊(yùn)含)、假(矛盾)或未確定(中性)。基于NLI的指標(biāo)將幻覺(jué)/忠實(shí)度得分定義為源與生成文本之間的隱含概率。與token匹配等方法相比,基于NLI的方法對(duì)詞匯變異性更具魯棒性。然而,現(xiàn)成的NLI模型往往不能很好地轉(zhuǎn)移到抽象摘要任務(wù)中。因此,有一系列研究來(lái)改進(jìn)和擴(kuò)展 NLI 范式,專門(mén)用于幻覺(jué)評(píng)估。此外,Goyal和Durrett[6]指出句子級(jí)隱含模型的局限性,提出依賴級(jí)蘊(yùn)涵以更細(xì)粒度地識(shí)別事實(shí)不一致性。

Faithfulness Classification Metrics 為了改進(jìn)基于NLI的指標(biāo),研究者構(gòu)建了特定于任務(wù)的數(shù)據(jù)集。Liu等人和Zhou等人在訓(xùn)練實(shí)例中自動(dòng)插入幻覺(jué)構(gòu)建句法數(shù)據(jù)。Santhanam等人和Honovich等人為對(duì)話響應(yīng)中的忠實(shí)度分類構(gòu)建新語(yǔ)料庫(kù),手動(dòng)注釋W(xué)izard-of-Wikipedia數(shù)據(jù)集。這些特定于忠實(shí)度的數(shù)據(jù)集可能比NLI數(shù)據(jù)集更好,因?yàn)镹LI數(shù)據(jù)集的蘊(yùn)涵或中性標(biāo)簽與忠實(shí)度并不等同。例如,“普京是美國(guó)總統(tǒng)”這個(gè)假設(shè)可以被認(rèn)為是中立于“普京是總統(tǒng)”這個(gè)前提的,也可以被認(rèn)為是由“普京是總統(tǒng)”這個(gè)前提衍生出來(lái)的。然而,從忠實(shí)度的角度來(lái)看,假設(shè)包含了不支持的信息“美國(guó)”,這被認(rèn)為是幻覺(jué)。

LM-based Metrics 這些指標(biāo)利用兩種語(yǔ)言模型(LM)來(lái)確定是否支持每個(gè)token:無(wú)條件LM僅在數(shù)據(jù)集中的目標(biāo)(真實(shí)引用)上進(jìn)行訓(xùn)練,而條件語(yǔ)言模型LM同時(shí)在源數(shù)據(jù)和目標(biāo)數(shù)據(jù)上進(jìn)行訓(xùn)練。如果在強(qiáng)制路徑解碼過(guò)程中,無(wú)條件LM的損失小于條件LM,我們將生成的token分類為幻覺(jué)。產(chǎn)生幻覺(jué)的token與目標(biāo)token總數(shù)的比值可以反映幻覺(jué)的程度。

3.人工評(píng)估

當(dāng)前,幻覺(jué)自動(dòng)評(píng)估在NLG中仍存在挑戰(zhàn)和不完善,因此人工評(píng)估仍是主要方法。人類評(píng)估主要包括評(píng)分和比較兩種形式。評(píng)估術(shù)語(yǔ)包括忠實(shí)、事實(shí)一致性、保真度等,用于判斷生成文本與源輸入是否一致。Chen等和Nie等[7]分別使用更細(xì)粒度的指標(biāo)進(jìn)行內(nèi)在和外在幻覺(jué)評(píng)估。此外,還有廣泛使用的指標(biāo)如正確性、準(zhǔn)確性和信息性。

四、幻覺(jué)緩解方法

根據(jù)幻覺(jué)的兩個(gè)主要因素,常見(jiàn)的緩解方法可分為兩類:數(shù)據(jù)相關(guān)方法和建模與推理方法。

1.數(shù)據(jù)相關(guān)

Building a Faithful Dataset 為避免數(shù)據(jù)噪音引發(fā)的錯(cuò)覺(jué),手動(dòng)構(gòu)建忠實(shí)的數(shù)據(jù)集是一種有效方式。方法包括從頭開(kāi)始編寫(xiě)干凈目標(biāo)或重寫(xiě)網(wǎng)絡(luò)真實(shí)句子。修訂策略分為三步:刪除不支持源的短語(yǔ)、解決共同引用和刪除依賴語(yǔ)境的短語(yǔ)以及句法修飾使句子流暢。此外,有研究利用模型生成數(shù)據(jù)并標(biāo)記幻覺(jué),雖然主要用于診斷評(píng)估,但也可構(gòu)建忠實(shí)數(shù)據(jù)集。

Cleaning Data Automatically 為了緩解語(yǔ)義噪聲問(wèn)題,一種方法是從平行語(yǔ)料庫(kù)中找到與輸入無(wú)關(guān)或矛盾的信息,然后對(duì)數(shù)據(jù)進(jìn)行過(guò)濾或校正。這種方法適用于低或中等噪聲水平的情況。另外,一些工作已經(jīng)在實(shí)例級(jí)別處理了幻覺(jué)問(wèn)題,方法是使用每個(gè)源引用對(duì)的分?jǐn)?shù)并過(guò)濾掉產(chǎn)生幻覺(jué)的引用對(duì)。實(shí)例級(jí)分?jǐn)?shù)可能導(dǎo)致信號(hào)丟失,因?yàn)閱卧~級(jí)別存在分歧。其他工作根據(jù)參考文獻(xiàn)校正配對(duì)訓(xùn)練樣本,特別是輸入數(shù)據(jù),增強(qiáng)輸入和輸出之間的語(yǔ)義一致性。這種方法適用于數(shù)據(jù)到文本的任務(wù),因?yàn)榻Y(jié)構(gòu)化數(shù)據(jù)比話語(yǔ)更容易校正。

Information Augmentation 通過(guò)使用外部信息擴(kuò)充輸入,可以獲得對(duì)源的更好表示。外部知識(shí)、顯式對(duì)齊、額外的訓(xùn)練數(shù)據(jù)等可以增加源和目標(biāo)之間的相關(guān)性,并幫助模型學(xué)習(xí)更好的任務(wù)相關(guān)特征。因此,更好的語(yǔ)義理解有助于緩解與源問(wèn)題的分歧。增強(qiáng)信息的示例包括實(shí)體信息、關(guān)系三元組、預(yù)執(zhí)行運(yùn)算結(jié)果、合成數(shù)據(jù)、檢索到的外部知識(shí)和類似訓(xùn)練樣本。這些方法加強(qiáng)了輸入和輸出之間的一致性,但帶來(lái)了挑戰(zhàn),如原始來(lái)源和增強(qiáng)信息之間的差距、歧義話語(yǔ)和結(jié)構(gòu)化數(shù)據(jù)的語(yǔ)義差距以及結(jié)構(gòu)化知識(shí)圖和自然語(yǔ)言之間的格式差異。

2.建模和推理方法

架構(gòu)

Encoder編碼器學(xué)習(xí)將輸入文本轉(zhuǎn)化為固定長(zhǎng)度的向量表示,但當(dāng)模型對(duì)輸入缺乏語(yǔ)義解釋時(shí),可能會(huì)出現(xiàn)幻覺(jué)。為解決這個(gè)問(wèn)題,一些研究者修改了編碼器架構(gòu),使其與輸入更兼容,并學(xué)習(xí)更好的表示。例如,Huang等人和Cao[8]等人提出了一種雙編碼器,由順序文檔編碼器和結(jié)構(gòu)化圖編碼器組成,以處理額外的知識(shí)。

Attention 神經(jīng)網(wǎng)絡(luò)中的注意力機(jī)制被用于選擇性關(guān)注序列的部分內(nèi)容,忽略其他依賴關(guān)系。Aralikate等[9]通過(guò)源條件偏置引入短路來(lái)鼓勵(lì)生成器關(guān)注來(lái)源。Krishna等[10]采用稀疏注意力以改善模型的長(zhǎng)期依賴性,減輕答案中的幻覺(jué)。Wu等[11]則通過(guò)誘導(dǎo)注意力注入預(yù)先建立的結(jié)構(gòu)信息來(lái)避免幻覺(jué),消除無(wú)信息的注意力聯(lián)系。

Decoder 解碼器是自然語(yǔ)言處理中的關(guān)鍵組件,負(fù)責(zé)將輸入轉(zhuǎn)化為輸出。為減輕幻覺(jué)問(wèn)題,研究者提出了多種解碼器結(jié)構(gòu),如多分支解碼器、不確定性感知解碼器和雙解碼器等。這些解碼器通過(guò)識(shí)別token間的隱含差異和依賴性或受顯式約束的限制,提高了生成忠實(shí)token的可能性,降低了產(chǎn)生幻覺(jué)的風(fēng)險(xiǎn)。然而,過(guò)度的約束可能會(huì)影響文本的流暢性和多樣性,因此需要在保持效果和提高流暢性之間找到平衡。

訓(xùn)練

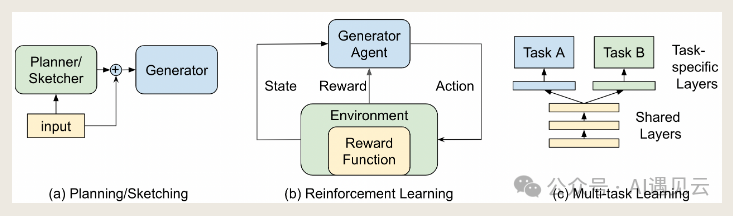

Planning/Sketching 規(guī)劃是控制和限制模型生成內(nèi)容的有效方法,可作為兩步生成器的一部分或注入到端到端模型中。與規(guī)劃類似的草圖也可用于處理幻覺(jué)問(wèn)題,但框架被視為最終文本的一部分。這種方法在提供更多可控性的同時(shí),需要在忠實(shí)性和多樣性之間找到平衡。

Reinforcement Learning (RL) Ranzato等人發(fā)現(xiàn),詞級(jí)最大似然訓(xùn)練可能導(dǎo)致暴露偏差問(wèn)題。為解決此問(wèn)題,一些研究采用強(qiáng)化學(xué)習(xí)(RL)并設(shè)計(jì)不同的獎(jiǎng)勵(lì)機(jī)制來(lái)優(yōu)化模型。Li等人提出槽一致性獎(jiǎng)勵(lì),通過(guò)減少模板中丟失或放錯(cuò)槽值的幻覺(jué)現(xiàn)象來(lái)提高生成質(zhì)量。Mesgar等人則使用NLI模型獲得人格一致性子獎(jiǎng)勵(lì)以減少對(duì)個(gè)人事實(shí)的幻覺(jué)。Huang等使用ROUGE和多項(xiàng)選擇填空分?jǐn)?shù)的組合作為獎(jiǎng)勵(lì)函數(shù),以提高總結(jié)輸出的可信度。

Multi-task Learning 多任務(wù)學(xué)習(xí)是一種訓(xùn)練模型同時(shí)處理多個(gè)NLG任務(wù)的方法,旨在學(xué)習(xí)任務(wù)的共性以減少幻覺(jué)問(wèn)題。這種問(wèn)題源于模型對(duì)單一數(shù)據(jù)集的依賴,導(dǎo)致無(wú)法準(zhǔn)確學(xué)習(xí)實(shí)際任務(wù)特征。通過(guò)添加適當(dāng)?shù)母郊尤蝿?wù),如單詞對(duì)齊或蘊(yùn)涵任務(wù),可以提高模型的性能。多任務(wù)學(xué)習(xí)具有提高數(shù)據(jù)效率、減少過(guò)擬合和快速學(xué)習(xí)等優(yōu)點(diǎn),但選擇合適的任務(wù)進(jìn)行聯(lián)合學(xué)習(xí)是關(guān)鍵,同時(shí)也帶來(lái)了設(shè)計(jì)和優(yōu)化的挑戰(zhàn)。

Controllable Generation 當(dāng)前工作將幻覺(jué)級(jí)別視為可控屬性,通過(guò)控制生成技術(shù)如重新采樣、手動(dòng)或自動(dòng)提供控制代碼來(lái)提高可信度。這種方法可能需要帶注釋的數(shù)據(jù)集進(jìn)行訓(xùn)練。考慮到幻覺(jué)可能帶來(lái)好處,可以調(diào)整可控方法以滿足不同應(yīng)用需求。此外,正則化和損失重建等通用訓(xùn)練方法也被提出以解決幻覺(jué)問(wèn)題。

后處理

后處理方法能有效糾正輸出中的幻覺(jué),尤其在有噪聲的數(shù)據(jù)集上表現(xiàn)出優(yōu)勢(shì)。這種方法通過(guò)先利用表現(xiàn)優(yōu)秀的模型生成結(jié)果,再進(jìn)行提煉和校正,盡管可能產(chǎn)生不符合語(yǔ)法的文本,但允許研究人員用少量訓(xùn)練數(shù)據(jù)專門(mén)提高準(zhǔn)確性。

五、未來(lái)方向

在自然語(yǔ)言生成(NLG)及其下游任務(wù)的研究中,幻覺(jué)問(wèn)題一直是學(xué)術(shù)界關(guān)注的焦點(diǎn)。我們已經(jīng)探討了許多衡量標(biāo)準(zhǔn)和緩解方法,旨在推動(dòng)這些領(lǐng)域的發(fā)展。從更廣泛的角度來(lái)看,我們覺(jué)得下述指標(biāo)設(shè)計(jì)和緩解方法方面的仍然存在著一些潛在的技術(shù)方向。

1.指標(biāo)設(shè)計(jì)

細(xì)粒度度量(Fine-grained Metrics):為了精確識(shí)別幻覺(jué)子串,我們需要開(kāi)發(fā)更細(xì)粒度的度量標(biāo)準(zhǔn)。現(xiàn)有的一些指標(biāo),如基于問(wèn)答的指標(biāo),無(wú)法精確定位單個(gè)幻覺(jué)子串,因此亟需改進(jìn)。細(xì)粒度度量能夠提供更深入的見(jiàn)解,幫助研究人員區(qū)分內(nèi)在和外在幻覺(jué)。未來(lái)的研究可以探索自動(dòng)分類方法,以進(jìn)一步提高度量的準(zhǔn)確性。

事實(shí)核查(Fact-Checking):對(duì)外在幻覺(jué)進(jìn)行事實(shí)驗(yàn)證是一個(gè)耗時(shí)且復(fù)雜的過(guò)程。利用自動(dòng)事實(shí)核查系統(tǒng)來(lái)驗(yàn)證外在幻覺(jué),是未來(lái)的一個(gè)重要研究方向。在選擇證據(jù)的子任務(wù)中,如何從世界知識(shí)中檢索有效證據(jù)是一個(gè)關(guān)鍵問(wèn)題。盡管有些研究嘗試將整個(gè)網(wǎng)絡(luò)作為知識(shí)來(lái)源,但確保網(wǎng)絡(luò)信息的可信度仍然是一個(gè)挑戰(zhàn)。未來(lái)研究應(yīng)著重解決這些問(wèn)題,以便更好地根據(jù)世界知識(shí)進(jìn)行證據(jù)選擇。

泛化能力(Generalization):研究不同任務(wù)的源文本和輸出文本之間的關(guān)系,探索評(píng)估幻覺(jué)的通用指標(biāo),是一個(gè)值得深入的方向。開(kāi)發(fā)具有跨領(lǐng)域魯棒性的任務(wù)無(wú)關(guān)度量標(biāo)準(zhǔn),有助于建立統(tǒng)一的評(píng)估基準(zhǔn)。構(gòu)建開(kāi)源平臺(tái),以便協(xié)作和標(biāo)準(zhǔn)化NLG任務(wù)的評(píng)估指標(biāo),也具有極其重要的意義。

融入人類認(rèn)知視角(Incorporation of Human Cognitive Perspective):優(yōu)秀的自動(dòng)度量標(biāo)準(zhǔn)應(yīng)當(dāng)與人類評(píng)估緊密相關(guān)。從人類認(rèn)知的角度設(shè)計(jì)新指標(biāo),例如模擬人類識(shí)別重要信息并過(guò)濾其余信息的能力,將有助于提高自動(dòng)檢測(cè)與人類判斷的相關(guān)性,從而進(jìn)一步減輕幻覺(jué)并改進(jìn)NLG系統(tǒng)。

2.緩解方法

數(shù)據(jù)預(yù)處理(Data Preprocessing):數(shù)據(jù)預(yù)處理是NLG中的關(guān)鍵環(huán)節(jié),但目前尚無(wú)適用于所有任務(wù)的通用方法。由于不同任務(wù)之間存在數(shù)據(jù)格式的差異,數(shù)據(jù)處理方法的選擇和應(yīng)用仍面臨挑戰(zhàn)。開(kāi)發(fā)通用且穩(wěn)健的數(shù)據(jù)預(yù)處理方法,將有助于減輕NLG中的幻覺(jué)問(wèn)題。

數(shù)字建模(Digital Modeling):對(duì)于數(shù)字幻覺(jué)問(wèn)題,數(shù)字的正確性對(duì)讀者至關(guān)重要。探索明確地對(duì)數(shù)字建模的方法,以減輕幻覺(jué),是一個(gè)值得研究的方向。

區(qū)分內(nèi)在和外在幻覺(jué)(Differentiating Intrinsic and Extrinsic Hallucinations):研究?jī)?nèi)在和外在幻覺(jué)的區(qū)別,并探索針對(duì)這兩種幻覺(jué)的不同緩解方法,是一個(gè)重要的研究領(lǐng)域。

長(zhǎng)文本生成(Long Text Generation):在長(zhǎng)文本生成任務(wù)中,減少自我矛盾是一個(gè)關(guān)鍵方向。引入推理能力,以提高生成文本的一致性和連貫性,是一個(gè)有趣的未來(lái)研究方向。

可控性(Controllability):模型應(yīng)具備控制幻覺(jué)程度的能力,并在忠實(shí)性和多樣性之間找到平衡。可控性是未來(lái)研究中的一個(gè)重要方面。

感謝您的閱讀,我們期待在未來(lái)的文章中繼續(xù)與您分享NLG領(lǐng)域的最新進(jìn)展。

參考文獻(xiàn)

[1] MAYNEZ J, NARAYAN S, BOHNET B, et al. On Faithfulness and Factuality in Abstractive Summarization[C/OL]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, Online. 2020. http://dx.doi.org/10.18653/v1/2020.acl-main.173. DOI:10.18653/v1/2020.acl-main.173

[2] DONG Y, WANG S, GAN Z, et al. Multi-Fact Correction in Abstractive Text Summarization[C/OL]//Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), Online. 2020. http://dx.doi.org/10.18653/v1/2020.emnlp-main.749. DOI:10.18653/v1/2020.emnlp-main.749.

[3] LEBRET R, GRANGIER D, AULI M. Neural Text Generation from Structured Data with Application to the Biography Domain[C/OL]//Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing, Austin, Texas. 2016. http://dx.doi.org/10.18653/v1/d16-1128. DOI:10.18653/v1/d16-1128.

[4] DHINGRA B, FARUQUI M, PARIKH AnkurP, et al. Handling Divergent Reference Texts when Evaluating Table-to-Text Generation[J]. Cornell University - arXiv,Cornell University - arXiv, 2019.

[5] WANG Z, WANG X, AN B, et al. Towards Faithful Neural Table-to-Text Generation with Content-Matching Constraints[C/OL]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, Online. 2020. http://dx.doi.org/10.18653/v1/2020.acl-main.101. DOI:10.18653/v1/2020.acl-main.101.

[6] GOYAL T, DURRETT G. Evaluating Factuality in Generation with Dependency-level Entailment.[J]. Cornell University - arXiv,Cornell University - arXiv, 2020.

[7] NIE F, YAO J G, WANG J, et al. A Simple Recipe towards Reducing Hallucination in Neural Surface Realisation[C/OL]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, Florence, Italy. 2019. http://dx.doi.org/10.18653/v1/p19-1256. DOI:10.18653/v1/p19-1256.

[8] CAO Z, WEI F, LI W, et al. Faithful to the Original: Fact Aware Neural Abstractive Summarization[J/OL]. Proceedings of the AAAI Conference on Artificial Intelligence, 2022. http://dx.doi.org/10.1609/aaai.v32i1.11912. DOI:10.1609/aaai.v32i1.11912.

[9] ARALIKATTE R, NARAYAN S, MAYNEZ J, et al. Focus Attention: Promoting Faithfulness and Diversity in Summarization[C/OL]//Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers), Online. 2021. http://dx.doi.org/10.18653/v1/2021.acl-long.474. DOI:10.18653/v1/2021.acl-long.474.

[10] KRISHNA K, ROY A, IYYER M. Hurdles to Progress in Long-form Question Answering[C/OL]//Proceedings of the 2021 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Online. 2021. http://dx.doi.org/10.18653/v1/2021.naacl-main.393. DOI:10.18653/v1/2021.naacl-main.393.

[11] WU Z, GALLEY M, BROCKETT C, et al. A Controllable Model of Grounded Response Generation[J/OL]. Proceedings of the AAAI Conference on Artificial Intelligence, 2022: 14085-14093. http://dx.doi.org/10.1609/aaai.v35i16.17658. DOI:10.1609/aaai.v35i16.17658.

本文轉(zhuǎn)載自 ??AI遇見(jiàn)云??,作者: 錢(qián)博文