開源版o1!中國大模型讓國外陷入瘋狂,成本猛降90% 精華

前不久,國產大模型平臺DeepSeek開源的v3模型,受到了Andrej Karpathy等業內大神的盛贊,在算法、數據等方面非常棒。

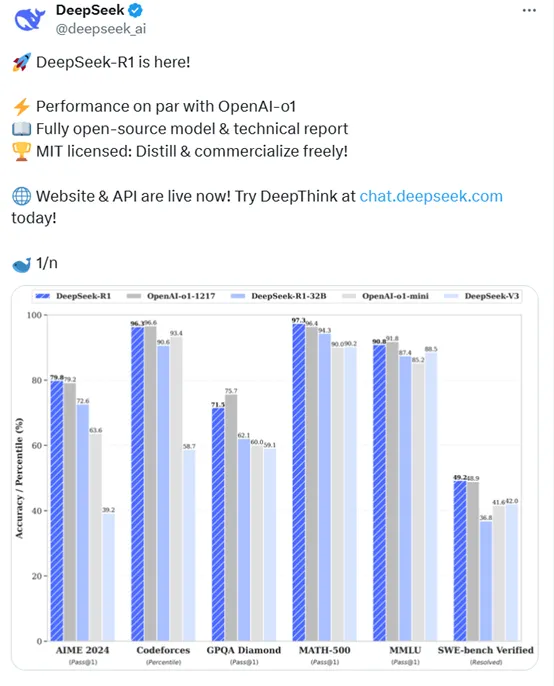

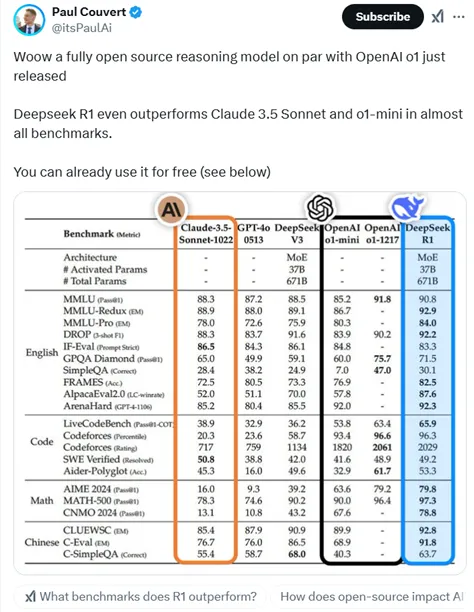

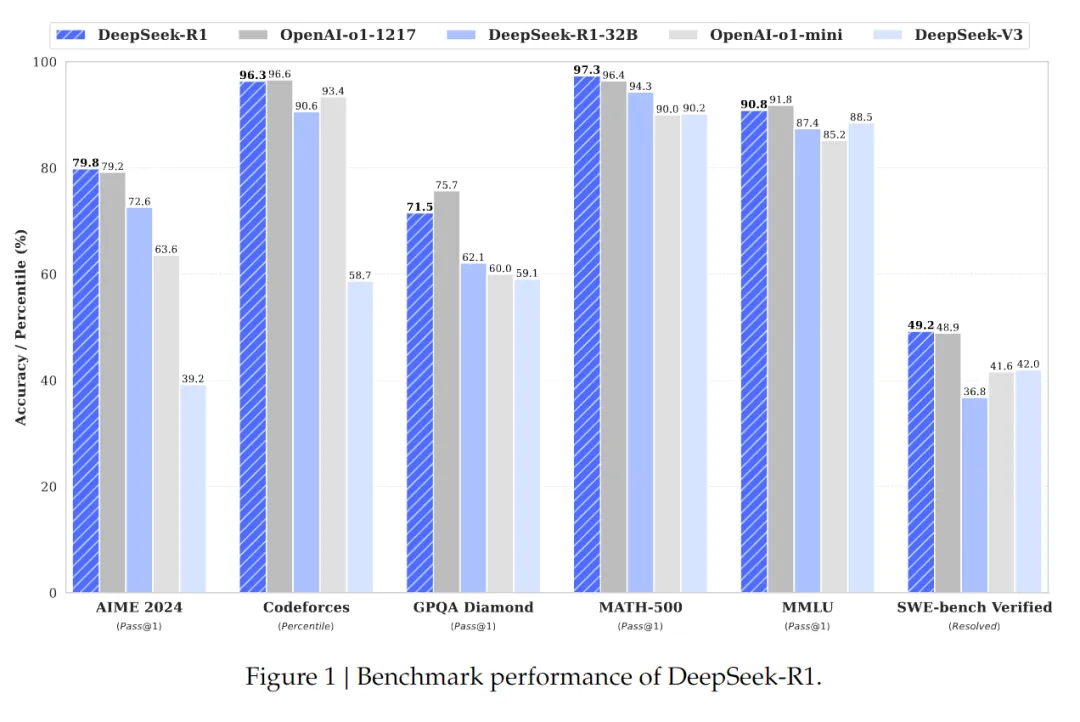

現在,DeepSeek又重磅開源了R1模型。根據其公布測試數據顯示,在美國AIME 2024測試中R1拿下79.8分,超過了OpenAI的o1模型的79.2分;在MATH-500,R1為97.3分,同樣超過了o1的96.4分;

在SWE-bench Verified,R1為49.2分再次超過了o1的48.9分。而在代碼測試Codeforces中,R1僅比o1模型低0.3分;MMLU低1分;GPQA低4.2分,整體性能與o1模型相當。

但價格方面o1模型每100萬tokens的輸入是15美元,R1是0.14美元,比GPT-4o-mini價格還要低(這個是目前OpenAI最便宜的主打模型之一)成本猛降90%。

輸出價格更是低的離譜,o1每100萬tokens輸出是60美元,R1只有2.19美元,降低了27倍左右。

開源地址:https://huggingface.co/deepseek-ai/R1

API:https://api-docs.deepseek.com/guides/reasoning_model

在DeepSeek宣布開源R1后,國外網友徹底瘋狂了,R1如此強的性能卻這么便宜,對中國開源大模型飛速發展感到不可思議,已經超過了Meta、Mistral等老牌開源平臺。

絕對瘋狂。與o1模型性能相當且開源。還可以用來蒸餾創建你自己的模型。

講真,有了這個超強模型之后,OpenAI每月的200美元訂閱就沒啥優勢了。

伙計們干的不錯,這真的很令人印象深刻,價格也很便宜。

恭喜,各方面都很出色,尤其是價格。

感謝你們把這一切開源!作為一個新學習者,這激勵我在這個領域探索更多。DeepSeek模型都非常令人印象深刻。祝賀你們!

開源界的英雄!

這個看起來很棒。你們為開源項目做出了杰出的工作。

開源、遵循 MIT 許可協議,且可與 OpenAI 相媲美?這正是我們喜聞樂見的創新。

我正在用它來編寫代碼,最佳大模型之一,持續改進 :)

R1就是o1,但是免費的。感謝deepseek團隊的研究人員。

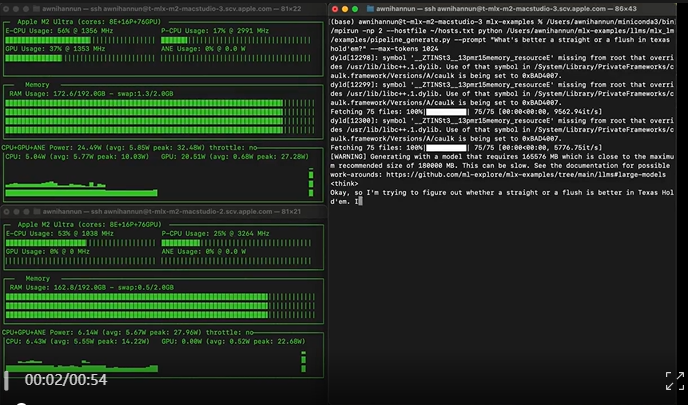

蘋果的機器學習研究員Awni Hannun已經測試了R1模型,僅在蘋果M2 Ultra上就能運行,推理效率還相當的快。

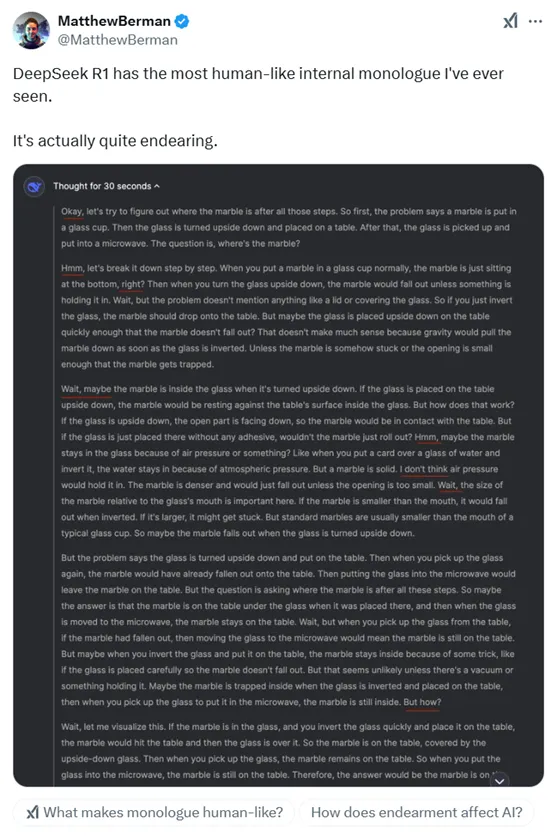

也有人體驗了DeepSeek R1后表示,這是最像人類內心獨白的模型,實際上相當不錯。

FileDash.ai創始人Paul Couvert也轉發了R1開源的消息,并認為比Claude 3.5 Sonnet 和 o1-mini 表現更出色,性能與o1幾乎差不多。

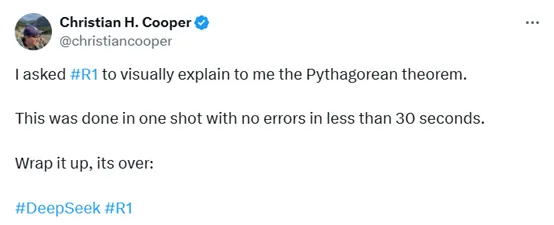

也有網友用R1,簡單、直觀的來解釋勾股定理。不到30秒,一次就完美解決,相當滿意。

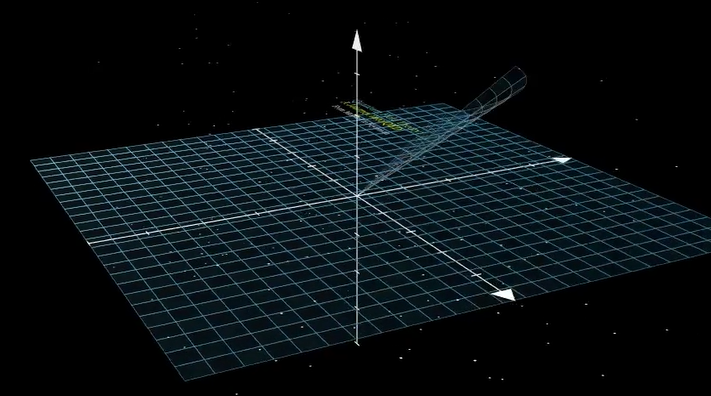

接著這位老哥又給R1加大了強度,要求其解釋量子電動力學的工作原理,以及如何將其可視化呈現。

只用了9分鐘,依然完美解決了這個問題。

最后這位老哥徹底服氣了,感慨道,我看不到任何錯誤。它一次就修正了旋轉。思考大約用了3分鐘,渲染花了45分鐘。所以,中國開源的大模型,可以勝過我見過的任何博士。

R1簡單介紹

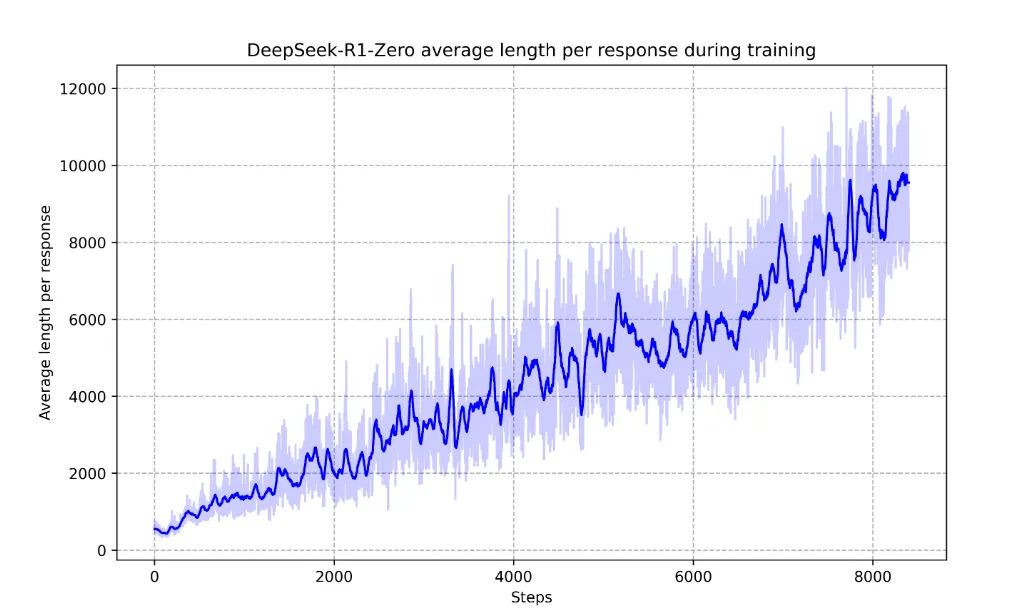

其實DeepSeek最開始開發的是R1-Zero模型,通過純強化學習訓練,不依賴于任何監督學習數據。該模型以DeepSeek-V3-Base為基礎,采用了GRPO算法進行訓練,通過采樣一組輸出并計算其相對優勢,從而優化模型的策略,避免了傳統強化學習中需要與策略模型同規模的評估模型,大大降低了訓練成本。

在訓練過程中,R1-Zero展現出了一系列強大的推理行為,例如,自我驗證、反思和生成長推理鏈等。這些行為并非人為植入,而是模型在強化學習過程中自然涌現的結果。

例如,在AIME 2024數學競賽中,R1-Zero的Pass@1得分從初始的15.6%提升至71.0%,通過多數投票進一步提升至86.7%,與OpenAI-o1-0912模型相當。這一結果證明了純強化學習在提升模型推理能力方面的巨大潛力。

但是R1-Zero也存在一些問題,如可讀性差和語言混用等。所以,DeepSeek又開發出了R1模型。

R1在R1-Zero的基礎上進行了改進,引入了冷啟動數據和多階段訓練流程,以提升模型的推理能力和可讀性。

冷啟動與多階段訓練

冷啟動階段是R1訓練流程的起點,也是整個訓練策略中最重要的一環。與R1-Zero直接從基礎模型開始強化學習不同,R1引入了少量高質量的長CoT數據作為冷啟動數據,為模型提供一個更加穩定和優化的起點,從而在后續的強化學習過程中更好地發展推理能力。

冷啟動數據的一個關鍵特點是其對可讀性的優化。與R1-Zero生成的推理過程相比,冷啟動數據更加注重語言的清晰性和邏輯性。例如,團隊設計了一種特定的輸出格式,即在每個回答的末尾添加一個總結,并用特殊標記將推理過程和總結區分開來。

這種格式不僅使模型的輸出更加易于理解,也為后續的強化學習提供了一個明確的結構框架。

在冷啟動階段之后, R1進入了一個包含多個階段的復雜訓練流程。這一流程的設計目標是通過逐步優化和調整,使模型在推理能力上達到更高的水平,同時在其他任務上也表現出色。

第一階段:推理導向的強化學習

在冷啟動數據的基礎上,R1進入了一個以推理為導向的強化學習階段。這一階段的核心目標是通過大規模的強化學習,進一步提升模型在數學、編程、科學和邏輯推理等任務上的表現。這一階段的訓練與R1-Zero的強化學習過程類似,但有一個重要的區別:R1在訓練過程中引入了語言一致性獎勵。

語言一致性獎勵的引入是為了解決模型在生成推理鏈時可能出現的語言混用問題。在多語言的推理任務中,模型可能會在推理過程中混用不同語言,這不僅影響了輸出的可讀性,還可能干擾模型的推理邏輯。

為了克服這一問題,研究團隊設計了一個獎勵機制,通過計算推理鏈中目標語言的比例來優化模型的輸出。雖然這種獎勵機制在一定程度上略微降低了模型的推理性能,但它顯著提升了輸出的可讀性和一致性。

第二階段:拒絕采樣與監督微調

當推理導向的強化學習接近收斂時,R1進入了一個關鍵的階段:拒絕采樣與監督微調。這一階段的目標是通過生成新的監督學習數據,進一步優化模型在推理和其他任務上的表現。

拒絕采樣是一種從模型生成的數據中篩選出高質量樣本的方法。在這一階段,研究團隊利用當前模型的檢查點,通過拒絕采樣生成了大量的推理相關數據。這些數據不僅包括了推理任務的樣本,還涵蓋了寫作、事實問答、自我認知等其他領域的數據。通過這種方式,模型不僅在推理任務上得到了優化,還在其他任務上展現了更強的能力。

第三階段:全場景強化學習

在經過拒絕采樣和監督微調之后,R1進入了一個更為復雜的階段:全場景強化學習。這一階段的目標是通過結合推理任務的規則獎勵和一般任務的偏好獎勵,進一步優化模型的性能。

在這一階段,模型不僅需要在推理任務上表現出色,還需要在其他任務上展現出更高的有用性和安全性。研究團隊通過引入多樣化的獎勵信號和任務分布,確保模型在推理能力、有用性和安全性之間達到平衡。

例如,在推理任務中,模型繼續使用規則獎勵來優化其推理鏈的準確性和效率。而在一般任務中,模型則依賴于偏好獎勵來優化其輸出的有用性和安全性。通過這種方式,R1能夠在多個任務上展現出卓越的性能,同時保持推理能力的核心優勢。

有興趣的小伙伴可以試試這個R1模型,在國外已經爆火成為開源大模型界的頂流了。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區