大模型是能力強(qiáng)還是記憶強(qiáng)?一項(xiàng)發(fā)人深省的研究 精華

在AI領(lǐng)域,我們經(jīng)常聽到這樣的說法:"這個(gè)大模型太強(qiáng)了,連bug都能自動(dòng)修復(fù)!"但你有沒有想過,大模型修復(fù)bug的能力是真的掌握了bug修復(fù)的規(guī)律,還是簡(jiǎn)單地"記住"了訓(xùn)練數(shù)據(jù)中的bug修復(fù)案例呢?

讓我們打個(gè)比方。想象你是一個(gè)編程老師,你發(fā)現(xiàn)一個(gè)學(xué)生在期末考試中完美地解決了一個(gè)復(fù)雜的bug。不僅代碼邏輯正確,連代碼風(fēng)格、變量命名、甚至注釋都跟課本上的例子一模一樣。這時(shí)候,你會(huì)覺得這個(gè)學(xué)生真的理解了問題的本質(zhì),還是在背誦標(biāo)準(zhǔn)答案呢?

近日,來自卡內(nèi)基梅隆大學(xué)的研究人員就帶來了一項(xiàng)發(fā)人深省的研究。他們對(duì)當(dāng)前廣泛使用的程序修復(fù)數(shù)據(jù)集進(jìn)行了系統(tǒng)性分析,發(fā)現(xiàn)一些流行的大模型可能只是在"背誦"訓(xùn)練數(shù)據(jù),而不是真正理解和掌握bug修復(fù)的能力。這個(gè)發(fā)現(xiàn)不禁讓我們反思:在評(píng)估AI模型時(shí),我們是否過于樂觀了?

研究背景與意義

軟件bug的自動(dòng)修復(fù)一直是軟件工程領(lǐng)域的重要挑戰(zhàn)。隨著大語言模型的崛起,研究人員開始探索使用AI來自動(dòng)定位和修復(fù)代碼中的bug。這些研究通常會(huì)使用一些標(biāo)準(zhǔn)的bug基準(zhǔn)數(shù)據(jù)集來評(píng)估模型性能。其中,Defects4J是成立于2014年的Java bug數(shù)據(jù)集,包含了數(shù)百個(gè)真實(shí)項(xiàng)目中的bug。而BugsInPy則專注于Python項(xiàng)目的bug數(shù)據(jù)集,收錄了近500個(gè)bug案例。還有較新的SWEBench,包含了各種代碼相關(guān)任務(wù)的測(cè)試用例。

這些數(shù)據(jù)集就像是AI模型的"考試題庫",我們用它們來評(píng)判模型的bug修復(fù)能力。但問題是:如果模型在"考試"前就已經(jīng)"見過"這些題目了呢?

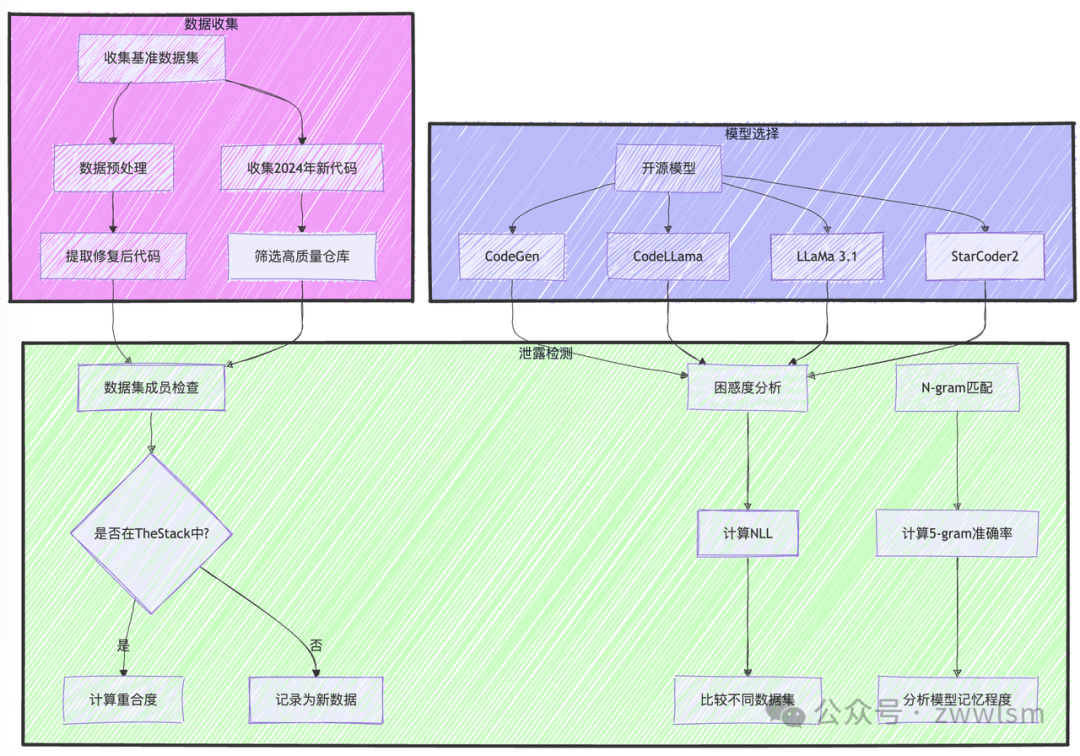

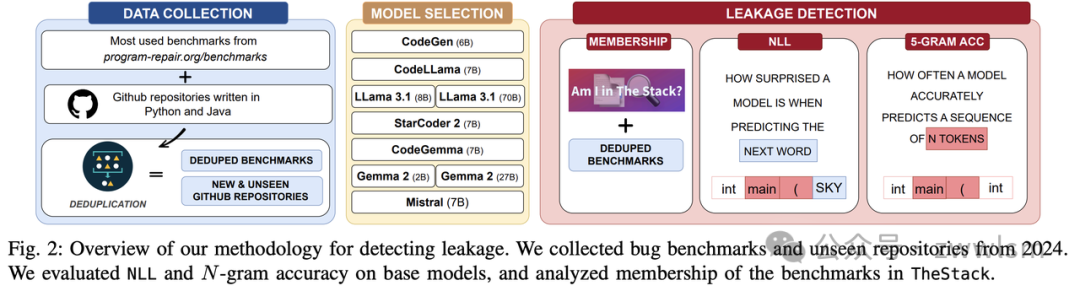

深入研究方法

研究團(tuán)隊(duì)設(shè)計(jì)了一套完整的方法論來探測(cè)數(shù)據(jù)泄露問題。

首先是成員資格檢查,通過檢查基準(zhǔn)數(shù)據(jù)集中的代碼是否出現(xiàn)在TheStack訓(xùn)練集中。

其次是困惑度分析,計(jì)算模型在預(yù)測(cè)代碼時(shí)的負(fù)對(duì)數(shù)似然值(NLL)。

最后是N-gram匹配,評(píng)估模型能否準(zhǔn)確重現(xiàn)連續(xù)的代碼片段。

讓我們通過一個(gè)具體的例子來理解這些方法。假設(shè)我們有一段來自Defects4J的代碼:

public String replaceText(String text) {

// 檢查是否找到搜索字符串

if (textIndex == -1) {

return text;

}

// 計(jì)算結(jié)果buffer的大小

int start = 0;

int increase = 0;

// 統(tǒng)計(jì)替換文本中比原文本更長(zhǎng)的元素

for (int i = 0; i < searchList.length; i++) {

if (searchList[i] == null || replacementList[i] == null) {

continue;

}

// ...后續(xù)代碼

}

}

當(dāng)讓codegen-multi模型續(xù)寫這段代碼時(shí),它不僅完美復(fù)現(xiàn)了原始實(shí)現(xiàn),連注釋都一字不差。這種表現(xiàn)看似完美,實(shí)際上可能是"完美的記憶"而非"完美的理解"。

令人深思的發(fā)現(xiàn)

研究發(fā)現(xiàn)了幾個(gè)值得注意的現(xiàn)象。我們先來看看不同模型的表現(xiàn)對(duì)比:

模型 | 訓(xùn)練數(shù)據(jù)量(T) | Defects4J NLL | 5-gram準(zhǔn)確率 | 特點(diǎn) |

codegen-multi | 0.5 | 0.15 | 82% | 強(qiáng)記憶、弱泛化 |

CodeLLama | 2.5 | 0.44 | 64% | 中等表現(xiàn) |

LLaMa 3.1 | 15.0 | 0.68 | 44% | 弱記憶、強(qiáng)泛化 |

StarCoder 2 | 3.5 | 0.58 | 51% | 均衡表現(xiàn) |

研究發(fā)現(xiàn)了訓(xùn)練數(shù)據(jù)量與記憶的反比關(guān)系。訓(xùn)練數(shù)據(jù)量較小的模型(如codegen-multi)表現(xiàn)出強(qiáng)烈的記憶特征,而訓(xùn)練數(shù)據(jù)量大的模型(如LLaMa 3.1)表現(xiàn)出更好的泛化能力。

數(shù)據(jù)集的年齡也會(huì)產(chǎn)生顯著影響。較老的數(shù)據(jù)集(如Defects4J)更容易被模型記住,而新數(shù)據(jù)集(如GitBug-Java)的測(cè)試結(jié)果更能反映模型真實(shí)能力。

至于模型大小的影響則展現(xiàn)出雙面性。更大的模型參數(shù)量會(huì)增加記憶能力,但如果配合足夠大的訓(xùn)練數(shù)據(jù),反而能減少過度記憶的現(xiàn)象。

對(duì)實(shí)踐的啟示

這項(xiàng)研究給AI應(yīng)用實(shí)踐帶來了重要啟示。在評(píng)估方法上,我們需要采用多維度的評(píng)估方案,包括組合使用新舊數(shù)據(jù)集,關(guān)注模型在未見過的代碼上的表現(xiàn),以及設(shè)計(jì)更難以通過簡(jiǎn)單記憶解決的測(cè)試案例。

在訓(xùn)練策略方面,我們應(yīng)該使用更大規(guī)模的訓(xùn)練數(shù)據(jù),注意數(shù)據(jù)的時(shí)間分布,可能還需要專門的策略來防止過度記憶現(xiàn)象的出現(xiàn)。

對(duì)于實(shí)際應(yīng)用,我們不應(yīng)過分依賴單一評(píng)估指標(biāo),要保持對(duì)模型輸出的審慎態(tài)度,并考慮使用多個(gè)不同特點(diǎn)的模型來互補(bǔ)短長(zhǎng)。

這項(xiàng)研究揭示的問題讓我們不得不思考:如何定義和衡量AI的"理解"?我們是否需要建立新的評(píng)估框架?如何區(qū)分記憶和理解?什么樣的表現(xiàn)才算真正的理解?

在數(shù)據(jù)集設(shè)計(jì)方面,我們需要思考如何構(gòu)建更難被記憶的測(cè)試集,是否應(yīng)該建立動(dòng)態(tài)更新的評(píng)估機(jī)制,以及如何設(shè)計(jì)多樣化的測(cè)試場(chǎng)景。

對(duì)于模型架構(gòu)的改進(jìn),我們需要著力增強(qiáng)模型的推理能力,降低對(duì)簡(jiǎn)單記憶的依賴,提升知識(shí)遷移的效果。

結(jié)語

這項(xiàng)研究像一面鏡子,讓我們看到了AI評(píng)估中的盲點(diǎn)。正如一個(gè)優(yōu)秀的學(xué)生不應(yīng)該靠死記硬背通過考試,一個(gè)真正強(qiáng)大的AI系統(tǒng)也應(yīng)該具備真實(shí)的理解和解決問題的能力。

在追求AI進(jìn)步的道路上,我們需要更加清醒地認(rèn)識(shí)到技術(shù)的現(xiàn)狀,設(shè)計(jì)更好的評(píng)估方法,訓(xùn)練更具實(shí)質(zhì)理解力的模型。只有這樣,AI技術(shù)才能真正地服務(wù)于軟件開發(fā),而不是成為另一個(gè)花哨但脆弱的工具。

這也提醒我們,在贊嘆AI驚人表現(xiàn)的同時(shí),要保持理性和客觀。真正的技術(shù)進(jìn)步不在于表面的數(shù)字,而在于實(shí)質(zhì)性的能力提升。期待看到更多這樣深入、嚴(yán)謹(jǐn)?shù)难芯抗ぷ鳎苿?dòng)AI向著更可靠、更有價(jià)值的方向發(fā)展。

本文轉(zhuǎn)載自 ??芝士AI吃魚??,作者: 芝士AI吃魚