【人工智能】10分鐘解讀-深入淺出大語言模型(LLM)——從ChatGPT到未來AI的演進 精華

一、前言

2022年底,OpenAI推出的聊天機器人ChatGPT一經上線,便迅速引發了全球范圍內的熱議與追捧。僅在上線五天內,注冊用戶便突破了百萬大關。ChatGPT的成功不僅展示了大語言模型(LLM)的強大能力,也標志著人類正式邁入了一個全新的人工智能時代。

本文將以ChatGPT為切入點,回顧GPT模型的發展歷程,深入解析大語言模型(LLM)的構成及其工作原理。同時,我們將涵蓋自然語言處理(NLP)、深度學習、Transformer等相關知識,幫助讀者全面了解LLM及其在AI領域中的重要地位。

二、GPT模型的發展歷程

2.1 自然語言處理的局限

自然語言處理(Natural Language Processing,簡稱NLP)作為人工智能的重要分支,旨在使計算機能夠理解、處理和生成自然語言。然而,傳統的NLP方法主要依賴于規則和統計模型,這導致了諸多局限性。例如:

- 語境理解不足:傳統模型在處理復雜語境時,往往難以理解句子間的深層次關聯。

- 生成能力有限:生成的文本缺乏多樣性和自然流暢性,通常顯得生硬和模板化。

- 特征依賴性強:傳統方法依賴于手工提取特征,難以自動學習語言的深層次表示。

在ChatGPT出現之前,盡管市場上已有許多智能聊天工具,但它們大多只能完成簡單、模板化的對話,難以應對復雜的交流需求。這些局限性促使研究人員不斷探索新的方法以突破傳統NLP的瓶頸。

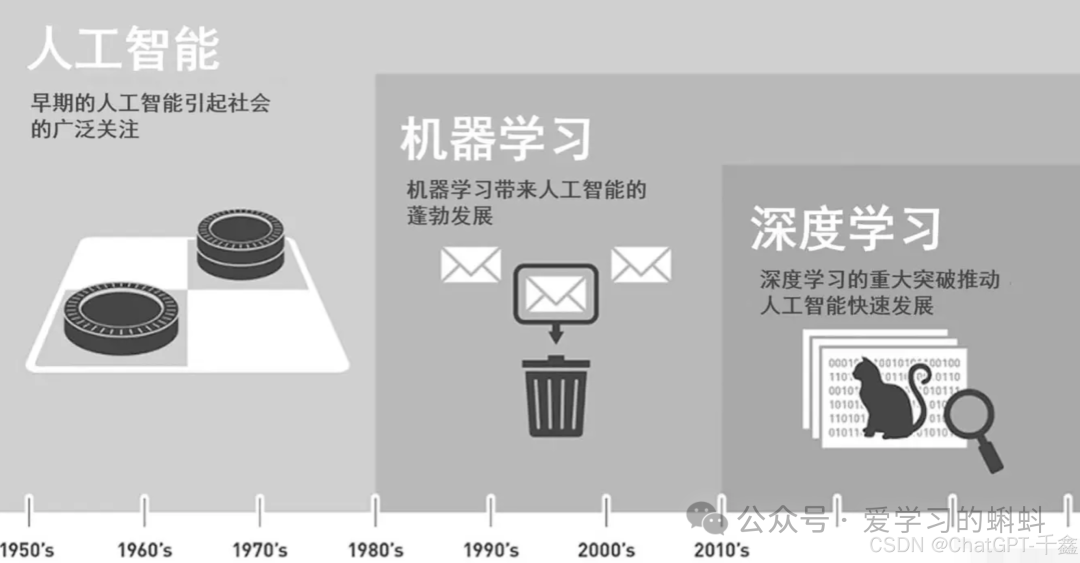

2.2 機器學習的崛起

隨著機器學習(Machine Learning,簡稱ML)的不斷發展,NLP領域迎來了新的契機。機器學習通過無監督和有監督學習方法,從大規模數據中提取模式和規律,顯著提升了計算機處理自然語言的能力。主要進展包括:

- 統計模型:如樸素貝葉斯、支持向量機(SVM)等,開始在文本分類、情感分析等任務中發揮作用。

- 詞向量表示:Word2Vec、GloVe等模型引入了詞嵌入,將離散的詞表示為連續的向量,捕捉詞之間的語義關系。

盡管機器學習方法在傳統NLP任務如文本分類、命名實體識別等方面取得了顯著進展,但在處理復雜語言任務時仍面臨諸多挑戰:

- 特征提取依賴人工:需要領域專家手工設計特征,耗時耗力且難以覆蓋所有語言現象。

- 模型泛化能力有限:難以在不同任務或領域間遷移,泛化能力不足。

2.3 深度學習的興起

深度學習(Deep Learning,簡稱DL)作為機器學習的一個子領域,通過構建多層神經網絡,模擬人腦的工作方式,使得計算機能夠更高效地處理和理解復雜數據。在NLP領域,深度學習模型如循環神經網絡(RNN)和卷積神經網絡(CNN)等的應用,帶來了突破性的進展。這些模型通過海量數據的訓練,能夠提取出更高級別的語義特征,顯著提升了語言理解和生成的準確性與靈活性。

2.3.1 神經網絡的訓練

深度學習依賴于有監督學習,通過提供大量標注數據,訓練神經網絡以完成特定任務。例如:

- 面部識別:神經網絡通過處理數百萬張標注過的人臉圖像,學習識別不同的面部特征。

- 機器翻譯:通過大量的雙語語料,訓練網絡實現從一種語言到另一種語言的自動翻譯。

在NLP中,神經網絡通過大量文本數據的訓練,學習語言的結構和語義。例如,長短期記憶網絡(LSTM)和門控循環單元(GRU)被廣泛應用于生成和理解任務中。

2.3.2 神經網絡面臨的挑戰

盡管神經網絡在多個領域取得了成功,但在NLP任務中依然面臨一些挑戰:

- 記憶長度:傳統神經網絡在處理長序列時,信息容易衰減,導致對遠距離依賴關系的捕捉不足。

- 并行性:序列數據的逐步處理方式限制了并行計算的效率,影響了訓練速度。

- 長距離依賴性:在處理長文本時,梯度消失和梯度爆炸問題使得模型難以有效學習長距離的語義關系。

這些挑戰促使研究人員不斷改進網絡結構,尋求更高效、更具表達能力的模型。

2.4 Transformer的革命性突破

2017年,Google在論文《Attention is All You Need》中提出了Transformer模型,徹底改變了NLP領域的格局。Transformer引入了自注意力機制(Self-Attention)和位置編碼(Positional Encoding),解決了傳統神經網絡在處理長序列數據時的諸多問題。其高度的并行性和強大的長距離依賴捕捉能力,使得Transformer在語言建模、機器翻譯等任務中取得了卓越的表現。

2.4.1 Transformer的核心組成

- 自注意力機制(Self-Attention):允許模型在處理中每個詞時,關注序列中所有其他詞的重要性,從而捕捉全局信息。

- 多頭注意力(Multi-Head Attention):通過并行多個注意力頭,捕捉不同子空間的特征,增強模型的表達能力。

- 前饋神經網絡(Feed-Forward Neural Network):在每個注意力層之后,進行非線性變換,提升模型的非線性表示能力。

- 位置編碼(Positional Encoding):通過添加位置信息,幫助模型理解詞語在序列中的順序。

2.4.2 Transformer的優勢

- 并行計算:不同于RNN的逐步處理方式,Transformer可以并行處理序列中的所有詞,提高了訓練效率。

- 捕捉長距離依賴:自注意力機制使得模型能夠直接訪問序列中任意位置的信息,解決了RNN在長序列處理中記憶衰減的問題。

- 模塊化設計:Transformer由多個相同的編碼器和解碼器層堆疊而成,具有高度的可擴展性和靈活性。

Transformer的成功不僅推動了NLP技術的發展,也為后續的大量基于深度學習的語言模型奠定了基礎,如BERT、GPT等,進一步推動了NLP技術的進步。

2.5 GPT模型的誕生與發展

在深度學習和Transformer技術的推動下,OpenAI于2018年推出了GPT(Generative Pre-trained Transformer)模型。GPT通過大規模的無監督預訓練,結合有監督的微調機制,成為生成式語言模型的代表,進一步提升了自然語言生成的能力。2022年末,基于GPT模型的ChatGPT正式上線,迅速獲得了全球范圍內的關注與認可。

2.5.1 GPT的核心特點

GPT模型具有以下三個核心特點:

- Transformer架構:GPT基于Transformer架構,實現了高效的并行計算和長距離依賴關系的捕捉。

- 預訓練-微調機制:GPT首先在海量未標注文本上進行無監督預訓練,隨后在特定任務上進行有監督微調,使模型具備了強大的通用性和適應性。

- 生成式能力:與雙向模型BERT不同,GPT采用單向語言模型的預訓練方法,使其在文本生成任務中表現尤為出色。

2.5.2 GPT模型的迭代與升級

GPT模型自誕生以來,經歷了多個版本的迭代,每一代都在參數規模和性能上實現了顯著提升:

- GPT-1:發布于2018年,擁有1.17億參數,證明了預訓練-微調框架在語言模型中的有效性。

- GPT-2:發布于2019年,參數規模增至15億,展示了更強的生成能力,但因擔憂濫用風險,初期未完全公開。

- GPT-3:發布于2020年,擁有1750億參數,進一步提升了語言生成的質量和多樣性,被廣泛應用于各種生成任務中。

- GPT-4:發布于2023年,參數規模超過GPT-3的10倍,具備更強的理解和生成能力,雖然訓練成本高昂,但在各項任務中表現卓越。

隨著技術的不斷進步,GPT模型不僅在參數規模上不斷增長,其架構和訓練方法也在不斷優化,推動了自然語言處理技術的前沿發展。

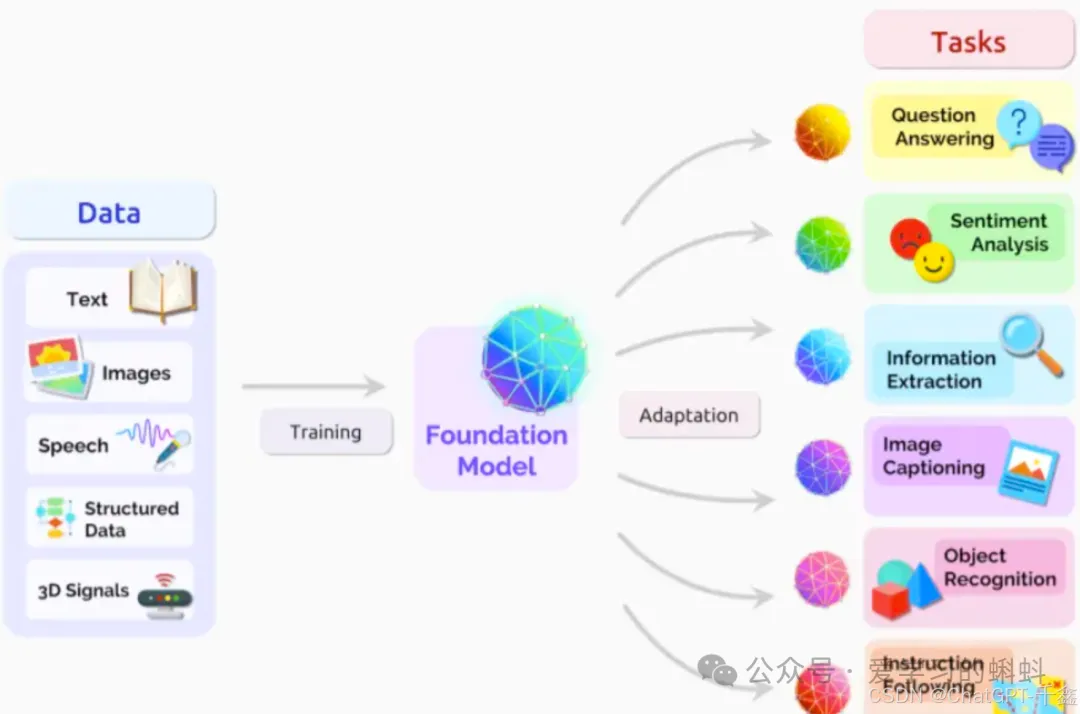

三、大語言模型時代的到來

GPT模型的成功,開啟了大語言模型(Large Language Model,簡稱LLM)時代。LLM通過大規模的預訓練,結合海量參數,顯著提升了語言理解與生成的能力,推動了生成式人工智能(Artificial Intelligence Generated Content,簡稱AIGC)的快速發展。這一時代不僅見證了語言模型在各類NLP任務中的突破,也為AI在更多實際應用場景中的落地提供了堅實基礎。

在這里插入圖片描述

3.1 LLM的定義與特征

LLM指的是具有數十億甚至上千億參數的語言模型,通常基于深度學習架構(如Transformer)。其主要特征包括:

- 大規模參數:數十億至上千億的參數量,使模型具備強大的表達和學習能力。

- 海量語料預訓練:在海量未標注文本上進行預訓練,掌握廣泛的語言知識和語義信息。

- 廣泛的適應性:通過微調,可以適應多種具體任務,如文本生成、翻譯、對話系統等。

3.2 LLM對AI發展的影響

- 提升自然語言理解和生成能力:LLM在語法、語義理解和上下文關聯方面表現出色,能夠生成連貫、自然的文本。

- 推動多模態AI的發展:結合其他生成模型,LLM可以與圖像、音頻等多模態數據融合,推動多模態AI的發展。

- 加速AI在各行業的應用:從客服、內容創作到代碼生成,LLM的應用前景廣泛,助力各行業實現智能化轉型。

四、揭開大語言模型(LLM)的面紗

4.1 什么是LLM

大語言模型(LLM,Large Language Model)是一種基于深度學習的語言模型,通常擁有數十億甚至上千億的參數。LLM通過對海量未標注文本的預訓練,掌握了豐富的語言知識和語義信息,具備強大的語言理解和生成能力。在特定任務上,LLM可通過微調適應不同的應用場景,從而實現多樣化的NLP功能。

LLM的名稱解釋:

- Large(大型):表示該模型具有大量的參數和語料,結構復雜龐大。

- Language(語言):表示該模型用于自然語言處理任務,能夠處理和生成多種語言文本。

- Model(模型):表示該模型是基于深度學習構建的神經網絡模型,通常基于Transformer架構。

4.2 LLM的構成特點

LLM主要由以下幾個關鍵組成部分構成:

- Transformer架構:利用自注意力機制和位置編碼處理序列數據,具備高度的并行性和長距離依賴捕捉能力。

- 預訓練-微調機制:通過大規模無監督預訓練獲取通用語言知識,再通過有監督微調適應特定任務需求。

- 生成式能力:具備強大的文本生成能力,能夠根據輸入生成連貫、自然的文本內容。

4.2.1 Transformer架構在LLM中的應用

Transformer架構在LLM中扮演著核心角色,其主要組件包括:

- 輸入嵌入(Input Embedding):將原始文本轉化為向量表示,通過詞嵌入(Word Embedding)和位置編碼(Positional Encoding)實現。

import torch.nn as nn

class InputEmbedding(nn.Module):

def __init__(self, vocab_size, embed_size, max_length):

super(InputEmbedding, self).__init__()

self.token_embedding = nn.Embedding(vocab_size, embed_size)

self.position_embedding = nn.Embedding(max_length, embed_size)

def forward(self, x):

positions = torch.arange(0, x.size(1)).unsqueeze(0).expand_as(x)

return self.token_embedding(x) + self.position_embedding(positions)- 編碼器(Encoder):由多層自注意力機制和前饋神經網絡組成,負責提取輸入文本的深層語義特征。

- 解碼器(Decoder):生成目標文本,通過自注意力機制和編碼-解碼注意力機制,實現高質量的文本生成。

關鍵技術詳解:

- 自注意力機制(Self-Attention):計算序列中每個詞與其他詞的相似度,生成加權表示。其中,( Q )、( K )、( V ) 分別為查詢(Query)、鍵(Key)、值(Value)的矩陣。

- 多頭注意力(Multi-Head Attention):并行計算多個注意力頭,捕捉不同子空間的特征。其中,( head_i = Attention(QW_i^Q, KW_i^K, VW_i^V) )。

- 前饋神經網絡(Feed-Forward Neural Network):對每個位置的表示進行非線性變換,通常包含兩個線性變換和一個激活函數。

- 位置編碼(Positional Encoding):通過正弦和余弦函數為每個位置生成獨特的編碼,注入序列位置信息。

4.2.2 預訓練-微調機制

LLM的訓練過程分為兩個階段:

- 預訓練階段:在大規模未標注文本上進行訓練,學習語言的基本模式和結構。常用的預訓練任務包括:

語言模型任務(Language Modeling):預測句子中的下一個詞或掩蓋詞。GPT采用自回歸模型,通過預測下一個詞進行訓練。

掩碼語言模型(Masked Language Modeling,MLM):如BERT,通過掩蓋部分詞語,訓練模型預測被掩蓋的詞。

- 微調階段:在特定任務的有標注數據上進行訓練,優化模型參數,使其更好地適應具體應用需求。常見的微調任務包括:

- 文本分類

- 命名實體識別

- 機器翻譯

- 問答系統

預訓練與微調的結合使得LLM既具備強大的通用性,又能夠在具體任務上表現出色。

4.2.3 生成式能力

LLM的生成式能力使其能夠在多種任務中表現出色,包括但不限于:

- 文本生成:根據輸入提示生成連貫的段落或文章。

- 對話系統:模擬人類對話,提供自然流暢的交流體驗。

- 代碼生成:根據自然語言描述生成相應的代碼片段。

- 多模態生成:結合圖像、音頻等多種模態,實現綜合內容生成。

4.3 LLM的工作原理

LLM的工作過程主要分為預訓練和微調兩個階段:

4.3.1 預訓練階段

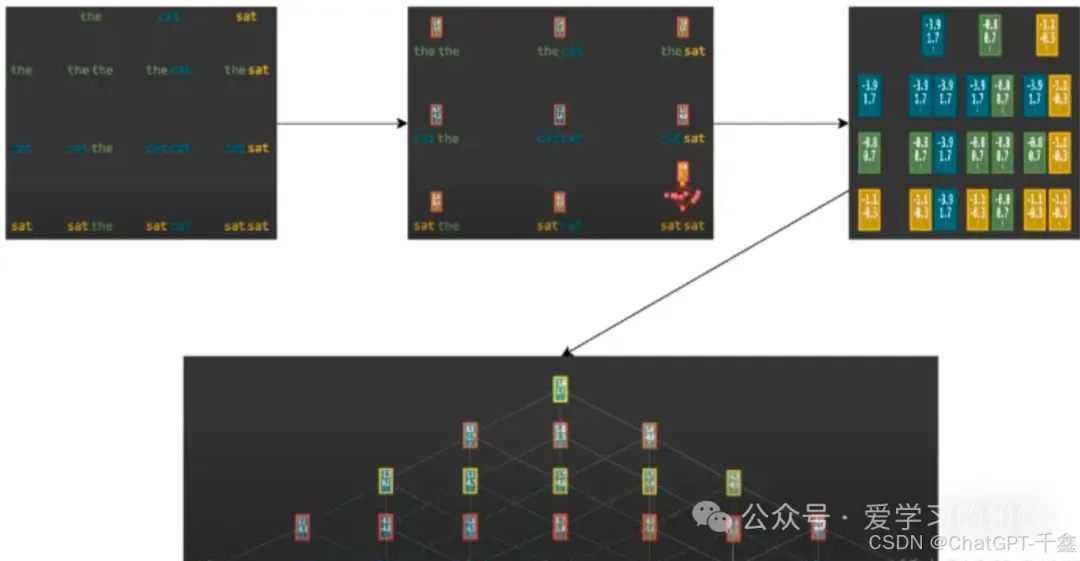

在預訓練階段,LLM在海量文本數據上進行無監督學習,掌握語言的基本規律和模式。預訓練通常采用自監督學習的方法,通過設計任務讓模型自動學習。例如,GPT模型通過自回歸的方式,逐詞預測下一個詞,從而學習語言的結構和語義。

預訓練的關鍵步驟:

- 數據準備:收集并清洗海量未標注文本數據,確保數據的多樣性和覆蓋面。

- 模型訓練:使用分布式計算資源,訓練具有數十億參數的模型,優化目標是最大化下一個詞的預測概率。

- 知識積累:通過長時間的訓練,模型逐步積累語言知識和語義理解能力。

4.3.2 微調階段

預訓練完成后,LLM在特定任務的有標注數據上進行微調。通過在特定任務上的有監督學習,模型進一步優化參數,使其更好地適應具體應用需求。

微調的關鍵步驟:

- 任務定義:明確具體任務,如文本分類、命名實體識別、機器翻譯等。

- 數據準備:收集并標注與任務相關的數據,確保數據的質量和覆蓋面。

- 模型微調:在預訓練模型的基礎上,使用特定任務的數據進行有監督訓練,調整模型參數以提高任務性能。

- 評估與優化:通過驗證集評估模型性能,進行必要的參數調整和優化,確保模型在實際應用中的表現。

通過預訓練和微調相結合,LLM不僅具備了廣泛的語言理解能力,還能夠在特定任務上展現出色的性能。

五、LLM的應用場景

大語言模型(LLM)憑借其強大的語言理解和生成能力,在多個領域展現出了廣泛的應用前景。以下是主要的應用場景:

5.1 RAG場景(檢索增強生成)

盡管LLM具備強大的生成能力,但在某些情況下,如處理最新信息或特定領域知識時,可能會遇到知識更新不及時或數據源不足的問題。引入RAG(Retrieval-Augmented Generation)技術,可以有效解決這些問題。

5.1.1 LLM存在的問題

LLM在實際應用中可能面臨以下兩個主要問題:

- 時效性不及時:LLM依賴于訓練時的語料,語料的時效性決定了LLM回答的正確性。例如,GPT-4的訓練數據截止到2023年10月,對于之后發生的事件,模型無法提供準確的信息。

- 數據源不充足:如果某個領域的語料數據不足,LLM在該領域的表現可能不佳,無法回答相關問題或生成高質量的內容。

5.1.2 什么是RAG

RAG(Retrieval-Augmented Generation)是一種結合了檢索和生成的方法,用于自然語言處理任務。其核心思路是將檢索到的相關信息作為上下文輸入LLM,輔助生成更準確和相關的內容。

RAG的工作流程:

- 檢索階段(Retrieval):

- 目標:從大型知識庫或文檔集合中檢索與當前任務相關的文本片段或文檔。

- 方法:采用向量檢索技術(如FAISS、Annoy),通過將查詢和文檔編碼為向量,計算相似度,檢索相關性最高的文本。

- 示例:用戶提問“最新的iPhone型號是什么?”,系統通過檢索獲取相關的最新iPhone信息。

- 生成階段(Generation):

- 目標:利用檢索到的文本作為上下文,生成符合邏輯和相關性的回答或內容。

- 方法:將檢索到的文本與用戶的輸入一起作為LLM的輸入,指導模型生成相關內容。

- 示例:基于檢索到的最新iPhone型號信息,生成詳細的描述和功能介紹。

- 調整階段(Adjustment):

- 目標:根據用戶反饋或特定需求,對生成的內容進行進一步優化和調整。

- 方法:使用后處理技術,如糾錯、風格調整,或根據規則進行內容篩選。

- 示例:根據用戶要求調整回答的詳細程度或語氣,確保生成內容符合預期。

5.1.3 RAG的應用

RAG技術廣泛應用于以下場景:

- 智能問答系統:通過檢索相關文檔,提供準確和詳細的回答。

- 文檔摘要生成:檢索相關段落,生成簡明扼要的摘要。

- 實時信息查詢:結合最新數據,提供時效性強的回答,如新聞查詢、股票行情等。

RAG的實現示例:

大模型聚集地-ChatMoss & ChatGPT中文版

from transformers import AutoTokenizer, AutoModelForSeq2SeqLM

import faiss

import numpy as np

# 加載檢索模型和生成模型

retriever_tokenizer = AutoTokenizer.from_pretrained("facebook/dpr-bert-base-retriever")

retriever_model = AutoModelForSeq2SeqLM.from_pretrained("facebook/dpr-bert-base-retriever")

generator_tokenizer = AutoTokenizer.from_pretrained("gpt-4")

generator_model = AutoModelForSeq2SeqLM.from_pretrained("gpt-4")

# 構建向量索引

index = faiss.IndexFlatL2(768) # 假設使用768維的向量

corpus_embeddings = np.load("corpus_embeddings.npy") # 預先計算好的語料庫向量

index.add(corpus_embeddings)

def retrieve(query, top_k=5):

query_embedding = retriever_model.encode(query)

distances, indices = index.search(np.array([query_embedding]), top_k)

return [corpus[i] for i in indices[0]]

def generate_response(query):

retrieved_docs = retrieve(query)

context = " ".join(retrieved_docs)

input_text = f"Question: {query}\nContext: {context}\nAnswer:"

inputs = generator_tokenizer.encode(input_text, return_tensors="pt")

outputs = generator_model.generate(inputs, max_length=200)

return generator_tokenizer.decode(outputs[0], skip_special_tokens=True)

# 用戶提問示例

response = generate_response("最新的iPhone型號是什么?")

print(response)5.2 AIGC場景(人工智能生成內容)

AIGC(Artificial Intelligence Generated Content)涵蓋了多種內容生成任務,包括文本生成、圖片生成、代碼編寫、視頻制作、語音合成等。LLM在AIGC中的應用,極大地推動了內容創作的自動化與智能化。

5.2.1 文本生成

LLM能夠根據輸入提示,自動生成高質量的文章、故事、新聞報道等,廣泛應用于內容創作、新聞寫作、自動摘要等領域。

應用示例:

- 內容創作:根據主題自動生成博客文章或技術文檔。

- 新聞寫作:基于數據自動生成新聞報道,提高新聞生產效率。

- 自動摘要:對長篇文章進行摘要,提取關鍵信息。

from transformers import GPT2LMHeadModel, GPT2Tokenizer

# 加載模型和tokenizer

model_name = "gpt2-large"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)

def generate_text(prompt, max_length=200):

inputs = tokenizer.encode(prompt, return_tensors="pt")

outputs = model.generate(inputs, max_length=max_length, num_return_sequences=1, no_repeat_ngram_size=2)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

# 生成示例

prompt = "在未來的人工智能時代,"

generated_text = generate_text(prompt)

print(generated_text)5.2.2 代碼編寫

通過理解自然語言描述,LLM可以生成相應的代碼片段,輔助程序員進行代碼編寫和調試,提高開發效率。

應用示例:

- 自動補全:根據開發者輸入的函數名稱或注釋,生成相應的代碼實現。

- 代碼翻譯:將一種編程語言的代碼轉換為另一種語言。

- 錯誤修復:根據錯誤提示,生成修復代碼。

大模型聚集地-ChatMoss & ChatGPT中文版

from transformers import CodexModel, CodexTokenizer

# 假設使用OpenAI的Codex模型

model_name = "code-davinci-002"

tokenizer = CodexTokenizer.from_pretrained(model_name)

model = CodexModel.from_pretrained(model_name)

def generate_code(description, max_length=150):

prompt = f"# {description}\n"

inputs = tokenizer.encode(prompt, return_tensors="pt")

outputs = model.generate(inputs, max_length=max_length, num_return_sequences=1, temperature=0.5)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

# 生成示例

description = "計算兩個數的最大公約數"

generated_code = generate_code(description)

print(generated_code)5.2.3 多模態生成

結合其他生成模型,LLM能夠實現文字、圖片、音視頻的綜合生成,應用于多媒體內容創作、虛擬現實等前沿領域。

應用示例:

- 文本生成圖像:根據文字描述生成對應的圖像內容。

- 視頻腳本生成:根據文字描述自動生成視頻腳本和分鏡頭設計。

- 語音合成:將文本內容轉換為自然流暢的語音。

大模型聚集地-ChatMoss & ChatGPT中文版

# 示例:文本生成圖像

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

import torch

# 加載模型和處理器

model = CLIPModel.from_pretrained("openai/CLIP-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/CLIP-vit-base-patch32")

def generate_image(text):

inputs = processor(text=[text], return_tensors="pt", padding=True)

outputs = model.get_text_features(**inputs)

# 由于CLIP是用于對齊圖像和文本的,實際圖像生成需要結合生成模型,如DALL·E

# 此處僅作為示例,生成過程復雜,此處省略

return "圖像生成需要使用專門的生成模型,如DALL·E"

# 生成示例

text = "一只在草地上奔跑的棕色狗"

image = generate_image(text)

print(image)六、LLM的挑戰與未來發展

盡管LLM在多個領域展現出了巨大的潛力,但其發展過程中也面臨諸多挑戰和問題,需要持續關注和解決。

6.1 模型偏見與倫理問題

LLM在訓練過程中依賴于海量的互聯網文本,這些文本中可能包含各種偏見和不當內容,導致模型生成的輸出也存在相應的偏見和問題。具體表現包括:

- 性別、種族偏見:模型可能生成帶有性別、種族偏見的內容。

- 虛假信息:模型可能生成看似合理但實際上不準確或虛假的信息。

- 隱私泄露:模型可能泄露訓練數據中的敏感信息。

解決方法:

- 數據清洗與過濾:在訓練前對數據進行嚴格的清洗和過濾,減少有害內容的輸入。

- 偏見檢測與糾正:開發偏見檢測工具,及時發現和糾正模型輸出中的偏見。

- 倫理規范制定:制定并遵守AI倫理規范,確保模型的開發和應用符合法律和道德標準。

6.2 計算成本與資源消耗

訓練和部署LLM需要大量的計算資源和高昂的成本。隨著模型規模的不斷擴大,資源消耗問題愈發突出,具體表現包括:

- 高昂的訓練成本:大規模模型的訓練需要大量的計算資源和時間,造成高昂的經濟成本。

- 環境影響:大量計算資源的消耗也帶來了顯著的碳排放,增加了環境負擔。

解決方法:

- 模型壓縮與優化:通過剪枝、量化、知識蒸餾等技術,壓縮模型規模,降低計算需求。

- 高效的分布式訓練:優化分布式訓練算法,提高計算效率,減少訓練時間。

- 綠色AI:采用節能環保的計算設備和數據中心,降低能源消耗和碳排放。

6.3 知識更新與保持

LLM的知識截止于訓練時的語料,對于之后發生的事件或新知識無法及時掌握。這限制了模型在一些需要最新信息的應用場景中的效果。

解決方法:

- 動態更新機制:定期更新模型的訓練數據,確保模型能夠掌握最新的信息和知識。

- 結合外部知識庫:通過與外部知識庫或實時數據源結合,彌補模型知識的更新滯后。

- 增量學習:采用增量學習方法,逐步更新模型參數,融入新知識而不遺忘舊知識。

6.4 多語言與跨文化理解

當前大多數LLM主要針對英語和少數幾種主流語言,其他語言的支持和理解能力相對較弱,存在多語言和跨文化理解的局限性。

解決方法:

- 多語言訓練:在訓練過程中引入更多的多語言語料,提高模型對不同語言的理解和生成能力。

- 跨文化數據融合:結合不同文化背景的數據,增強模型的跨文化理解能力。

- 社區協作:鼓勵全球社區參與多語言數據的收集和模型的訓練,提升多語言模型的覆蓋面和質量。

七、總結

本文通過回顧GPT模型的發展歷程,深入解析了大語言模型(LLM)的構成及其工作原理,探討了LLM在RAG和AIGC等多個應用場景中的廣泛應用。我們還分析了LLM面臨的挑戰,如模型偏見、計算成本、知識更新和多語言理解等,并提出了相應的解決方法。

隨著技術的不斷進步,LLM將繼續引領自然語言處理和人工智能領域的創新,為未來的研究和實際應用開辟更多可能。從ChatGPT的成功到LLM時代的到來,人工智能技術正在以前所未有的速度發展,賦能各行各業。未來,隨著更強大的模型和更豐富的數據的涌現,LLM將在更多領域展現其潛力,推動社會的智能化進程。

本文轉載自 ??愛學習的蝌蚪??,作者: hpstream