六個問題帶你看懂什么是理工科學霸-OpenAI o1!

這篇主要會回答下面的問題(too long,don't read):

- 什么是OpenAI o1?——一個擅長數學物理化學生物編程等問題的理科學霸大模型

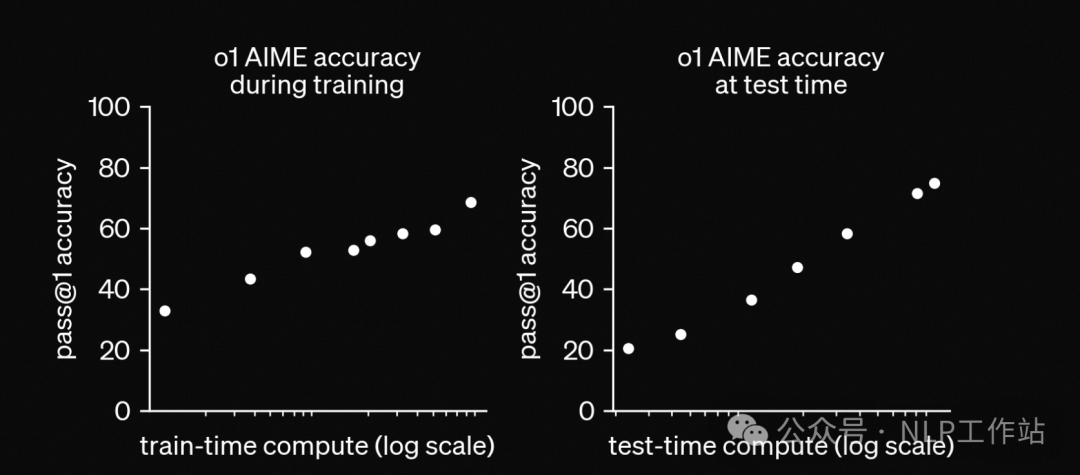

- OpenAI o1最大的技術特征是什么?——RL訓練和推理,在傳統COT之外隱藏了一個很長的內在COT,滿足scaling law

- OpenAI o1到底有多強?——斷崖碾壓GPT4-o,達到人類競賽選手,以及博士生水平。

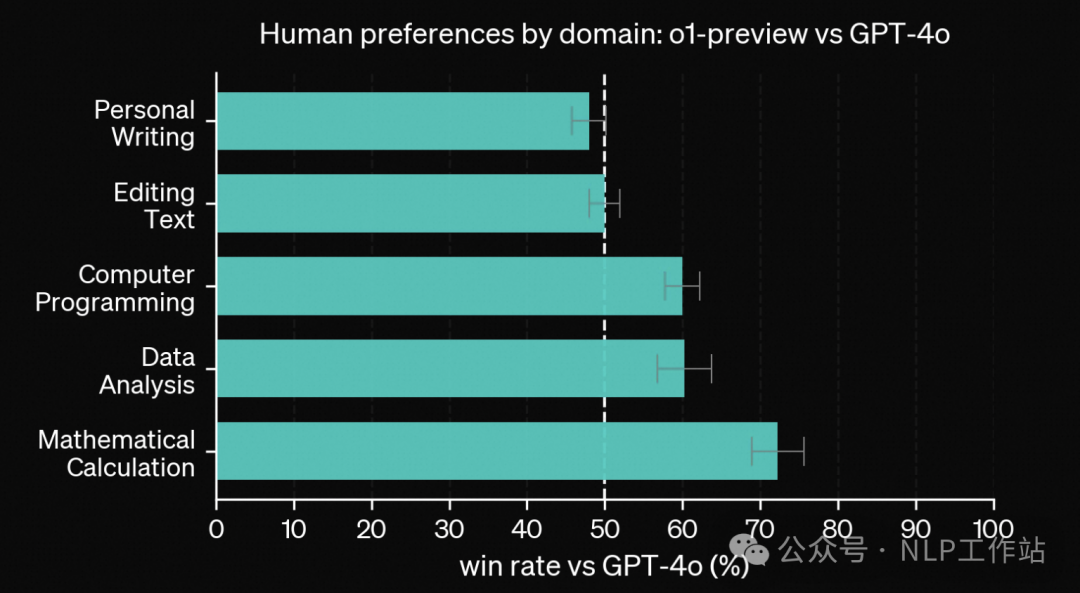

- 人們更喜歡GPT4-o還是OpenAI o1?——文科方面o1沒有優勢,理工科方面碾壓GPT4-o

- OpenAI o1的安全性怎么樣?—— 相比4o優勢明顯,更容易教會模型人類價值觀和原則

- OpenAI o1為什么要向用戶隱藏內在思維過程?——為了安全性和用戶體驗(不想讓大家蒸餾它的內在思維過程作為訓練數據)

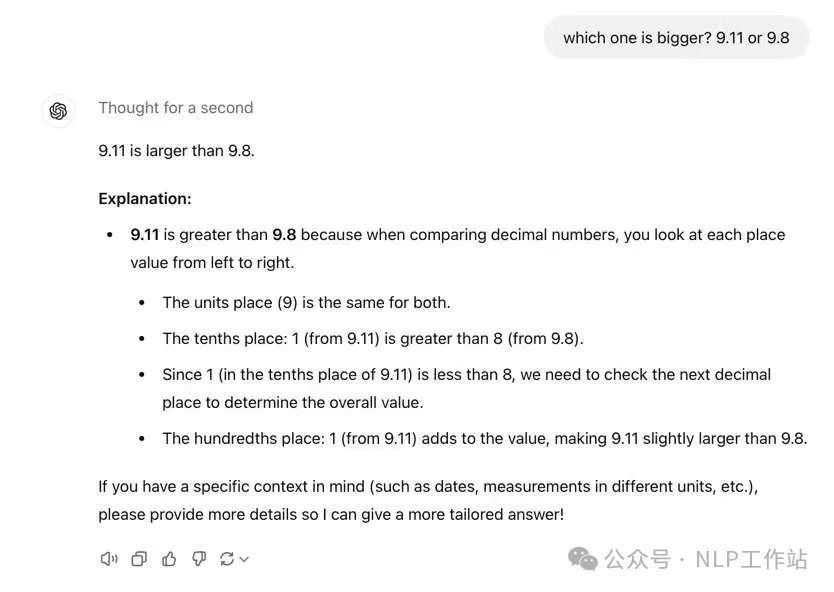

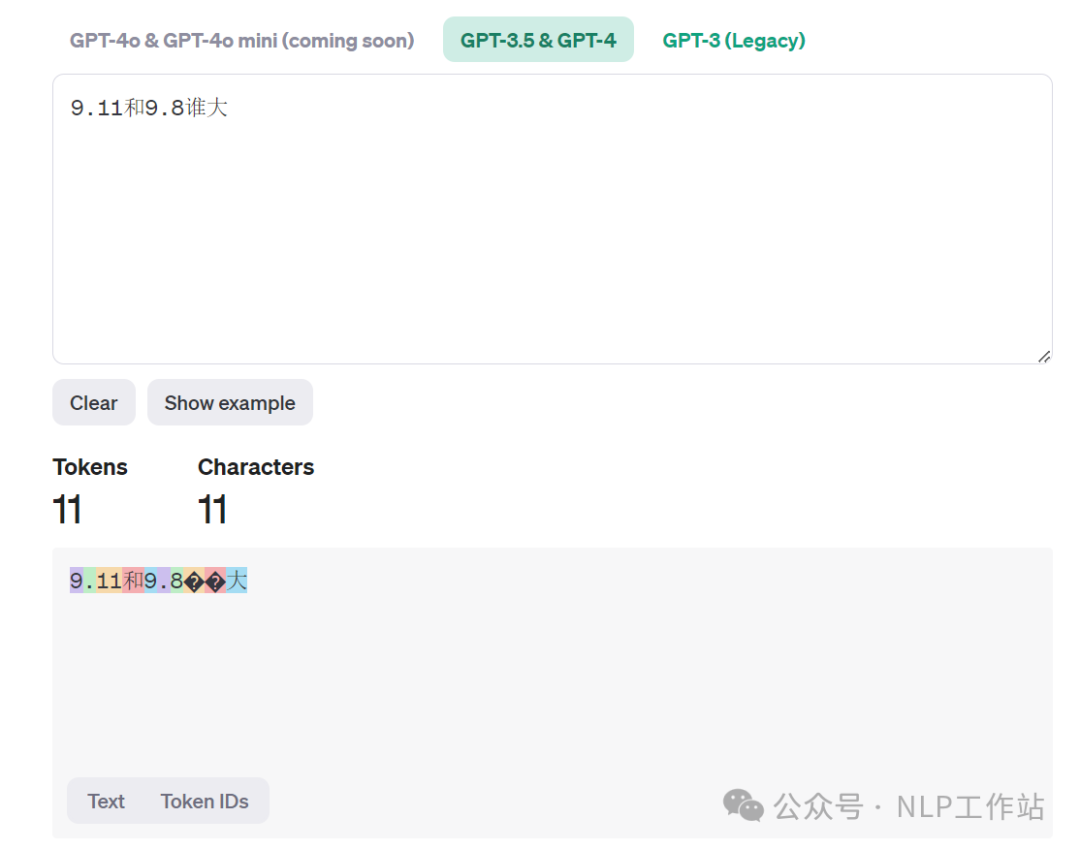

知乎:https://zhuanlan.zhihu.com/p/719859500PS:“9.11和9.8誰大”的這個問題OpenAI o1依然存在問題!!!OpenAI o1模型是否被過譽,讓子彈再飛一會!

什么是OpenAI o1?

OpenAI o1(后面簡稱o1)是OpenAI在2024.9.12號發布的最新大模型,主要針對的任務是復雜任務推理,比如競賽難度的編程問題,奧賽難度的數學問題等。

參考OpenAI原始介紹: https://openai.com/index/learning-to-reason-with-llms/

OpenAI o1最大的技術特征是什么?

在訓練階段,會通過強化學習,讓o1完善其思維鏈并優化所使用的策略。例如:識別并糾正錯誤,將復雜步驟拆分為簡單步驟,當前方法不work時,換一種方法

在推理階段,模型同樣會在呈現給用戶的cot之外,做一個更深的的所謂的long internal chain of thought,所以推理時間會更長,相當于COT套娃了,給COT再加一個COT(猜測是把MCTS搜索過程序列化了,case放在文末)。

值得注意的是,這次OpenAI依然主打了他們一直信奉的Scaling Law,在訓練和測試時的時間都能和性能形成對數線性關系。

OpenAI o1到底有多強?

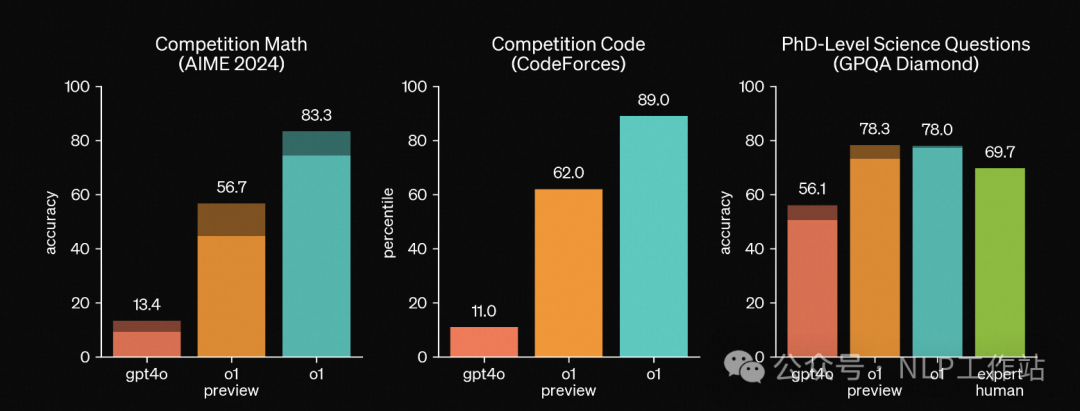

效果不用多說了,跟GPT4-o已經是斷崖式差距了,在最難的數學,code,物理化學生物等benchmark上遙遙領先。

- 在全美高中生數學競賽AIME上,o1能達到74分(GPT4-o僅有12分),如果采樣1000次,結合reward model加權投票能到93分,能排進全國前500名,超過USA Mathematical Olympiad的晉級分數線;

- 在GPQA,一個關于物理,化學和生物的智力測試上,OpenAI招募了一群相關領域有博士學位的專家和o1同臺競技, o1能夠在GPQA-diamond questions.上超過這群專家。

- 在視覺感知能力后方面,o1 在 MMMU 上取得了 78.2% 的分數,成為第一個與人類專家媲美的模型。

值得注意的是,OpenAI在o1的基礎上加強了模型的代碼能力,以o1為初始化又訓了一個o1-IOI,用于參加2024年的國際奧林匹克信息競賽(2024 International Olympiad in Informatics), 在和人類選手相同的條件下,在10h內解決6道非常難的競賽問題,每個問題最多允許提交50次。最終,o1-IOI能獲得一個216分的分數,在放開提交次數后,o1-IOI能獲得362.14,超過了金牌線。這種和人類頂尖選手同臺競技,才是最能反映模型能力的benchmark吧。在CodeForce上,打出了驚人的1807分。

人們更喜歡GPT4-o還是OpenAI-o1?

OpenAI測試了在不同領域的問答上,用GPT4-o和o1匿名回答,大家投票,結果顯示,o1只是在理工科方面顯著高于4o,比如編程,數據分析和數學題,但是在寫作和文本編輯方面和4o相差無幾,看起來o1確實是一個偏科的理工科選手。

OpenAI o1的安全性怎么樣?

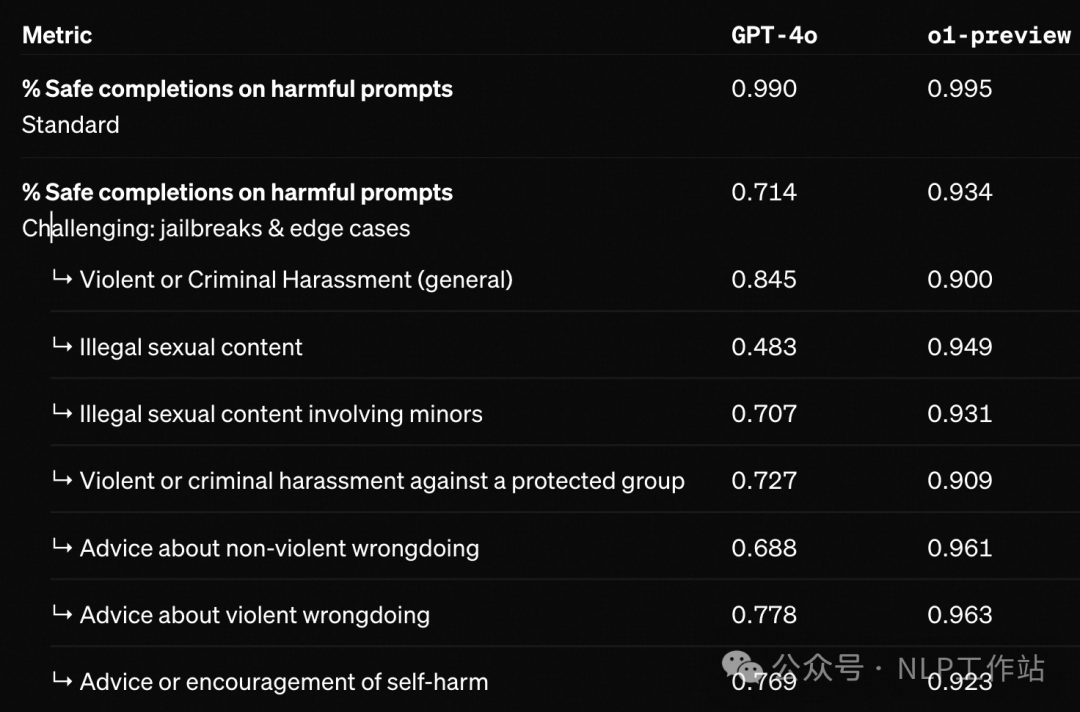

將模型需要遵循的準則融入內在COT中,可以高效且穩健魯棒地教會模型人類偏好的價值和需要遵循的原則,不管是OpenAI內部的安全benchmark還是外部公開的benchmark,o1都能達到極高的水平。更具體的好處有兩點:

- 可以讓我們(不是,是OpenAI,我們看不到)更清晰地看到模型內在的思維過程;

- o1關于安全規則的模型推理對于分布外場景(OOD)更加穩健.

OpenAI o1為什么要對用戶隱藏internal COT?

翻譯了一下OpenAI的原話,主要是為了用戶體驗和安全問題:

“我們認為隱藏的思維鏈為監控模型提供了獨特的機會。如果思維鏈忠實且易于理解,它允許我們“讀懂”模型的內心并理解其思維過程。例如,將來我們可能希望監控思維鏈,以識別是否存在操縱用戶的跡象。然而,為了實現這一點,模型必須能夠以未經過濾的形式表達其想法,因此我們不能將任何政策合規性或用戶偏好嵌入到思維鏈中。同時,我們也不希望讓不對齊的思維鏈直接展示給用戶。因此,在權衡用戶體驗、競爭優勢以及追求思維鏈監控的選項后,我們決定不向用戶展示原始的思維鏈。我們承認這一決定存在缺點。我們努力通過教模型在回答中重現思維鏈中的有用觀點部分來彌補這一不足。對于o1模型系列,我們展示了模型生成的思維鏈摘要。”

但是實際上,我認為主要是不想讓大家蒸餾它的內在思維過程作為訓練數據。

一些關于內在思維鏈的Cases

都太長了,展示不下,知道最重要的一點就行:內在思維鏈比思維鏈長的長的多。

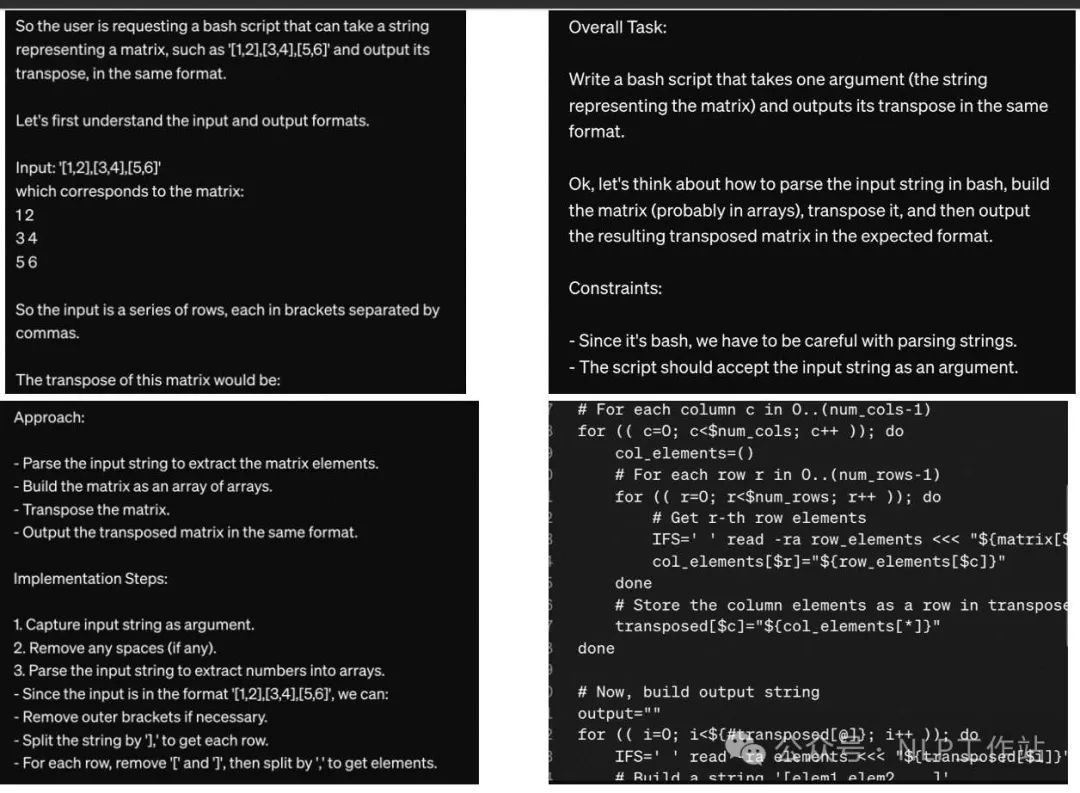

- 編程題目

Write a bash script that takes a matrix represented as a string with format '[1,2],[3,4],[5,6]' and prints the transpose in the same format.

思維鏈

內在思維鏈

最后說一點

雖然OpenAI的o1從各方面來看很強,但對于“9.11和9.8誰大”的這個問題,依然回答存在錯誤。

可能是tokenizer的問題,不過現在還不確定,在 platform.openai.com/tokenizer 上還看不到。

讓子彈在飛一會哈。

本文轉載自?? NLP工作站??,作者:白蘇蘇