大模型微調終極指南

大家好,我是劉聰NLP。

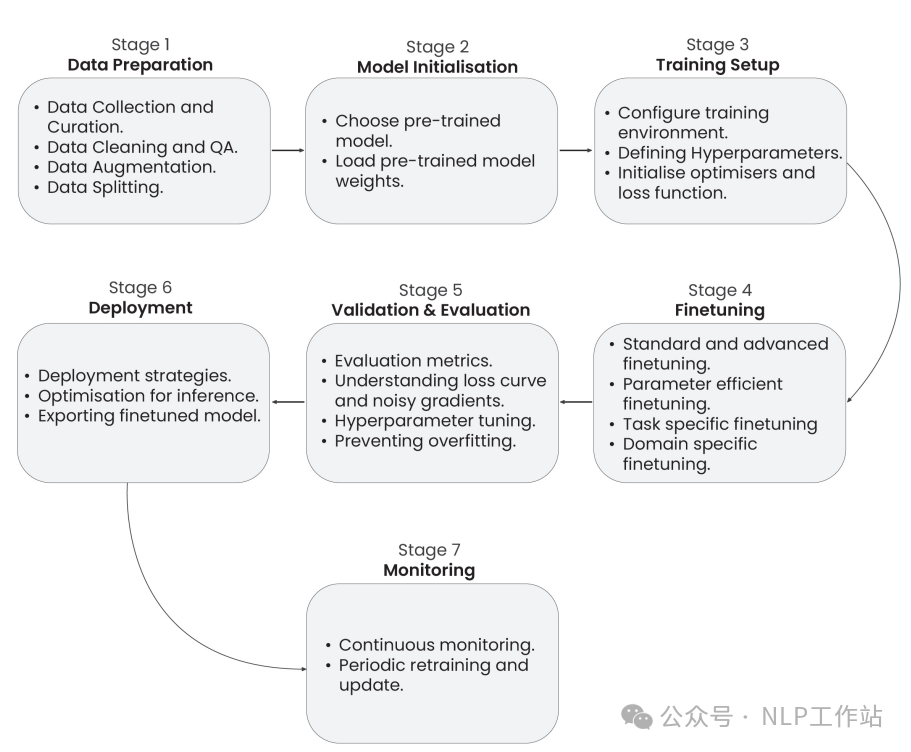

今天給大家帶來一篇大模型微調相關的最新綜述,主要大模型微調歸納為7個階段分別為數據準備、模型初始化、訓練環境配置、模型微調、模型評估與驗證、模型部署以及模型監控與維護。

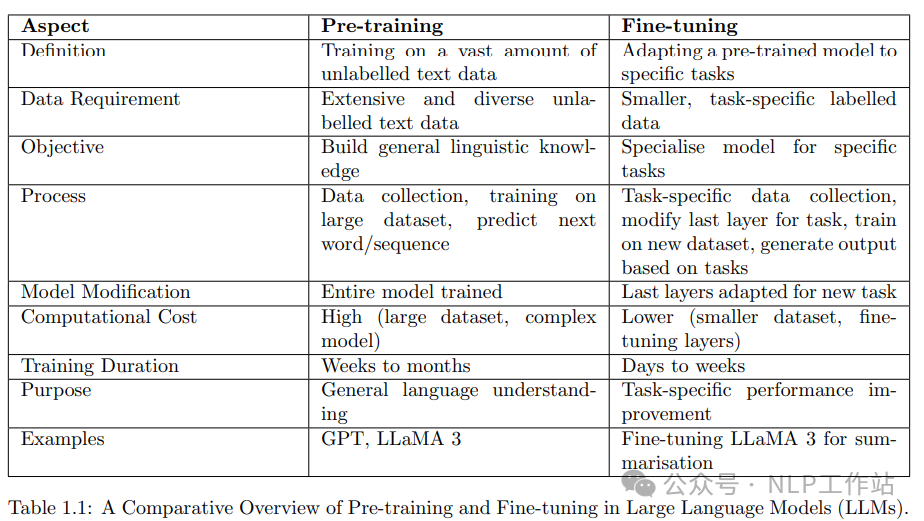

Paper: https://arxiv.org/abs/2408.13296模型微調(Fine-Tuning)就是以預訓練模型為基礎,通過相對較少的特定數據集進行的進一步訓練,主要是在模型預先存在的知識之上用過減少數據和計算成本來提高特定任務的效果。

模型預訓練與微調之間差距

大模型微調的優勢:

- 遷移學習:利用預訓練過程中獲得的知識,通過減少計算時間和資源,將其適應于特定任務

- 減少數據需求:需要較少的標注數據,專注于將預訓練的特征調整到目標任務

- 改善泛化能力:增強了模型對特定任務或領域的泛化能力,捕捉通用語言特征并對其進行定制

- 高效的模型部署:微調后的模型更適合實際應用,計算效率高,適合特定任務

- 適應各種任務:能夠適應廣泛的任務,在各種應用中表現良好

- 特定領域的性能:允許模型通過調整目標領域的細微差別和詞匯,從而在特定領域的任務中表現出色

- 更快收斂:從通用語言特征的權重開始訓練,能夠更快地收斂

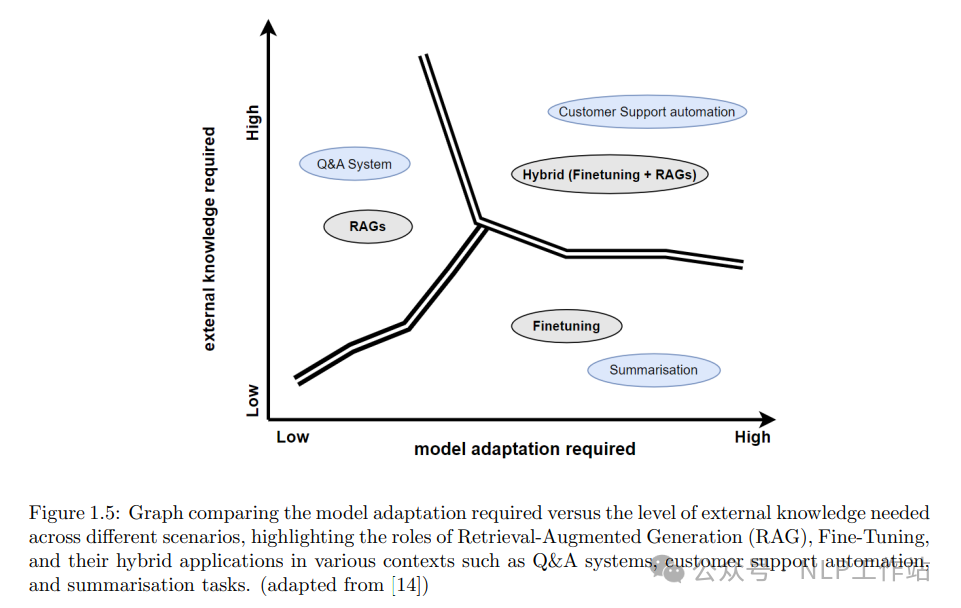

雖然,很多任務通過提示工程或RAG技術可能完美解決,但如果你需要模型調整其行為、寫作風格或融入特定領域的知識,那么微調仍然是必不可少的。

下面從7個不同階段來詳細介紹大模型微調所要準備的工作。

數據準備

- 高質量數據收集:確保數據的高質量、多樣化和代表性,確保數據在不同場景下的全面覆蓋,以增強模型的魯棒性;

- 有效的數據預處理:去除噪聲、錯誤和不一致性的數據對于模型至關重要;

- 數據不平衡處理:過采樣、欠采樣和SMOTE等技術有助于平衡數據集;

- 數據增強和合成:采用數據增強手段對數據集擴充但需要確保數據標注的一致性;同時利用提示工程或多步生成的方式合成數據;

- 道德數據處理:審查數據中有害或有偏見的內容,以防止模型輸出有害結果;

- 定期評估和迭代:持續評估和迭代數據準備流程,利用反饋循環和性能指標確保持續改進并適應新的數據需求。

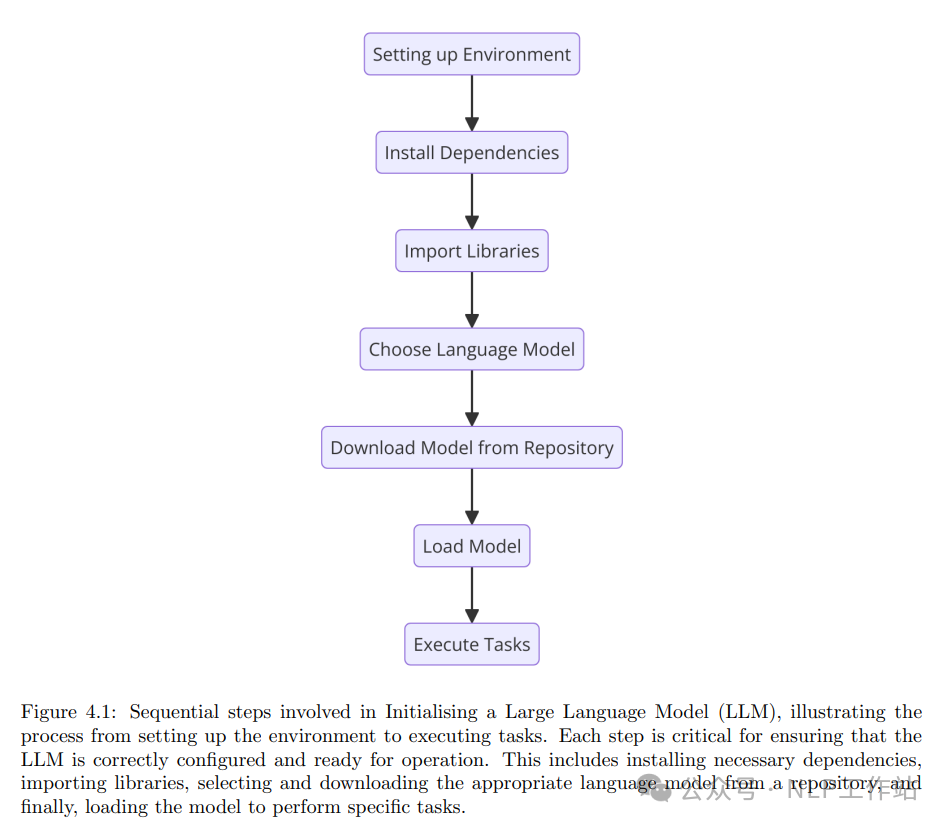

模型初始化

在該階段主要配置環境、安裝依賴項、選擇合適的大模型、下載對應的模型、預先在特定任務執行模型。

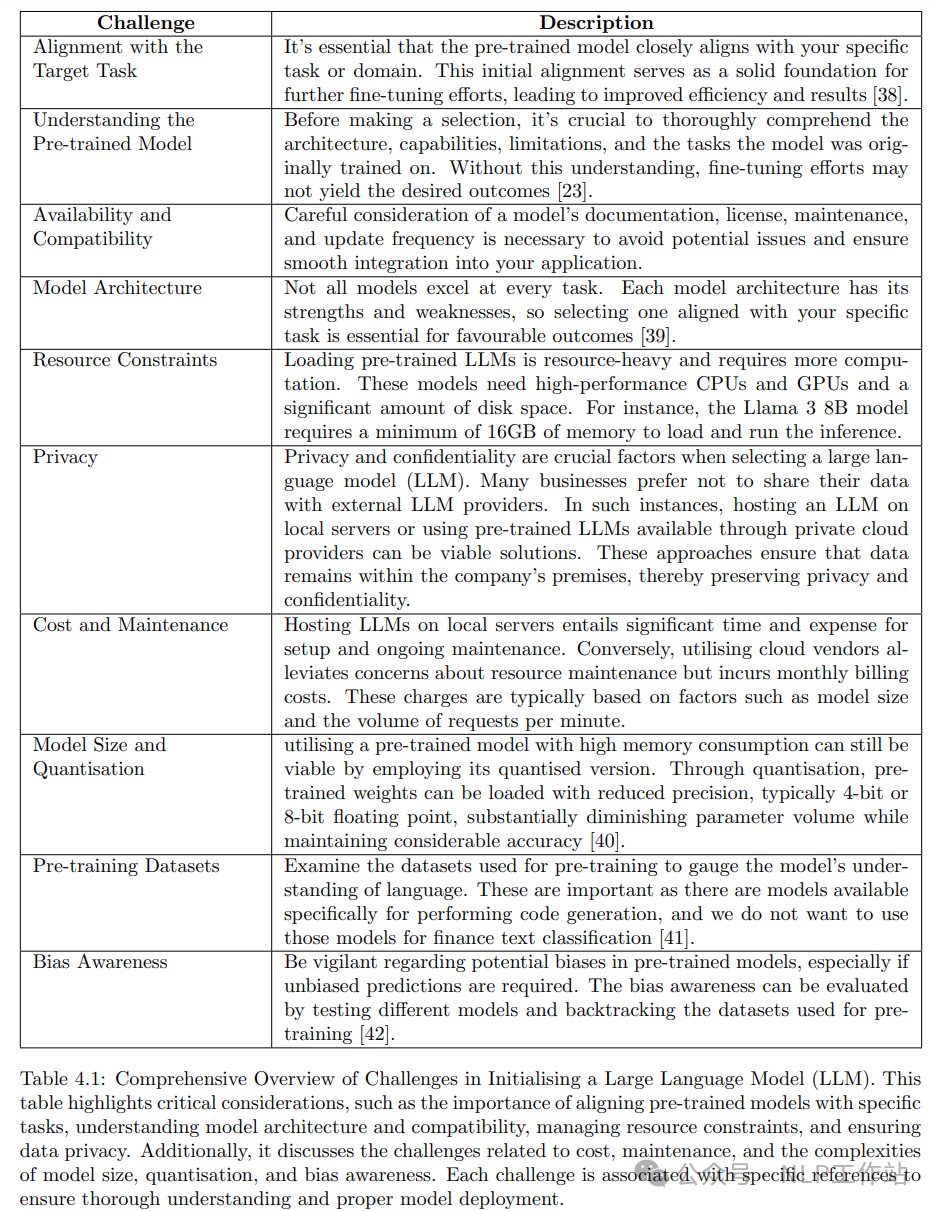

在模型選擇時,需要考慮選擇的模型與目標任務的一致性如何、模型的可用性和兼容性、模型的架構、資源的限制等等。

訓練設置

主要是在模型訓練過程中設置優化器、損失函數、參數調節。

- 學習率調節:一般使用較低的學習率,采用學習率預熱也會有益;

- Batch大小:一般更大的Batch可以獲得更好的效果,但需要選擇一個平衡顯存限制和訓練效率的Batch大小;

- 定期保存檢查點:不同間隔定期保存模型權重,實施及早停止測略,防止模型過擬合;

- 數據并行和模型并行:考慮使用數據并行或模型并行技術,將訓練工作負載分布在多個GPU或TPU上;

- 定期監控和記錄:蹤訓練指標、資源使用和潛在瓶頸,可以用TensorBoard、Weights & Biases、MLflow等工具;

- 混合精度訓練:以減少內存使用并提高計算效率,可以顯著加快訓練速度并減少所需的內存占用;

- 評估和迭代:使用單獨的驗證集不斷評估模型性能,并根據結果對訓練過程進行迭代;

- 模型可重復:通過設置隨機種子并提供訓練過程的詳細記錄來確保可重復性,有助于調試和進一步開發。

微調技術

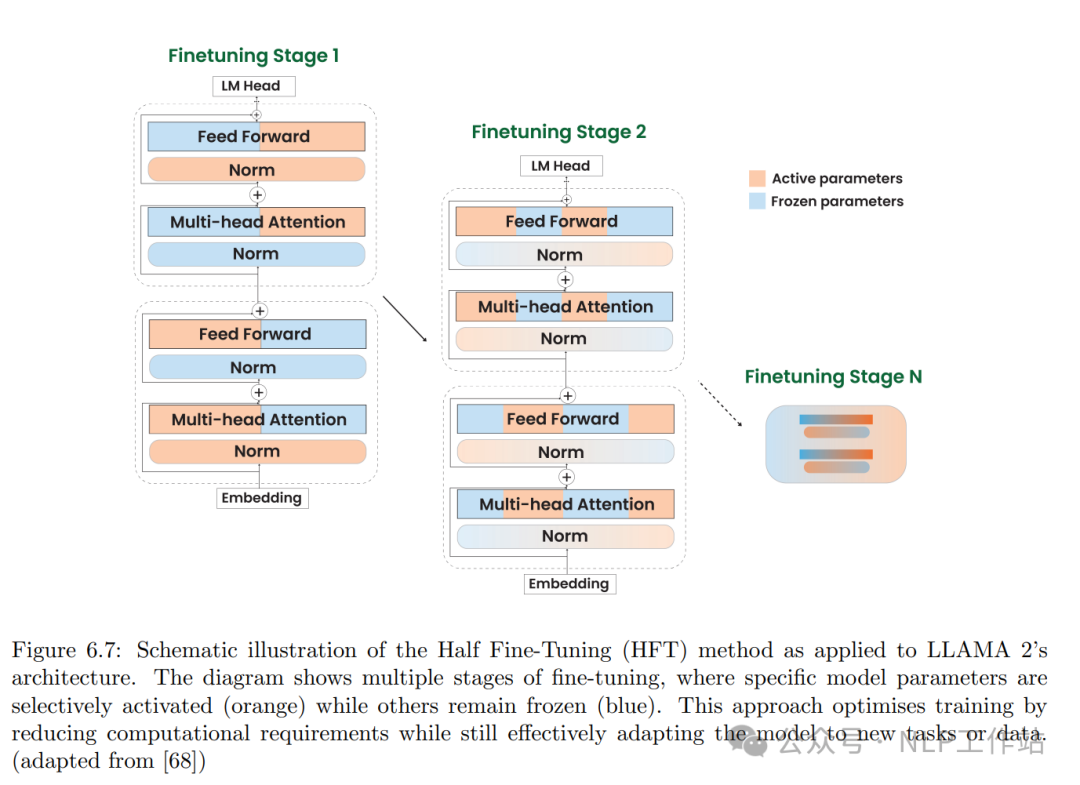

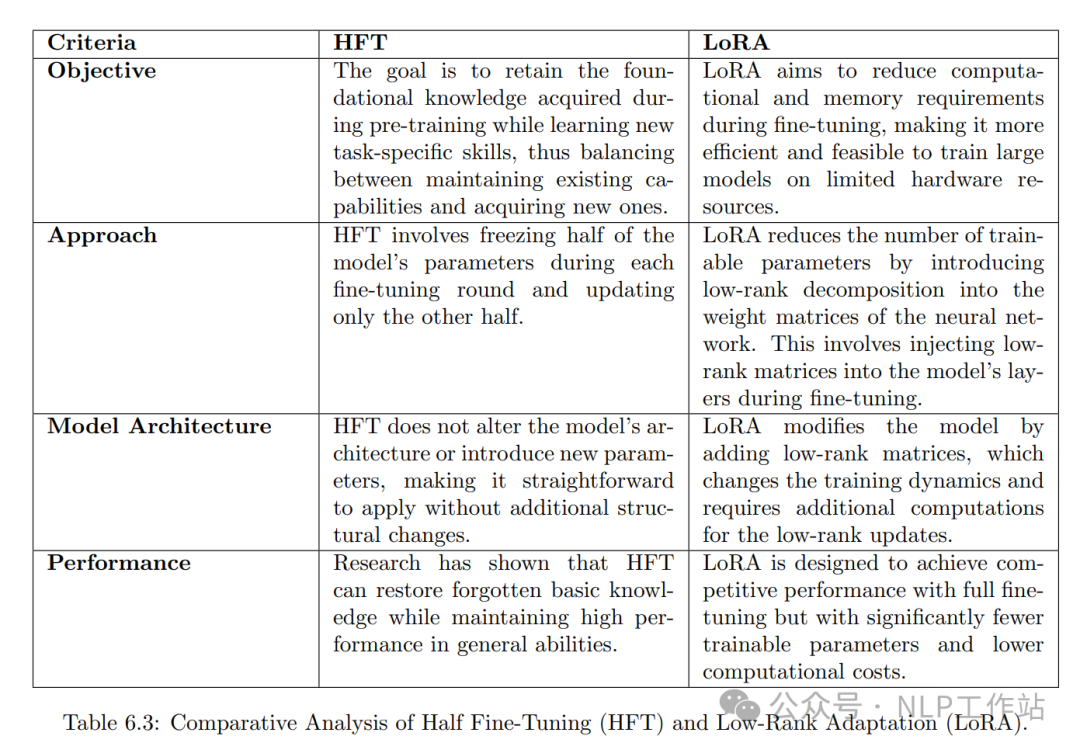

主要有特定任務的微調、特定領域的微調、參數高效微調、半微調、偏好對齊、MoE、MOA等。

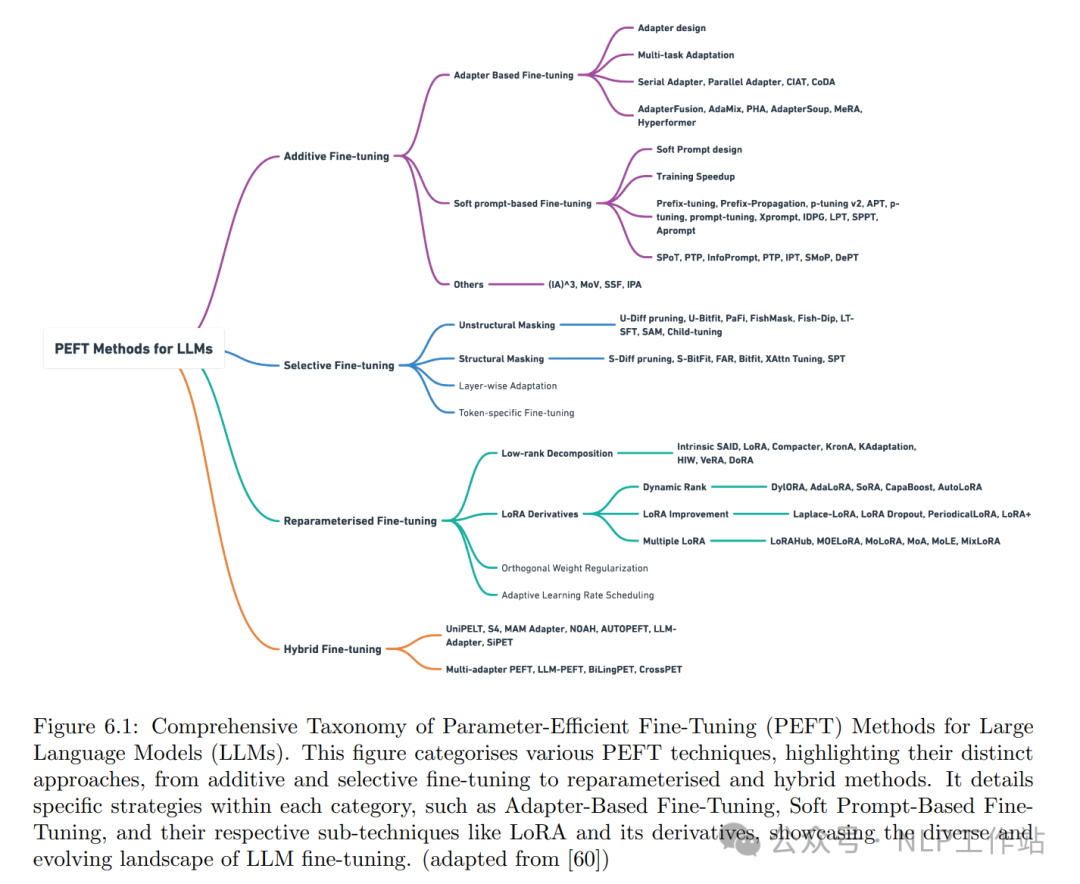

參數高效微調

評估和驗證

有效評估LLMs需要根據模型性能的各個方面指定一些特殊的評價指標:

- 困惑度:衡量概率分布或模型預測樣本的程度

- 事實性:評估LLM所提供信息的準確性

- LLM不確定性:利用每個生成令牌的對數概率,衡量模型輸出文本的置信度

- 提示困惑度:評估模型對輸入提示的理解程度

- 上下文相關性:衡量檢索到的上下文與用戶查詢的相關性

- 完整性:評估模型的響應是否根據提供的上下文完全回答了查詢

- Chuk歸屬和利用:評估檢索到的信息塊對最終響應的貢獻效果如何

- 數據錯誤潛力:量化了模型在學習訓練數據時面臨的困難,數據質量越高,錯誤潛力越低

- 安全指標:確保LLM的輸出適當且無害

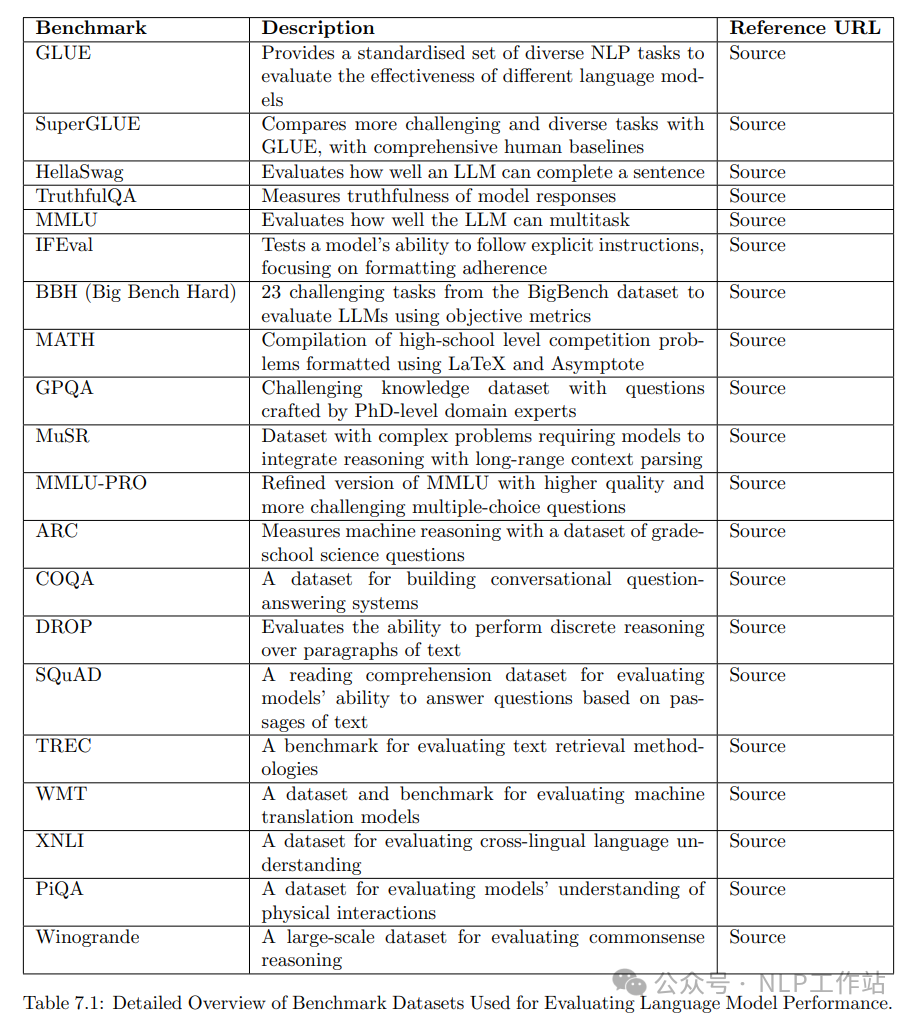

評測榜單

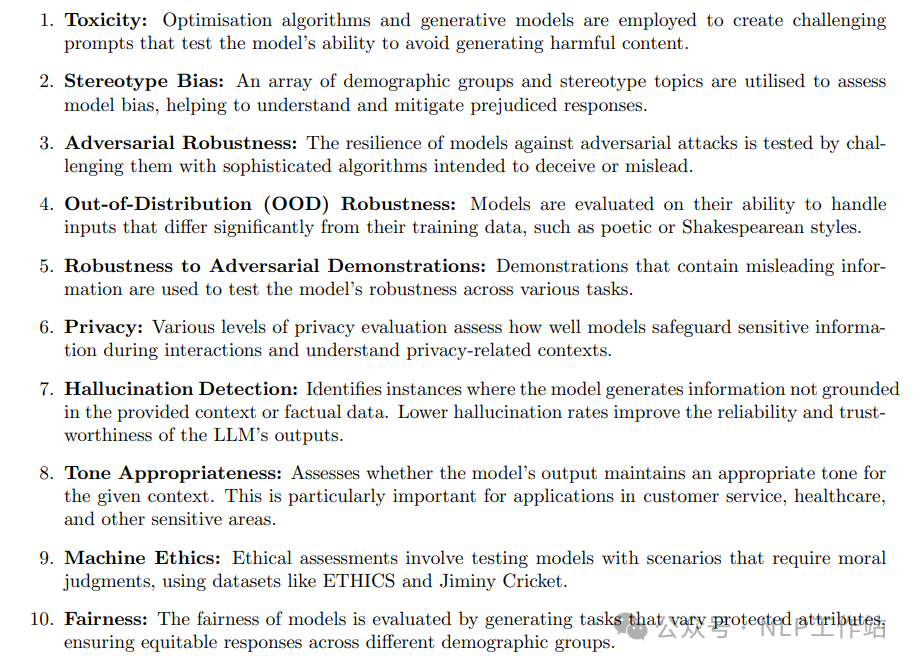

安全性評測指標

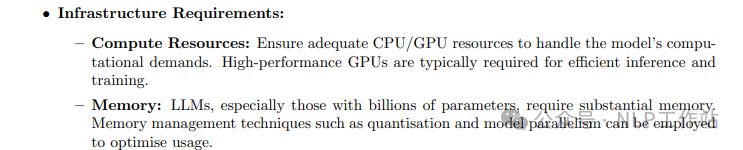

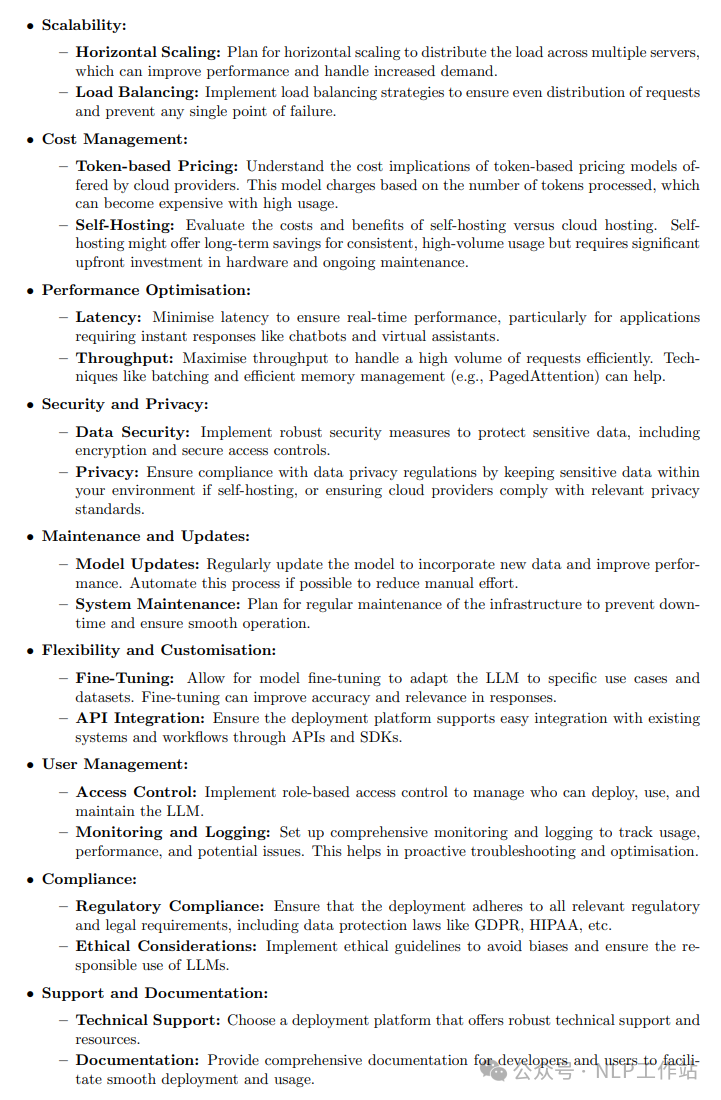

模型部署

本地部署、云平臺部署、分布式部署、模型量化等。

模型監控

性能監控、準確性監控、錯誤監控、日志分析、警報機制、反饋循環、安全監控、模型版本控制、提示詞監控、輸出結果監控、LLM知識更新等。

本文轉載自NLP工作站,作者:劉聰NLP ????

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦