大語言模型知識沖突的綜述 精華

一、結(jié)論寫在前面

論文來自:清華大學(xué),西湖大學(xué),香港中文大學(xué)

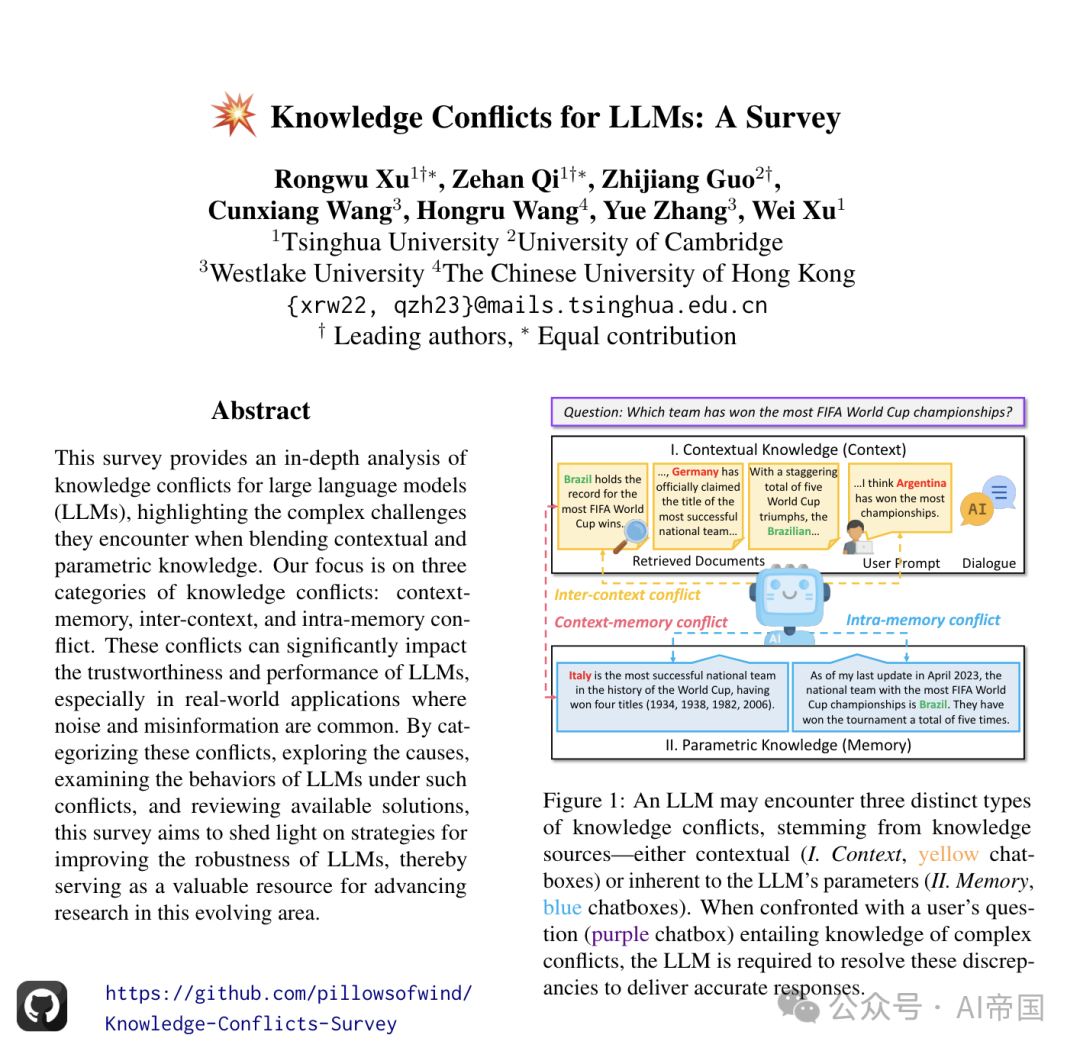

論文標(biāo)題:Knowledge Conflicts for LLMs: A Survey

論文鏈接:??https://arxiv.org/pdf/2403.08319??

論文廣泛探討了知識沖突,闡明了其分類、成因、LLMs對這些沖突的響應(yīng)方式及可能的解決方案,強調(diào)了在融合上下文知識和參數(shù)知識時所遇到的復(fù)雜挑戰(zhàn)。論文的研究重點是三類知識沖突:上下文-記憶沖突、跨上下文沖突和內(nèi)存內(nèi)沖突。這些沖突顯著影響LLMs的可信度和性能,特別是在現(xiàn)實世界應(yīng)用中,噪聲和錯誤信息普遍存在。通過分類這些沖突,探究其成因,檢查LLMs在這些沖突下的行為,并回顧現(xiàn)有解決方案,論文旨在為提高LLMs的魯棒性提供策略,從而成為推動這一不斷發(fā)展領(lǐng)域研究的重要資源。

?二、論文的簡單介紹

2.1 論文的背景?

將上下文知識集成到大型語言模型(LLMs)中能使它們跟上當(dāng)前事件,并生成更準(zhǔn)確的響應(yīng),但由于豐富的知識來源,也存在沖突的風(fēng)險。上下文與模型參數(shù)化知識之間的差異被稱為知識沖突。

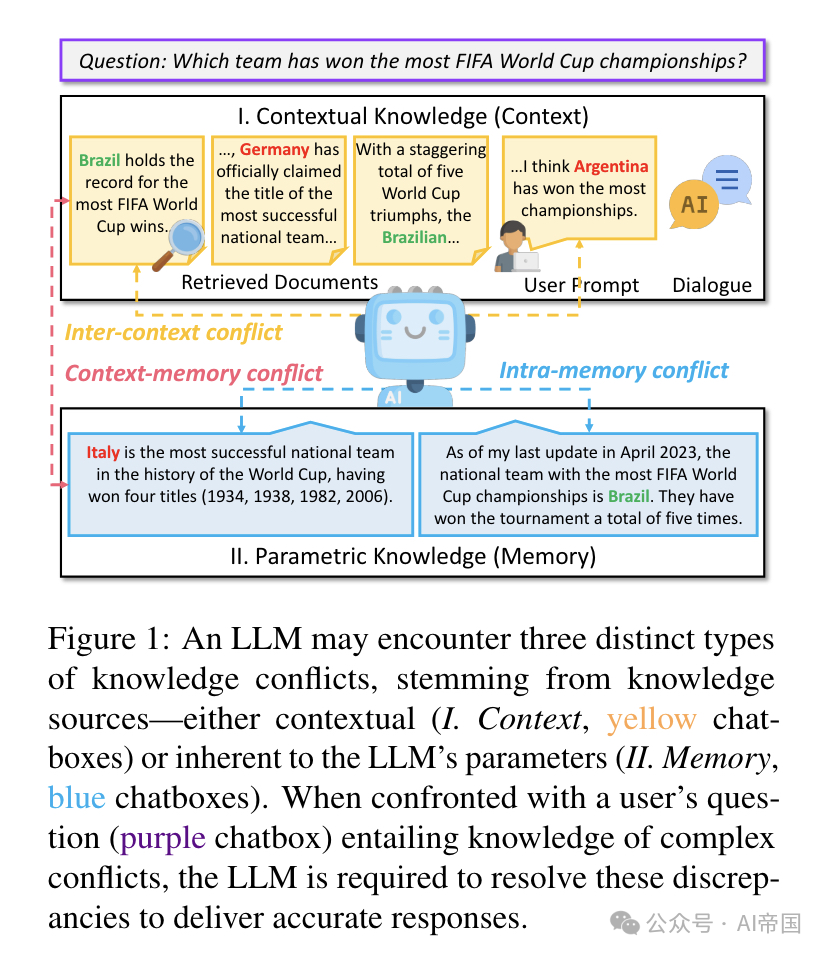

論文將知識沖突分為三種不同類型,如圖1所示。如圖1中的例子所示,當(dāng)使用LLM回答用戶問題時,用戶可能為LLM提供補充提示,而LLM也利用搜索引擎從網(wǎng)絡(luò)上收集相關(guān)文檔以增強其知識。用戶提示、對話歷史和檢索到的文檔的組合構(gòu)成了上下文知識(context)。上下文知識可能與LLM參數(shù)中包含的參數(shù)化知識(memory)發(fā)生沖突,論文稱之為上下文-記憶沖突(CM)。在現(xiàn)實場景中,外部文檔可能充滿噪音甚至是故意制造的錯誤信息,這使得它們難以準(zhǔn)確處理和響應(yīng)。論文將各種上下文知識之間的沖突稱為上下文間沖突(IC)。為了減少回答中的不確定性,用戶可能以不同形式提出問題。因此,LLM的參數(shù)化知識可能對這些不同表述的問題產(chǎn)生不同的回答。這種差異可歸因于LLM參數(shù)中嵌入的沖突知識,這些沖突源于復(fù)雜多樣的預(yù)訓(xùn)練數(shù)據(jù)集中存在的不一致性。這就產(chǎn)生了論文稱之為記憶內(nèi)沖突(IM)的情況。

知識沖突最初源于開放域問答研究。這個概念在Longpre等人(2021年)的研究中引起了關(guān)注,該研究聚焦于參數(shù)化知識與外部段落之間的基于實體的沖突。同時,多個段落之間的差異也隨后受到了仔細(xì)審查。隨著大型語言模型(LLMs)的最近出現(xiàn),知識沖突引起了極大的關(guān)注。例如,近期研究發(fā)現(xiàn)LLMs既堅持參數(shù)化知識,又容易受到上下文影響,當(dāng)這種外部知識在事實上不正確時,這可能會產(chǎn)生問題。考慮到這對LLMs的可信度、實時準(zhǔn)確性和穩(wěn)健性的影響,深入理解和解決知識沖突變得至關(guān)重要。

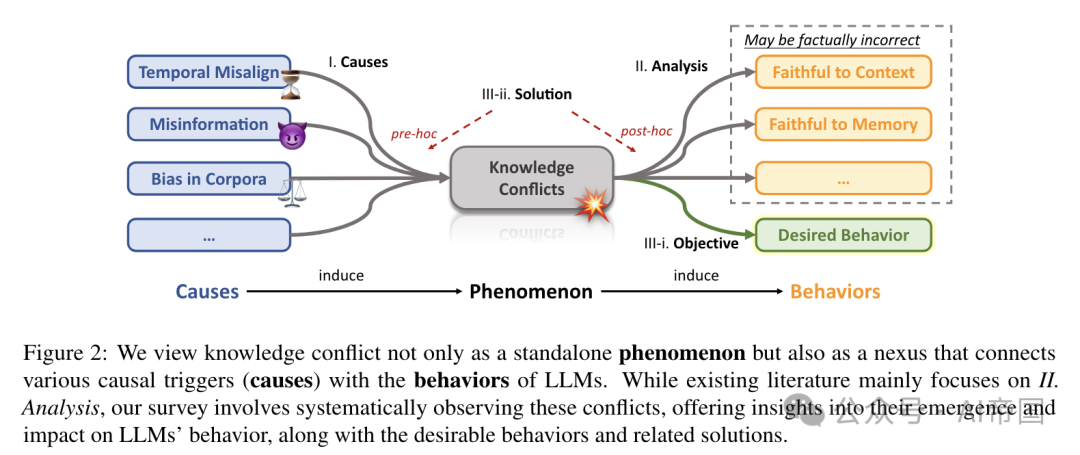

論文將知識沖突的生命周期概念化為導(dǎo)致各種行為的原因,同時也是源于知識復(fù)雜本質(zhì)的結(jié)果,如圖2所示。知識沖突作為原因和模型行為之間的重要中介。例如,它們顯著地導(dǎo)致模型生成事實上不正確的信息,即所謂的"幻覺"。論文的研究,以類似于弗洛伊德精神分析的方式,強調(diào)了理解這些沖突起源的重要性。盡管現(xiàn)有的分析傾向于人為構(gòu)建這些沖突,但論文認(rèn)為這些分析并未充分解決問題的相互關(guān)聯(lián)性。

除了回顧和分析原因和行為之外,論文更深入地提供了解決方案的系統(tǒng)性綜述,這些方案用于最小化知識沖突的不良后果,即鼓勵模型展現(xiàn)符合特定目標(biāo)的期望行為(請注意,這些目標(biāo)可能因特定場景而異)。基于與潛在沖突相對的時間,策略分為兩類:預(yù)先策略和事后策略。它們之間的關(guān)鍵區(qū)別在于是在潛在沖突出現(xiàn)之前還是之后進行調(diào)整。

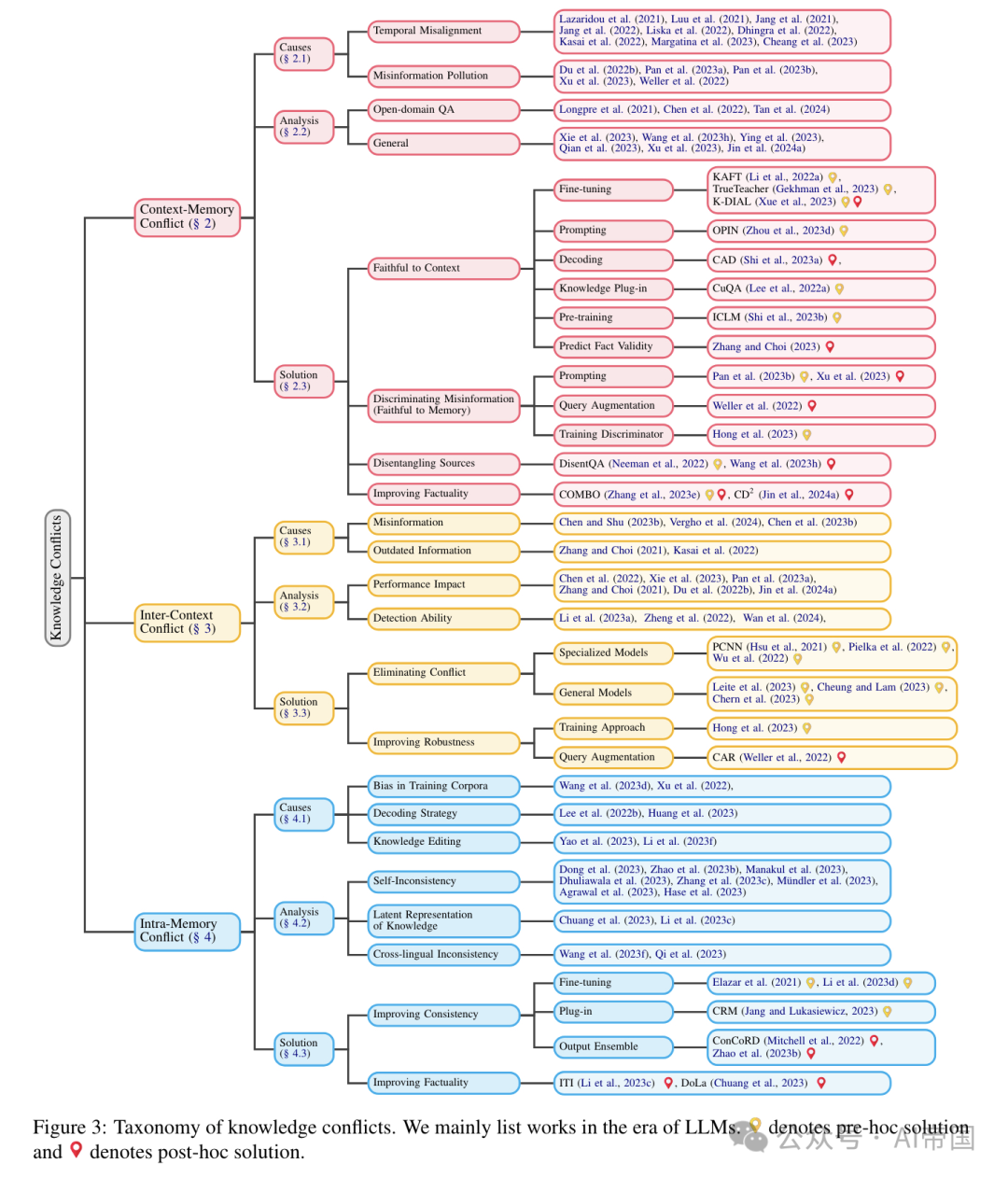

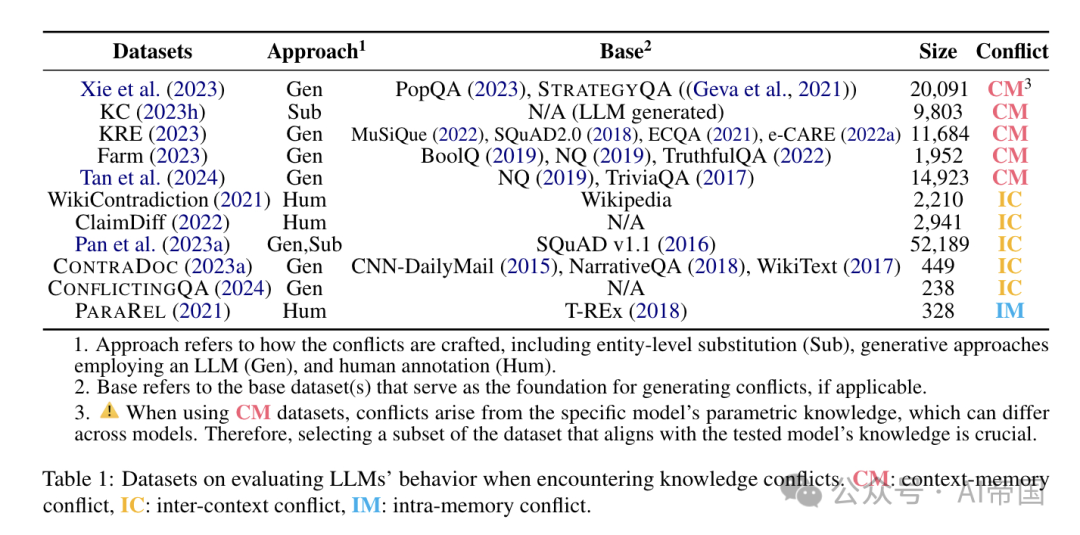

知識沖突的分類如圖3所示。論文依次討論三種知識沖突,詳細(xì)說明每種沖突的原因、模型行為分析,以及根據(jù)各自目標(biāo)組織的可用解決方案。相關(guān)數(shù)據(jù)集可在表1中找到。

圖1 展示了大型語言模型(LLM)可能遇到的三種不同類型的知識沖突,這些沖突源自知識來源——無論是上下文相關(guān)的(I. 上下文,黃色聊天框)還是固有于LLM參數(shù)中的(II. 記憶,藍(lán)色聊天框)。當(dāng)面對用戶的提問(紫色聊天框),涉及復(fù)雜的知識沖突時,LLM需要解決這些差異以提供準(zhǔn)確的回答

圖2:論文將知識沖突不僅視為一個獨立現(xiàn)象,而且視為連接各種因果觸發(fā)因素(原因)與大型語言模型(LLMs)行為的紐帶。盡管現(xiàn)有文獻主要關(guān)注

分析,論文的調(diào)查系統(tǒng)地觀察這些沖突,提供對其產(chǎn)生及對LLMs行為影響的洞察,以及期望行為和相關(guān)解決方案

圖 3:知識沖突的分類。論文主要列出了在大語言模型時代的工作。9 表示預(yù)先解決方案,而 9 表示事后解決方案

表1:評估大型語言模型在遇到知識沖突時的行為的數(shù)據(jù)集。CM:上下文-記憶沖突,IC:跨上下文沖突,IM:內(nèi)部記憶沖突

2.2 上下文-記憶沖突(Context-Memory Conflict)

上下文-記憶沖突是三種沖突中研究最廣泛的。大型語言模型(LLMs)的特點是其固定的參數(shù)知識,這是大量相關(guān)處理的結(jié)果。這種靜態(tài)的參數(shù)知識與外部信息的動態(tài)性質(zhì)形成鮮明對比,后者以快速的速度進化。

2.2.1 原因

上下文-記憶沖突的核心源于上下文與參數(shù)知識之間的差異。論文考慮兩個主要原因:時間錯位和錯誤信息污染。

時間錯位。時間錯位在以往數(shù)據(jù)訓(xùn)練的模型中自然出現(xiàn),因為它們可能無法準(zhǔn)確反映當(dāng)代或未來的現(xiàn)實情況(即部署后的上下文知識)。這種錯位會隨著時間的推移降低模型的性能和相關(guān)性,因為它可能無法捕捉新的趨勢、語言使用的變化、文化變遷或知識更新。研究者指出,時間錯位導(dǎo)致模型在各種 NLP 任務(wù)上的性能下降。此外,由于預(yù)訓(xùn)練范式和擴大模型規(guī)模相關(guān)成本的增加,時間錯位問題預(yù)計會加劇。

先前的工作試圖通過關(guān)注三種策略來解決時間錯位問題:

?知識編輯(KE)旨在直接更新現(xiàn)有預(yù)訓(xùn)練模型的參數(shù)知識。

?檢索增強生成(RAG)利用檢索模塊從外部資源(如數(shù)據(jù)庫、網(wǎng)絡(luò))獲取相關(guān)文檔,以補充模型的知識而不改變其參數(shù)。

?持續(xù)學(xué)習(xí)(CL)尋求通過在新數(shù)據(jù)和更新數(shù)據(jù)上持續(xù)預(yù)訓(xùn)練來更新內(nèi)部知識。然而,這些緩解時間錯位的方法并非萬能。

KE可能引入知識沖突的副作用,導(dǎo)致知識不一致(即一種內(nèi)部記憶沖突),甚至可能增強大型語言模型(LLMs)的幻覺。對于RAG,由于模型參數(shù)未更新,知識沖突不可避免(。CL面臨災(zāi)難性遺忘問題,并需要大量計算資源。

Context-Memory Conflict 作為導(dǎo)致上下文記憶沖突的另一個因素出現(xiàn),特別是對于模型已準(zhǔn)確學(xué)習(xí)的時間不變知識。對手通過在檢索文檔的網(wǎng)絡(luò)語料庫中引入虛假或誤導(dǎo)性信息來利用這一漏洞和用戶對話。后者構(gòu)成實際威脅,因為對手可以利用諸如提示注入攻擊等技術(shù)。這一漏洞構(gòu)成真實威脅,因為模型可能在不加審查地吸收欺騙性輸入的情況下無意中傳播虛假信息。

研究者觀察到,制造的惡意錯誤信息能顯著削弱自動化事實核查系統(tǒng)和開放領(lǐng)域問答模型的準(zhǔn)確性。此外,近期研究也強調(diào)了模型傾向于迎合用戶觀點,即所謂的“諂媚”,這進一步加劇了問題。在當(dāng)前的大型語言模型(LLMs)領(lǐng)域,自然語言處理(NLP)社區(qū)對于LLMs可能產(chǎn)生的錯誤信息日益擔(dān)憂。研究者認(rèn)識到檢測由LLMs生成的錯誤信息所面臨的挑戰(zhàn)。這突顯了在上下文錯誤信息的背景下,解決LLMs帶來的微妙挑戰(zhàn)的緊迫性。

2.2.2 模型行為的分析

LLMs如何處理上下文記憶沖突?本節(jié)將詳細(xì)介紹相關(guān)研究,盡管它們提供了相當(dāng)不同的答案。根據(jù)情景,論文首先介紹開放領(lǐng)域問答(ODQA)設(shè)置,然后關(guān)注一般設(shè)置。

ODQA:

?在早期的ODQA文獻中,Longpre等人(2021)探討了當(dāng)提供的上下文信息與已學(xué)習(xí)的信息相矛盾時,問答模型如何表現(xiàn)。作者們開發(fā)了一個自動化框架,該框架能夠識別出答案為命名實體的QA實例,并將黃金文檔中提及該實體的部分替換為另一個實體,從而創(chuàng)建沖突上下文。這項研究揭示了這些模型過度依賴參數(shù)知識的傾向。

?Chen等人(2022)重新審視了這一設(shè)置,并報告了不同的觀察結(jié)果,他們指出,在最佳表現(xiàn)設(shè)置中,模型主要依賴于上下文知識。他們將這種發(fā)現(xiàn)上的差異歸因于兩個因素。首先,Longpre等人(2021)使用的實體替換方法可能降低了受干擾段落的語義連貫性。其次,Longpre等人(2021)的研究基于單一證據(jù)段落,而Chen等人(2022)則利用了多個證據(jù)段落。

?最近,隨著ChatGPT(Ouyang等人, 2022; OpenAI, 2023)和Llama 2(Touvron等人, 2023)等早期大型語言模型的出現(xiàn),研究人員重新審視了這一問題。

?Tan等人(2024)研究了在ODQA設(shè)置中,LLM如何融合檢索到的上下文與生成的知識,并發(fā)現(xiàn)模型傾向于偏好參數(shù)知識,這是受到這些生成上下文與輸入問題更相似以及檢索信息往往不完整的影響,尤其是在沖突來源的范圍內(nèi)。

概述:

?Xie等人(2023年)利用大型語言模型(LLMs)生成與記憶知識相沖突的上下文。他們發(fā)現(xiàn),語言模型對與外部證據(jù)高度敏感,即使這些證據(jù)與其參數(shù)化知識相沖突,只要外部知識連貫且令人信服。同時,他們也識別出LLMs中存在強烈的確認(rèn)偏誤(Nickerson, 1998),即模型傾向于偏愛與內(nèi)部記憶一致的信息,即使面對沖突的外部證據(jù)。

?Wang等人(2023g)提出,當(dāng)LLM遇到?jīng)_突時,理想的行為應(yīng)該是準(zhǔn)確定位沖突并提供明確的答案。他們發(fā)現(xiàn),盡管LLMs在識別知識沖突的存在方面表現(xiàn)良好,但在確定具體的沖突片段并在沖突信息中產(chǎn)生明確答案時遇到困難。

?Ying等人(2023年)分析了LLMs在沖突情況下的魯棒性,重點關(guān)注兩個方面:事實魯棒性(從提示或記憶中識別正確事實的能力)和決策風(fēng)格(根據(jù)認(rèn)知理論將LLMs的行為分類為直覺型、依賴型或理性型)。研究發(fā)現(xiàn),LLMs極易受到誤導(dǎo)性提示的影響,尤其是在常識知識的背景下。

?Qian等人(2023年)更系統(tǒng)地評估了參數(shù)化知識與外部知識之間潛在的交互作用,合作知識圖譜(KG)。他們揭示,當(dāng)面對直接沖突或詳細(xì)上下文變化時,LLMs常常偏離其參數(shù)化知識。

?Xu等人(2023年)研究了大型語言模型(LLMs)在交互會話中如何應(yīng)對知識沖突。他們的發(fā)現(xiàn)表明,LLMs傾向于偏愛邏輯結(jié)構(gòu)化的知識,即使這與事實準(zhǔn)確性相矛盾。

2.2.3 解決方案

解決方案根據(jù)其目標(biāo)進行組織,即論文期望LLM在遇到?jīng)_突時表現(xiàn)出的預(yù)期行為。現(xiàn)有的策略可以歸類為以下目標(biāo):忠實于上下文的策略旨在與上下文知識保持一致,側(cè)重于上下文優(yōu)先級。鑒別錯誤信息的策略鼓勵對可疑上下文持懷疑態(tài)度,傾向于參數(shù)知識。分離來源的策略將上下文和知識分開處理,并提供解耦的答案。提高事實性的策略旨在利用上下文和參數(shù)知識整合回答,以實現(xiàn)更真實的解決方案。

忠實于上下文。

?微調(diào)。Li等人(2022a)認(rèn)為,LLM應(yīng)優(yōu)先考慮上下文中的任務(wù)相關(guān)信息,并在上下文無關(guān)時依賴內(nèi)部知識。他們將這兩種屬性稱為可控性和魯棒性。他們引入了知識感知微調(diào)(KAFT),通過將反事實和無關(guān)上下文納入標(biāo)準(zhǔn)訓(xùn)練數(shù)據(jù)集來加強這兩種屬性。Gekhman等人(2023)介紹了TrueTeacher,該方法通過使用LLM對模型生成的摘要進行標(biāo)注,專注于提高摘要的事實一致性。這種方法有助于保持對原始文檔上下文的忠誠度,確保生成的摘要準(zhǔn)確無誤,不會被無關(guān)或錯誤細(xì)節(jié)誤導(dǎo)。DIAL(Xue等人, 2023)專注于通過直接知識增強和RLFC(強化學(xué)習(xí)事實校驗)來提高對話系統(tǒng)的事實一致性,以準(zhǔn)確地使響應(yīng)與提供的事實知識對齊。

?提示策略。Zhou等人(2023d)探討了通過專門的提示策略增強大型語言模型(LLMs)對上下文的遵守,特別是基于意見的提示和反事實演示。這些技術(shù)通過確保LLMs忠實于相關(guān)上下文,顯著提高了在上下文敏感任務(wù)中的表現(xiàn),無需額外訓(xùn)練。

?解碼技術(shù)。Shi等人(2023a)引入了上下文感知解碼(Context-aware Decoding, CAD),通過放大有無上下文時的輸出概率差異來減少幻覺,這與對比解碼(Li等人,20220)的概念相似。CAD通過有效地優(yōu)先考慮相關(guān)上下文而非模型的先驗知識,特別是在信息沖突的任務(wù)中,增強了LLMs的忠實度。

?知識插件。Lee等人(2022a)提出了持續(xù)更新的問答(Continuously-updated QA, CuQA),以提高語言模型(LMs)整合新知識的能力。他們的方法使用即插即用模塊來存儲更新的知識,確保原始模型不受影響。與傳統(tǒng)的持續(xù)預(yù)訓(xùn)練或微調(diào)方法不同,CuQA能夠解決知識沖突。

?預(yù)訓(xùn)練。ICLM(Shi等人,2023b)是一種新的預(yù)訓(xùn)練方法,擴展了LLMs處理跨多個文檔的長而多變的上下文的能力。這種方法通過使模型能夠從更廣泛的上下文中綜合信息,可能有助于解決知識沖突,從而提高對相關(guān)知識的理解和應(yīng)用。

?預(yù)測事實有效性。Zhang和Choi(2023)通過引入事實持續(xù)時間預(yù)測來識別并丟棄LLMs中的過時事實,解決了知識沖突問題。這種方法通過確保遵守最新的上下文信息,提高了在開放域問答(ODQA)等任務(wù)中的模型性能。

辨別錯誤信息(忠于記憶)。

?提示。為了應(yīng)對錯誤信息污染,Pan等人(2023b)提出了諸如錯誤信息檢測和警覺提示等防御策略,旨在增強模型在潛在錯誤信息中保持對事實、參數(shù)化信息忠實的能力。同樣,Xu等人(2023)利用系統(tǒng)提示提醒大型語言模型(LLM)對潛在錯誤信息保持謹(jǐn)慎,并在回應(yīng)前驗證其記憶的知識。這種方法旨在提升LLM保持忠實性的能力。

?查詢增強。Weller等人(2022)利用大型語料庫中信息冗余性來防御錯誤信息污染。他們的方法涉及查詢增強以找到一組多樣化的不太可能被污染的段落,并結(jié)合一種名為“答案冗余信心”(CAR)的方法,該方法比較預(yù)測答案在檢索上下文中的連貫性。這一策略通過確保模型在多個來源中交叉驗證答案的忠實性來緩解知識沖突。訓(xùn)練鑒別器:Hong等人(2023)對一個較小的語言模型進行微調(diào),作為鑒別器,并結(jié)合提示技術(shù),發(fā)展模型的能力以區(qū)分可靠與不可靠信息,幫助模型在面對誤導(dǎo)性上下文時保持忠實。

分離來源。DisentQA(Neeman等人,2022)訓(xùn)練一個模型,為給定問題預(yù)測兩種類型的答案:一種基于上下文知識,另一種基于參數(shù)化知識。Wang等人(2023g)引入了一種方法來改進LLM處理知識沖突的能力。他們的方法是一個三步流程,旨在幫助LLM檢測沖突、準(zhǔn)確識別沖突段落,并基于沖突數(shù)據(jù)生成明確的、有根據(jù)的回應(yīng),旨在產(chǎn)生更精確和細(xì)致的模型輸出。

提高事實準(zhǔn)確性。Zhang等人(2023e)提出了COMBO框架,該框架通過匹配兼容的生成和檢索段落來解決差異。它使用在銀標(biāo)上訓(xùn)練的判別器來評估段落兼容性,通過利用LLM生成的(參數(shù)化)和外部檢索的知識來提高開放域問答(ODQA)的性能。Jin等人(2024a)引入了一種基于對比解碼的算法,即CD?,該算法在知識沖突下最大化不同邏輯之間的差異,并校準(zhǔn)模型對真實答案的信心。

2.3 上下文間沖突(Inter-Context Conflict)

上下文間沖突在LLMs中體現(xiàn)為整合外部信息源時出現(xiàn)的問題,這一挑戰(zhàn)因RAG技術(shù)的出現(xiàn)而加劇。RAG通過將檢索到的文檔內(nèi)容整合到上下文中來豐富LLM的響應(yīng)。然而,這種整合可能導(dǎo)致提供上下文內(nèi)的不一致,因為外部文檔可能包含相互沖突的信息。

2.3.1 原因

錯誤信息。錯誤信息一直是現(xiàn)代數(shù)字時代的一個重大關(guān)切。RAG的出現(xiàn)引入了一種新的方法,通過整合外部文檔來提高LLMs的生成質(zhì)量。雖然這種方法有可能通過多樣化的知識源豐富內(nèi)容,但也帶來了包含錯誤信息文檔的風(fēng)險,如假新聞。此外,已有案例表明AI技術(shù)被用于創(chuàng)建或傳播錯誤信息。LLMs的先進生成能力加劇了這一問題,導(dǎo)致這些系統(tǒng)生成的錯誤信息增加。這一趨勢令人擔(dān)憂,因為它不僅助長了錯誤信息的傳播,還挑戰(zhàn)了檢測由LLMs生成的錯誤信息的能力。

過時信息。除了錯誤信息的挑戰(zhàn)外,認(rèn)識到事實隨時間變化,這一點也很重要。檢索到的文檔可能同時包含來自網(wǎng)絡(luò)的更新信息和過時信息,導(dǎo)致這些文檔之間出現(xiàn)沖突。

2.3.2 模型行為分析

性能影響。先前的研究實證表明,預(yù)訓(xùn)練語言模型的性能可以顯著受到特定上下文中錯誤信息(Zhang 和 Choi,2021)或過時信息(Du 等人,2022b)的存在的影響。

?在最近的研究中,Pan 等人(2023a)引入了一種錯誤信息攻擊策略,涉及創(chuàng)建維基百科文章的偽造版本,隨后將其插入到真實的維基百科語料庫中。他們的研究結(jié)果揭示,現(xiàn)有的語言模型容易受到錯誤信息攻擊,無論假文章是手工制作還是模型生成的。

?為了深入了解LLMs在遇到矛盾上下文時的行為,Chen 等人(2022)主要使用解碼器中的融合技術(shù)在NQ-Open(Kwiatkowski 等人,2019)和TriviaQA(Joshi 等人,2017)上進行實驗。他們發(fā)現(xiàn),跨知識源的不一致對模型的置信度影響最小。這些模型傾向于偏好與查詢直接相關(guān)的上下文和與模型固有參數(shù)知識一致的上下文。

?Xie 等人(2023)在POPQA(Mallen 等人,2022)和STRATEGYQA(Geva 等人,2021)上對閉源LLMs和開源LLMs進行了實驗。得到的結(jié)果與Chen 等人(2022)的結(jié)果一致,表明LLMs對與模型參數(shù)記憶一致的證據(jù)表現(xiàn)出顯著的偏見。他們還發(fā)現(xiàn),LLMs傾向于強調(diào)與更高知名度實體相關(guān)的信息和在給定上下文中由更大體積文檔證實的答案。

?此外,這些模型對數(shù)據(jù)引入的順序表現(xiàn)出顯著的敏感性。Jin 等人(2024a)發(fā)現(xiàn),隨著沖突跳數(shù)的增加,LLMs在推理方面遇到更大的挑戰(zhàn)。

Detection Ability 在評估大型語言模型(LLMs)面對矛盾上下文時的表現(xiàn)之外,多項研究還探討了它們識別此類矛盾的能力。

?鄭等人(2022)檢驗了包括BERT、RoBERTa和ERNIE在內(nèi)的多種模型在識別中文對話中矛盾陳述的表現(xiàn)。其實驗結(jié)果顯示,識別對話中的矛盾語句對這些模型來說是一個重大挑戰(zhàn)。

?李等人(2023a)分析了GPT-4、ChatGPT、PaLM-2和Llama 2在識別新聞文章(Hermann et al., 2015)、故事(Kocisky et al., 2018)及維基百科(Merity et al., 2017)中矛盾文檔的表現(xiàn)。研究者發(fā)現(xiàn),平均檢測準(zhǔn)確率不盡如人意。該研究還指出,LLMs在處理特定類型的矛盾時面臨特殊挑戰(zhàn),尤其是涉及主觀情感或觀點的矛盾。

?此外,文檔的長度和自相矛盾的多樣性對檢測性能的影響較小。萬等人(2024)研究了影響LLMs在面對沖突信息時評估文檔可信度的文本特征。他們發(fā)現(xiàn),現(xiàn)有模型嚴(yán)重偏向于文檔與查詢的相關(guān)性,但往往忽視了人類認(rèn)為重要的風(fēng)格特征,如文本中科學(xué)引用的存在或中立語調(diào)。

?金等人(2024a)發(fā)現(xiàn),LLMs在區(qū)分真實信息與虛假信息方面存在困難。此外,他們發(fā)現(xiàn)LLMs傾向于支持在上下文中出現(xiàn)頻率最高的證據(jù),并對外部信息表現(xiàn)出確認(rèn)偏誤,這些信息與其內(nèi)部記憶相符。

2.3.3解決方案

消除沖突。專業(yè)化模型。Hsu等人(2021)開發(fā)了一種名為成對矛盾神經(jīng)網(wǎng)絡(luò)(PCNN)的模型,利用微調(diào)的Sentence-BERT嵌入來計算文章之間的矛盾概率。Pielka等人(2022)建議將語言學(xué)知識融入學(xué)習(xí)過程中,基于發(fā)現(xiàn)XLM-RoBERTa難以有效掌握對于準(zhǔn)確矛盾檢測至關(guān)重要的句法和語義特征。Wu等人(2022)提出了一種創(chuàng)新方法,將文本的拓?fù)浔硎菊系秸Z言模型中,以增強矛盾檢測能力,并在MultiNLI數(shù)據(jù)集(Williams等人,2018)上評估了他們的方法。

通用模型。Chern等人(2023)提出了一種事實核查框架,該框架將大型語言模型(LLMs)與各種工具(包括Google搜索、Google Scholar、代碼解釋器和Python)集成,用于檢測文本中的事實錯誤。Leite等人(2023)利用LLMs為輸入文本生成與預(yù)定義可信度信號相關(guān)的弱標(biāo)簽,并通過弱監(jiān)督技術(shù)聚合這些標(biāo)簽,以對輸入的真實性做出預(yù)測。

提高魯棒性。訓(xùn)練方法。Hong等人(2023)提出了一種新穎的微調(diào)方法,涉及同時訓(xùn)練一個判別器和一個解碼器,使用共享的編碼器。此外,作者還引入了另外兩種策略來提高模型的魯棒性,包括提示GPT-3在生成響應(yīng)之前識別受擾動的文檔,以及將判別器的輸出整合到GPT-3的提示中。他們的實驗結(jié)果表明,微調(diào)方法產(chǎn)生了最令人滿意的結(jié)果。

查詢增強技術(shù) 如Augmentin等人(2023)所述,通過提示GPT-3根據(jù)原始查詢生成新的問題。隨后,他們通過參考檢索到的相應(yīng)段落來評估每個問題答案的置信度。基于這種置信度,他們決定是依賴原始問題的預(yù)測,還是匯總來自增強問題且置信度得分高的預(yù)測。

2.4 內(nèi)部記憶沖突(Intra-Memory Conflict)?

隨著LLMs的發(fā)展,LLMs被廣泛應(yīng)用于知識密集型問答系統(tǒng)(Gao等人,2023b;Yu等人,2022;Petroni等人,2019;Chen等人,2023c)。有效部署LLMs的一個關(guān)鍵方面是確保它們對具有相似含義或意圖的各種表達產(chǎn)生一致的輸出。盡管有此必要,但內(nèi)部記憶沖突——LLMs對語義上等效但句法上不同的輸入表現(xiàn)出不可預(yù)測的行為并生成不同響應(yīng)的情況——成為一個顯著挑戰(zhàn)(Chang和Bergen,2023;Chen等人,2023a;Raj等人,2023;Rabinovich等人,2023;Raj等人,2022;Bartsch等人,2023)。內(nèi)部記憶沖突實質(zhì)上通過在其輸出中引入不確定性,削弱了LLMs的可靠性和實用性。

2.4.1 原因

LLMs中的內(nèi)部記憶沖突可歸因于三個主要因素:訓(xùn)練語料庫偏差(Wang等人,2023d;Xu等人,2022)、解碼策略(Lee等人,2022b;Huang等人,2023)和知識編輯(Yao等人,2023;Li等人,2023f)。這些因素分別涉及訓(xùn)練階段、推理階段和隨后的知識精煉。

訓(xùn)練語料庫中的偏差。最近的研究表明,大型語言模型(LLMs)知識獲取的主要階段主要發(fā)生在預(yù)訓(xùn)練階段(Zhou et al., 2023a; Kaddour et al., 2023; Naveed et al., 2023; Akyiüirek et al., 2022; Singhal et al., 2022)。預(yù)訓(xùn)練語料庫主要從互聯(lián)網(wǎng)上爬取,數(shù)據(jù)質(zhì)量多樣,可能包含不準(zhǔn)確或誤導(dǎo)性信息(Bender et al., 2021; Weidinger et al., 2021)。當(dāng)LLMs在包含錯誤知識的數(shù)據(jù)上訓(xùn)練時,它們可能會記憶并無意中放大這些不準(zhǔn)確之處(Lin et al., 2022; Elazar et al., 2022; Lam et al., 2022; Grosse et al., 2023),導(dǎo)致LLMs參數(shù)內(nèi)部沖突知識并存的情況。

此外,先前的工作表明,LLMs傾向于在其訓(xùn)練數(shù)據(jù)中編碼普遍存在的表面關(guān)聯(lián),而不是真正理解其中包含的基礎(chǔ)知識(Li et al., 2022b; Kang and Choi, 2023; Zhao et al., 2023a; Kandpal et al., 2023)。這可能導(dǎo)致LMs表現(xiàn)出一種傾向,即基于訓(xùn)練數(shù)據(jù)的虛假相關(guān)性生成預(yù)定響應(yīng)。由于依賴于虛假相關(guān)性,當(dāng)面對具有不同句法結(jié)構(gòu)但傳達相同語義意義的提示時,LLMs可能會提供不同的答案。

解碼策略。大型語言模型(LLMs)的直接輸出是對潛在下一個詞的概率分布。從這一分布中抽樣是確定生成內(nèi)容的關(guān)鍵步驟。已提出了多種抽樣技術(shù),包括貪心抽樣、top-p抽樣、top-k抽樣等(Jawahar et al., 2020; Massarelli et al., 2020),大致可分為確定性和隨機性抽樣方法。隨機抽樣作為LLMs普遍采用的解碼策略(Fan et al., 2018; Holtzman et al., 2020)。然而,隨機抽樣方法的隨機性引入了生成內(nèi)容的不確定性。此外,由于LLMs固有的從左到右生成模式,抽樣詞的選擇對后續(xù)生成內(nèi)容具有重大影響。使用隨機抽樣可能導(dǎo)致LLMs在相同上下文下產(chǎn)生完全不同的內(nèi)容,引發(fā)內(nèi)部記憶沖突(Lee et al., 2022b; Huang et al., 2023; Dziri et al., 2021)。

知識編輯。隨著模型參數(shù)的指數(shù)級增長,微調(diào)LLMs變得越來越困難且資源密集。針對這一挑戰(zhàn),研究者探索了知識編輯技術(shù),作為高效修改LLMs中編碼知識的一小部分的方法(Meng et al., 2022; Ilharco et al., 2022; Zhong et al., 2023)。確保修改的一致性是一個重大挑戰(zhàn)。由于編輯方法可能存在的局限性,修改后的知識無法有效泛化。這可能導(dǎo)致LLMs在處理不同情境下相同知識時產(chǎn)生不一致的響應(yīng)(Li et al., 2023f; Yao et al., 2023)。內(nèi)部記憶沖突主要被視為知識編輯過程中的副作用。

備注:大型語言模型(LLMs)中的內(nèi)存內(nèi)部沖突源于三個不同階段的獨特原因。在這些原因中,訓(xùn)練語料庫偏差尤為突出,是這些沖突的根本催化劑。訓(xùn)練數(shù)據(jù)集中知識的矛盾導(dǎo)致模型參數(shù)內(nèi)編碼的知識不一致。此外,解碼策略間接加劇了這些沖突。推理過程中采樣過程的固有隨機性放大了模型響應(yīng)中的不一致性。知識編輯旨在對模型的知識進行后更新,但可能無意中將沖突信息引入LLM的內(nèi)存中。

2.4.2 模型行為的分析

自相矛盾。Elazar等人(2021)開發(fā)了一種評估語言模型知識一致性的方法,特別關(guān)注知識三元組。研究者主要使用BERT、RoBERTa和ALBERT進行實驗。結(jié)果顯示,這些模型的準(zhǔn)確率僅在50%至60%之間,表現(xiàn)出較差的一致性。Hase等人(2023)采用了Elazar等人(2021)相同的指標(biāo),但使用了更多樣化的數(shù)據(jù)集。他們的研究也揭示了RoBERTa-base和BART-base在改寫上下文中的不一致性。Zhao等人(2023b)重新表述問題,然后評估LLM對這些重新表述問題的響應(yīng)的一致性。研究發(fā)現(xiàn),即使在常識性問答任務(wù)中,GPT-4也顯示出13%的顯著不一致率。他們進一步發(fā)現(xiàn),LLMs在面對不常見知識時更容易產(chǎn)生不一致。Dong等人(2023)對多個開源LLMs進行了實驗,發(fā)現(xiàn)所有這些模型都表現(xiàn)出強烈的不一致性。Li等人(2023d)探討了LLMs可能給出的初始答案與隨后否認(rèn)先前答案的不一致性。研究者專注于閉卷問答實驗,揭示了Alpaca-30B僅在50%的情況下表現(xiàn)出一致性。

為了進一步分析大型語言模型(LLMs)表現(xiàn)出的不一致性,Li等人(2022b)進行的一項研究發(fā)現(xiàn),基于編碼器的模型更依賴于位置上接近且高度共現(xiàn)的詞匯來生成錯誤的事實性詞匯,而不是依賴于知識相關(guān)的詞匯。這種現(xiàn)象是由于這些模型傾向于從訓(xùn)練數(shù)據(jù)集中過度學(xué)習(xí)不恰當(dāng)?shù)年P(guān)聯(lián)。Kang和Choi(2023)強調(diào)了LLMs中的共現(xiàn)偏差,其中模型傾向于偏好頻繁共現(xiàn)的詞匯而非正確答案,尤其是在回憶事實時,即使經(jīng)過微調(diào),主題和對象在預(yù)訓(xùn)練數(shù)據(jù)集中很少共現(xiàn)的情況下。此外,他們的研究表明,即使在微調(diào)過程中遇到這些事實,LLMs在主題和對象很少一起出現(xiàn)在預(yù)訓(xùn)練數(shù)據(jù)集中的情況下回憶事實仍然面臨挑戰(zhàn)。

知識潛表示。當(dāng)代LLMs固有的多層變換器架構(gòu)促進了復(fù)雜的內(nèi)部記憶沖突,不同的知識表示散布在各個層次。先前的研究建議,LLMs在較淺層次存儲低級信息,在較深層次存儲語義信息(Tenney et al., 2019; Rogers et al., 2020; Wang et al., 2019; Jawahar et al., 2019; Cui et al., 2020)。Chuang等人(2023)在LLMs的背景下探討了這一點,并發(fā)現(xiàn)LLMs中的事實知識通常集中在特定的變換器層和不同層的不一致知識中。此外,Li等人(20230)發(fā)現(xiàn),正確的知識確實存儲在模型的參數(shù)中,但在生成過程中可能無法準(zhǔn)確表達。作者對同一LLM進行了兩項實驗,一項關(guān)注生成準(zhǔn)確性,另一項使用知識探針來檢查知識的包含情況。這些實驗的結(jié)果顯示,知識探針準(zhǔn)確性與生成準(zhǔn)確性之間存在顯著的40%差異。

跨語言不一致性 真正的知識普遍性超越了表面形式的變異(Ohmer 等人,2023),這一原則理想上應(yīng)適用于大型語言模型(LLMs)。然而,LLMs 對不同語言保持了不同的知識集,導(dǎo)致了不一致性(Ji 等人,2023)。Wang 等人(2023e)研究了 LLMs 在跨語言擴展編輯知識時面臨的挑戰(zhàn),表明與不同語言相關(guān)的知識在模型參數(shù)中被單獨存儲。Qi 等人(2023)提出了一種名為 RankC 的度量標(biāo)準(zhǔn),用于評估 LLMs 事實知識的跨語言一致性。他們利用這一度量分析了多個模型,并揭示了 LLMs 存儲的知識中存在明顯的語言依賴性,且隨著模型規(guī)模的增加,跨語言一致性并未觀察到改善。

備注 LLMs 中的內(nèi)存間沖突現(xiàn)象主要通過對語義相同查詢的不一致響應(yīng)來體現(xiàn)。這種不一致性主要歸因于預(yù)訓(xùn)練階段使用的數(shù)據(jù)集質(zhì)量不佳。解決這一挑戰(zhàn)需要開發(fā)高效且成本有效的解決方案,這仍然是一個重大障礙。此外,LLMs 的特點是存在多個知識電路,這些電路對其對特定查詢的響應(yīng)機制有顯著影響。探索和詳細(xì)檢查 LLMs 內(nèi)部的知識電路代表了一個有前景的未來研究方向。

?2.4.3解決方案

2.4.3.1 提高一致性?

微調(diào)。Elazar 等人(2021)提出了一種一致性損失函數(shù),并使用一致性損失與標(biāo)準(zhǔn) MLM 損失的組合來訓(xùn)練語言模型。Li 等人(2023d)利用一種語言模型在雙重能力下運作:作為生成器產(chǎn)生響應(yīng),并作為驗證器評估這些響應(yīng)的準(zhǔn)確性。該過程涉及向生成器查詢響應(yīng),隨后由驗證器評估其準(zhǔn)確性。只有那些被認(rèn)為一致的響應(yīng)對被保留。這一組一致的響應(yīng)對隨后用于微調(diào)模型,旨在增加生成一致響應(yīng)對的概率。

插件。Jang 和 Lukasiewicz(2023)利用中間訓(xùn)練技術(shù),使用詞典中的詞-定義對重新訓(xùn)練語言模型,以提高其對符號意義的理解。隨后,他們提出了一種高效的參數(shù)集成方法,將這些增強的參數(shù)與現(xiàn)有語言模型的參數(shù)合并。這種方法旨在通過增強模型理解意義的能力來糾正模型的不一致行為。

輸出集成。Mitchell等人(2022)提出了一種通過采用雙模型架構(gòu)來減輕語言模型不一致性的方法,該架構(gòu)涉及使用一個基礎(chǔ)模型負(fù)責(zé)生成一組潛在答案,隨后由關(guān)系模型評估這些答案之間的邏輯一致性。最終答案的選擇考慮了基礎(chǔ)模型和關(guān)系模型的信念。Zhao等人(2023b)引入了一種方法來檢測問題是否可能導(dǎo)致大型語言模型(LLMs)的不一致性。具體而言,他們首先使用LLMs重述原始問題并獲得相應(yīng)的答案,然后對這些答案進行聚類并檢查分歧程度。檢測結(jié)果基于分歧水平確定。

2.4.3.2 提高事實性

Chuang等人(2023)提出了一種名為DoLa的新型對比解碼方法。具體地,作者開發(fā)了一種動態(tài)層選擇策略,選擇適當(dāng)?shù)脑缙趯雍统墒鞂印=酉聛韱卧~的輸出概率通過計算早期層和成熟層對數(shù)概率的差異來確定。Li等人(2023c)提出了一種類似的方法名為ITI。他們首先識別出一批稀疏的注意力頭,這些頭在TruthfulQA(Lin等人,2022)衡量的事實性方面表現(xiàn)出高線性探測準(zhǔn)確性。在推理階段,ITI沿著通過知識探測獲得的與事實相關(guān)的方向調(diào)整激活,這種干預(yù)在完成過程中對每個令牌進行自回歸重復(fù)。DoLa和ITI都針對模型不同層之間的知識不一致性,以減少LLMs中的事實錯誤。

本文轉(zhuǎn)載自 ??AI帝國??,作者: 無影寺