港科大新SOTA丨大語言模型在通用視覺定位中的能力(LLM-Optic) 原創(chuàng)

?摘要:視覺定位是將用戶提供的文本查詢與圖像中特定區(qū)域鏈接起來的基本工具。盡管視覺定位模型取得了一定進(jìn)展,但它們在理解復(fù)雜查詢方面的能力仍然有限。為了解決這一限制,我們引入了LLM-Optic,這是一種創(chuàng)新方法,利用大型語言模型(LLM)作為光學(xué)透鏡來增強(qiáng)現(xiàn)有視覺定位模型對涉及復(fù)雜文本結(jié)構(gòu)、多對象或?qū)ο罂臻g關(guān)系的復(fù)雜文本查詢的理解能力——這些情況是當(dāng)前模型難以應(yīng)對的。LLM-Optic首先使用LLM作為文本定位器來解釋復(fù)雜的文本查詢,并準(zhǔn)確識(shí)別用戶意圖定位的對象。然后,利用預(yù)訓(xùn)練的視覺定位模型,根據(jù)文本定位器優(yōu)化后的查詢生成候選的邊界框。接下來,LLM-Optic通過數(shù)值標(biāo)記對候選邊界框進(jìn)行注釋,以在文本和特定圖像區(qū)域之間建立連接,從而鏈接兩種不同的模態(tài)。最后,利用大型多模態(tài)模型(LMM)作為視覺定位器,選擇與原始文本查詢最匹配的標(biāo)記候選對象。通過LLM-Optic,我們實(shí)現(xiàn)了通用視覺定位,能夠檢測由任意人類語言輸入指定的任意對象。重要的是,我們的方法無需額外的訓(xùn)練或微調(diào)即可實(shí)現(xiàn)這一增強(qiáng)。大量不同挑戰(zhàn)基準(zhǔn)上的實(shí)驗(yàn)表明,LLM-Optic實(shí)現(xiàn)了最先進(jìn)的零樣本視覺定位能力。項(xiàng)目頁面:[https://haoyu-zhao.github.io/LLM-Optic.github.io/](https://haoyu-zhao.github.io/LLM-Optic.github.io/)。

1 引言

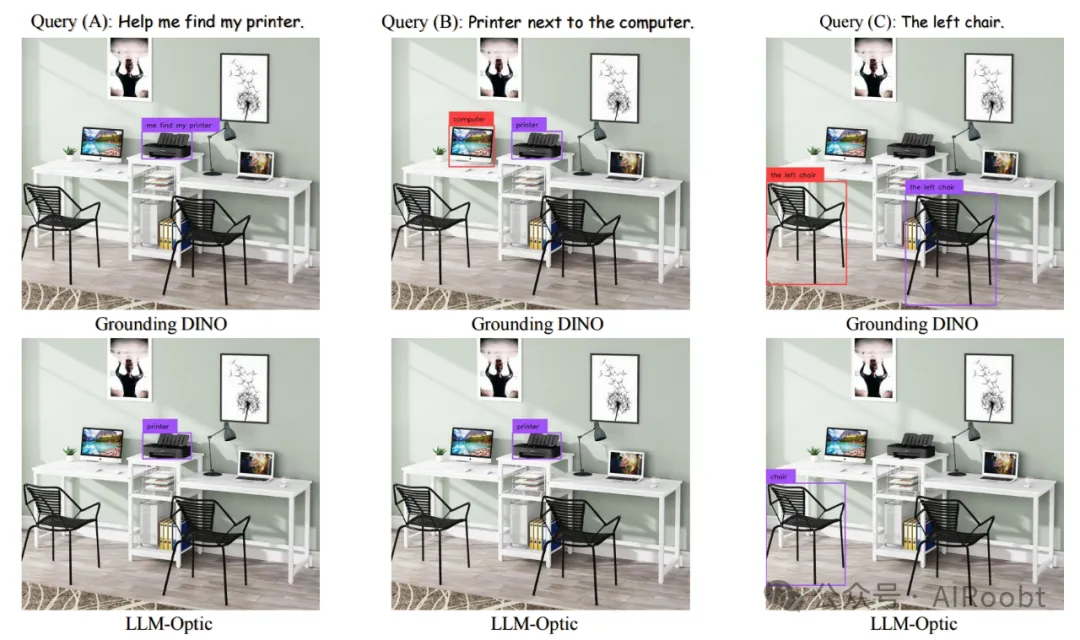

視覺定位是計(jì)算機(jī)視覺中的一項(xiàng)關(guān)鍵任務(wù),是多個(gè)領(lǐng)域如自動(dòng)駕駛【1, 2】、機(jī)器人技術(shù)【3】、無人機(jī)導(dǎo)航【4, 5】的基礎(chǔ)。先驅(qū)性的研究【6-12】對這一任務(wù)進(jìn)行了廣泛探索,推動(dòng)了持續(xù)的進(jìn)步。值得注意的是,Grounding DINO【6】表現(xiàn)出色,達(dá)到了最先進(jìn)的結(jié)果。Grounding DINO是一種強(qiáng)大的開放詞匯對象檢測模型,其性能優(yōu)越,能夠處理自由形式的文本輸入查詢。這一能力源于其在多個(gè)階段實(shí)現(xiàn)了視覺和語言模態(tài)的融合。然而,盡管Grounding DINO取得了顯著成就,但在完全理解復(fù)雜輸入文本查詢方面仍面臨挑戰(zhàn)。在各種場景中,其局限性顯而易見:(1) 它在處理復(fù)雜句子結(jié)構(gòu)時(shí)表現(xiàn)困難,誤解語義信息,如圖1(A)所示,將“me find my printer”錯(cuò)誤地分類為對象標(biāo)簽;(2) 在涉及多個(gè)對象的查詢中存在困難,常常無法區(qū)分主要對象及其地標(biāo),從而無法進(jìn)行精確定位,如圖1(B)所示,它錯(cuò)誤地檢測到了查詢中提到的所有對象,但忽略了主要關(guān)注的對象;(3) 它錯(cuò)誤解釋了空間關(guān)系,如圖1(C)所示。這些局限性凸顯了視覺定位的復(fù)雜性,表明需要進(jìn)一步的改進(jìn)。

圖1:LLM-Optic通過整合大型語言模型(LLM)的推理能力,增強(qiáng)了領(lǐng)先的視覺定位模型Grounding DINO的能力,從而在任何給定查詢中實(shí)現(xiàn)了更高的視覺定位準(zhǔn)確性。具體而言,Grounding DINO在以下方面存在局限:(1) 在處理復(fù)雜句子結(jié)構(gòu)時(shí)表現(xiàn)困難,如查詢(A)所示;(2) 在涉及多個(gè)對象的查詢中面臨挑戰(zhàn),常常無法區(qū)分主要對象及其地標(biāo),從而無法進(jìn)行精確定位(查詢(B));(3) 錯(cuò)誤解釋空間關(guān)系(查詢(C))。然而,我們的框架有效地解決了這些問題。

Grounding DINO表現(xiàn)出這些局限性的主要原因可能在于其使用BERT【13】作為文本編碼器。BERT主要通過兩個(gè)任務(wù)進(jìn)行預(yù)訓(xùn)練:掩碼語言建模(MLM)和下一個(gè)句子預(yù)測(NSP)。盡管這些任務(wù)有助于學(xué)習(xí)基本的語言結(jié)構(gòu),但不足以捕捉更復(fù)雜的語言現(xiàn)象和上下文關(guān)系的細(xì)微差別。相反,大型語言模型(LLM)在自然語言理解方面表現(xiàn)出卓越的能力。LLM通常在更廣泛的任務(wù)和顯著更大的數(shù)據(jù)集上進(jìn)行預(yù)訓(xùn)練,這些數(shù)據(jù)集涵蓋了復(fù)雜的文本生成和理解任務(wù)。這種廣泛的訓(xùn)練使得它們能夠更深入地理解復(fù)雜的語義關(guān)系和上下文變化,從而增強(qiáng)其解釋和響應(yīng)復(fù)雜查詢的能力。大型多模態(tài)模型(LMM),也稱為多模態(tài)大型語言模型(MM-LLM),是LLM的擴(kuò)展,結(jié)合了圖像和文本模態(tài)。在語言理解能力方面,它們優(yōu)于像Grounding DINO這樣的模型。然而,目前LMM在視覺定位方面存在局限,常常無法為復(fù)雜的定位查詢生成精確的邊界框。為了提升LMM在視覺語言任務(wù)如視覺定位中的表現(xiàn),當(dāng)前的方法【14-16】涉及對現(xiàn)有的大模型進(jìn)行訓(xùn)練或微調(diào)。這個(gè)過程需要大量的訓(xùn)練數(shù)據(jù)、顯著的計(jì)算資源和大量的訓(xùn)練時(shí)間。

在這項(xiàng)工作中,我們介紹了LLM-Optic,一種簡單但有效的解決方案,通過整合大型語言模型的推理能力,增強(qiáng)現(xiàn)有的開放詞匯對象檢測模型,而無需額外的訓(xùn)練或微調(diào)。它有效地解決了現(xiàn)有模型在解釋復(fù)雜文本查詢時(shí)遇到的挑戰(zhàn)。此外,LLM-Optic超越了通常與專用模型相關(guān)的限制,這些模型通常僅限于定義狹窄的任務(wù)和特定的輸出格式。它實(shí)現(xiàn)了通用視覺定位,能夠基于各種描述識(shí)別任意數(shù)量的對象,并且能夠處理描述對象在圖像中不存在的情況,顯著增強(qiáng)了視覺定位在各種場景中的適用范圍,實(shí)現(xiàn)了與人類一樣的穩(wěn)健性。該框架在零樣本設(shè)置中在視覺定位基準(zhǔn)中達(dá)到了最先進(jìn)的準(zhǔn)確性,在所有評估的數(shù)據(jù)集中都表現(xiàn)出改進(jìn),其中在RefCOCOg【17】驗(yàn)證集中的最高增幅達(dá)到了22%。

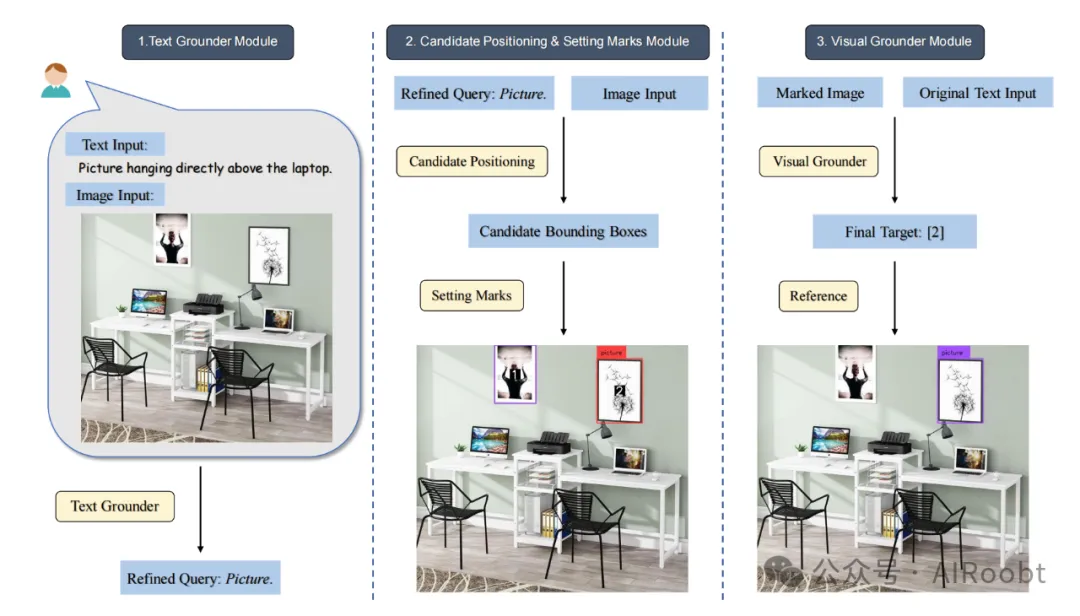

LLM-Optic主要由三個(gè)模塊組成:基于LLM的文本定位器、候選位置設(shè)置和標(biāo)記模塊,以及基于LMM的視覺定位器。最初,LLM作為文本定位器,處理復(fù)雜的文本查詢以確定文本背后的真實(shí)意圖。文本定位器的輸出然后傳遞到候選位置設(shè)置和標(biāo)記模塊。在該模塊中,文本定位器的輸出,即對目標(biāo)的簡單但精確的描述,被傳遞到一個(gè)預(yù)訓(xùn)練的開放詞匯對象檢測模型。該模型負(fù)責(zé)為可能對應(yīng)描述的候選對象生成邊界框。每個(gè)邊界框都用數(shù)字標(biāo)識(shí)符進(jìn)行清晰標(biāo)記。隨后,帶有標(biāo)記邊界框的圖像以及原始查詢文本由視覺定位器處理。在這里,一個(gè)LMM確定哪些標(biāo)記的對象準(zhǔn)確地對應(yīng)于查詢文本描述。我們的框架的模塊化架構(gòu)使我們能夠無縫地整合最新的進(jìn)展,并在該領(lǐng)域保持領(lǐng)先地位。

總之,我們的貢獻(xiàn)可以總結(jié)為:

- 我們提出了LLM-Optic,一個(gè)簡單但高效且完全模塊化的框架,通過三個(gè)基本組件增強(qiáng)了視覺定位模型的能力:基于LLM的文本定位器,分析文本查詢中的潛在意圖;候選位置設(shè)置和標(biāo)記模塊,負(fù)責(zé)生成潛在目標(biāo)邊界框并通過標(biāo)記在文本和對應(yīng)的圖像區(qū)域之間建立連接;以及基于LMM的視覺定位器,精確識(shí)別圖像中查詢描述的對象。我們的框架原則具有適應(yīng)性,能夠通過簡化的遷移過程應(yīng)用于廣泛的計(jì)算機(jī)視覺任務(wù)。

- 我們的方法顯著擴(kuò)展了當(dāng)前最先進(jìn)定位模型的能力,無需額外的訓(xùn)練或微調(diào)。它有效地解決了現(xiàn)有模型在解釋復(fù)雜文本查詢時(shí)遇到的挑戰(zhàn)。此外,我們的框架超越了專用模型的限制,這些模型通常僅限于狹窄定義的任務(wù)和受限的輸出格式,允許多樣化的輸入文本以及多樣化的輸出結(jié)果。

- 大量跨多個(gè)視覺定位基準(zhǔn)的實(shí)驗(yàn)表明,所提出的框架在零樣本設(shè)置中顯著優(yōu)于最先進(jìn)的模型,無需使用額外的數(shù)據(jù)。這些實(shí)驗(yàn)在所有評估的數(shù)據(jù)集中都表現(xiàn)出顯著改進(jìn),其中在RefCOCOg驗(yàn)證集中的最大增幅為22%。

2 相關(guān)工作

視覺定位。視覺定位基于對象檢測,通過將圖像的特定區(qū)域與自然語言描述鏈接起來,增強(qiáng)跨模態(tài)的理解。對象檢測任務(wù)是計(jì)算機(jī)視覺領(lǐng)域的核心工作之一,并在不斷演進(jìn)。對象檢測的主要目標(biāo)是在圖像中定位屬于預(yù)定義類別的所有目標(biāo)對象【18-22】。然而,這些閉合詞匯對象檢測(CVD)模型專注于在閉合類別集合內(nèi)進(jìn)行檢測,由于這些預(yù)定義類別的限制,難以泛化到新的類別。隨著研究的進(jìn)展,出現(xiàn)了幾項(xiàng)相關(guān)任務(wù)。除了CVD之外,該領(lǐng)域現(xiàn)在根據(jù)輸入文本的類型區(qū)分三項(xiàng)任務(wù):開放詞匯對象檢測(OVD)、指稱表達(dá)理解(REC)和短語定位(PG)。OVD【6-12】任務(wù)通過允許識(shí)別超出預(yù)定義類別的任意類別來解決傳統(tǒng)對象檢測的局限性。相比之下,REC【23-26, 10, 27】任務(wù)專注于高度具體的查詢,可能會(huì)詳細(xì)描述對象的相對位置、外觀特征和其他描述。與OVD不同,一個(gè)單一類別標(biāo)簽可以對應(yīng)多個(gè)邊界框,而在REC中,每個(gè)查詢特定定位一個(gè)唯一對象。PG【28, 12, 11, 29】任務(wù)要求定位句子中所有引用的對象(短語),需要全面識(shí)別文本輸入中的多個(gè)對象。

在本文中,我們介紹了LLM-Optic,它針對的是更廣泛適用的視覺定位任務(wù),即通用視覺定位。與為特定任務(wù)設(shè)計(jì)的專用模型不同,例如在復(fù)雜用戶查詢時(shí)表現(xiàn)不佳的OVD任務(wù)模型,或者只能定位單個(gè)對象并需要特定訓(xùn)練數(shù)據(jù)的REC任務(wù)模型,LLM-Optic設(shè)計(jì)得更加靈活。這意味著LLM-Optic可以根據(jù)任何給定查詢識(shí)別任意數(shù)量的對象,顯著擴(kuò)展了視覺定位在各種場景中的適用范圍,從而真正實(shí)現(xiàn)了通用視覺定位。

大型多模態(tài)模型。大型語言模型(LLM)領(lǐng)域的最新進(jìn)展展示了顯著的成果。這些成就迅速擴(kuò)展到包含文本和圖像模態(tài)的大型多模態(tài)模型(LMM)。最先進(jìn)的模型【30-38】廣泛應(yīng)用于敘事生成【39, 40】、場景生成【41】、圖像字幕生成【42】,以及作為視覺語言任務(wù)的評估器【43, 44】,展現(xiàn)了其卓越的能力。此外,LLM和LMM在各種應(yīng)用方法中表現(xiàn)出靈活性。例如,一些LMM被專門訓(xùn)練或微調(diào)用于視覺定位【14, 15】和3D理解【45, 46】等任務(wù)。此外,一些研究【47-50】僅將LLM用作多輪對話中的計(jì)劃和工具使用的代理,而無需進(jìn)行任何額外的訓(xùn)練或微調(diào)。這些多樣的應(yīng)用方法展示了它們顯著的實(shí)際價(jià)值。

然而,最先進(jìn)的LMM如GPT-4V【31】和LLaVA【35】雖然在多個(gè)領(lǐng)域中表現(xiàn)出色,但并未針對視覺定位任務(wù)進(jìn)行專門優(yōu)化。因此,它們通常在處理復(fù)雜的視覺定位查詢時(shí)表現(xiàn)不佳,通常無法直接輸出查詢中指定對象的精確邊界框。因此,據(jù)我們所知,我們的框架LLM-Optic是首次嘗試將LLM和LMM的能力與2D視覺定位模型結(jié)合。這一整合利用了LLM和LMM在圖像和文本方面的推理能力,以及視覺定位模型的精確定位能力。它無需任何額外的訓(xùn)練或微調(diào)。此外,每次交互只需要一次對話,使用最少的令牌消耗。

3 方法

我們的目標(biāo)是通過整合LLM和LMM的高級推理能力,提升現(xiàn)有視覺定位模型理解復(fù)雜文本查詢的能力。這種增強(qiáng)使它們能夠克服當(dāng)前的局限性,從而確保對任何查詢進(jìn)行準(zhǔn)確的視覺定位。我們提出的框架命名為LLM-Optic,分為三個(gè)主要組件:文本定位器(§3.1)、候選位置和標(biāo)記設(shè)置(§3.2)以及視覺定位器(§3.3)。這種高度模塊化的方法無需額外的訓(xùn)練或微調(diào),每個(gè)組件都可以與任何最先進(jìn)的模型互換。

圖2:LLM-Optic概覽。我們提出使用LLM和LMM作為有效的推理模塊來處理復(fù)雜的用戶查詢,以實(shí)現(xiàn)通用視覺定位。我們的框架包括三個(gè)關(guān)鍵模塊:基于LLM的文本定位器、候選位置和標(biāo)記設(shè)置模塊,以及基于LMM的視覺定位器。該框架不需要任何額外的訓(xùn)練,并具有完全模塊化的設(shè)計(jì),允許快速整合新技術(shù)的最新進(jìn)展。

3.1 文本定位器

LLM在自然語言理解方面表現(xiàn)出色【30, 51】。對于復(fù)雜的用戶查詢,我們使用LLM(GPT-3.5 Turbo)作為文本定位器來解析和解釋文本查詢。我們告知LLM預(yù)期的輸入和輸出格式;LLM使用的提示詳情在附錄A中提供。文本定位器有效地提取關(guān)鍵信息,確保對用戶實(shí)際意圖的深入理解。這種準(zhǔn)確的解釋至關(guān)重要,因?yàn)樗笇?dǎo)了后續(xù)的預(yù)訓(xùn)練視覺定位模型準(zhǔn)確識(shí)別用戶查詢中指定的對象。例如,直接將“掛在筆記本電腦正上方的圖片”輸入到視覺定位模型中可能會(huì)導(dǎo)致誤解。然而,文本定位器通過語義和常識(shí)推理確定應(yīng)關(guān)注定位圖片,而筆記本電腦只是一個(gè)參考地標(biāo)。文本定位器處理用戶的原始查詢后,傳遞給視覺定位模型的優(yōu)化輸入變?yōu)樘崛〉奈谋尽皥D片”,標(biāo)識(shí)了一個(gè)特定的對象類別,視覺定位模型可以高效處理。

3.2 候選位置和標(biāo)記設(shè)置

候選位置。通過文本定位器處理后,我們得到一個(gè)簡單但精確的輸入查詢表達(dá),即“優(yōu)化查詢”,如“圖片”。這個(gè)簡潔的表達(dá)被傳遞給一個(gè)開放詞匯對象檢測模型,我們具體使用Grounding DINO。Grounding DINO是一個(gè)強(qiáng)大的、預(yù)訓(xùn)練的開放詞匯對象檢測器,在現(xiàn)有視覺定位模型中表現(xiàn)優(yōu)異。該模型負(fù)責(zé)生成可能匹配優(yōu)化查詢的候選對象的邊界框。然而,這些候選并不是最終目標(biāo);相反,它們是匹配查詢對象指定類別的初步選擇。進(jìn)一步的處理,包括對象外觀和空間關(guān)系的分析,需要在后續(xù)模塊中由視覺定位器進(jìn)行額外推理。

標(biāo)記設(shè)置。定位候選對象后,我們在每個(gè)候選邊界框的中心標(biāo)記一個(gè)唯一的數(shù)字標(biāo)識(shí)符,如圖3所示。這些標(biāo)識(shí)符作為每個(gè)候選邊界框的唯一身份。此步驟有兩個(gè)主要目的:首先,通過直接索引每個(gè)用邊界框注釋的特定區(qū)域到對應(yīng)的編號(hào),建立文本-視覺鏈接,使后續(xù)的視覺定位器能夠更有效地基于這些標(biāo)記進(jìn)行推理和響應(yīng)。其次,根據(jù)Set-of-Mark Visual Prompting的研究【52】,這些標(biāo)記可以有效減少大型多模態(tài)模型中常見的幻覺,從而提高視覺定位器的準(zhǔn)確性。

圖3:候選位置和標(biāo)記設(shè)置的過程。圖像(a)是原始輸入圖像,圖像(b)顯示了用邊界框標(biāo)注的圖像,而圖像(c)顯示了在每個(gè)邊界框上應(yīng)用標(biāo)記后的圖像。

3.3 視覺定位器

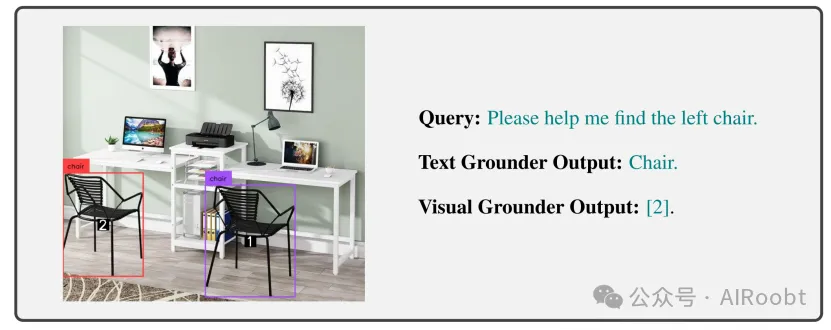

圖像標(biāo)記后,它與原始未處理的查詢配對形成圖像-文本對。這個(gè)對輸入到一個(gè)LMM中,具體來說是LLM-Optic中的GPT-4V,作為視覺定位器。最先進(jìn)的LMM,如GPT-4V,在一般的視覺語言任務(wù)中表現(xiàn)出色【53, 54】。作為視覺定位器,LMM利用其推理能力分析標(biāo)記圖像和原始文本查詢,最終從標(biāo)記候選對象中選擇與查詢描述目標(biāo)最匹配的對象。同樣地,我們告知LMM預(yù)期的輸入和輸出格式;LLM使用的提示詳情在附錄A中提供。LMM的輸出是與文本查詢匹配的對象的標(biāo)記標(biāo)識(shí)符,然后用來索引先前保存的邊界框以定位目標(biāo)對象。詳細(xì)示例如圖4所示。

圖4:文本定位器和視覺定位器輸出示例。我們放大了標(biāo)記的尺寸以增強(qiáng)可見性;然而,實(shí)際標(biāo)記較小,如附錄E中的附加結(jié)果所示,以避免遮擋目標(biāo)對象。

4 實(shí)驗(yàn)

4.1 數(shù)據(jù)集

為了評估LLM-Optic的性能,我們在多個(gè)數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn),包括RefCOCO【55】、RefCOCOg【17】和描述檢測數(shù)據(jù)集(D3)【56】。這些數(shù)據(jù)集以其復(fù)雜的描述為特征,廣泛用于現(xiàn)有視覺定位模型的訓(xùn)練和測試。

RefCOCO & RefCOCOg。RefCOCO【55】和RefCOCOg【17】是專為指稱表達(dá)理解(REC)任務(wù)設(shè)計(jì)的數(shù)據(jù)集,重點(diǎn)是理解在圖像中指示唯一對象的自然語言表達(dá)。源自MS-COCO【57】,RefCOCO分為四個(gè)部分:Train、TestA、TestB和Val,而RefCOCOg分為三個(gè)部分:Train、Test和Val。兩者的主要區(qū)別在于指稱表達(dá)的復(fù)雜性;RefCOCO適應(yīng)任何類型的語言,而RefCOCOg提供了更詳細(xì)的對象描述。值得注意的是,RefCOCOg的平均表達(dá)長度為8.4個(gè)詞,顯著長于RefCOCO的3.5個(gè)詞。

描述檢測數(shù)據(jù)集(D3)。不同于RefCOCO和RefCOCOg,D3數(shù)據(jù)集采用了多樣且靈活的語言表達(dá),長度和復(fù)雜性各異。D3的一個(gè)顯著特點(diǎn)是包含了大量強(qiáng)調(diào)某些概念缺失的描述,例如“直升機(jī)不在空中飛行”。這一特點(diǎn)大大有助于評估不同方法的穩(wěn)健性。

4.2 評估指標(biāo)

我們使用多種常用指標(biāo)評估不同模型的視覺定位能力,包括平均交并比(mIoU)以及Accuracy@0.25和Accuracy@0.5。Accuracy@0.25和Accuracy@0.5分別指的是邊界框預(yù)測與真實(shí)邊界框的交并比超過0.25和0.5的準(zhǔn)確率。

4.3 基線

我們選擇了GPT-4V【31】、Grounding DINO【6】和UNINEXT【58】作為我們的基線,因?yàn)樗鼈冊诖硇院头€(wěn)健性方面表現(xiàn)優(yōu)異。在視覺定位方面,Grounding DINO和UNINEXT在各自的任務(wù)中表現(xiàn)出了最先進(jìn)的性能,特別是在OVD任務(wù)中Grounding DINO和在REC任務(wù)中UNINEXT。同樣,GPT-4V也作為最先進(jìn)的LMM表現(xiàn)出色。值得注意的是,GPT-4V和Grounding DINO沒有在REC數(shù)據(jù)集(RefCOCO系列)上進(jìn)行訓(xùn)練。相比之下,UNINEXT在RefCOCO系列上進(jìn)行了訓(xùn)練,表現(xiàn)出卓越的最先進(jìn)性能。我們包含這一基線以展示經(jīng)過訓(xùn)練的管道的能力,相對于我們的零樣本設(shè)置建立了一個(gè)性能上限。基線的詳細(xì)規(guī)格如下。

GPT-4V。GPT-4V(ison)【31】是一個(gè)最先進(jìn)的大型多模態(tài)模型,目前在各種任務(wù)中表現(xiàn)出色【53, 54】。在我們的實(shí)驗(yàn)中,我們?yōu)镚PT-4V提供了精心設(shè)計(jì)的提示,詳細(xì)信息見附錄A,使其能夠基于用戶查詢直接輸出目標(biāo)對象的邊界框。

Grounding DINO。Grounding DINO【6】是一個(gè)強(qiáng)大的視覺定位模型,在各種對象檢測數(shù)據(jù)集中表現(xiàn)出最先進(jìn)的性能。該模型通過整合雙編碼器單解碼器架構(gòu)增強(qiáng)了閉合集檢測器DINO【18】,在多個(gè)階段促進(jìn)了視覺語言模態(tài)融合。這一先進(jìn)架構(gòu)包括一個(gè)特征增強(qiáng)器、一個(gè)語言引導(dǎo)的查詢選擇模塊和一個(gè)跨模態(tài)解碼器。

UNINEXT。UNINEXT【58】是在RefCOCO系列上使用額外訓(xùn)練數(shù)據(jù)達(dá)到最先進(jìn)結(jié)果的模型。它圍繞三個(gè)主要組件構(gòu)建:提示生成、圖像-提示特征融合和對象發(fā)現(xiàn)與檢索。其訓(xùn)練過程分為三個(gè)階段:通感知覺預(yù)訓(xùn)練、圖像級聯(lián)合訓(xùn)練和視頻級聯(lián)合訓(xùn)練。值得注意的是,RefCOCO系列在后兩個(gè)階段用于微調(diào)。

4.4 結(jié)果

由于GPT-4V的配額限制,我們采用了抽樣方法進(jìn)行實(shí)驗(yàn)。我們隨機(jī)抽取了RefCOCO每個(gè)部分的200對文本-圖像對(共800對),RefCOCOg每個(gè)部分的200對文本-圖像對(共600對),以及D3的200對文本-圖像對。總共,這些抽樣策略產(chǎn)生了1600對文本-圖像對,為我們的實(shí)驗(yàn)提供了一個(gè)大量且多樣化的測試數(shù)據(jù)集。此外,初步測試表明GPT-4在處理復(fù)雜查詢方面的定位能力較弱,因此我們只從每個(gè)數(shù)據(jù)集部分抽取了50對文本-圖像對,總計(jì)400對文本-圖像對。所有實(shí)驗(yàn)均在一致的環(huán)境和統(tǒng)一的設(shè)置下進(jìn)行。

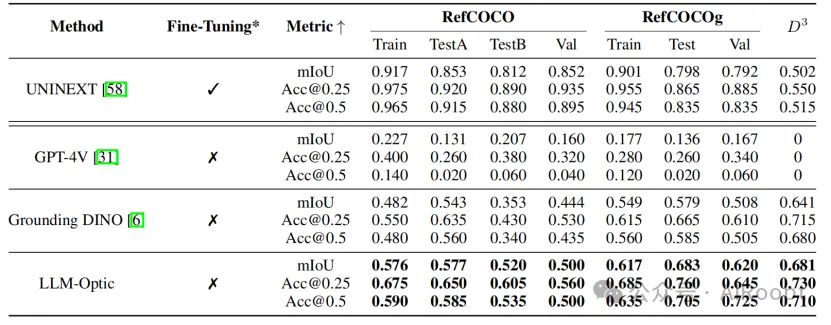

我們按照上述數(shù)據(jù)集設(shè)置進(jìn)行了實(shí)驗(yàn),結(jié)果詳見表1。這些結(jié)果清楚地表明,LLM-Optic在零樣本設(shè)置中在所有評估的數(shù)據(jù)集中實(shí)現(xiàn)了最先進(jìn)的性能,顯著超越了Grounding DINO。例如,LLM-Optic在RefCOCOg驗(yàn)證集上的Accuracy@0.5方面顯示出22%的顯著改進(jìn)。與通常使用32或16個(gè)A100 GPU以及額外訓(xùn)練數(shù)據(jù)進(jìn)行訓(xùn)練的最先進(jìn)模型UNINEXT相比,LLM-Optic的性能相當(dāng),盡管我們的框架不需要額外的訓(xùn)練。此外,在沒有對UNINEXT進(jìn)行微調(diào)的D3數(shù)據(jù)集中,LLM-Optic的性能超過了UNINEXT 20%,突顯了我們框架的有效性。除了其出色的性能外,還需要注意的是,為了確保公平比較,我們采用了特定設(shè)置,這可能表明LLM-Optic的實(shí)際性能可能高于表1中所示的結(jié)果。有關(guān)更多詳細(xì)信息,請參見附錄B。

表1:在RefCOCO、RefCOCOg和D3數(shù)據(jù)集上與最先進(jìn)基線的比較,突出顯示了我們的優(yōu)越性能,最高分以粗體表示。包括了UNINEXT在RefCOCO系列上的結(jié)果,以展示當(dāng)前訓(xùn)練管道的能力,作為RefCOCO系列對我們零樣本設(shè)置的性能上限。在相同的零樣本設(shè)置下,我們的框架在D3數(shù)據(jù)集上顯著優(yōu)于UNINEXT,展示了我們的卓越性能和穩(wěn)健性。結(jié)果清楚地表明,我們的框架在很大程度上超越了這些最先進(jìn)的方法。*表示模型是否在RefCOCO系列上進(jìn)行了微調(diào)。

4.5 附加評估

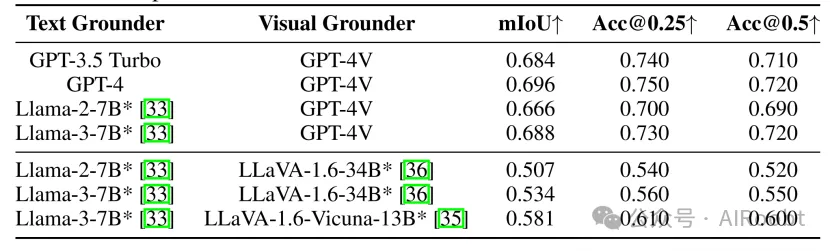

使用不同LLM和LMM的消融研究。我們在D3數(shù)據(jù)集上進(jìn)行了消融研究,以評估不同LLM作為文本定位器和LMM作為視覺定位器的有效性。我們從D3數(shù)據(jù)集中隨機(jī)選擇了100個(gè)樣本進(jìn)行分析。對于文本定位器,我們使用了各種LLM,包括GPT-3.5 Turbo、GPT-4、Llama-2【33】和Llama-3【33】。我們的結(jié)果(見表2)表明,所有測試的LLM表現(xiàn)出強(qiáng)大的性能。值得注意的是,開源LLM的性能與GPT-4相當(dāng),甚至基本的7B模型也表現(xiàn)出足夠的能力,作為輸入查詢的文本定位器。

表2:在D3數(shù)據(jù)集上使用不同大型語言模型(LLM)作為文本定位器和大型多模態(tài)模型(LMM)作為視覺定位器的消融研究。*表示模型是否開源。

對于視覺定位器,除了GPT-4V,我們還評估了廣泛使用的開源LMM,如LLaVa-1.5【35】和LLaVa-1.6(也稱為LLaVa-Next)【36】,具有不同的模型參數(shù)規(guī)模。這些評估表明,雖然LLaVa-1.6能夠作為視覺定位器,但在提供準(zhǔn)確響應(yīng)方面不如GPT-4V有效。這可能是因?yàn)镚PT-4V擁有更多的模型參數(shù),并且在更廣泛的數(shù)據(jù)集上進(jìn)行了預(yù)訓(xùn)練。相比之下,LLaVa-1.5未能完成作為視覺定位器的任務(wù),其表現(xiàn)不佳可能是因?yàn)長LaVa-1.6具備增強(qiáng)的視覺推理和OCR能力,這歸功于改進(jìn)的視覺指令調(diào)優(yōu)數(shù)據(jù)混合,而LLaVa-1.5缺乏這些能力。這鞏固了GPT-4V作為當(dāng)前最可靠選擇的地位。我們的模塊化設(shè)計(jì)允許我們隨時(shí)替換最新的預(yù)訓(xùn)練模型,從而可能隨著該領(lǐng)域研究的進(jìn)展提升我們模型的性能。

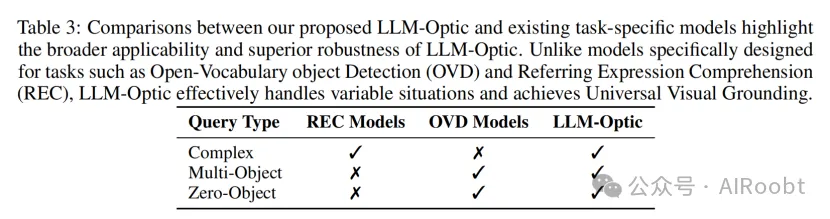

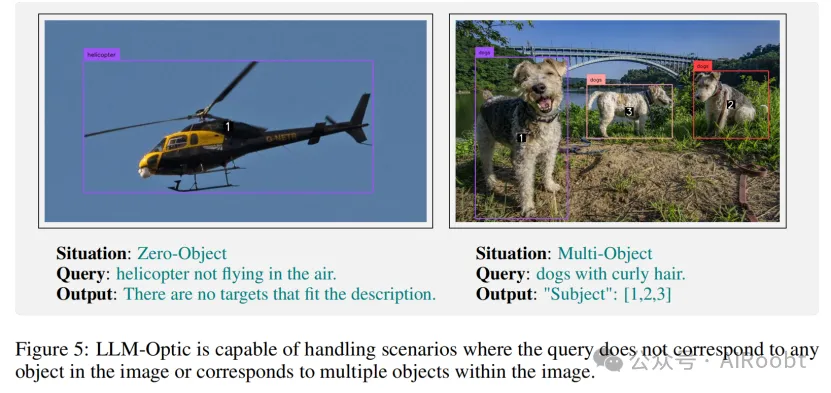

LLM-Optic的穩(wěn)健性。LLM-Optic克服了專用模型的典型限制,這些模型通常局限于狹窄定義的任務(wù)和特定的輸出格式。例如,OVD模型由于缺乏詳細(xì)的上下文理解而受到限制,主要關(guān)注預(yù)定義類別,而不是詳細(xì)考慮目標(biāo)的具體屬性。然而,REC模型擅長解析擴(kuò)展描述,但受到假設(shè)圖像中僅存在一個(gè)目標(biāo)且需要特定訓(xùn)練數(shù)據(jù)的限制。這種假設(shè)在目標(biāo)缺失或存在多個(gè)目標(biāo)的情況下引入了限制。與這些模型不同,LLM-Optic提供了一個(gè)多功能且穩(wěn)健的解決方案,能夠應(yīng)對各種復(fù)雜的視覺定位挑戰(zhàn)。LLM-Optic實(shí)現(xiàn)了通用視覺定位,能夠根據(jù)各種描述識(shí)別任意數(shù)量的對象,并且能夠處理描述對象在圖像中不存在的情況。這顯著增強(qiáng)了視覺定位在各種場景中的適用范圍,實(shí)現(xiàn)了與人類相似的穩(wěn)健性。不同視覺定位模型之間的區(qū)別總結(jié)在表3中。此外,我們在圖5中展示了LLM-Optic處理不同情況的案例。

5 結(jié)論

在本文中,我們介紹了LLM-Optic,這是一種旨在增強(qiáng)當(dāng)前最先進(jìn)視覺定位模型能力的新型框架,無需額外的訓(xùn)練或微調(diào)。它有效地解決了現(xiàn)有模型在解釋復(fù)雜文本查詢時(shí)遇到的局限性。此外,LLM-Optic克服了專用模型固有的限制,這些模型通常受限于定義狹窄的任務(wù)和輸出格式,實(shí)現(xiàn)了通用視覺定位。該框架具有模塊化設(shè)計(jì),每個(gè)組件都可以與任何最先進(jìn)的模型互換。具體來說,它集成了三個(gè)核心組件:基于LLM的文本定位器、候選位置和標(biāo)記設(shè)置模塊,以及基于LMM的視覺定位器。廣泛的實(shí)驗(yàn)表明,LLM-Optic在多個(gè)數(shù)據(jù)集的零樣本設(shè)置中,性能優(yōu)于當(dāng)前最先進(jìn)的方法。此外,據(jù)我們所知,LLM-Optic是首個(gè)利用LLM和LMM來增強(qiáng)計(jì)算機(jī)視覺方法的研究,為未來的研究提供了寶貴的見解。

Zhao H, Ge W, Chen Y. LLM-Optic: Unveiling the Capabilities of Large Language Models for Universal Visual Grounding[J]. arXiv preprint arXiv:2405.17104, 2024.

本文轉(zhuǎn)載自公眾號(hào)AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/pHSddyFBGBhTuhZp7K0qYQ??