TASK-ME-ANYTHING:一個多模態benchmark生成引擎

一、結論寫在前面

論文標題:Task Me Anything

論文鏈接:??https://arxiv.org/pdf/2406.11775??

項目鏈接:??https://www.task-me-anything.org??

大多模態語言模型(MLMs)的基準現在同時評估模型的通用能力,而不是針對特定能力的評估。因此,當開發者想要確定哪些模型適用于他們的應用時,他們會被眾多的基準所淹沒,并且不確定哪個基準的結果最能反映他們的具體用例。

論文介紹了TASK-ME-ANYTHING,一個基準生成引擎,它能夠根據用戶需求定制基準。TASK-ME-ANYTHING維護了一個可擴展的視覺資產分類法,并能夠程序化地生成大量的任務實例。此外,它還能在計算預算內高效地處理關于MLM性能的用戶查詢。它包含113K張圖片,10K個視頻,2K個3D對象資產,超過365個對象類別,655個屬性,以及335種關系。它能夠生成7.5億個圖像/視頻問答對,專注于評估MLM的感知能力。

TASK-ME-ANYTHING揭示了:開源MLMs在對象和屬性識別方面表現出色,但在空間和時間理解上有所欠缺;每個模型都展現出獨特的優勢和弱點;較大的模型通常表現更好,盡管存在例外;GPT40在識別旋轉/移動對象和區分顏色方面遇到挑戰。

二、論文的簡單介紹

2.1 論文的背景

當開發者想要確定哪些模型適用于他們的應用時,他們仍然不確定哪些基準測試結果最符合他們的特定用例。考慮一個場景,應用開發者需要一個能最準確識別物體形狀的模型。他們可能會發現存在如SHAPES 和 CLEVR 這樣的現有數據集,其中包含與形狀相關的任務實例,但涉及的物體是簡單的幾何圖形而非現實世界中的物體。同樣,考慮一家大型科技公司的研究團隊,他們希望識別其專有MLM的局限性。盡管MLMs發布了在MMBench、MMMU、BLINK和SeedBench等基準上的評估結果,但這些整體基準的性能并不能精確指出哪些細粒度能力不足。

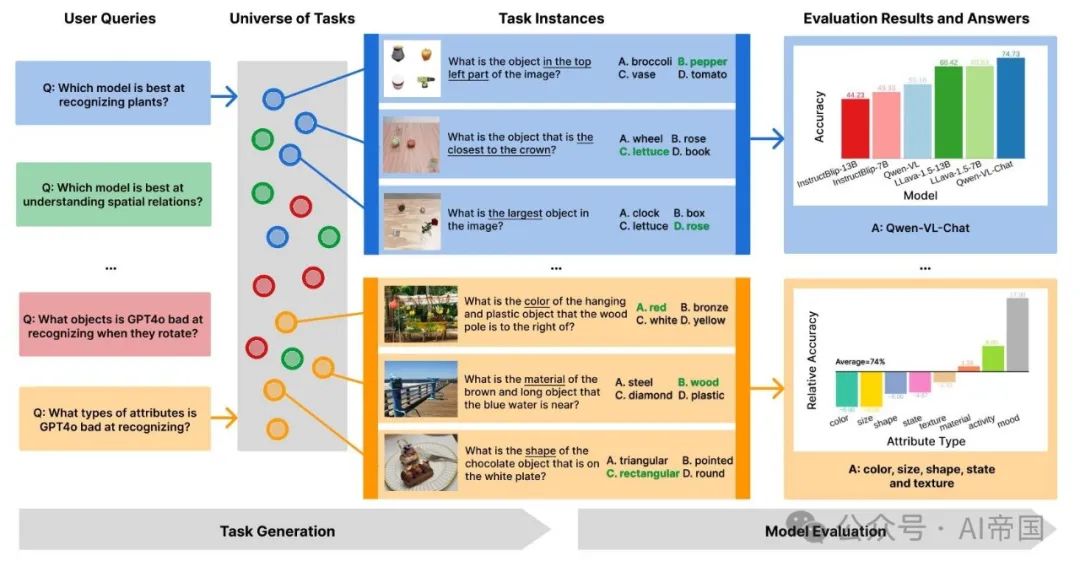

圖1展示了用戶查詢的示例,以及由TASK-ME-ANYTHING生成的相應任務實例及其在解答這些查詢上的評估結果

存在一個需求,即需要一個原則性的基準生成過程來解答針對特定任務的用戶查詢:“(Q1) 哪個模型在識別物體形狀方面表現最佳?”或“(Q2) 論文可以進一步改進模型的哪些弱點?”。為了實現這樣一個過程,存在幾個挑戰。首先,論文需要定義一個可擴展的分類法來表示輸入和輸出的空間。例如,為了回答Q1,該分類法必須包含物體及其形狀。此分類法應易于擴展,以便未來的查詢能夠評估新概念。其次,該過程必須能夠根據用戶查詢精心策劃足夠數量的輸入-輸出評估對。為了回答Q1,它必須能夠生成包含已知形狀物體的數千張圖像。第三,評估機器學習模型(MLMs)在計算上是昂貴的,因此評估過程應在給定計算預算的情況下估計MLM的性能。

論文提出了TASK-ME-ANYTHING,這是一個基準生成引擎,可以根據用戶查詢定制專用基準(圖1)。

首先,TASK-ME-ANYTHING維護一個可擴展的分類體系,并配有相應的視覺資產(例如帶有場景圖的圖像、3D對象資產、帶有時空標注的視頻、渲染軟件等)。它作為一個可擴展的庫實現,其中可以輕松添加新的概念及其對應的資產和標注。

其次,TASK-ME-ANYTHING包含程序化任務生成器,這些生成器從分類體系中進行子選擇,以策劃大量輸入-輸出對。圖像/視頻要么來自現有數據集,要么通過特定配置程序化生成。憑借論文當前的分類體系,TASK-ME-ANYTHING能夠生成超過7.5億個任務。相比之下,現有的MILMs基準任務實例較少:MME(2,194個)、MMBench(3,217個)、BLINK(3,807個)、MMMU(11,550個)、SeedBench(19,242個)。程序化任務生成并非新穎——CLEVR[43]和GQA[39]也是程序化生成的。盡管它們的貢獻是最終生成的基準,但論文的貢獻是基準生成過程本身。

第三,TASK-ME-ANYTHING允許用戶指定計算預算。它包含算法,通過預測模型在大量輸入-輸出對上的性能,而不實際在每個任務實例上調用MLM,來近似用戶查詢的結果。

2.2 TASK-ME-ANYTHING

考慮一個用戶想要了解“哪個開源MLM最擅長識別旋轉中的物體?”的情況。TASK-ME-ANYTHING為用戶提供了一個界面,以便他們提出此類問題并獲得答案(圖2)。

它包含了一個用于符號化表示視覺內容的分類法。查詢識別出回答查詢所需的分類法的相關部分。它還包含了任務生成器,這些生成器創建輸入-輸出對以測試特定能力。分類法的子集用于選擇適當的任務生成器。

論文采用了現有基準中常用的輸入-輸出格式,即TASK-ME-ANYTHING中的所有任務實例都包含圖像/視頻、一個問題和多個選項,其中有一個是正確答案。MLMs將在這些生成的任務實例上進行評估,并將結果返回給用戶。

最后,它還支持查詢,不僅詢問最佳性能模型,還詢問任務實例(“找出GPT40表現最差的10個任務實例”)或分類法概念(“找出GPT4O性能高于閾值的物體”),以及針對此類細粒度查詢的預算內結果近似方法。與大多數現有的程序化數據系統不同,論文設計TASK-ME-ANYTHING使得任務生成空間可以通過添加新的源數據和/或任務生成器代碼來擴展。

2.2.1 分類法

論文采用時空場景圖作為圖像或視頻中表示的概念的一種表示形式。在場景圖中,對象及其相應的屬性是節點,對象之間的關系是邊。場景圖已經被用于在數據集如GQA和AGQA中程序化生成VQA任務實例。

場景圖表示是通用的:它可以擴展以包含諸如光照條件等概念,并詢問光源、照明和陰影等問題。實際上,論文將傳統的場景圖與Objaverse中的3D對象資產相結合,使論文能夠詢問任何具有可用3D模型的對象及其空間位置等問題。

2.2.2 任務生成器

任務生成器是一個Python程序,它可以根據分類法的一個子集生成VQA任務實例。它使用模板類型生成問題:“圖像中有多少<目標對象>?”,其中<目標對象>可以填充場景圖中的對象,如“電話”。

此外,它根據場景圖程序化地生成正確答案。它為每個問題合成錯誤但看似合理的選項。對于與每個問題相關的視覺輸入,論文使用帶有場景圖注釋的圖像和視頻。然而,場景圖數據成本高且有限。為了促進多樣化的用戶查詢,論文程序化地從場景圖表示生成圖像/視頻。由于圖像/視頻生成模型可能會在論文的評估流程中引入潛在錯誤,論文將使用生成模型的任務留待未來的工作。相反,論文程序化地生成圖像/視頻布局并渲染它們。

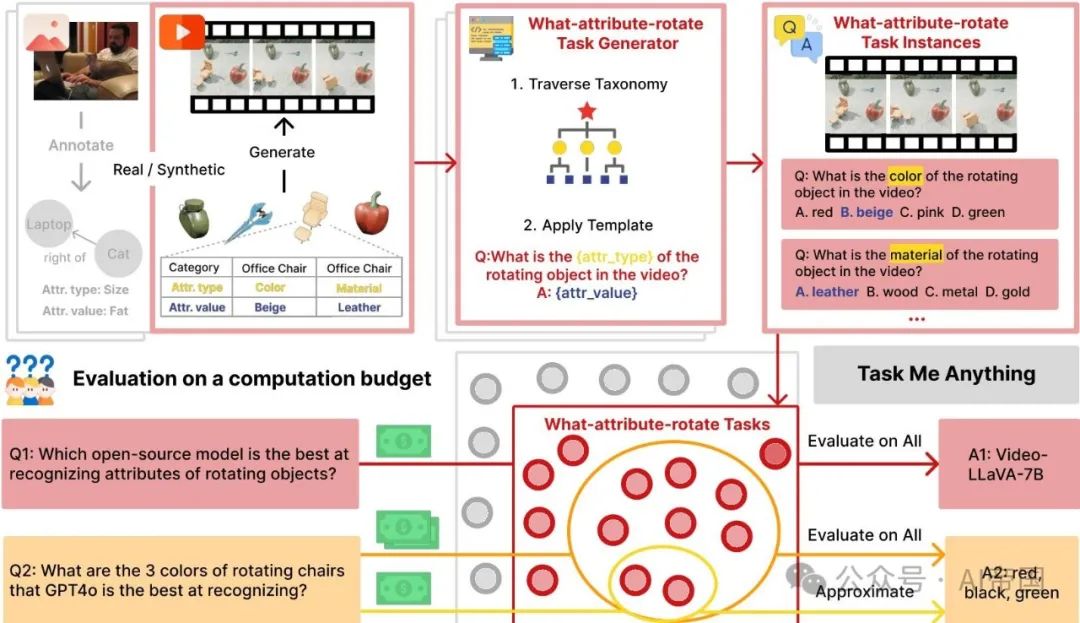

圖2展示了TASK-ME-ANYTHING的關鍵組件。上半部分展示了任務生成過程,以一個使用3D物體及其標注合成的示例視頻為例,以及用于生成關于旋轉物體屬性的問題的任務生成器。下半部分描述了模型評估過程,該過程根據用戶的查詢和預算選擇相關任務,并執行完整評估或結果近似以回答查詢

使用Blender結合3D物體模型,通過以下兩種方法實現:

(1)二維貼紙圖像(簡稱2D):受SHAPES數據集 [4] 啟發,論文將單個3D物體模型的二維渲染圖像置于網格中(2x2或3x3)以構成圖像,這種方法生成快速但缺乏真實感,例如,合理的物體共現、光照、陰影等元素缺失。

(2)三維桌面場景(簡稱3D):為克服2D方法的局限性,論文在桌面上放置3D物體資產后渲染場景以生成圖像[68]。同樣,論文生成視頻,并在不同關鍵幀調整物體的位置和角度,使物體移動和旋轉。這種渲染的圖像/視頻更為真實,因為Blender還支持光照和碰撞控制。

2.2.3 處理用戶查詢

鑒于TASK-ME-ANYTHING能夠生成的數百萬個任務實例,即使在整個任務空間上評估單個模型在計算上也是不可行的。對于日常用戶來說,這也會耗費太長時間。論文描述了TASK-ME-ANYTHING如何支持按需任務生成和評估以解決用戶查詢。

細粒度用戶查詢。雖然許多用戶查詢可以通過上述工作流程簡單處理,論文還額外支持了四種細粒度的用戶查詢,用于針對單個任務和分類法概念的調查:

1.7op-K查詢使用戶能夠請求排名前K的分類法概念或任務(例如,“返回LLAVA-13B在哪些顏色/任務上表現不佳的前10名”)。

2.閾值查詢允許用戶查詢模型性能超過或低于給定閾值的分類法概念或任務(例如,“找出LLAVA-NEXT-34B和GPT40在哪些物體識別任務上的準確率低于30%”)。

3.模型比較查詢識別一個模型在哪些類型的任務上以指定幅度優于另一個模型,實現比較分析(例如,GPT40在哪些類型的任務上優于GEMINI-PRO?)。

4.模型調試查詢識別模型性能與其平均水平相差一個標準差的情況,有助于揭示模型的不一致行為(例如,VIDEO-LLAMA-2-7B在識別哪些動作時與其他動作相比有困難?)。

處理預算下的細粒度查詢。這些細粒度的用戶查詢可能涉及大量任務以生成和評估以獲取查詢結果。例如,為了獲取模型表現最差的任務生成器的排名前K的任務,論文必須評估所有可能的任務。為此,論文借鑒了主動學習文獻[45],為這些細粒度用戶查詢實施了三種高效的查詢結果近似方法:

(1) 隨機采樣:從查詢的總可能任務中隨機抽取一部分任務實例。僅評估MLMs(機器學習模型)在這一子集上的表現。

(2) 擬合采樣:同樣隨機抽取一個子集并評估MLMs。結果用于為每個MLM訓練一個高效的功能近似器。該功能近似器通過特征化任務元數據來學習預測MLM在任務上的表現——從不實際生成任務實例本身。盡管有許多適用的模型選擇,但論文在整個工作中采用高斯過程回歸器,因為初步研究顯示它能提供穩定的性能。它使用此功能來近似MLM在剩余任務空間上的表現。

(3) 主動學習:類似于擬合,但通過主動學習迭代訓練每個功能近似器。給定一個較小的子集,它訓練一個初始功能,然后用該功能采樣最不確定的任務實例。MLMs在這些不確定的實例上進行評估,結果用于重新訓練功能。

2.2.4 最終基準引擎?

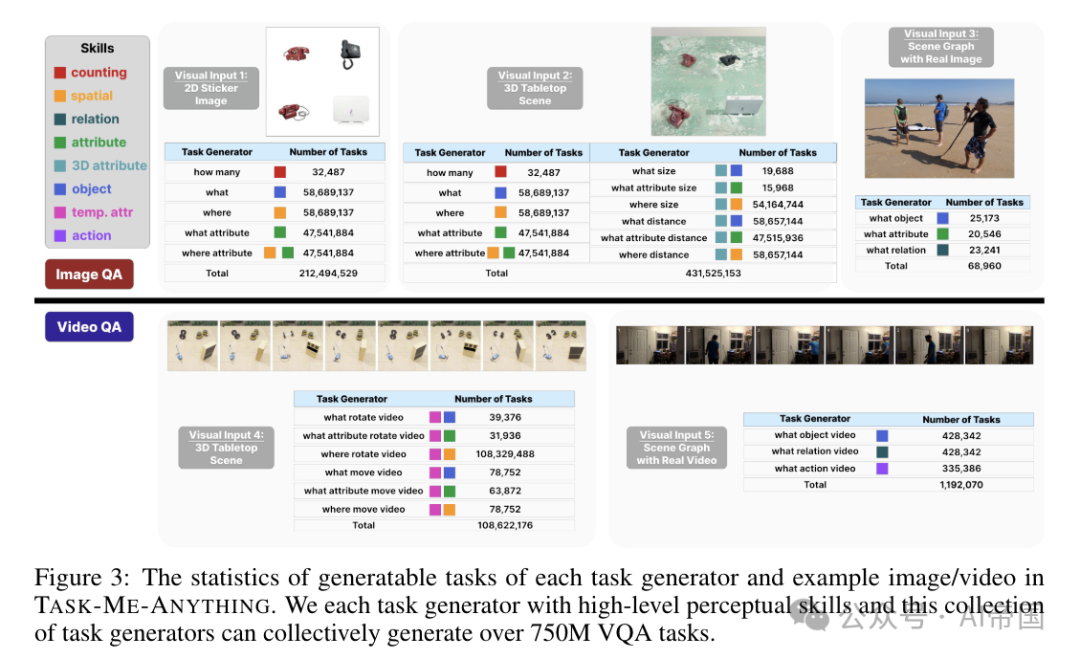

盡管TASK-ME-ANYTHING支持多種不同類型的推理任務,但目前它主要關注視覺感知能力。論文包含了28種不同的任務模板,跨越5種類型的視覺輸入:2D貼紙圖像(2D)、3D桌面場景圖像/視頻(3D)以及真實圖像/視頻。

圖3:TASK-ME-ANYTHlNG中每個任務生成器的可生成任務統計及示例圖像/視頻。論文為每個任務生成器配備了高級感知技能,這一系列任務生成器共同能生成超過7.5億個VQA任務

采用人工標注的場景圖。總計,它能生成超過7.5億種可能的VQA任務實例(詳見圖3的分解)。論文從Visual Genome 中抽取圖像場景圖,從Action Genome 中抽取視頻時空場景圖。論文還包含了GQA和AGQA以獲取真實的VQA實例。對于2D和3D場景,論文從Objaverse-LVIS中選取了337個類別中的1,996個高質量3D對象,這是Objaverse 1.0 的一個子集,已用LVIS 類別進行標注。每個3D對象都人工標注了顏色、材料、形狀和可見角度等屬性。

這28種不同的任務生成器提供了一種全面評估視覺理解能力的方法,包括物體識別、屬性識別、關系識別、定位、空間推理、時間推理、動作識別等(圖3)。憑借這種多樣性的潛在問題,TASK-ME-ANYTHING支持在不同所需粒度級別上的評估。

對于模型用戶,TASK-ME-ANYTHING可以幫助決定哪款模型適合其需求;對于模型開發者,它能識別模型的弱點以進行改進。例如,一個希望找到區分不同犬種最佳模型的用戶可以查詢:“區分犬類的三大最佳模型是什么?”同樣,模型開發者可能會查詢:“所有模型在空間推理方面普遍缺乏哪些能力?”以識別當前架構中的一些普遍問題。或者他們也可能查詢:“LLAVA在哪些類型的材料識別上表現不佳?”然后添加相應數據到訓練中,以提升LLAVA的材料識別性能。

該系統不僅功能多樣,而且可擴展。通過添加新的任務生成器、資產如3D對象模型以及軟件如Blender、DALL-E等,論文可以持續擴展其分類體系。更新底層能力的分類體系比為機器學習模型(MLMs)快速增長的使用案例收集足夠數據更具可擴展性。

2.3 使用TASK-ME-ANYTHING評估MLMs

在本研究中,論文廣泛評估了13個開源MLMs在100萬個任務實例上的表現,以及18個開源/專有MLMs在8,400個任務實例上的表現,這些任務實例均由TASK-ME-ANYTHING生成,以驗證TASK-ME-ANYTHING并進行分析。

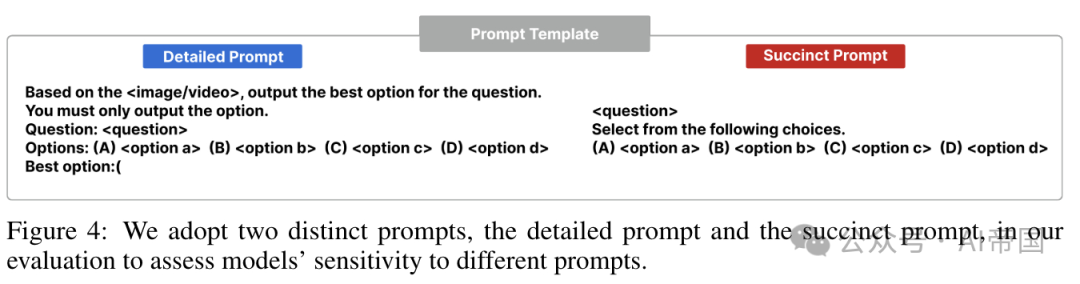

模型評估協議。論文采用模型在任務上的準確率來捕捉模型的性能。然而,一個任務可以包含眾多具體的任務實例。實踐中,論文隨機為每個任務生成n個任務實例,然后使用模型在這n個任務實例上的準確率作為模型在該任務上準確率的代理。為了公平評估模型的性能并增強結果的魯棒性,論文使用了兩種版本的提示:簡潔提示和詳細提示。簡潔版本僅在問題和選項之間添加了“從以下選項中選擇”[24],而詳細提示則包括更多指令,如:“基于圖像/視頻”,并將選項括在括號內(例如,“(A) 相機 (B) 電話”),并在提示末尾加上“最佳選項:(”以引導模型僅輸出選項[53]。確切的提示模板可在圖4中找到。對于選項提取,論文將模型輸出與三種類型的選項表示進行匹配:1) 選項標識符,例如,“(A)”,2) 選項名稱,例如,“相機”,3) 選項標識符和名稱,例如,“(A) 相機”,以提高選項提取的召回率。

圖4:論文采用兩種不同的提示,詳細提示和簡潔提示,在論文的評估中以評估模型對不同提示的敏感性

TASK-ME-ANYTHING-RANDOM:隨機任務集。為了概述當前TASK-ME-ANYTHING的任務空間,論文從每個任務生成器中創建一個包含100個任務的隨機子集。對于每個任務,論文隨機生成3個任務實例,產生5,700個圖像問答任務實例和2,700個視頻問答任務實例。論文稱這個隨機集為TASK-ME-ANYTHING-RANDOM,并將其作為基準發布。論文使用詳細提示和簡潔提示評估了18個開源/專有MLMs。

TASK-ME-ANYTHING-DB:模型評估結果數據庫。論文還隨機從所有任務生成器中選擇了超過10萬個任務,并為每個任務生成了15個任務實例,總共產生了超過100萬個任務實例。然后,論文使用詳細提示評估了13個開源MLM模型在這些生成的任務實例上,產生了總共24,240,780個<模型, 任務實例>評估對。論文稱這一系列的評估結果為TASK-ME-ANYTHING-DB,論文用它來研究查詢結果近似方法,并發布以供未來研究模型性能預測。

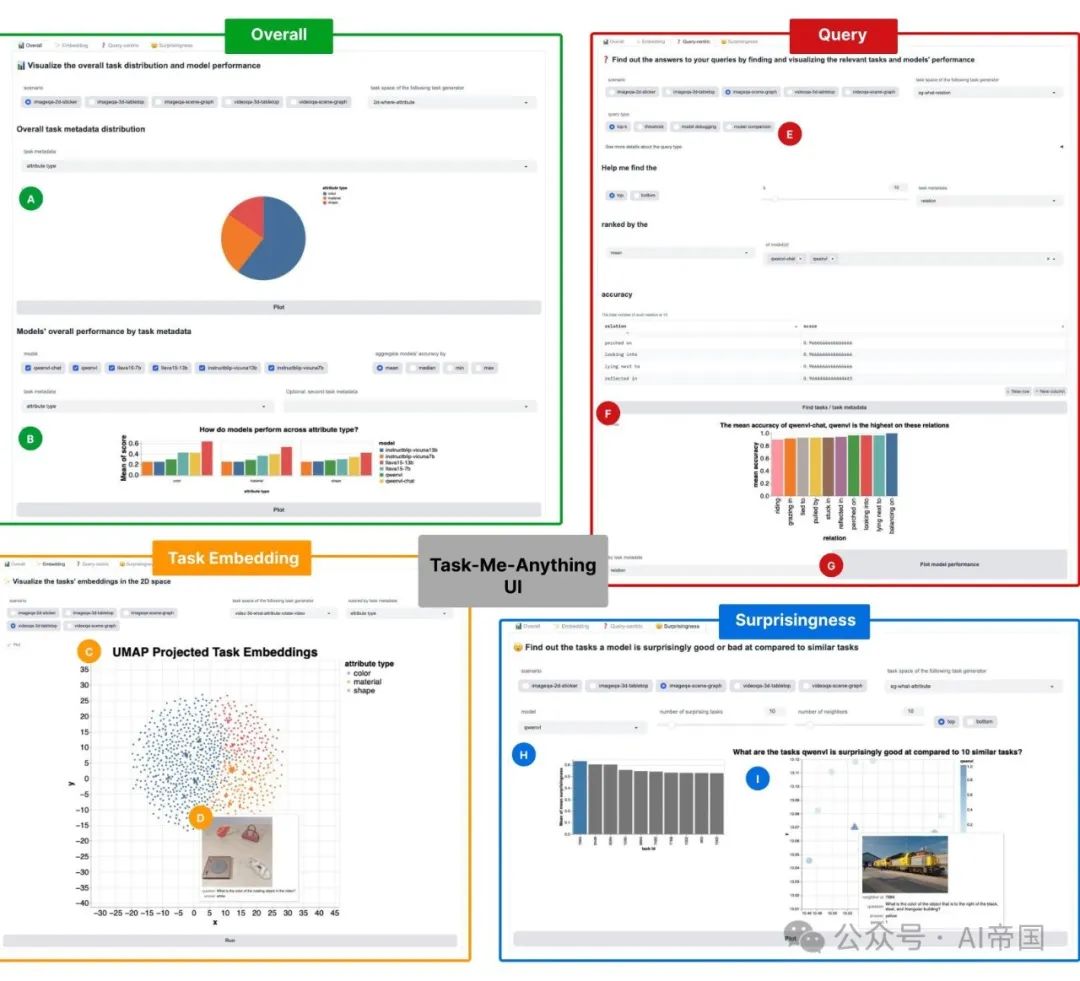

TASK-ME-ANYTHING-UI:模型性能研究圖形界面。TASK-ME-ANYTHING 允許用戶查詢與其應用最相似的任務。因此,TASK-ME-ANYTHING 不必局限于大多數其他基準常見的靜態排行榜。相反,論文通過交互式圖形用戶界面使 TASK-ME-ANYTHING 的發現可訪問。論文的界面允許用戶在不編寫任何代碼的情況下指定他們的需求。他們可以選擇最能代表其應用的分類法部分。論文使用在 TASK-ME-ANYTHING-DB 中獲得的探索結果來構建一個簡單的示例界面:TASK-ME-ANYTHING-UI。它包含四個選項卡:

總體選項卡報告了在 TASK-ME-ANYTHING 分類法的不同子集上跨十幾個 MLM 的模型性能;

任務嵌入選項卡在 2D 空間中可視化不同的任務實例,并允許用戶觀察模型在類似任務上的行為;

意外性選項卡突出顯示了模型相對于類似任務表現出色或不佳的任務;

查詢界面支持用戶使用上述四種細粒度用戶查詢類型進行以查詢為中心的模型能力或限制調查(圖 5)。

2.4 驗證與剖析 TASK-ME-ANYTHING?

論文通過測量人類在論文任務上的表現來驗證論文生成的評估數據的準確性。然后,論文評估了不同近似方法,以證明它們的效果。

圖5:TASK-ME-ANYTHING-UI 接口

通過人類評估進行驗證。為了驗證TASK-ME-ANYTHING,論文首先對TASK-ME-ANYTHING-RANDOM進行了(N=2)人類評估,以檢查任務的正確性。在這些隨機子集中,標注者對于來自不同任務生成器的任務實例的準確率達到了92% - 100%(具體而言,人類在ImageQA 2D計數任務上達到了100%,而在VideoQA 3D旋轉任務上達到了92%),表明論文的任務準確且可由人類解決。相比之下,GQA [39] 和 AGQA [29] 報告的人類性能在70% - 84%之間。

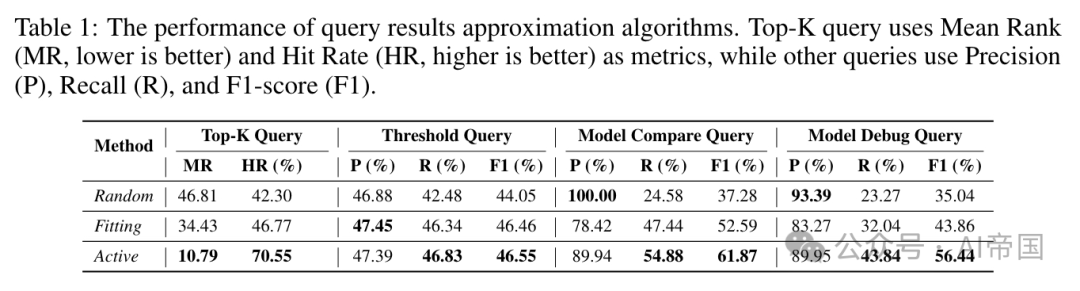

分析近似算法。論文在4種查詢類型中共1,137個查詢上評估了提出的查詢結果近似算法(見表1)。為了衡量近似質量,論文使用TASK-ME-ANYTHING-DB的評估結果作為基準查詢結果。從表1中可以看出,Active方法在幾乎所有查詢類型上都優于Random和Fitting方法,但仍有改進空間。實驗和結果的更多細節見附錄F。

表1:查詢結果近似算法的性能。Top-K查詢使用平均排名(MR,越低越好)和命中率(HR,越高越好)作為指標,而其他查詢使用精確度(P)、召回率(R)和F1分數(F1)

2.5 使用TASK-ME-ANYTHING分析MLMs

論文使用TASK-ME-ANYTHING進行了多項分析,以突出其不同的使用場景,同時對當今的MLMs進行深入洞察。

2.5.1 查詢1:模型在所有可能問題的一個隨機子集上的表現如何?

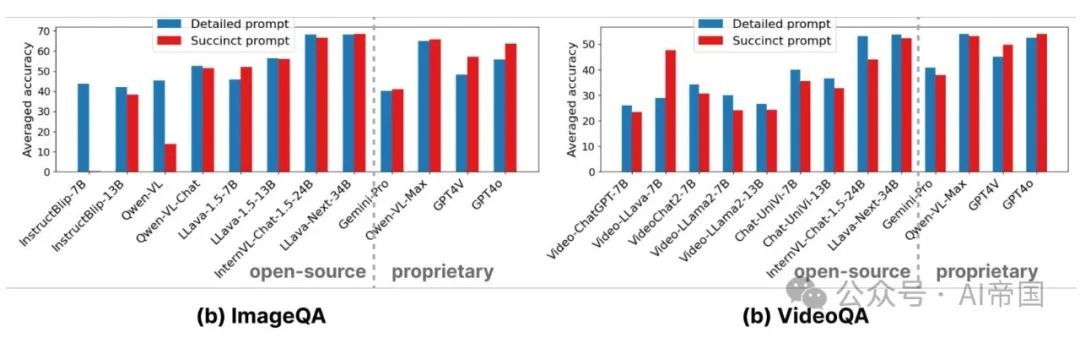

論文評估了18個MLMs在TASK-ME-ANYTHING-RANDOM測試集上的表現(圖6),以獲得模型性能的概覽。通常,詳細的提示會產生更好的結果;然而,某些模型,如GPT4V,使用簡潔提示時的表現要遠優于其他模型,表明當前模型仍然對提示敏感。

對于圖像問答任務,最新的開源模型,如INTERNVL-CHAT-1.5-24B和LLAVA-NEXT-34B,表現優于流行的專有模型,達到了最先進的性能,這一點也在最近的基準測試結果中得到證實[16]。值得注意的是,像INSTRUCTBLIP-7B和QwEN-VL這樣的模型,在詳細提示下的表現明顯優于簡潔提示。對于視頻問答任務,論文還評估了較大或專有的圖像問答模型,如GPT4V,通過將視頻的四個幀拼接成一張圖片。值得注意的是,VIDEO-LLAVA-7B在簡潔提示下的表現遠優于其他小型開源模型。

圖6:模型在TASK-ME-ANYTHING-RANDOM上的性能表現,這是TASK-ME-ANYTHING中隨機選取的任務子集

2.5.2 查詢2:MLMs在哪些技能上表現最佳和最差?

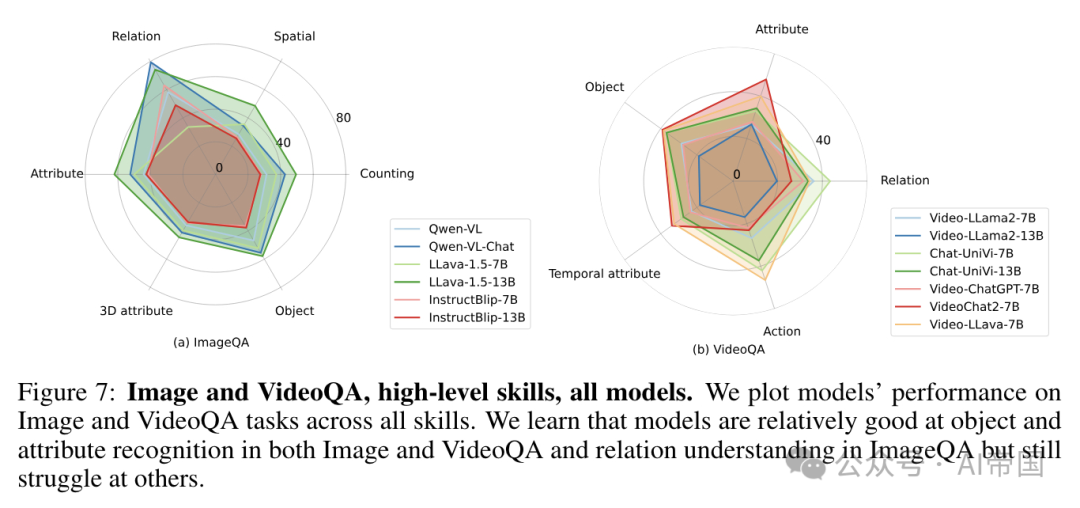

論文分析了不同感知能力下的性能,以回答:所有模型在哪些技能上表現得好或差?論文分別對ImageQA和VideoQA任務進行了這項研究。論文發現,沒有特定的技能在所有(圖像和視頻)模型中表現得最好或最差(圖7)。論文觀察到,所有模型在ImageQA任務中的空間推理、物體計數和3D屬性理解方面都存在困難,而在VideoQA任務中的物體識別和時間理解方面也存在困難。它們在物體、屬性和其他關系識別實例上表現良好。

令人驚訝的是,論文發現大多數MLMs在物體間的關系理解上表現最佳,如果不能完美得分,也能在交互關系如“騎乘”、“注視”、“躺在一旁”等方面獲得高分。另一方面,這些模型在合成圖像中的空間推理方面表現最差,尤其是在詢問圖像中“中間”、“底部”或“后面”(對于3D圖像)部分的物體的問題上表現不佳。盡管如此,一些模型表現不同。例如,LLAVA-13B在識別3D屬性方面表現最差,未能正確識別“最小”或“最近”的3D物體。與此同時,LLAVA-7B在物體識別方面表現最佳,而在關系理解方面表現最差,難以理解其他模型能夠很好地執行的簡單動作,如“觸摸”。

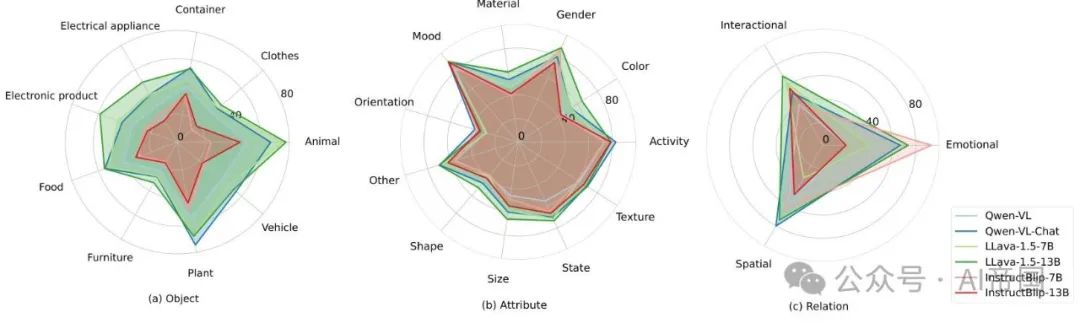

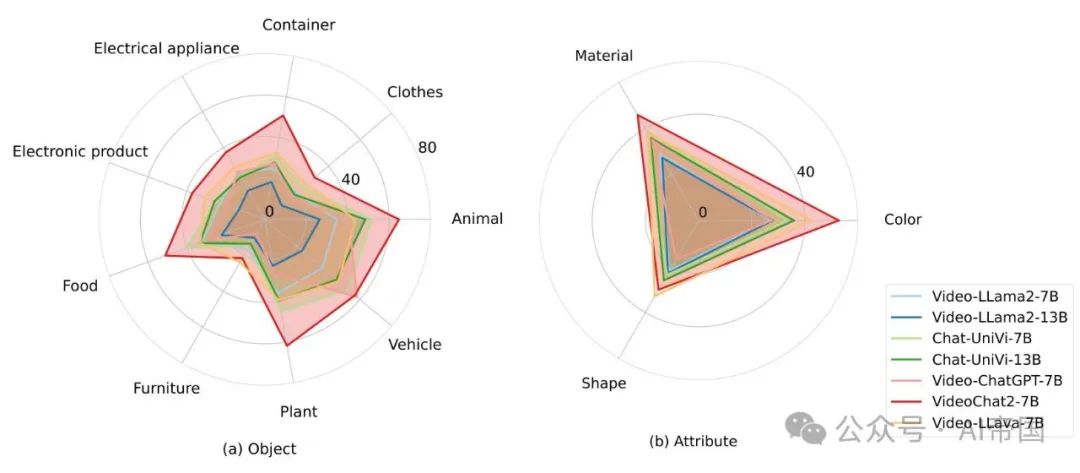

此外,TAsK-ME-ANYTHING還使論文能夠對模型的細粒度技能進行分析,例如識別特定類型的對象、屬性或關系。例如,在ImageQA任務中,論文發現平均而言,模型在識別植物、理解情緒以及理解現實世界對象之間的空間關系方面表現更好(圖9)。然而,某些模型可能展現出不同的優勢:LLAVA-13B在識別動物方面表現更佳(圖9(a)),而INSTRUCTBL1P-7B在理解情感關系方面更勝一籌(圖9(O))。另一方面,在VideoQA任務中,論文了解到模型在識別車輛、材料以及理解空間關系方面表現更佳(圖10和圖11)。

2.5.3 查詢3:哪種MLM最適合特定技能

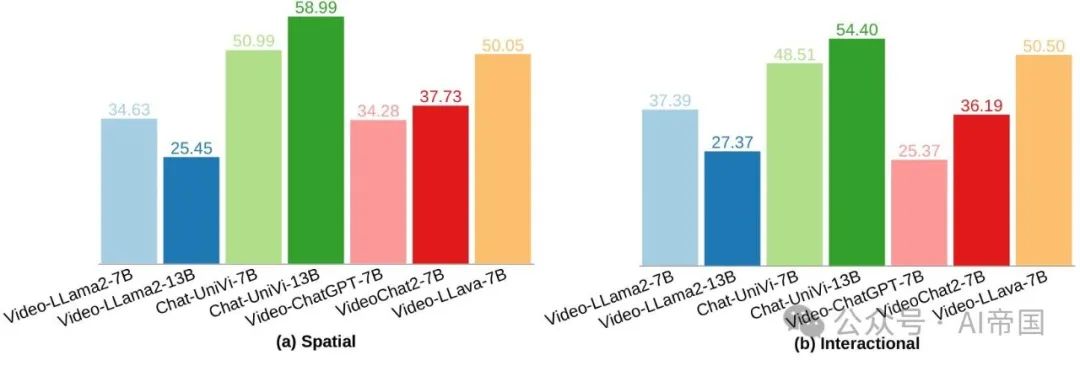

LLAVA-13B在ImageQA任務中表現突出,除關系理解外,在所有技能上均取得最佳成績;而VIDEO-LLAVA-7B則是VideoQA任務的總體贏家,在動作理解方面得分最高,在其他方面排名第二或第三。具體而言,論文發現LLAVA-13B在除關系理解外的所有技能上,相比其他多模態模型表現更為一致,其中QwEN-VL-CHAT在關系理解方面表現更佳(圖7(a))。在VideoQA任務中,除了VIDEO-LLAVA-7B外,CHAT-UNIVI-7B也相對全面,在除屬性理解外的所有技能上均位列前三(圖7(b))。另一方面,盡管VIDEOCHAT2-7B在對象、屬性和時間屬性理解方面表現出色,但在動作和關系推理方面則稍顯不足(圖7(b))。

圖7:圖像和視頻問答,高級技能,所有模型。論文繪制了模型在圖像和視頻問答任務中所有技能上的表現。論文發現模型在圖像和視頻問答中的物體和屬性識別以及圖像問答中的關系理解方面相對較好,但在其他方面仍面臨挑戰

圖8:圖像和視頻問答,高級技能,開源與專有最佳模型。論文繪制了在圖像問答和視頻問答任務中,每項技能的最佳開源模型與專有模型的性能對比

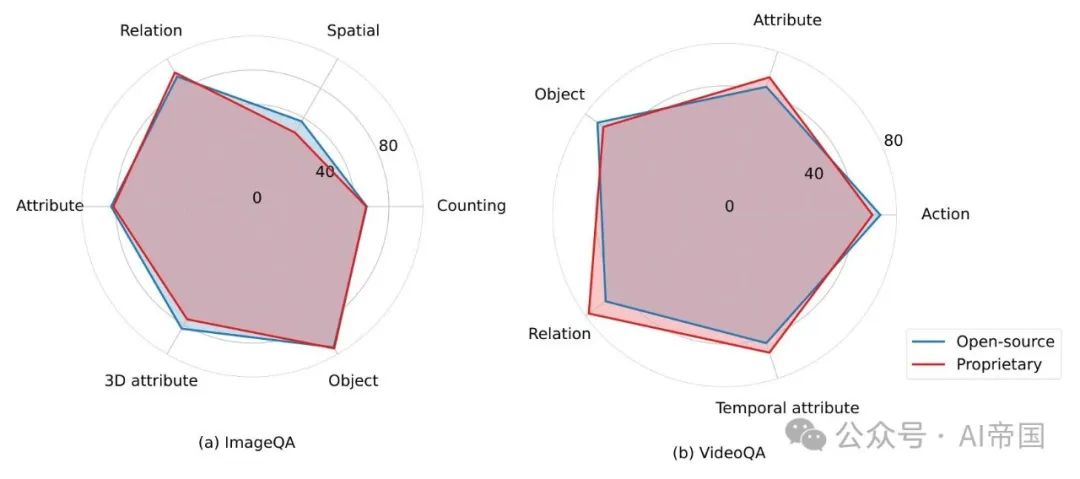

2.5.4 查詢4:在各項技能中,最佳開源模型與最佳專有模型相比如何?

此外,論文發現在圖像問答任務中,最佳開源模型(在物體識別方面為LLAVA-NEXT-34B,關系理解方面為LLAVA-13B,其他方面為INTERNVL-CHAT-1.5-24B)

圖9:ImageQA,細粒度技能,所有模型。論文還分析了模型在ImageQA任務上針對細粒度技能的表現,發現盡管不同模型之間存在差異,但平均而言,模型在識別植物、理解情緒以及理解現實世界物體之間的空間關系方面表現良好

圖10:視頻問答,細粒度對象及屬性技能,所有模型。論文展示了模型在視頻問答任務中針對細粒度技能的表現,并發現平均而言,模型在識別車輛和理解視頻中的材料方面表現良好

圖11:VideoQA,細粒度關系技能,所有模型。在VideoQA任務中,論文發現模型在平均水平上更擅長理解空間關系而非交互關系

其中,最佳開源模型在屬性識別上與最佳專有模型(GPT4O)持平,甚至在計數和QwEN-VL-CHAT等方面表現更佳(圖8)。值得注意的是,最佳開源模型在空間推理上領先最佳專有模型約8%,在3D屬性上領先7%。在VideoQA任務中,最佳開源模型INTERNVL-CHAT-1.5-24B在物體和動作識別上超越了最佳專有模型QwEN-VL-MAX,但在屬性、時間屬性和關系理解上落后于專有模型5-10%。

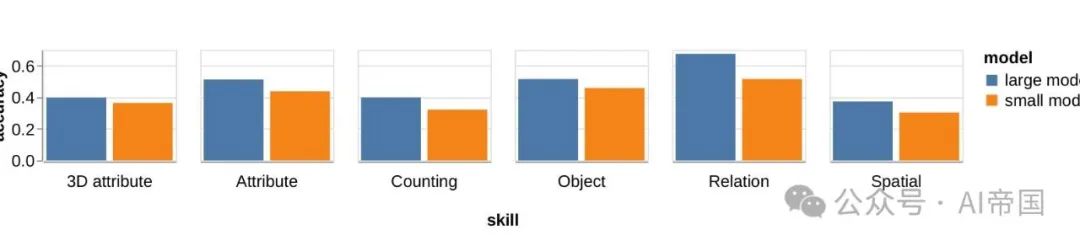

2.5.5 查詢5:小型模型與大型模型的對比如何?

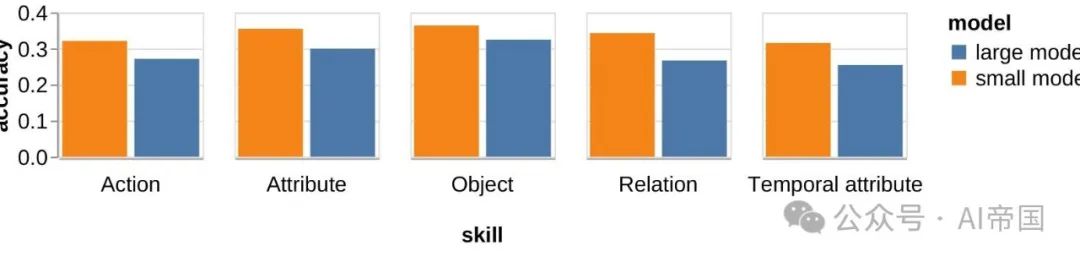

論文也對具有相同技能的小型模型與大型模型的相對性能感興趣。例如,在ImageQA任務中,論文觀察到大型多模態模型在ImageQA任務上的整體表現優于小型模型(圖12)。然而,這一發現對于個別模型可能并不總是成立。通過來自同一來源的小型和大型模型之間的t檢驗,論文發現一個例外:INSTRUCTBLIP-7B(u = 0.63)在關系理解上顯著優于INSTRUCTBLIP-13B(pu = 0.49),p值< 1e - 5(圖14)。

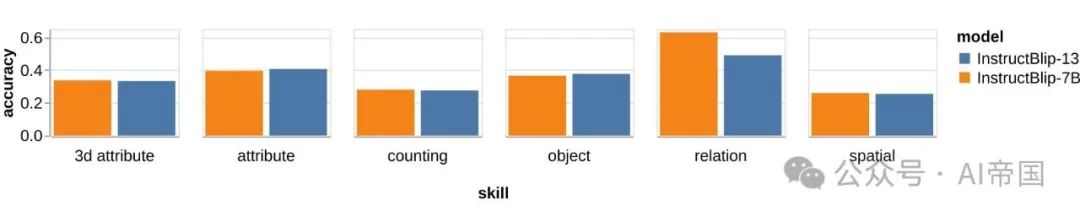

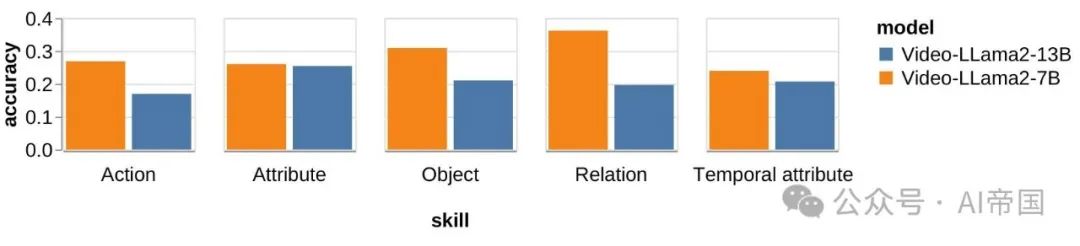

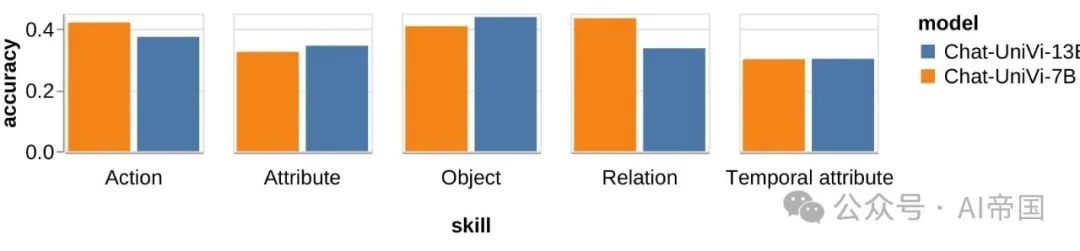

在VideoQA任務中,有趣的是,論文發現小型模型在平均水平上在VideoQA任務中擊敗了大型模型(圖13)。論文推測這是因為論文在評估中包含了一些強大的小型視頻模型。例如,論文看到VIDEO-LLAMA-2-7B在所有技能上的得分高于VIDEO-LLAMA-2-13B,p值< 3e - 5(圖15),并且CHAT-UNIVI-7B在動作和關系理解上優于CHAT-UN1V1-13B,p值< 1e - 5(圖16)。

圖12:技能比較:小型模型與大型模型在ImageQA上的表現

圖13:技能對比:小型與大型模型在視頻問答上的表現

圖14:技能對比:INSTRUCTBLIP-7B 與 INSTRUCTBLIP-13B

圖15:技能比較:VIDEO-LLAMA-2-7B 與 VIDEO-LLAMA-2-13B

圖16:技能對比:CHAT-UNIV1-7B vs. CHAT-UNIVI-13B

2.5.6 查詢6:模型的優勢和劣勢在視覺輸入上是否一致?

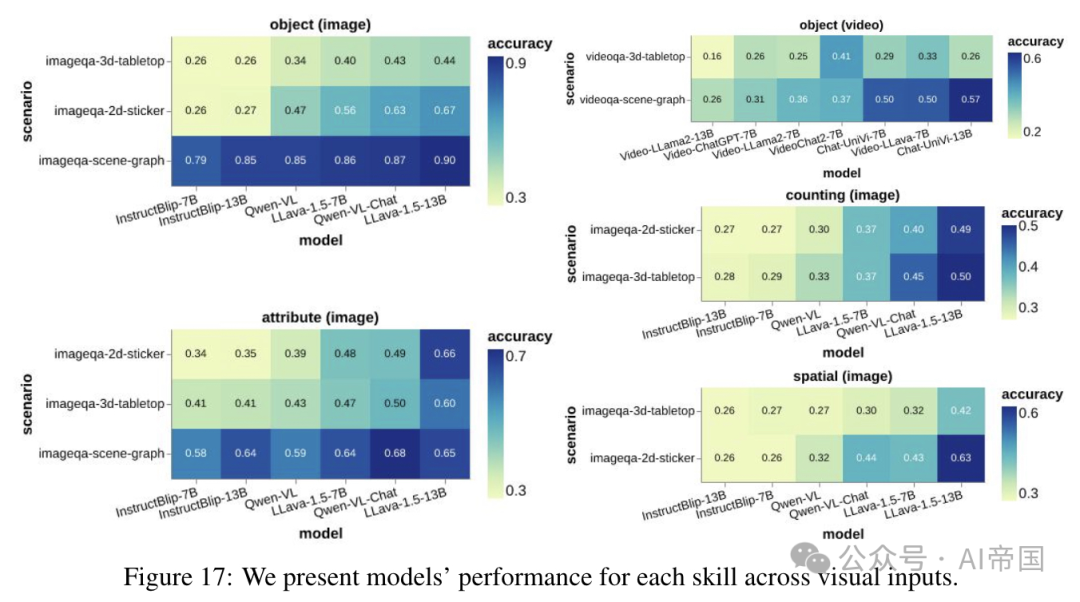

進一步地,論文好奇模型的強項和弱項在視覺輸入上是否保持一致。為此,論文考察了模型在物體、屬性、空間理解和計數等技能上的表現,這些技能涉及多種視覺輸入任務,如2D和3D。論文發現,對于同一技能,模型在不同視覺輸入下的排名大體保持一致(圖17)。論文觀察到,在同一技能下,不同視覺輸入的模型準確度得分之間存在強相關性(斯皮爾曼系數為0.77-0.94),只有一個例外:視頻模型在3D桌面任務中對物體理解的表現在場景圖任務中的表現僅弱相關(系數=0.64)。這一發現表明,論文定義的技能與視覺輸入是正交的,這使論文能夠發現模型的固有優勢和劣勢。

圖17展示了模型在處理視覺輸入時針對每項技能的表現

2.5.7 查詢7:當前流行的專有模型GPT40在哪些方面表現不佳?

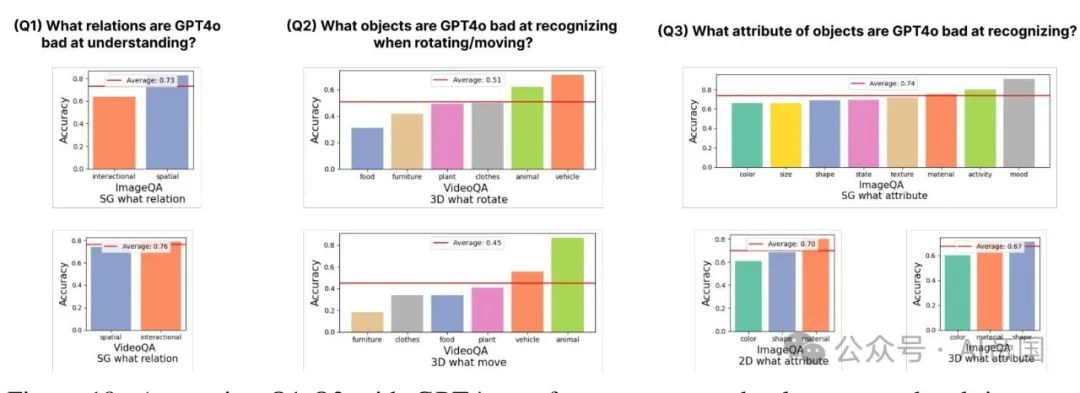

最后,論文探討了當前流行的專有模型GPT40的不足之處:GPT40在旋轉/移動物體識別方面存在哪些缺陷?在理解關系方面有何不足?以及在識別物體屬性方面有哪些弱點?為了回答這些問題,論文首先為每個問題確定任務生成器,這些生成器能夠產生相關的任務以供評估。基于此,論文提供了GPT40在物體/關系/屬性類別和個人識別方面的不足之處。需要注意的是,這些只是示例問題,TASK-ME-ANYTHING可以處理更多此類問題。

通過物體/關系/屬性類別進行回答。首先,論文通過比較GPT40在不同粗粒度物體/關系/屬性類別及其平均表現來回答這些問題,如圖18所示。論文可以看到:1) GPT40在識別圖像中的“交互性”關系和視頻中的“空間關系”方面表現不佳;2) 識別旋轉/移動的“家具”、“食物”和“植物”對GPT40來說比識別其他物體類別如“動物”和“車輛”更具挑戰性;3) GPT40在識別“顏色”方面比其他屬性表現更差。

圖18:使用GPT4O在隨機生成的任務實例上回答Q1-Q3,這些任務實例涉及粗粒度的對象/關系/屬性類別

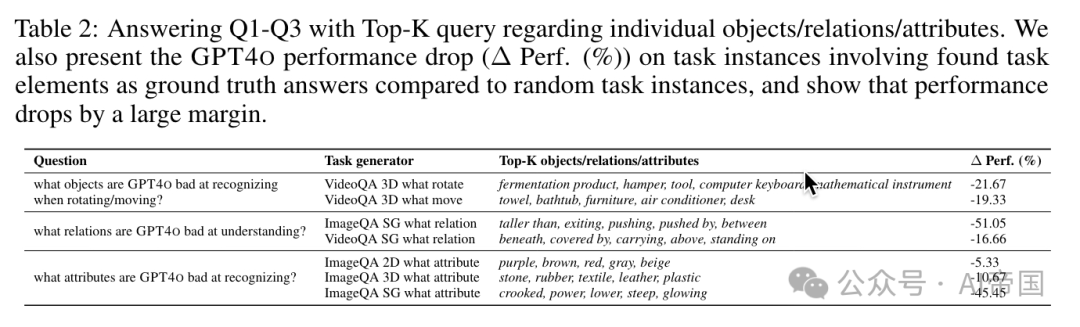

針對個體對象/關系/屬性的回答。為了精確找出GPT4O在哪些具體的對象/關系/屬性上表現不佳,論文將每個問題轉化為關于個體對象/關系/屬性的Top-K查詢,并采用論文的Active方法進行查詢結果的近似,預算為GPT4o調用次數。論文發現,在TASK-ME-ANYTHING發現的Top-s對象/關系/屬性上,GPT40的性能大幅下降(-5%至-50%6),表明這些仍然對GPT4o構成挑戰(表2)。此示例展示了如何利用TASK-ME-ANYTHING系統來定位模型在細粒度概念上的弱點。

表2:針對個體對象/關系/屬性的Top-K查詢回答Q1-Q3。論文還展示了與隨機任務實例相比,GPT4o在涉及發現任務元素作為地面實況答案的任務實例上的性能下降(A Perf. (%)),并表明性能下降幅度很大

本文轉載自 AI帝國,作者: 無影寺