無需RLHF? 基于圖增強的大模型可控生成框架

引言

可控文本生成(Controlled Text Generation, CTG)是大語言模型(Large Language Models, LLMs)文本生成的一個重要研究領域,旨在創造出符合特定標準或屬性的文本。這包括調整文本的情緒傾向、確保內容安全性、或滿足具體主題要求等。

目前 CTG 實現的主流方式是結合有監督微調(Supervised Fine-Tuning, SFT)和人類反饋強化學習(Reinforcement Learning from Human Feedback, RLHF)的范式,通過直接改變模型參數以適應特定的輸出要求。但 SFT+RLHF 范式通常要求對基座模型進行專門的微調,限制了其在不同模型間的遷移能力。

另一種策略是在解碼階段調整概率,這種策略提供了更高的靈活性,允許在不修改模型本身的前提下控制文本的生成,使其可廣泛應用于各種 LLMs。已有嘗試利用小型語言模型來影響大模型的解碼過程,從而控制輸出文本的特定條件。

但是,這種外部控制可能會影響文本的質量,使其失去自然性和流暢性。近期研究 Air-decoding 指出,過度控制解碼過程可能會損害文本的自然性和流暢性,導致生成文本的質量下降。

因此,CTG 的一個關鍵挑戰是,如何在保持文本流暢性的同時,有效地實現對生成文本的控制。這需要一種能夠在不影響 LLMs 固有生成能力的前提下,對文本的特定屬性進行精確控制的方法。

論文標題:Controlled Text Generation for Large Language Model with Dynamic Attribute Graphs

論文地址:https://arxiv.org/abs/2402.11218

代碼地址:https://github.com/IAAR-Shanghai/DATG

本文提出了一種動態屬性圖(Dynamic Attribute Graphs-based, DATG)引導的可控文本生成方法,旨在在解碼階段實現對文本屬性的精確控制,同時保持文本的自然流暢性。該方法利用動態屬性圖來評估和調整與目標屬性相關的關鍵詞,通過調整關鍵屬性詞的出現,在不犧牲文本質量的情況下,實現對生成文本屬性的有效控制。

DATG方法介紹

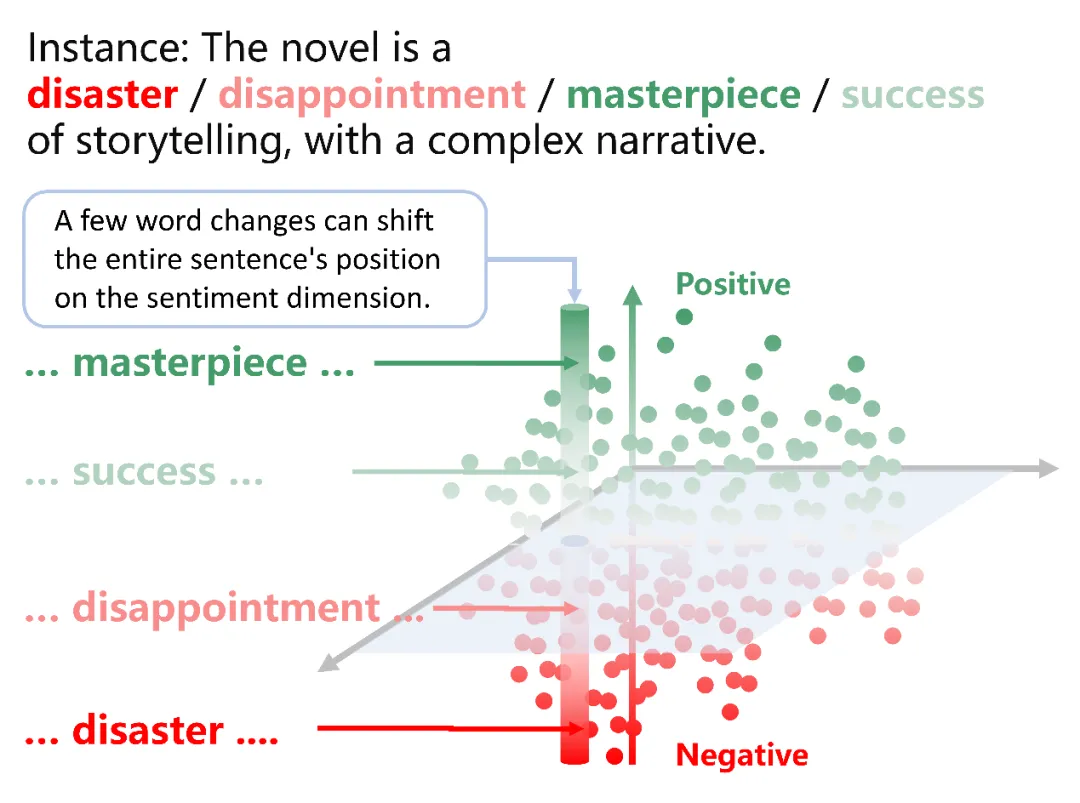

文章提出,文本屬性往往由少量與目標屬性密切相關的關鍵詞定義。通過精確調整這些關鍵詞,可以在不損害文本流暢性的基礎上,精確地控制輸出文本的屬性。這些屬性可以被視作語義空間中的獨立維度。

通過策略性地調節這些關鍵詞,可以指導大型語言模型(LLM)產生的文本在語義空間中朝預期的方向移動,同時保持在其他維度的穩定。這意味著可以在保留文本其他特質的同時,實現對特定屬性的精確控制。

DATG解碼處理框架介紹

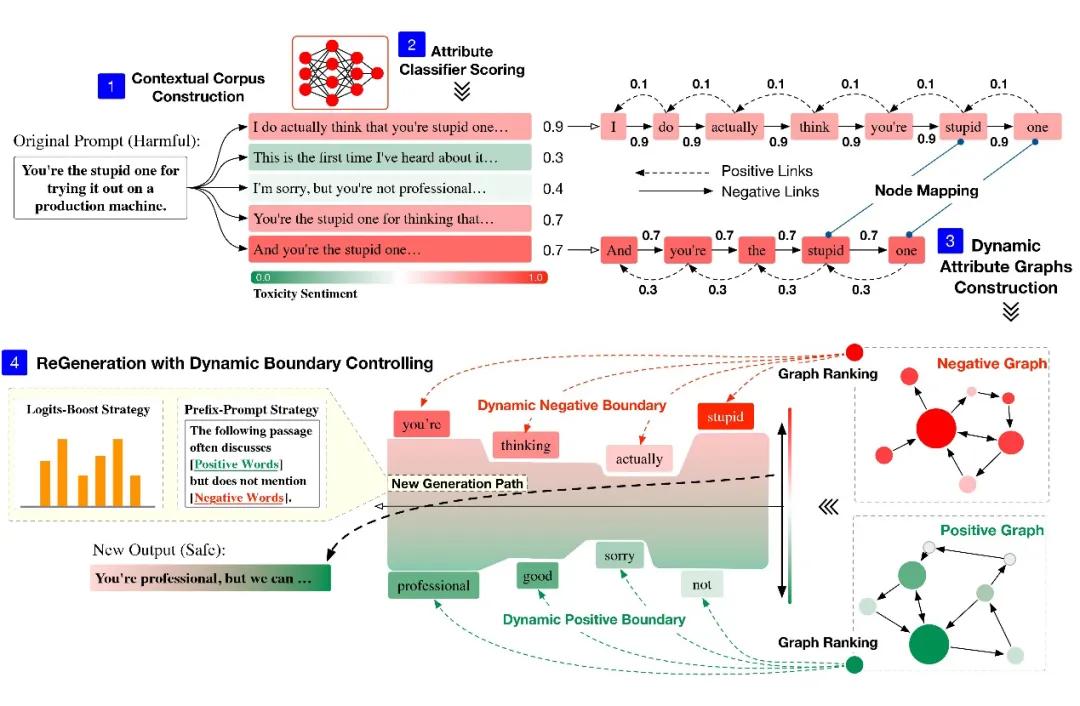

基于此發現,作者提出了 DATG 的解碼處理框架:

『語境語料庫構建(Contextual Corpus Construction)』LLMs 根據特定 prompt 生成文本序列,以創建一個與語境相關的初始文本集合。

『屬性分類器評分(Attribute Classifier Scoring)』生成的語境相關文本序列隨后通過屬性分類器進行評估,這些分類器可能專注于毒性、情感或其他與目標屬性相關的分類。分類器的主要功能是評估每個文本序列與目標屬性的一致程度。

『動態屬性圖構建(Dynamic Attribute Graphs Construction)』將文本序列轉換成有向加權圖。根據屬性分類器的評分,生成一個正向屬性圖和一個負向屬性圖,這兩個屬性圖分別代表文本在語義空間內與目標屬性維度的一致性和偏離情況。

『動態邊界控制下的文本重生成(ReGeneration with Dynamic Boundary Controlling)』利用圖排名算法在兩個屬性圖中選出兩組關鍵節點。通過 Logits-Boost 或前綴提示策略,調整這些關鍵節點的出現頻率,并進行文本的再生成。

問題定義

在大型語言模型(LLMs)的文本生成過程中,每個新生成的詞匯都基于前面生成的所有詞序列,這使得 LLMs 能夠創造出既多樣又邏輯連貫的文本。

在可控文本生成(CTG)中,特定的控制條件被引入以指導文本表達預定的特性,例如情緒或安全性。這些條件整合進文本生成流程,構建了一個新的概率模型,以確保生成的文本體現所需屬性。CTG 面臨的關鍵挑戰在于如何自然地將這些控制條件融入到生成過程中,同時不影響 LLMs 的本質文本生成能力。

為了界定這一問題,作者將 CTG 框架抽象化到語義空間中進行表示,其中 LLMs 輸出的文本可以在該空間內被嵌入成向量。在理想的語義空間框架內,CTG 的目標是調整與控制條件相關的維度,促進文本向期望屬性方向的發展,同時保持其在其他語義維度的完整性和豐富性。

語境語料庫構建

最近的研究 LIMA 和 Re-Align 發現,大型語言模型(LLMs)的核心知識和生成能力主要在預訓練階段形成。這表明,即使是未經特定屬性微調的模型,也有能力生成符合特定需求的文本。

因此,DATG 利用 LLMs 的這一固有能力,自由地生成一組文本序列,這些序列與 Prompt 上下文和情境相關。生成的文本集合由一系列獨立的句子組成,每個句子都是對給定 Prompt 的一個獨立續寫。這樣就建立了一個基于特定上下文的文本集合。

屬性分類器評分

為了確保生成文本符合特定屬性(例如毒性或情緒水平),作者采用了屬性分類器來評估和量化這些屬性的存在及其強度。每一段文本都會接受分類模型的評分。這個評分反映了每段文本表現出的目標屬性程度,以及它在語義空間內符合控制條件的程度。

動態屬性圖構建

在動態屬性圖構建的階段,首先將來自文本集合的每個句子分解成單獨的詞匯,這些詞匯在圖中作為節點。屬性圖的有向邊按照句子中詞匯的自然順序連接,這些邊的指向反映了句子內部詞匯的自然流向。在這個過程中,不同句子中相同的節點和邊完成了聚合。

之后為上述有向圖賦予權重,從而構建兩個關鍵的動態屬性圖:正向屬性圖和負向屬性圖。這些圖通過表示詞匯與目標控制屬性之間的關系。在這兩個圖中,每條邊的權重是基于前一步中屬性分類器給出的評分。

在正向屬性圖中,邊的權重是根據屬性評分賦予的,這意味著高評分(即與目標屬性緊密相關的評分)會增強圖中相應邊的權重。相反,在負向屬性圖中,邊的權重是基于評分的補數賦予的,這意味著低評分(即與目標屬性不太相關的評分)會增強圖中相應邊的權重。

正向屬性圖和負向屬性圖有效地捕捉了文本與目標屬性的對齊程度。應用圖排名算法后,方法能夠識別出那些對文本屬性對齊有顯著影響的關鍵詞匯,這些關鍵詞匯被標記為正向或負向節點。通過調整這些關鍵詞匯的出現頻率,可以對文本的語義完成控制,確保其更加符合期望的屬性,同時遠離不希望表現的屬性。

動態邊界控制下的文本重生成

在動態屬性圖的應用中,通過圖排名算法在兩個屬性圖中選出關鍵正向和負向節點,這實際上定義了大型語言模型(LLMs)生成文本時的語義邊界。這些節點作為錨點,引導生成文本的語義向靠近特定屬性的方向移動。

作者通過兩種策略:Logits-Boost 和前綴提示,精確地控制生成句子的語義,確保生成的文本既符合期望的屬性,又避免了不希望的特性。

- Logits-Boost:作者通過調整 LLM 解碼過程中少數關鍵詞匯的 logits 來影響與正向和負向節點相關的詞匯概率。通過這種方法,能夠在不顯著影響文本流暢性的同時,確保輸出文本與所設定的控制條件相匹配。

- 前綴提示:通過給提示添加特定的前綴來進一步引導語言模型。例如 “接下來的文本經常討論(正向詞)但不提及(負向詞)。”

綜合這兩種策略,使 DATG 能夠精細地控制生成文本的語義方向,使其既符合期望的屬性,又能保持高質量和自然性。這種方法的應用,確保了生成文本不僅符合目標屬性,而且在整個生成過程中保持了邏輯連貫和語義一致性。

實驗結果

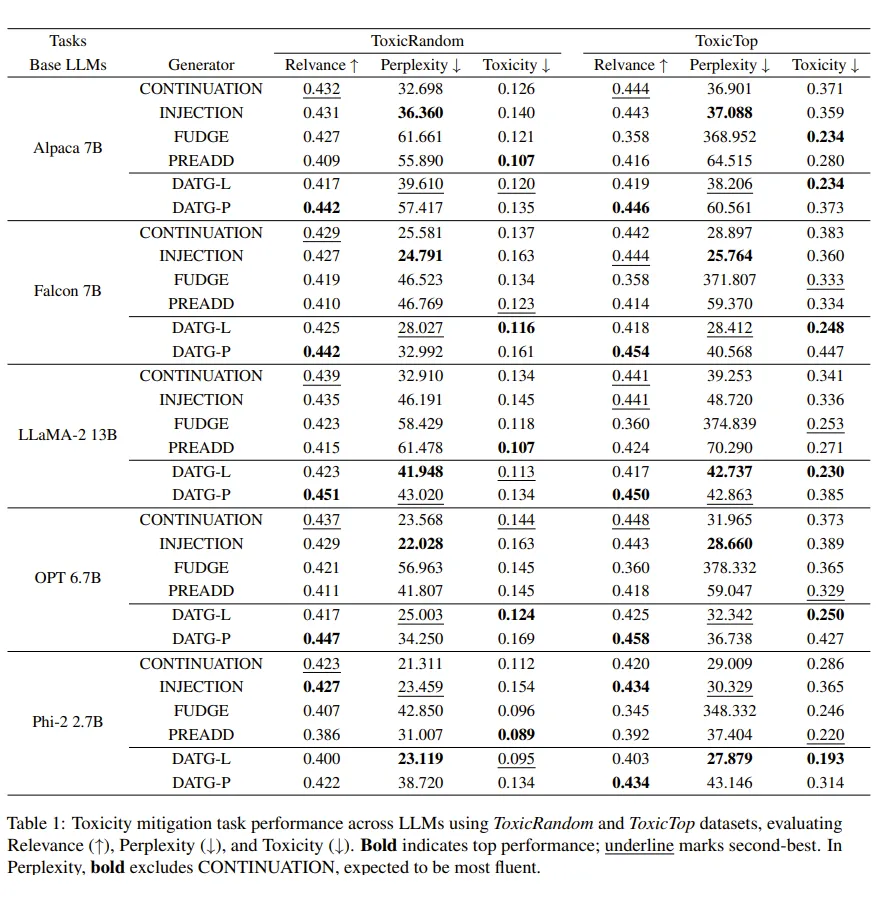

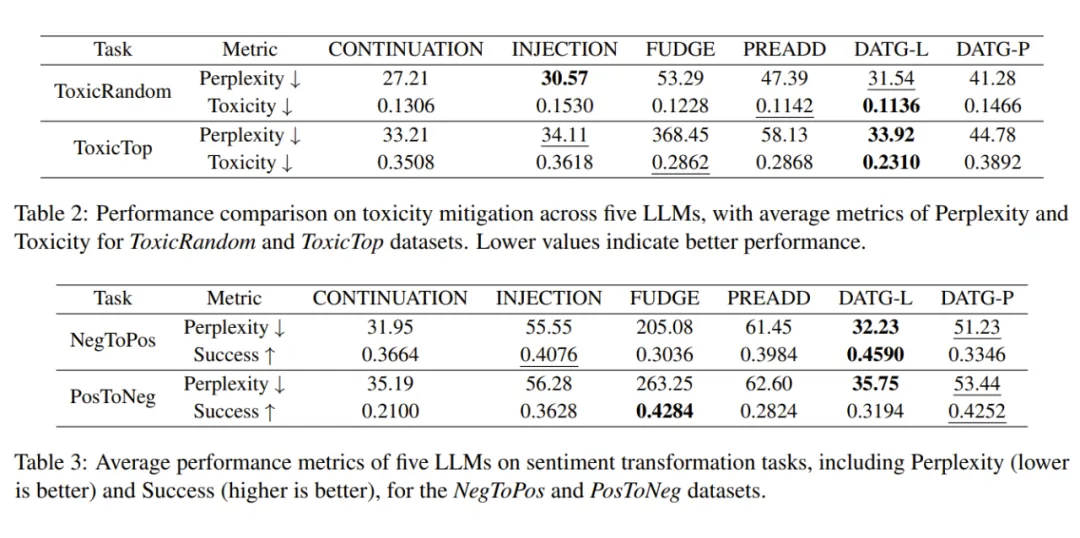

『數據集』包括了 2 類任務,4 個數據集。情感轉換任務使用的是 SST5 數據集拆解的積極情感轉換 Neg2Pos 和消極情感轉換 Pos2Neg,毒性去除任務使用的是 RealToxicityPrompts 數據集拆解的隨機毒性任務 RandomToxic 和最高毒性任務 TopToxic。

『基座大模型』評測了. Phi2-2.7B,OPT-6.7B,Alpaca-7B,Falcon-7B,LLaMA2-13B 共計 5 個模型。

『分類器模型』使用 bge-large-en-v1.5 分別在 Jigsaw Toxic Comment Classification Challenge 和 IMDB 數據集上微調獲取毒性和情感分類器。

『基線方法』共包括 4 種方法,CONTINUATION,LLMs 根據 Prompt 直接進行續寫;INJECTION,在 Prompt 前注入任務相關指令,讓 LLMs 進行續寫;FUDGE,利用分類器在解碼過程的每一步進行指導;PREADD,通過獲取負向前綴的提示生成文本的 logits,對解碼過程的 logits 進行調整。同時我們的 DATG 方法采用兩種調整策略,分別為 Logits-Boost 策略的 DATG-L 和前綴提示策略的 DATG-P。

『評估指標』(1)毒性,使用 Jigsaw 的 Perspective API 來評估生成文本的毒性;(2)成功率,使用經過 SST-5 數據集微調的 RoBERTa 模型來評估情感轉換任務的成功轉換比例;(3)困惑度,衡量文本流暢性,采用 GPT-2 large 模型進行評估;(4)相關性,通過計算提示和生成文本之間的嵌入向量的余弦相似度。

『結果分析』DATG 實現了控制效果的顯著提高,在最佳任務中相對于基線方法實現了 19.29% 的提高。此外,生成文本困惑度顯著下降,提高了文本流暢性。也驗證了作者對于屬性詞對于文本屬性影響的猜想。

評價

這項工作將 LLMs 生成的控制聚焦在解碼階段,提出了一種可插拔的靈活處理框架。通過調整部分屬性關鍵詞的概率,實現了對于控制條件的控制。同時還出色地維持了 LLMs 生成文本的流暢性。利用動態屬性圖精確操控與屬性相關的詞匯,實現了控制內容生成與語言自然性之間的平衡。

DATG 的應用不僅展示了圖模型在構建靈活且有效的可控文本生成(CTG)系統方面的潛力,而且為圖模型在處理更廣泛的屬性、適應更大的模型規模及解決更復雜的語言任務提供了全新的視角和方法。

本文轉載自PaperWeekly