哪個中文開源大模型在信息抽取上效果最好?附:用于提取的提示詞

1. 背景

信息抽取(Information Extraction,IE)一般包括命名實體識別(Named Entity Recognition,NER)、關系抽取(Relation Extraction,RE)和事件抽取(Event Extraction,EE)。

NER作為基礎任務,專注于識別并分類文本中的命名實體,如人物、組織、地點和日期。

RE則致力于發現實體間的語義聯系,比如某人在某地工作或兩人之間的婚姻關系。

EE則關注于識別文本中的特定事件及其相關要素,這些事件是特定時間、地點下發生的,涉及特定參與者和實體的行動或現象。

今天這篇論文的作者選取了4個中文開源模型進行實驗和對比,這4個開源模型分別是:ChatGLM3-6B、Qwen-7B-Chat與Qwen-14B-Chat 、Baichuan2-13B-Chat。并且選取了ChatGPT作為測試基準進行對比。之所以選取這幾個模型,是因為這幾個模型在SuperCLUE排行榜上排名比較靠前,并且這幾個模型都可以在一張A40的GPU上完成部署。

2. 信息抽取方法

2.1 命名實體識別方法

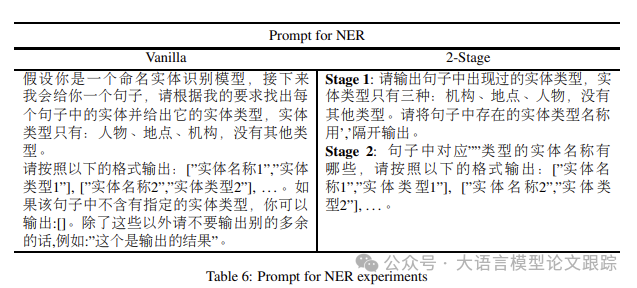

命名實體識別(NER)方面,作者采用了兩種策略:基礎法和分步法。

? 基礎法簡潔明了,僅需提供句子和實體類型列表,模型便能按照指定格式輸出實體及其類型。

? 分步法則將任務拆分為兩步:第一步,模型需識別并輸出文本中的實體類型;第二步,模型將逐一針對每種實體類型輸出相應的實體。

下圖是作者用于命名實體識別的提示詞:

圖片

圖片

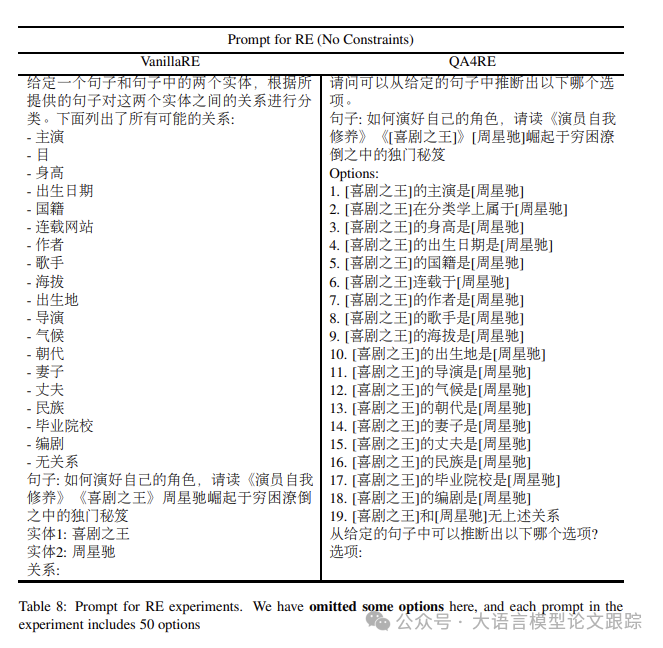

2.2 關系抽取方法

關系抽取(RE)實驗中,采用了兩種零樣本框架:VanillaRE和QA4RE。在這兩種框架下,模型輸入包括句子、兩個實體以及所有可能的關系類型,分別設置了有類型約束和無類型約束兩種情況。

? VanillaRE框架直接列出所有候選關系供模型選擇

? QA4RE框架則將關系轉化為多項選擇題,更適合LLMs進行生成性問答

下圖是作者用于關系抽取的提示詞:

圖片

圖片

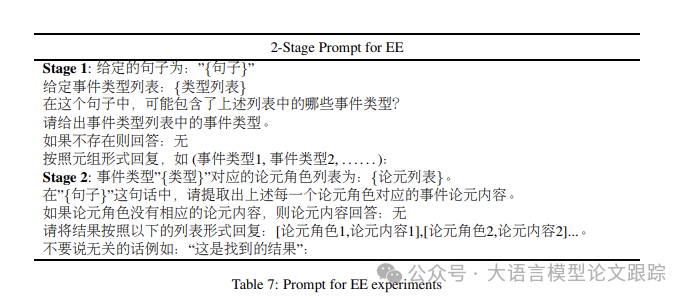

2.3 事件抽取方法

事件抽取(EE)任務因難度較高且基礎框架表現不佳,作者只展示了分步法的實驗結果,并對比了不同大型語言模型的性能。在分步法的第一階段,模型負責從文本中識別所有預定義的事件類型;第二階段則進一步提取每種事件類型的論元角色及其內容。

下圖是作者用于事件抽取的提示詞:

圖片

圖片

3. 到底哪個模型強!

3.1 命名實體識別任務哪個模型強?

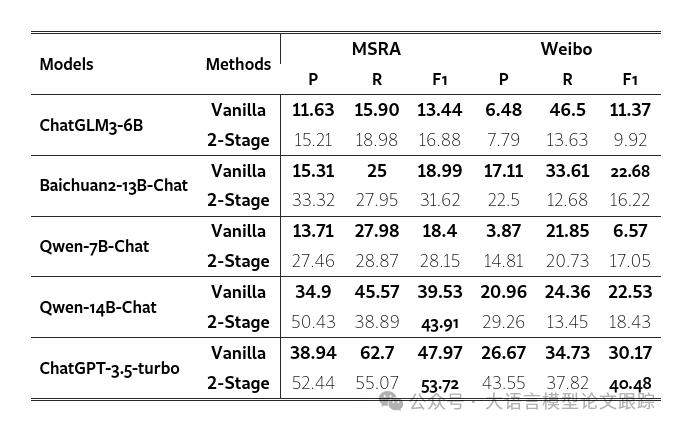

在命名實體識別(NER)任務上,作者對比了零樣本和少樣本兩種策略。零樣本測試中,動用了五款大型語言模型(LLMs),并針對兩個數據集進行了性能評估。少樣本測試中,挑選了零樣本評估中表現最優的開源模型 Qwen-14B-Chat,進一步在兩個數據集上進行了測試。

3.1.1 零樣本測試

NER 的零樣本測試成果展示在下表中。

圖片

圖片

? (1) 所有大型語言模型中,ChatGPT-3.5-Turbo 以卓越的表現領先,其在所有數據集和方法上均取得了最高的F1分數。在所有開源LLMs中,Qwen-14B-Chat 在 MSRA 數據集上獲得了最高的F1分數,而 Baichuan-13B-Chat 則在 Weibo 數據集上創下了最高紀錄。

? (2) 在所有開源LLMs中,參數規模為13B/14B的模型在相同方法和數據集的準確度上,始終超越了參數規模為6B/7B的模型。除了 Baichuan-13B-Chat 在 Weibo 數據集上采用2-Stage方法得到的F1分數低于 Qwen-7B-Chat 0.55之外,參數規模較大的模型在F1分數上普遍優于參數規模較小的模型。這可能是因為規模更大的LLMs擁有更豐富的實體識別相關知識,從而帶來更精準的分類效果。

? (3) 在涵蓋兩個數據集和五款LLMs的共10項測試中,2-Stage方法在7項測試的F1分數上超越了基礎法。2-Stage方法在每次測試中至少提升了1.31個百分點,最高提升了18.01個百分點的準確率。這表明2-Stage方法能更有效地引導模型識別所需類型的實體,從而顯著提高模型的預測準確度和F1分數。

? (4) 當模型保持不變時,MSRA 數據集上的F1分數普遍高于 Weibo 數據集。這種差異可能源于幾個因素:首先,兩個數據集的難度級別不同;其次,MSRA 數據集源自報紙媒體,使用的是書面語言,而 Weibo 數據集來自社交媒體,語言風格更偏向口語。模型的內在知識與書面語言更為契合,因此在提取書面文本信息方面更為得心應手。

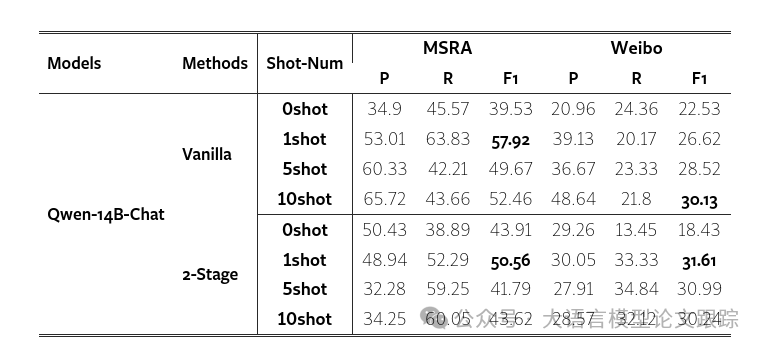

3.1.2 少樣本測試

NER 的少樣本測試結果如下表。作者對每種方法進行了三種不同樣本量的少樣本測試:1個、5個和10個樣本。

圖片

圖片

? (1) 少樣本測試在四分之三的情況下F1分數超越了零樣本測試,這表明提供示例有助于模型更好地理解任務。但在2-Stage方法中,除了從零樣本到一樣本F1分數有所提升外,增加樣本數量并未顯著提升,甚至降低了F1分數,這主要是由于精確度的大幅下滑。2-Stage方法將NER任務拆分為兩個子任務,隨著示例的增多,模型在第一階段傾向于生成更多類型以匹配示例中的多樣性,這可能導致在第二階段詢問一個不存在的類型時模型錯誤地輸出潛在答案,從而顯著降低了精確度和F1分數。

? (2) 在基礎法中,除了在Weibo數據集上從1樣本增加到5樣本時精確度有所下降外,其他所有測試均顯示,隨著樣本數量的增加,同一數據集上的精確度也隨之提高。這是因為基礎法的提示缺少詳細的任務描述,導致模型在零樣本測試中對預測實體類型的理解不夠明確。一旦提供了示例,模型就能更準確地識別出需要提取的實體,從而顯著提升了從零樣本到一樣本的精確度。隨著樣本數量的進一步增加,模型對任務的理解更加深入,精確度也得到了進一步提升。

(3) 2-Stage方法的測試結果呈現出不同的變化趨勢。除了在Weibo數據集上從5樣本增加到10樣本時召回率輕微下降外,其他所有測試都顯示,隨著樣本數量的增加,同一數據集上的召回率有所提升。這可能與(1)中提到的原因有關,即生成更多內容時,實驗的召回率也在一定程度上得到了改善。

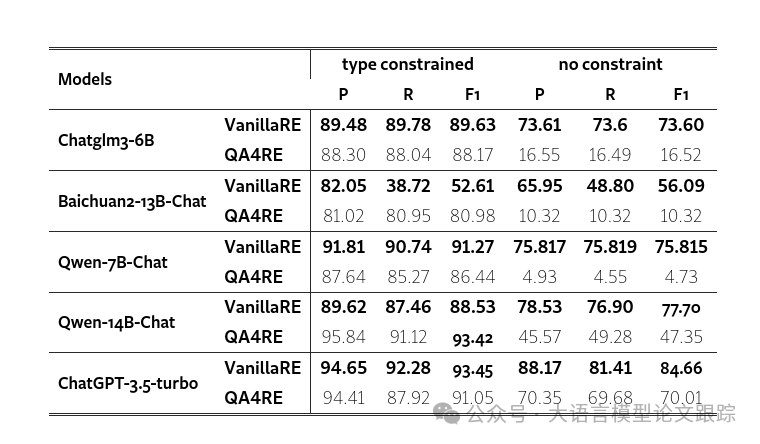

3.2 關系抽取任務哪個模型強?

中文零樣本關系抽取的結果如下表。

圖片

圖片

? (1) 大多數大型語言模型在類型約束下表現優異,但在缺乏約束時性能急劇下降。沒有類型約束,LLM必須在50種關系類型中做出選擇,而適當的約束可以大大減少對模型的干擾信息。特別地,在某些特定類型的實體對中,只保留了正確的關系類型和“無上述關系”(NoTA)。

? (2) 傳統基礎法框架下的表現普遍優于QA4RE框架。這可能是因為DuIE2.0數據集的關系抽取任務對于LLM而言并不復雜,而問答(QA)形式的引入反而增加了理解難度。此外,在無約束實驗中,許多不合理的選項(如“Alice是Bob的出版商”)被加入提示中,這些信息對LLM選擇關系類型造成了干擾。

? (3) 在兩種設置下,LLM的表現大體一致。ChatGLM3-6B、Qwen-7B-Chat、Qwen-14B-Chat和ChatGPT-3.5-turbo在有類型約束和無約束的環境中均展現出領先優勢。在所有開源LLM中,Qwen-14B-Chat的表現最為出色,其在類型約束環境中的表現僅比ChatGPT-3.5-turbo低0.03個百分點。

? (4) 在無約束的QA4RE環境中,ChatGPT-3.5-turbo的表現遠遠超過其他LLM(70.01%對比47.35%),顯示出其在面對較長且包含不合理句子的提示時,具有比所有開源LLM更強的抗干擾能力。然而,考慮到模型規模的差異(175B對比最大的14B),這樣的差距實際上也是在可接受范圍內。

討論DuIE 2.0數據集的局限性時,值得注意的是,在類型約束設置中,許多實體對只保留了正確的關系類型和“無上述關系”(NoTA)。例如,出版社和書籍之間的關系類型僅限于“出版”或NoTA。這在一定程度上解釋了為什么LLM在類型約束條件下能夠表現卓越。

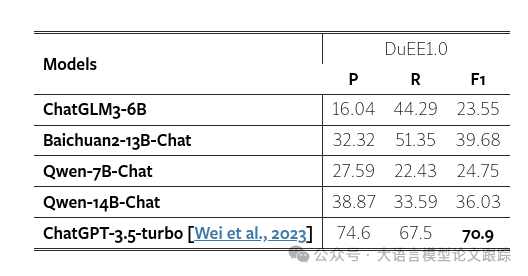

3.3 事件抽取任務哪個模型強?

圖片

圖片

上表展示了零樣本事件抽取任務的結果。鑒于事件抽取對模型理解力的更高挑戰,只能采用兩階段分解法,才能提煉出更為明晰的答案。ChatGPT以其卓越的理解力和對復雜提示格式要求的精準把握,再次以所有大型語言模型中最高的F1分數領跑。在開源模型領域,Baichuan2-13B-Chat表現出色,盡管其F1分數仍落后ChatGPT高達31.22分。

? 論文原文: https://arxiv.org/abs/2406.02079

本文轉載自??大語言模型論文跟蹤??,作者:HuggingAGI ????