人大 & 百度 SIGIR 新發(fā)現(xiàn):揭開 RAG 的 “黑箱”,LLM 知識利用的四階段與神經(jīng)元密碼

當我們?yōu)镽AG(檢索增強生成)系統(tǒng)能輸出更精準的答案而欣喜時,一個核心問題始終懸而未決:當外部檢索到的知識涌入LLM(大語言模型)時,模型是如何在自身參數(shù)化知識與外部非參數(shù)化知識之間做選擇的?是優(yōu)先采信新信息,還是固守舊認知?

中國人民大學與百度團隊聯(lián)合發(fā)表于2025年SIGIR的研究《Unveiling Knowledge Utilization Mechanisms in LLM-based Retrieval-Augmented Generation》,首次從宏觀知識流與微觀模塊功能兩個維度,系統(tǒng)性拆解了RAG中LLM的知識利用機制。這項研究不僅讓我們看清了知識在模型內(nèi)部的“流動軌跡”,更提出了可量化、可調(diào)控的技術(shù)方法,為打造更可控、低幻覺的RAG系統(tǒng)提供了底層支撐。

論文地址:https://arxiv.org/pdf/2505.11995

01、研究動機:RAG的“好用”與“未知”的矛盾

RAG技術(shù)的崛起,本質(zhì)上是為了解決LLM的“知識困境”——模型訓練完成后,參數(shù)中固化的“內(nèi)部知識”難以覆蓋實時動態(tài)信息或?qū)I(yè)領域細節(jié),容易產(chǎn)生事實性錯誤(幻覺)。通過引入檢索模塊補充“外部知識”,RAG成功擴展了模型的知識邊界,在開放域問答、智能客服等場景中大放異彩。

但光鮮的性能背后,RAG系統(tǒng)實則是個“半黑箱”:

- 外部知識進入模型后,經(jīng)歷了怎樣的處理流程?

- 檢索段落的相關性究竟如何影響模型的決策傾向?

- 模型內(nèi)部的MHA(多頭注意力)和MLP(多層感知器)模塊,在知識整合中分別扮演什么角色?

現(xiàn)有研究雖能通過調(diào)整檢索策略、優(yōu)化上下文格式提升RAG性能,卻始終未能觸及“知識如何被利用”的核心機制。正是這一研究缺口,推動團隊開展了這場對RAG內(nèi)部運作邏輯的“解剖式探索”。

02、核心定義:先分清兩種“知識源”

在深入解析前,我們需明確RAG中兩類關鍵知識的本質(zhì)差異,這是后續(xù)分析的基礎:

- 內(nèi)部知識(IK):LLM在預訓練階段沉淀于參數(shù)中的知識,無需外部輸入即可調(diào)用。生成過程可表示為:

,其中 I 為指令, q 為查詢,

,其中 I 為指令, q 為查詢, 為僅依賴內(nèi)部知識的答案。

為僅依賴內(nèi)部知識的答案。 - 外部知識(EK):推理階段通過檢索器從外部語料庫獲取的上下文信息,生成過程需引入檢索段落

,其中為融合外部知識的答案。

,其中為融合外部知識的答案。

研究正是圍繞這兩類知識的“交互與博弈”展開,聚焦開放域問答(ODQA)任務,選用LLaMA、Qwen兩大開源模型家族,在Natural Questions、TriviaQA、HotpotQA三大基準數(shù)據(jù)集上開展實驗,并特意構(gòu)造“假段落”(替換真實答案的錯誤文本)驗證模型的知識選擇偏好。

03、宏觀視角:知識在RAG中的4個流動階段

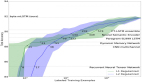

團隊創(chuàng)新性地采用“信息流分析”方法,通過追蹤注意力分數(shù)與梯度變化,首次將RAG中的知識利用過程劃分為四個清晰的階段,完整呈現(xiàn)了外部知識從“輸入”到“輸出”的全生命周期。

信息流分析的兩大工具

為精準捕捉知識流動,研究設計了兩種互補的分析方法:

- 基于注意力的信息流:通過量化關鍵token(K,潛在答案)與上下文token(C,檢索段落)、查詢token(Q,用戶問題)、答案token(A,生成結(jié)果)之間的注意力交互,定義了三個核心指標:

(關鍵到上下文)、

(關鍵到上下文)、 (關鍵到查詢)、

(關鍵到查詢)、 (關鍵到答案),公式如下:

(關鍵到答案),公式如下:

- 基于顯著性的信息流:結(jié)合監(jiān)督微調(diào)損失的梯度信息,衡量每個token對最終預測的邊際貢獻,彌補了注意力分析僅關注表層交互的局限,得到更全面的

指標。

指標。

知識流動的四階段模型

兩種分析方法的結(jié)果高度一致,共同揭示了知識在LLM不同層級間的動態(tài)變化規(guī)律,最終形成“四階段模型”:

1. 知識精煉階段(早期層級)

此階段 (關鍵到上下文)指標達到峰值,表明模型正集中精力對檢索到的外部知識進行“篩選與提煉”。就像我們拿到一份參考資料時,首先會快速抓取核心信息,這一階段完成了外部知識的初步“消化”,上下文信息逐漸趨于穩(wěn)定。

(關鍵到上下文)指標達到峰值,表明模型正集中精力對檢索到的外部知識進行“篩選與提煉”。就像我們拿到一份參考資料時,首先會快速抓取核心信息,這一階段完成了外部知識的初步“消化”,上下文信息逐漸趨于穩(wěn)定。

2. 知識激發(fā)階段(中間層級)

(關鍵到查詢)指標在此階段達到頂峰,意味著精煉后的外部知識開始與用戶問題深度融合,幫助模型重新理解查詢意圖。例如,當被問“2025年世界杯冠軍是誰”時,檢索到的“阿根廷隊奪冠”信息會在此階段修正模型對“2025年賽事結(jié)果”的認知,是外部知識向模型內(nèi)部傳遞的關鍵環(huán)節(jié)。

(關鍵到查詢)指標在此階段達到頂峰,意味著精煉后的外部知識開始與用戶問題深度融合,幫助模型重新理解查詢意圖。例如,當被問“2025年世界杯冠軍是誰”時,檢索到的“阿根廷隊奪冠”信息會在此階段修正模型對“2025年賽事結(jié)果”的認知,是外部知識向模型內(nèi)部傳遞的關鍵環(huán)節(jié)。

3. 知識表達階段(中后層級)

(關鍵到答案)指標顯著上升,說明模型開始將整合后的知識轉(zhuǎn)化為具體的答案內(nèi)容。此時外部知識對生成結(jié)果的影響力最強,若檢索段落準確,答案的事實性將得到有效保障。

(關鍵到答案)指標顯著上升,說明模型開始將整合后的知識轉(zhuǎn)化為具體的答案內(nèi)容。此時外部知識對生成結(jié)果的影響力最強,若檢索段落準確,答案的事實性將得到有效保障。

4. 知識競爭階段(深層級)

在模型最深處, 指標逐漸下降,而顯著性分析顯示外部知識的“隱性影響”仍在持續(xù)。這種差異表明,內(nèi)部知識與外部知識在此階段展開最終博弈,模型需權(quán)衡兩種知識的可靠性,最終確定輸出內(nèi)容。

指標逐漸下降,而顯著性分析顯示外部知識的“隱性影響”仍在持續(xù)。這種差異表明,內(nèi)部知識與外部知識在此階段展開最終博弈,模型需權(quán)衡兩種知識的可靠性,最終確定輸出內(nèi)容。

值得注意的是,即使外部知識與內(nèi)部知識存在沖突(如假段落場景),這四個階段的流動模式依然穩(wěn)定,說明知識處理的“框架”是LLM的固有特性。

相關性的“指揮棒”作用

檢索段落的相關性如何影響知識流動?研究通過對比“正例段落(含正確答案)、困難負例(相關無答案)、易負例(弱相關)、隨機段落(無關)”四類數(shù)據(jù)發(fā)現(xiàn):

- 無論相關性高低,知識流動的四階段模式始終存在,但信息流強度隨相關性降低而顯著減弱——無關段落難以引發(fā)模型對外部知識的深度利用。

- 相關性的影響集中體現(xiàn)在知識激發(fā)階段:正例段落在此階段的

指標遠高于其他類型,表明模型會在這一環(huán)節(jié)主動判別外部知識的價值,優(yōu)先整合高相關性信息。

指標遠高于其他類型,表明模型會在這一環(huán)節(jié)主動判別外部知識的價值,優(yōu)先整合高相關性信息。

進一步實驗證實,若在知識激發(fā)階段切斷關鍵token與查詢token的交互,高相關性段落對答案的影響會急劇下降,這直接證明了該階段是模型進行“相關性判斷與知識篩選”的核心關口。

04、微觀視角:神經(jīng)元與模塊的“分工密碼”

如果說知識流是“宏觀軌跡”,那么模型內(nèi)部的神經(jīng)元與功能模塊就是實現(xiàn)這一軌跡的“微觀單元”。研究通過拆解LLM的核心組件,揭開了知識利用的底層分工邏輯。

知識特異性神經(jīng)元:可調(diào)控的“知識開關”

模型中是否存在專門負責處理內(nèi)部或外部知識的神經(jīng)元?團隊提出KAPE(知識激活概率熵) 指標,成功識別出這類“知識特異性神經(jīng)元”。

KAPE的工作原理

- 神經(jīng)元激活量化:基于LLM中MLP層的GLU(門控線性單元)機制,計算每個神經(jīng)元在處理內(nèi)部知識與外部知識時的激活概率

和

和 。

。 - 熵值計算:通過熵值衡量神經(jīng)元的知識偏好,公式為:

低KAPE值意味著神經(jīng)元對某類知識有顯著偏好(如僅對外部知識激活),即“知識特異性神經(jīng)元”。

神經(jīng)元調(diào)控的神奇效果

通過選擇性停用這些特異性神經(jīng)元,模型的知識依賴偏好可被精準調(diào)控:

- 當使用含正確答案的黃金文檔時,停用外部知識神經(jīng)元會導致答案準確性大幅下降,說明此時模型高度依賴外部信息;

- 當使用含錯誤答案的噪聲文檔時,停用外部知識神經(jīng)元能有效過濾誤導信息,提升輸出質(zhì)量;

- 這種調(diào)控效果在LLaMA、Qwen等不同模型家族,以及單跳、多跳等不同任務中均保持一致,證明了方法的通用性。

一個典型案例顯示:當檢索段落包含錯誤答案時,模型最初會被誤導;但停用外部知識特異性神經(jīng)元后,模型立即轉(zhuǎn)向依賴內(nèi)部知識,輸出了正確結(jié)果。反之,當外部知識正確但模型未充分利用時,停用內(nèi)部知識神經(jīng)元可強制模型采信外部信息。

MHA與MLP的“互補分工”

Transformer架構(gòu)中的兩大核心模塊在知識利用中扮演著截然不同的角色,研究通過殘差流分析與早期解碼技術(shù)揭開了它們的分工:

- MHA(多頭注意力)模塊:專注于“知識整合”。它負責將外部知識、查詢意圖、內(nèi)部記憶中的相關信息進行跨源融合,為答案生成構(gòu)建統(tǒng)一的上下文基礎,類似“信息調(diào)度中心”;

- MLP(多層感知器)模塊:專注于“知識驗證”。它對知識的準確性極為敏感——當檢索到黃金文檔時,MLP模塊對答案生成的貢獻顯著增強;當遇到虛假文檔時,其貢獻則明顯下降,相當于“事實審核員”。

這一發(fā)現(xiàn)解釋了為何部分RAG系統(tǒng)會整合錯誤信息:若MLP模塊功能弱化,模型就難以甄別外部知識的真?zhèn)危荒鼙粍右蕾嘙HA整合的信息。

05、總結(jié):RAG技術(shù)的“可控化”新起點

人大與百度的這項研究,不僅是對RAG機制的“解剖報告”,更是推動RAG從“經(jīng)驗驅(qū)動”走向“原理驅(qū)動”的關鍵一步。其核心貢獻可概括為三點:

- 宏觀建模:首次明確RAG中知識利用的四階段流程(精煉→激發(fā)→表達→競爭),并鎖定知識激發(fā)階段為相關性影響的核心環(huán)節(jié);

- 微觀突破:提出KAPE指標實現(xiàn)知識特異性神經(jīng)元的精準識別,為調(diào)控模型知識依賴提供了“開關級”工具;

- 模塊解碼:厘清MHA與MLP的互補作用,為針對性優(yōu)化模型結(jié)構(gòu)、提升事實準確性指明了方向。

對于產(chǎn)業(yè)界而言,這些發(fā)現(xiàn)的價值尤為深遠:未來的RAG系統(tǒng)可通過以下方式實現(xiàn)升級:

- 優(yōu)化知識激發(fā)階段的上下文設計,強化高相關性信息的引導作用;

- 基于KAPE指標篩選神經(jīng)元,在金融、醫(yī)療等關鍵領域定向增強模型對權(quán)威外部知識的依賴;

- 針對性強化MLP模塊功能,提升模型對噪聲知識的“免疫力”。

從“知其然”到“知其所以然”,這項研究讓我們離可控、可靠的AI系統(tǒng)又近了一步。當RAG的“黑箱”被逐層揭開,那些曾困擾我們的幻覺、不可控等問題,終將在原理性突破中找到答案。