TATTOO:讓PRM真正"看見"表格的工具集成驗證框架

大家好,我是肆〇柒。今天我們一起探索一項來自UIUC、Amazon、Purdue大學和斯坦福大學的聯合研究——TATTOO。這項研究揭示了一個令人驚訝的現象:盡管現有Process Reward Models (PRMs)在文本推理中表現出色,但在面對表格數據時卻近乎"失明"。研究團隊通過詳實的實證分析發現,當將模型提取的子表替換為隨機子表后,PRM給出的獎勵分布幾乎不變,這意味著PRM無法有效利用表格信息進行監督。針對這一問題,他們提出了創新的TATTOO框架,讓PRM不僅能"看見"表格,還能"用工具驗證"表格操作,改變了表格推理的監督范式。

表格數據在金融、科學分析和政務決策等場景中無處不在,如何讓大型推理模型(LRM)準確理解并推理表格內容已成為人工智能領域的新戰場。想象一下,當你需要從一張包含數千行財務數據的表格中快速識別異常交易模式,或是在醫療研究中從復雜的臨床試驗表格中提取關鍵結論,這些任務對人類專家都頗具挑戰,更不用說對AI模型了。與自由文本不同,表格通過行列結構隱式編碼信息,有效推理需要精確解讀表格內容并進行逐步邏輯推導。Process Reward Models (PRMs) 作為測試時擴展(Test-Time Scaling, TTS)的關鍵組件,本應提供步驟級監督以增強 LRM 的推理能力,但實證研究表明,現有 PRMs 在表格推理任務中卻表現乏力。當研究者將 LRM 提取的子表替換為隨機選擇的子表區域后,PRM 給出的獎勵分布與原表幾乎一致,這揭示了現有 PRM 在表格監督中的根本缺陷——它們無法有效利用表格信息進行可靠監督。

表格推理為何成為 LLM(Large Language Model)的新戰場?

表格推理能力已成為新興大型推理模型(LRM)在現實世界應用中的基礎能力,涵蓋數值分析、事實核查和問答等多個場景。與自由文本不同,表格通過行列結構隱式編碼信息,有效推理需要準確解讀表格內容并進行逐步邏輯推導。在表格環境中,模型首先需要正確檢索與查詢相關的子表區域(Table Retrieval),然后基于檢索到的內容進行邏輯推理(Schema Interaction),最后完成計算或得出結論。這一過程對模型的結構化理解能力提出了極高要求。

實證分析表明,在 500 個錯誤案例中,47.7% 源于 Table Retrieval 錯誤,34.3% 源于 Schema Interaction 錯誤,這凸顯了表格推理的核心瓶頸。

表格推理錯誤分布

Table Retrieval 指模型定位與查詢相關的行/列區域的能力,而 Schema Interaction 則涉及基于檢索內容進行的邏輯推理。這兩類步驟構成了表格推理的核心,但現有 PRM 對它們的監督能力極為有限。

更細致的錯誤分類顯示,表格推理錯誤主要集中在單位不匹配(15.0%)、行選擇錯誤(14.8%)、計算錯誤(11.2%)、列選擇錯誤(10.4%)和部分聚合(9.6%)等類別。

表格推理錯誤類型分布

這一分布揭示了一個關鍵問題:表格推理的挑戰不僅在于純邏輯推理,更在于模型對表格結構的理解與操作。

例如,在一個典型場景中,當模型需要計算"平均突出度"時,它本應檢索"Prominence(m)"列,卻錯誤地檢索了"Country"和"Elevation(m)"列。

表格推理錯誤案例

在這個案例中,模型在第一步就錯誤地檢索了無關列,但 PRM 仍給出"correct"的判定,這直接導致了錯誤的最終答案。這種監督失效使得 PRM 無法有效引導 LRM 修正表格檢索錯誤,從而限制了整體推理質量。

盡管 PRM 能訪問原始表格,但實驗數據清晰顯示它們無法有效利用表格信息。在一項關鍵實驗中,研究者將 LRM 提取的子表替換為隨機選擇的子表區域后,Qwen2.5-Math-PRM-72B 給出的獎勵分布與原表幾乎一致。

PRM對真實與隨機子表的獎勵分布

這一現象證明 PRM 對表格檢索的正確性不敏感,無法區分相關與無關表格內容,導致其監督信號質量低下。

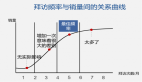

更令人擔憂的是,性能飽和現象進一步印證了現有 PRM 的局限性。

性能飽和現象

上圖顯示,當響應數量 N≥8 時,即使使用 Qwen2.5-Math-PRM-72B,Fact Checking 任務準確率也停滯在 79.84%,無法充分利用額外測試時計算資源。這一現象在三種表格任務的性能曲線上均清晰可見,表明現有 PRM 無法有效指導 LRM 生成更高質量的推理軌跡。

現有 PRM 的局限性:實證分析揭示兩大致命短板及其根源

研究者通過實證分析揭示了現有 PRM 在表格推理中的兩大致命短板。在 Table Retrieval 方面,PRM 無法判斷模型是否提取了正確的子表區域。實驗表明,在 500 個案例中,將 LRM 檢索的子表替換為隨機選擇的子表后,Qwen2.5-Math-PRM-72B 給出的獎勵分布幾乎不變,這證明 PRM 對表格檢索的正確性不敏感。

典型案例顯示,當模型錯誤地檢索"Country"和"Elevation(m)"列進行山峰平均突出度計算時,PRM 仍將其判定為正確步驟,導致后續所有推理步驟均出錯。

表格推理錯誤案例

上表中,模型在第一步就錯誤地檢索了無關列,但 PRM 仍給出"correct"的判定,這直接導致了錯誤的最終答案。這種監督失效使得 PRM 無法有效引導 LRM 修正表格檢索錯誤,從而限制了整體推理質量。

在 Schema Interaction 方面,由于注意力局部性偏置,模型在后續步驟中傾向于忽略早期檢索的表格內容。錯誤分析表明,500 個錯誤案例中,47.7% 源于 Table Retrieval 錯誤,34.3% 源于 Schema Interaction 錯誤。更細致的錯誤分類顯示,表格推理錯誤主要集中在單位不匹配(15.0%)、行選擇錯誤(14.8%)、計算錯誤(11.2%)、列選擇錯誤(10.4%)和部分聚合(9.6%)等類別。

表格推理錯誤類型分布

注意力分布分析進一步證實,Schema Interaction 步驟(第 8 步)對 Table Retrieval 步驟(第 0 步)的注意力質量隨距離急劇衰減,導致模型頻繁誤解或丟棄先前檢索的內容。

注意力質量隨距離衰減

上面中圖清晰展示了這一現象,注意力質量從第 0 步到第 8 步急劇下降,使得模型難以維持對早期檢索內容的關注。

而現有 PRM 由于評估高度局限于當前步驟,無法捕捉遠距離步驟間的依賴關系。Figure 3右圖展示了這一關鍵發現:當在每個Schema Interaction步驟前添加正確的子表前綴時,數值推理任務的準確率顯著提升。這一實驗結果揭示了一個重要洞見——如果PRM能直接訪問相關表格內容,而非依賴遠距離注意力,就能有效監督Schema Interaction步驟。

然而,這一方法面臨現實挑戰:當前PRM無法自動識別Schema Interaction步驟,且LRM檢索的子表前綴本身可能不準確。這一發現直接催生了TATTOO的核心創新:讓PRM不僅"看得見表格",還能"主動驗證表格檢索正確性"。在表格推理流程中,當模型進行Schema Interaction時,TATTOO會主動插入工具調用代碼,驗證檢索內容的正確性,從而解決注意力衰減導致的監督失效問題。

TATTOO 的設計哲學:讓 PRM "看得見表格、用得了工具"

針對現有 PRM 的局限性,研究者提出 TATTOO(Table Thinking PRM with Tool integration abilities),其核心思想是將獎勵監督分解為兩類:inner-thinking reward(針對純文本推理步驟)與 table-aware reward(針對表格操作步驟),以提供針對性監督。

TATTOO 的關鍵創新在于顯式工具集成驗證(Tool Integration)。與現有 PRM 不同,TATTOO 在生成驗證理由時,主動插入工具調用代碼并模擬執行結果作為判斷依據。計算工具(如 Python/SQL)用于精確驗證聚合與算術操作,避免文本推理中的計算錯誤;查表工具(如 Polars DataFrame API)用于驗證行列檢索正確性,解決 Table Retrieval 問題。

在驗證容量求和步驟時,TATTOO 會自動生成包含 total_capacity = sum(row[capacity_index] for row in table["data"]) 的代碼沙盒,并基于執行結果進行判斷。與現有 PRM 的本質區別在于,TATTOO 的驗證過程本身成為一種可執行的、可靠的推理,而非僅依賴對文本的判斷。

TATTOO框架概述

上圖詳細展示了 TATTOO 的框架設計。在數據構建階段,研究者設計了可擴展的數據整理管道,通過整合專家驗證理由與工具執行結果,構建了超過 60k 高質量步驟級標注數據集。具體而言,該管道包含三個主要階段:

1. 推理軌跡生成:從專家 LRM(如 DeepSeek-R1 和 Claude-Opus-4.1)收集表格問題的響應,涵蓋 TableInstruct、HybridQA、ToTTo 和 WikiTQ 等多個基準。通過生成多個響應并進行雙重驗證(人工標注員和專家 LLM),確保數據質量。

2. 驗證合成與獎勵分配:為每個候選響應提供步驟級驗證理由和獎勵標簽,對表格檢索步驟、Schema Interaction 步驟和 Inner-thinking 步驟分別處理。對于表格檢索步驟,使用 LLM-as-a-judge 評估檢索內容與查詢的相關性;對于 Schema Interaction 步驟,將準確子表作為前綴添加到驗證理由中;對于 Inner-thinking 步驟,則直接評估推理質量。

3. 工具使用合成:在驗證理由中添加工具調用、執行結果和反饋,主要使用兩類工具:計算工具(Python/SQL 代碼片段)和表格查找工具(DataFrame API)。例如,當驗證求和操作時,將手動計算替換為代碼執行結果;當需要查找特定單元格時,替換為明確的查找工具調用。

這一數據構建方法確保了 TATTOO 能夠學習到精確的表格驗證能力,而非僅依賴于文本推理。通過將工具調用整合到驗證過程中,TATTOO 能夠提供更可靠、更精確的監督信號,有效解決現有 PRM 在表格推理中的"失明"問題。

值得注意的是,TATTOO 的驗證過程本身成為一種可執行的推理軌跡,這與傳統 PRM 僅提供判斷結果有本質區別。當 TATTOO 驗證一個計算步驟時,它會生成可執行的代碼片段,通過實際執行來驗證結果,而不是依賴文本推理中的計算。這種設計使得 TATTOO 的驗證過程本身具有高度可靠性,避免了傳統 PRM 在復雜計算中容易出錯的問題。

雙階段訓練范式:從模仿到強化的躍遷

TATTOO 采用雙階段訓練范式實現從基礎工具使用能力到可靠驗證能力的躍遷。第一階段為監督微調(SFT),使模型學習識別準確子表區域、動態整合檢索表格前綴到每個 Schema Interaction 步驟,并生成帶有工具集成模式的驗證理由。SFT 階段建立了基礎工具使用能力,但驗證仍可能出錯。

TATTOO訓練動態

上圖展示了 TATTOO 和變體的訓練動態,SFT+RL 訓練過程中的獎勵信號持續提升,而僅使用 SFT 或規則基線的模型則無法達到相同水平。這直觀證明了雙階段訓練的有效性。

理論分析通過 Theorem 4.1 揭示了 TATTOO 如何改進下游策略。該定理表明,TATTOO 的分解獎勵設計能通過提升獎勵信號的可區分性(variance)與對策略優勢的對齊度(alignment),共同驅動下游 LRM 的策略改進:

特別值得注意的是,TATTOO 的獎勵設計通過工具集成實現了對表格操作的精準監督。在 TB-DA(數據分析)任務中,47.7%的錯誤源于 Table Retrieval,而 TATTOO 通過 tool-grounding 項使 PRM 能夠準確識別這些錯誤,從而引導 LRM 改進其表格檢索能力。這種針對性監督是傳統 PRM 無法實現的,因為它們缺乏對表格內容的精確驗證能力。

實驗結果與泛化能力:精準打擊,全面領先

突破性能瓶頸:持續擴展的TTS能力

鑒于 82% 的錯誤集中于 Table Retrieval (47.7%) 與 Schema Interaction (34.3%),TATTOO 針對性地強化這兩類步驟的監督,取得了顯著效果。在 TableBench 數據分析(TB-DA)任務上,TATTOO 將準確率從 27.7% (N=4) 提升至 34.3% (N=32),絕對提升 6.6 個百分點。

在 TableBench 數值推理(TB-NR)任務上,TATTOO (78.1%) 顯著超越 Qwen2.5-Math-PRM-72B (75.3%),且性能隨 N 增加持續提升,而基線在 N=16 后即達到飽和。

TB-NR任務上隨N增加的性能曲線

上圖清晰展示了這一趨勢,TATTOO 在 N=32 時達到 78.3%,而 Qwen2.5-Math-PRM-72B 在 N=16 后幾乎停滯。

TATTOO在TB-DA(TableBench數據分析)任務上的突破性提升(+6.6%)直接對應其解決的核心問題。數據分析任務高度依賴準確的Table Retrieval(占比47.7%)和Schema Interaction(占比34.3%),而這兩類錯誤正是TATTOO的專攻領域。相比之下,TB-FC(事實核查)任務中Inner-thinking步驟占比更高,因此提升幅度相對較小(+2.2%)。這一任務差異性驗證了TATTOO設計的針對性——它不是通用PRM的簡單替代,而是專為表格推理瓶頸量身定制的解決方案。

在五個表格推理基準(TableBench、WTQ、MMQA 等)上,TATTOO 平均提升 30.9%,展現了卓越的泛化能力。尤為引人注目的是其參數效率:TATTOO-8B 在 TableBench 事實核查(TB-FC)任務上達到 82.0% (N=32),超越參數量 9 倍于它的 Qwen2.5-Math-PRM-72B (79.8%),實現了以小博大的技術突破。

TATTOO的參數效率奇跡源于其精準的監督靶向性。傳統PRM需龐大參數量來泛化各種推理模式,而TATTOO通過將監督分解為inner-thinking reward與table-aware reward,使8B參數模型能專注于表格推理的關鍵瓶頸。參數敏感性分析進一步證實,當=0.8和=1.0時,模型達到最佳性能平衡點。這種精準調控使TATTOO能以小搏大,在TB-FC任務上以8B參數實現82.0%的準確率,超越參數量9倍的競品。

雙階段訓練的必要性:SFT vs SFT+RL

消融實驗表明,雙階段訓練對 TATTOO 的性能至關重要。Table 3 顯示,僅 SFT 訓練的 TATTOO 平均準確率為 72.3%,而加入 RL 后提升至 78.5%,帶來 10.2% 的平均準確率提升。

SFT與RL階段驗證對比

獎勵塑形組件分析進一步揭示了各部分的貢獻:移除 tool-grounding 項導致 TB-DA 任務在 N=32 時下降 4.0%,證明工具調用對表格驗證至關重要;排除 confidence calibration 使 TB-FC 任務平均下降 1.6%,顯示其在穩定獎勵信號中的互補作用。

案例研究直觀展示了 RL 訓練前后的差異:SFT 階段的 TATTOO 僅靠文本推理驗證步驟 3 的計算,得出錯誤結果 16,920 并錯誤判定步驟不正確;而 RL 階段的 TATTOO 學會調用 Python 代碼進行驗證,正確計算出 22,460 并準確判定步驟正確。隨機抽樣 500 條軌跡的分析表明,RL 訓練后工具集成比例提升了 26.3%。

獎勵塑形參數的敏感性分析揭示了TATTOO性能的精細調控空間。當λcal從0.3提升至0.8時,TB-DA任務準確率從33.1%提升至34.3%,表明適當的置信度校準能穩定訓練過程;當λtool從0.1提升至1.0時,TB-DA任務準確率從30.8%躍升至34.3%,證明工具集成對表格驗證的決定性作用。但過度強調任一組分都會導致性能下降——當λcal=1.0或λtool=1.3時,性能開始回落。這種精確的參數平衡使TATTOO能在不同任務間保持穩健表現,也凸顯了雙階段訓練中RL微調的必要性。

TATTOO 在 Best-of-N、Beam Search 和 Diverse Verifier Tree Search (DVTS) 三種測試時擴展策略下均表現穩健,無性能飽和現象,能有效利用更大的響應池。

TATTOO在多種TTS策略下的表現

在 Beam Search 中,TATTOO 將平均準確率從 45.0% 提升至 54.8%,而 GenPRM-32B 則飽和在 51% 左右。這些結果突顯了 TATTOO 在不同 TTS 策略下的一致優越性,證明其不僅能突破性能瓶頸,還能有效利用更大規模的測試時計算資源。

特別值得注意的是,在 TB-DA 任務中,TATTOO 的性能隨 N 增加而持續提升,而其他 PRM 在 N=16 后即達到飽和。這表明 TATTOO 能夠有效區分更多樣化的推理軌跡,為下游 LRM 提供更豐富的監督信號。這種能力源于 TATTOO 的工具集成驗證機制,使其能夠精確評估表格操作的正確性,而不僅僅是依賴文本推理的表面一致性。

對我們的啟示

TATTOO 的研究揭示了一個重要洞見:表格推理不能僅靠"文本思維",必須引入結構感知與可執行驗證——驗證過程本身應成為可靠的推理。PRM 的未來發展方向是從"判官"變為"工具化驗證智能體",其驗證過程具備可執行性與可靠性。

對工業實踐而言,構建高質量步驟級監督數據與工具鏈集成構成可擴展的推理監督范式;雙階段訓練(SFT+RL)是培養工具使用能力的關鍵路徑;獎勵塑形設計應明確鼓勵工具調用,而非僅關注最終正確性。

然而,TATTOO 也面臨現實挑戰。與僅 SFT 訓練相比,RL 階段引入了額外的計算開銷,包括額外的 rollout、獎勵評估和優化步驟,這增加了訓練成本和資源需求,可能影響低資源環境的可復現性。此外,當前框架僅限于文本-表格推理,尚未擴展到多模態表格(含圖表)。如果工具或訓練數據包含錯誤,這些錯誤可能被放大而非糾正,因此需要探索驗證器可靠性審計機制。

特別值得關注的是,TATTOO 的設計理念可能適用于其他結構化數據推理任務,如代碼理解、公式推導等。在這些任務中,同樣存在"文本思維"與"結構感知"的鴻溝,而工具集成驗證機制可能提供類似的性能提升。隨著結構化數據在AI應用中的重要性不斷提升,這種將驗證過程本身設計為可執行推理的方法,有望成為下一代推理監督框架的核心思想。