NeurIPS 2025|火山引擎多媒體實驗室聯合南開大學推出TempSamp-R1強化學習新框架,視頻時序理解大模型SOTA!

在人工智能與多媒體技術深度融合的當下,視頻時序定位(Video Temporal Grounding) 成為視頻理解領域的核心任務之一,其目標是根據自然語言查詢,在長段視頻流中精準定位出與之匹配的時序片段。這一能力是智能視頻剪輯、內容檢索、人機交互、事件分析等眾多場景落地的關鍵基礎。例如,快速定位球賽進球瞬間、影視劇名場面、游戲高光鏡頭、響應“回放主角微笑片段” 、異常事件查看等需求,均依賴于高效精準的時序定位技術。如今,火山引擎多媒體實驗室聯合南開大學研發的 TempSamp-R1 框架,通過對強化學習技術的突破性創新,為視頻大模型的“時空感知力”帶來質的飛躍—— 該成果已被人工智能領域頂會 NeurIPS 2025接收。

論文鏈接:https://arxiv.org/pdf/2509.18056

直擊行業痛點:傳統方法深陷 “效率與精度” 雙重困境

圖1 視頻時序定位任務示例

視頻時序定位任務中,模型需在數分鐘甚至數小時的視頻流中,精準鎖定與文本查詢匹配的幾秒到幾十秒片段。現有主流方案長期面臨兩大核心難題:基于監督微調(SFT)的方法過度依賴確定性標注,缺乏動態時序推理能力,面對復雜視頻場景易出現定位偏差;而基于強化學習的 GRPO 方法雖具備自適應學習能力,但受限于 on-policy 采樣機制,在廣泛的視頻時序搜索空間中探索效率低下,且存在獎勵信號稀疏、訓練收斂不穩定等問題,導致訓練時精度與速度難以兼顧。

三大核心創新:高效提升 MLLM 視頻時序定位精度

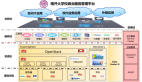

圖2 TempSamp-R1框架概述,該框架用于微調多模態策略模型。

TempSamp-R1 框架通過“混合策略采樣+優勢塑造+靈活推理范式”的三重創新,構建起高效穩定的視頻時序定位學習體系,其技術突破點可概括為以下三方面:

1、混合策略采樣:讓真值標注成為“精準導航儀”

TempSamp-R1 框架將 on-policy 動態探索與 off-policy 監督指導相結合,提出“(G-1)+1”混合采樣策略,即每個查詢對應 G 個訓練樣本,其中 G-1 個來自當前策略的 on-policy 生成樣本,1個為基于真值標注的 off-policy 樣本。這種設計既保留了強化學習的探索能力,又通過標注數據樣本為模型提供精準時序定位,有效解決了GRPO框架中 on-policy 采樣的稀疏性問題。

圖3 TempSamp-R1 將高質量的注釋與基于策略的采樣相結合示例

2、非線性優勢塑造:給獎勵信號 “裝上穩壓器”

混合采樣雖結合兩類樣本優勢,但 off-policy 標注數據樣本的高獎勵與 on-policy 探索樣本的常規獎勵存在分布偏移,直接融合易致訓練主導失衡、梯度波動。

針對此問題,TempSamp-R1 提出三個可選擇的優勢塑造策略:

- 通過獎勵縮放將 off-policy 獎勵限制在最大值的80%,避免其過度主導訓練;

- 采用優勢錨定機制獨立計算 off-policy 優勢,增強監督信號的引導作用;

- 創新引入非線性獎勵函數,對高獎勵區域進行壓縮、低獎勵區域進行擴展,有效緩解獎勵稀疏帶來的梯度不穩定問題。

如圖4所示,GRPO 基線獎勵中位數低、箱線分散(方差大,訓練波動劇烈),而 TempSamp-R1 獎勵箱線更緊湊、中位數更高,直觀印證優勢塑造的“穩壓”效果——既穩定捕捉高價值時序解,又降低獎勵波動,緩解梯度震蕩。

圖4 對比GRPO和TempSamp-R1算法在Charades-STA和ActivityNet Captions數據集上top-1 IoU得分的分布情況。

3、混合 CoT 訓練:兼容適配“復雜+高效”雙重需求

考慮到不同視頻任務的推理復雜度差異,框架設計了混合思維鏈(CoT)訓練范式:

- 第一階段聚焦基礎定位能力,僅要求模型輸出<Answer>標簽的時序結果,確保核心定位精度;

- 第二階段引入格式獎勵機制(輸出符合<Think>推理過程+<Answer>結果),引導模型學習顯式推理邏輯,強化結構化輸出能力。

在推理階段則支持可選擇 CoT 與非 CoT 模式:

- 面對事件定位等復雜任務時,CoT 模式通過顯式推理提升邊界精度;

- 處理高光檢測等簡單任務時,非 CoT 模式直接輸出結果以提升效率。

這種“雙模式”的設計,大幅提升了框架的場景適配性。

圖5 TempSamp-R1進行時間定位的示例。

刷新 SOTA 紀錄:三大數據集性能全面突破

基于 Qwen2.5-VL-7B-Instruct 基座模型,TempSamp-R1 在三大權威基準數據集上展現出壓倒性性能優勢,核心指標均超越現有最優方案:

- CharadesSTA(事件時序定位):R1@0.7 指標達到52.9%,較最優 GRPO 基線提升5.0個百分點,較 SFT 基線提升7.6個百分點;

- ActivityNet Captions(長視頻事件定位):R1@0.5 指標達到56.0%,較此前 SOTA 提升5.3個百分點,在長時序推理場景中優勢尤為顯著;

- QVHighlights(視頻高光檢測):mAP 指標達到 30.0%,較最優基線提升3.0個百分點,且非 CoT 模式下推理速度提升25%。

圖6 對比不同模型在 Charades-STA、ActivityNet Captions 和 QVHighlights 數據集上性能。

更值得關注的是,TempSamp-R1 展現出極強的泛化能力:

- 在跨數據集遷移測試中,從 CharadesSTA 訓練的模型直接應用于 ActivityNet Captions,mIoU 指標達34.7%,較 GRPO 提升4.0個百分點;

圖7 從 Charades-STA 到 ActivityNet 的跨域泛化性能。

- 在小樣本的訓練中,僅用50個訓練樣本時,mIoU 達44.7%,超 SFT 2.8%;500 樣本時 mIoU 達55.1%,超 SFT 8.9%、GRPO 5.3%,且訓練時間(218分鐘)短于 GRPO(338分鐘)。

智能剪輯迎來突破:效率實現跨越式提升,重構內容生產流程

TempSamp-R1 在強化學習領域的核心突破,不僅是技術層面的創新升級,更關鍵的是,依托該技術已構建起“基于時序理解的高光檢測→基于故事線理解的智能剪輯”這一行業領先的完整技術閉環解決方案,目前已在點播與直播場景深度應用,跨越式提升智能剪輯效率:

圖9 視頻高光智剪解決方案框架圖

- 點播場景:基于 TempSamp-R1 對視頻內容的深度理解技術,打造“精彩標題-智能封面-看點解說-爆款衍生”一站式高光混剪解決方案,可實現高光劇情集錦、精彩內容解說等內容的大規模自動化生產,大幅提升二創視頻生產力,有效促進用戶消費,為業務增長注入技術動力。

- 直播場景:依托 TempSamp-R1 打造的“直播高光智剪”解決方案,以強大的內容理解能力為內容生產注入全新動能。

- 在體育賽事直播中,該方案支持多語種解說智能剪輯,即時捕捉精彩瞬間,自動生成集錦和吸睛標題,顯著提升內容生產效率。

- 在電商直播場景中,該方案可精準識別商品講解高光與核心賣點,一鍵生成引流視頻,顯著提升直播間成交轉化,助力商家實現降本提效與業務增長。

- 「V-Orbit」音視頻 AI 應用廣場:是火山引擎視頻云智能媒體產品線聚焦音視頻處理工具+AI 應用的平臺。平臺全面覆蓋視頻直播、視頻點播、企業直播及 ImageX 產品線的所有 AI 能力,您可以一站式使用所需的音視頻圖片處理工具,體驗上文介紹的短劇高光智剪和直播高光智剪、視頻處理智能體 Aideo Agent、智能播放器 Aideo player、AI 視頻翻譯、無痕字幕擦除、電商萬創等熱門應用,詳情可訪問:

https://www.volcengine.com/experience/vcloudlite/ai

「V-Orbit」音視頻 AI 應用廣場頁面