微軟BitDistill將LLM壓縮到1.58比特:10倍內存節省、2.65倍CPU推理加速

大語言模型(LLM)不僅在推動通用自然語言處理方面發揮了關鍵作用,更重要的是,它們已成為支撐多種下游應用如推薦、分類和檢索的核心引擎。盡管 LLM 具有廣泛的適用性,但在下游任務中高效部署仍面臨重大挑戰。隨著模型規模的急劇擴大,這些挑戰被進一步放大,尤其是在資源受限的設備上(如智能手機),內存占用和計算開銷都變得極其昂貴。

為應對這些問題,近期研究提出了極低比特(extreme low-bit)LLM,例如使用 1.58 比特(即三值 {-1, 0, 1})表示的 BitNet。這種方法旨在顯著降低內存占用并加速推理,從而為 LLM 在下游應用中的高效部署提供一條可行途徑。

然而,要讓 1.58 比特的 BitNet 在下游任務中達到與高精度模型相媲美的準確率,通常需要從零開始在大規模語料上進行預訓練,這會帶來巨大的計算和能耗成本。

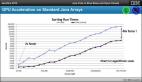

如圖 1 所示,直接對已有的全精度 LLM 進行 1.58 比特量化感知訓練(Quantization-Aware Training, QAT)時,在特定下游任務上的訓練過程往往不穩定,難以保持原有的性能,并表現出較差的可擴展性:當模型規模從 0.6B 增大到 4B 時,相對于全精度基線的性能差距從 13.9 擴大到 15.3。

這一現象凸顯出:迫切需要專門為 1.58 比特 BitNet 設計的更有效的量化感知訓練方法。

在本研究中,來自微軟的研究者聚焦于將已有的 LLM 微調至 1.58 比特以適配特定下游任務,同時保持與全精度模型相當的性能。為此,本文提出了 BitDistill(BitNet Distillation)—— 一種具備良好可擴展性的量化感知訓練(QAT)框架,旨在彌合極端 1.58 比特量化與實際部署之間的性能差距。

在四個基準任務及多種模型規模上的大量實驗表明,BitDistill 具有出色的可擴展性,其下游任務性能可與全精度基線持平。同時,如圖 1 所示,BitDistill 在 CPU 上實現了 10 倍的內存節省和 2.65 倍的推理加速,顯著改善了延遲、吞吐量、內存效率和能耗,使其特別適合部署在資源受限的硬件平臺上。

- 論文地址:https://www.arxiv.org/pdf/2510.13998

- 代碼地址:https://github.com/microsoft/BitNet

- 論文標題:BitNet Distillation

方法介紹:BitDistill

本文針對在資源受限設備上部署 LLM 以執行特定下游任務。重點是高效地將現有的預訓練 LLM 壓縮為 1.58 比特的 BitNet 模型,同時盡量減少性能損失與訓練成本。

BitDistill 框架包含三個關鍵階段:

第一階段:模型精煉階段。

與全精度模型不同,在標準初始化方案下,全精度模型的隱藏狀態方差通常能夠保持在一個穩定范圍內;而低比特量化模型(如 1.58 比特 LLM)則常常遭受過大的激活方差問題,導致優化過程不穩定并造成收斂性能下降。

為緩解這一問題,借鑒先前 1.58 比特 BitNet 的設計原則,本文在每個 Transformer 模塊內的關鍵位置引入了額外的歸一化層(SubLN),以實現穩定的優化過程。

第二階段:持續預訓練階段。

如圖 1 所示,直接將已有的全精度 LLM 轉換為 1.58 比特 BitNet 并在下游任務上進行微調,往往會得到次優結果。這是因為有限的訓練 token 數量不足以有效地將全精度權重適配到受限的 1.58 比特表示空間中,從而導致可擴展性較差:隨著模型規模的增大,其性能與全精度基線之間的差距也隨之擴大。

為此,本文提出了一個兩階段訓練流程:首先進行持續訓練階段,利用少量預訓練語料來實現所需的適配;隨后再在下游任務上進行微調。

第三階段:基于蒸餾的微調。

為更有效地緩解由精度降低帶來的性能退化,本文在下游任務微調階段引入了兩種知識蒸餾技術:其中,微調后的全精度 LLM 作為教師模型,而其 1.58 比特量化版本作為學生模型,通過蒸餾過程進行學習與性能對齊。

蒸餾過程主要利用 logits 蒸餾和多頭注意力蒸餾來恢復全精度性能。

實驗

實驗設置

BitDistill 方法的有效性在兩個代表性任務上進行評估:文本分類與文本摘要。分類任務采用通用語言理解評估 (GLUE) 基準中的 MNLI、QNLI 與 SST-2 三個數據集,摘要任務使用 CNN/DailyMail (CNNDM) 數據集。所有數據集均用于訓練與評估,以全面驗證方法性能。

BitDistill 的目標是將預訓練的全精度大語言模型 (LLM) 微調為適用于下游任務的 1.58-bit BitNet 模型。比較對象包括:

(1) 在相同任務上直接微調的全精度 FP16 模型 (FP16-SFT);

(2) 將全精度模型量化為 1.58-bit BitNet 后再微調的模型 (BitNet-SFT)。

實驗以 Qwen3 系列為基礎模型,涵蓋 0.6B、1.7B 與 4B 三種規模,并額外測試了 Qwen2.5 與 Gemma 等替代骨干網絡以評估模型類型影響。所有方法均采用貪心搜索確定學習率與訓練輪數,以兼顧性能與公平比較。最大訓練序列長度設為 512,批大小為 32,所有模型均在配備 8 塊 AMD Mi300X GPU 的服務器上訓練。

Logits 蒸餾溫度設為 5.0;分類任務中 λ=10、γ=1e5,摘要任務中 λ=1、γ=1e3,所有實驗中 αi=1.0。持續預訓練階段使用 FALCON 語料庫中采樣的 100 億個 token,與從頭訓練 1.58-bit 模型所需的約 4 萬億個 token 相比,成本幾乎可忽略。

評估設置

采樣參數固定為 top-p=1.0、溫度 = 0。分類性能以準確率衡量,摘要性能使用 BLEU、ROUGE-1/2/L/SUM 評估,最大生成長度為 4096 token。運行時效率通過 16 線程 CPU 的 token 吞吐量(tokens/s)報告。

主要結果

BitDistill 在各基準數據集上表現如表 1 與表 2 所示。與全精度基線相比,1.58-bit 模型在準確率和摘要質量上保持接近性能,同時推理速度提升約 2 倍,內存占用減少近 10 倍,展示出在資源受限環境下的顯著優勢。這表明通過合理蒸餾策略,激進量化仍可實現高性能。

文本分類任務上的結果。所有模型均由 Qwen3 系列 [QY+25] 初始化。每個指標和數據集的最高分均以粗體突出顯示。1.58-bit 的 BitDistill 模型實現了與 FP16 基線相當的性能,同時在所有數據集上將推理速度提升了 2 倍,并將內存占用降低了 10 倍。符號 * 表示在 BitDistill 中所使用的 FP16 教師模型。

文本摘要任務(CNNDM 數據集)上的結果。所有模型均由 Qwen3 系列 [QY+25] 初始化。每個指標和數據集的最高分均以粗體突出顯示。1.58-bit 的 BitDistill 模型實現了與 FP16 基線相當的性能,同時在所有數據集上將推理速度提升了 2 倍,并將內存占用降低了 10 倍。符號 * 表示在 BitDistill 中所使用的 FP16 教師模型。

將基礎模型替換為 Qwen2.5 和 Gemma 后,BitDistill 仍保持穩定性能(見表 4)。雖然不同預訓練模型間存在輕微波動,但整體趨勢一致,顯示該方法具備跨架構通用性和良好的部署適應性。

不同量化技術在文本分類任務上的結果。B、G、A 分別代表塊量化、GPTQ 和 AWQ。

消融實驗

BitDistill 包含三個階段。消融實驗表明,移除任一階段均顯著降低性能(表 5),說明各階段相互補充,完整流程對效率與準確率平衡至關重要。

BitDistill 中不同階段的效果。此處使用 Qwen3 0.6B 作為基礎模型。M.D.、C.T. 和 D.T. 分別表示建模優化、持續預訓練以及基于蒸餾的微調。

在第三階段中,單獨使用 logits 蒸餾或注意力蒸餾均能提升性能,但聯合使用效果最佳(表 6)。兩種技術從不同角度緩解量化優化難題,其協同作用在極低比特環境下尤為顯著。

蒸餾技術的效果。此處,LD 表示公式 9 中的 logits 蒸餾,AD 表示公式 12 中的多頭注意力蒸餾。

BitDistill 與 Block-Quant、GPTQ、AWQ 等多種量化方案兼容。實驗顯示:(1) 無論底層量化方法為何,BitDistill 均能穩定提升性能;(2) GPTQ、AWQ 等復雜量化策略在其基礎上進一步增強效果。這表明 BitDistill 提供了一種普適的低比特模型增強框架。

分析

在階段一中插入 SubLN 層能穩定 1.58-bit BitNet 的優化并加速收斂。如圖 3 (a) 所示,帶 SubLN 的模型在 FALCON 語料庫上的微調表現優于未使用 SubLN 的版本。

(a) 使用 SubLN 將現有的大語言模型 (LLMs) 微調為 1.58-bit BitNet,可以獲得更優的性能和更快的收斂速度。

持續訓練可顯著縮小大模型的 1.58-bit 與 FP16 性能差距。權重分布可視化(圖 2)顯示,經過持續訓練后,BitNet 權重從近似高斯分布轉變為更接近從頭訓練的分布。該特征促使權重集中于 0 與 ±1 過渡區域,增加梯度更新的敏感度,從而提升模型對下游任務的擬合能力。

模型權重的可視化。上面兩行展示了從頭開始訓練的 BitNet 的量化權重,及其對應的 FP16 分布。下面兩行展示的是從 LLM 加載權重并進行持續訓練后,BitNet 的量化權重及其對應的 FP16 分布。

在第三階段,單層注意力蒸餾優于多層蒸餾(圖 3 (b))。后期層的蒸餾效果更佳,表明層選擇對蒸餾質量至關重要。

(b) 在 Qwen3 0.6B 模型上,通過蒸餾不同層所獲得的 MNLI 準確率對比。

使用更大規模的 FP16 教師(如 Qwen3-1.7B、Qwen3-4B)顯著提升學生模型性能(圖 3 (c)),甚至超越同規模的 FP16 模型,證明高質量教師能為 BitDistill 帶來額外收益。

(c) 使用不同規模的 FP16 教師模型對 Qwen3-0.6B 進行蒸餾,所獲得的 MNLI 準確率對比。