阿里通義王炸Qwen3-VL開源:235B參數秒殺GPT-4V,32種語言OCR+萬物識別!

隨著人工智能技術的飛速發展,多模態模型逐漸成為研究和應用的熱點。Qwen3-VL作為阿里云通義千問團隊推出的最新一代視覺語言模型,憑借其卓越的視覺理解、空間感知和長上下文處理能力,為多模態交互帶來了全新的可能性。

一、項目概述

Qwen3-VL是阿里云通義千問團隊發布的多模態視覺語言模型系列,旨在通過強大的視覺和語言處理能力,實現更自然、更智能的人機交互。該模型系列具備卓越的視覺交互能力、純文本處理能力、視覺編程能力、空間感知與推理能力、長上下文與長視頻理解能力、多模態推理與思考能力、全面升級的視覺感知與識別能力以及多語言OCR與復雜場景識別能力。

二、核心功能

(一)視覺交互與任務執行

Qwen3-VL能夠操作電腦和手機界面,識別圖形用戶界面(GUI)元素,理解按鈕功能,調用工具并執行任務。在OS World等基準測試中表現卓越,通過工具調用顯著提升細粒度感知任務的表現。

(二)強大的純文本處理能力

從預訓練初期開始,Qwen3-VL融合文本與視覺模態的協同訓練,持續強化文本處理能力。純文本任務表現與Qwen3-235B-A22B-2507純文本旗艦模型相當。

(三)視覺編程能力

Qwen3-VL支持根據圖像或視頻生成代碼,能夠將設計圖轉化為網頁代碼,幫助開發者快速實現前端開發。

(四)空間感知與推理

2D定位從絕對坐標升級為相對坐標,支持判斷物體方位、視角變化和遮擋關系,能實現3D定位。

(五)長上下文與長視頻理解

全系列模型原生支持256K token的上下文長度,可擴展至100萬token。模型能完整輸入、全程記憶、精準檢索,支持視頻精確定位到秒級別。

(六)多模態推理與思考

Thinking版本重點優化STEM和數學推理能力。面對專業學科問題,模型能捕捉細節、分析因果,給出有邏輯、有依據的答案。

(七)全面升級的視覺感知與識別

Qwen3-VL能識別更豐富的對象類別,從名人、動漫角色、商品、地標到動植物等,滿足日常生活和專業領域的“萬物識別”需求。

(八)多語言OCR與復雜場景識別

OCR支持的語言種類從10種擴展到32種,覆蓋更多國家和地區。在復雜光線、模糊、傾斜等實拍場景下表現穩定,對生僻字、古籍字、專業術語的識別準確率顯著提升,超長文檔理解和精細結構還原能力進一步增強。

圖片

圖片

三、技術揭秘

(一)多模態融合

Qwen3-VL結合視覺(圖像、視頻)和語言(文本)模態,通過混合模態預訓練,實現視覺和語言的深度融合。

(二)架構設計

基于原生動態分辨率設計,結合MRoPE-Interleave技術,交錯分布時間、高度和寬度信息,提升對長視頻的理解能力。引入DeepStack技術,融合ViT多層次特征,提升視覺細節捕捉能力和圖文對齊精度。

(三)視覺特征token化

將ViT不同層的視覺特征進行token化,保留從底層到高層的豐富視覺信息,提升視覺理解能力。

(四)時間戳對齊機制

基于“時間戳-視頻幀”交錯輸入形式,實現幀級別的時間信息與視覺內容的細粒度對齊,提升視頻語義感知和時間定位精度。

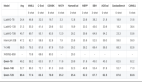

四、性能表現

(一)視覺任務性能

Qwen3-VL在視覺任務中表現出色,尤其在圖像描述和視覺問答任務中。例如,在圖像描述任務中,其準確率高達91.2%,超越了GPT-4V的85.7%。

(二)純文本任務性能

在純文本任務中,Qwen3-VL的表現與Qwen3-235B-A22B-2507純文本旗艦模型相當。這表明Qwen3-VL在文本生成、文本理解等任務上具備強大的能力。無論是生成連貫的文本內容,還是理解復雜的文本語義,Qwen3-VL都能提供高質量的輸出。

(三)多模態任務性能

在多模態任務中,Qwen3-VL展現了強大的推理和理解能力。例如,在視頻理解任務中,模型能夠處理長達數小時的視頻,并進行精準的語義理解和時間定位。Qwen3-VL能夠理解視頻中的復雜場景和事件,并生成準確的描述和總結。

(四)長上下文與長視頻理解性能

Qwen3-VL全系列模型原生支持256K token的上下文長度,可擴展至100萬token。這使得模型能夠處理超長文本和長視頻內容,而不會出現信息丟失或理解不準確的問題。在長視頻理解任務中,Qwen3-VL能夠完整輸入、全程記憶、精準檢索,支持視頻精確定位到秒級別。

圖片

圖片

五、應用場景

(一)自動化辦公與任務執行

Qwen3-VL能夠操作電腦和手機界面,自動完成各種任務,極大地提高了辦公效率。例如,它可以識別圖形用戶界面(GUI)元素,理解按鈕功能,調用工具并執行任務。在自動化辦公場景中,Qwen3-VL可以自動打開應用程序、填寫表單、發送郵件等,減少人工操作的繁瑣步驟。

(二)視覺編程輔助

Qwen3-VL支持根據圖像或視頻生成代碼,這為開發者提供了強大的編程輔助功能。例如,它可以將設計圖直接轉化為網頁代碼,幫助開發者快速實現前端開發。這種能力不僅節省了開發時間,還提高了代碼的質量和一致性。

(三)教育與學習輔導

在教育領域,Qwen3-VL能夠為學生提供詳細的解題思路和答案,輔助學習。它在STEM學科問題解答上表現出色,能夠捕捉問題的細節,進行因果分析,并給出有邏輯、有依據的答案。此外,Qwen3-VL還可以通過圖像和視頻輔助教學,使學習過程更加生動和直觀。

(四)創意內容生成

Qwen3-VL可以根據圖像或視頻內容生成文案、故事等,為創作者提供靈感和素材,助力創意寫作。例如,它可以為廣告公司生成創意文案,為小說家提供故事大綱,為視頻創作者生成腳本等。這種能力不僅激發了創作者的靈感,還提高了內容創作的效率。

(五)復雜文檔處理

Qwen3-VL能夠解析長文檔和多頁文件,提取關鍵信息,方便用戶快速獲取所需內容。它支持多語言OCR和復雜場景識別,能夠處理生僻字、古籍字、專業術語等,對超長文檔的理解和精細結構還原能力進一步增強。這使得Qwen3-VL在法律、金融、科研等領域具有重要的應用價值。

(六)視頻內容理解與分析

Qwen3-VL在視頻理解方面表現出色,能夠處理長達數小時的視頻,并進行精準的語義理解和時間定位。它可以用于視頻內容的自動標注、視頻摘要生成、視頻問答等場景。例如,在視頻監控領域,Qwen3-VL可以實時分析監控視頻,識別異常行為并發出警報。

(七)多語言文檔處理

Qwen3-VL支持32種語言的OCR識別,覆蓋更多國家和地區。這使得它在跨國企業、國際組織等場景中具有廣泛的應用價值。例如,它可以用于多語言文檔的翻譯、內容提取和信息檢索,幫助用戶快速處理和理解不同語言的文檔。

六、快速使用

(一)安裝依賴

執行下面命令、安裝相關依賴

pip install git+https://github.com/huggingface/transformers

# pip install transformers==4.57.0 # currently, V4.57.0 is not released(二)推理示例

以下是基于transformers 推理的代碼示例:

from transformers import AutoModelForImageTextToText, AutoProcessor

# default: Load the model on the available device(s)

model = AutoModelForImageTextToText.from_pretrained(

"Qwen/Qwen3-VL-235B-A22B-Instruct", dtype="auto", device_map="auto"

)

# We recommend enabling flash_attention_2 for better acceleration and memory saving, especially in multi-image and video scenarios.

# model = AutoModelForImageTextToText.from_pretrained(

# "Qwen/Qwen3-VL-235B-A22B-Instruct",

# dtype=torch.bfloat16,

# attn_implementatinotallow="flash_attention_2",

# device_map="auto",

# )

processor = AutoProcessor.from_pretrained("Qwen/Qwen3-VL-235B-A22B-Instruct")

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",

},

{"type": "text", "text": "Describe this image."},

],

}

]

# Preparation for inference

inputs = processor.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_dict=True,

return_tensors="pt"

)

inputs = inputs.to(model.device)

# Inference: Generation of the output

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)七、結語

Qwen3-VL作為阿里云通義千問團隊推出的多模態視覺語言模型,憑借其卓越的性能和廣泛的應用場景,為人工智能領域帶來了新的突破。無論是視覺交互、純文本處理,還是多模態推理,Qwen3-VL都展現出了強大的能力。未來,隨著技術的不斷發展,Qwen3-VL有望在更多領域發揮更大的作用。

項目地址

項目官網:https://qwen.ai/blog?id=99f0335c4ad9ff6153e517418d48535ab6d8afef&from=research.latest-advancements-list

GitHub倉庫:https://github.com/QwenLM/Qwen3-VL

Hugging Face模型庫:https://huggingface.co/collections/Qwen/qwen3-vl-68d2a7c1b8a8afce4ebd2dbe