神經(jīng)架構(gòu)搜索NAS:核心算法原理與Python代碼

最近好多論文開始將 神經(jīng)架構(gòu)搜索(NAS) 應(yīng)用于大模型或 大型語言/視覺語言模型的設(shè)計(jì)中。

比如: LangVision-LoRA-NAS、Jet-Nemotron、PhaseNAS 等看來NAS又要有一波熱度了,所以我來回顧一下NAS的基礎(chǔ)技術(shù)。

深度學(xué)習(xí)的成功很大程度上依賴于神經(jīng)網(wǎng)絡(luò)架構(gòu)的精心設(shè)計(jì)。從AlexNet到ResNet,再到Transformer,每一個(gè)里程碑式的架構(gòu)都凝聚了研究者大量的領(lǐng)域知識(shí)和反復(fù)試驗(yàn)。這種依賴人工設(shè)計(jì)的模式存在明顯局限性:設(shè)計(jì)過程耗時(shí)費(fèi)力,且很難保證找到全局最優(yōu)解。

神經(jīng)架構(gòu)搜索(Neural Architecture Search, NAS)正是為了解決這一問題而誕生。NAS將神經(jīng)網(wǎng)絡(luò)設(shè)計(jì)轉(zhuǎn)化為一個(gè)可以自動(dòng)求解的優(yōu)化問題,通過算法自動(dòng)搜索最優(yōu)架構(gòu),顯著提升了架構(gòu)設(shè)計(jì)的效率和性能上限。

本文將深入分析NAS的核心技術(shù)原理,重點(diǎn)討論三種主要搜索策略:強(qiáng)化學(xué)習(xí)方法、進(jìn)化算法以及基于梯度的方法,并通過具體的代碼實(shí)現(xiàn)來展示這些方法的實(shí)際應(yīng)用效果。

NAS的技術(shù)框架與核心原理

神經(jīng)架構(gòu)搜索本質(zhì)上是一個(gè)自動(dòng)化的網(wǎng)絡(luò)設(shè)計(jì)系統(tǒng),它將傳統(tǒng)的人工設(shè)計(jì)過程轉(zhuǎn)化為機(jī)器可以處理的優(yōu)化問題。與人工逐層設(shè)計(jì)不同,NAS算法能夠在龐大的架構(gòu)空間中高效搜索,通過系統(tǒng)性評(píng)估找到性能最優(yōu)的網(wǎng)絡(luò)結(jié)構(gòu)。

圖片

圖片

NAS的工作流程可以抽象為一個(gè)通用框架,其中搜索空間定義了所有可能的網(wǎng)絡(luò)架構(gòu),搜索策略決定了如何在這個(gè)空間中進(jìn)行探索,而性能評(píng)估機(jī)制則為搜索過程提供反饋信號(hào)。

整個(gè)NAS過程包含三個(gè)關(guān)鍵環(huán)節(jié):

搜索空間定義是NAS的基礎(chǔ),它確定了算法可以構(gòu)建的所有可能神經(jīng)網(wǎng)絡(luò)架構(gòu)的集合。搜索空間的設(shè)計(jì)需要在表達(dá)能力和計(jì)算復(fù)雜度之間找到平衡點(diǎn)。

搜索策略選擇決定了算法如何在搜索空間中進(jìn)行探索。不同的搜索策略適用于不同的場(chǎng)景,主要包括強(qiáng)化學(xué)習(xí)、進(jìn)化算法、基于梯度的方法、貝葉斯優(yōu)化以及隨機(jī)搜索等。

性能評(píng)估環(huán)節(jié)負(fù)責(zé)評(píng)估候選架構(gòu)的質(zhì)量。由于完整訓(xùn)練每個(gè)候選架構(gòu)的計(jì)算開銷巨大,實(shí)際應(yīng)用中通常采用加速技術(shù),如在小規(guī)模數(shù)據(jù)集上訓(xùn)練、使用性能預(yù)測(cè)模型,或者采用權(quán)重共享機(jī)制讓子網(wǎng)絡(luò)繼承超網(wǎng)絡(luò)的預(yù)訓(xùn)練權(quán)重。

圖片

圖片

雙層優(yōu)化問題的數(shù)學(xué)表述

NAS的目標(biāo)是找到能夠最小化驗(yàn)證損失的最優(yōu)架構(gòu),這個(gè)過程可以表述為一個(gè)雙層優(yōu)化問題。在這個(gè)框架中,需要同時(shí)優(yōu)化網(wǎng)絡(luò)架構(gòu)和模型參數(shù)兩個(gè)層面。

數(shù)學(xué)上,這個(gè)優(yōu)化問題可以形式化為:

其中α?表示最優(yōu)架構(gòu),A是整個(gè)搜索空間,L_val是驗(yàn)證損失,w?(α)是給定架構(gòu)α下的最優(yōu)權(quán)重參數(shù)。

圖片

圖片

這里L_train表示訓(xùn)練損失,w是模型權(quán)重,α是架構(gòu)參數(shù)。

外層優(yōu)化(公式1)處理架構(gòu)搜索問題,內(nèi)層優(yōu)化(公式2)處理標(biāo)準(zhǔn)的模型訓(xùn)練。外層優(yōu)化的難點(diǎn)在于架構(gòu)空間通常是離散的且高維,傳統(tǒng)的梯度優(yōu)化方法難以直接應(yīng)用。NAS的核心貢獻(xiàn)就是提供了有效求解這個(gè)雙層優(yōu)化問題的算法框架。

NAS的應(yīng)用領(lǐng)域擴(kuò)展

NAS技術(shù)已經(jīng)從最初的圖像分類任務(wù)擴(kuò)展到多個(gè)重要應(yīng)用領(lǐng)域。在計(jì)算機(jī)視覺中,NAS不僅能夠發(fā)現(xiàn)新的網(wǎng)絡(luò)架構(gòu),還能針對(duì)特定任務(wù)(如小目標(biāo)檢測(cè))優(yōu)化專用的損失函數(shù)。在自然語言處理領(lǐng)域,NAS幫助設(shè)計(jì)更適合處理特定語言現(xiàn)象(如稀有詞匯、長(zhǎng)距離依賴)的網(wǎng)絡(luò)結(jié)構(gòu)。在醫(yī)學(xué)影像分析中,NAS生成的架構(gòu)對(duì)細(xì)微病理特征表現(xiàn)出更高的敏感性,為臨床診斷提供了重要支持。

NAS的三種核心搜索策略

搜索策略是NAS系統(tǒng)的核心組件,決定了算法在架構(gòu)空間中的探索方式和效率。不同的搜索策略有各自的適用場(chǎng)景和技術(shù)特點(diǎn)。

基于強(qiáng)化學(xué)習(xí)的搜索方法

強(qiáng)化學(xué)習(xí)將架構(gòu)搜索建模為一個(gè)序貫決策問題,其中智能體通過不斷試錯(cuò)來學(xué)習(xí)選擇高性能架構(gòu)的策略。在這個(gè)框架中,網(wǎng)絡(luò)架構(gòu)的構(gòu)建過程被分解為一系列決策步驟,每個(gè)步驟選擇特定的架構(gòu)組件(如層類型、連接方式等)。

圖片

圖片

強(qiáng)化學(xué)習(xí)方法的核心是訓(xùn)練一個(gè)控制器網(wǎng)絡(luò),該網(wǎng)絡(luò)學(xué)習(xí)生成有希望的架構(gòu)候選。控制器接收當(dāng)前的架構(gòu)狀態(tài)作為輸入,輸出下一個(gè)架構(gòu)組件的選擇概率分布。通過與環(huán)境的交互(即評(píng)估生成架構(gòu)的性能),控制器逐步學(xué)習(xí)到更好的架構(gòu)生成策略。

這種方法特別適合處理復(fù)雜的搜索空間,因?yàn)閺?qiáng)化學(xué)習(xí)天然具備處理序貫決策和延遲獎(jiǎng)勵(lì)的能力。同時(shí),通過設(shè)計(jì)合適的獎(jiǎng)勵(lì)函數(shù),可以很容易地將多個(gè)優(yōu)化目標(biāo)(如準(zhǔn)確率、延遲、模型大小)整合到一個(gè)統(tǒng)一的框架中。

進(jìn)化算法的群體搜索機(jī)制

進(jìn)化算法借鑒生物進(jìn)化的思想,將網(wǎng)絡(luò)架構(gòu)類比為生物個(gè)體,通過模擬自然選擇過程來搜索最優(yōu)架構(gòu)。在這個(gè)框架中,維護(hù)一個(gè)由多個(gè)架構(gòu)組成的群體,通過選擇、交叉、變異等操作產(chǎn)生新的架構(gòu)候選。。

圖片

圖片

進(jìn)化算法的優(yōu)勢(shì)在于其全局搜索能力強(qiáng),不容易陷入局部最優(yōu)解。算法維護(hù)多個(gè)搜索方向,通過群體的多樣性保證了搜索的泛化性。進(jìn)化算法天然支持并行計(jì)算,可以同時(shí)評(píng)估群體中的多個(gè)個(gè)體,顯著提升搜索效率。

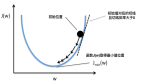

對(duì)于多目標(biāo)優(yōu)化問題,進(jìn)化算法可以找到一組非支配解(帕累托前沿),為用戶提供在不同目標(biāo)間權(quán)衡的多種選擇。這在實(shí)際應(yīng)用中非常有價(jià)值,因?yàn)橥枰跍?zhǔn)確性和效率之間找到平衡點(diǎn)。

基于梯度的可微分搜索

基于梯度的方法通過構(gòu)建可微分的搜索空間,將離散的架構(gòu)搜索問題轉(zhuǎn)化為連續(xù)優(yōu)化問題,從而可以直接應(yīng)用梯度下降算法。這類方法的代表是可微架構(gòu)搜索(Differentiable Architecture Search, DARTS)。

DARTS的核心思想是構(gòu)建一個(gè)包含所有可能操作的超網(wǎng)絡(luò)(supernet),然后通過學(xué)習(xí)各個(gè)操作的權(quán)重來隱式地進(jìn)行架構(gòu)搜索。在訓(xùn)練過程中,每個(gè)邊上的操作是所有候選操作的加權(quán)組合,權(quán)重通過梯度下降進(jìn)行優(yōu)化。

圖片

圖片

DARTS采用交替優(yōu)化的策略來處理雙層優(yōu)化問題:首先固定架構(gòu)參數(shù),優(yōu)化網(wǎng)絡(luò)權(quán)重;然后固定網(wǎng)絡(luò)權(quán)重,優(yōu)化架構(gòu)參數(shù)。這種交替優(yōu)化的方式避免了直接求解雙層優(yōu)化問題的困難。

基于梯度的方法的主要優(yōu)勢(shì)是計(jì)算效率高,相比強(qiáng)化學(xué)習(xí)和進(jìn)化算法,DARTS通常能在更短的時(shí)間內(nèi)找到滿意的架構(gòu)。但這種方法也有局限性,主要適用于相對(duì)簡(jiǎn)單的搜索空間和單目標(biāo)優(yōu)化問題。

三種搜索策略的實(shí)驗(yàn)對(duì)比

為了直觀展示不同搜索策略的特點(diǎn)和性能,我們通過一個(gè)具體的實(shí)驗(yàn)來比較三種方法在循環(huán)神經(jīng)網(wǎng)絡(luò)架構(gòu)搜索中的表現(xiàn)。雖然任何類型的網(wǎng)絡(luò)都可以通過NAS進(jìn)行優(yōu)化,但復(fù)雜架構(gòu)通常能從自動(dòng)化搜索中獲得更顯著的收益。

有效的搜索空間設(shè)計(jì)是NAS成功的關(guān)鍵。搜索空間需要為算法提供一套明確的規(guī)則和約束,確保生成的架構(gòu)既有創(chuàng)新性又具有實(shí)用性。

在架構(gòu)層面,需要明確允許使用的構(gòu)建模塊,包括層類型(全連接層、卷積層等)、激活函數(shù)以及優(yōu)化器選擇。連接規(guī)則定義了這些模塊如何組合,例如是否允許跳躍連接、分支結(jié)構(gòu)等。參數(shù)范圍設(shè)置確定了網(wǎng)絡(luò)規(guī)模的邊界,如層數(shù)范圍、每層神經(jīng)元數(shù)量、正則化參數(shù)等。

搜索空間設(shè)計(jì)需要在靈活性和可處理性之間找到平衡:既要足夠靈活以包含高性能的新穎架構(gòu),又要有適當(dāng)?shù)募s束以保證計(jì)算的可行性。

我們定義的搜索空間同時(shí)涵蓋了架構(gòu)結(jié)構(gòu)參數(shù)和訓(xùn)練超參數(shù),這樣NAS算法可以協(xié)同優(yōu)化網(wǎng)絡(luò)設(shè)計(jì)和訓(xùn)練策略,尋找整體最優(yōu)的解決方案。

import torch.nn as nn

import torch.optim as optim

search_space = {

# 架構(gòu)結(jié)構(gòu)

'num_hidden_layers': [1, 2, 3, 4, 5],

'hidden_layer_size': [32, 64, 128, 256, 512],

'activation_function': ['ReLU', 'LeakyReLU', 'Tanh'],

# 超參數(shù)

'learning_rate': [0.1, 0.01, 0.001, 0.0001],

'optimizer': ['Adam', 'SGD', 'RMSprop'],

'dropout_rate': [0.0, 0.2, 0.4, 0.6]

}

activation_map = {

'ReLU': nn.ReLU,

'LeakyReLU': nn.LeakyReLU,

'Tanh': nn.Tanh

}

optimizer_map = {

'Adam': optim.Adam,

'SGD': optim.SGD,

'RMSprop': optim.RMSprop

}架構(gòu)評(píng)估是NAS流程中的關(guān)鍵環(huán)節(jié),它為搜索算法提供了判斷架構(gòu)質(zhì)量的標(biāo)準(zhǔn)。評(píng)估函數(shù)需要接收完整的架構(gòu)描述(包括結(jié)構(gòu)參數(shù)和超參數(shù)),返回量化的性能指標(biāo),使搜索算法能夠比較不同架構(gòu)的優(yōu)劣。

import torch

def evaluate_architecture(architecture, X_train, y_train, X_val, y_val, num_epochs=50):

# 初始化模型、優(yōu)化器和損失函數(shù)

model = build_model(architecture)

criterion = nn.MSELoss()

optimizer_class = optimizer_map[architecture['optimizer']]

optimizer = optimizer_class(model.parameters(), lr=architecture['learning_rate'])

# 訓(xùn)練模型

model.train()

for _ in range(num_epochs):

optimizer.zero_grad()

outputs = model(X_train)

loss = criterion(outputs, y_train)

loss.backward()

optimizer.step()

# 使用驗(yàn)證數(shù)據(jù)集驗(yàn)證模型

model.eval()

with torch.no_grad():

val_outputs = model(X_val)

val_loss = criterion(val_outputs, y_val)

return val_loss.item()強(qiáng)化學(xué)習(xí)方法通過訓(xùn)練一個(gè)策略網(wǎng)絡(luò)來生成架構(gòu)候選。控制器網(wǎng)絡(luò)以循環(huán)神經(jīng)網(wǎng)絡(luò)為基礎(chǔ),能夠處理變長(zhǎng)的架構(gòu)序列,并為每個(gè)架構(gòu)組件生成選擇概率。

import torch.nn as nn

class ArchitectureController(nn.Module):

def __init__(self, search_space):

super(ArchitectureController, self).__init__()

self.search_space = search_space

self.keys = list(search_space.keys())

self.vocab_size = [len(search_space[key]) for key in self.keys]

self.num_actions = len(self.keys)

self.rnn = nn.RNN(input_size=1, hidden_size=64, num_layers=1)

self.policy_heads = nn.ModuleList([nn.Linear(64, vs) for vs in self.vocab_size])

def forward(self, input, hidden):

output, hidden = self.rnn(input, hidden)

logits = [head(output.squeeze(0)) for head in self.policy_heads]

return logits, hidden強(qiáng)化學(xué)習(xí)的搜索過程采用策略梯度方法,通過最大化期望獎(jiǎng)勵(lì)來優(yōu)化控制器參數(shù)。

import torch

def run_rl_search(

search_space, X_train, y_train, X_val, y_val, num_epochs=10, num_episodes=5

):

# 使用ArchitectureController類初始化控制器

controller = ArchitectureController(search_space)

控制器優(yōu)化器 = optim.Adam(控制器.parameters(), lr=0.01)

# 開始搜索

最佳損失 = float(‘inf’)

最佳架構(gòu) = None

for 事件 in range(事件數(shù)):

# 清零梯度

控制器優(yōu)化器.zero_grad()

# RNN期望輸入形狀為(batch_size, timesteps, features)

hidden = torch.zeros(1, 1, 64)

# 初始化列表/字典存儲(chǔ)對(duì)數(shù)概率與架構(gòu)選擇

log_probs = []

architecture = {}

# 測(cè)試架構(gòu)選項(xiàng)

for i, key in enumerate(controller.keys):

# 執(zhí)行控制器

logits, hidden = controller(torch.zeros(1, 1, 1), hidden)

# 為當(dāng)前架構(gòu)選項(xiàng)創(chuàng)建類別分布

dist = torch.distributions. Categorical(logits=logits[i])

# 從分布采樣動(dòng)作

action_index = dist.sample()

# 存儲(chǔ)選定的架構(gòu)值和對(duì)數(shù)概率

architecture[key] = search_space[key][action_index.item()]

log_probs.append(dist.log_prob(action_index))

# 計(jì)算驗(yàn)證損失

val_loss = evaluate_architecture(architecture, X_train, y_train, X_val, y_val, num_epochs=num_epochs)

# update the optimal architecture choice

reward = -val_loss

policy_loss = torch.sum(torch.stack(log_probs) * -reward)

policy_loss.backward()

controller_optimizer.step()

if val_loss < best_loss:

best_loss = val_loss

best_architecture = architecture

return best_architecture, best_loss

best_arch_rl, best_perf_rl = run_rl_search(

search_space, X_train, y_train, X_val, y_val, num_episodes=5

)進(jìn)化算法的群體演化搜索

進(jìn)化算法通過維護(hù)一個(gè)架構(gòu)群體并模擬生物進(jìn)化過程來搜索最優(yōu)解。該方法在每一代中評(píng)估群體中所有個(gè)體的適應(yīng)度,然后通過選擇、交叉和變異操作產(chǎn)生下一代群體。

import random

from copy import deepcopy

def run_evolutionary_search(X, y, search_space, population_size=10, num_generatinotallow=5):

best_loss = float(‘inf’)

best_architecture = None

# 創(chuàng)建訓(xùn)練集和驗(yàn)證集

split_idx = int(len(X) * 0.8)

X_train, X_val = X[:split_idx], X[split_idx:]

y_train, y_val = y[:split_idx], y[split_idx:]

# 在種群中啟動(dòng)搜索

population = []

for _ in range(population_size):

# 隨機(jī)選擇待測(cè)試架構(gòu)

architecture = {key: random.choice(search_space[key]) for key in search_space}

population.append(architecture)

# 遍歷所有代(架構(gòu)選項(xiàng)集合)

for _ in range(num_generations):

fitness = []

for arch in population:

loss = evaluate_architecture(arch, X_train, y_train, X_val, y_val, num_epochs=10)

fitness.append((loss, arch))

if loss < best_loss:

best_loss = loss

best_architecture = arch

# 從當(dāng)前代中篩選'精英'(高性能架構(gòu))創(chuàng)建新種群

fitness.sort(key=lambda x: x[0])

new_population = []

精英數(shù)量 = 種群規(guī)模 // 2

精英 = [arch for loss, arch in 適應(yīng)度[:精英數(shù)量]]

新種群.extend(精英)

# 從新種群創(chuàng)建并變異后代

while new_population.length < population_size:

parent1 = random.choice(elites)

parent2 = random.choice(elites)

child = deepcopy({})

for key in parent1: child[key] = random.choice([parent1[key], parent2[key]])

mutation_key = random.choice(list(search_space.keys()))

child[mutation_key] = random.choice(search_space[mutation_key])

new_population.append(child)

population = new_population

return best_architecture, best_loss

best_arch_ea, best_perf_ea = run_evolutionary_search(

search_space, population_size=10, num_generatinotallow=5

)基于梯度的方法通過構(gòu)建可微分的搜索空間來直接優(yōu)化架構(gòu)參數(shù)。我們實(shí)現(xiàn)了一個(gè)簡(jiǎn)化版的DARTS框架,展示其核心思想。

import torch.nn as nn

# 定義單元

class Cell(nn.Module):

def __init__(self, in_features, out_features, ops):

super(Cell, self).__init__()

self.ops = nn.ModuleList([

nn.Sequential(nn.Linear(in_features, out_features), op()) for op in ops

])

def forward(self, x, weights):

return sum(w * op(x) for w, op in zip(weights, self.ops))

# 定義目標(biāo)模型

class Model(nn.Module):

def __init__(self, search_space):

super(Model, self).__init__()

self.ops_list = [activation_map[name] for name in search_space['activation_function']]

self.num_ops = len(self.ops_list)

self.num_hidden_layers = max(search_space['num_hidden_layers'])

self.hidden_layer_size = search_space['hidden_layer_size'][0]

self.alphas = nn.Parameter(torch.randn(self.num_hidden_layers, self.num_ops, requires_grad=True))

self.layers = nn.ModuleList()

self.layers.append(nn.Linear(1, self.hidden_layer_size))

for _ in range(self.num_hidden_layers - 1):

self.layers.append(Cell(self.hidden_layer_size, self.hidden_layer_size, self.ops_list))

self.output_layer = nn.Linear(self.hidden_layer_size, 1)

def forward(self, x):

architecture_weights = nn.functional.softmax(self.alphas, dim=-1)

output = x

for i, layer in enumerate(self.layers):

if isinstance(layer, nn.Linear):

output = layer(output)

elif isinstance(layer, Cell):

output = layer(output, architecture_weights[i-1])

return self.output_layer(output)

def discretize(self):

architecture = {

'num_hidden_layers': self.num_hidden_layers,

'hidden_layer_size': self.hidden_layer_size,

'learning_rate': 0.001,

'optimizer': 'Adam',

'dropout_rate': 0.0

}

best_op_indices = self.alphas.argmax(dim=-1)

best_ops = [self.ops_list[i].__name__ for i in best_op_indices]

architecture['activation_function'] = best_ops[0]

return architectureDARTS采用交替優(yōu)化策略,分別更新網(wǎng)絡(luò)權(quán)重和架構(gòu)參數(shù):

import torch.nn as nn

import torch.optim as optim

def run_gradient_based_search(search_space, X_train, y_train, X_val, y_val, num_epochs=50):

# 定義模型、損失函數(shù)和優(yōu)化器

model = Model(search_space)

criterion = nn.MSELoss()

arch_params = [model.alphas]

optimizer_alpha = optim.Adam(arch_params, lr=0.001)

arch_param_ids = {id(p) for p in arch_params}

weight_params = [p for p in model.parameters() if p.requires_grad and id(p) notin arch_param_ids]

optimizer_w = optim.Adam(weight_params, lr=0.01)

# 開始搜索

for epoch in range(num_epochs):

# 梯度置零

optimizer_w.zero_grad()

# 前向傳播

outputs = model(X_train)

# 優(yōu)化

loss_w = criterion(outputs, y_train)

loss_w.backward()

optimizer_w.step()

# 反向傳播

optimizer_alpha.zero_grad()

val_outputs = model(X_val)

loss_alpha = criterion(val_outputs, y_val)

loss_alpha.backward()

optimizer_alpha.step()

best_architecture = model.discretize()

final_loss = evaluate_architecture(best_architecture, X_train, y_train, X_val, y_val, num_epochs=50)

return best_architecture, final_loss

best_arch_gb, best_perf_gb = run_gradient_based_search(

search_space, X_train, y_train, X_val, y_val

)實(shí)驗(yàn)結(jié)果分析與方法對(duì)比

結(jié)果

進(jìn)化算法(EA)方法是在此任務(wù)中找到最優(yōu)架構(gòu)的最有效方法,達(dá)到了最低的最佳驗(yàn)證MSE為0.1498。

以下是結(jié)果的細(xì)分。

1. 強(qiáng)化學(xué)習(xí)(RL)

RL方法找到的最佳驗(yàn)證MSE為0.2744。損失和獎(jiǎng)勵(lì)值在五個(gè)回合中變化顯著,最好的結(jié)果出現(xiàn)在最后一個(gè)回合。

運(yùn)行了五個(gè)回合:

- 回合1:損失 = 1.1483,獎(jiǎng)勵(lì) = -1.1483

- 回合2:損失 = 3.2017,獎(jiǎng)勵(lì) = -3.2017

- 回合3:損失 = 4.0062,獎(jiǎng)勵(lì) = -4.0062

- 回合4:損失 = 2.5762,獎(jiǎng)勵(lì) = -2.5762

- 回合5:損失 = 0.2744,獎(jiǎng)勵(lì) = -0.2744

找到的最佳架構(gòu):

- 隱藏層數(shù):4

- 隱藏層大小:64

- 激活函數(shù):Tanh

- 學(xué)習(xí)率:0.1

- 優(yōu)化器:RMSprop

- Dropout率:0.2

最佳驗(yàn)證MSE:0.2744

2. 進(jìn)化算法(EA)

EA成功地在五代中最小化了損失,導(dǎo)致最佳總體驗(yàn)證MSE為0.1498。

這個(gè)架構(gòu)在搜索的第二代中被找到。

用十個(gè)個(gè)體的群體搜索了五代:

- 第1/5代 —— 此代中的最佳損失:0.4558

- 第2/5代 —— 此代中的最佳損失:0.1498

- 第3/5代 —— 此代中的最佳損失:0.3062

- 第4/5代 —— 此代中的最佳損失:0.4200

- 第5/5代 —— 此代中的最佳損失:0.3125

找到的最佳架構(gòu):

- 隱藏層數(shù):5

- 隱藏層大小:512

- 激活函數(shù):Tanh

- 學(xué)習(xí)率:0.1

- 優(yōu)化器:SGD

- Dropout率:0.2

最佳驗(yàn)證MSE:0.1498

3. 基于梯度的方法

盡管運(yùn)行了50個(gè)epoch,這種方法的表現(xiàn)最差。它導(dǎo)致了最高的最佳驗(yàn)證MSE為3.6725。

用50個(gè)epoch進(jìn)行搜索:

- Epoch 10/50:訓(xùn)練損失 = 0.0938,架構(gòu)損失 = 2.1598

- Epoch 20/50:訓(xùn)練損失 = 0.0509,架構(gòu)損失 = 1.6185

- Epoch 30/50:訓(xùn)練損失 = 0.0338,架構(gòu)損失 = 1.7296

- Epoch 40/50:訓(xùn)練損失 = 0.0184,架構(gòu)損失 = 0.4939

- Epoch 50/50:訓(xùn)練損失 = 0.0114,架構(gòu)損失 = 0.2417

找到的最佳架構(gòu):

- 隱藏層數(shù):5

- 隱藏層大小:32

- 激活函數(shù):LeakyReLU

- 學(xué)習(xí)率:0.001

- 優(yōu)化器:Adam

- Dropout率:0.0

最佳驗(yàn)證MSE:3.6725

強(qiáng)化學(xué)習(xí)方法的性能表現(xiàn)

強(qiáng)化學(xué)習(xí)方法經(jīng)過5個(gè)episode的訓(xùn)練,最終找到的最優(yōu)驗(yàn)證MSE為0.2744。從訓(xùn)練過程可以看出,該方法存在較大的性能波動(dòng),這反映了策略學(xué)習(xí)過程中的探索-利用權(quán)衡問題。

訓(xùn)練過程中的損失變化如下:Episode 1的損失為1.1483,Episode 2達(dá)到3.2017,Episode 3進(jìn)一步上升到4.0062,Episode 4回落至2.5762,最終在Episode 5獲得最佳結(jié)果0.2744。這種波動(dòng)模式說明強(qiáng)化學(xué)習(xí)需要充分的探索過程才能收斂到較好的解。

最終發(fā)現(xiàn)的最優(yōu)架構(gòu)配置為:4個(gè)隱藏層,每層64個(gè)神經(jīng)元,使用Tanh激活函數(shù),學(xué)習(xí)率設(shè)置為0.1,采用RMSprop優(yōu)化器,dropout率為0.2。這個(gè)配置在網(wǎng)絡(luò)復(fù)雜度和泛化能力之間取得了較好的平衡。

進(jìn)化算法的優(yōu)異表現(xiàn)

進(jìn)化算法在5代進(jìn)化過程中展現(xiàn)了穩(wěn)定且優(yōu)秀的搜索性能,最終獲得了0.1498的最佳驗(yàn)證MSE。值得注意的是,這個(gè)最優(yōu)架構(gòu)在第2代就被發(fā)現(xiàn),說明進(jìn)化算法能夠快速識(shí)別出有前景的架構(gòu)模式。

各代的最佳損失演化軌跡為:第1代0.4558,第2代0.1498,第3代0.3062,第4代0.4200,第5代0.3125。從這個(gè)軌跡可以看出,進(jìn)化算法通過維護(hù)群體多樣性,即使在后續(xù)代中出現(xiàn)性能波動(dòng),但始終保持了全局最優(yōu)解。

最優(yōu)架構(gòu)配置包含5個(gè)隱藏層,每層512個(gè)神經(jīng)元,使用Tanh激活函數(shù),學(xué)習(xí)率0.1,SGD優(yōu)化器,dropout率0.2。相比強(qiáng)化學(xué)習(xí)發(fā)現(xiàn)的架構(gòu),進(jìn)化算法傾向于選擇更大的網(wǎng)絡(luò)容量,這可能與其群體搜索機(jī)制有關(guān)。

基于梯度方法的局限性分析

盡管運(yùn)行了50個(gè)epoch,基于梯度的方法表現(xiàn)最差,驗(yàn)證MSE達(dá)到3.6725。這個(gè)結(jié)果暴露了DARTS在某些場(chǎng)景下的局限性,特別是在搜索空間設(shè)計(jì)不夠精細(xì)或者超參數(shù)設(shè)置不當(dāng)?shù)那闆r下。

訓(xùn)練過程顯示了典型的雙層優(yōu)化收斂模式:訓(xùn)練損失從0.0938(epoch 10)逐步下降到0.0114(epoch 50),而架構(gòu)損失則從2.1598下降到0.2417。雖然兩個(gè)損失都在下降,但最終的泛化性能仍然不佳。

發(fā)現(xiàn)的架構(gòu)配置為:5個(gè)隱藏層,每層32個(gè)神經(jīng)元,LeakyReLU激活函數(shù),學(xué)習(xí)率0.001,Adam優(yōu)化器,無dropout。這個(gè)配置相對(duì)保守,可能是梯度優(yōu)化傾向于選擇穩(wěn)定但不夠激進(jìn)的架構(gòu)導(dǎo)致的。

方法特性的深層分析

三種方法的表現(xiàn)差異反映了它們?cè)谒阉鳈C(jī)制上的根本不同。進(jìn)化算法通過群體多樣性和并行搜索,能夠更好地避免局部最優(yōu)并發(fā)現(xiàn)全局最優(yōu)解。強(qiáng)化學(xué)習(xí)雖然有一定的探索能力,但單一智能體的搜索路徑限制了其搜索效率。基于梯度的方法雖然計(jì)算效率高,但在處理復(fù)雜、非凸的架構(gòu)搜索空間時(shí)容易陷入局部最優(yōu)。

這些結(jié)果也說明了搜索空間設(shè)計(jì)和超參數(shù)調(diào)優(yōu)在NAS中的重要性。不同的方法可能需要針對(duì)性的搜索空間設(shè)計(jì)才能發(fā)揮最佳性能。

總結(jié)

神經(jīng)架構(gòu)搜索技術(shù)為自動(dòng)化神經(jīng)網(wǎng)絡(luò)設(shè)計(jì)提供了強(qiáng)有力的工具,顯著降低了高性能架構(gòu)設(shè)計(jì)的門檻。通過算法自動(dòng)化搜索,NAS能夠發(fā)現(xiàn)超越人工設(shè)計(jì)的新穎架構(gòu),特別是在需要最前沿性能的關(guān)鍵應(yīng)用中展現(xiàn)出重要價(jià)值。

當(dāng)前的NAS技術(shù)仍面臨兩個(gè)核心挑戰(zhàn)。首先是計(jì)算成本問題:早期的NAS方法往往需要數(shù)千GPU小時(shí)的計(jì)算資源,這種巨大的計(jì)算開銷限制了技術(shù)的普及應(yīng)用。其次是泛化能力不足:大多數(shù)NAS方法針對(duì)特定任務(wù)進(jìn)行優(yōu)化,缺乏跨任務(wù)的遷移能力,導(dǎo)致每個(gè)新問題都需要重新進(jìn)行昂貴的搜索過程。

從長(zhǎng)遠(yuǎn)來看,NAS技術(shù)正在向更加智能化和實(shí)用化的方向發(fā)展,特別是在大語言模型領(lǐng)域已經(jīng)開始展現(xiàn)出巨大潛力。近期的研究如LangVision-LoRA-NAS、Jet-Nemotron等工作表明,研究者們已經(jīng)開始探索用NAS來優(yōu)化大語言模型的架構(gòu)設(shè)計(jì),包括注意力機(jī)制、前饋網(wǎng)絡(luò)結(jié)構(gòu)、以及模型壓縮策略等關(guān)鍵組件。這種趨勢(shì)預(yù)示著NAS將從傳統(tǒng)的小規(guī)模網(wǎng)絡(luò)設(shè)計(jì)擴(kuò)展到大規(guī)模預(yù)訓(xùn)練模型的自動(dòng)化優(yōu)化,最終實(shí)現(xiàn)真正意義上的端到端神經(jīng)網(wǎng)絡(luò)自動(dòng)設(shè)計(jì)。這不僅會(huì)進(jìn)一步降低深度學(xué)習(xí)應(yīng)用的技術(shù)門檻,也將為發(fā)現(xiàn)適應(yīng)特定任務(wù)和資源約束的新型大模型架構(gòu)提供強(qiáng)有力的工具。